Next ’24 で発表された Cloud Pub/Sub の新機能

Google Cloud Japan Team

※この投稿は米国時間 2024 年 4 月 18 日に、Google Cloud blog に投稿されたものの抄訳です。

ストリーミング テクノロジーを導入する組織の増加を受け、Google Cloud ではストリーミング取り込みと分析のための包括的なソリューションを提供しています。Cloud Pub/Sub は Google Cloud のスケーラビリティと信頼性に優れたシンプルなグローバル メッセージ サービスです。Cloud Pub/Sub はストリーミング データを Google Cloud に取り込むための主なエントリ ポイントとして機能し、Google Cloud の AI 対応の統合データ分析プラットフォームである BigQuery とネイティブに統合されています。このデータはその後、ダウンストリームの分析、可視化、AI アプリケーションに使用できます。このたび、ストリーミング データの取り込みと分析のさらなる簡素化を求めるお客様のニーズにお応えして、Pub/Sub の最新のイノベーションを発表いたしました。

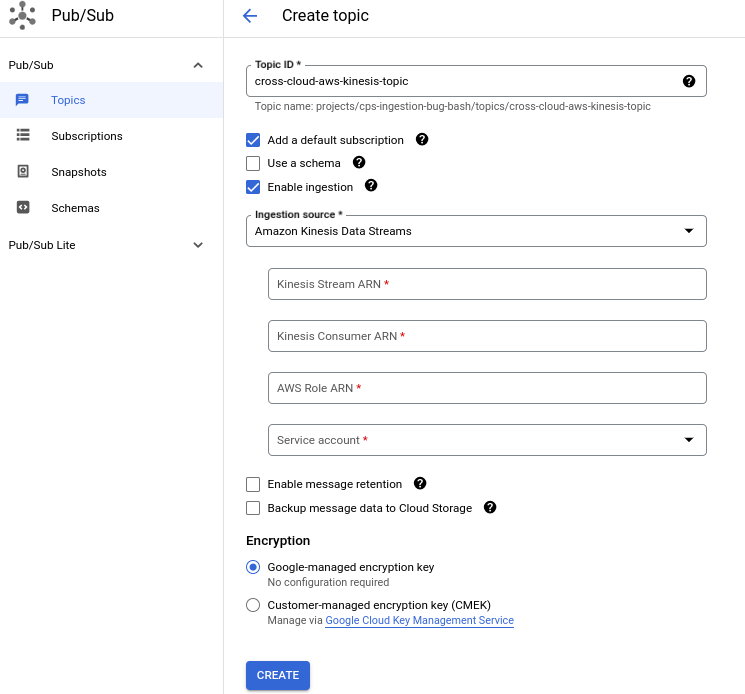

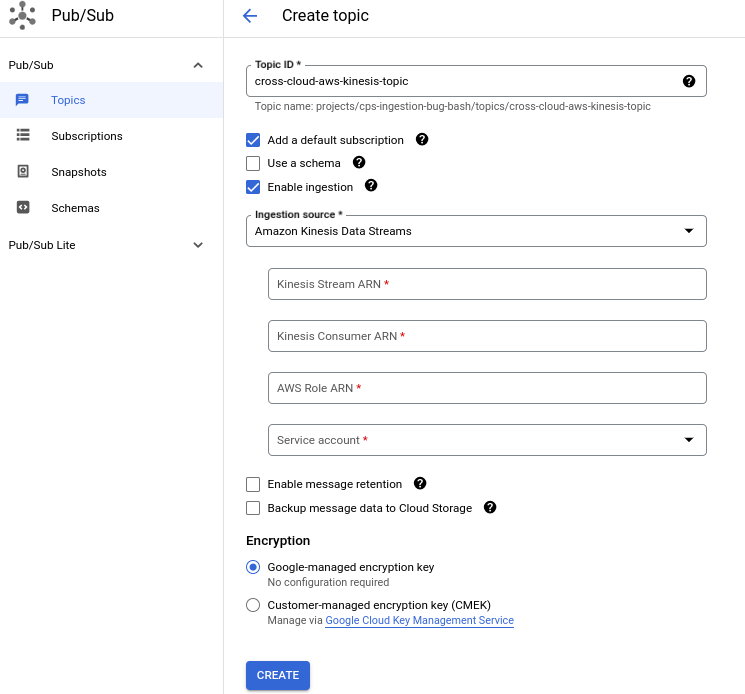

ワンクリック ストリーミング インポート(GA)

特定のワークロード(運用など)を 1 つのパブリック クラウドで実行し、分析ワークロードを別のパブリック クラウドで実行したいと考えている多くの組織で、マルチクラウド ワークロードが現実のものになりつつあります。一方で、ビジネスデータの全体像を把握するのが困難な場合があります。1 つのパブリック クラウドにデータを統合することで、データ フットプリント全体にわたって分析を実行できます。Google Cloud のお客様は、BigQuery にデータを統合して組織の信頼できる情報源とするのが一般的です。

AWS Kinesis Data Streams などの外部ソースからストリーミング データを Google Cloud に取り込むには、カスタム コネクタを構成、デプロイ、実行、管理、スケールする必要があります。また、ストリーミング取り込みパイプラインが想定どおりに実行されていることを確認するために、コネクタのモニタリングと保守も必要となります。先週、Kinesis Data Streams を皮切りに、外部ソースからストリーミング データを Pub/Sub トピックに取り込むノーコードのワンクリック機能をリリースしました。インポート トピック機能の一般提供(GA)が開始され、次のようなメリットをご利用いただけるようになりました。

-

データ パイプラインの簡素化: インポート トピック機能を使用することで、クラウド間のストリーミング データの取り込みパイプラインを合理化できます。これにより、カスタム コネクタの実行と管理のオーバーヘッドが除去されます。

-

自動スケーリング: マネージド インポート トピックを使用して作成されたストリーミング パイプラインは、受信スループットに応じてスケールアップおよびスケールダウンされます。

- すぐに使用できるモニタリング: インポート トピックをモニタリングするための 3 つの新しい Pub/Sub 指標をすぐにご利用いただけます。

インポート トピックでは、年内にもう一つの外部ソースとして Cloud Storage をサポートする予定です。

Pub/Sub Apache Flink コネクタを使用したストリーミング分析(GA)

Apache Flink は高度なストリーム処理とバッチ処理の機能を備えたオープンソースのストリーム処理フレームワークであり、さまざまな企業で導入されるようになってきています。多くの場合、お客様は Apache Flink とメッセージ サービスを併用することでストリーミング分析のユースケースを実現しています。このたび、Google Cloud Pub/Sub チームの積極的な支援のもと、Pub/Sub Flink コネクタの新しいバージョンの一般提供を開始いたしました。このコネクタは Apache 2.0 ライセンスに基づいた完全なオープン ソースであり、Google Cloud の GitHub リポジトリでホストされています。わずか数ステップで、コネクタを使用して既存の Apache Flink デプロイメントを Pub/Sub に接続できます。

このコネクタでは、Apache Flink 出力を Pub/Sub トピックにパブリッシュしたり、Pub/Sub サブスクリプションを Apache Flink アプリケーションのソースとして使用したりできます。コネクタの新しい GA バージョンには、複数の機能改善が加えられています。StreamingPull API を活用することで、最大スループットと低レイテンシを達成しています。メッセージ リースの自動延長のサポートも追加され、より長いチェックポイント間隔を設定できるようになりました。さらに、このコネクタは最新の Apache Flink のソース ストリーミング API をサポートしています。

エクスポート サブスクリプション エクスペリエンスの強化

Pub/Sub には BigQuery と Cloud Storage という 2 つの一般的なエクスポート サブスクリプションがあります。このたび、BigLake マネージド テーブル(Google Cloud 上にオープン形式のレイクハウスを構築するために最近発表された BigQuery の機能)にストリーミング データを取り込む簡単な方法として、BigQuery サブスクリプションをご利用いただけるようになりました。この方法を使用すると、ストリーミング データを Cloud Storage バケット内の Parquet または Iceberg 形式のファイルに変換できます。これらのエクスポート サブスクリプションに対する多くの機能強化もリリースしました。

BigQuery サブスクリプションでは、構造化データをシームレスに移動するさまざまな方法へのサポートを拡大しています。最大の変更点は、Pub/Sub トピックでスキーマを定義せずに、JSON データを BigQuery の列に書き込めるようになったことです。これまでは、トピックでスキーマを定義し、そのスキーマに一致したデータをパブリッシュするのが、データを列に取り込む唯一の方法でした。今後は、テーブル スキーマを使用する機能を活用し、Pub/Sub から BigQuery テーブルのスキーマを使用してテーブルに JSON メッセージを書き込むことができます。現在は基本的なデータ型がサポートされており、NUMERIC や DATETIME などのより高度なデータ型も間もなくサポートされる予定です。

データ型のサポートに関してもう一つお知らせします。BigQuery サブスクリプションでほとんどの Avro 論理型を処理できるようになりました。非ローカル タイムスタンプ型(BigQuery の TIMESTAMP 型と互換性あり)と小数型(BigQuery の NUMERIC 型および BIGNUMERIC 型と互換性あり、近日リリース)が BigQuery サブスクリプションでサポートされるようになりました。こうした論理型を使用することで、複数のパイプライン間でフィールドのセマンティックな意味を保持できます。

要望が特に多かったもう一つの機能として、カスタム サービス アカウントを指定する機能が BigQuery サブスクリプションと Cloud Storage サブスクリプションの両方に間もなく導入されます。現在、テーブルまたはバケットにメッセージを書き込むために使用できるのは、プロジェクトごとの Pub/Sub サービス アカウントのみです。そのため、アクセス権を付与すると、このプロジェクト全体のサービス アカウントを使用する権限を持つユーザーなら誰でも宛先に書き込むことができてしまいます。間もなく導入されるこの機能を使用すると、アクセスを特定のサービス アカウントに制限できます。

Cloud Storage サブスクリプションには、今後数か月以内に新しいバッチ オプションが追加され、各ファイル内の Pub/Sub メッセージの数に応じて Cloud Storage ファイルをまとめられるようになります。カスタムのダウンストリーム データレイク分析パイプラインをサポートするために、Cloud Storage ファイル名にカスタムの日時形式を指定することもできるようになります。さらに、トピック スキーマを使用して Cloud Storage バケットにデータを書き込めるようになります。

使ってみる

今回は、多様なユースケースでストリーミング データを活用するのに役立つさまざまな新機能をご紹介しました。マネージド インポートを使用して、クロスクラウド取り込みパイプラインを簡素化できるようになりました。ストリーミング分析のユースケースでは、Apache Flink と Pub/Sub を活用できます。さらに、強化されたエクスポート サブスクリプションを使用して、BigQuery または Cloud Storage にデータをシームレスに取り込めるようになりました。ビジネス上の課題の解決に今回ご紹介した Pub/Sub 機能をぜひご活用ください。

-Cloud Pub/Sub シニア プロダクト マネージャー、Prateek Duble

-Cloud Pub/Sub テクニカル リーダー、Kamal Aboul-Hosn