Colab Enterprise と生成 AI 用の MLOps で Vertex AI を強化

Google Cloud Japan Team

※この投稿は米国時間 2023 年 8 月 30 日に、Google Cloud blog に投稿されたものの抄訳です。

3 年前、Google は、AI ワークロードを加速するための最適な AI / ML プラットフォームを提供すること、そして組織が必要とするあらゆる ML ツールを 1 つのプラットフォームで提供することを目標として、Vertex AI をリリースしました。それ以来、多くの変化がありました。特に今年は、Vertex AI で生成 AI のサポートが追加されました。たとえば、一般的な生成 AI ユースケース向けのアプリを構築するためのデベロッパー フレンドリーなプロダクトが追加されたり、Google、オープンソース コントリビュータ、サードパーティ製の 100 を超える大規模モデルにアクセスしたりできるようになりました。

これにより、初めて AI に取り組むような多くのデベロッパーも含め、Vertex AI のユーザーが大幅に拡大しました。その一方で、データ サイエンスと ML エンジニアリングは依然として Google の中核であり続けています。この点を踏まえ、データ サイエンティストの生産性とコラボレーションの向上および組織による MLOps のより適切な管理を可能にする、Vertex AI の新しいプロダクトをいくつか発表します。

このたび公開プレビュー版がリリースされた Colab Enterprise は、9 月に一般提供の開始が予定されています。これは、Google の Colab ノートブックの使いやすさとエンタープライズ レベルのセキュリティおよびコンプライアンスのサポート機能を組み合わせたマネージド サービスを提供するものです。データ サイエンティストは Colab Enterprise を使用して、Vertex AI プラットフォームの全機能へのアクセス、直接データアクセスのための BigQuery とのインテグレーション、さらにはコードの補完と生成を行い、AI ワークフローを協調的に加速させることができます。

また、Google は AI ワークロードを効率的にスケールするための、Vertex AI での Ray を発表し、Vertex AI のオープンソース サポートも拡張しています。さらに、複数のモダリティにわたるチューニングやモデル評価を可能にし、Vertex AI Feature Store の新バージョンでエンべディングのサポートを追加することで、生成 AI 用の MLOps への取り組みを継続的に推し進めています。これにより、お客様はプロトタイピングや試験運用から本番環境でのモデルのデプロイと管理に至るまで、AI / ML ワークフロー全体にわたって必要な機能を活用できます。これらの発表と、それが組織の AI 運用の推進にどのように役立つかについて詳しく見てみましょう。

Colab を Google Cloud で利用してコラボレーションと生産性を向上

既存の基盤モデルのカスタマイズや新しいモデルの開発のプロセスでは、重要な試験運用、コラボレーション、そしてイテレーションを行います。これらのタスクは通常、データ サイエンティストがノートブックを使用して行いますが、適切なセキュリティやガバナンスがない、または AI / ML の作業に適したハードウェアを利用できない状態で、ローカル ノートパソコンでサイロ化されたデータを扱うこともよくあります。

Google Research によって開発された Colab は、ブラウザで実行される人気のクラウドベース Jupyter ノートブックであり、1 か月のアクティブ ユーザー数は 700 万を超えています。Python コードを実行でき、プロジェクトとインサイトの共有を容易にし、チャート、イメージ、HTML、LaTeX などをサポートしています。Fortune 100 企業の 67% ですでに Colab を使用していただいていますが、このたび、これらの強固な機能を Google Cloud のエンタープライズ対応のセキュリティ、データ管理、信頼性と組み合わせて提供できることになりました。

データ サイエンティストは、すぐに利用を開始できます。構成の必要はありません。Colab Enterprise を Vertex AI で使用すると、Model Garden やさまざまなチューニング ツールから、フレキシブルなコンピューティング リソースやマシンタイプ、データ サイエンス、MLOps ツールに至るまで、Vertex AI ePlatform が提供するすべてのサービスをご利用いただけます。

Colab Enterprise は、BigQuery Studio のノートブック エクスペリエンスも提供します。これは、BigQuery でのデータの検出、探索、分析、予測を容易にする新しい統合コラボレーション ワークスペースです。Colab Enterprise を使用すると、BigQuery でノートブックを起動してデータの探索と準備を行った後、その同じノートブックを Vertex AI で開いて、専用の AI インフラストラクチャとツールで作業を続けることができます。チームはどこで作業していてもデータに直接アクセスできます。Colab Enterprise では、複数のチームメンバーや環境の間でノートブックを共有できるため、データと AI ワークロードの間の境界線を実質的に取り除くことができます。

オープンソースのサポートの拡張により、作業の柔軟性が向上

データ サイエンス チームがそれぞれ好きなやり方で作業できるように、Vertex AI は Tensorflow、PyTorch、scikit-learn、XGBoost などのさまざまなオープンソース フレームワークをサポートしています。そしてこのたび、AI と Python のワークロードをスケーリングするためのオープンソース統合コンピューティング フレームワークである Ray のサポートを追加したことをお知らせいたします。

Vertex AI での Ray は、エンタープライズ クラスのマネージド セキュリティ、生産性の向上、費用対効果と業務効率の向上を実現します。Colab Enterprise、Training、Predictions、MLOps 機能のような Vertex AI プロダクト間のインテグレーションにより、Vertex AI での Ray を既存のワークフロー内で簡単に実装できます。

Colab Enterprise と Vertex AI での Ray がどのように連携するかを理解するために、データ サイエンティストは Vertex AI の Model Garden から始めるとよいでしょう。Model Garden では、Llama 2、Dolly、Falcon、Stable Diffusion などの幅広いオープンソース モデルから選択できます。ワンクリックでこれらのモデルを Colab Enterprise ノートブックで開いて、試験運用、チューニング、プロトタイピングをすぐに始めることができます。Vertex AI での Ray は、スケーラビリティとパフォーマンスに優れているうえ、強化学習のサポートが組み込まれているため、オープンな生成 AI モデルをトレーニングし、コンピューティング リソースを最大限に活用するのに最適です。Vertex AI で Ray を使用すると、チームは簡単に Ray クラスタを作成し、それを Colab Enterprise ノートブックに接続してトレーニング ジョブをスケールできます。ノートブックから簡単に、フルマネージドの自動スケーリング エンドポイントにモデルをデプロイできます。

Vertex AI での Ray の使いやすさについて、すでにお客様から大きな反響をいただいています。

「サプライ チェーン業界は、注文量の急増から商品不足、消費者の購買パターンの変化に至るまで、多くの課題に直面してきました。ビジネスはデータドリブンであるだけでなく、AI ドリブンであることも重要です。Vertex で Ray を使用すると、トレーニング手順をスケールアップし、ML エージェントと強化学習エージェントをトレーニングして、さまざまな倉庫稼働状態にわたって最適化を容易に行うことができます」と、マテリアル ハンドリング、ソフトウェア、サービスを取り扱う Dematic の主任 AI サイエンティストである Matthew Haley 氏と、シニア AI サイエンティストの Murat Cubuktepe 氏は述べています。「私たちは、Vertex AI によるこうした改善を生かして、お客様がサプライ チェーンの混乱を切り抜けながら費用の削減に取り組むお手伝いをいたします。」

生成 AI の時代における包括的な MLOps を実装

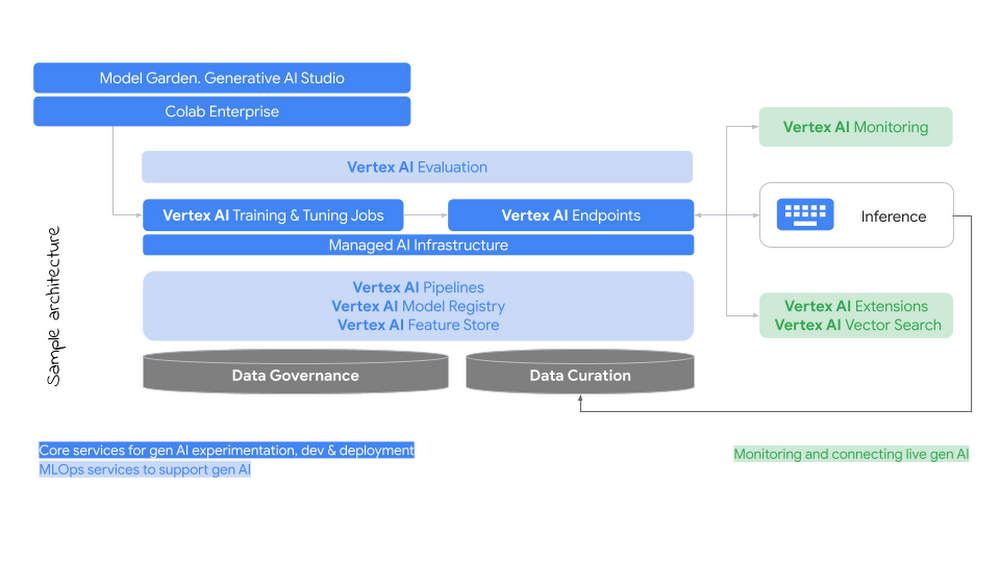

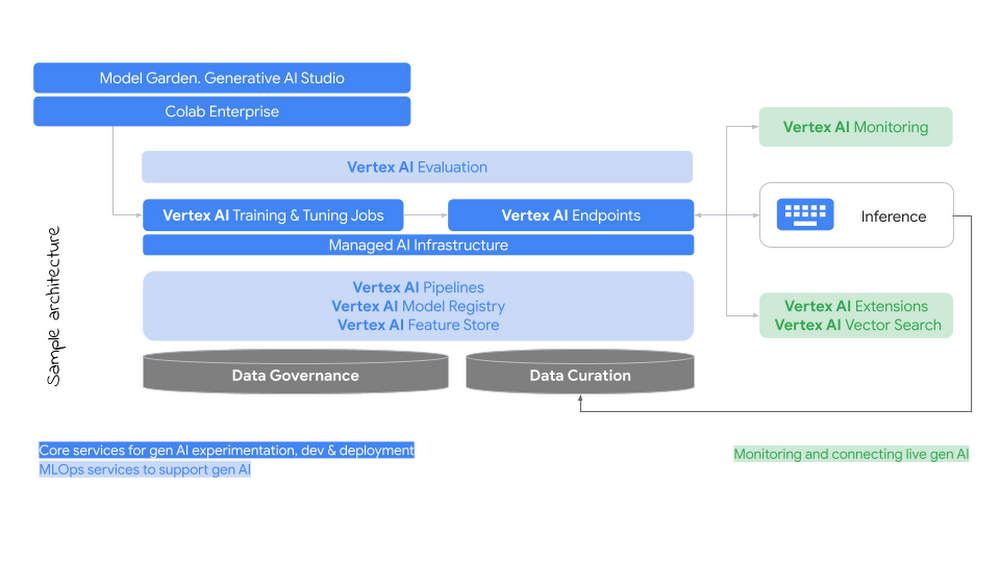

お客様から、生成 AI によって MLOps の要件がどのように変わるのかという質問をよくいただきます。私たちは、MLOps の既存の投資を放棄する必要はないと考えています。エンタープライズ データを使用したモデルのカスタマイズ、中央リポジトリでのモデルの管理、パイプラインを介したワークフローのオーケストレーション、エンドポイントやバッチ処理を使用した本番環境へのモデルのデプロイ、本番環境でのモデルのモニタリングなど、ベスト プラクティスおよび要件の多くはこれまでと変わりません。

とは言え、生成 AI により新たな課題が生まれるため、次のような領域については組織が MLOps 戦略を更新しなければならない可能性があります。

AI Infrastructure の管理: 生成 AI では、モデルのサイズが拡大するにつれて、トレーニング、チューニング、サービングに関する AI Infrastructure の要件が増加します。

新しい手法によるカスタマイズ: プロンプト エンジニアリング、教師ありチューニング、人間によるフィードバックを用いた強化学習(RLHF)において、さまざまな手法によりこうしたマルチタスク モデルをカスタマイズする方法が増加しています。

新しいタイプのアーティファクトの管理: 生成 AI では、プロンプト、チューニング パイプライン、エンべディングに関連する新しいガバナンス要件が導入されます。

生成された出力のモニタリング: 本番環境で使用する場合は、責任ある AI 機能を使用して、安全と列挙のために生成された出力を継続的にモニタリングすることが不可欠です。

エンタープライズ データのキュレートと接続: 多くのユースケースにおいて、モデルには内部システムとデータコーパスからの最新で関連性のあるデータが必要です。結果の信頼性を高めるには、事実と引用に基づいたグラウンディングを行うことが重要になります。

パフォーマンスの評価: 生成されたコンテンツやタスクの品質を評価する方法の決定は、予測 ML の場合とは意味合いが大きく異なります。

エンタープライズ対応であることは、Google の生成 AI に対するアプローチの中核となるものです。これらの課題への取り組みの支援として、予測 AI と生成 AI に対応する新しい MLOps フレームワークを開発しました。

20 年にわたって先進的な AI / ML ワークロードを大規模に実行してきた経験が Vertex AI に注ぎ込まれているため、今ある機能の多くは生成 AI のニーズをよく満たしています。GPU と TPU の両方を含む幅広いハードウェアの選択肢があることで、チームは大規模モデルに最適化された AI Infrastructure を選択でき、望ましい価格とパフォーマンスを実現できます。Vertex AI Pipelines は、チューニング パイプラインまたは人間によるフィードバックを用いた強化学習(RLHF)パイプラインのオーケストレーションと実行をサポートしています。モデル レジストリでは、予測モデルだけでなく生成 AI モデルのライフサイクルも管理できます。データ サイエンティストは連携して新しいアーティファクトを共有および再利用できるほか、CI / CD プロセスを介してバージョン管理やデプロイを行うこともできます。

新しい機能によって、本番環境で生成 AI を効果的に使用するための強固な基盤も提供されます。Google Cloud は、オープンソース、ファースト パーティ、サードパーティのモデルを含む、ハイパースケール クラウド プロバイダからの厳選されたモデルのみを提供します。また、教師ありチューニングや RLHF など、さまざまなチューニング方法をサポートしています。セキュリティ機能、安全機能、バイアス機能が組み込まれており、すべて Google の責任ある AI に関する原則に基づいています。さらに、外部データソースと機能の拡張も新たに発表されました。

本日は、生成 AI 用の MLOps をさらに強化する次のような新機能をご紹介します。

複数のモダリティにわたるチューニング: PaLM 2 for Text で教師ありチューニングを一般提供し、RLHF を公開プレビュー版に導入します。また、スタイル チューニングと呼ばれる Imagen の新しいチューニング方法も導入します。これにより、企業はわずか 10 枚の参照画像で、特定のブランド取り扱いガイドラインやその他のクリエイティブ ニーズに合った画像を作成できます。

モデルの評価: 2 つの新機能によって、組織はモデルの品質を体系的に評価できるようになり、継続的なイテレーションと改善を推進できます。1 つは Automatic Metrics で、定義されたタスクと「正解(グラウンド トゥルース)」データセットに基づいてモデルが評価されます。もう 1 つは Automatic Side by Side で、大規模モデルを使用してテスト対象の複数のモデルの出力を評価することで、人間による評価を大規模に補強します。

エンべディングをサポートする Feature Store: データの重複を回避し、データアクセス ポリシーを保持できるように BigQuery 上に構築された、次世代の Vertex AI Feature Store を導入します。この新しい Feature Store は、ベクトル エンベディング データ型をネイティブにサポートしているため、非構造化データをリアルタイムで保存、管理、取得するために必要なインフラストラクチャを簡素化できます。

「Vertex AI Feature Store の新機能は、我々のチームに運用面での大きな利点をもたらします」と、e コマース企業 Wayfair のシニア ML エンジニアである Gabriele Lanaro 氏は述べています。「次のような分野で全体的な改善が期待されます。

推論とトレーニング - ネイティブの BigQuery オペレーションは高速で直感的に使用できるため、MLOps パイプラインが簡素化されるだけでなく、データ サイエンティストがスムーズに試験運用を実施できるようになります。

機能の共有 - 使い慣れた権限管理機能を搭載した BigQuery データセットを使用することで、既存のツールを用いてデータのカタログ化を改善できます。

エンべディングのサポート - 詐欺検出のための顧客行動のエンコードなど、多くのアプリケーションで社内アルゴリズムによって生成されたカスタム ベクトル エンべディングを活用します。ベクトルが Vertex AI Feature Store の最高レベルの構成要素になったことは喜ばしいことです。メンテナンスが必要なシステムの数を減らすことで、MLOps は他のタスクに時間をかけられるため、チームはより短時間でモデルを本番環境に導入できるようになります。」

生成 AI 用の MLOps - リファレンス アーキテクチャ

AI があらゆる企業に深く根を下ろし、組織全体で AI のユースケースに取り組む従業員が増えるにつれて、AI プラットフォームの重要性はますます高まっています。私たちは、エンタープライズ対応の AI に必要な機能を利用して、今日のイノベーションのペースに合わせて進んでいくことを目指しています。

詳しい情報を確認して Colab Enterprise の使用を開始するには、ドキュメントをご覧ください。生成 AI の管理について詳しくは、Google の AI 導入フレームワークに基づいた新しい AI Readiness Quick Check ツールをご確認ください。

- プロダクト管理、Cloud AI 担当シニア ディレクター、Warren Barkley