In dieser Anleitung wird beschrieben, wie Sie mit Schutz sensibler Daten eine BigQuery-Tabelle prüfen und die Prüfungsergebnisse an Data Catalog senden.

Sie können zusätzlich eine Datenprofilerstellung durchführen, die sich von einem Prüfvorgang unterscheidet. Sie können auch Datenprofile an Dataplex Universal Catalog senden. Weitere Informationen finden Sie unter Tabellen im Dataplex Universal Catalog anhand von Erkenntnissen aus Datenprofilen taggen.

Data Catalog ist ein skalierbarer Dienst zur Metadatenverwaltung, mit dem Sie alle Ihre Daten in Google Cloudschnell finden, verwalten und verstehen können.

Sensitive Data Protection ist in Data Catalog integriert. Wenn Sie mit einer Aktion zum Schutz sensibler Daten Ihre BigQuery-Tabellen nach sensiblen Daten untersuchen, können Ergebnisse direkt in Form einer Tag-Vorlage an Data Catalog gesendet werden.

In dieser Anleitung führen Sie folgende Schritte aus:

- Aktivieren Sie Data Catalog und Sensitive Data Protection.

- Richten Sie den Schutz sensibler Daten ein, um eine BigQuery-Tabelle zu prüfen.

- Sie konfigurieren eine Prüfung auf sensible Daten, um die Prüfungsergebnisse an Data Catalog zu senden.

Weitere Informationen zu Data Catalog finden Sie in der Data Catalog-Dokumentation.

Wenn Sie die Ergebnisse von Datenprofilerstellungsvorgängen (nicht von Prüfjobs) an Dataplex Universal Catalog senden möchten, lesen Sie stattdessen die Dokumentation zum Erstellen von Profilen für eine Organisation oder einen Ordner oder für ein Projekt.

Kosten

In diesem Dokument verwenden Sie die folgenden kostenpflichtigen Komponenten von Google Cloud:

- Sensitive Data Protection

- BigQuery

Mit dem Preisrechner können Sie eine Kostenschätzung für Ihre voraussichtliche Nutzung vornehmen.

Hinweise

Bevor Sie Ergebnisse der Überprüfung zum Schutz sensibler Daten an Data Catalog senden können, müssen Sie Folgendes tun:

- Schritt 1: Abrechnung einrichten

- Schritt 2: Neues Projekt erstellen und neue BigQuery-Tabelle füllen. (Optional)

- Schritt 3: Data Catalog aktivieren.

- Schritt 4: Schutz sensibler Daten aktivieren.

In den folgenden Unterabschnitten wird jeder Schritt detailliert beschrieben.

Schritt 1: Abrechnung einrichten

Sie müssen zuerst ein Rechnungskonto einrichten, falls Sie noch keines haben.

Weitere Informationen zum Aktivieren der Abrechnung

Schritt 2: Neues Projekt erstellen und neue BigQuery-Tabelle füllen (optional)

Wenn Sie dieses Feature für Produktionszwecke einrichten oder bereits eine BigQuery-Tabelle haben, die Sie untersuchen möchten, öffnen Sie dasGoogle Cloud -Projekt, das die Tabelle enthält. Fahren Sie dann mit Schritt 3 fort.

Wenn Sie dieses Feature ausprobieren und Testdaten untersuchen möchten, erstellen Sie ein neues Projekt. Für diesen Schritt benötigen Sie die IAM-Rolle Projektersteller. Weitere Informationen zu IAM-Rollen

- Rufen Sie in der Google Cloud Console die Seite Neues Projekt auf.

- Wählen Sie in der Drop-down-Liste Rechnungskonto das Rechnungskonto aus, dem das Projekt in Rechnung gestellt werden soll.

- Wählen Sie in der Drop-down-Liste Organisation die Organisation aus, in der Sie das Projekt erstellen möchten.

- Wählen Sie in der Drop-down-Liste Speicherort die Organisation oder den Ordner aus, in dem Sie das Projekt erstellen möchten.

- Klicken Sie auf Erstellen, um das Projekt zu erstellen.

Laden Sie anschließend die Beispieldaten herunter und speichern Sie diese:

- Öffnen Sie das Repository für Anleitungen zu Cloud Run-Funktionen auf GitHub.

- Wählen Sie eine der CSV-Dateien mit Beispieldaten aus und laden Sie die Datei herunter.

- Rufen Sie als Nächstes in der Google Cloud -Console BigQuery auf.

- Wählen Sie Ihr Projekt aus.

- Klicken Sie auf Dataset erstellen.

- Klicken Sie auf Tabelle erstellen.

- Klicken Sie auf Hochladen und wählen Sie die Datei aus, die Sie hochladen möchten.

- Geben Sie der Tabelle einen Namen und klicken Sie dann auf Tabelle erstellen.

Schritt 3: Data Catalog aktivieren.

Aktivieren Sie als Nächstes Data Catalog für das Projekt, das die BigQuery-Tabelle enthält, die Sie mit dem Schutz sensibler Daten prüfen möchten.

So aktivieren Sie Data Catalog über die Google Cloud Console:

- Registrieren Sie Ihre Anwendung für Data Catalog.

- Wählen Sie auf der Registrierungsseite in der Drop-down-Liste Projekt erstellen das Projekt aus, das Sie mit Data Catalog verwenden möchten.

- Klicken Sie nach der Auswahl des Projekts auf Weiter.

Data Catalog ist jetzt für Ihr Projekt aktiviert.

Schritt 4: Schutz sensibler Daten aktivieren

Aktivieren Sie den Schutz sensibler Daten für das Projekt, für das Sie Data Catalog aktiviert haben.

So aktivieren Sie den Schutz sensibler Daten über die Google Cloud Console:

- Registrieren Sie Ihre Anwendung für Sensitive Data Protection.

- Wählen Sie auf der Registrierungsseite in der Drop-down-Liste Projekt erstellen das Projekt aus, das Sie im vorherigen Schritt ausgewählt haben.

- Klicken Sie nach der Auswahl des Projekts auf Weiter.

Der Schutz sensibler Daten ist jetzt für Ihr Projekt aktiviert.

Inspektionsjob für Schutz sensibler Daten konfigurieren und ausführen

Sie können einen Job zum Schutz sensibler Daten entweder über die Google Cloud -Console oder die DLP API konfigurieren und ausführen.

Data Catalog-Tag-Vorlagen werden im selben Projekt und in derselben Region wie die BigQuery-Tabelle gespeichert. Wenn Sie eine Tabelle aus einem anderen Projekt untersuchen, müssen Sie dem Sensitive Data Protection-Dienst-Agent im Projekt, in dem sich die BigQuery-Tabelle befindet, die Rolle „Data Catalog TagTemplate Owner“ (roles/datacatalog.tagTemplateOwner) zuweisen.

Google Cloud Console

So richten Sie einen Prüfjob für eine BigQuery-Tabelle mit dem Schutz sensibler Daten ein:

Rufen Sie in der Google Cloud Console im Bereich „Schutz sensibler Daten“ die Seite Job oder Job-Trigger erstellen auf.

Geben Sie die Informationen zum Job für den Schutz sensibler Daten ein und klicken Sie auf Weiter, um die einzelnen Schritte abzuschließen:

Geben Sie für Schritt 1: Eingabedaten auswählen einen Namen für den Job im Feld Name ein. Wählen Sie unter Speicherort im Menü Speichertyp die Option BigQuery aus und geben Sie die Informationen für die zu untersuchende Tabelle ein. Der Bereich Probenahme ist zur Ausführung einer Stichprobenprüfung für Ihre Daten vorkonfiguriert. Sie können die Felder Zeilen beschränken durch und Maximale Zeilenanzahl anpassen, um bei großen Datenmengen Ressourcen zu sparen. Weitere Informationen finden Sie unter Eingabedaten auswählen.

(Optional) In Schritt 2: Erkennung konfigurieren können Sie festlegen, nach welchen Datentypen (infoTypes) gesucht werden soll. Lassen Sie für diese Anleitung die Standard-infoTypes ausgewählt. Weitere Informationen finden Sie unter Erkennung konfigurieren.

Aktivieren Sie für Schritt 3: Aktionen hinzufügen die Option In Data Catalog speichern.

(Optional) Übernehmen Sie für Schritt 4: Zeitplan bei dieser Anleitung die Menüoption Keiner, wenn die Überprüfung nur einmal ausgeführt werden soll. Weitere Informationen zum Planen wiederkehrender Inspektionsaufträge finden Sie unter Planen.

Klicken Sie auf Erstellen. Der Job wird sofort ausgeführt.

DLP API

In diesem Abschnitt konfigurieren Sie einen Job zur Prüfung auf sensible Daten und führen ihn aus.

Der hier konfigurierte Inspektionsjob weist Sensitive Data Protection an, entweder die in Schritt 2 beschriebenen BigQuery-Beispieldaten oder Ihre eigenen BigQuery-Daten zu prüfen. In der von Ihnen angegebenen Jobkonfiguration weisen Sie Sensitive Data Protection außerdem an, die Inspektionsergebnisse in Data Catalog zu speichern.

Schritt 1: Projektkennung notieren

Rufen Sie die Google Cloud Console auf.

Klicken Sie auf Auswählen.

Wählen Sie in der Drop-down-Liste Auswählen aus die Organisation aus, für die Sie Data Catalog aktiviert haben.

Kopieren Sie unter ID die Projekt-ID des Projekts, das die Daten enthält, die Sie prüfen möchten. Dies ist das Projekt, das im Schritt Speicher-Repositories festlegen weiter oben auf dieser Seite beschrieben wurde.

Klicken Sie unter Name auf das Projekt, um es auszuwählen.

Schritt 2: APIs Explorer öffnen und den Job konfigurieren

Rufen Sie APIs Explorer auf der Referenzseite für die Methode

dlpJobs.createauf. Damit diese Anleitung verfügbar bleibt, klicken Sie mit der rechten Maustaste auf den folgenden Link und öffnen Sie ihn in einem neuen Tab oder Fenster:Geben Sie im Feld parent Folgendes ein, wobei project-id die Projekt-ID ist, die Sie zuvor notiert haben:

projects/project-id

Kopieren Sie als Nächstes den folgenden JSON-Code. Wählen Sie den Inhalt des Felds Anfragetext im APIs Explorer aus und fügen Sie den JSON-Code ein, um den Inhalt zu ersetzen. Ersetzen Sie die Platzhalter

project-id,bigquery-dataset-nameundbigquery-table-namejeweils durch die tatsächliche Projekt-ID sowie die Namen der BigQuery-Datasets und -Tabellen.{ "inspectJob": { "storageConfig": { "bigQueryOptions": { "tableReference": { "projectId": "project-id", "datasetId": "bigquery-dataset-name", "tableId": "bigquery-table-name" } } }, "inspectConfig": { "infoTypes": [ { "name": "EMAIL_ADDRESS" }, { "name": "PERSON_NAME" }, { "name": "US_SOCIAL_SECURITY_NUMBER" }, { "name": "PHONE_NUMBER" } ], "includeQuote": true, "minLikelihood": "UNLIKELY", "limits": { "maxFindingsPerRequest": 100 } }, "actions": [ { "publishFindingsToCloudDataCatalog": {} } ] } }

Weitere Informationen zu den verfügbaren Prüfoptionen finden Sie unter Speicher und Datenbanken auf sensible Daten prüfen. Eine vollständige Liste der Informationstypen, die Sensitive Data Protection prüfen kann, finden Sie in der Referenz zu InfoTypes.

Schritt 3: Anfrage ausführen, um den Prüfjob zu starten

Nachdem Sie den Job mithilfe der vorherigen Schritte konfiguriert haben, klicken Sie auf Ausführen, um die Anfrage zu senden. Wenn die Anfrage erfolgreich ist, wird eine Antwort mit einem Erfolgscode und einem JSON-Objekt angezeigt, das den Status des gerade erstellten Sensitive Data Protection-Jobs angibt.

Die Antwort auf Ihre Inspektionsanfrage enthält die Job-ID des Inspektionsjobs als "name"-Schlüssel und den aktuellen Status des Inspektionsjobs als "state"-Schlüssel. Da Sie die Anfrage gerade gesendet haben, lautet der Jobstatus in diesem Moment "PENDING".

Status des Inspektionsjobs für den Schutz sensibler Daten prüfen

Nachdem Sie die Prüfanfrage gesendet haben, wird der Prüfjob sofort gestartet.

Google Cloud Console

So prüfen Sie den Status des Inspektionsjobs:

Öffnen Sie in der Google Cloud Console den Schutz sensibler Daten.

Klicken Sie auf den Tab Jobs und Job-Trigger und dann auf Alle Jobs.

Der Job, den Sie gerade ausgeführt haben, befindet sich wahrscheinlich ganz oben in der Liste. Prüfen Sie in der Spalte Status, ob der Status Fertig lautet.

Sie können auf die Job-ID des Jobs klicken, um die Ergebnisse aufzurufen. Auf jeden infoType-Detektor, der auf der Seite "Jobdetails" aufgelistet ist, folgt die Anzahl der Übereinstimmungen, die im Inhalt gefunden wurden.

DLP API

So prüfen Sie den Status des Inspektionsjobs:

Klicken Sie auf die folgende Schaltfläche, um APIs Explorer auf der Referenzseite für die Methode

dlpJobs.getaufzurufen:Geben Sie im Feld Name den Namen des Jobs aus der JSON-Antwort auf die Prüfanfrage im folgenden Format ein:

projects/project-id/dlpJobs/job-id

i-1234567890123456789.Zum Absenden der Anfrage klicken Sie auf Ausführen.

Wenn der Schlüssel "state" des JSON-Antwortobjekts angibt, dass der Job "DONE" ist, bedeutet dies, dass der Prüfjob abgeschlossen ist.

Scrollen Sie die Seite nach unten, um den Rest des JSON-Antwortcodes anzusehen. Unter "result" > "infoTypeStats" sollte jeder aufgeführte Informationstyp einen entsprechenden "count" haben. Wenn nicht, prüfen Sie, ob Sie den JSON-Code richtig eingegeben haben und der Pfad oder Speicherort Ihrer Daten korrekt ist.

Nachdem der Inspektionsjob abgeschlossen ist, können Sie mit dem nächsten Abschnitt dieser Anleitung fortfahren, um die Inspektionsergebnisse im Security Command Center anzusehen.

Ergebnisse der Sensitive Data Protection-Prüfung in Data Catalog ansehen

Da Sie Sensitive Data Protection angewiesen haben, die Ergebnisse des Inspektionsjobs an Data Catalog zu senden, können Sie jetzt die automatisch erstellten Tags und die Tag-Vorlage in der Data Catalog-Benutzeroberfläche ansehen:

- Rufen Sie in der Google Cloud Console die Seite „Data Catalog“ auf.

- Suchen Sie nach der Tabelle, die Sie geprüft haben.

- Klicken Sie auf die Ergebnisse, die Ihrer Tabelle entsprechen, um die Metadaten der Tabelle anzusehen.

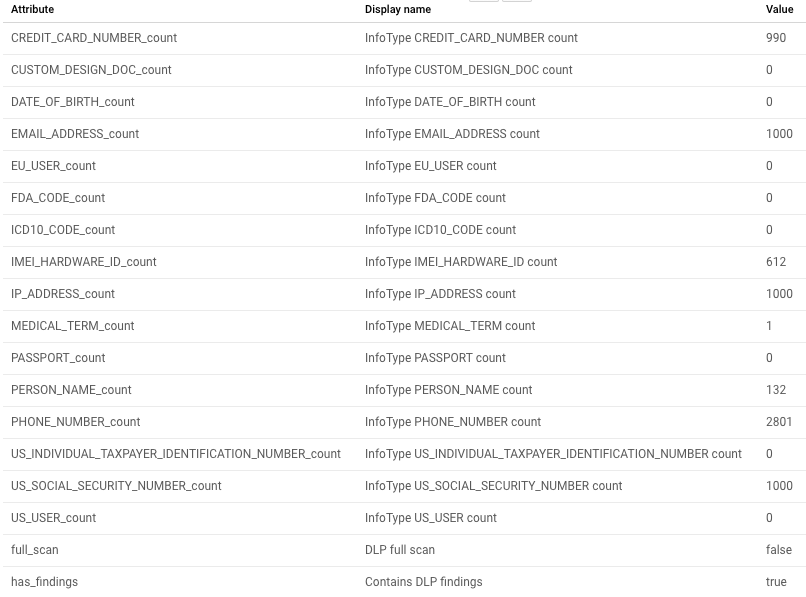

Der folgende Screenshot zeigt die Data Catalog-Metadatenansicht einer Beispieltabelle:

Zusammenfassung der Inspektion

Die Ergebnisse von Sensitive Data Protection sind im Zusammenfassungsformat für die geprüfte Tabelle enthalten. Diese Zusammenfassung enthält die infoType-Gesamtzahl sowie Übersichtsdaten zum Inspektionsjob, die Datumsangaben und die ID der Jobressource enthalten.

Alle infoTypes, die geprüft wurden, werden aufgelistet. In diesen Ergebnissen wird eine Anzahl größer null angezeigt.

Bereinigen

Führen Sie einen der folgenden Schritte aus, um zu vermeiden, dass Ihrem Google Cloud -Konto die in diesem Thema verwendeten Ressourcen in Rechnung gestellt werden, je nachdem, ob Sie Beispieldaten oder Ihre eigenen Daten verwendet haben:

- Beispieldaten: Löschen Sie das von Ihnen erstellte Projekt.

- Eigene Daten: Löschen Sie den von Ihnen erstellten Job zum Schutz sensibler Daten.

Projekt löschen

Am einfachsten vermeiden Sie unnötige Kosten, wenn Sie das durch Befolgen der Anweisungen in diesem Thema erstellte Projekt löschen.

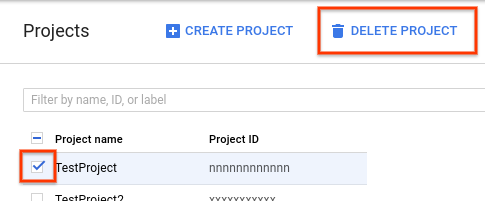

So löschen Sie das Projekt:

- Rufen Sie in der Google Cloud Console die Seite „Projekte“ auf.

- Wählen Sie in der Projektliste das Projekt aus, das Sie löschen möchten, und klicken Sie auf Projekt löschen.

- Geben Sie im Dialogfeld die Projekt-ID ein und klicken Sie auf Beenden, um das Projekt zu löschen.

Wenn Sie Ihr Projekt mit dieser Methode löschen, werden auch der von Ihnen erstellte Sensitive Data Protection-Job und der Cloud Storage-Bucket gelöscht. Es ist nicht notwendig, die Anweisungen in den folgenden Abschnitten zu befolgen.

Job oder Job-Trigger für den Schutz sensibler Daten löschen

Wenn Sie Ihre eigenen Daten geprüft haben, löschen Sie den gerade erstellten Prüfjob oder Job-Trigger.

Google Cloud Console

Öffnen Sie in der Google Cloud Console den Schutz sensibler Daten.

Klicken Sie auf den Tab Jobs und Job-Trigger und dann auf den Tab Job-Trigger.

Klicken Sie in der Spalte Aktionen für den zu löschenden Job-Trigger auf das Dreipunktmenü und dann auf Löschen.

Optional können Sie auch die Jobdetails für den ausgeführten Job löschen. Klicken Sie auf den Tab Alle Jobs. In der Spalte Aktionen für den zu löschenden Job klicken Sie auf das Dreipunktmenü und dann auf Löschen.

DLP API

Klicken Sie auf die folgende Schaltfläche, um APIs Explorer auf der Referenzseite für die Methode

dlpJobs.deleteaufzurufen:Geben Sie im Feld Name den Namen des Jobs aus der JSON-Antwort auf die Inspektionsanfrage ein, der folgende Form hat:

projects/project-id/dlpJobs/job-id

i-1234567890123456789.

Wenn Sie zusätzliche Inspektionsjobs erstellt haben oder den Job erfolgreich löschen möchten, können Sie alle vorhandenen Jobs auflisten:

Klicken Sie auf die folgende Schaltfläche, um APIs Explorer auf der Referenzseite für die Methode

dlpJobs.listaufzurufen:Geben Sie im Feld Parent die Projektkennung in der folgenden Form ein, wobei project-id Ihre Projekt-ID ist:

projects/project-id

Klicken Sie auf Execute.

Wenn in der Antwort keine Jobs aufgeführt sind, haben Sie alle Jobs gelöscht. Wenn Jobs in der Antwort aufgeführt sind, wiederholen Sie den oben beschriebenen Löschvorgang für diese Jobs.

Nächste Schritte

- Weitere Informationen zur Aktion

publishFindingsToCloudDataCatalogim Schutz sensibler Daten. - Weitere Informationen zum Erstellen benutzerdefinierter Tags oder Tags auf Spaltenebene in Data Catalog basierend auf Sensitive Data Protection-Ergebnissen

- Speicher-Repositories mithilfe des Schutzes sensibler Daten auf sensible Daten prüfen

- Mehr zur Verwendung von Data Catalog