HITL 라벨러 워크벤치는 문서 엔티티를 추출된 라벨에 매핑하는 WYSIWYG (What You See Is What You Get) 인터페이스를 제공하므로 라벨러가 쉽게 비교하고 수정할 수 있습니다. 인간 라벨러에게 어떤 라벨을 찾아 추가해야 하는지, Document AI 모델이나 HITL의 검증 필터에서 누락된 경우를 안내하는 안내 문서가 필요합니다. 여기에는 다음이 포함됩니다.

- 검토할 라벨입니다.

- 필수 또는 선택 입력란이 있는지 여부입니다.

- 라벨 수정 (예: 미국이 지정되지 않은 미국 주소에 'USA' 추가)

- 올바른 거부 필드가 있는 문서를 거부합니다(예: 인보이스가 10,000달러를 초과하는 경우 거부).

- 스키마 라벨에 매핑되는 문서의 특수 라벨 이름으로, 라벨러가 이를 추가할 수 있습니다(예: '고객 번호' = '계정 번호').

- 이는 HITL 작업 구성에서 필터로 설정할 수 있습니다.

효과적인 안내 설계

효과적인 안내는 양질의 수동 라벨링 결과를 보장하는 데 가장 중요한 요소입니다. 효과적인 안내는 수동 라벨러에게 원하는 작업 방식을 알려주는 안내입니다. 다음은 효과적인 안내 작성에 관한 몇 가지 가이드라인입니다.

- 수동 라벨러는 사용자의 도메인 관련 지식을 보유하고 있지 않을 수 있습니다. 라벨러에게 전달하는 지침은 사용 사례를 잘 모르는 사람도 쉽게 이해할 수 있어야 합니다.

- 안내가 너무 길면 안 됩니다. 라벨러가 20분 안에 살펴보고 이해할 수 있을 정도의 길이가 가장 좋습니다.

- 안내는 태스크의 개념과 데이터에 라벨을 지정하는 방법을 모두 설명해야 합니다.

- 안내에 대응하는 라벨 세트가 포함되어 있다면 안내는 해당 세트에 있는 모든 라벨에 적용될 수 있어야 합니다. 안내에 있는 라벨 이름은 라벨 세트에 있는 이름과 일치해야 합니다.

- 일반적으로 이 과정을 몇 번 거쳐야 효과적인 안내가 완성됩니다. 먼저 작은 데이터 세트에 라벨을 지정한 다음 결과를 바탕으로 안내를 수정하는 방법을 권장합니다.

효과적인 안내에는 다음 항목이 포함되어야 합니다.

- 라벨 목록 및 설명: 사용된 라벨을 모두 나열하고 각 라벨의 의미를 설명합니다.

- 예시: 각 라벨에 긍정 예시를 3개 이상, 부정 예시를 1개 이상 제시합니다. 이러한 예는 다양한 사례에 적용될 수 있어야 합니다.

- 특이 사례 적용: 다양한 특이 사례를 최대한 명확하게 설명합니다. 이렇게 하면 라벨러가 라벨을 해석하지 않아도 됩니다. 예를 들어 인물 주위에 경계 상자를 그려야 한다면 조건을 명확하게 설명하는 것이 좋습니다.

- 사람이 여러 명 있으면 각 사용자별로 상자가 필요한가요?

- 사람이 가려진 경우 상자가 필요한가요?

- 이미지에 일부만 보이는 사람에도 상자를 그려야 하나요?

- 사진이나 그림에 있는 사람에 대해서도 상자를 그려야 하나요?

- 주석을 추가하는 방법을 설명하세요. 예를 들면 다음과 같습니다.

- 경계 상자는 꼭 맞아야 하나요, 여유가 있어야 하나요?

- 텍스트 항목 추출 작업에서 관심 있는 항목의 시작 지점과 종료 지점은 어디인가요?

- 라벨을 명확하게 설명해야 합니다. 라벨 두 개가 서로 비슷하거나 혼동하기 쉽다면 예시를 제시해 차이를 명확하게 설명하세요.

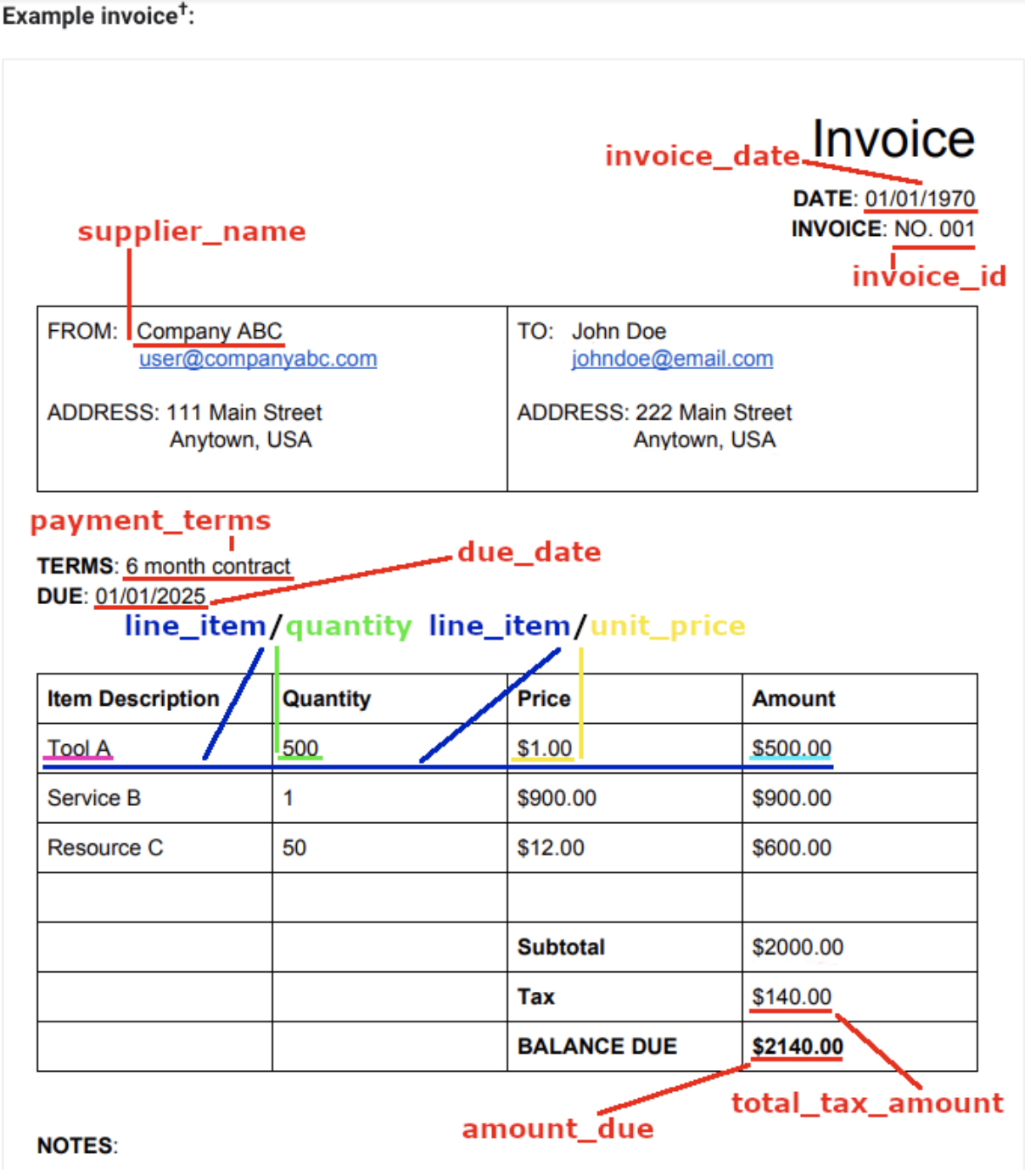

시각적 예시

시각적 예시는 문서에서 다양한 항목을 어디에서 찾아야 하는지, 스키마에서 추출된 라벨에 어떻게 매핑되는지 라벨러에게 명확하게 설명합니다. 다음과 같이 시각적 예시를 포함하세요.