15.1. 網路需求

請參閱下圖的 SG1000 和 SG6060 纜線圖,設定 GRID、管理員和用戶端網路:

15.1.1. 管理節點 SG1000

SG1000 至少要有兩個管理節點。

每個管理員節點都必須有四個 IP 位址,每個位址分別位於下列位置:

- BMC Network。

- 管理員網路。

- 用戶端網路。

- Grid Network。

您必須有三個子網路,分別用於下列項目:

- 管理員網路。

- BMC Network。

用戶端網路和格線網路,以及每個子網路的子網路遮罩,最多只能有 30 位元。

15.1.2. 儲存節點 SG6060 和 SG6000

SG6060 和 SG6000 型號必須至少有三個儲存節點。

每個儲存節點都必須有五個 IP 位址,分別位於下列位置:

- BMC 網路(管理)。

- 管理網路(mgmt)。

- Grid Network。

- 儲存空間控制器網路 (管理)。注意:儲存空間控制器網路必須有兩個 IP 位址。

您必須為下列各項建立兩個子網路:

- BMC Network。

- 管理員網路。

- 儲存空間控制器網路。

- Grid Network。

下表列出管理員和儲存節點的 IP 位址數量:

| 需要的 IP 數量 | 管理員網路 | 用戶端網路 | 電網 |

|---|---|---|---|

| 管理節點 | 2 | 1 | 1 |

| 儲存空間節點 | 4 | 0 | 1 |

您必須具備下列三個子網路:

- 管理員網路。

- 用戶端網路。

- Grid Network。

每個子網路的子網路遮罩最多只能有 30 位元。

15.1.3. 網路詳細資料

15.1.3.1. Distributed Cloud 管理層網路:

Distributed Cloud 頻外 (OOB) 管理網路包含物件儲存空間主機板管理控制器 (BMC) 網路和管理網路。網路會連線至 mgmtsw。

您必須在下列各項上擁有 OOB BMC IP 位址:

- SG1000

- SG6000

您必須在下列各項上設定 OOB 管理 IP 位址:

- SG1000

- SG6000

- SG6060

15.1.3.2. Distributed Cloud 資料平面網路

資料平面網路包含外部物件 StorageGRID (SG1000) 用戶端 LIF 和 NetApp 中的用戶端網路。

請按照下列步驟,找出每個裝置上的

SubnetClaim:- S3 API 端點:

- 在

cellconfig檔案中,搜尋external-objectstorage-client-lif-subnet。 - 找出對應的

SubnetClaim,其中指定了指派的 CIDR/閘道 IP 位址。

SG1000 格線網路設備端點:

- 在

cellconfig檔案中,搜尋objectstorage-admin-nodes-lif-subnet。 - 找出對應的

SubnetClaim,其中指定了指派的 CIDR/閘道 IP 位址。

- 在

SG6060 格線網路設備端點:

- 在

cellconfig檔案中,搜尋objectstorage-storage-nodes-lif-subnet。 - 找出對應的

SubnetClaim,其中指定了指派的 CIDR/閘道 IP 位址。

- 在

15.2. 準備

15.2.1. 收集資訊

預估時間:5 到 10 分鐘

繼續本節之前,請確認網路啟動程序和設定已完成 Distributed Cloud 執行個體,且作業人員可存取最準確或最新的 cellconfig 檔案,或啟動程序。

15.2.1.1. 收集儲存裝置資訊

Distributed Cloud 執行個體遵循固定命名慣例,可識別機架中的硬體裝置。具體來說,是下列物件儲存裝置:

- 管理節點(SG1000):

<cell>-<rack>-objsadm[node-number]。例如:af-ae-objsadm01代表管理員節點。 - 儲存空間運算控制器節點 (SG6000-CN):

<cell>-<rack>-objs[node-number]. 例如:af-ae-objs01。 - 儲存空間控制器機架(E2860):

<cell>-<rack>-objs[node-number]-s1。例如:af-ae-objs01-s1 - 儲存節點控制器(SG6060):

<cell>-<rack>-objs[node-number]-s1-[controller number]. 例如:af-ae-objs01-s1-01和af-ae-objs01-s1-02

15.2.1.2. 收集管理平面網路資訊

在網路啟動和設定期間,營運商必須為管理平面建立子網路。在啟動程序中,物件儲存空間系統需要下列資訊:

- 管理子網路。

- 管理閘道 IP 位址。

- 管理子網路中保留 16 個 IP 位址,每個管理節點兩個 IP 位址,每個儲存節點四個 IP 位址。

從 SubnetClaim <cell>-<rack>-mgmtsw01-objs-os-subnet 找出管理閘道 IP 位址。<cell> 和 <rack> 與「收集儲存裝置硬體資訊」步驟中識別的相同。舉例來說:af-ae-mgmtsw01-objs-os-subnet

kubectl get subnetclaim -n root <cell>-<rack>-mgmtsw01-objs-os-subnet -o jsonpath='{.status.ipv4SubnetStatus.reservedIpRanges[?(.type == "GatewayReservation")].ipRange.startIPAddress}'

將指令的值儲存在 MANAGEMENT_SWITCH_GATEWAY 中。

15.2.1.3. 收集資料平面網路資訊

繼續操作前,請確認您已在網路啟動和設定期間,為物件儲存系統佈建三個子網路。

檢查下列子網路是否存在:

-

objectstorage-admin-nodes-lif-subnet -

objectstorage-storage-nodes-lif-subnet -

external-objectstorage-client-lif-subnet

使用 SubnetClaim 的名稱執行下列指令:

kubectl -n root get SubnetClaim SUBNET_CLAIM_NAME

您會看見以下輸出內容:

NAME CIDRCLAIM OVERLAY-NETWORK IPV4-CIDR IPV6-CIDR VLAN READY VLANREADY

objectstorage-admin-nodes-lif-subnet objectstorage-admin-nodes-lif-cidr ObjectStorage 10.7.7.0/24 7 True True

確認是否包含下列欄位:

VLANREADY: TrueVLANREADY: True

15.2.1.4. 收集依附元件資訊

物件儲存系統依賴 Distributed Cloud 中的下列核心服務和基礎架構:

- NTP

- 硬體安全性模組 (HSM)

- DNS

15.2.1.5. 更新 TO-BE-FILLED 欄位

檢查 obj-cellobj.yaml 檔案是否有任何 TO-BE-FILLED 值,並更新這些值。

執行下列指令,確保 YAML 檔案中沒有該值:

cat OBJ_CELLOBJ_YAML_PATH | grep "TO-BE-FILLED"

15.2.2. 透過本機連線管理設定網路

預估時間:30 至 45 分鐘

這個小節會為每個 StorageGRID 設備節點設定管理網路。管理網路設定完成後,即可使用管理網路中的 IP 從啟動程序存取 StorageGRID 節點。

請按照下列步驟操作所有 ObjectStorage 裝置:

-

af-ae-objsadm01 -

af-ae-objsadm02 -

af-ae-objs01 -

af-ae-objs02 -

af-ae-objs03

如要啟動 StorageGRID 裝置,請使用管理網路通訊埠 6 上的故障排除車連線至每個裝置 (包括兩個管理節點和三個儲存節點),然後前往 https://169.254.0.1:8443,在管理網路上設定管理 IP 位址。

使用乙太網路線,將故障排除車直接連至服務設備最右側的 RJ-45 連接埠。以下圖表以管理員和儲存節點的連接埠 6 為例:

在急救車上開啟網路瀏覽器。

在每部電腦上前往

https://169.254.0.1:8443。在 StorageGRID 設備安裝程式的選單列中,依序點選「Configure Networking」>「Link Configuration」。確認管理員網路是否已啟用。

如要設定管理網路的 IP 位址,請依序選取「Configure Networking」>「IP Configuration」。

向下捲動至「Admin Network」(管理網路) 區段,然後在「IP Assignment」(IP 指派) 中選取「Static」(靜態),並輸入節點的相應管理 IP 位址

managementIP。您可以在obj-cellobj.yaml檔案中找到每個節點的管理 IP。例如:ObjectStorageAdminNode (SG1000):

apiVersion: storagegrid.netapp.storage.private.gdc.goog/v1alpha1 kind: ObjectStorageAdminNode metadata: creationTimestamp: null name: af-ae-objsadm01 spec: network: bmcIP: 10.251.188.11/24 clientIP: 10.251.113.2/28 dataIP: 10.1.0.66/26 managementIP: 10.251.188.10/24 siteName: objectstorage-siteObjectStorageStorageNode (SG6000):

apiVersion: storagegrid.netapp.storage.private.gdc.goog/v1alpha1 kind: ObjectStorageStorageNode metadata: creationTimestamp: null name: af-ae-objs01 spec: network: bmcIP: 10.251.243.34/24 controllerAManagementIP: 10.251.243.35/24 controllerBManagementIP: 10.251.243.36/24 dataIP: 10.1.0.132/26 managementIP: 10.251.243.33/24 siteName: objectstorage-site

將閘道設為

MANAGEMENT_SWITCH_GATEWAY。下圖顯示使用

obj-cellobj.yaml檔案中分配的管理 IP 位址,為af-ae-objs01進行的設定:

按一下「儲存」,確認 IP 位址是否更新。

從啟動程式連線偵測 (ping) 管理 IP 位址,確認可連線。

- 從啟動程式連線偵測 (ping) 管理 IP 位址,確認可以連上。

- 所有節點在管理網路中都有 IP 位址後,請使用管理 IP 位址存取 StorageGRID 節點安裝 GUI。

疑難排解:

如果節點無法 Ping:

- 從上述步驟 3 存取 StorageGRID 節點安裝使用者介面,並檢查對話方塊橫幅中是否顯示任何錯誤。嘗試解決錯誤。視需要聯絡工程師。

- 依序前往「Configure Networking」>「IP Configuration」。確認已在正確的「管理網路」部分設定正確的靜態 IP 和閘道。有時,StorageGRID 節點在確認後,不會完全註冊管理網路設定。

- 再次執行步驟 5 至 8,並驗證管理員節點網路。

如要繼續安裝物件儲存系統,必須存取每個節點上的 StorageGRID 節點安裝 GUI。

15.2.3. 升級 StorageGRID

預估時間:1 至 1.5 小時

升級 StorageGRID 之前,請先檢查 StorageGRID 軟體版本。依序前往「Advanced」>「Upload StorageGRID Software」。您會看到目前的 StorageGRID 版本。

檢查隨附的 StorageGRID 安裝版本:

gdcloud artifacts tree oci | grep object-storage/os

範例輸出內容如下:

│ │ │ └── gpc-system-object-storage/os:11.8.0

├── gpc-system-object-storage/os:sha256-d4cb75f91f43a92cb580db98faae12e87ec49d2b27c7db8a056d6411ac3b6044.sig

版本會標記在構件上,在本例中為 11.8.0:

將版本的值儲存在 SG_INSTALL_VERSION 中。

檢查隨附的 StorageGRID 韌體版本:

gdcloud artifacts tree oci | grep object-storage/firmware

範例輸出內容如下:

│ │ │ ├── gpc-system-object-storage/firmware:3.8.1

├── gpc-system-object-storage/firmware:sha256-20a664504c342b5f14188114fad7a1e7d40abc042690bb0f776aa67cecff52e1.sig

版本會標記在構件上,在本例中為 3.8.1:

將版本的值儲存在 SG_FIRMWARE_VERSION 中。

如果節點上的版本不是 SG_INSTALL_VERSION,請繼續執行後續步驟,升級或降級 StorageGRID 安裝版本。如果目前版本為 SG_INSTALL_VERSION,請移至「升級 SANtricity」一節。

15.2.3.1. 升級韌體

請對所有 StorageGRID 節點執行下列步驟:

-

af-ae-objsadm01 -

af-ae-objsadm02 -

af-ae-objs01 -

af-ae-objs02 -

af-ae-objs03

從套件擷取韌體映像檔:

gdcloud artifacts extract oci storage --image-name=gpc-system-object-storage/firmware:SG_FIRMWARE_VERSION tar -xvzf storage/gpc-system-object-storage/firmware.tar.gz檔案位於

storagegrid_firmware_install/中。前往 StorageGRID 節點上的 StorageGRID Appliance Installer。 依序選擇「進階」 >「升級韌體」。上傳所選韌體版本的韌體映像檔

storagegrid_SG_FIRMWARE_VERSION_firmware_image.bin.tar.bz2和檢查碼storagegrid_SG_FIRMWARE_VERSION_firmware_checksum.bin.sha1。上傳後,StorageGRID 會自動開始驗證檔案。驗證程序通常需要五到十分鐘。

出現兩個綠色勾號後,按一下「Upgrade Inactive Partition」(升級非使用中分割區)。

收到訊息

Successfully updated the firmware on the inactive partition後,請查看「目前的韌體」部分,確認非使用中的分割區確實是正確版本。按兩下「重新啟動」和「交換分割區」。

節點完成重新啟動後,請重複步驟一和二,升級其他分割區的韌體。使用中的分割區是所選版本,而閒置分割區則包含舊版。

15.2.3.2. 升級 StorageGRID 軟體

所有節點的韌體升級至正確版本後,請在兩個管理員節點上將軟體升級至所選版本。儲存空間節點會模仿並提取管理節點上的軟體,因此不必升級。

請按照 SG1000 管理節點上的下列操作說明執行:

-

af-ae-objsadm01 -

af-ae-objsadm02

從套件擷取安裝映像檔:

gdcloud artifacts extract oci storage --image-name=gpc-system-object-storage/os:SG_INSTALL_VERSION tar -xvzf storage/gpc-system-object-storage/os.tar.gz檔案位於

storagegrid_os_install/。依序前往「Advanced」->「Upload StorageGRID Software」。按一下「移除」即可移除目前的軟體,然後上傳新的軟體套件

storagegrid_SG_INSTALL_VERSION_webscale_os_image.deb和對應的總和檢查碼storagegrid_SG_INSTALL_VERSION_webscale_os_checksum.deb.md5,如下所示:

軟體上傳完成後,請確認節點軟體已更新至所選版本:

15.2.4. 升級 SANtricity

預估時間:1 至 1.5 小時

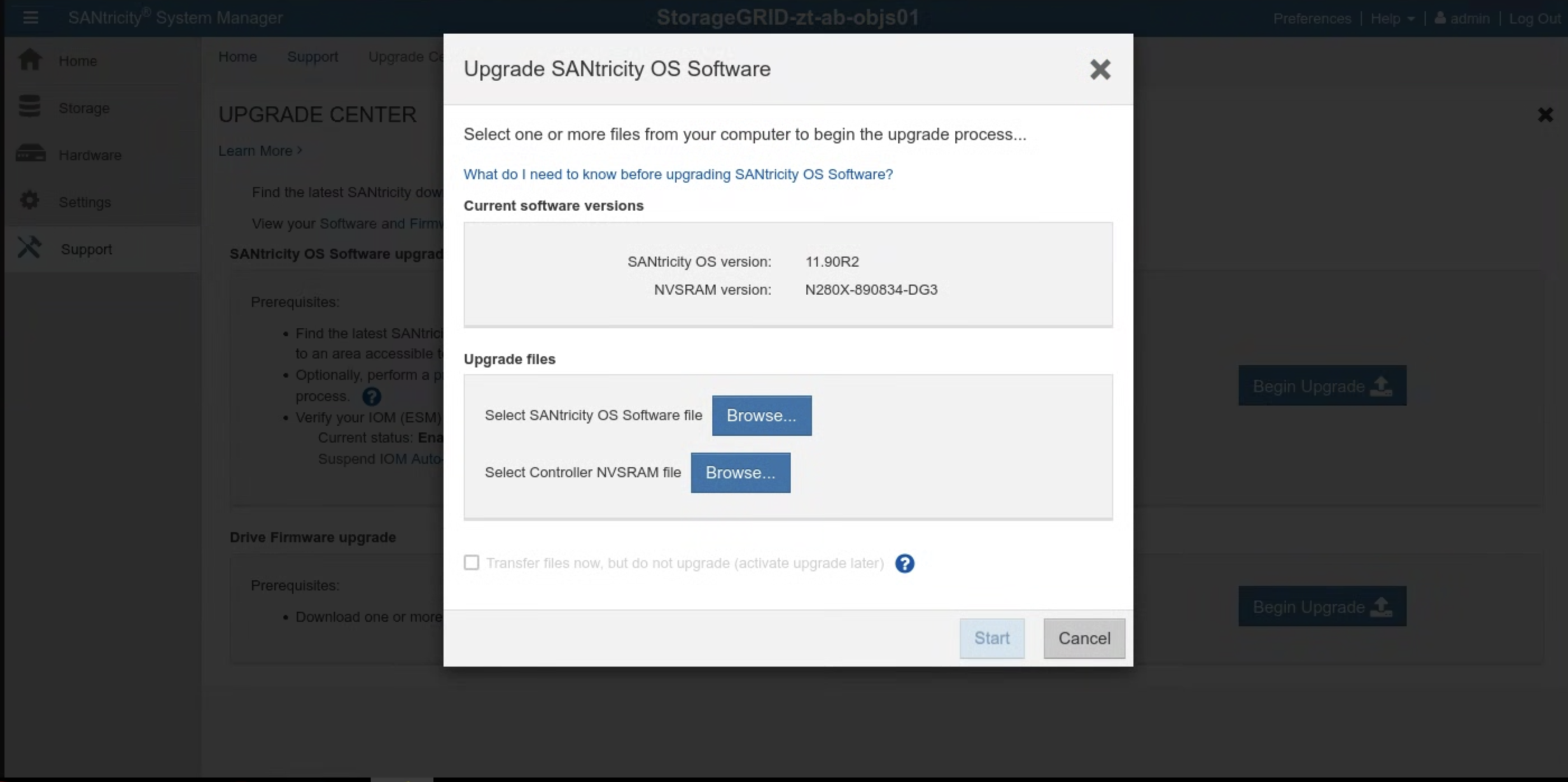

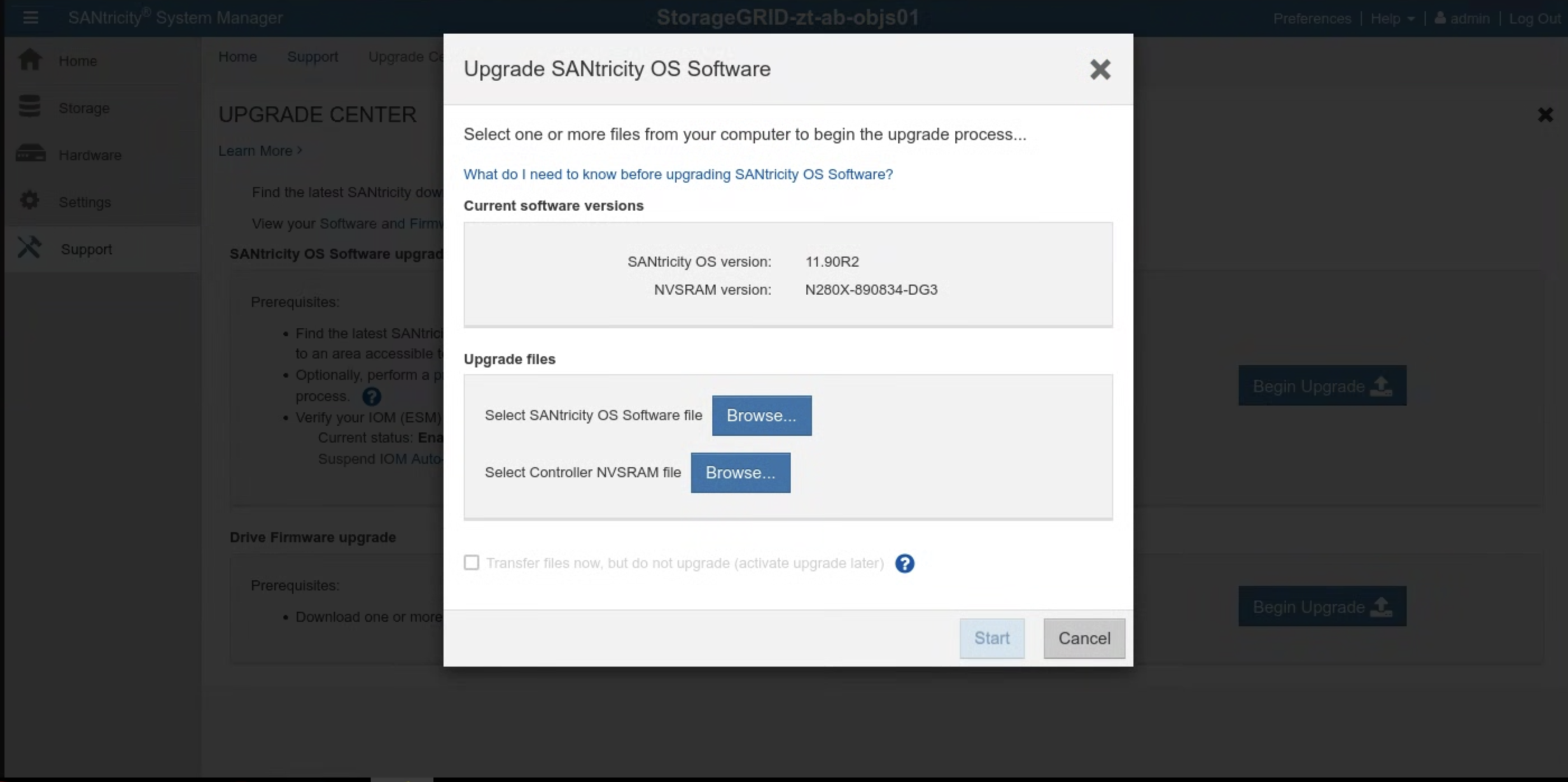

升級 SANtricity 前,請先檢查 SANtricity 軟體版本。前往 SANtricity UI,然後依序點選「Support」>「UPGRADE CENTER」>「Begin Upgrade」。畫面上會顯示目前的 SANtricity 版本。

檢查隨附的 SANtricity 安裝版本:

gdcloud artifacts tree oci | grep object-storage/santricity

範例輸出內容如下:

│ │ │ └── gpc-system-object-storage/santricity:11.70.5R1

├── gpc-system-object-storage/santricity:sha256-b145edeb8b24cac420862e7ef09224009aa51da6c6508f5a113753cc07db6ec5.sig

這個範例中的構件標記為 11.70.5R1。

將版本的值儲存在 SANTRICITY_OS_VERSION 中。

如果 SANtricity 版本低於 SANTRICITY_OS_VERSION,請繼續下一個步驟,升級 SANtricity OS 版本。否則,請前往「安裝」一節。

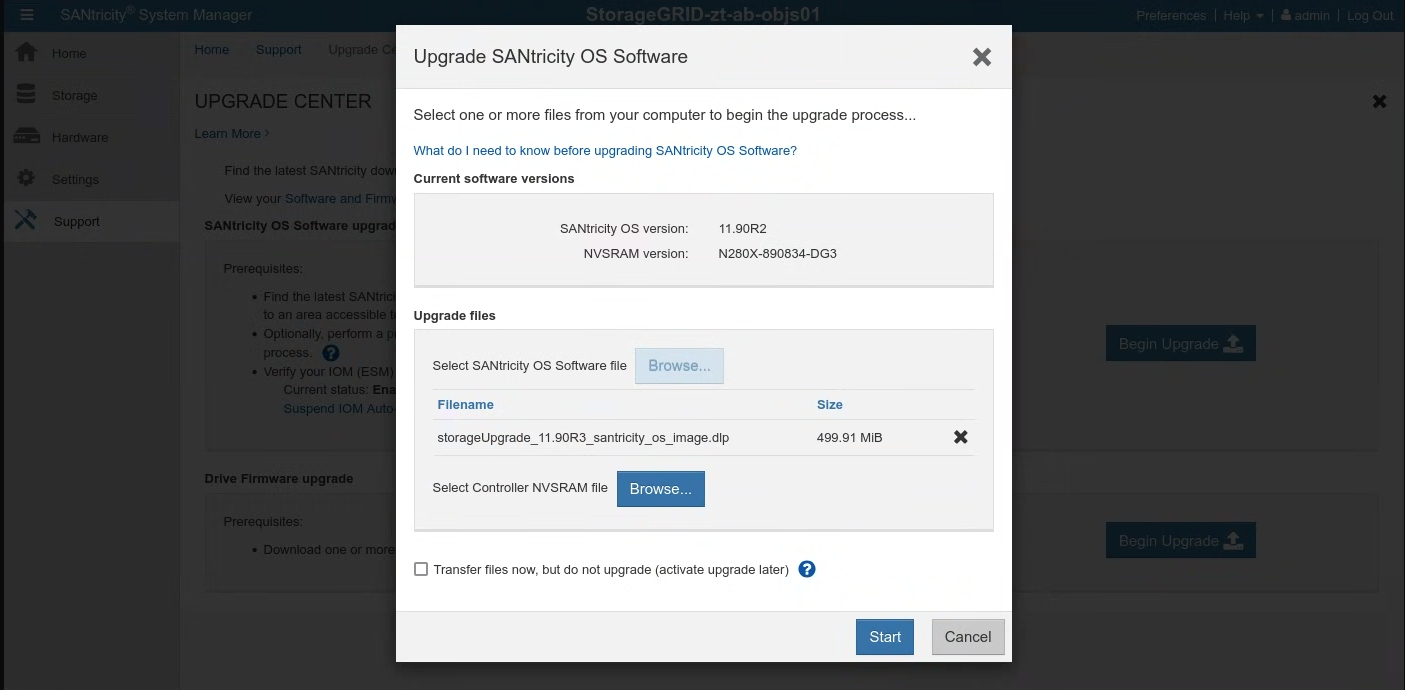

15.2.4.1. 升級 SANtricity OS

在 SANtricity UI 中,針對每個儲存節點按照下列指示操作:

從套件擷取安裝映像檔:

gdcloud artifacts extract oci santricity \ --image-name=gpc-system-object-storage/santricity:SANTRICITY_OS_VERSION tar -xvzf santricity/gpc-system-object-storage/santricity.tar.gz升級檔案位於

santricity/SANTRICITY_OS_VERSION/。依序前往「支援」>「升級中心」。在「SANtricity OS Software upgrade」(SANtricity OS 軟體升級) 頁面中,按一下「Begin Upgrade」(開始升級)。按一下「瀏覽」,選取 SANtricity OS 軟體檔案。上傳新軟體套件

RCB_SANTRICITY_OS_VERSION_santricity_os_image.dlp,如下所示:

按一下「開始」,然後確認要執行這項操作。

升級完成後,請確認版本已更新:

15.3. 安裝

15.3.1. 建立密鑰

預估時間:15 到 30 分鐘

如要取得建立密鑰的值,請使用 cellcfg 目錄:

取得

objectstoragestoragenodes的名稱:$ CELL_ID=$(kubectl get cells -n gpc-system -o jsonpath="{.items[0].metadata.name}") $ sed -n '/kind: ObjectStorageStorageNode/, /status: {}/p' CELLCFG_PATH/$CELL_ID-obj-cellobj.yaml | grep ' name:' | awk '{print $2}'輸出內容範例:

# CELL_ID=$(kubectl get cells -n gpc-system -o jsonpath="{.items[0].metadata.name}") # sed -n '/kind: ObjectStorageStorageNode/, /status: {}/p' ./cellcfg/$CELL_ID-obj-cellobj.yaml | grep ' name:' | awk '{print $2}' ah-ac-objs01 ah-ac-objs02 ah-ac-objs03擷取儲存節點的 BMC IP 位址:

echo https://$(sed -n "/name: STORAGE_NODE_NAME$/, /bmcIP/p" $CELL_ID-obj-cellobj.yaml | grep bmcIP | awk '{print $2}' | cut -d'/' -f1):8443透過上一個指令輸出內容中的連結,登入 SANtricity 系統管理員。如果先前未設定密碼,請建立密碼並登入:

- 如果忘記 SANtricity 密碼,請透過 StorageGRID E2860 序列主控台重設密碼。如要連線至 E2860 磁碟陣列序列埠,終端機設定為 115200 8N1。

在 SANtricity 系統管理員中,為兩個控制器設定 NTP 伺服器位址:

擷取 NTP 伺服器位址

kubectl get ntpserver -n ntp-system -o custom-columns=NAME:.metadata.name,MANAGEMENT-IP:.status.managementIP ```在 SANtricity 系統管理員中選取「Hardware」(硬體)。

如果圖形顯示磁碟機,請按一下「顯示檔案櫃背面」。圖形會變更為顯示控制器,而非磁碟機。

按一下要設定的遙控器。系統隨即會顯示控制器的內容選單。

選取「設定 NTP 伺服器」。系統會開啟「設定網路時間通訊協定 (NTP) 伺服器」對話方塊。

選取「I want to enable NTP on Controller (A or B)」(我要在控制器 (A 或 B) 上啟用 NTP)。對話方塊中會顯示其他選項。

選取「手動指定 NTP 伺服器位址」。使用先前指令擷取的其中一個 IP,輸入主要 NTP 伺服器位址。

按一下 [儲存]。

在 cell.yaml 檔案中,更新包含每個儲存節點 SANtricity 憑證的密鑰。如果密鑰不存在,請按照下列範本新增密鑰:

apiVersion: v1 kind: Secret metadata: creationTimestamp: null name: <STORAGE_NODE_NAME>-santricity namespace: gpc-system stringData: password: 'PASSWORD' username: 'admin' type: Opaque為上一步列出的每個儲存節點建立密鑰:

kubectl create secret generic \ --namespace=gpc-system STORAGE_NODE_NAME-santricity \ --from-literal=username=admin \ --from-literal=password=PASSWORD

驗證:

針對上一個步驟列出的每個儲存空間節點,執行下列指令。這會列印出上一個步驟中設定的 Santricity 使用者名稱。驗證管理員:

kubectl get secret -n gpc-system STORAGE_NODE_NAME-santricity -o jsonpath='{.data.username}' | base64 -d; echo針對上一個步驟列出的每個儲存空間節點,執行下列指令。並列出 Santricity 密碼:

kubectl get secret -n gpc-system STORAGE_NODE_NAME-santricity -o jsonpath='{.data.password}' | base64 -d; echo執行下列指令,取得 Santricity Management UI 的網址。使用使用者名稱和密碼登入 Santricity:

echo https://$(sed -n "/name: STORAGE_NODE_NAME$/, /controllerAManagementIP/p" $CELL_ID-obj-cellobj.yaml | grep controllerAManagementIP | awk '{print $2}' | cut -d'/' -f1):8443

疑難排解:

如果在執行驗證步驟 1 或 2 時找不到密鑰,請再次執行 kubectl create secret 步驟。

如果無法登入 Santricity 管理使用者介面,請按照下列步驟操作:

- 透過 StorageGRID E2860 序列埠控制台重設管理員憑證。

- 執行所有先前的步驟,最後一個步驟除外。

刪除每個節點現有的 Santricity 密鑰:

kubectl delete secret -n gpc-system STORAGE_NODE_NAME-santricity執行最後一個步驟,重新建立 Santricity 密碼。

15.3.2. 啟動物件儲存空間

Object Storage 的啟動程序在第一個區域和加入的區域之間有所不同。請根據您的具體情況參閱相關章節。

重要事項:請先確認錨點區域已完成全域 API 啟動程序,再繼續操作。

15.3.2.1. 在第一個區域中啟動物件儲存空間

執行下列指令來啟動物件儲存空間:

gdcloud system objectstorage install --config /CELLCFG_PATH --first-zone --enable-objectstorage-hsm -v 5

15.3.2.2. 在加入的區域中啟動 Object Storage

疑難排解:

- 如果 Google Cloud CLI 指令逾時或傳回錯誤,請解決傳回的任何問題。

- 如要進一步瞭解錯誤,請檢查登入

gpc-system/obj-infra-cluster-cm-backend-controllerPod。

15.3.2.3. 在加入的區域中啟動 Object Storage

預估時間:30 至 60 分鐘

在加入區域中啟動 Object Storage 時,需要錨點區域和加入區域中的 Object Storage 調解器協調運作。由於在啟動程序期間,兩個區域之間沒有可供調解器使用的安全受控通訊管道,因此 IO 需要手動為兩個區域之間的 Object Storage 調解器建立安全通訊。

- 在錨定區域的根管理員區域叢集和全域叢集中,將 叢集管理員預先定義角色授予自己。詳情請參閱 IAM 執行手冊。

或者,您也可以在錨點區域中套用這兩個角色繫結:

在全域 API 中:

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: mz-admin-binding

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: mz-bootstrap-global-backend-controllers-role

subjects:

- apiGroup: rbac.authorization.k8s.io

kind: User

name: fop-cluster-admin@example.com

在根管理員叢集中:

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: cluster-admin-binding

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: cluster-admin

subjects:

- apiGroup: rbac.authorization.k8s.io

kind: User

name: fop-cluster-admin@example.com

在錨點區域中執行指令,取得 DNS 伺服器 IP,並記下以供稍後使用:

sh kubectl --kubeconfig /ROOT_ADMIN_CLUSTER_KUBECONFIG_PATH get service gpc-coredns-external-udp -n dns-system -o jsonpath='{.status.loadBalancer.ingress[0].ip}'設定加入區域的 DNS 存根解析程式,與錨點區域建立連結:

停用並停止 systemd-resolved

sh systemctl disable systemd-resolved.service --now刪除 resolv.conf 檔案 (如果存在)

sh rm -f /etc/resolv.conf將錨定區域的 DNS 伺服器 IP 寫入加入區域的 resolv.conf

sh vim /etc/resolv.conf範例 /etc/resolv.conf 檔案內容:sh nameserver 10.200.40.0

在加入的區域中建立

TokenRequestYAML 檔案。gdcloud system multi-zone create-token-request --zone JOINING_ZONE_NAME --client-type obj-join --cluster kind --namespace gpc-system --output-file TOKEN_REQUEST_YAML_PATH請將

JOINING_ZONE_NAME替換為客戶填寫問卷中的區域名稱,如本節結尾的附註所述。將 TokenRequest YAML 檔案轉移至錨點區域。

scp TOKEN_REQUEST_YAML_PATH ANCHOR_ZONE_NODE_IP:TOKEN_REQUEST_YAML_PATH將 TokenRequest YAML 套用至錨點可用區的根管理員全域叢集。

kubectl --kubeconfig /GLOBAL_ROOT_ADMIN_CLUSTER_KUBECONFIG_PATH apply -f TOKEN_REQUEST_YAML_PATH在錨點區域中建立權杖 YAML 檔案。

gdcloud system multi-zone create-token --zone JOINING_ZONE_NAME --namespace gpc-system --output-file TOKEN_YAML_PATH將權杖 YAML 檔案轉移至加入的區域。

scp TOKEN_YAML_PATH JOINING_ZONE_BOOTSTRAP_NODE_IP:TOKEN_YAML_PATH將 Token YAML 套用至加入區域的 KIND 叢集。

kubectl --kubeconfig /KIND_CLUSTER_KUBECONFIG_PATH apply -f TOKEN_YAML_PATH在錨點區域中建立 ObjectStorageBootstrap YAML 檔案。

gdcloud system objectstorage create-bootstrap --output-file OBJECT_STORAGE_BOOTSTRAP_YAML_PATH將 ObjectStorageBootstrap YAML 檔案轉移至加入的區域。

scp OBJECT_STORAGE_BOOTSTRAP_YAML_PATH JOINING_ZONE_BOOTSTRAP_NODE_IP:OBJECT_STORAGE_BOOTSTRAP_YAML_PATH將 ObjectStorageBootstrap YAML 檔案套用至加入區域的 KIND 叢集。

kubectl --kubeconfig /KIND_CLUSTER_KUBECONFIG_PATH apply -f OBJECT_STORAGE_BOOTSTRAP_YAML_PATH在加入的區域中啟動物件儲存空間。

gdcloud system objectstorage install --config /CELLCFG_PATH --add-zone --enable-objectstorage-hsm -v 5