Paso 6: Ejecuta la implementación

En esta página, se describe el sexto paso para implementar Cortex Framework Data Foundation, el núcleo de Cortex Framework. En este paso, ejecutarás la implementación de la base de datos de Cortex Framework.

Proceso de compilación

Después de configurar el archivo config.json como se describe en el paso 5: Configura la implementación, sigue estas instrucciones para compilar tu proceso.

Ejecuta el siguiente comando para ubicarte en el repositorio clonado:

cd cortex-data-foundationEjecuta el comando de compilación con el bucket de registros de destino:

gcloud builds submit \ --substitutions=_GCS_BUCKET=LOGS_BUCKET_NAME,_BUILD_ACCOUNT='projects/SOURCE_PROJECT/serviceAccounts/CLOUD_BUILD_SA@SOURCE_PROJECT.iam.gserviceaccount.com'Reemplaza lo siguiente:

LOGS_BUCKET_NAMEcon el nombre del bucket para el almacenamiento de registros. La cuenta de servicio de Cloud Build necesita acceso para escribirlos aquí.SOURCE_PROJECTcon el proyecto de origen.CLOUD_BUILD_SAcon el ID de la cuenta de servicio de Cloud Build que se creó en el paso 4 de la implementación.

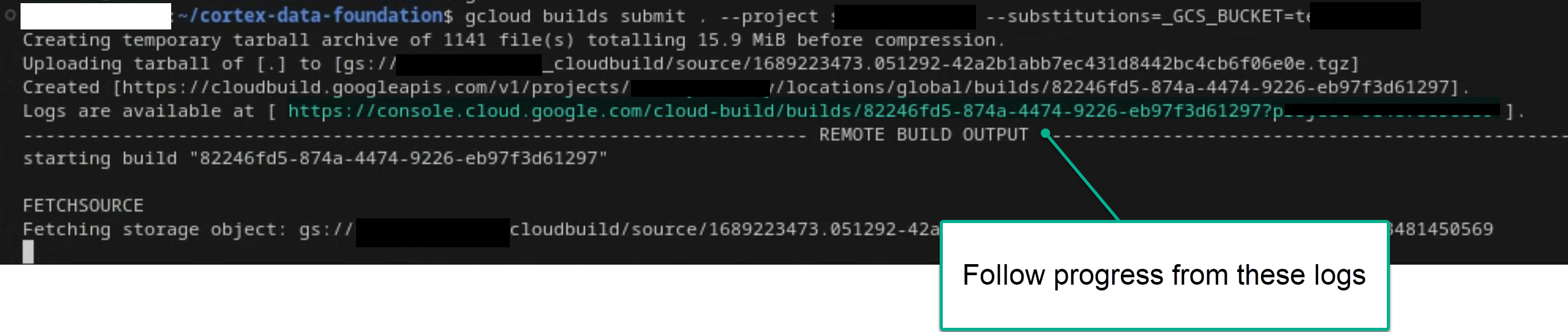

Sigue el proceso de compilación principal desde la observación de los registros en la terminal o en la consola de Cloud Build, si tienes los permisos suficientes. Consulta las siguientes imágenes para obtener más referencias.

Figura 1. Ejemplo de cómo ver el progreso de los registros en la terminal.

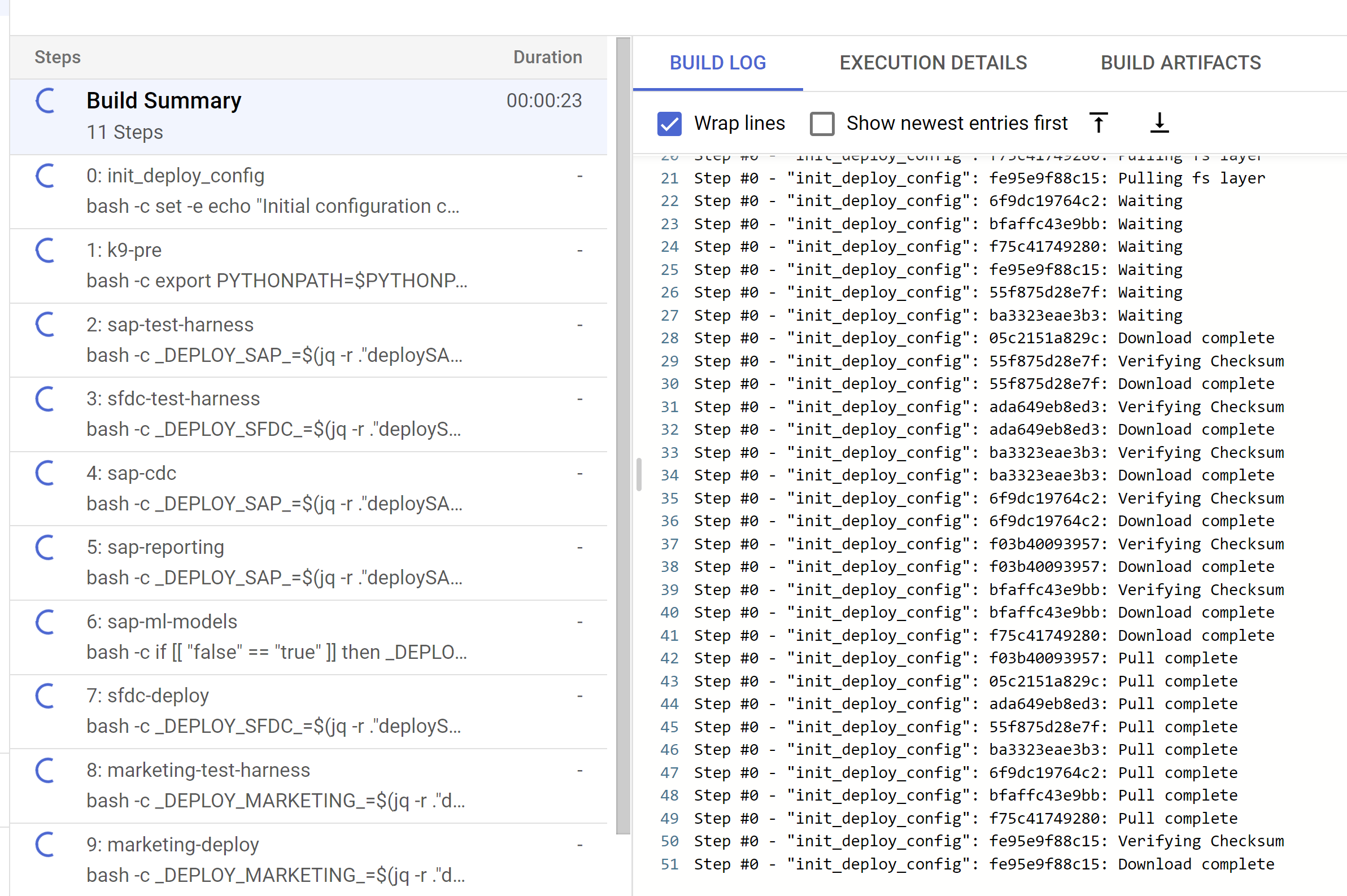

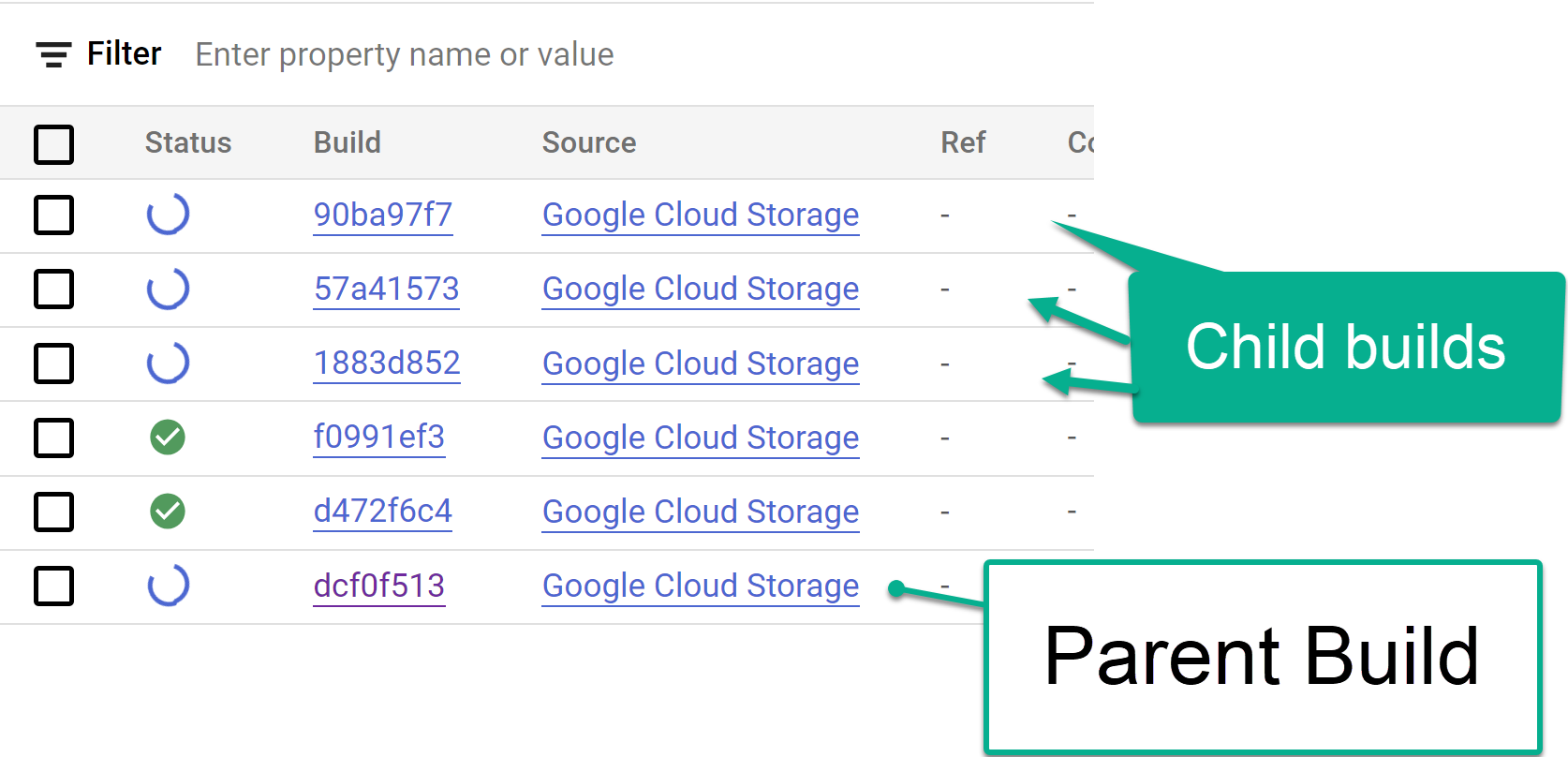

Figura 2: Ejemplo de cómo ver el progreso de los registros en la consola. Realiza un seguimiento de los pasos de compilación secundarios activados desde la consola de Cloud Build o dentro de los registros creados a partir de los pasos. Consulta las siguientes imágenes para obtener más referencias.

Figura 3: Ejemplo de seguimiento de los pasos de compilación secundarios en la consola.

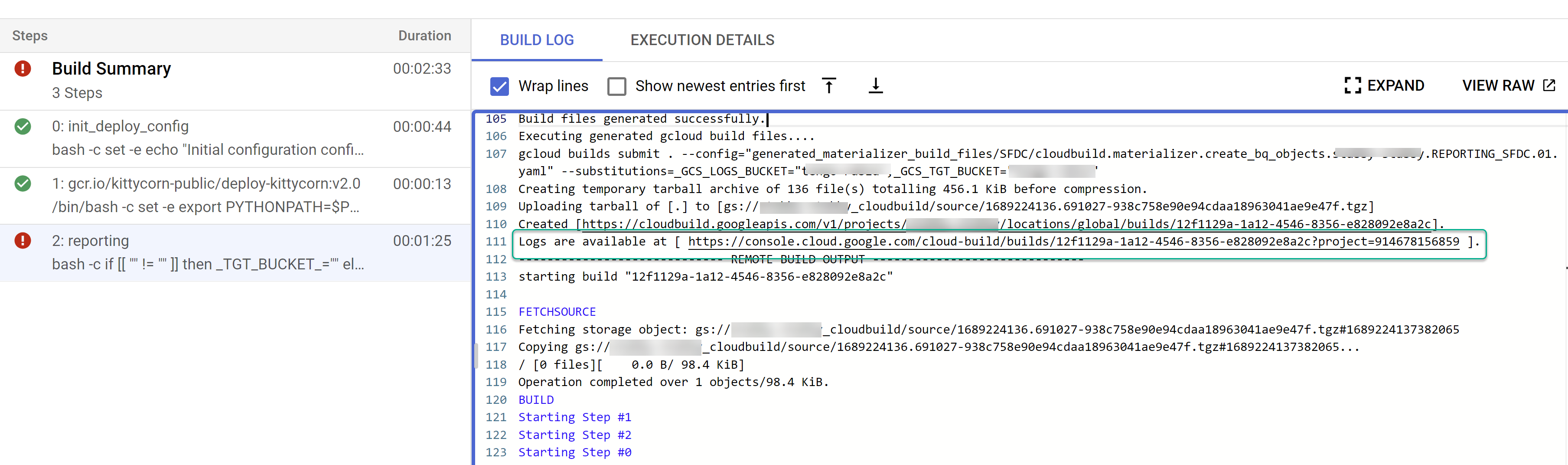

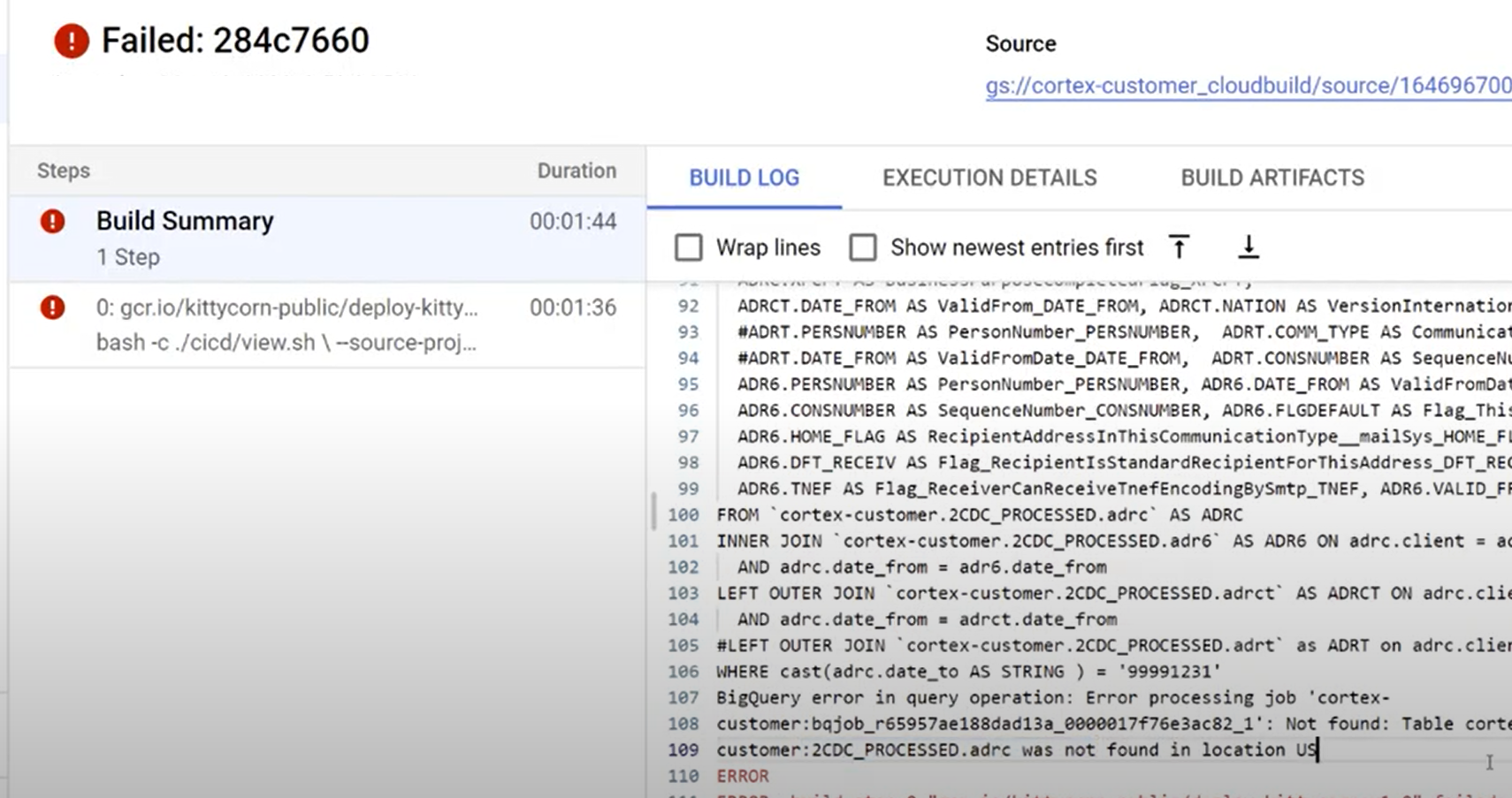

Figura 4. Ejemplo de seguimiento de los pasos de compilación secundarios en los registros. Identificar cualquier problema con las compilaciones individuales Corrige los errores, si los hay. Se recomienda pegar el código SQL generado en BigQuery para identificar y corregir los errores. La mayoría de los errores están relacionados con campos que se seleccionan, pero que no están presentes en la fuente replicada. La IU de BigQuery ayuda a identificar esos comentarios y a quitarlos.

Figura 5. Ejemplo de identificación de problemas a través de los registros de Cloud Build.

Mueve archivos al bucket de DAG de Cloud Composer (Airflow)

Si optaste por generar archivos de integración o de CDC y tienes una instancia de Cloud Composer (Airflow), puedes moverlos a su bucket final con el siguiente comando:

gcloud storage -m cp -r gs://OUTPUT_BUCKET/dags/ gs://COMPOSER_DAG_BUCKET/

gcloud storage -m cp -r gs://OUTPUT_BUCKET/data/ gs://COMPOSER_DAG_BUCKET/

Reemplaza lo siguiente:

OUTPUT_BUCKETcon el bucket de salida.COMPOSER_DAG_BUCKETcon el bucket del DAG de Cloud Composer (Airflow)

Personaliza y prepárate para la actualización

Muchos clientes empresariales tienen personalizaciones específicas de sus sistemas, como documentos adicionales en un flujo o tipos específicos de un registro. Son específicos para cada cliente y los configuran los analistas funcionales a medida que surgen las necesidades comerciales.

Cortex utiliza etiquetas ## CORTEX-CUSTOMER en el código para indicar los lugares en los que es probable que se requieran tales personalizaciones. Usa el comando grep -R CORTEX-CUSTOMER para verificar todos los comentarios de ## CORTEX-CUSTOMER que debes personalizar.

Además de las etiquetas CORTEX-CUSTOMER, es posible que debas personalizar aún más lo siguiente. Para ello, confirma todos estos cambios con una etiqueta clara en el código de tu propio repositorio clonado o bifurcado:

- Se agregaron reglas comerciales.

- Agregar otros conjuntos de datos y unirlos con vistas o tablas existentes

- Reutilizar las plantillas proporcionadas para llamar a APIs adicionales

- Modificar secuencias de comandos de implementación

- Aplicar más conceptos de la malla de datos

- Adaptar algunas tablas o APIs de destino para incluir campos adicionales que no se incluyen en el estándar

Adopta una canalización de CI/CD que funcione para tu organización y mantén estas mejoras probadas y tu solución general en un estado confiable y sólido. Una canalización puede reutilizar los cloudbuild.yaml scripts para activar la implementación de extremo a extremo de forma periódica o según las operaciones de Git, según el repositorio que elijas para automatizar las compilaciones.

Usa el archivoconfig.json para definir diferentes conjuntos de proyectos y conjuntos de datos para los entornos de desarrollo, etapa de pruebas y producción. Usa pruebas automatizadas con tus propios datos de muestra para asegurarte de que los modelos siempre produzcan lo que esperas.

Etiquetar tus propios cambios de forma visible en tu bifurcación o clon de un repositorio junto con cierta automatización de pruebas y de implementación ayuda a realizar actualizaciones.

Asistencia

Si tienes problemas o solicitudes de funciones relacionadas con estos modelos o con los implementadores, crea un problema en el repositorio de Cortex Framework Data Foundation. Para ayudar a recopilar la información necesaria, ejecuta support.sh desde el directorio clonado. Este diálogo te guiará por una serie de pasos para ayudarte a solucionar problemas.

Si tienes solicitudes o problemas relacionados con Cortex Framework, ve a la sección de asistencia en la página de descripción general.

Bloques y paneles de Looker

Aprovecha los bloques y paneles de Looker disponibles. Básicamente, son modelos de datos reutilizables para patrones analíticos y fuentes de datos comunes para Cortex Framework. Para obtener más información, consulta la Descripción general de los bloques y los paneles de Looker.