VESSL AI が Google Cloud で構築したエンドツーエンドの MLOps プラットフォーム

Jaeman An

CEO and Co-founder at VESSL AI

※この投稿は米国時間 2024 年 5 月 30 日に、Google Cloud blog に投稿されたものの抄訳です。

AI には競争上の優位性をもたらす力がありますが、ビジネスにおいてその価値を実現するのは依然として難しいものです。AI プロジェクトを実験以上のレベルに進めようという組織の取り組みでは苦戦が続いており、過去数年間におけるいくつかの推計では、ML の試験運用の半数以上が実運用に至っていないと示されています。

ML システムには隠れた技術的負債が数しれずあります。ML のコードは、実世界で機能する ML システムの実現に必要なインフラストラクチャ、コンポーネント、プロセスのごく一部にすぎません。AI 主導型産業の拡大する要望に対応しようとするならば、現状の ML チームには ML の運用を増強できる合理的で効率のよいワークフローが必要です。

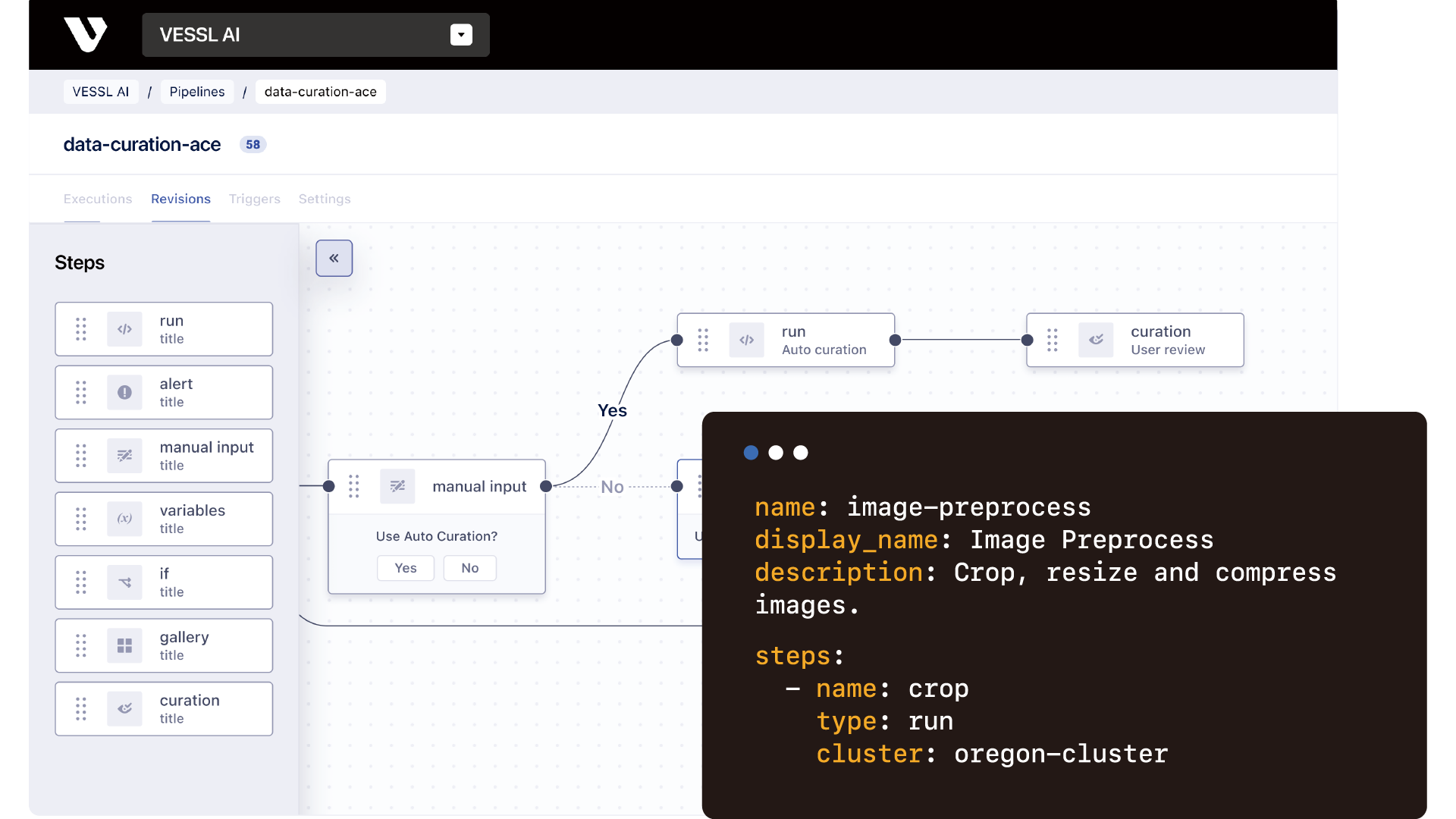

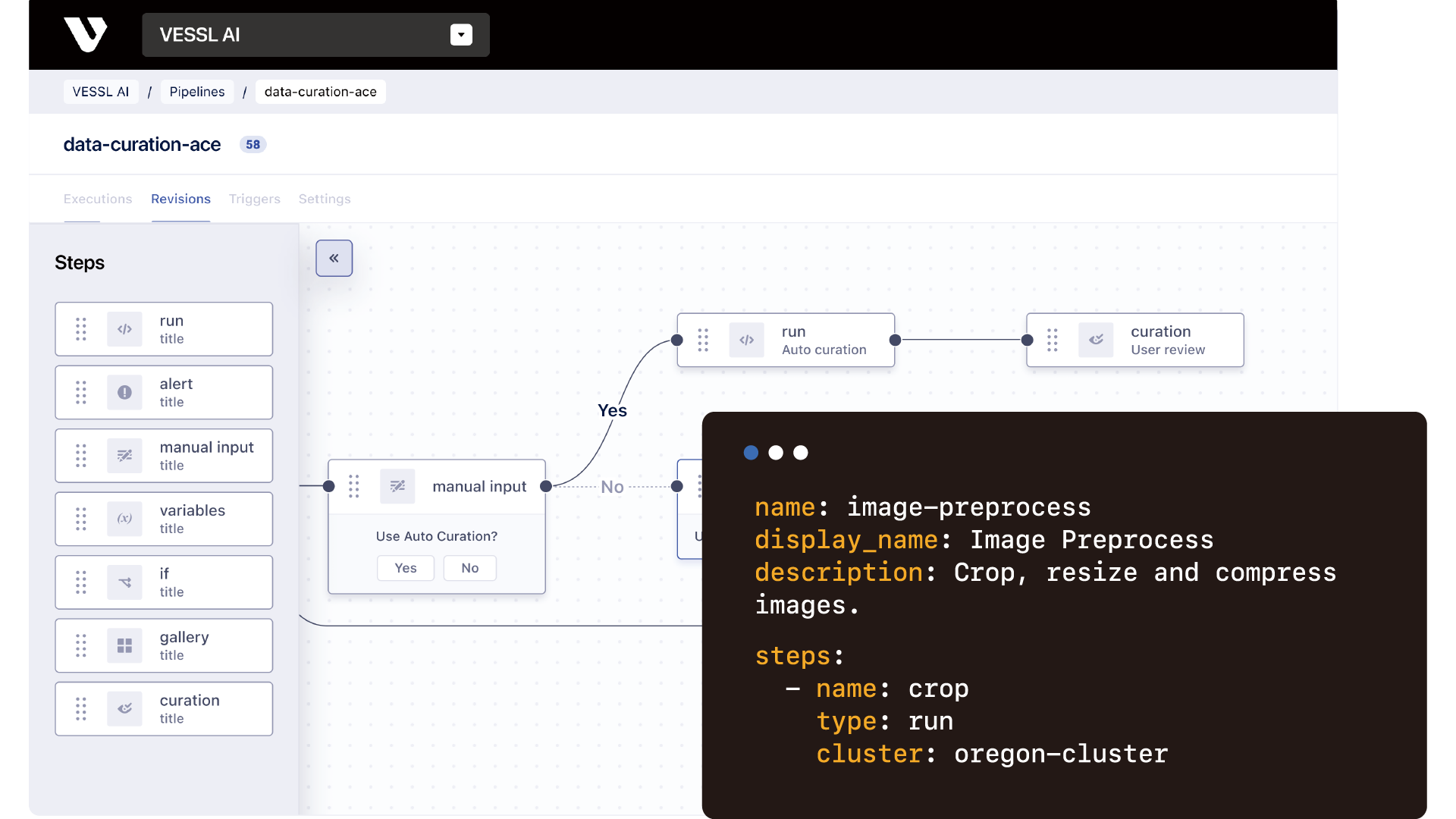

VESSL AI は、AI の取り組みを拡張し加速できるように組織を支援することを使命としており、そのために、包括的なツール群、フルマネージドのインフラストラクチャ、概念実証と本番環境とのギャップを埋めるために構築された最新のエンドツーエンド MLOps プラットフォームを提供しています。

Google Cloud: VESSL AI の取り組みを促進するエンジン

VESSL AI は初期から、クラウド コンピューティングやクラウド サービスには MLOps プラットフォームを強化できる革新的能力があると認識しており、それを実現するために Google Cloud を選択しました。

Google Cloud の潤沢なリソースにより、シームレスにソリューションをデプロイできるため、お客様は中断なく運用を続け、必要に応じたスケーリングが可能です。Compute Engine や Google Kubernetes Engine(GKE)などの Google Cloud サービスを活用することで、モデルの要件に応じてスケーリング可能なインフラストラクチャを提供し、お客様が最適な形でリソースを使用できるようにしています。Google Cloud の大規模なネットワークとインフラストラクチャにより、自社のソリューションをグローバルに提供し、あらゆる地域の企業に対応することが可能です。

たとえば、当社を含め、多くの生成 AI 関連のスタートアップが直面した課題は、大規模言語モデル(LLM)や生成 AI モデルを実行するための多種多様な GPU を迅速に調達できる堅牢なインフラストラクチャの構築でした。これに対応するため、当社が開発したのが VESSL Run です。これは、さまざまな構成の GPU 上であらゆる種類の ML ワークロードを実行できるように設計した統合インターフェースです。GKE を使用して、ML ワークロードを Kubernetes 上で動的にスケーリングできる堅牢なコンピューティング クラスタを構築しました。このセットアップによって、トレーニングからデプロイまでの ML ライフサイクル全体を通じた管理が可能になります。さらに、Spot GPU の使用により、当社のプラットフォームでは、性能に影響を及ぼすことなく、コンピューティング効率の最適化と大幅な費用の抑制が実現できます。

データはビジネスの中核となる資産であるため、データ セキュリティも AI チームや AI 企業にとって非常に重要です。Google Cloud にはセキュリティとコンプライアンスの厳格なプロトコルがあるため、最高水準の標準と要件を満たしていることをお客様に自信を持って保証できます。たとえば VESSL AI Artifacts では、Google Cloud の粒度の細かいアクセス制御を利用して、データセットやモデル、その他の重要なアーティファクトを安全に保存します。VESSL AI の ML データセットとモデルはすべて Cloud Storage に保存されており、NFS には Filestore を使用してチームが常時データとワークロードにアクセスできるようにしています。これにより、ML ライフサイクル全体を通じてデータがアクセス可能であるだけでなく、データの正確性、整合性、安全性、セキュリティも保証できます。

(さらに)パワフルな AI の活用

さらに最近では Vertex AI とのインテグレーションを追加したことで、能力が大幅に向上しています。Vertex AI の使用によって、既存の MLOps コンポーネントを補完でき、ユーザーは最小限の手動による介入と専門知識でデータセットのラベル付けやモデルのトレーニングを実施できるだけでなく、Google のパワフルなモデルや AutoML ソリューションも活用できるようになりました。この統合は、AI モデル開発の進化するニーズに対応し、より包括的で効率的なサービスをお客様に提供する VESSL AI の能力における重要な進歩を意味します。Vertex AI の使用によって、既存の MLOps コンポーネントが補完され、ユーザーはデータセットのラベル付けやモデルのトレーニングを最小限の手動による介入と専門知識で実施できるため、ML ワークフローの効率化がさらに進みました。

VESSL AI プラットフォームのパワーを活用することで、すでに多くの組織に、時間と費用を節約できる革新的なメリットを体感いただいています。Google Cloud を使用することで、VESSL AI はユーザーが AI モデルを最大 4 倍速く作成できるようサポートし、アイディエーションからデプロイまでの時間を何百時間も節約しています。また、クラウド支出を最大 80% 節約することも可能にしました。

さらに、Google Cloud の専門家チームと密接に連携できることによって、Google Cloud から得られる最大限の成果を深く理解し、お客様にメリットをもたらすシナジー関係を作ることができるようになりました。

今後の展望

VESSL AI はすでに MLOps の分野で大きな前進を遂げていますが、この取り組みはまだ始まったばかりです。企業での成功事例と 2023 年の公開ベータ版のリリースを経て、現在、ML チームが複数のサードパーティのクラウド プラットフォームを統合し、トレーニングからモデルのデプロイまでシームレスに ML ワークフローをスケールできる未来に向けて準備を進めています。

さらに、Google for Startups Accelerator プログラムへの参加により、当社の可能性を大きく広げる、またとないメリットが得られています。このプログラムは、スタートアップに豊富なリソース、メンターシップ、潜在的な資金調達の機会へのアクセスを提供します。スタートアップが迅速にスケールアップし、グローバル市場に進出し、提案製品を洗練するための促進剤として機能し、他の業界リーダーとの協力や、成長を呼ぶ強固なエコシステムへの参加機会が得られます。

AI とオペレーションの融合によって業界に革新が起きています。Google Cloud との共同作業によって、そうした変革の最前線に立ち続けることができると考えており、新しい生成 AI の時代にクラウドを用いて成長を加速しようとする他のスタートアップの見本になればよいと思います。Google Cloud との連携により、イノベーターは最新の技術を使用できるようになるだけでなく、ビジネス リサーチや事業拡大の可能性を大幅に拡げることができるネットワーク内の立ち位置を獲得することが可能になります。

スタートアップの方で Google Cloud によって運用がどのように改善するかお知りになりたい場合は、Google for Startups プログラムのページでプログラムやそのメリットの詳細をご覧ください。活動を支援する最高 350,000 米ドルの Google Cloud クレジットや技術サポートなどもあります。

-VESSL AI、CEO / 共同創業者 Jaeman An 氏