Rocky Linux 8 および CentOS 7 バージョンの HPC VM イメージが一般提供に

Google Cloud Japan Team

※この投稿は米国時間 2024 年 3 月 23 日に、Google Cloud blog に投稿されたものの抄訳です。

この度、気象予測、流体力学、分子モデリングなどの密結合ワークロードに焦点を当てたハイ パフォーマンス コンピューティング(HPC)ワークロード向けに、Rocky Linux 8 ベースおよび CentOS 7 ベースの HPC 仮想マシン(VM)イメージの一般提供を開始したことをお知らせいたします。

HPC VM イメージを使用すると、HPC 対応の VM インスタンスを簡単に構築できます。また、Google Cloud 上で HPC を実行する次のようなベスト プラクティスが組み込まれています。

-

すぐに使用できる HPC 対応の VM - 特に HPC VM イメージの定期リリースでは、密結合 HPC ワークロード向けに手動でパフォーマンスを調整する、VM の再起動を管理する、Google Cloud アップデートに関する最新情報を入手する、といった作業は必要ありません。再起動は、調整によって再起動が必要になった場合に自動的にトリガーされ、このプロセスは HPC VM イメージによって管理されます。

-

密結合のワークロードのネットワーク最適化 - 小規模メッセージのレイテンシを低減するように最適化されます。ポイントツーポイント通信とグループ通信に大きく依存するアプリケーションにメリットがあります。

-

コンピューティング最適化 - システム ジッターを削減するように最適化されます。これにより、スケーラビリティを向上させるうえで重要な単一ノードのパフォーマンスの一貫性が保たれます。

-

アプリケーションの互換性の向上 - Intel HPC プラットフォーム仕様のノードレベルの要件を満たすことで、システム間で高度な相互運用性を実現します。

HPC ベンチマークを使用したパフォーマンス測定

Intel MPI ベンチマーク(IMB)において、デフォルトの CentOS 7 イメージおよび GCP に最適化された Rocky Linux 8 イメージと、HPC VM イメージのパフォーマンスを比較しました。

ベンチマークは次のイメージに対して実行されました。

HPC Rocky Linux 8

-

イメージ名: hpc-rocky-linux-8-v20240126

-

イメージ プロジェクト: cloud-hpc-image-public

デフォルトの GCP Rocky Linux 8

-

イメージ名: rocky-linux-8-optimized-gcp-v20240111

-

イメージ プロジェクト: rocky-linux-cloud

マシンの各クラスタは、max_distance=1 のコンパクト プレースメントでデプロイされました。つまり、ネットワーク レイテンシを最小限に抑えるために、すべての VM が物理的に同じラック上のハードウェアに配置されているということです。

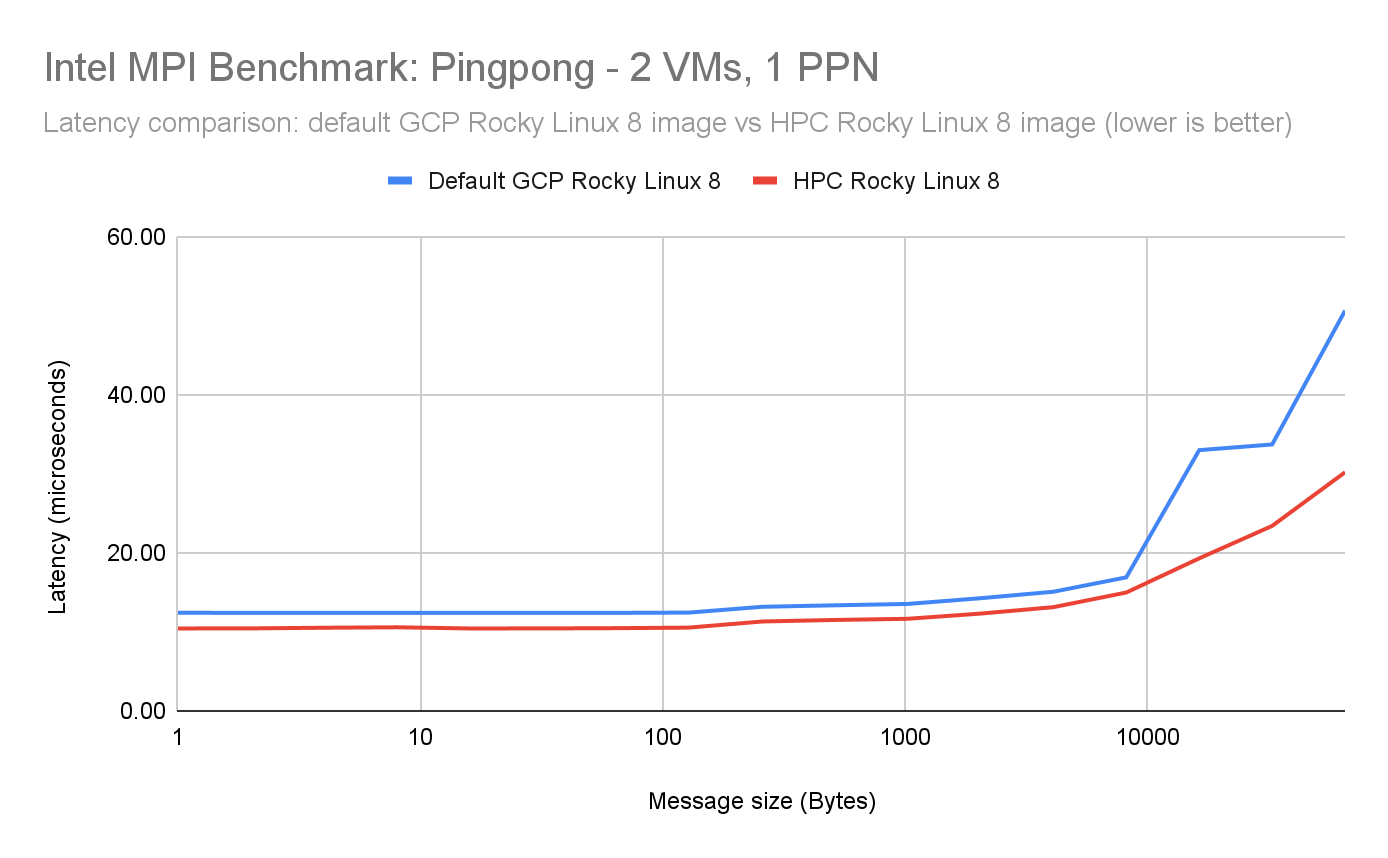

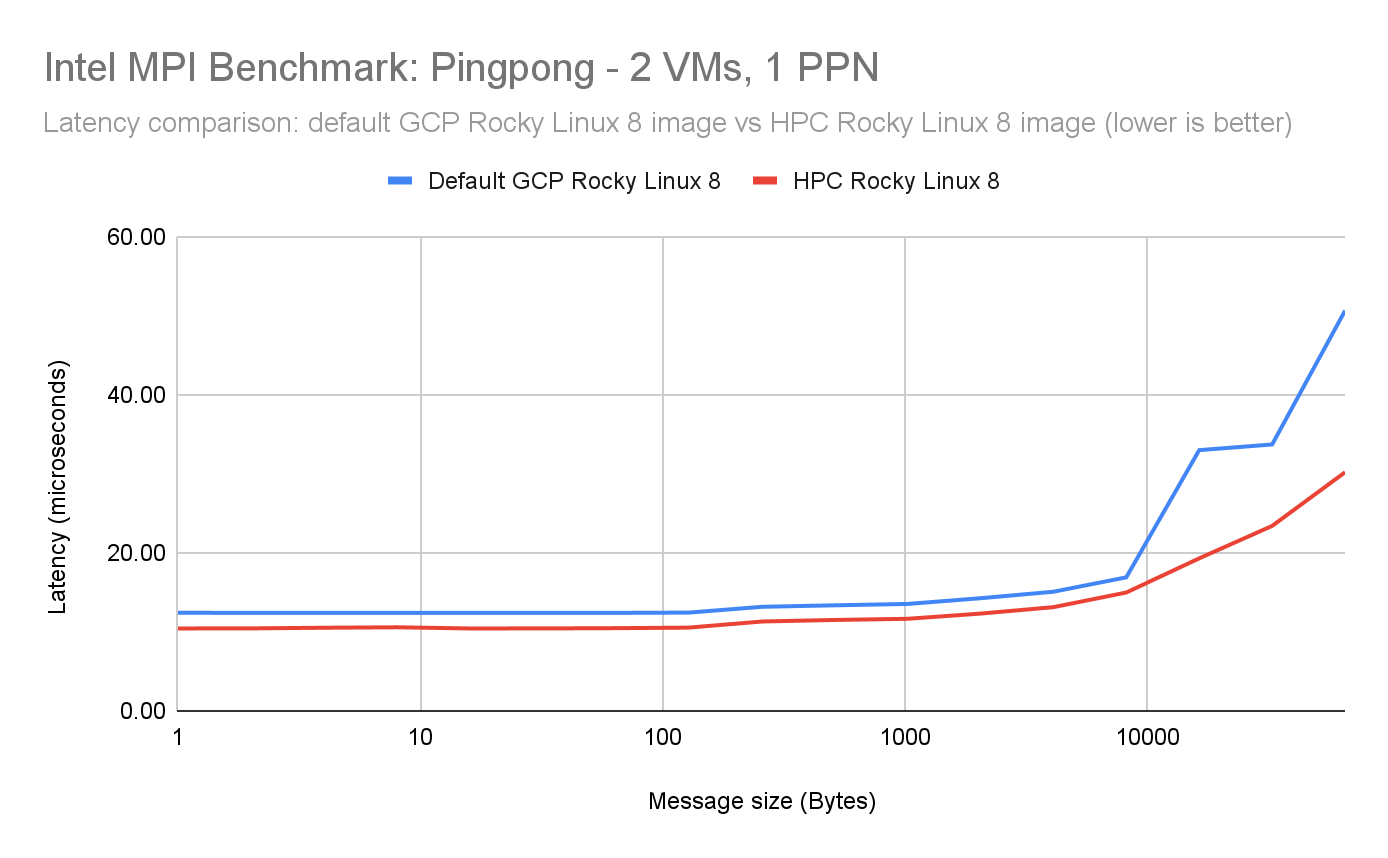

Intel MPI ベンチマーク(IMB)Ping-Pong

IMB Ping-Pong は、異なる VM 上の 2 つのランク間で固定サイズのメッセージを転送するときのレイテンシを測定します。HPC Rocky Linux 8 イメージを使用した場合、デフォルトの GCP Rocky Linux 8 イメージと比較して最大 15% の改善が見られました。

ベンチマークのセットアップ

-

2 x h3-standard-88

-

MPI ライブラリ: Intel OneAPI MPI ライブラリ 2021.11.0

-

MPI ベンチマーク アプリケーション: Intel MPI ベンチマーク 2019 アップデート 6

-

MPI 環境変数:

-

I_MPI_PIN_PROCESSOR_LIST=0

-

I_MPI_FABRICS=shm:ofi

-

FI_PROVIDER=tcp

-

コマンドライン: mpirun -n 2 -ppn 1 -bind-to core -hostfile <hostfile> IMB-MPI1 Pingpong -msglog 0:16 -iter 50000

結果

Pingpong 1 PPN - Rocky Linux 8(低いほど良い)

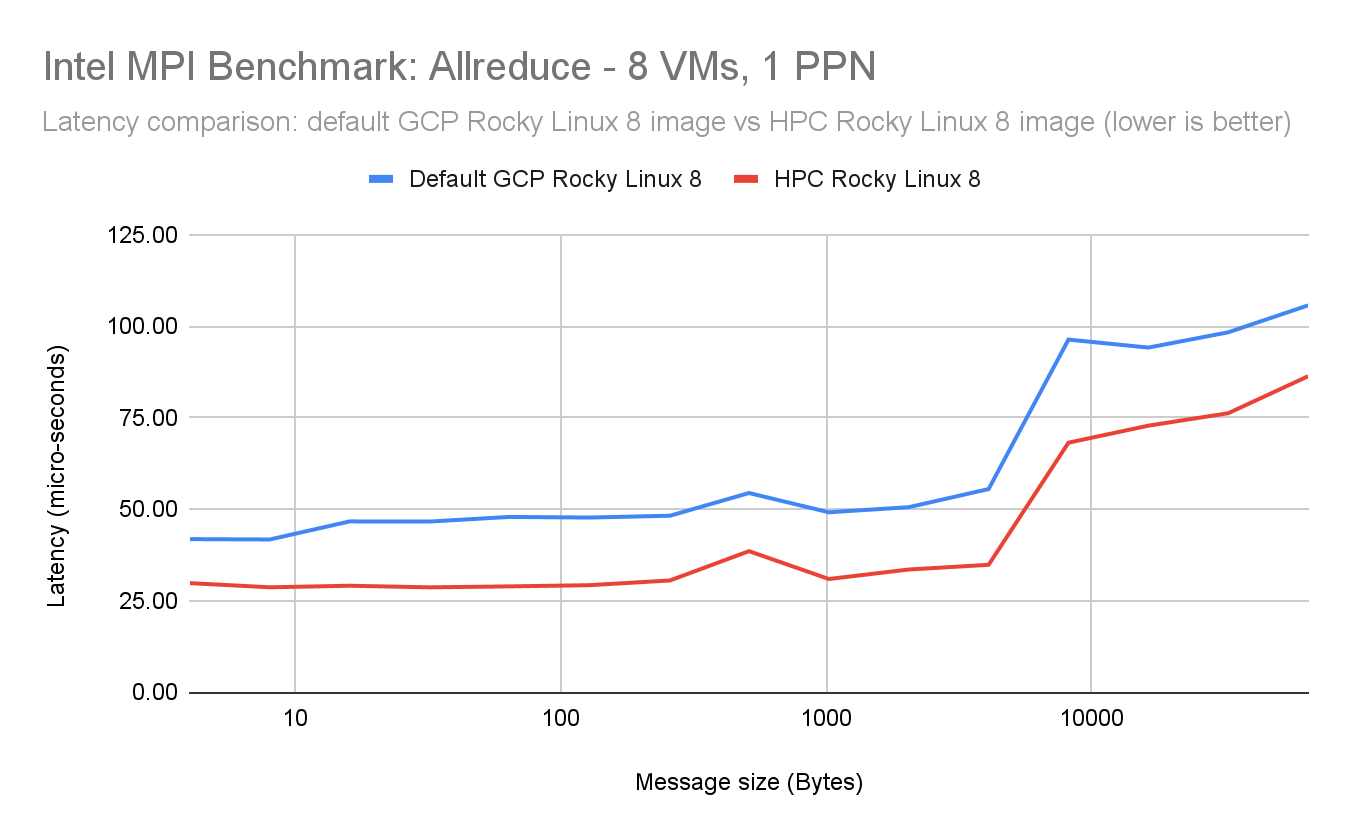

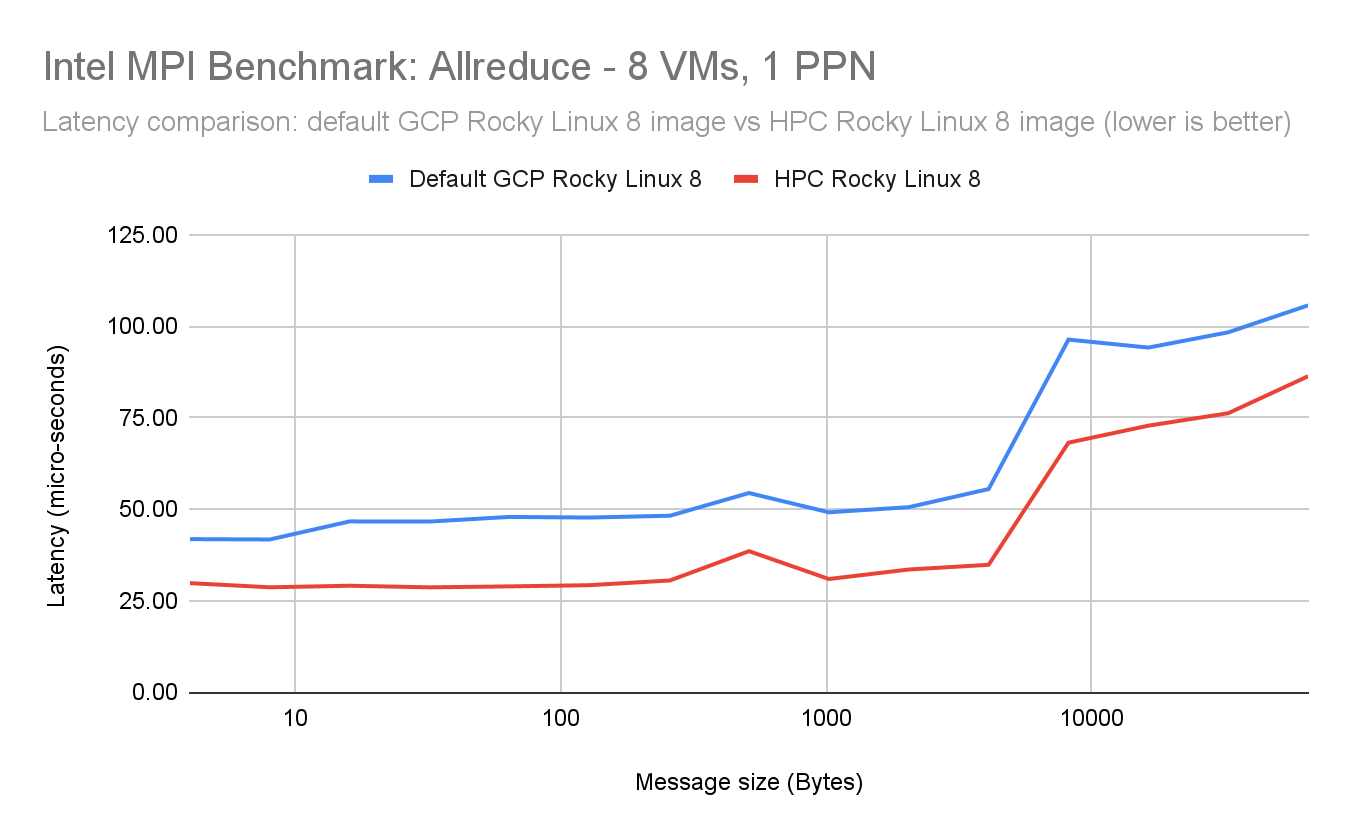

Intel MPI ベンチマーク(IMB)AllReduce - 1 ノードあたり 1 プロセス

IMB AllReduce ベンチマークは複数の VM 間の複数のランクでグループ レイテンシを測定します。MPI_SUM オペレーションを実施して固定長のベクトルを集約します。

ネットワーク パフォーマンスを分離するために、最初に 8 つの VM で 1 つの PPN(ノードあたりのプロセス数)結果(1 MPI ランク)を示します。

HPC Rocky Linux 8 イメージでは、デフォルトの GCP Rocky Linux 8 イメージと比較して最大 35% の改善が見られました。

ベンチマークのセットアップ

-

8 x h3-standard-88

-

1 ノードあたり 1 プロセス

-

MPI ライブラリ: Intel OneAPI MPI ライブラリ 2021.11.0

-

MPI ベンチマーク アプリケーション: Intel MPI ベンチマーク 2019 アップデート 6

-

MPI 環境変数:

-

I_MPI_FABRICS=shm:ofi

-

FI_PROVIDER=tcp

-

I_MPI_ADJUST_ALLREDUCE=11

-

コマンドライン: mpirun -n 008 -ppn 01 -bind-to core -hostfile <hostfile> IMB-MPI1 Allreduce -msglog 0:16 -iter 50000 -npmin 008

結果

Allreduce 1 PPN - Rocky Linux 8(低いほど良い)

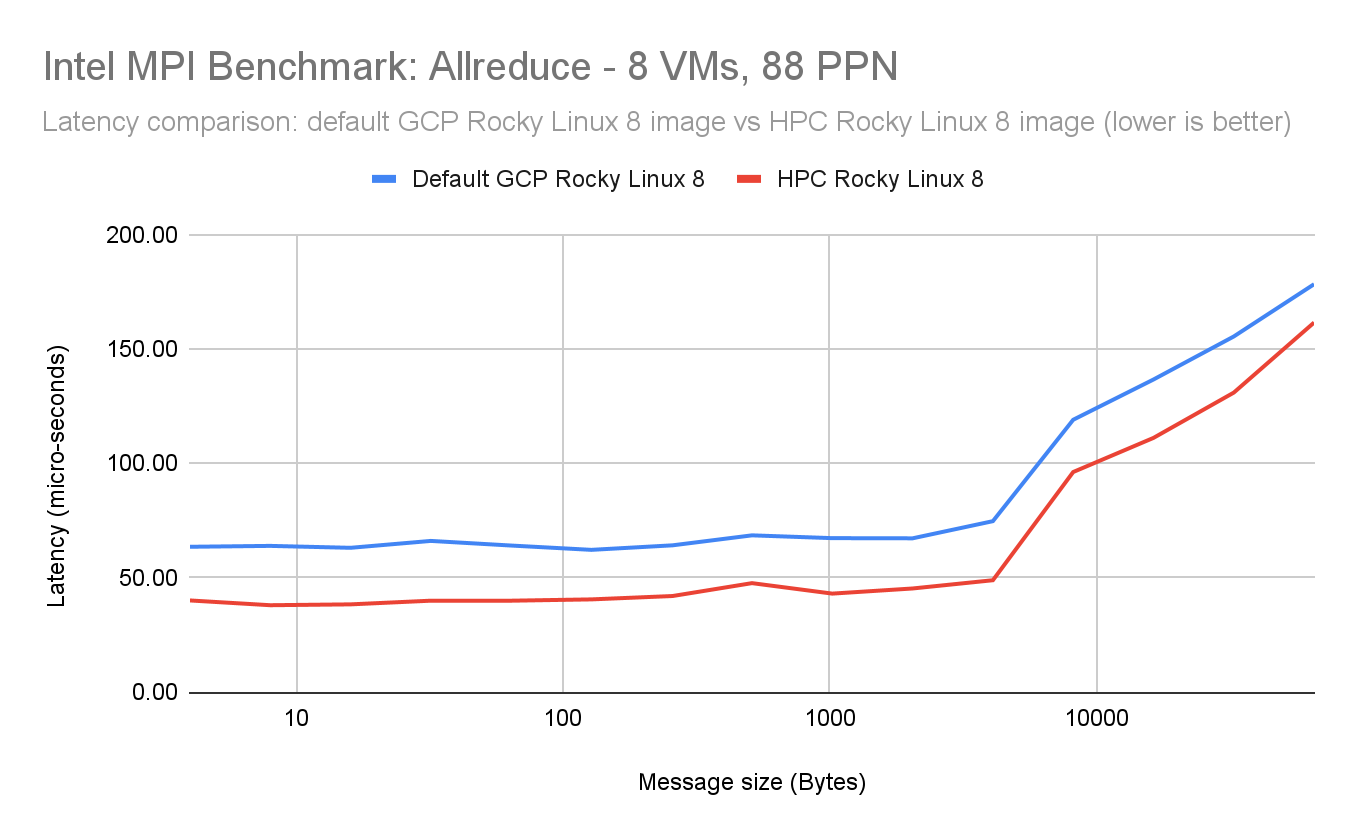

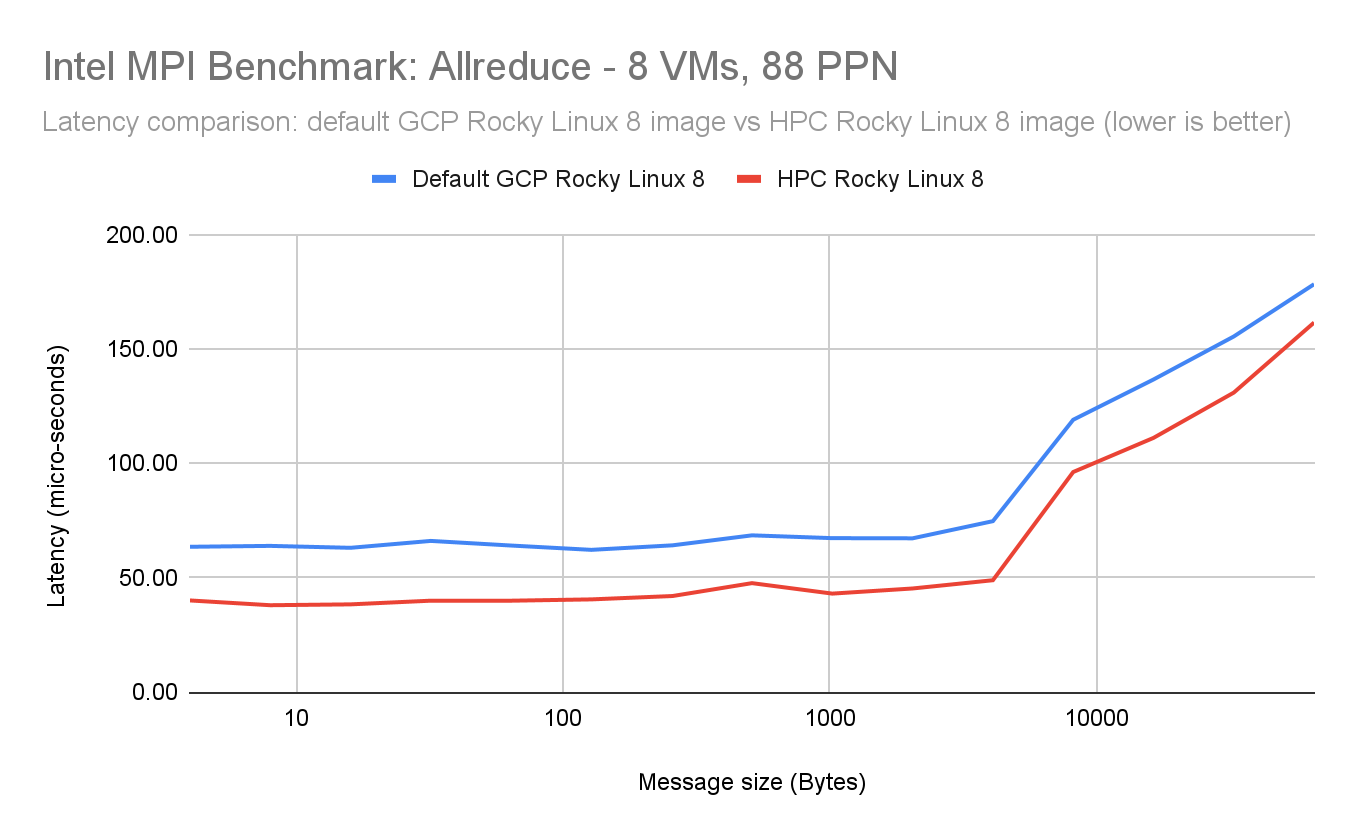

Intel MPI ベンチマーク(IMB)AllReduce - 1 コアあたり 1 プロセス(1 ノードあたり 88 プロセス)

88 MPI ランク/ノード、1 スレッド/ランク(704 ランク)の 88 の PPN 結果を示します。

このテストでは、HPC Rocky Linux 8 イメージについて、デフォルトの GCP Rocky Linux 8 イメージと比較して最大 25% の改善が見られました。

ベンチマークのセットアップ

-

8 x h3-standard-88

-

1 コアあたり 1 プロセス(1 ノードあたり 88 プロセス)

-

MPI ライブラリ: Intel OneAPI MPI ライブラリ 2021.11.0

-

MPI ベンチマーク アプリケーション: Intel MPI ベンチマーク 2019 アップデート 6

-

MPI 環境変数:

-

I_MPI_FABRICS=shm:ofi

-

FI_PROVIDER=tcp

-

I_MPI_ADJUST_ALLREDUCE=11

-

コマンドライン: mpirun -n 704 -ppn 88 -bind-to core -hostfile <hostfile> IMB-MPI1 Allreduce -msglog 0:16 -iter 50000 -npmin 704

結果

Allreduce 88 PPN - Rocky Linux 8(低いほど良い)

ご利用方法

HPC 対応 VM を作成するには、次のオプションを使用します。

-

Google Cloud コンソール - 注: イメージは、コンソールの Cloud Marketplace から入手できます。

-

SchedMD の Slurm ワークロード マネージャー。デフォルトで HPC VM イメージを使用します。詳細については、Intel Select Solution 検証済みクラスタの作成をご覧ください。

- Omnibond CloudyCluster。デフォルトで HPC VM イメージを使用します。

-Cloud HPC 担当ソフトウェア エンジニア、Rohit Ramu

-Cloud HPC 担当グループ プロダクト マネージャー、Annie Ma-Weaver