LLM がビジネス成果に与える影響を評価する方法

Ivan Nardini

Developer Relations Engineer

Irina Sigler

Product Manager, Cloud AI

※この投稿は米国時間 2024 年 7 月 2 日に、Google Cloud blog に投稿されたものの抄訳です。

大規模言語モデル(LLM)から所期の結果が得られているかどうかは、どうすれば確認できるでしょうか。また、目的のユースケースに最適なモデルを選択するにはどうすればよいでしょうか。LLM の出力を評価することは、生成 AI を使用するうえで最も難しい課題の一つです。LLM は幅広いタスクで優れた性能を発揮しますが、特定のユースケースでのモデルのパフォーマンスを理解することは非常に重要です。

リーダーボードと技術レポートからモデルの能力の概要はわかりますが、自社のニーズに最適なモデルを選択し、そのモデルの動作を目的のタスクに適合させるには、カスタマイズされた評価アプローチが不可欠です。

この課題に対処するため、Google は Vertex Gen AI Evaluation Service をリリースしました。このサービスは、特定のユースケースに応用できる、品質管理された説明可能な一連の評価方法を含むツールキットを提供します。これにより、開発ライフサイクル全体を通して十分な情報に基づく意思決定が可能になり、LLM アプリケーションから最大限の可能性を引き出すことができます。

このブログ投稿では、Vertex Gen AI Evaluation Service について紹介し、その使用方法と、Gen AI Evaluation Service を使用して RAG ベースの LLM アプリケーションを本番環境に導入した Generali Italia の事例を紹介します。

Vertex Gen AI Evaluation Service による LLM の評価

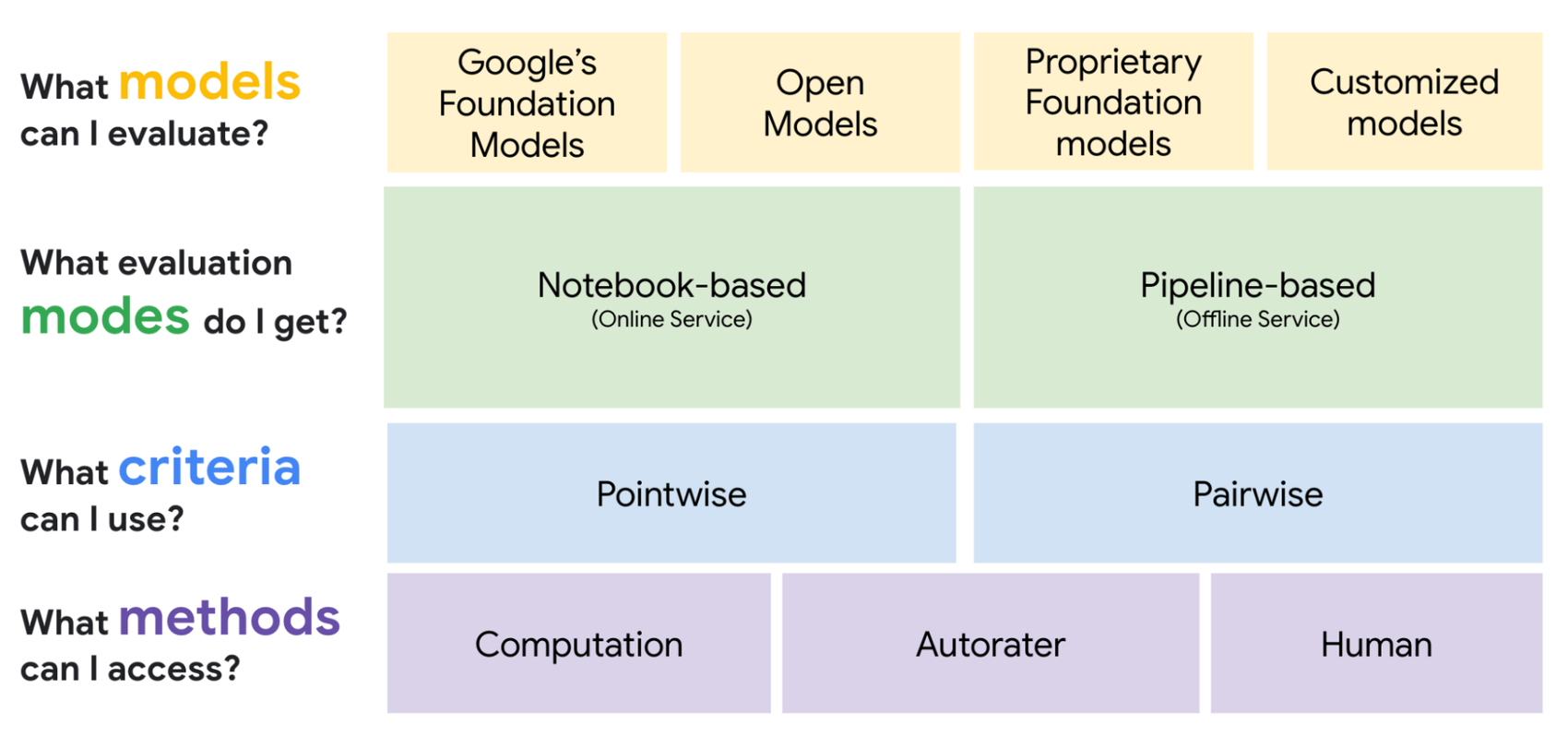

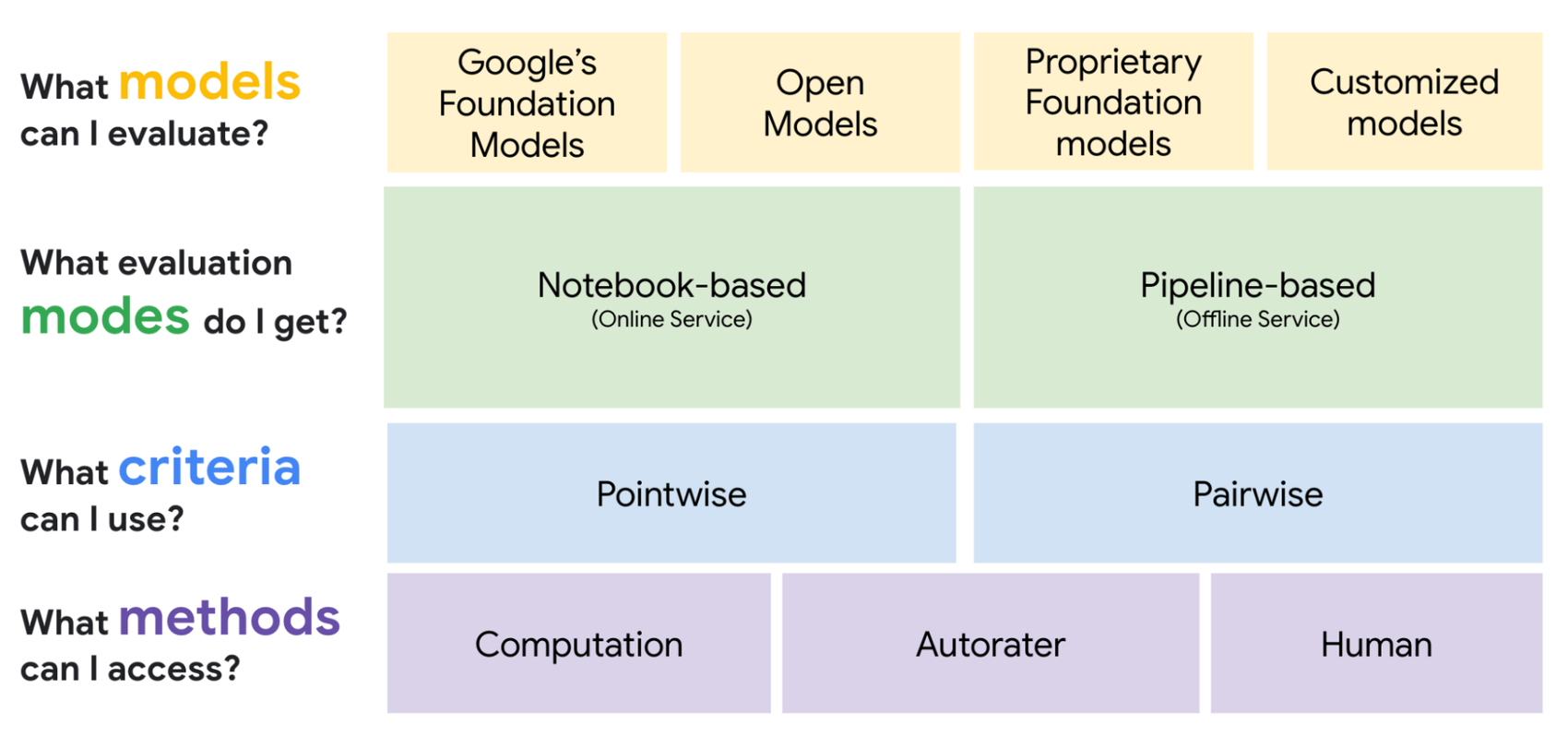

Gen AI Evaluation Service には、品質管理された説明可能な評価方法が豊富に用意されており、これを使用してインタラクティブまたは非同期の評価モードであらゆるモデルを評価できます。次のセクションでは、このサービスを 3 つの側面から詳しく見ていきます。

生成 AI アプリケーションの開発を始めるときは、さまざまな段階で重要な決定を下す必要があります。そして開発プロセスの開始後すぐに、目的のタスクに適したモデルを選択し、最適な出力を生成するプロンプトを設計する必要があります。このモデル、プロンプト、タスク間の最適な適合を見出すプロセスにおいて意思決定を迅速化するには、プロンプト テンプレートを繰り返し試してモデルをその場で比較できるオンライン評価が役立ちます。ただし、評価は開発の初期段階に限定されるわけではありません。たとえば、チューニングによってモデルのパフォーマンスが向上したかどうかを確認する、そのジョブ用のモデルはもっと小規模で十分かどうかを評価するといった堅牢なベンチマークには、大規模なデータセットを使用したより体系的なオフライン評価が不可欠です。デプロイ後は、パフォーマンスを継続的に評価し、アップグレードする時期を見極める必要があります。評価とは本質的に、開発プロセスの単なる一ステップではなく、生成 AI のデベロッパーが業務に取り入れなければならない継続的な実務と言えます。

多様な評価ユースケース全体にわたって最善のサポートを提供するため、Gen AI Evaluation Service では、デベロッパーが好みの IDE またはコーディング環境内で Vertex AI SDK を介してオンラインまたはオフライン評価を行えるようになっています。評価はすべて Vertex AI Experiments に自動的に記録されるため、テストを手動で追跡する必要はありません。また、Gen AI Evaluation Service には、Vertex AI Pipelines を使用して本番環境で評価とモニタリングを行うための事前構築されたパイプライン コンポーネントも用意されています。

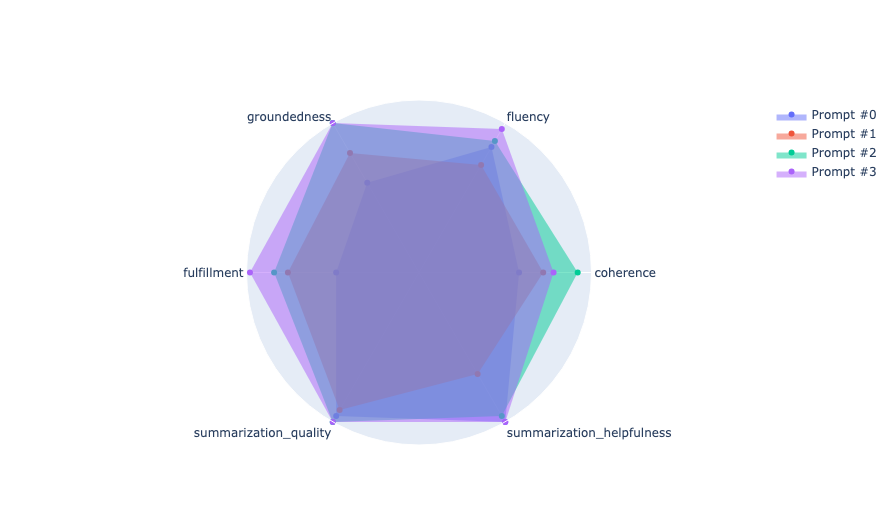

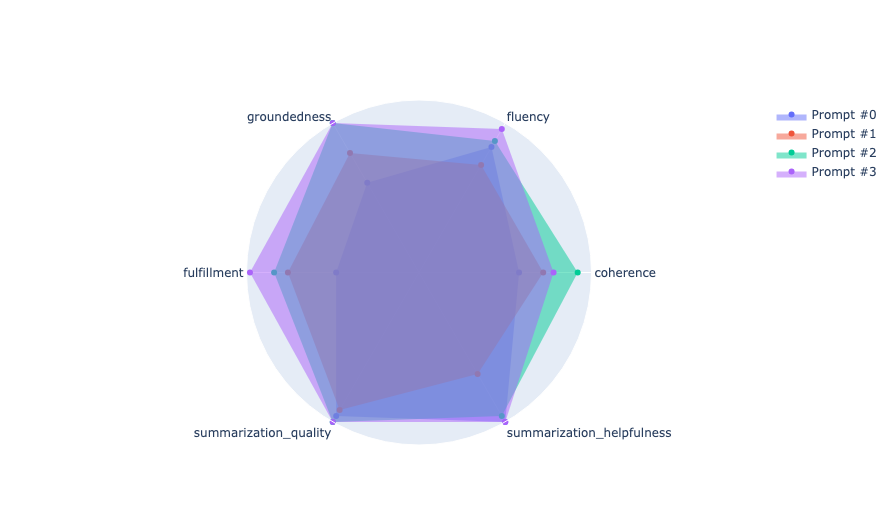

使用可能な評価方法は、3 つのグループに分類できます。最初のグループは、計算ベースの指標です。これにはグラウンド トゥルースが必要で、新しい出力をラベル付けされた入力 / 出力ペアのゴールデン データセットと比較する必要があります。Google には構築済み指標の豊富なライブラリがあり、これらをカスタマイズするオプションも提供しています。つまり、デベロッパーが評価基準を独自に定義し、任意の指標を実装できます。使用可能な各種指標をナビゲートしやすいように、ユースケースごとの適切な指標セットにワンクリックでアクセスできる指標バンドルも用意されています。以下のコード例は、Vertex AI SDK を使用して要約タスクを評価する方法を示します。

このコードでは、要約タスク評価用の指標バンドルを使用し、評価パラメータと指標を Vertex AI Experiments に自動的に記録しています。得られた評価指標の結果は、次のように集計して可視化できます。

計算ベースの指標は効率的で比較的費用がかからず、進捗の把握に役立ちます。ただし、生成タスクの本質を完全に捉えるには、計算ベースの指標だけでは十分ではありません。望ましい要約品質のすべてを 1 つの式に組み込むのは困難です。さらに、たとえ入念に作成されたゴールデン データセットであっても、ラベル付けされたサンプルとは異なる要約の方が望ましい場合もあります。そのため、追加の生成タスク評価方法が必要になります。

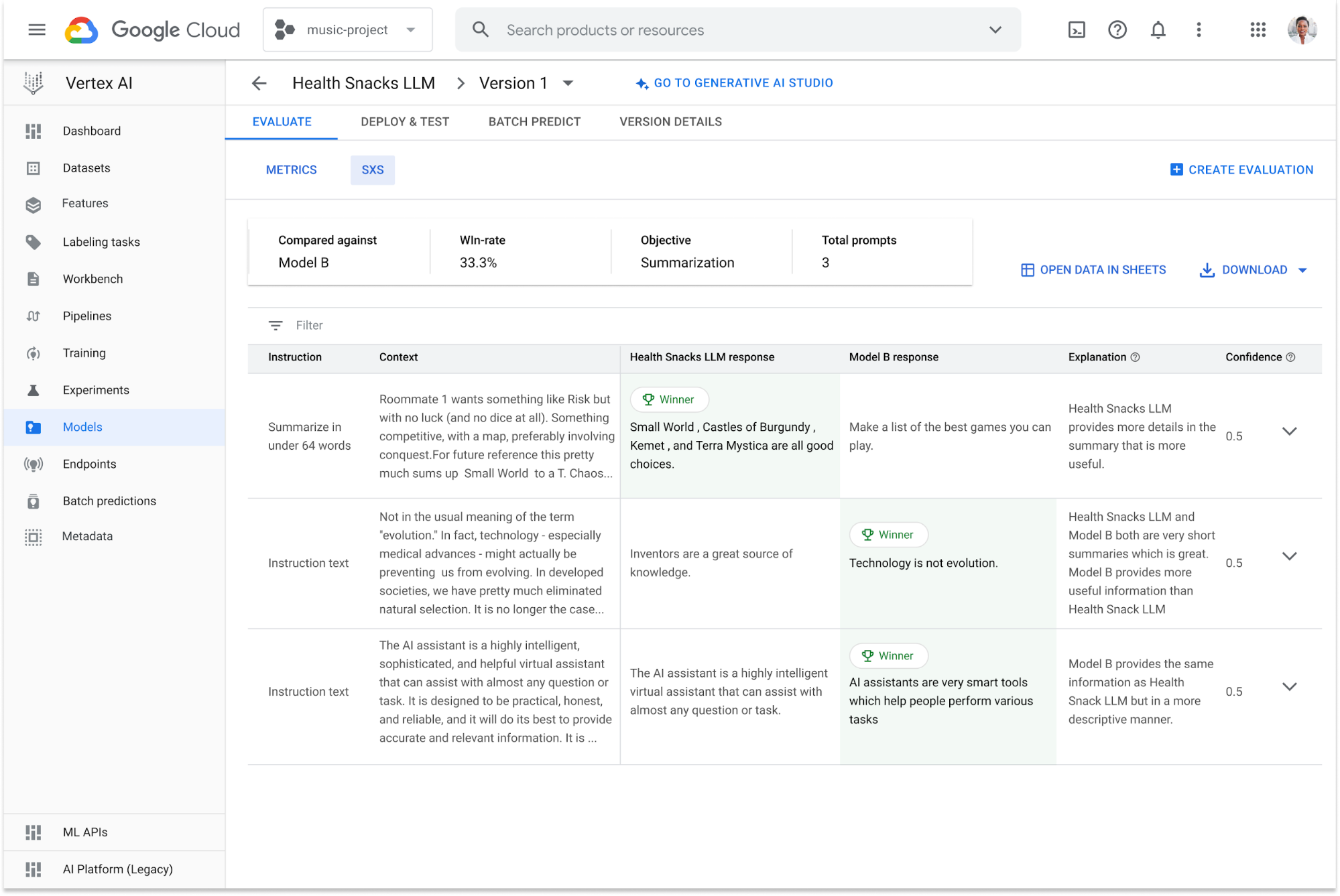

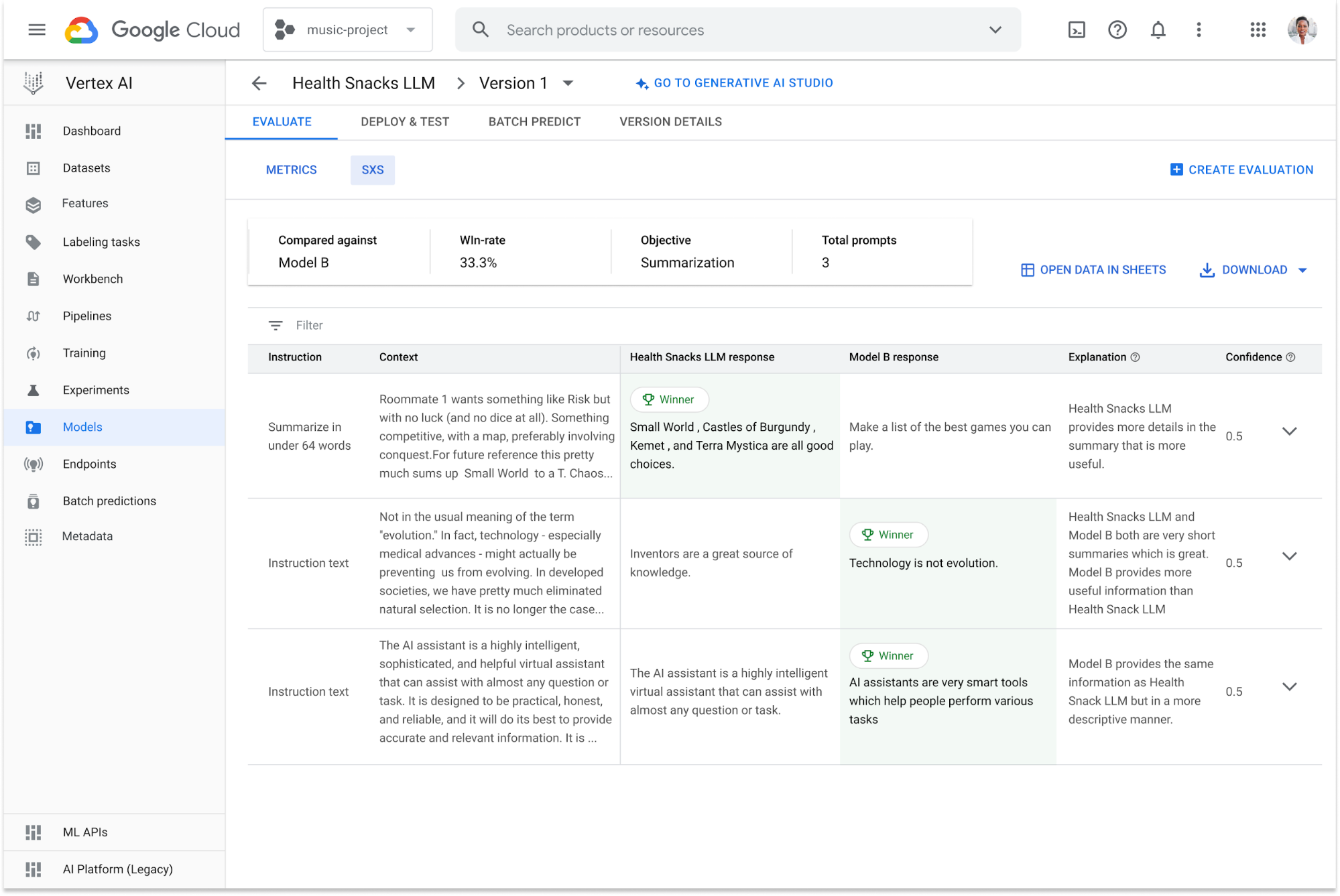

2 番目の評価方法グループは自動評価ツールで、これは LLM を「審査員」として使用します。審査員となる LLM は、評価タスクを実行するために特別にカスタマイズされています。この方法では、グラウンド トゥルースは必要ありません。デベロッパーは、1 つのモデルを評価するか、2 つのモデルを相互に比較するかを選択できます。Google の自動評価ツールは、品質を保証するために人間の評価者によって念入りに調整されています。これらはマネージド ツールであり、追加設定なしですぐに使用できます。ここで重要となるのは、自動評価ツールによる評価をデベロッパーが精査し、その結果を信頼できるものにすることです。そのため、自動評価ツールが下したそれぞれの判断に説明と信頼スコアが付けられます。次の図は、AutoSxS の出力例を示します。

上部の概要ボックスに、比較対象のモデル、評価データセット、「勝率」と呼ばれる全体的な結果などの簡単な要約が表示されます。勝率はパーセンテージで表され、Health Snacks LLM から出力された要約がモデル B より優れていた割合を示します。勝率をより深く理解できるように、自動評価ツールによる説明と信頼スコアを含む表形式の結果も表示されます。これらの結果や説明を期待していた結果と照らし合わせることで、目的のユースケースにおける自動評価ツールの精度を評価できます。入力プロンプトごとに、Health Snack LLM からのレスポンスとモデル B からのレスポンスが一覧表示されます。自動評価ツールがより優れた要約と判断した方には、左上隅に緑色の勝者アイコンが付いています。説明は勝者選択の根拠を示し、信頼スコアは自動評価ツールの自己一貫性に基づく選択の確信度を示します。

説明と信頼スコアに加えて、デベロッパー自身が自動評価ツールを調整して、全体的な評価プロセスの精度と信頼性に対する信頼度を高めることもできます。そのためには、アライメント集計統計を出力する AutoSxS に人間の好みのデータを直接提供する必要があります。これらの統計では、ランダムな一致を考慮して、自動評価ツールと人間の好みのデータとの一致が測定されます(コーエンのカッパ係数)。

人間による評価を取り入れることは重要ですが、人間による評価を収集することは、評価プロセス全体の中で最も時間のかかるタスクの一つです。そのため、Google の生成 AI 評価フレームワークには、人間によるレビューが 3 番目の評価方法グループとして統合されています。Google と LabelBox などのサードパーティ データ セントリック プロバイダとのパートナーシップにより、デベロッパーは、幅広いタスクや基準に照らし合わせた人間による評価に簡単にアクセスできます。

最後にまとめると、Gen AI Evaluation Service は、さまざまなチャネル(オンラインとオフライン)を通じてアクセスできる豊富な評価方法を提供しており、デベロッパーは LLM モデルでこれらの評価方法を使用して、生成 AI アプリケーションを効率的に評価するためのカスタマイズされた評価フレームワークを構築できます。

Gen AI Evaluation Service を使用して RAG ベースの LLM アプリケーションを本番環境に導入した Generali Italia の事例

イタリアの大手保険会社である Generali Italia は、Gen AI Evaluation Service の初期ユーザーの一つでした。Generali Italia のテクニカル リード責任者、Stefano Frigerio 氏は次のように述べています。

「LLM を本番環境に導入するうえで、モデル評価は成功への鍵でした。私たちには、非静的なエコシステムで出力を手動で確認して改良するような余裕はありませんでした。」

他の保険会社と同様に、Generali Italia は、保険証書、詳細な説明と期限が記載された保険料明細書など、さまざまな文書を作成します。Generali Italia は、検索拡張生成(RAG)技術を利用した生成 AI アプリケーションを開発しました。このイノベーションにより、従業員は会話形式で文書を扱えるようになり、情報検索が迅速化されました。しかし、検索機能と生成機能の両方を評価するための堅牢なフレームワークがなければ、このアプリケーションの導入を成功させることはできなかったでしょう。同社のチームはまず自分たちにとって重要なパフォーマンスの次元を定義してから、Gen AI Evaluation Service を使用してパフォーマンスをベースラインと比較評価しました。

Generali Italia のテクニカル リード データ サイエンティストである Ivan Vigorito 氏によると、Generali Italia が Vertex Gen AI Evaluation Service を採用した理由はいくつかあります。まず、AutoSxS という自動評価ツールにより、LLM からのレスポンスの品質評価において人間による評価をエミュレートできる点が挙げられます。これにより、手動での評価の必要性が減り、時間とリソースの両方が節約されました。また、Gen AI Evaluation Service のおかげで、事前に定義した基準に基づいて評価を行えるようになり、評価プロセスの客観性が高まりました。AutoSxS による説明と信頼スコアは、モデルのパフォーマンスを理解する助けとなり、アプリケーションを改善する道を示しました。最後に、Vertex Gen AI Evaluation Service は、事前に生成された予測や外部予測を使用することで、どのようなモデルでも評価できました。この機能は特に、Vertex AI でホストされていないモデルからの出力を比較するのに役立ちました。

Generali Italia のテクニカル リード ML エンジニアである Dominico Vitarella 氏によると、Gen AI Evaluation Service は、チームがモデルの評価に費やす時間と労力を節約するだけではありません。このサービスは Vertex AI にシームレスに組み込まれているため、単一の包括的なプラットフォームから生成アプリケーションと予測アプリケーションの両方のトレーニング、デプロイ、評価ができるという利点もあります。

まとめ

生成 AI アプリケーションの評価に苦労していませんか?

Gen AI Evaluation Service には、品質管理された説明可能な一連の評価方法が用意されており、これらを異なるモードで使用して特定のユースケースに応用可能な評価システムを構築できます。Gen AI Evaluation Service は、目的のタスクに適したモデルを見つけ、より迅速に試行錯誤し、自信を持ってモデルをデプロイするのに役立ちます。

次のステップ

Vertex AI の Gen AI Evaluation Service についてもっと詳しく知りたい場合は、次のリソースをご覧ください。

ドキュメント

Notebooks

動画およびブログ投稿

-セールス エンジニア Ivan Nardini

-Cloud AI プロダクト マネージャー Irina Sigler