Auf dieser Seite werden zwei Möglichkeiten beschrieben, wie Sie die Antworten eines Modells mit Vertex AI fundieren können. Außerdem erfahren Sie, wie Sie die Fundierung mithilfe der Grounding API in Ihren Anwendungen nutzen können.

Mit Vertex AI können Sie Modellausgaben mithilfe der folgenden Datenquellen fundieren:

- Google Suche: Antworten werden anhand öffentlich verfügbarer Webdaten fundiert.

- Meine Daten: Antworten werden anhand Ihrer Daten aus Vertex AI Search fundiert (Vorabversion).

Fundierung mit der Google Suche

Verwenden Sie die Funktion „Mit der Google Suche fundieren“, wenn Sie Ihr Modell mit dem Wissen der ganzen Welt, einer Vielzahl von Themen oder aktuellen Informationen im Internet verknüpfen möchten.

Die Funktion „Mit der Google Suche fundieren“ unterstützt die dynamische Abfrage, mit der Sie fundierte Antworten mit der Google Suche generieren können. Daher wird in der Konfiguration für die dynamische Abfrage geprüft, ob für einen Prompt Wissen über aktuelle Ereignisse erforderlich ist, und die Fundierung mit der Google Suche wird aktiviert. Weitere Informationen finden Sie unter Dynamisches Abrufen.

Weitere Informationen zur Fundierung in Vertex AI finden Sie im Fundierungs-Überblick.

Unterstützte Modelle

In der folgenden Tabelle sind die Modelle aufgeführt, die Grounding unterstützen. Wenn Sie sehen möchten, wie jedes Modell fundierte Antworten generiert, testen Sie das Modell in der Google Cloud Console und klicken Sie auf die Ein/Aus-Schaltfläche Fundierung.

| Modell | Beschreibung | Modell testen |

|---|---|---|

|

Gemini 1.5 Pro |

Nur Texteingabe | Gemini 1.5 Pro-Modell testen |

|

Gemini 1.5 Flash |

Nur Texteingabe | Gemini 1.5 Flash-Modell testen |

|

Gemini 1.0 Pro |

Nur Texteingabe | Gemini 1.0 Pro-Modell testen |

|

Gemini 2.0 Flash |

Text, Code, Bilder, Audio, Video, Video mit Audio, PDF Unterstützt kein dynamisches Abrufen. Weitere Informationen finden Sie unter Hinweise. |

Gemini 2.0 Flash-Modell testen |

Unterstützte Sprachen

Eine Liste der unterstützten Sprachen finden Sie unter Sprachen.

Modell mit der Google Suche fundieren

Folgen Sie der nachstehenden Anleitung, um ein Modell mit öffentlich verfügbaren Webdaten zu fundieren.

Dynamische Abfrage

Mit der dynamischen Abfrage in Ihrer Anfrage können Sie festlegen, wann die Funktion „Mit der Google Suche fundieren“ deaktiviert werden soll. Das ist nützlich, wenn für den Prompt keine Antwort erforderlich ist, die auf der Google Suche basiert, und die unterstützten Modelle eine Antwort auf der Grundlage ihres Wissens ohne Grundwahrheit liefern können. So lassen sich Latenz, Qualität und Kosten effizienter verwalten.

Bevor Sie die Konfiguration für den dynamischen Abruf in Ihrer Anfrage aufrufen, sollten Sie sich mit den folgenden Begriffen vertraut machen:

Vorhersagewert: Wenn Sie eine fundierte Antwort anfordern, weist Vertex AI dem Prompt einen Vorhersagewert zu. Der Vorhersagewert ist ein Gleitkommawert im Bereich [0,1]. Der Wert hängt davon ab, ob die Antwort auf den Prompt durch die neuesten Informationen aus der Google Suche fundiert werden kann. Daher hat ein Prompt, für den eine Antwort auf der Grundlage der neuesten Fakten im Web erforderlich ist, eine höhere Vorhersagebewertung. Ein Prompt, für den eine vom Modell generierte Antwort ausreicht, hat einen niedrigeren Vorhersagewert.

Hier sind einige Beispiele für Prompts und ihre Vorhersagewerte.

Prompt Vorhersagewert Kommentar „Schreib ein Gedicht über Pfingstrosen“ 0,13 Das Modell kann auf sein Wissen zurückgreifen und die Antwort muss nicht begründet werden. „Empfehle mir ein Spielzeug für ein zweijähriges Kind“ 0,36 Das Modell kann auf sein Wissen zurückgreifen und die Antwort muss nicht begründet werden. „Kannst du mir ein Rezept für eine asiatisch inspirierte Guacamole nennen?“ 0,55 Die Google Suche kann eine fundierte Antwort liefern, eine Fundierung ist aber nicht unbedingt erforderlich. Das Modellwissen reicht möglicherweise aus. „Was ist Agent Builder? Wie wird die Fundierung in Agent Builder abgerechnet?“ 0,72 Erfordert die Google Suche, um eine fundierte Antwort zu generieren „Wer hat den letzten Formel-1-Grand-Prix gewonnen?“ 0,97 Erfordert die Google Suche, um eine fundierte Antwort zu generieren Schwellenwert: In Ihrer Anfrage können Sie eine Konfiguration für den dynamischen Abruf mit einem Grenzwert angeben. Der Schwellenwert ist ein Gleitkommawert im Bereich [0,1] und standardmäßig auf 0,7 festgelegt. Wenn der Schwellenwert null ist, wird die Antwort immer mit der Google Suche fundiert. Für alle anderen Schwellenwerte gilt Folgendes:

- Wenn der Vorhersagewert größer oder gleich dem Schwellenwert ist, basiert die Antwort auf der Google Suche. Ein niedrigerer Schwellenwert bedeutet, dass für mehr Prompts Antworten mithilfe der Google Suche generiert werden.

- Wenn der Vorhersagewert unter dem Schwellenwert liegt, generiert das Modell möglicherweise trotzdem eine Antwort, die aber nicht auf der Google Suche basiert.

Um einen geeigneten Schwellenwert für Ihre Geschäftsanforderungen zu finden, können Sie eine repräsentative Reihe von Suchanfragen erstellen, die Sie voraussichtlich erhalten werden. Anschließend können Sie die Abfragen nach dem Vorhersagewert in der Antwort sortieren und einen geeigneten Schwellenwert für Ihren Anwendungsfall auswählen.

Hinweise

Wenn Sie die Funktion „Fundierung mit der Google Suche“ verwenden möchten, müssen Sie die Google-Suchvorschläge aktivieren. Weitere Informationen finden Sie unter Google-Suchvorschläge.

Die besten Ergebnisse erzielen Sie mit einer Temperatur von

0.0. Weitere Informationen zum Festlegen dieser Konfiguration finden Sie unter Gemini API-Anfragetext in der Modellreferenz.Die Fundierung mit der Google Suche ist auf eine Million Abfragen pro Tag beschränkt. Wenn du weitere Fragen hast, wende dich bitte an den Google Cloud Support.

Nur die Gemini 1.0- und Gemini 1.5-Modelle unterstützen die dynamische Abfrage. Die Gemini 2.0-Modelle unterstützen kein dynamisches Abrufen.

REST

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- LOCATION: Die Region, in der die Anfrage verarbeitet werden soll.

- PROJECT_ID: Ihre Projekt-ID.

- MODEL_ID: Die Modell-ID des multimodalen Modells. Nur die Gemini 1.0- und Gemini 1.5-Modelle unterstützen den dynamischen Abruf. Die Gemini 2.0-Modelle unterstützen kein dynamisches Abrufen.

- TEXT: Die Textanleitung, die in den Prompt eingefügt werden soll.

- DYNAMIC_THRESHOLD: Optionales Feld zum Festlegen des Grenzwerts, bei dem die Konfiguration für die dynamische Abfrage aufgerufen wird. Es ist ein Gleitkommawert im Bereich [0,1]. Wenn Sie das Feld

dynamicThresholdnicht festlegen, wird der Schwellenwert standardmäßig auf 0,7 festgelegt.

HTTP-Methode und URL:

POST https://LOCATION-aiplatform.googleapis.com/v1beta1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/MODEL_ID:generateContent

JSON-Text anfordern:

{

"contents": [{

"role": "user",

"parts": [{

"text": "TEXT"

}]

}],

"tools": [{

"googleSearchRetrieval": {

"dynamicRetrievalConfig": {

"mode": "MODE_DYNAMIC",

"dynamicThreshold": DYNAMIC_THRESHOLD

}

}

}],

"model": "projects/PROJECT_ID/locations/LOCATION/publishers/google/models/MODEL_ID"

}

Wenn Sie die Anfrage senden möchten, maximieren Sie eine der folgenden Optionen:

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

{

"candidates": [

{

"content": {

"role": "model",

"parts": [

{

"text": "Chicago weather changes rapidly, so layers let you adjust easily. Consider a base layer, a warm mid-layer (sweater-fleece), and a weatherproof outer layer."

}

]

},

"finishReason": "STOP",

"safetyRatings":[

"..."

],

"groundingMetadata": {

"webSearchQueries": [

"What's the weather in Chicago this weekend?"

],

"searchEntryPoint": {

"renderedContent": "....................."

}

"groundingSupports": [

{

"segment": {

"startIndex": 0,

"endIndex": 65,

"text": "Chicago weather changes rapidly, so layers let you adjust easily."

},

"groundingChunkIndices": [

0

],

"confidenceScores": [

0.99

]

},

]

"retrievalMetadata": {

"webDynamicRetrievalScore": 0.96879

}

}

}

],

"usageMetadata": { "..."

}

}

Node.js

Bevor Sie dieses Beispiel anwenden, folgen Sie den Node.js-Einrichtungsschritten in der Vertex AI-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Informationen finden Sie in der Referenzdokumentation zur Vertex AI Node.js API.

Richten Sie zur Authentifizierung bei Vertex AI Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für eine lokale Entwicklungsumgebung einrichten.

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

LOCATION: Die Region, in der die Anfrage verarbeitet werden soll.

PROJECT_ID: Ihre Projekt-ID.

MODEL_ID: Die Modell-ID des multimodalen Modells. Nur die Gemini 1.0- und Gemini 1.5-Modelle unterstützen das dynamische Abrufen. Die Gemini 2.0-Modelle unterstützen kein dynamisches Abrufen.

TEXT: Die Textanleitung, die in den Prompt eingefügt werden soll.

DYNAMIC_THRESHOLD: Optionales Feld zum Festlegen des Grenzwerts, bei dem die Konfiguration für die dynamische Abfrage aufgerufen wird. Es ist ein Gleitkommawert im Bereich

[0,1]. Wenn Sie das FelddynamicThresholdnicht festlegen, wird der Schwellenwert standardmäßig auf0.7festgelegt.

const {VertexAI} = require('@google-cloud/vertexai');

// Initialize Vertex with your Cloud project and location

const vertex_ai = new VertexAI({project: PROJECT_ID, location: LOCATION});

const model = MODEL_ID;

// Instantiate the models

const generativeModel = vertex_ai.preview.getGenerativeModel({

model: model,

generationConfig: {

'maxOutputTokens': 8192,

'temperature': 1,

'topP': 0.95,

},

safetySettings: [

{

'category': 'HARM_CATEGORY_HATE_SPEECH',

'threshold': 'OFF',

},

{

'category': 'HARM_CATEGORY_DANGEROUS_CONTENT',

'threshold': 'OFF',

},

{

'category': 'HARM_CATEGORY_SEXUALLY_EXPLICIT',

'threshold': 'OFF',

},

{

'category': 'HARM_CATEGORY_HARASSMENT',

'threshold': 'OFF',

}

],

tools: [

{

googleSearchRetrieval: {

dynamicRetrievalConfig: {

mode: "MODE_DYNAMIC",

dynamicThreshold: DYNAMIC_THRESHOLD

}

},

},

],

});

async function generateContent() {

const req = {

contents: [

{role: 'user', parts: [{text: `TEXT`}]}

],

};

const streamingResp = await generativeModel.generateContentStream(req);

for await (const item of streamingResp.stream) {

process.stdout.write('stream chunk: ' + JSON.stringify(item) + '\n');

}

process.stdout.write('aggregated response: ' + JSON.stringify(await streamingResp.response));

}

generateContent();

Console

So verwenden Sie die Fundierung mit der Google Suche mit Vertex AI Studio:

- Rufen Sie in der Google Cloud Console die Seite „Vertex AI Studio“ auf.

- Klicken Sie auf den Tab Freies Format.

- Klicken Sie in der Seitenleiste auf die Ein/Aus-Schaltfläche Antworten für Bodenmodelle.

- Klicken Sie auf Anpassen und legen Sie die Google Suche als Quelle fest.

- Geben Sie Ihren Prompt in das Textfeld ein und klicken Sie auf Senden.

Ihre Prompt-Antworten werden jetzt in der Google Suche fundiert.

Python

Informationen zur Installation des Vertex AI SDK for Python finden Sie unter Vertex AI SDK for Python installieren. Weitere Informationen finden Sie in der Referenzdokumentation zur Python API.

Ihre Antwort verstehen

Wenn Ihr Modell-Prompt von Vertex AI Studio oder der API erfolgreich bei der Google Suche fundiert wird, enthalten die Antworten Metadaten mit Quelllinks (Web-URLs). Es gibt jedoch mehrere Gründe, warum diese Metadaten möglicherweise nicht bereitgestellt werden und die Prompt-Antwort nicht fundiert wird. Dazu gehören eine geringe Quellenrelevanz oder unvollständige Informationen in der Antwort des Modells.

Zitationen

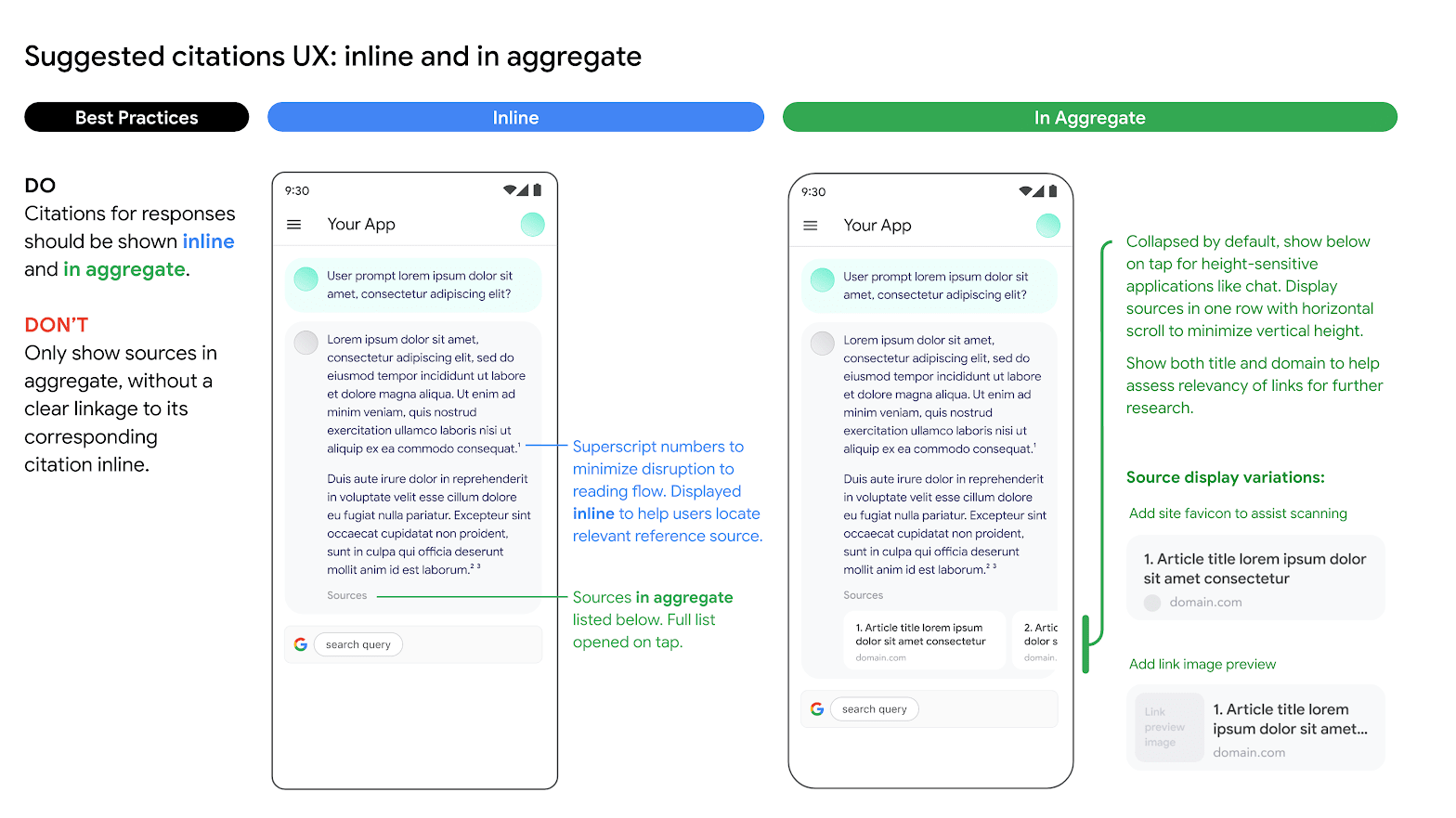

Die Anzeige von Zitaten wird dringend empfohlen. Sie helfen den Nutzern, die Antworten der Publisher selbst zu validieren, und bieten Möglichkeiten zum weiteren Lernen.

Zitate für Antworten aus Quellen der Google Suche sollten sowohl inline als auch aggregiert angezeigt werden. In der folgenden Abbildung sehen Sie einen Vorschlag dafür.

Verwendung alternativer Suchmaschinenoptionen

Die Verwendung der Funktion „Grundlagen mit der Google Suche“ durch den Kunden hindert ihn nicht daran, alternative Suchmaschinenoptionen anzubieten, alternative Suchoptionen als Standardoption für Kundenanwendungen festzulegen oder eigene Suchvorschläge oder Suchergebnisse von Drittanbietern in Kundenanwendungen anzuzeigen, sofern diese Dienste oder zugehörigen Ergebnisse, die nicht von der Google Suche stammen, getrennt von den Ergebnissen der Funktion „Grundlagen“ und den Suchvorschlägen angezeigt werden und nicht vernünftigerweise Google-Ergebnissen zugeordnet oder mit diesen verwechselt werden können.

Gemini auf Basis Ihrer Daten fundieren

In diesem Abschnitt wird gezeigt, wie Sie mithilfe der Vertex AI API Textantworten auf einem Vertex AI Agent Builder-Datenspeicher fundieren. Sie können keinen Website-Suchdatenspeicher als Referenzquelle angeben.

Unterstützte Modelle

Die folgenden Modelle unterstützen Grounding:

- Gemini 1.5 Pro nur mit Texteingabe

- Gemini 1.5 Flash nur mit Texteingabe

- Gemini 1.0 Pro nur mit Texteingabe

- Gemini 2.0 Flash

Vorbereitung

Es sind bestimmte Voraussetzungen erforderlich, bevor Sie die Modellausgabe auf Ihren Daten fundieren können.

- Aktivieren Sie Vertex AI Agent Builder und die API.

- Erstellen Sie Datenquelle und Anwendung für Vertex AI Agent Builder.

- Verknüpfen Sie Ihren Datenspeicher mit Ihrer Anwendung im Vertex AI Agent Builder. Die Datenquelle dient als Grundlage für das Grounding von Gemini 1.0 Pro in Vertex AI. Sie können keinen Website-Suchdatenspeicher als Referenzquelle angeben.

- Aktivieren Sie die Enterprise-Version für Ihren Datenspeicher.

Weitere Informationen finden Sie unter Einführung in Vertex AI Search.

Vertex AI Agent Builder aktivieren

Rufen Sie in der Google Cloud Console die Seite Agent Builder auf.

Lesen und akzeptieren Sie die Nutzungsbedingungen und klicken Sie anschließend auf Fortfahren und API aktivieren.

Vertex AI Agent Builder ist am Standort global oder am multiregionalen Standort eu und us verfügbar. Weitere Informationen finden Sie unter Standorte von Vertex AI Agent Builder.

Datenspeicher in Vertex AI Agent Builder erstellen

Um Ihre Modelle auf Ihren Quelldaten zu fundieren, müssen Sie die Daten vorbereitet und in Vertex AI Search gespeichert haben. Dazu müssen Sie einen Datenspeicher in Vertex AI Agent Builder erstellen.

Wenn Sie bei null beginnen, müssen Sie Ihre Daten für die Aufnahme in den Vertex AI Agent Builder vorbereiten. Weitere Informationen finden Sie unter Daten für die Aufnahme vorbereiten. Je nach Größe der Daten kann die Datenaufnahme einige Minuten bis mehrere Stunden dauern. Nur unstrukturierte Datenspeicher werden für das Fundieren unterstützt.

Nachdem Sie Ihre Daten für die Datenaufnahme vorbereitet haben, können Sie einen Suchdatenspeicher erstellen. Nachdem Sie erfolgreich einen Datenspeicher erstellt haben, erstellen Sie eine Suchanwendung, um eine Verknüpfung dazu herzustellen, und aktivieren Sie die Enterprise-Version.

Beispiel: Gemini 1.5-Flash-Modell fundieren

Folgen Sie der nachstehenden Anleitung, um ein Modell mit Ihren eigenen Daten zu fundieren.

Wenn Sie Ihre Datenspeicher-ID nicht kennen, gehen Sie so vor:

Rufen Sie in der Google Cloud Console die Seite Vertex AI Agent Builder auf und klicken Sie im Navigationsmenü auf Datenspeicher.

Klicken Sie auf den Namen des Datenspeichers.

Rufen Sie auf der Datenseite Ihres Datenspeichers die Datenspeicher-ID ab. Sie können keinen Website-Suchdatenspeicher als Referenzquelle angeben.

REST

Senden Sie zum Testen eines Text-Prompts mit der Vertex AI API eine POST-Anfrage an den Endpunkt des Publisher-Modells.

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- LOCATION: Die Region, in der die Anfrage verarbeitet werden soll.

- PROJECT_ID: Ihre Projekt-ID.

- MODEL_ID: Die Modell-ID des multimodalen Modells.

- TEXT: Die Textanleitung, die in den Prompt eingefügt werden soll.

HTTP-Methode und URL:

POST https://LOCATION-aiplatform.googleapis.com/v1beta1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/MODEL_ID:generateContent

JSON-Text anfordern:

{

"contents": [{

"role": "user",

"parts": [{

"text": "TEXT"

}]

}],

"tools": [{

"retrieval": {

"vertexAiSearch": {

"datastore": projects/PROJECT_ID/locations/global/collections/default_collection/dataStores/DATA_STORE_ID

}

}

}],

"model": "projects/PROJECT_ID/locations/LOCATION/publishers/google/models/MODEL_ID"

}

Wenn Sie die Anfrage senden möchten, maximieren Sie eine der folgenden Optionen:

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

{

"candidates": [

{

"content": {

"role": "model",

"parts": [

{

"text": "You can make an appointment on the website https://dmv.gov/"

}

]

},

"finishReason": "STOP",

"safetyRatings": [

"..."

],

"groundingMetadata": {

"retrievalQueries": [

"How to make appointment to renew driving license?"

],

"groundingChunks": [

{

"retrievedContext": {

"uri": "https://vertexaisearch.cloud.google.com/grounding-api-redirect/AXiHM.....QTN92V5ePQ==",

"title": "dmv"

}

}

],

"groundingSupport": [

{

"segment": {

"startIndex": 25,

"endIndex": 147

},

"segment_text": "ipsum lorem ...",

"supportChunkIndices": [1, 2],

"confidenceScore": [0.9541752, 0.97726375]

},

{

"segment": {

"startIndex": 294,

"endIndex": 439

},

"segment_text": "ipsum lorem ...",

"supportChunkIndices": [1],

"confidenceScore": [0.9541752, 0.9325467]

}

]

}

}

],

"usageMetadata": {

"..."

}

}

Antwort, die auf der Google Suche basiert

Wenn ein fundiertes Ergebnis generiert wird, enthalten die Metadaten einen URI, der zum Verlag bzw. Webpublisher der Inhalte weiterleitet, die zum Generieren des fundierten Ergebnisses verwendet wurden. Die Metadaten enthalten auch die Domain des Publishers. Die angegebenen URIs sind 30 Tage lang nach der Generierung des gefundeten Ergebnisses zugänglich.

Python

Informationen zur Installation des Vertex AI SDK for Python finden Sie unter Vertex AI SDK for Python installieren. Weitere Informationen finden Sie in der Referenzdokumentation zur Python API.

Console

Führen Sie die folgenden Schritte aus, um Ihre Modellausgabe im Vertex AI Agent Builder zu fundieren. Dazu nutzen Sie Vertex AI Studio in der Google Cloud Console:

- Rufen Sie in der Google Cloud Console die Seite „Vertex AI Studio“ auf.

- Klicken Sie auf den Tab Freies Format.

- Klicken Sie in der Seitenleiste auf die Ein/Aus-Schaltfläche Modellantworten erden, um die Erdung zu aktivieren.

- Klicken Sie auf Anpassen und legen Sie Vertex AI Agent Builder als Quelle fest. Der Pfad muss das folgende Format haben: projects/project_id/locations/global/collections/default_collection/dataStores/data_store_id.

- Geben Sie Ihren Prompt in das Textfeld ein und klicken Sie auf Senden.

Ihre Prompt-Antworten werden jetzt in Vertex AI Agent Builder fundiert.

Weitere Ressourcen zu generativer KI

- Informationen zum Senden von Anfragen für Chat-Prompts finden Sie unter Mehrere Antworten in einem Chat.

- Weitere Informationen zu Best Practices für verantwortungsbewusste KI und den Sicherheitsfiltern von Vertex AI finden Sie unter Best Practices für Sicherheit.

- Informationen zur Einbindung der PaLM-Modelle finden Sie unter Grounding in Vertex AI.