L-diversity adalah properti set data dan ekstensi k-anonymity yang mengukur keragaman nilai sensitif untuk setiap kolom tempat nilai tersebut muncul. Sebuah set data memiliki l-diversity jika, untuk setiap set baris dengan pengidentifikasi semu yang identik, terdapat setidaknya l nilai berbeda untuk setiap atribut sensitif.

Anda dapat menghitung nilai keragaman l berdasarkan satu atau beberapa kolom, atau kolom, dari set data. Topik ini menunjukkan cara menghitung nilai keragaman l untuk set data menggunakan Perlindungan Data Sensitif. Untuk mengetahui informasi selengkapnya tentang keragaman l atau analisis risiko secara umum, lihat topik konsep analisis risiko sebelum melanjutkan.

Sebelum memulai

Sebelum melanjutkan, pastikan Anda telah melakukan hal berikut:

- Login ke Akun Google Anda.

- Di konsol Google Cloud , pada halaman pemilih project, pilih atau buat project Google Cloud . Buka pemilih project

- Pastikan penagihan diaktifkan untuk Google Cloud project Anda. Pelajari cara mengonfirmasi bahwa penagihan diaktifkan untuk project Anda.

- Aktifkan Sensitive Data Protection. Mengaktifkan Sensitive Data Protection

- Pilih set data BigQuery yang akan dianalisis. Sensitive Data Protection menghitung metrik keragaman l dengan memindai tabel BigQuery.

- Tentukan ID kolom sensitif (jika ada) dan setidaknya satu quasi-ID dalam set data. Untuk mengetahui informasi selengkapnya, lihat Istilah dan teknik analisis risiko.

Menghitung l-diversity

Sensitive Data Protection melakukan analisis risiko setiap kali tugas analisis risiko dijalankan. Anda harus membuat tugas terlebih dahulu, baik menggunakan Google Cloud konsol, mengirim permintaan DLP API, atau menggunakan library klien Sensitive Data Protection.

Konsol

Di konsol Google Cloud , buka halaman Create risk analysis.

Di bagian Pilih data input, tentukan tabel BigQuery yang akan dipindai dengan memasukkan project ID project yang berisi tabel, ID set data tabel, dan nama tabel.

Di bagian Metrik privasi yang akan dihitung, pilih l-diversity.

Di bagian Job ID, Anda dapat memberikan ID kustom untuk tugas dan memilih lokasi resource tempat Sensitive Data Protection akan memproses data Anda. Setelah selesai, klik Lanjutkan.

Di bagian Tentukan kolom, Anda menentukan kolom sensitif dan quasi-identifier untuk tugas risiko l-diversity l. Perlindungan Data Sensitif mengakses metadata tabel BigQuery yang Anda tentukan pada langkah sebelumnya dan mencoba mengisi daftar kolom.

- Pilih kotak centang yang sesuai untuk menentukan kolom sebagai kolom sensitif (S) atau quasi-ID (QI). Anda harus memilih 1 kolom sensitif dan minimal 1 quasi-ID.

- Jika Perlindungan Data Sensitif tidak dapat mengisi kolom, klik Masukkan nama kolom untuk memasukkan satu atau beberapa kolom secara manual dan menetapkan setiap kolom sebagai kolom sensitif atau quasi-ID. Setelah selesai, klik Lanjutkan.

Di bagian Tambahkan tindakan, Anda dapat menambahkan tindakan opsional yang akan dilakukan saat tugas risiko selesai. Opsi yang tersedia adalah:

- Simpan ke BigQuery: Menyimpan hasil pemindaian analisis risiko ke tabel BigQuery.

Publikasikan ke Pub/Sub: Memublikasikan notifikasi ke topik Pub/Sub.

Beri tahu melalui email: Mengirimkan email yang berisi hasil kepada Anda. Setelah selesai, klik Buat.

Tugas analisis risiko keragaman l akan segera dimulai.

C#

Untuk mempelajari cara menginstal dan menggunakan library klien untuk Sensitive Data Protection, lihat library klien Sensitive Data Protection.

Untuk melakukan autentikasi ke Sensitive Data Protection, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan autentikasi untuk lingkungan pengembangan lokal.

Go

Untuk mempelajari cara menginstal dan menggunakan library klien untuk Sensitive Data Protection, lihat library klien Sensitive Data Protection.

Untuk melakukan autentikasi ke Sensitive Data Protection, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan autentikasi untuk lingkungan pengembangan lokal.

Java

Untuk mempelajari cara menginstal dan menggunakan library klien untuk Sensitive Data Protection, lihat library klien Sensitive Data Protection.

Untuk melakukan autentikasi ke Sensitive Data Protection, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan autentikasi untuk lingkungan pengembangan lokal.

Node.js

Untuk mempelajari cara menginstal dan menggunakan library klien untuk Sensitive Data Protection, lihat library klien Sensitive Data Protection.

Untuk melakukan autentikasi ke Sensitive Data Protection, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan autentikasi untuk lingkungan pengembangan lokal.

PHP

Untuk mempelajari cara menginstal dan menggunakan library klien untuk Sensitive Data Protection, lihat library klien Sensitive Data Protection.

Untuk melakukan autentikasi ke Sensitive Data Protection, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan autentikasi untuk lingkungan pengembangan lokal.

Python

Untuk mempelajari cara menginstal dan menggunakan library klien untuk Sensitive Data Protection, lihat library klien Sensitive Data Protection.

Untuk melakukan autentikasi ke Sensitive Data Protection, siapkan Kredensial Default Aplikasi. Untuk mengetahui informasi selengkapnya, lihat Menyiapkan autentikasi untuk lingkungan pengembangan lokal.

REST

Untuk menjalankan tugas analisis risiko baru guna menghitung keragaman l, kirim permintaan ke resource

projects.dlpJobs, dengan PROJECT_ID menunjukkan ID project

Anda:

https://dlp.googleapis.com/v2/projects/PROJECT_ID/dlpJobs

Permintaan berisi objek

RiskAnalysisJobConfig, yang terdiri dari berikut ini:

Objek

PrivacyMetric. Di sinilah Anda menentukan bahwa Anda menghitung keragaman l dengan menyertakan objekLDiversityConfig.Objek

BigQueryTable. Tentukan tabel BigQuery yang akan dipindai dengan menyertakan semua hal berikut:projectId: Project ID project yang berisi tabel.datasetId: ID set data tabel.tableId: Nama tabel.

Kumpulan satu atau beberapa objek

Action, yang merepresentasikan tindakan yang akan dijalankan, dalam urutan yang diberikan, setelah penyelesaian tugas. Setiap objekActiondapat berisi salah satu tindakan berikut:SaveFindingsobject: Menyimpan hasil pemindaian analisis risiko ke tabel BigQuery.PublishToPubSubobject: Memublikasikan notifikasi ke topik Pub/Sub.JobNotificationEmailsobjek: Mengirimi Anda email berisi hasil.

Dalam objek

LDiversityConfig, Anda menentukan hal berikut:quasiIds[]: Sekumpulan kuasi-pengenal (objekFieldId) yang menunjukkan cara kelas kesetaraan ditentukan untuk komputasi l-keragaman. SepertiKAnonymityConfig, saat Anda menentukan beberapa kolom, kolom tersebut dianggap sebagai satu kunci gabungan.sensitiveAttribute: Kolom sensitif (objekFieldId) untuk menghitung nilai keragaman l.

Segera setelah Anda mengirim permintaan ke DLP API, API tersebut akan memulai tugas analisis risiko.

Mencantumkan tugas analisis risiko yang selesai

Anda dapat melihat daftar tugas analisis risiko yang telah dijalankan di project saat ini.

Konsol

Untuk mencantumkan tugas analisis risiko yang sedang berjalan dan yang sebelumnya dijalankan di konsol Google Cloud , lakukan hal berikut:

Di Google Cloud console, buka Sensitive Data Protection.

Klik tab Tugas & pemicu tugas di bagian atas halaman.

Klik tab Risk jobs.

Daftar tugas risiko akan muncul.

Protokol

Untuk membuat daftar tugas analisis risiko yang sedang berjalan dan yang sebelumnya berjalan, kirim permintaan GET ke

resource

projects.dlpJobs. Menambahkan filter jenis tugas (?type=RISK_ANALYSIS_JOB) akan mempersempit respons hanya untuk tugas analisis risiko.

https://dlp.googleapis.com/v2/projects/PROJECT_ID/dlpJobs?type=RISK_ANALYSIS_JOB

Respons yang Anda terima berisi representasi JSON dari semua tugas analisis risiko saat ini dan sebelumnya.

Melihat hasil tugas l-diversity

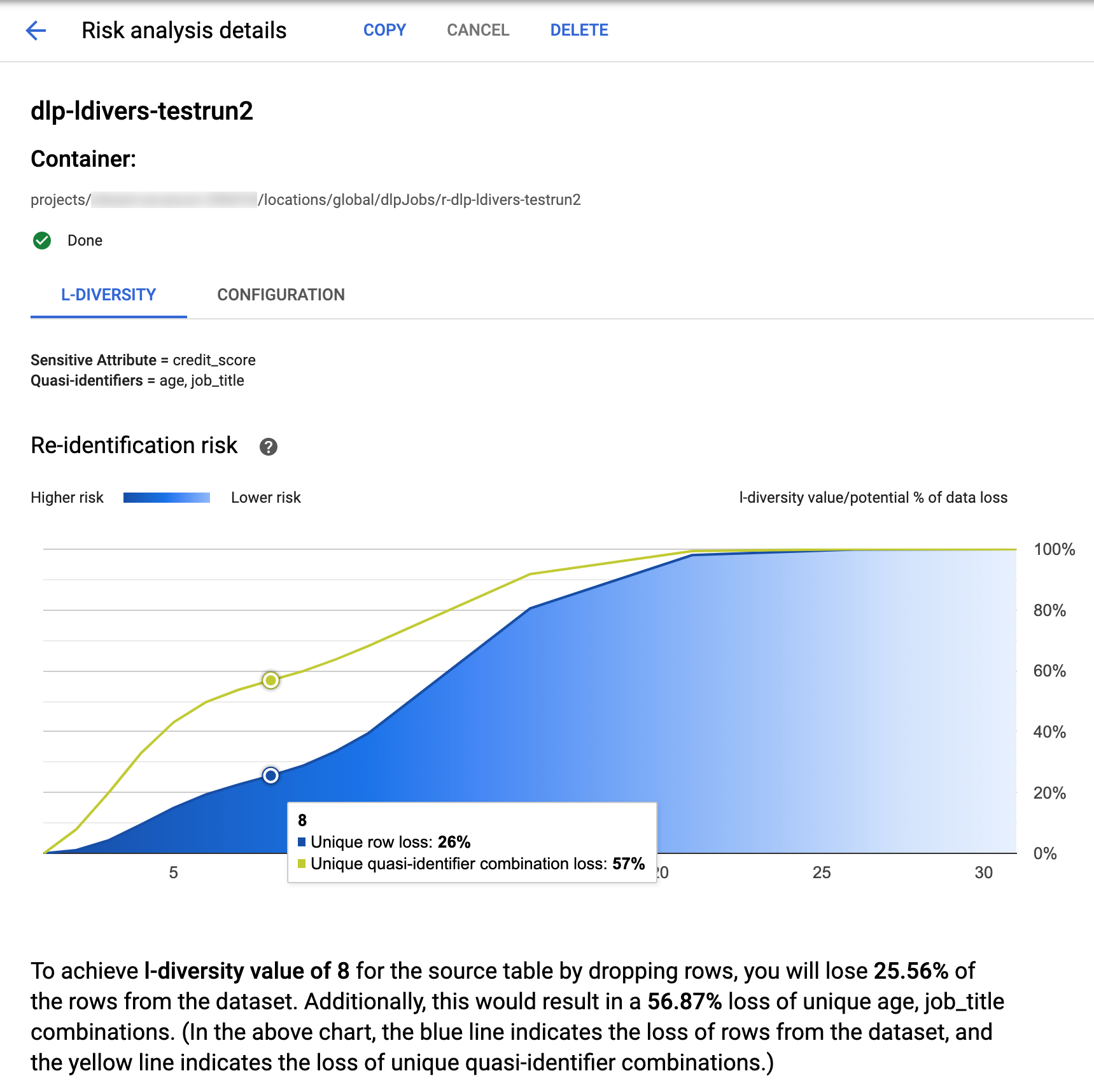

Sensitive Data Protection di konsol menampilkan visualisasi bawaan untuk tugas l-diversity yang telah selesai. Google Cloud Setelah mengikuti petunjuk di bagian sebelumnya, dari daftar tugas analisis risiko, pilih tugas yang hasilnya ingin Anda lihat. Dengan asumsi tugas telah berjalan dengan berhasil, bagian atas halaman Detail analisis risiko akan terlihat seperti ini:

Di bagian atas halaman terdapat informasi tentang tugas risiko keragaman l, termasuk ID tugasnya dan, di bagian Container, lokasi resource-nya.

Untuk melihat hasil penghitungan l-diversity, klik tab L-diversity. Untuk melihat konfigurasi tugas analisis risiko, klik tab Konfigurasi.

Tab L-diversity pertama-tama mencantumkan nilai sensitif dan quasi-identifier yang digunakan untuk menghitung l-diversity.

Bagan risiko

Diagram Risiko identifikasi ulang memetakan, pada sumbu y, potensi persentase kehilangan data untuk baris unik dan kombinasi quasi-ID unik untuk mencapai nilai l-diversity pada sumbu x. Warna diagram juga menunjukkan potensi risiko. Warna biru yang lebih gelap menunjukkan risiko yang lebih tinggi, sedangkan warna yang lebih terang menunjukkan risiko yang lebih rendah.

Nilai l-diversity yang lebih tinggi menunjukkan keragaman nilai yang lebih rendah, yang dapat membuat set data lebih sulit diidentifikasi ulang dan lebih aman. Namun, untuk mendapatkan nilai keragaman l yang lebih tinggi, Anda perlu menghapus persentase baris total yang lebih tinggi dan kombinasi quasi-ID unik yang lebih tinggi, yang dapat mengurangi kegunaan data. Untuk melihat nilai persentase kehilangan potensial tertentu untuk nilai l-diversity tertentu, arahkan kursor ke diagram. Seperti yang ditunjukkan pada screenshot, tooltip muncul di diagram.

Untuk melihat detail selengkapnya tentang nilai keragaman l tertentu, klik titik data yang sesuai. Penjelasan mendetail ditampilkan di bawah diagram dan tabel contoh data muncul di bagian bawah halaman.

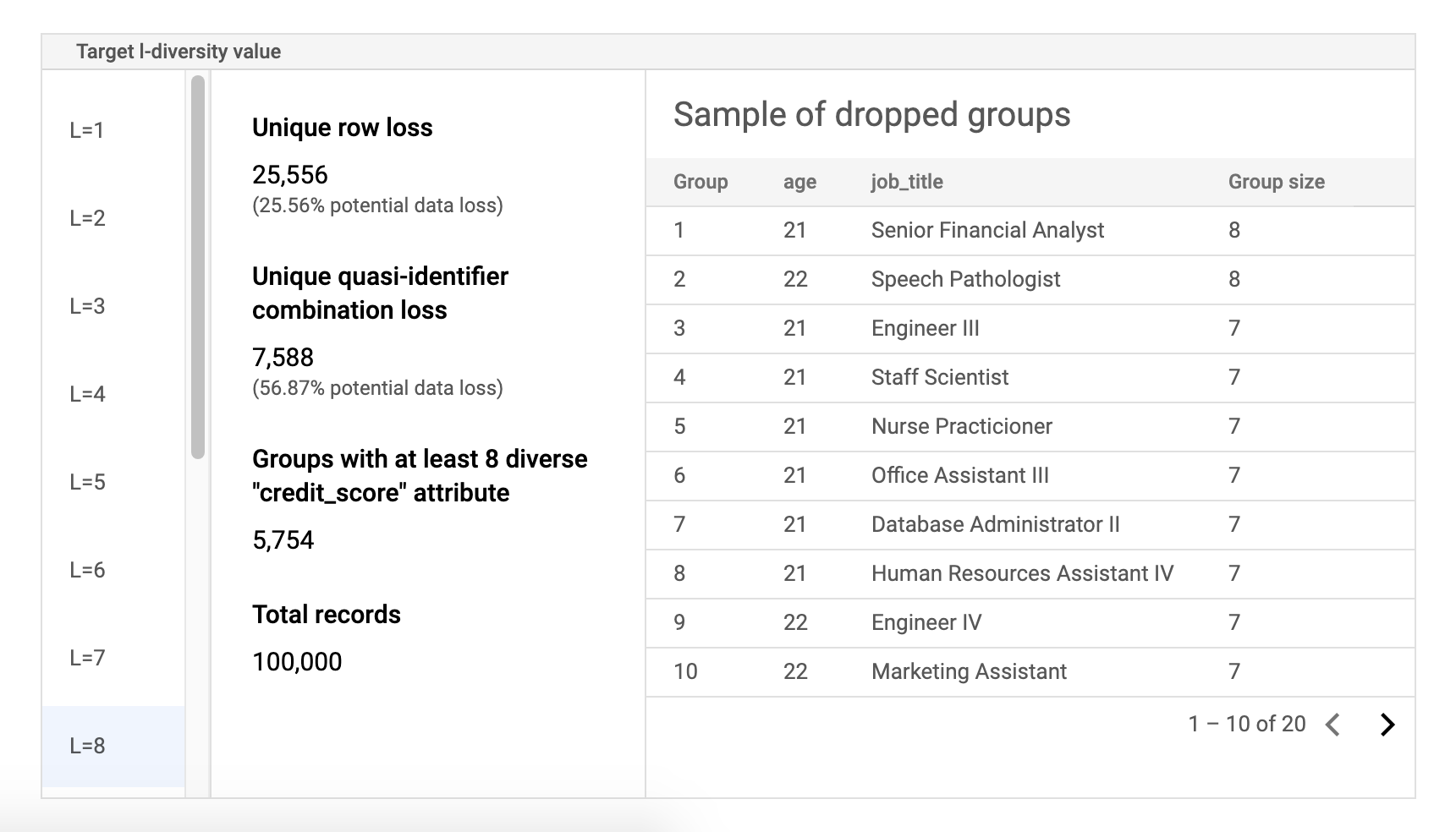

Tabel data sampel risiko

Komponen kedua pada halaman hasil tugas risiko adalah tabel data contoh. Tabel ini menampilkan kombinasi quasi-ID untuk nilai l-diversity target tertentu.

Kolom pertama tabel mencantumkan nilai k-anonimitas. Klik nilai keragaman l untuk melihat data sampel terkait yang perlu dihapus untuk mencapai nilai tersebut.

Kolom kedua menampilkan potensi kehilangan data masing-masing baris unik dan kombinasi quasi-ID untuk mencapai nilai l-diversity yang dipilih, serta jumlah grup dengan setidaknya l atribut sensitif dan jumlah total kumpulan data.

Kolom terakhir menampilkan sampel grup yang memiliki kombinasi kuasi-ID yang sama, beserta jumlah data yang ada untuk kombinasi tersebut.

Mengambil detail tugas menggunakan REST

Untuk mengambil hasil tugas analisis risiko keragaman l menggunakan REST

API, kirim permintaan GET berikut ke resource

projects.dlpJobs. Ganti PROJECT_ID dengan project ID Anda dan

JOB_ID dengan ID tugas yang ingin Anda peroleh hasilnya.

ID pekerjaan ditampilkan saat Anda memulai pekerjaan, dan juga dapat diambil dengan

mencantumkan semua pekerjaan.

GET https://dlp.googleapis.com/v2/projects/PROJECT_ID/dlpJobs/JOB_ID

Permintaan menampilkan objek JSON yang berisi instance tugas. Hasil

analisis ada di dalam kunci "riskDetails", dalam objek

AnalyzeDataSourceRiskDetails. Untuk informasi selengkapnya, lihat referensi API untuk resource

DlpJob.

Langkah berikutnya

- Pelajari cara menghitung nilai k-anonimitas untuk set data.

- Pelajari cara menghitung nilai k-map untuk set data.

- Pelajari cara menghitung nilai δ-kehadiran untuk set data.