Elige los modelos y la infraestructura para tu aplicación de IA generativa

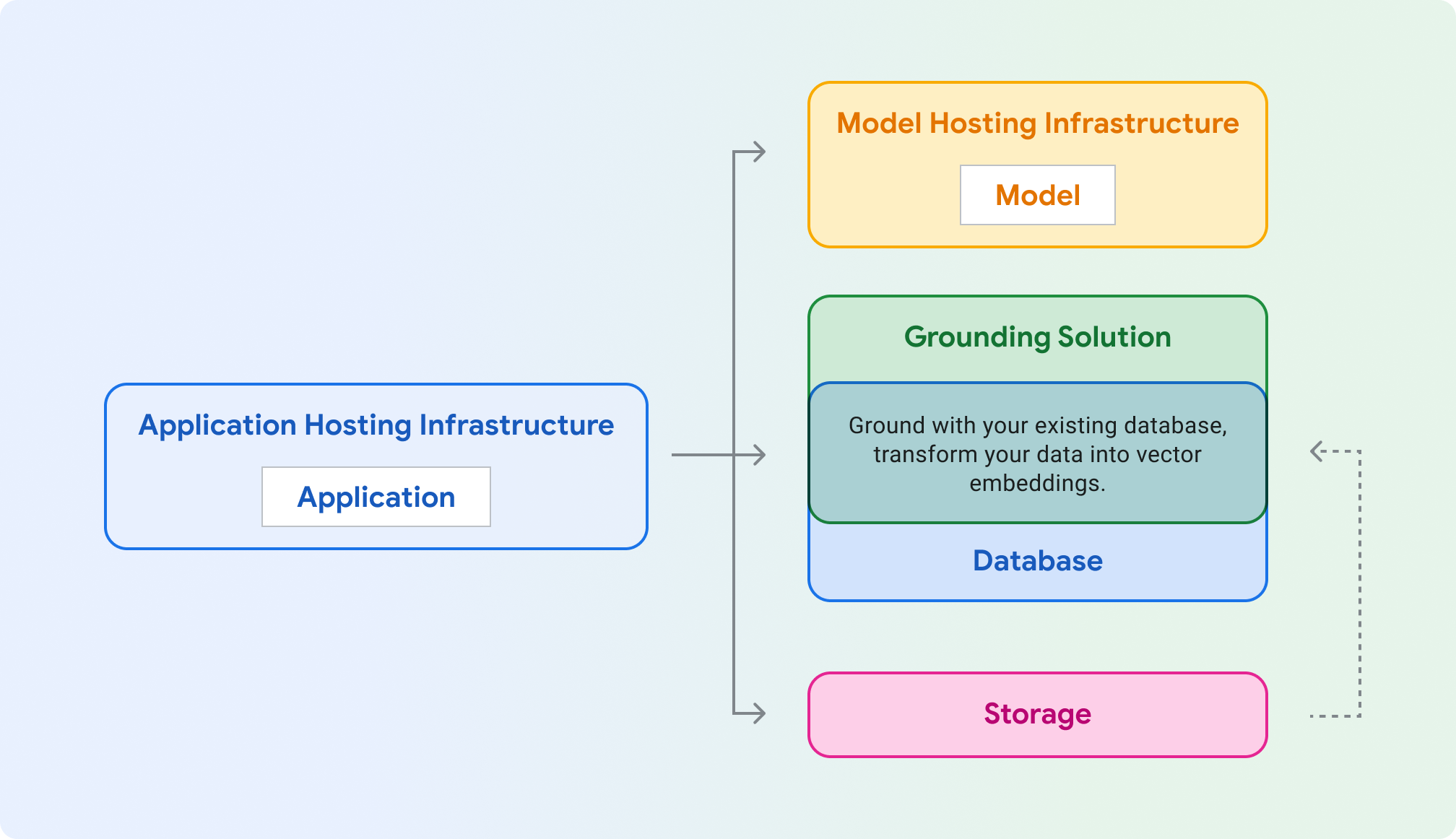

Hosting de aplicaciones: Compute para alojar tu aplicación. Tu aplicación puede usar las bibliotecas de cliente y los SDKs de Google Cloud para comunicarse con diferentes productos de Cloud.

Alojamiento de modelos: alojamiento escalable y seguro para un modelo generativo.

Modelo: modelo generativo para texto, chat, imágenes, código, incrustaciones y multimodal.

Solución de grounding: ancla la salida del modelo a fuentes de información verificables y actualizadas.

Base de datos: almacena los datos de tu aplicación. Puedes reutilizar tu base de datos como solución de fundamentación aumentando las peticiones mediante consultas SQL o almacenando tus datos como embeddings de vectores con una extensión como pgvector.

Almacenamiento: almacena archivos como imágenes, vídeos o front-ends web estáticos. También puedes usar Storage para los datos de base sin procesar (por ejemplo, PDFs) que luego conviertes en inserciones y almacenas en una base de datos de vectores.

En las secciones que se indican a continuación, se explican cada uno de esos componentes para ayudarte a elegir qué productos de Google Cloud probar.

Infraestructura de alojamiento de aplicaciones

Elige un producto para alojar y servir tu carga de trabajo de la aplicación, que hace llamadas al modelo generativo.

Infraestructura de alojamiento del modelo

Google Cloud ofrece varias formas de alojar un modelo generativo, desde la plataforma estrella Vertex AI hasta el alojamiento personalizable y portátil en Google Kubernetes Engine.

Usas Gemini y necesitas funciones empresariales como escalabilidad, seguridad, privacidad de los datos y observabilidad

¿Quieres una infraestructura totalmente gestionada con herramientas y APIs de IA generativa de primera clase?

¿Tu modelo requiere un kernel especializado, un SO antiguo o tiene términos de licencia especiales?

Modelo

Google Cloud ofrece un conjunto de modelos fundacionales de vanguardia a través de Vertex AI , incluido Gemini. También puedes desplegar un modelo de terceros en Model Garden de Vertex AI o en un alojamiento propio en GKE , Cloud Run o Compute Engine.

¿Quieres generar embeddings para búsquedas, clasificaciones o agrupaciones?

Vale, quieres generar texto. ¿Quieres incluir imágenes o vídeos en tus peticiones de texto? (multimodal)

De acuerdo, solo peticiones de texto. ¿Quieres aprovechar el modelo insignia más potente de Google?

Implementa un modelo de código abierto en: Vertex AI (Model Garden) GKE (Hugging Face)

Fundamentación y RAG

Para asegurarte de que las respuestas del modelo sean precisas y estén bien fundamentadas, basa tu aplicación de IA generativa en datos en tiempo real. Este proceso se denomina generación aumentada por recuperación (RAG).

Si quieres generar contenido basado en información actualizada de Internet, los modelos de Gemini pueden evaluar si el conocimiento del modelo es suficiente o si es necesario basarse en la Búsqueda de Google.

Puedes implementar la fundamentación usando un índice de tus datos con un buscador. Muchos buscadores almacenan ahora los embeddings en una base de datos de vectores, que es un formato óptimo para operaciones como la búsqueda de similitud. Google Cloud ofrece varias soluciones de bases de datos de vectores para diferentes casos prácticos.

Nota: Puedes fundamentar la información usando bases de datos no vectoriales consultando una base de datos como Cloud SQL o Firestore, y puedes usar el resultado de la consulta en la petición de tu modelo.

¿Quieres una solución optimizada y totalmente gestionada que admita la mayoría de las fuentes de datos y que impida el acceso directo a las inserciones subyacentes?

¿Quieres crear un motor de búsqueda para RAG usando un orquestador gestionado con una interfaz similar a LlamaIndex?

¿Necesitas una búsqueda vectorial de baja latencia, un servicio a gran escala o una base de datos de vectores especializada y optimizada?

¿Se accede a sus datos de forma programática (OLTP)? ¿Ya usas una base de datos SQL?

¿Quieres usar modelos de IA de Google directamente desde tu base de datos? ¿Necesitas una latencia baja?

¿Tiene un gran conjunto de datos analíticos (OLAP)? ¿Necesitas procesamiento por lotes y acceso frecuente a tablas SQL por parte de personas o secuencias de comandos (ciencia de datos)?

Fundamentación con APIs

Extensiones de Vertex AI (vista preliminar privada)

Componentes de LangChain

Grounding en Vertex AI

Empezar a desarrollar

Configurar LangChain

LangChain es un framework de código abierto para aplicaciones de IA generativa que te permite añadir contexto a tus peticiones y tomar medidas en función de la respuesta del modelo.

Ver códigos de ejemplo e implementar aplicaciones de ejemplo

Consulta ejemplos de código para casos prácticos habituales y ejemplos de implementación de aplicaciones de IA generativa que sean seguras, eficientes, resilientes, de alto rendimiento y rentables.