Modelle und Infrastruktur für Ihre generative KI-Anwendung auswählen

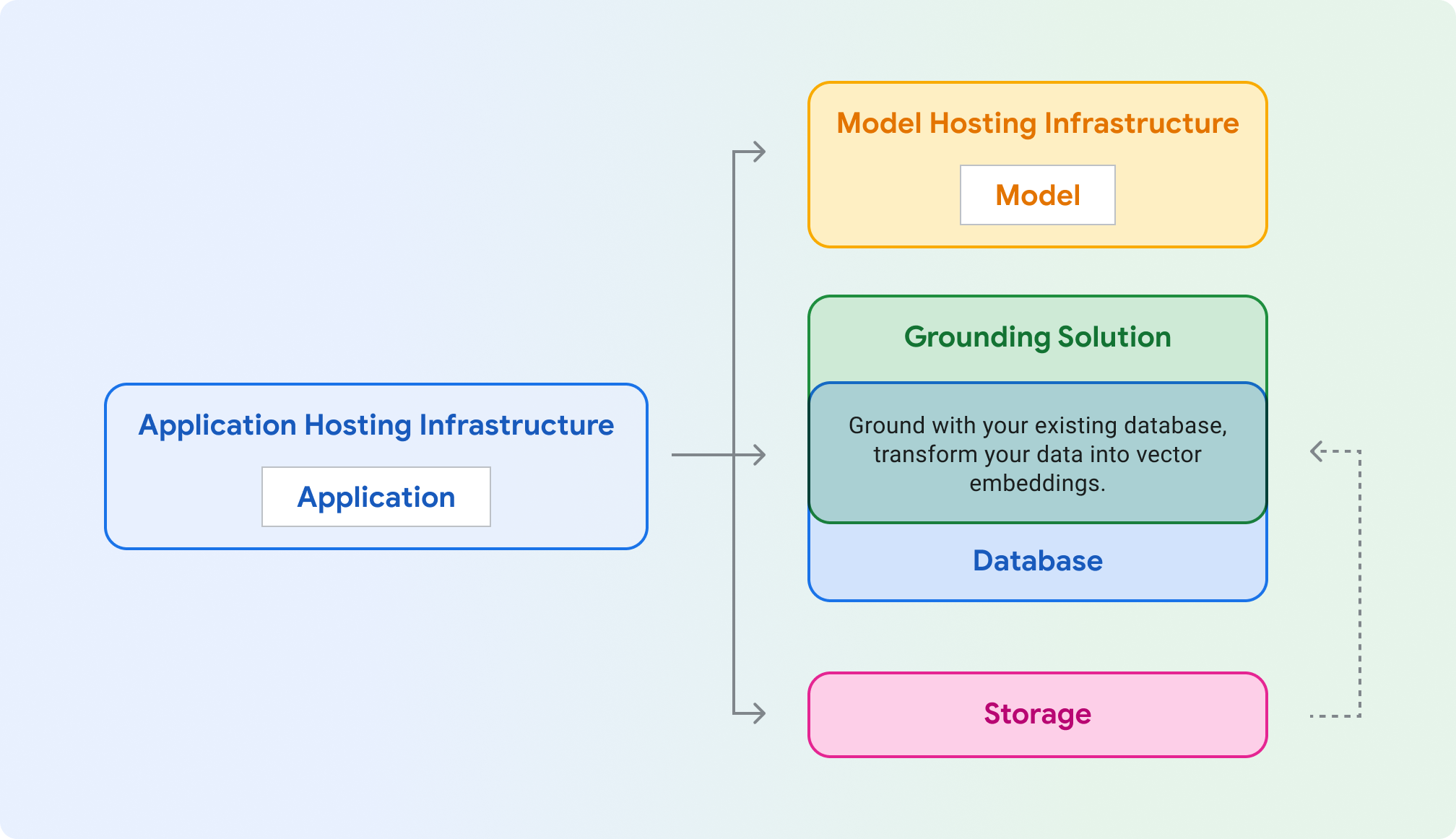

Anwendungshosting: Compute zum Hosten Ihrer Anwendung. Ihre Anwendung kann die Clientbibliotheken und SDKs von Google Cloud verwenden, um mit verschiedenen Cloud-Produkten zu kommunizieren.

Modellhosting: Skalierbares und sicheres Hosting für ein generatives Modell.

Modell: Generatives Modell für Text, Chat, Bilder, Code, Einbettungen und multimodal.

Fundierungslösung: Verankern Sie die Modellausgabe auf überprüfbare, aktualisierte Informationsquellen.

Datenbank: Speichern Sie die Daten Ihrer Anwendung. Sie können Ihre vorhandene Datenbank als Fundierungslösung wiederverwenden, indem Sie Prompts über SQL-Abfrage erweitern und/oder Ihre Daten mit einer Erweiterung wie pgvector als Vektoreinbettungen speichern.

Speicher: Speichern Sie Dateien wie Bilder, Videos oder statische Web-Front-Ends. Sie können den Speicher auch für die grundlegenden Fundierungsdaten verwenden (z. B. PDFs), die später in Einbettungen konvertiert und in einer Vektordatenbank gespeichert werden.

In den folgenden Abschnitten werden diese Komponenten beschrieben, damit Sie die richtigen Google Cloud-Produkte auswählen können.

Infrastruktur für das Anwendungshosting

Wählen Sie ein Produkt zum Hosten und Bereitstellen Ihrer Anwendungsarbeitslast aus, wodurch Aufrufe an das generative Modell gesendet werden.

Modellhostinginfrastruktur

Google Cloud bietet mehrere Möglichkeiten zum Hosten eines generativen Modells, von der Flagship-Vertex-AI-Plattform bis hin zu anpassbarem und portablem Hosting in Google Kubernetes Engine.

Sie verwenden Gemini und benötigen Unternehmensfunktionen wie Skalierung, Sicherheit, Datenschutz und Observability

Sie benötigen eine vollständig verwaltete Infrastruktur mit erstklassigen Tools und APIs für generative KI?

Benötigt Ihr Modell einen speziellen Kernel, ein älteres Betriebssystem oder gelten spezielle Lizenzierungsbedingungen?

Modell

Google Cloud bietet eine Reihe hochmoderner Foundation Models über Vertex AI, einschließlich Gemini. Sie können ein Drittanbietermodell auch in Vertex AI Model Garden oder Self-Hosting in GKE, Cloud Run oder Compute Engine bereitstellen.

Sie möchten Einbettungen für die Suche, Klassifizierung oder das Clustering generieren?

Ok, Sie möchten Text generieren. Möchten Sie Bilder oder Videos in Ihre Textvorschläge aufnehmen? (multimodal)

Ok, nur Textprompts. Möchten Sie das leistungsstärkste Flaggschiffmodell von Google nutzen?

Open-Source-Modelle können in folgenden Umgebungen bereitgestellt werden: Vertex AI (Model Garden) GKE (HuggingFace)

Grounding und RAG

Damit Sie fundierte und präzise Modellantworten erhalten, können Sie Ihre generative KI-Anwendung mit Echtzeitdaten fundieren. Dies wird als Retrieval Augmented Generation (RAG) bezeichnet.

Wenn Sie Inhalte generieren möchten, die auf aktuellen Informationen aus dem Internet basieren, können Gemini-Modelle prüfen, ob das Wissen des Modells ausreicht oder ob eine Fundierung mit der Google Suche erforderlich ist.

Sie können die Datenvernetzung mithilfe eines Index Ihrer Daten in einer Suchmaschine implementieren. Viele Suchmaschinen speichern Einbettungen jetzt in einer Vektordatenbank, die ein optimales Format für Vorgänge wie die Ähnlichkeitssuche ist. Google Cloud bietet mehrere Lösungen für Vektordatenbanken für verschiedene Anwendungsfälle.

Hinweis: Sie können auch herkömmliche Datenbanken (keine Vektordatenbanken) nutzen, indem Sie eine vorhandene Datenbank wie Cloud SQL oder Firestore abfragen und das Ergebnis in Ihrer Modell-Eingabeaufforderung verwenden.

Sie suchen eine vollständig verwaltete, optimierte Lösung, die die meisten Datenquellen unterstützt und den direkten Zugriff auf die zugrunde liegenden Einbettungen verhindert?

Möchten Sie eine Suchmaschine für RAG mit einem verwalteten Orchestrator mit einer LlamaIndex-ähnlichen Oberfläche erstellen?

Benötigen Sie eine Vektorsuche mit niedriger Latenz, eine Bereitstellung im großen Maßstab oder eine spezielle und optimierte Vektordatenbank?

Wird programmatisch auf Ihre Daten zugegriffen (OLTP)? Verwenden Sie bereits eine SQL-Datenbank?

Möchten Sie Google AI-Modelle direkt aus Ihrer Datenbank verwenden? Niedrige Latenz erforderlich?

Haben Sie einen großen Analysedatensatz (OLAP)? Erforderlich ist die Batchverarbeitung und der häufige Zugriff auf SQL-Tabellen durch Nutzer oder Scripts (Datenwissenschaft)?

Fundierung mit APIs

Vertex AI-Erweiterungen (private Vorschau)

Langchain-Komponenten

Fundierung in Vertex AI

Gleich mit dem Erstellen loslegen

Entwicklungsumgebung für Google Cloud einrichten

LangChain einrichten

LangChain ist ein Open-Source-Framework für generative KI-Anwendungen, mit dem Sie Kontext in Ihre Prompts integrieren und basierend auf der Antwort des Modells Maßnahmen ergreifen können.

Codebeispiele ansehen und Beispielanwendungen bereitstellen

Sehen Sie sich Codebeispiele für gängige Anwendungsfälle an und implementieren Sie Beispiele für generative KI-Anwendungen, die sicher, effizient, stabil, leistungsstark und kostengünstig sind.