Tiempo estimado para completarse: 4 días

Propietario del componente operable: HW

Perfil de habilidades: ingeniero de implementaciones

Completa las siguientes tareas para restablecer los dispositivos y sistemas que se ejecutan en el entorno aislado de Google Distributed Cloud (GDC).

6.1. Índice

- Descripción general del procedimiento de restablecimiento

- Restablecimiento del servidor HPE

- Restablecimiento de NetApp StorageGRID

- Restablecimiento de NetApp ONTAP

- Restablecimiento de HSM de Thales

- Restablecimiento de cortafuegos de Palo Alto

- Restablecer interruptores de Cisco

- Additional Resources

6.2. Requisitos previos y seguridad

6.2.1. Acceso necesario

- Acceso físico: acceso a la sala de datos con equipo de carro de emergencia

- Acceso a la red: conectividad de la interfaz de gestión o acceso a la consola

- Credenciales: acceso de administrador a todos los sistemas

- Copias de seguridad: copia de seguridad completa de todos los secretos y datos de configuración.

6.2.2. Lista de comprobación de seguridad

- [ ] Acceso físico a la infraestructura

- [ ] Los secretos de acceso de emergencia se han protegido sin conexión

- [ ] Copia de seguridad de la infraestructura (si es necesario)

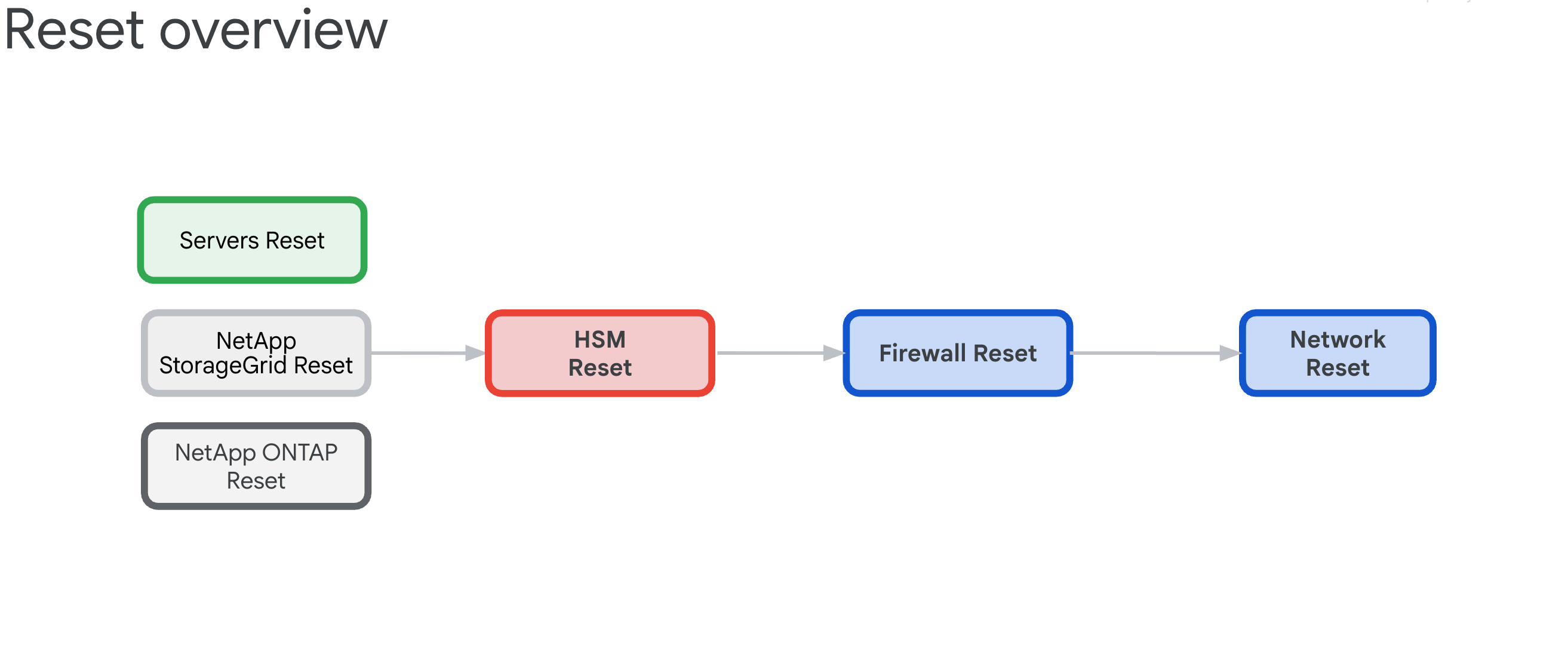

6.3. Descripción general del procedimiento de restablecimiento

El procedimiento de restablecimiento de una zona de celdas de GDC tiene como objetivo liberar todos los dispositivos de hardware de cualquier dependencia y, a continuación, restaurar su estado de fábrica.

6.3.1. Dependencias de la infraestructura

Los componentes tienen las siguientes interdependencias que determinan el orden de restablecimiento:

- Servidores, NetApp ONTAP y NetApp StorageGrid se basan en los dispositivos HSM de Thales, ya que proporcionan las claves de cifrado para ILOs, discos, inquilinos y contenedores.

- Los dispositivos HSM de Thales dependen de la conectividad de los cortafuegos de perímetro y de los IDP, así como de los switches de Cisco.

- Los cortafuegos de perímetro o IDP se basan en la infraestructura de redes de los switches de Cisco.

- Los switches de Cisco deben restablecerse como último recurso, ya que la conectividad se interrumpirá después de restablecerlos.

6.3.2. Reset Order (Critical)

Sigue este orden exacto para evitar bloqueos del sistema:

- Servidores HPE: primero elimina las dependencias de HSM

- NetApp StorageGRID: borrar el cifrado y restablecer los nodos

- NetApp ONTAP: inhabilita el HSM y restablece el clúster

- HSM de Thales: restablecer el estado de fábrica y borrar la raíz de confianza

- Firewalls: restablecer la configuración predeterminada de fábrica

- Switches de Cisco: restablecer último (interrumpirá la conectividad)

6.4. Borrado seguro de Hewlett Packard Enterprise

Hay tres tipos de operaciones de restablecimiento disponibles, cada una de las cuales sirve como método alternativo para limpiar la configuración de iLO Key Manager. El objetivo principal es eliminar la dependencia del módulo de seguridad de hardware (HSM).

Por lo general, el restablecimiento de fábrica de ILO es suficiente para limpiar la configuración de KMS. Después, en el siguiente arranque, el proceso de arranque del servidor inicializará los parámetros de la BIOS del servidor, borrará los discos y volverá a inicializar el servidor.

En esta sección se explica cómo realizar tres tipos de borrado:

Estas secuencias de comandos de borrado usan un archivo CSV de ejemplo llamado example.csv.

Antes de continuar, prepara el siguiente archivo CSV:

root@example-bootstrapper:/home/ubuntu/md# cat example.csv

ip,passd

10.251.248.62,XXXXXXXX

10.251.248.64,XXXXXXXX

10.251.248.66,XXXXXXXX

10.251.248.68,XXXXXXXX

10.251.248.70,XXXXXXXX

10.251.248.72,XXXXXXXX

10.251.248.74,XXXXXXXX

10.251.248.76,XXXXXXXX

6.4.1. Restablecer el estado de fábrica de iLO

Completa un restablecimiento de fábrica normal de iLO:

Crea un archivo llamado

serversreset.pyy añade la siguiente secuencia de comandos de Python:import csv import argparse import requests import urllib3 import json urllib3.disable_warnings() PARSER = argparse.ArgumentParser(prog='serversreset.py', \ description='reset ilo to factory settings') PARSER.add_argument('-csv', '--file', help='choose the csv file', type=str) ARGS = vars(PARSER.parse_args()) headers = {'content-type': 'application/json'} payload = {'ResetType': 'Default'} url = '/redfish/v1/Managers/1/Actions/Oem/Hpe/HpeiLO.ResetToFactoryDefaults/' with open(ARGS['file'], encoding="utf8", mode='r') as csv_file: CSV_READER = csv.DictReader(csv_file) for row in CSV_READER: try: system = requests.post('https://'+row['ip']+url,data=json.dumps(payload),headers=headers,verify=False,auth=('administrator',row['passd'])) systemData = system.json() print(systemData) except Exception as err: print(err)Ejecuta el siguiente comando y sustituye

example.csvpor tu archivo CSV:python3 serversreset.py -csv example.csvLa salida debe ser similar a la siguiente:

{'error': {'code': 'iLO.0.10.ExtendedInfo', 'message': 'See @Message.ExtendedInfo for more information.', '@Message.ExtendedInfo': [{'MessageId': 'iLO.2.15.ResetInProgress'}]}} {'error': {'code': 'iLO.0.10.ExtendedInfo', 'message': 'See @Message.ExtendedInfo for more information.', '@Message.ExtendedInfo': [{'MessageId': 'iLO.2.15.ResetInProgress'}]}} {'error': {'code': 'iLO.0.10.ExtendedInfo', 'message': 'See @Message.ExtendedInfo for more information.', '@Message.ExtendedInfo': [{'MessageId': 'iLO.2.15.ResetInProgress'}]}}

6.4.2. Pasos manuales adicionales de iLO

Realiza un reinicio manual de iLO mediante la interfaz de usuario de iLO:

Seleccione iLO > Administración > Gestor de claves > Eliminar ajustes.

En la consola de la BIOS, selecciona Utilidades del sistema > Configuración del sistema > RAID integrado > Administración > Restablecer valores predeterminados.

Define las interfaces para que solo se puedan iniciar desde la red en LOM1. Todos los nodos de GPU NO tienen tarjetas LOM1, sino tarjetas Intel.

Configura la red iLO en DHCP.

6.4.3. Restablecimiento de la BIOS

Sigue estos pasos para restablecer el BIOS:

Crea un archivo llamado

biosreset.pyy añade la siguiente secuencia de comandos de Python:import csv import argparse import requests import urllib3 import json urllib3.disable_warnings() PARSER = argparse.ArgumentParser(prog='biosreset.py', \ description='reset BIOS to factory settings') PARSER.add_argument('-csv', '--file', help='choose the csv file', type=str) ARGS = vars(PARSER.parse_args()) headers = {'content-type': 'application/json'} payload = {} with open(ARGS['file'], encoding="utf8", mode='r') as csv_file: CSV_READER = csv.DictReader(csv_file) for row in CSV_READER: try: system = requests.post('https://'+row['ip']+'/redfish/v1/systems/1/bios/Actions/Bios.ResetBios/',data=json.dumps(payload),headers=headers,verify=False,auth=('administrator',row['passd'])) systemData = system.json() print(systemData) except Exception as err: print(err)Ejecuta el siguiente comando y sustituye

example.csvpor tu archivo CSV:python3 biosreset.py -csv example.csvLa salida debe ser similar a la siguiente:

{'error': {'code': 'iLO.0.10.ExtendedInfo', 'message': 'See @Message.ExtendedInfo for more information.', '@Message.ExtendedInfo': [{'MessageId': 'iLO.2.15.SystemResetRequired'}]}}Después de ejecutar el comando, los servidores estarán encendidos. Debes ejecutar la siguiente secuencia de comandos para apagar todos los servidores:

import csv import argparse import requests import urllib3 import json urllib3.disable_warnings() PARSER = argparse.ArgumentParser(prog='power-ilo.py', \ description='power off server') PARSER.add_argument('-csv', '--file', help='choose the csv file', type=str) ARGS = vars(PARSER.parse_args()) headers = {'content-type': 'application/json'} payload = {'ResetType': 'PushPowerButton'} with open(ARGS['file'], encoding="utf8", mode='r') as csv_file: CSV_READER = csv.DictReader(csv_file) for row in CSV_READER: try: system = requests.post( 'https://' + row['ip'] + '/redfish/v1/systems/1/Actions/ComputerSystem.Reset/', data=json.dumps(payload), headers=headers, verify=False, auth=('administrator', row['passd'])) systemData = system.json() if 'Success' in systemData['error']['@Message.ExtendedInfo'][0][ 'MessageId']: print(f"ilo with ip {row['ip']} succeeded") #print(systemData) else: print(f"ilo with ip {row['ip']} failed") print(systemData) except Exception as err: print(err)Apaga manualmente los servidores:

python3 power-ilo.py -csv ~/servers.csv- (Opcional) Para comprobar el estado, usa la siguiente secuencia de comandos:

import csv import argparse import requests import urllib3 import json urllib3.disable_warnings() PARSER = argparse.ArgumentParser(prog='ilostatus.py', \ description='check power status of server') PARSER.add_argument('-csv', '--file', help='choose the csv file', type=str) ARGS = vars(PARSER.parse_args()) headers = {'content-type': 'application/json'} with open(ARGS['file'], encoding="utf8", mode='r') as csv_file: CSV_READER = csv.DictReader(csv_file) for row in CSV_READER: try: system = requests.get('https://'+row['ip']+'/redfish/v1/Systems/1',headers=headers,verify=False,auth=('administrator',row['passd'])) systemData = system.json() print(f"ilo with ip {row['ip']} has power status of {systemData['PowerState']}") if 'Success' in systemData['error']['@Message.ExtendedInfo'][0]['MessageId']: print(f"ilo with ip {row['ip']} succeeded") print(systemData) else: print(f"ilo with ip {row['ip']} failed") print(systemData) except Exception as err: passEjecuta el siguiente comando:

python3 ilostatus.py -csv ~/servers.csvLa salida debe ser similar a la siguiente:

ilo with ip 172.22.112.96 has power status of Off ilo with ip 172.22.112.97 has power status of Off ilo with ip 172.22.112.98 has power status of Off ilo with ip 172.22.112.100 has power status of Off ilo with ip 172.22.112.101 has power status of Off ilo with ip 172.22.112.102 has power status of Off6.4.4. Borrado seguro

Pulsa F10 en la pantalla POST del servidor. Se iniciará Intelligent Provisioning.

Después de iniciar Intelligent Provisioning, haz clic en la flecha hacia abajo que aparece después de First Time Setup Wizard (Asistente de configuración inicial) para saltarte el asistente.

En la ventana del asistente, haz clic en Sí.

Haz clic en Realizar mantenimiento.

Haz clic en Borrado seguro con un botón.

Aparece un mensaje que indica que no tienes suficientes privilegios. Haz clic en Iniciar sesión e introduce las credenciales de administrador.

Haz clic en Listo.

Haz clic en Enviar.

Confirma que quieres realizar el borrado seguro y escribe ERASE.

Haz clic en ERASE.

Haz clic en Yes (Sí) para confirmar la acción.

En la sección Cola de trabajos, haz clic en Iniciar ahora.

En un plazo de 2 minutos, sigue las instrucciones para hacer clic en Aceptar.

El equipo se reiniciará. No toques nada durante unos 10-15 minutos.

Una vez que se haya completado el borrado seguro, vuelve a la BIOS haciendo clic en F9 durante el POST Boot.

Vaya a Aplicaciones integradas > Registro de gestión integrada (IML) > Ver IML > Aceptar. Aparecerá el mensaje Borrado seguro con un botón completado:

Crea un archivo llamado

serversreset.pyy añade la siguiente secuencia de comandos de Python:import csv import argparse import requests import urllib3 import json urllib3.disable_warnings() PARSER = argparse.ArgumentParser(prog='secureerase.py', \ description='reset ilo to factory settings') PARSER.add_argument('-csv', '--file', help='choose the csv file', type=str) ARGS = vars(PARSER.parse_args()) headers = {'content-type': 'application/json'} payload = {'SystemROMAndiLOErase': True , 'UserDataErase': True} with open(ARGS['file'], encoding="utf8", mode='r') as csv_file: CSV_READER = csv.DictReader(csv_file) for row in CSV_READER: try: system = requests.post('https://'+row['ip']+'/redfish/v1/Systems/1/Actions/Oem/Hpe/HpeComputerSystemExt.SecureSystemErase/',data=json.dumps(payload),headers=headers,verify=False,auth=('administrator',row['passd'])) systemData = system.json() print(systemData) except Exception as err: print(err)Ejecuta el siguiente comando y sustituye

example.csvpor tu archivo CSV:python serversreset.py -csv example.csvDespués de ejecutar el comando, los servidores estarán apagados. Debes encender el servidor manualmente.

6.5. Restablecer un dispositivo NetApp StorageGRID

6.5.1. Requisitos previos

Antes de restablecer tu dispositivo NetApp StorageGRID, asegúrate de leer lo siguiente: - Si el sistema tiene habilitado el cifrado de nodos o el cifrado de unidades, debes seguir los pasos que se indican en Inhabilitar el cifrado de sitios HSM. De lo contrario, continúa para restablecer el sistema StorageGRID.

6.5.2. Inhabilitar el cifrado del sitio de HSM de StorageGRID en los nodos de Storage Controller

Para obtener las IPs de los nodos del controlador de almacenamiento (dos IPs por cada nodo de almacenamiento), haz lo siguiente:

$ kubectl get objectstoragestoragenodes -n gpc-system -o custom-columns="NAME:metadata.name,COMPUTE_NODEA_IP:.spec.network.controllerAManagementIP,COMPUTE_NODEB_IP:.spec.network.controllerBManagementIP"

NAME COMPUTE_NODEA_IP COMPUTE_NODEB_IP

ak-ac-objs01 172.22.210.166/24 172.22.210.167/24

ak-ac-objs02 172.22.210.170/24 172.22.210.171/24

ak-ac-objs03 172.22.210.174/24 172.22.210.175/24

Si el sistema StorageGRID se habilitó previamente con HSM, es necesario eliminar el cifrado antes de restablecer los ajustes de fábrica. Sigue estos pasos con cada nodo de almacenamiento antes de restablecer el dispositivo. De lo contrario, es posible que se bloqueen los discos y el sistema.

Inicia sesión en el sitio de Object Storage y ve a la lista de nodos de la barra lateral.

Haz clic en el nombre del nodo de almacenamiento.

Vaya a la pestaña SANtricity System Manager.

Ve a Ajustes > Sistema > Gestión de llaves de seguridad.

Selecciona Inhabilitar gestión de claves externa e introduce la contraseña para descargar la clave de copia de seguridad.

6.5.3. Restablecer el estado de fábrica de un nodo de administración y un nodo de computación de StorageGRID

Para obtener las IPs de los nodos de administrador, sigue estos pasos:

$ kubectl get objectstorageadminnodes -n gpc-system

NAME SITE NAME MANAGEMENT IP READY AGE

ak-ac-objsadm01 ak-obj-site-1 172.22.210.160/24 True 12d

ak-ac-objsadm02 ak-obj-site-1 172.22.210.162/24 True 12d

Para obtener las IPs de los nodos de computación de almacenamiento, sigue estos pasos:

$ kubectl get objectstoragestoragenodes -n gpc-system

NAME SITE NAME MANAGEMENT IP READY AGE

ak-ac-objs01 ak-obj-site-1 172.22.210.164/24 True 12d

ak-ac-objs02 ak-obj-site-1 172.22.210.168/24 True 12d

ak-ac-objs03 ak-obj-site-1 172.22.210.172/24 True 12d

Para restablecer el estado de fábrica del dispositivo StorageGRID, debes completar los siguientes pasos en cada nodo (tanto de almacenamiento como de administración) del sitio:

Obtén las IPs de gestión de cada nodo. Puedes obtenerlo del archivo cell.yaml buscando

ObjectStorageStorageNodeyObjectStorageAdminNode. También se pueden encontrar en los recursos de nodo del clúster de administración raíz.Obtén la contraseña y conéctate al nodo mediante SSH:

Si el nodo no tiene instalado StorageGRID, utiliza

admin/bycastoroot/netapp1!como nombre de usuario y contraseña, respectivamente. Usa el puerto SSH 8022 si SSH no funciona.Si el nodo tiene instalado StorageGRID, pero no se ha configurado ningún sitio, usa

admin/bycastoroot/bycastcomo nombre de usuario y contraseña, respectivamente.Si el sitio está configurado y el nodo forma parte de él:

Obtener la frase de contraseña de aprovisionamiento. Se almacena en un secreto llamado

grid-secret, que se encuentra en el archivo cell.yaml. También puedes ejecutar el siguiente comando. Asegúrate de decodificar en base64 la contraseña:echo $(kubectl get secret -n gpc-system grid-secret -ojsonpath="{.data.grid-management-provisioning-password}" | base64 -d)En la interfaz de usuario del sitio de Object Storage, ve a Mantenimiento > Sistema > Paquete de recuperación para descargar el paquete de recuperación después de introducir la contraseña de aprovisionamiento.

Después de descargar el archivo tar, extráelo. Contendrá otro archivo tar:

GIDXXXXX_REV1_SAID.zip. Extrae ese archivo tar.gz para encontrar el archivoPasswords.txt. UsaPasswordtanto para el acceso SSH como para el acceso de administrador, e ignoraSSH Access Password.Archivo de ejemplo:

Password Data for Grid ID: 546285, Revision: 1 Revision Prepared on: 2022-06-13 20:49:56 +0000 Server "root" and "admin" Account Passwords Server Name Password SSH Access Password ____________________________________________________________ alatl14-gpcstgeadm01 <removed> <removed> alatl14-gpcstgeadm02 <removed> <removed> alatl14-gpcstgecn01 <removed> n/a alatl14-gpcstgecn02 <removed> n/a alatl14-gpcstgecn03 <removed> n/a

Abre una consola en serie en el nodo o conéctate a él mediante SSH:

ssh -o ProxyCommand=None -o StrictHostKeyChecking=no \ -o UserKnownHostsFile=/dev/null admin@<node-management-ip>Introduce las credenciales para iniciar sesión. Para obtener privilegios de superusuario, escribe

su -, e introduce la contraseña de administrador obtenida en el segundo paso.Introduce el comando

sgareinstally pulsaypara seguir restableciendo el dispositivo.Si el cifrado estaba habilitado en el dispositivo, una vez que se haya completado el restablecimiento, sigue estos pasos para eliminar los grupos de discos y la caché SSD.

6.5.4. Eliminar grupos de discos y caché SSD en nodos de controlador de almacenamiento

Para obtener las IPs de los nodos del controlador de almacenamiento (dos IPs por cada nodo de almacenamiento), haz lo siguiente:

$ kubectl get objectstoragestoragenodes -n gpc-system -o custom-columns="NAME:metadata.name,COMPUTE_NODEA_IP:.spec.network.controllerAManagementIP,COMPUTE_NODEB_IP:.spec.network.controllerBManagementIP"

NAME COMPUTE_NODEA_IP COMPUTE_NODEB_IP

ak-ac-objs01 172.22.210.166/24 172.22.210.167/24

ak-ac-objs02 172.22.210.170/24 172.22.210.171/24

ak-ac-objs03 172.22.210.174/24 172.22.210.175/24

Si el cifrado estaba habilitado en el dispositivo y los nodos se han restablecido después de seguir la última sección, los grupos de discos deben eliminarse junto con las unidades. Esto debe hacerse antes de reiniciar el sitio para que pueda crear nuevos grupos de discos. Sigue estos pasos para cada nodo de almacenamiento (controlador de almacenamiento e2860) del sitio (también conocido como controllerAManagementIP):

Abre un navegador web para visitar

https://<storage-node-controller-ip>:8443e introduce las credenciales. Si no tienes acceso a las credenciales de SANtricity, sigue estos pasos.Vaya a Almacenamiento > Grupos de volúmenes y de almacenamiento.

Eliminar caché de SSD:

Selecciona la caché SSD para resaltarla.

Selecciona el menú desplegable Tareas poco comunes y haz clic en Eliminar.

Elimina el grupo de discos:

Selecciona el grupo de discos para resaltarlo.

Selecciona el menú desplegable Tareas poco comunes y haz clic en Eliminar.

Prueba a crear un nuevo grupo de discos. Aparece un cuadro de diálogo que impide la creación y pide que se borren las unidades.

Como las unidades seguras habilitadas sin asignar no se pueden usar para crear un pool, primero debes eliminarlas. Haz clic en el botón de radio Sí, quiero seleccionar las unidades que quiero borrar para la operación y, a continuación, selecciona todas las unidades que quieras borrar. Confirma la operación de borrado y haz clic en Aceptar. No crees un nuevo grupo.

Sigue los pasos que se indican en la sección para eliminar el cifrado de nodos.

6.5.5. Eliminar el cifrado de nodos en nodos de administración y nodos de computación de almacenamiento de StorageGRID

Para obtener las IPs de los nodos de administrador, sigue estos pasos:

$ kubectl get objectstorageadminnodes -n gpc-system

NAME SITE NAME MANAGEMENT IP READY AGE

ak-ac-objsadm01 ak-obj-site-1 172.22.210.160/24 True 12d

ak-ac-objsadm02 ak-obj-site-1 172.22.210.162/24 True 12d

Para obtener las IPs de los nodos de computación de almacenamiento, sigue estos pasos:

$ kr get objectstoragestoragenodes -n gpc-system

NAME SITE NAME MANAGEMENT IP READY AGE

ak-ac-objs01 ak-obj-site-1 172.22.210.164/24 True 12d

ak-ac-objs02 ak-obj-site-1 172.22.210.168/24 True 12d

ak-ac-objs03 ak-obj-site-1 172.22.210.172/24 True 12d

Si el cifrado estaba habilitado en el dispositivo y los nodos se han restablecido después de seguir estos pasos y los grupos de discos y la caché SSD se han eliminado con estos pasos, sigue estos pasos en cada nodo para quitar el cifrado del nodo:

Vaya a la interfaz de usuario del instalador del dispositivo StorageGRID.

Ve a Configurar hardware > Cifrado de nodos.

Haz clic en Borrar clave de KMS y eliminar datos.

Una vez que se haya activado el borrado, el mando se reiniciará, lo que puede tardar unos 15 minutos.

6.5.6. Reinstalar StorageGRID

Reinicia cada nodo manualmente.

Abre una consola serie en el nodo, accede al menú del gestor de arranque GRUB y selecciona StorageGRID Appliance: Force StorageGRID reinstall (Dispositivo StorageGRID: forzar reinstalación de StorageGRID).

6.5.7. Obtener credenciales de SANtricity

Abre una consola serie en cualquiera de los controladores de SANtricity.

Usa las siguientes credenciales para iniciar sesión:

- Nombre de usuario:

spri - Contraseña:

SPRIentry

- Nombre de usuario:

Una vez que hayas iniciado sesión, verás un menú como este:

Service Interface Main Menu ============================== 1)Display IP Configuration 2)Change IP Configuration 3)Reset Storage Array Administrator Password 4)Display 7-segment LED codes 5)Disable SAML 6)Unlock remote admin account Q)Quit Menu Enter Selection: 3 Are you sure that you want to reset the Storage Array Password ? (Y/N): Y Storage Array Password reset successfulInicia sesión en los controladores de SANtricity y estará disponible la opción para restablecer la contraseña.

6.6. Restablecer un dispositivo NetApp ONTAP

6.6.1. Requisitos previos

Antes de restablecer tu dispositivo NetApp ONTAP, asegúrate de leer lo siguiente:

Si el sistema se había habilitado previamente con un módulo de seguridad de hardware (HSM), debes seguir los pasos que se indican en la sección Inhabilitar el módulo de seguridad de hardware antes de restablecer los sistemas ONTAP.

Se trata de una operación destructiva que borra todos los datos de CipherTrust Manager, incluidos, entre otros, las claves, las copias de seguridad, las claves de copia de seguridad y los registros del sistema.

Asegúrate de que tienes una copia de seguridad válida de CipherTrust Manager de todos los datos y las claves de copia de seguridad.

Si hay un HSM insertado disponible, no se restablecerá como parte de esta operación.

Opcional: Se recomienda volver a inicializar un HSM insertado después de esta operación para configurarlo como raíz de confianza.

Si se ha usado un dispositivo de introducción de PIN (PED) remoto, debe volver a conectarse una vez completada la operación.

Esta operación puede tardar hasta 15 minutos. Asegúrate de tener una batería de reserva.

6.6.2. Inhabilitar el módulo de seguridad de hardware

Si el sistema se habilitó anteriormente mediante un HSM, sigue estos pasos antes de restablecer los sistemas ONTAP. De lo contrario, es posible que se bloqueen los discos y el sistema. Ejecuta los siguientes comandos en el clúster de ONTAP:

Define el nivel de privilegio como avanzado:

set -privilege advancedLista la clave de datos del disco y las claves de autenticación de los estándares federales de procesamiento de información (FIPS) que utiliza:

storage encryption disk showEn cada disco del sistema, asigna al nodo el ID de clave de autenticación de datos y FIPS predeterminado 0x0:

storage encryption disk modify -disk * -fips-key-id 0x0 storage encryption disk modify -disk * -data-key-id 0x0Para confirmar que la operación se ha realizado correctamente, haz lo siguiente:

storage encryption disk show-statusRepite el comando

show-statushasta que recibasDisks Begun == Disks Done. Esto significa que la operación se ha completado.cluster1:: storage encryption disk show-status FIPS Latest Start Execution Disks Disks Disks Node Support Request Timestamp Time (sec) Begun Done Successful ------- ------- -------- ------------------ ---------- ------ ------ ---------- cluster1 true modify 1/18/2022 15:29:38 3 14 5 5 1 entry was displayed.Elimina la configuración del gestor de claves externo:

Si la conexión HSM está activa, ve directamente al paso f. Si la conexión HSM no funciona, ve al paso b.

cluster1::> security key-manager external show-statusVe al modo

diagejecutandoset -priv diag.Ejecuta el siguiente comando para mostrar todas las claves de cifrado de volumen.

debug smdb table kmip_external_key_cache_mdb_v2 show.Recopila la propiedad

vserver-id.Ejecuta el siguiente comando en todos los servidores de claves para eliminar las claves:

debug smdb table kmip_external_key_cache_mdb_v2 delete -vserver-id <vserver-id> -key-id * -key-server <key-server endpoint>.Elimina todos los volúmenes mediante la interfaz de usuario (UI) de ONTAP o elimina los volúmenes manualmente desde la consola.

Si eliminas los volúmenes desde la consola, debes ignorar los volúmenes raíz de los nodos. Suelen tener el nombre

vol0y uno de los nodos es elvserver. Por lo general, no se permite eliminar ningún volumen que tenga un nodo comovserver, por lo que no se debe eliminar.Si no se pueden eliminar otros volúmenes que no sean

vol0desde la interfaz de usuario, prueba a usar la CLI:cluster1::> vol offline -volume volume_to_be_deleted -vserver vserve-id cluster1::> vol delete -volume volume_to_be_deleted -vserver vserver-idPara iniciar sesión en un clúster de almacenamiento desde la interfaz de usuario, obtén el nombre de usuario y la contraseña del secreto con los siguientes comandos. Sustituye CELL_ID por el ID único de la celda en la que estés realizando la instalación:

kubectl get secret -n gpc-system ontap-CELL_ID-stge-clus-01-credential -o jsonpath='{.data.netapp_username}' | base64 --decode kubectl get secret -n gpc-system ontap-CELL_ID-stge-clus-01-credential -o jsonpath='{.data.netapp_password}' | base64 --decodeA continuación, ve a Volúmenes, selecciona todos los volúmenes y haz clic en Eliminar. Debe repetir este proceso varias veces en cada página. Nota: Puedes ignorar sin problemas un error que indique que no se ha podido eliminar un volumen. Consulta la base de conocimientos de NetApp para obtener más información.

ag-stge-clus-01::*> vol show Vserver Volume Aggregate State Type Size Available Used% --------- ------------ ------------ ---------- ---- ---------- ---------- ----- ag-ad-stge01-01 vol0 aggr0_ag_ad_stge01_01 online RW 151.3GB 84.97GB 40% ag-ad-stge01-02 vol0 aggr0_ag_ad_stge01_02 online RW 151.3GB 86.69GB 39% ag-ad-stge02-01 vol0 aggr0_ag_ad_stge02_01 online RW 151.3GB 83.62GB 41% ag-ad-stge02-02 vol0 aggr0_ag_ad_stge02_02 online RW 151.3GB 85.97GB 40% ag-ad-stge03-01 vol0 aggr0_ag_ad_stge03_01 online RW 151.3GB 89.19GB 37% ag-ad-stge03-02 vol0 aggr0_ag_ad_stge03_02 online RW 151.3GB 88.74GB 38%

Después de eliminar todos los volúmenes, ejecuta el siguiente comando para purgar la cola de recuperación:

recovery-queue purge-all -vserver <vserver>.Ejecuta el siguiente comando para eliminar el gestor de claves externo:

clusterl::> security key-manager external remove-servers -vserver <CLUSTER_NAME> -key-servers <IP1:PORT,IP2:PORT,...>. Después de este paso, puede que aparezca el siguiente error:Error: command failed: The key server at "172.22.112.192" contains authentication keys that are currently in use and not available from any other configured key server.Este error indica que quedan claves. Para eliminar las claves restantes, sigue estos pasos:

Para enumerar las claves restantes, ejecuta el siguiente comando:

security key-manager key queryLa salida es similar al siguiente ejemplo:

Node: ag-ad-stge01-01 Vserver: ag-stge-clus-01 Key Manager: 172.22.112.192:5696 Key Manager Type: KMIP Key Manager Policy: - Key Tag Key Type Encryption Restored ------------------------------------ -------- ------------ -------- ag-ad-stge01-01 NSE-AK AES-256 true Key ID: 00000000000000000200000000000100454007f1854b3e3f5c90756bc5cfa6cc0000000000000000Anota el valor de ID de clave del resultado anterior. Usa el comando

security key-manager key delete -key-id+ el valor ID de clave para eliminar las claves restantes:security key-manager key delete -key-id 00000000000000000200000000000100454007f1854b3e3f5c90756bc5cfa6cc0000000000000000Repite los pasos i y j para eliminar las claves restantes. Cuando hayas terminado, el resultado será similar al siguiente ejemplo:

ag-stge-clus-01::*> security key-manager key query No matching keys found.6.6.3. Restablecer nodos de ONTAP

Para restablecer los nodos de ONTAP, sigue estos pasos:

Reinicia el nodo para acceder al menú de arranque con el comando

system node rebooten la petición del sistema. Nota: Puedes ignorar las advertencias de reinicio del sistema.Ejemplos:

ag-stge-clus-01::> system reboot -node ag-ad-stge03-02 Warning: Are you sure you want to reboot node "ag-ad-stge03-02"? {y|n}: y Error: Could not migrate LIFs away from node: Failed to migrate one or more LIFs away from node "ag-ad-stge03-02". Use the "network interface show -curr-node ag-ad-stge03-02" command to identify LIFs that could not be migrated off that node. Use the "network interface migrate" command to manually migrate the LIFs off the node. Reissue the command with "-skip-lif-migration-before-reboot" to skip the migration and continue with takeover. ag-stge-clus-01::> system reboot -node ag-ad-stge03-02 -skip-lif-migration-before-reboot Warning: Are you sure you want to reboot node "ag-ad-stge03-02"? {y|n}: y Connection to 172.22.115.134 closed.ag-stge-clus-01::> system reboot -node ag-ad-stge02-02 Error: command failed: Taking node "ag-ad-stge02-02" out of service might result in a data service failure and client disruption for the entire cluster. If possible, bring an additional node online to improve the resiliency of the cluster and to ensure continuity of service. Verify the health of the node using the "cluster show" command, then try the command again, or provide "-ignore-quorum-warnings" to bypass this check. ag-stge-clus-01::> system reboot -node ag-ad-stge02-02 -ignore-quorum-warnings Warning: Are you sure you want to reboot node "ag-ad-stge02-02"? {y|n}: y Error: Could not migrate LIFs away from node: Failed to migrate one or more LIFs away from node "ag-ad-stge02-02". Use the "network interface show -curr-node ag-ad-stge02-02" command to identify LIFs that could not be migrated off that node. Use the "network interface migrate" command to manually migrate the LIFs off the node. Reissue the command with "-skip-lif-migration-before-reboot" to skip the migration and continue with takeover. ag-stge-clus-01::> system reboot -node ag-ad-stge02-02 -ignore-quorum-warnings -skip-lif-migration-before-reboot Warning: Are you sure you want to reboot node "ag-ad-stge02-02"? {y|n}: y Connection to 172.22.115.132 closed.Si estás en el menú

LOADER, introduceboot_ontappara continuar con el reinicio. Durante el proceso de reinicio, pulsaCtrl-Cpara mostrar el menú de arranque cuando se te pida. El nodo muestra las siguientes opciones del menú de arranque:(1) Normal Boot. (2) Boot without /etc/rc. (3) Change password. (4) Clean configuration and initialize all disks. (5) Maintenance mode boot. (6) Update flash from backup config. (7) Install new software first. (8) Reboot node. (9) Configure Advanced Drive Partitioning Selection (1-9)?Selecciona la opción

(9) Configure Advanced Drive Partitioning. El nodo muestra las siguientes opciones:* Advanced Drive Partitioning Boot Menu Options * ************************************************* (9a) Destroy aggregates, unpartition all disks and remove their ownership information. (9b) Clean configuration and initialize node with partitioned disks. (9c) Clean configuration and initialize node with whole disks. (9d) Reboot the node. (9e) Return to main boot menu. (9f) Remove disk ownership.Selecciona la opción

9ae introducenocuando se te pida que confirmes la cancelación. El nodo vuelve a mostrar la siguiente opción después de9a:(9a) Unpartition all disks and remove their ownership information. (9b) Clean configuration and initialize node with partitioned disks. (9c) Clean configuration and initialize node with whole disks. (9d) Reboot the node. (9e) Return to main boot menu. ```Ejecuta la operación

9aen todos los nodos de almacenamiento del clúster antes de continuar.En cada nodo, ejecuta la opción

9be introduceyespara confirmar.(9a) Unpartition all disks and remove their ownership information. (9b) Clean configuration and initialize node with partitioned disks. (9c) Clean configuration and initialize node with whole disks. (9d) Reboot the node. (9e) Return to main boot menu.Si hay un par de alta disponibilidad, se mostrará el siguiente mensaje. Asegúrate de que todos los nodos del clúster hayan completado el paso 9a antes de ejecutar el paso 9b en ellos.

Selection (9a-9f)?: 9b 9b Option (9a) MUST BE COMPLETED on BOTH nodes in an HA pair (and DR/DR-AUX partner nodes if applicable) prior to starting option (9b). Has option (9a) been completed on all the nodes (yes/no)? yes yes

Cuando se muestre el mensaje

Welcome to the cluster setup wizard, se habrá completado el restablecimiento.

6.7. Restablecer el Thales k570

Para restablecer el Thales k570, empieza por restablecer el estado de fábrica de Ciphertrust Manager y, a continuación, restablece el propio Luna HSM.

6.7.1. Restablecer el estado de fábrica del sistema

Crea un directorio de trabajo temporal para las credenciales de HSM:

TMPPWDDIR=/run/user/$(id --user)/hsm mkdir -p $TMPPWDDIR chmod 700 $TMPPWDDIREstablece una conexión SSH con el HSM:

export ADMIN_SSH_SECRET_NAME=`kubectl get secrets -n hsm-system -o json | jq .items[].metadata.name | tr -d '"' | grep "ssh"` kubectl get secret $ADMIN_SSH_SECRET_NAME \ --namespace=hsm-system \ --output jsonpath='{.data.ssh-privatekey}' \ | base64 --decode > $TMPPWDDIR/hsm-ssh-privatekey chmod 0600 $TMPPWDDIR/hsm-ssh-privatekey ssh -i $TMPPWDDIR/hsm-ssh-privatekey ksadmin@$HSM_MGMT_IPSi no es posible, conéctate mediante un cable serie desde tu ordenador al puerto de la consola. Ejecuta el siguiente comando en otra pestaña para obtener la contraseña de

ksadmin.export KSADMIN_SECRET_NAME=`kubectl get secrets -n hsm-system -o json | jq .items[]metadata.name | tr -d '"' | grep "ksadmin"` kubectl get secret $KSADMIN_SECRET_NAME \ --namespace=hsm-system \ --output jsonpath='{.data.password}' \ | base64 --decodeUna vez que inicies sesión en la consola serie, verás una petición de inicio de sesión. Introduce el nombre de usuario como

ksadminy pega la contraseña del comando anterior.Antes de ejecutar el comando

factory-reset:No reinicies el sistema durante este tiempo, ya que la reconexión implica varios reinicios del sistema y no se puede deshacer.

Asegúrate de que tienes una batería de reserva.

Ejecuta el siguiente comando para restablecer el estado de fábrica:

sudo /opt/keysecure/ks_reset_to_factory.shEl proceso de restablecimiento tarda unos 10 minutos en completarse.

6.7.2. Restablecimiento de Luna HSM

El restablecimiento del estado de fábrica del sistema no borra la raíz de confianza de los HSMs. Ejecuta los siguientes comandos para restablecer el HSM Luna:

Desde el host de CipherTrust Manager, ya sea a través de SSH o de la consola serie, ejecuta el siguiente comando:

/usr/safenet/lunaclient/bin/lunacmlunacm:> hsm factoryResetElimina el directorio de trabajo temporal del programa de arranque:

rm $TMPPWDDIR

6.8. Restablecer cortafuegos

Para obtener instrucciones sobre cómo restablecer los ajustes de fábrica de tus cortafuegos, consulta Restablecer los ajustes de fábrica del cortafuegos.

6.9. Restablecer los switches de Cisco

Sigue estos pasos para restablecer los switches de Cisco. Ten en cuenta que estas instrucciones también se aplican a los cambios de almacenamiento, como stgesw.

- Inicia sesión en los interruptores.

Escribe, borra y vuelve a cargar los interruptores:

write erase reloadSi los interruptores se configuraron anteriormente y tienes disponible el directorio

cellcfg, puedes seguir las instrucciones de Limpieza previa.Comprueba que los interruptores estén en aprovisionamiento automático al encenderse (POAP).

Si el interruptor se ha restablecido correctamente, debería aparecer la siguiente petición cuando te conectes a él mediante el servidor de la consola:

Abort Power On Auto Provisioning [yes - continue with normal setup, skip - bypass password and basic configuration, no - continue with Power On Auto Provisioning] (yes/skip/no)[no]:

6.10. Recursos adicionales sobre el proceso de restablecimiento

Para obtener más información sobre el proceso de restablecimiento, consulta los siguientes recursos:

https://docs.netapp.com/us-en/ontap/system-admin/manage-node-boot-menu-task.htmlhttps://docs.netapp.com/us-en/ontap/encryption-at-rest/return-seds-unprotected-mode-task.html