Objectifs

Utiliser Dataproc Hub pour créer un environnement de notebook JupyterLab à utilisateur unique exécuté sur un cluster Dataproc

Créer un notebook et exécuter une tâche Spark sur le cluster Dataproc

Supprimer le cluster et conserver le notebook dans Cloud Storage

Avant de commencer

- L'administrateur doit vous accorder l'autorisation

notebooks.instances.use. Consultez la section Définir les rôles IAM (Identity and Access Management).

Créer un cluster JupyterLab Dataproc depuis Dataproc Hub

Sélectionnez l'onglet Notebooks gérés par l'utilisateur sur la page Dataproc → Workbench de la console Google Cloud .

Cliquez sur Ouvrir JupyterLab sur la ligne contenant l'instance Dataproc Hub créée par l'administrateur.

- Si vous n'avez pas accès à la console Google Cloud , saisissez dans votre navigateur Web l'URL de l'instance Dataproc Hub qu'un administrateur a partagée avec vous.

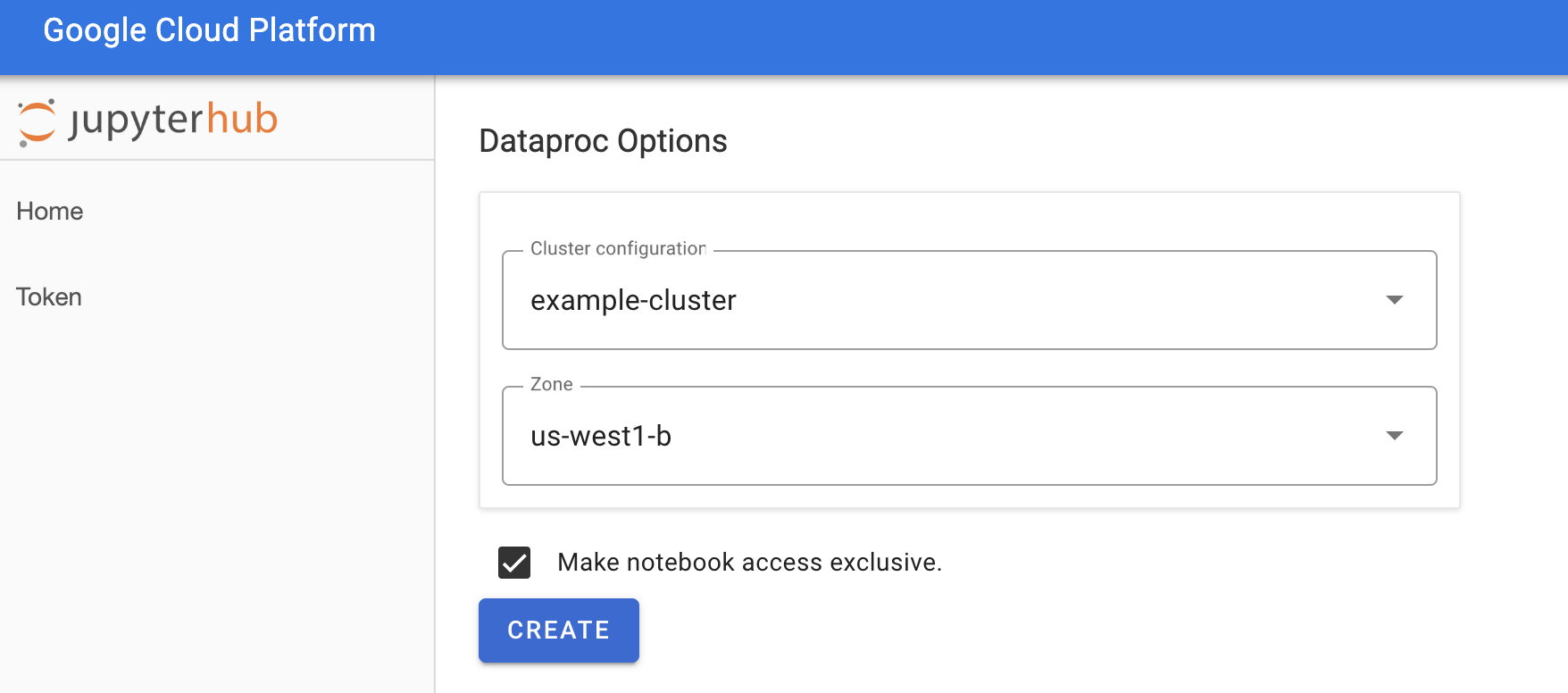

Sur la page Jupyterhub→Options Dataproc, sélectionnez une configuration et une zone de cluster. Si les personnalisations sont activées, spécifiez-les, puis cliquez sur Créer.

Une fois le cluster Dataproc créé, vous êtes redirigé vers l'interface JupyterLab exécutée sur le cluster.

Créer un notebook et exécuter une tâche Spark

Dans le panneau de gauche de l'interface JupyterLab, cliquez sur

GCS(Cloud Storage).Créez un notebook PySpark à partir du lanceur JupyterLab.

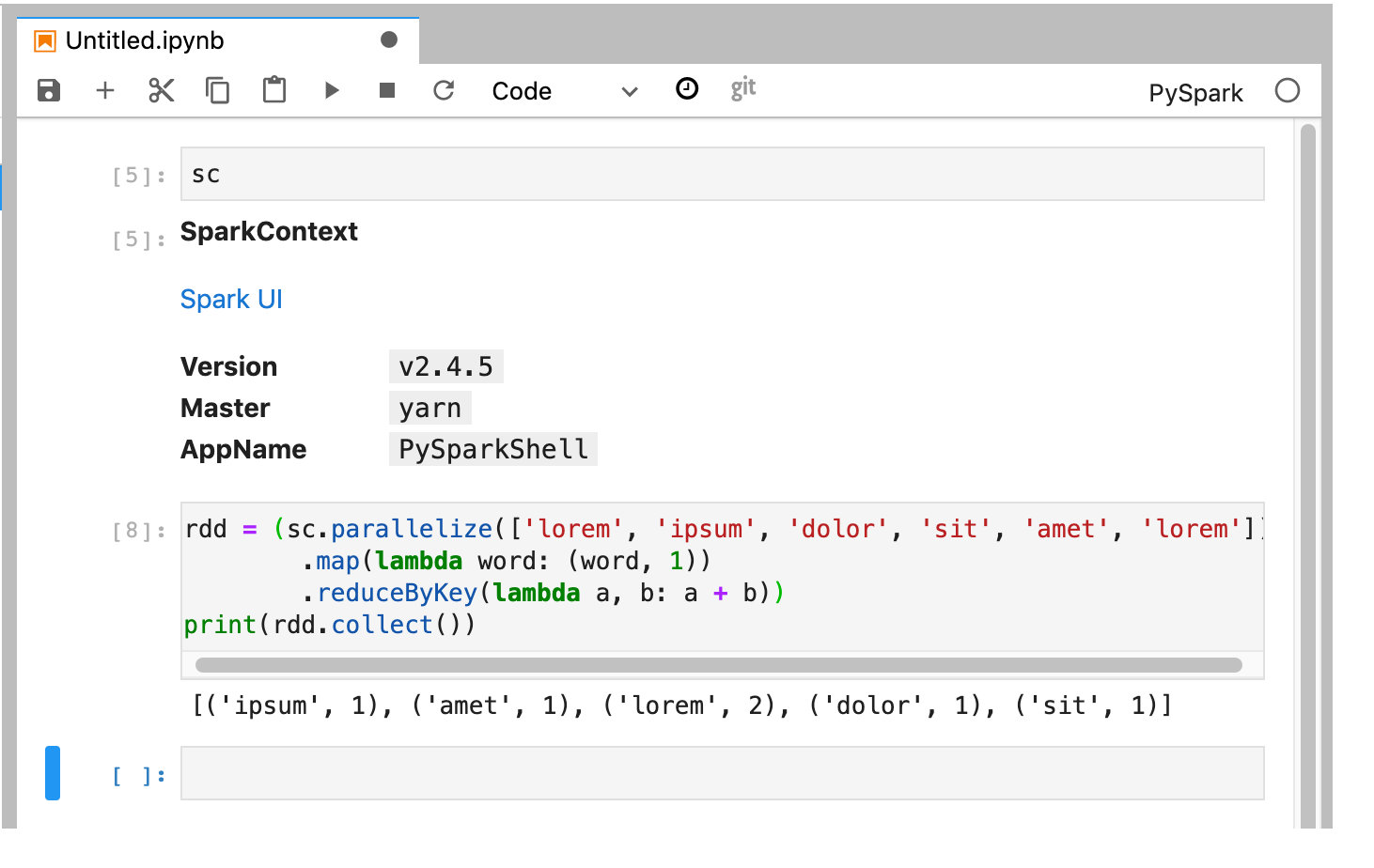

Le noyau PySpark initialise un SparkContext (à l'aide de la variable

sc). Vous pouvez examiner le SparkContext et exécuter une tâche Spark à partir du notebook.rdd = (sc.parallelize(['lorem', 'ipsum', 'dolor', 'sit', 'amet', 'lorem']) .map(lambda word: (word, 1)) .reduceByKey(lambda a, b: a + b)) print(rdd.collect())

Nommez et enregistrez le notebook. Le notebook est enregistré et reste dans Cloud Storage après la suppression du cluster Dataproc.

Éteindre le cluster Dataproc

Dans l'interface JupyterLab, sélectionnez Fichier → Panneau de configuration Hub pour ouvrir la page Jupyterhub.

Cliquez sur Stop My Cluster (Arrêter mon cluster) pour arrêter (supprimer) le serveur JupyterLab, ce qui supprime le cluster Dataproc.

Étapes suivantes

- Explorez des notebooks Spark et Jupyter sur Dataproc sur GitHub.