Questo tutorial mostra come utilizzare Dataflow SQL per unire un flusso di dati da Pub/Sub con i dati di una tabella BigQuery.

Obiettivi

In questo tutorial:

- Scrivi una query Dataflow SQL che unisce i dati di streaming Pub/Sub con i dati della tabella BigQuery.

- Esegui il deployment di un job Dataflow dall'interfaccia utente di Dataflow SQL.

Costi

In questo documento vengono utilizzati i seguenti componenti fatturabili di Google Cloud:

- Dataflow

- Cloud Storage

- Pub/Sub

- Data Catalog

Per generare una stima dei costi in base all'utilizzo previsto,

utilizza il calcolatore prezzi.

Prima di iniziare

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Dataflow, Compute Engine, Logging, Cloud Storage, Cloud Storage JSON, BigQuery, Cloud Pub/Sub, Cloud Resource Manager and Data Catalog. APIs.

-

Create a service account:

-

In the Google Cloud console, go to the Create service account page.

Go to Create service account - Select your project.

-

In the Service account name field, enter a name. The Google Cloud console fills in the Service account ID field based on this name.

In the Service account description field, enter a description. For example,

Service account for quickstart. - Click Create and continue.

-

Grant the Project > Owner role to the service account.

To grant the role, find the Select a role list, then select Project > Owner.

- Click Continue.

-

Click Done to finish creating the service account.

Do not close your browser window. You will use it in the next step.

-

-

Create a service account key:

- In the Google Cloud console, click the email address for the service account that you created.

- Click Keys.

- Click Add key, and then click Create new key.

- Click Create. A JSON key file is downloaded to your computer.

- Click Close.

-

Set the environment variable

GOOGLE_APPLICATION_CREDENTIALSto the path of the JSON file that contains your credentials. This variable applies only to your current shell session, so if you open a new session, set the variable again. -

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Dataflow, Compute Engine, Logging, Cloud Storage, Cloud Storage JSON, BigQuery, Cloud Pub/Sub, Cloud Resource Manager and Data Catalog. APIs.

-

Create a service account:

-

In the Google Cloud console, go to the Create service account page.

Go to Create service account - Select your project.

-

In the Service account name field, enter a name. The Google Cloud console fills in the Service account ID field based on this name.

In the Service account description field, enter a description. For example,

Service account for quickstart. - Click Create and continue.

-

Grant the Project > Owner role to the service account.

To grant the role, find the Select a role list, then select Project > Owner.

- Click Continue.

-

Click Done to finish creating the service account.

Do not close your browser window. You will use it in the next step.

-

-

Create a service account key:

- In the Google Cloud console, click the email address for the service account that you created.

- Click Keys.

- Click Add key, and then click Create new key.

- Click Create. A JSON key file is downloaded to your computer.

- Click Close.

-

Set the environment variable

GOOGLE_APPLICATION_CREDENTIALSto the path of the JSON file that contains your credentials. This variable applies only to your current shell session, so if you open a new session, set the variable again. - Installa e inizializza gcloud CLI. Scegli una delle

opzioni di installazione.

Potresti dover impostare la proprietà

projectsul progetto che stai utilizzando per questa procedura dettagliata. - Vai all'UI web di Dataflow SQL nella console Google Cloud . In questo modo

viene aperto il progetto a cui hai eseguito l'accesso più di recente. Per passare a un altro progetto, fai clic sul nome del progetto in alto nell'interfaccia utente web di Dataflow SQL e cerca il progetto che vuoi utilizzare.

Vai all'interfaccia utente web di Dataflow SQL

- Un argomento Pub/Sub denominato

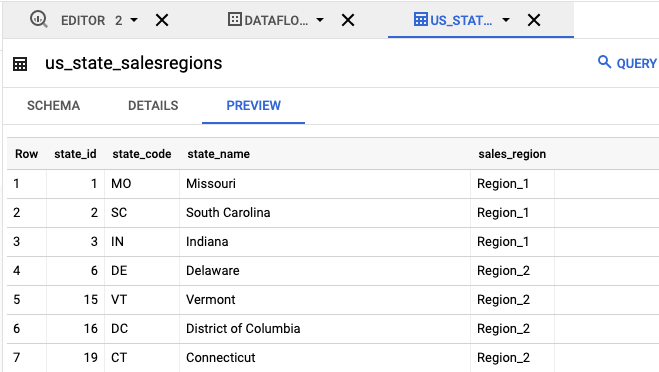

transactions: un flusso di dati delle transazioni che arrivano tramite una sottoscrizione all'argomento Pub/Sub. I dati di ogni transazione includono informazioni come il prodotto acquistato, il prezzo di vendita e la città e la provincia in cui è stato effettuato l'acquisto. Dopo aver creato l'argomento Pub/Sub, crea uno script che pubblica i messaggi nell'argomento. Eseguirai questo script in una sezione successiva di questo tutorial. - Una tabella BigQuery denominata

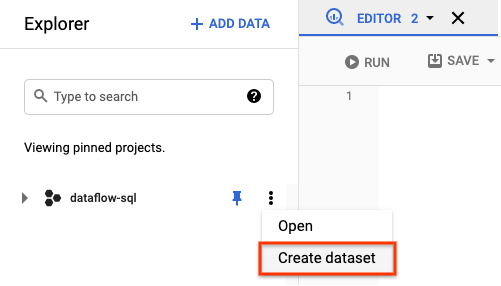

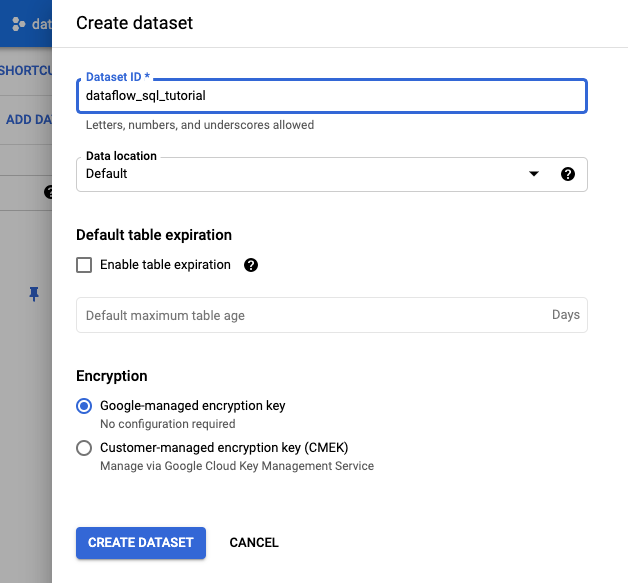

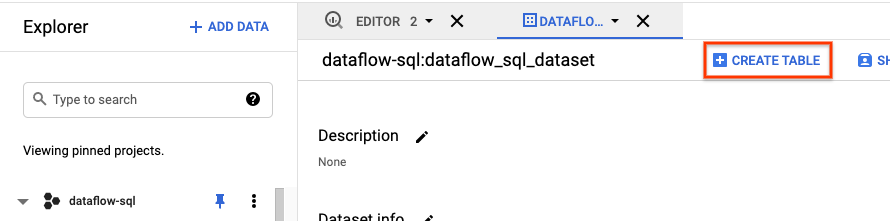

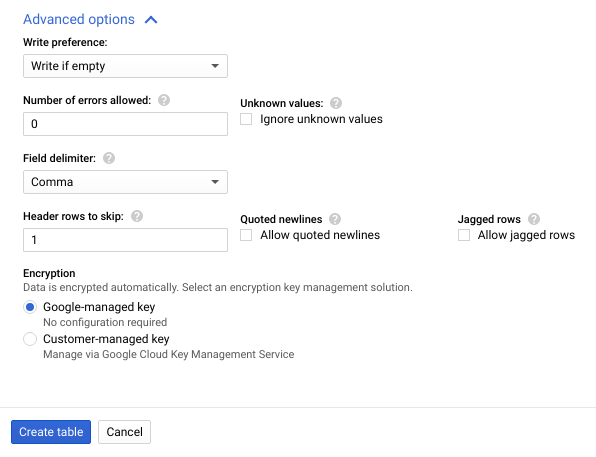

us_state_salesregions: una tabella che fornisce una mappatura degli stati alle regioni di vendita. Prima di creare questa tabella, devi creare un set di dati BigQuery. Crea un file di testo e chiamalo

transactions_schema.yaml. Copia e incolla il seguente testo dello schema intransactions_schema.yaml.- column: event_timestamp description: Pub/Sub event timestamp mode: REQUIRED type: TIMESTAMP - column: tr_time_str description: Transaction time string mode: NULLABLE type: STRING - column: first_name description: First name mode: NULLABLE type: STRING - column: last_name description: Last name mode: NULLABLE type: STRING - column: city description: City mode: NULLABLE type: STRING - column: state description: State mode: NULLABLE type: STRING - column: product description: Product mode: NULLABLE type: STRING - column: amount description: Amount of transaction mode: NULLABLE type: FLOATAssegna lo schema utilizzando Google Cloud CLI.

a. Aggiorna gcloud CLI con il seguente comando. Assicurati che la versione di gcloud CLI sia 242.0.0 o successive.

gcloud components update

b. Esegui il seguente comando in una finestra della riga di comando. Sostituisci project-id con il tuo ID progetto e path-to-file con il percorso del tuo file

transactions_schema.yaml.gcloud data-catalog entries update \ --lookup-entry='pubsub.topic.`project-id`.transactions' \ --schema-from-file=path-to-file/transactions_schema.yaml

Per ulteriori informazioni sui parametri del comando e sui formati di file di schema consentiti, consulta la pagina della documentazione di gcloud data-catalog entries update.

c. Verifica che lo schema sia stato assegnato correttamente all'argomento Pub/Sub

transactions. Sostituisci project-id con l'ID progetto.gcloud data-catalog entries lookup 'pubsub.topic.`project-id`.transactions'

Vai a SQL Workspace.

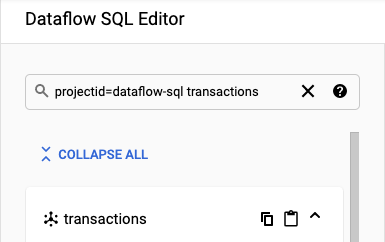

Nel riquadro Editor Dataflow SQL, nella barra di ricerca, cerca

projectid=project-id transactions. Sostituisci project-id con l'ID progetto.

- Nel riquadro Editor Dataflow SQL dell'interfaccia utente di Dataflow SQL, fai clic su

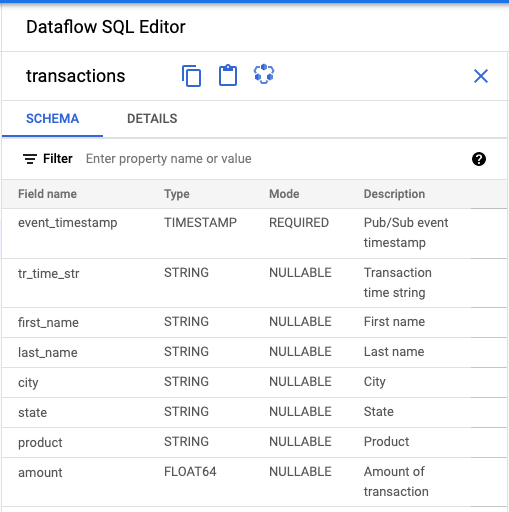

transactions o cerca un argomento Pub/Sub digitando

projectid=project-id system=cloud_pubsube seleziona l'argomento. In Schema, puoi visualizzare lo schema che hai assegnato all'argomento Pub/Sub.

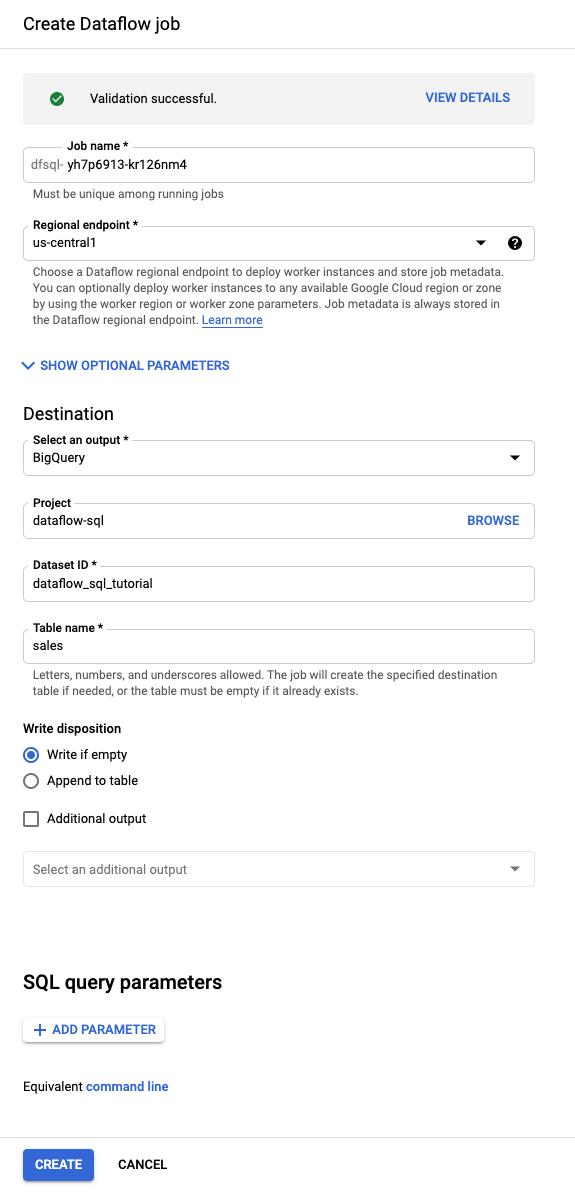

Nell'editor query, fai clic su Crea job.

Nel riquadro Crea job Dataflow che si apre:

- Per Destinazione, seleziona BigQuery.

- In ID set di dati, seleziona

dataflow_sql_tutorial. - In Nome tabella, inserisci

sales.

(Facoltativo) Dataflow sceglie automaticamente le impostazioni ottimali per il job Dataflow SQL, ma puoi espandere il menu Parametri facoltativi per specificare manualmente le seguenti opzioni della pipeline:

- Numero massimo di worker

- Zona

- Email dell'account di servizio

- Tipo di macchina

- Esperimenti aggiuntivi

- Configurazione dell'indirizzo IP del worker

- Rete

- Subnet

Fai clic su Crea. L'avvio del job Dataflow richiede alcuni minuti.

Nella pagina Job di Dataflow, fai clic sul job che vuoi modificare.

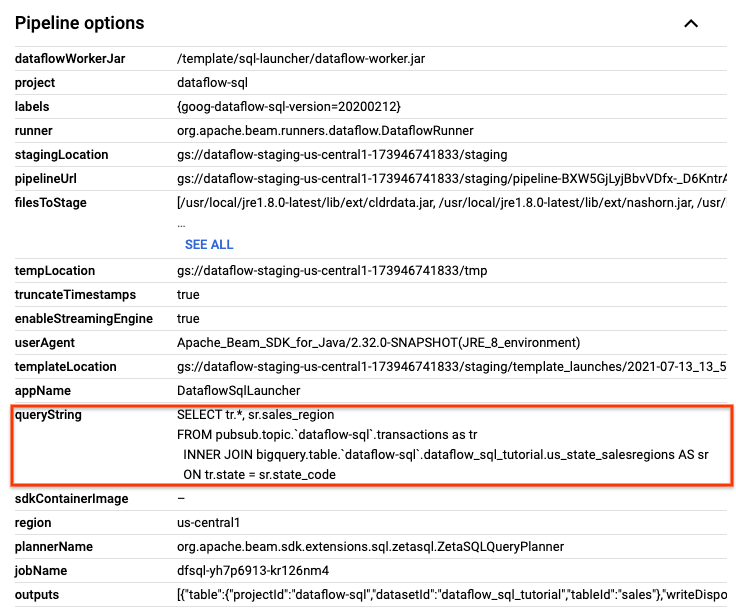

Nella pagina Dettagli job, nel riquadro Informazioni job, individua la query SQL nella sezione Opzioni pipeline. Trova la riga relativa a queryString.

Copia e incolla la seguente query SQL nell'editor Dataflow SQL in SQL Workspace per aggiungere finestre temporali. Sostituisci project-id con l'ID progetto.

SELECT sr.sales_region, TUMBLE_START("INTERVAL 15 SECOND") AS period_start, SUM(tr.amount) as amount FROM pubsub.topic.`project-id`.transactions AS tr INNER JOIN bigquery.table.`project-id`.dataflow_sql_tutorial.us_state_salesregions AS sr ON tr.state = sr.state_code GROUP BY sr.sales_region, TUMBLE(tr.event_timestamp, "INTERVAL 15 SECOND")

Fai clic su Crea job per creare un nuovo job con la query modificata.

Interrompi lo script di pubblicazione di

transactions_injector.pyse è ancora in esecuzione.Interrompi i job Dataflow in esecuzione. Vai all'UI web di Dataflow nella console Google Cloud .

Per ogni job creato seguendo questa procedura dettagliata, esegui i seguenti passaggi:

Fai clic sul nome del job.

Nella pagina Dettagli job, fai clic su Interrompi. Viene visualizzata la finestra di dialogo Interrompi job con le opzioni per interrompere il job.

Seleziona Annulla.

Fai clic su Interrompi job. Il servizio interrompe tutte le operazioni di importazione ed elaborazione dei dati il prima possibile. Poiché Annulla interrompe immediatamente l'elaborazione, potresti perdere i dati "in volo". L'arresto di un job potrebbe richiedere alcuni minuti.

Elimina il set di dati BigQuery. Vai all'UI web di BigQuery nella console Google Cloud .

Nel riquadro Explorer, nella sezione Risorse, fai clic sul set di dati dataflow_sql_tutorial che hai creato.

Nel riquadro dei dettagli, fai clic su Elimina. Si apre una finestra di dialogo di conferma.

Nella finestra di dialogo Elimina set di dati, conferma il comando di eliminazione digitando

delete, quindi fai clic su Elimina.

Elimina l'argomento Pub/Sub. Vai alla pagina degli argomenti Pub/Sub nella console Google Cloud .

Vai alla pagina degli argomenti Pub/Sub

Seleziona l'argomento

transactions.Fai clic su Elimina per eliminare definitivamente l'argomento. Si apre una finestra di dialogo di conferma.

Nella finestra di dialogo Elimina argomento, conferma il comando di eliminazione digitando

delete, quindi fai clic su Elimina.Vai alla pagina delle sottoscrizioni Pub/Sub.

Seleziona gli abbonamenti rimanenti da

transactions. Se i job non vengono più eseguiti, potrebbero non essere presenti abbonamenti.Fai clic su Elimina per eliminare definitivamente gli abbonamenti. Nella finestra di dialogo di conferma, fai clic su Elimina.

Elimina il bucket di staging Dataflow in Cloud Storage. Vai alla pagina Bucket di Cloud Storage nella console Google Cloud .

Seleziona il bucket di staging di Dataflow.

Fai clic su Elimina per eliminare il bucket. Si apre una finestra di dialogo di conferma.

Nella finestra di dialogo Elimina bucket, conferma il comando di eliminazione digitando

DELETE, quindi fai clic su Elimina.

Crea origini di esempio

Se vuoi seguire l'esempio fornito in questo tutorial, crea le seguenti origini e utilizzale nei passaggi del tutorial.

Assegna uno schema all'argomento Pub/Sub

L'assegnazione di uno schema consente di eseguire query SQL sui dati dell'argomento Pub/Sub. Al momento, Dataflow SQL prevede che i messaggi negli argomenti Pub/Sub vengano serializzati in formato JSON.

Per assegnare uno schema all'argomento Pub/Sub di esempio transactions:

Trovare le origini Pub/Sub

L'interfaccia utente di Dataflow SQL consente di trovare gli oggetti di origine dati Pub/Sub per qualsiasi progetto a cui hai accesso, in modo da non dover ricordare i loro nomi completi.

Per l'esempio in questo tutorial, vai all'editor Dataflow SQL e cerca l'argomento Pub/Sub transactions che hai creato:

Visualizzare lo schema

Crea una query SQL

L'interfaccia utente di Dataflow SQL ti consente di creare query SQL per eseguire i job Dataflow.

La seguente query SQL è una query di arricchimento dei dati. Aggiunge un campo aggiuntivo,sales_region, al flusso di eventi Pub/Sub (transactions), utilizzando una tabella BigQuery (us_state_salesregions) che mappa gli stati alle regioni di vendita.

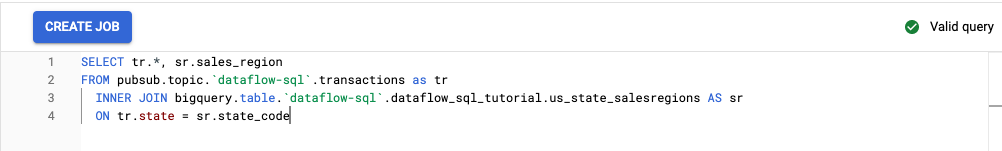

Copia e incolla la seguente query SQL nell'Editor di query. Sostituisci project-id con l'ID progetto.

SELECT tr.*, sr.sales_region FROM pubsub.topic.`project-id`.transactions as tr INNER JOIN bigquery.table.`project-id`.dataflow_sql_tutorial.us_state_salesregions AS sr ON tr.state = sr.state_code

Quando inserisci una query nell'interfaccia utente di Dataflow SQL, lo strumento di convalida verifica la sintassi della query. Se la query è valida, viene visualizzata un'icona con un segno di spunta verde. Se la query non è valida, viene visualizzata un'icona rossa con punto esclamativo. Se la sintassi della query non è valida, facendo clic sull'icona dello strumento di convalida vengono fornite informazioni su cosa devi correggere.

Lo screenshot seguente mostra la query valida nell'Editor di query. Il validatore mostra un segno di spunta verde.

Crea un job Dataflow per eseguire la query SQL

Per eseguire la query SQL, crea un job Dataflow dall'interfaccia utente di Dataflow SQL.

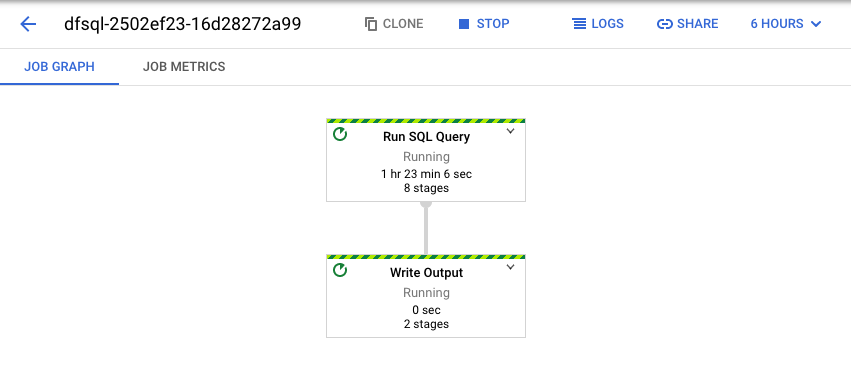

Visualizza il job Dataflow

Dataflow trasforma la query SQL in una pipeline Apache Beam. Fai clic su Visualizza job per aprire l'interfaccia utente web di Dataflow, dove puoi vedere una rappresentazione grafica della pipeline.

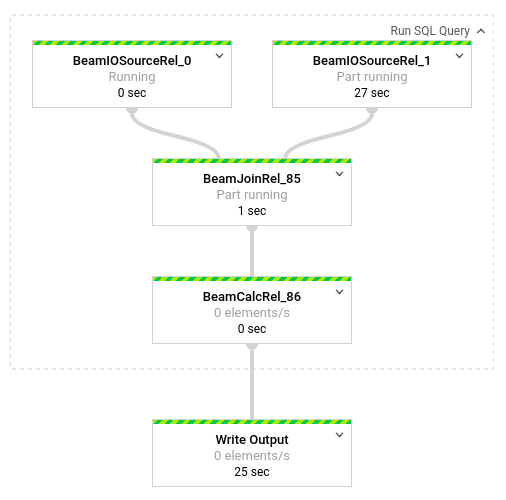

Per visualizzare una suddivisione delle trasformazioni che si verificano nella pipeline, fai clic sulle caselle. Ad esempio, se fai clic sulla prima casella nella rappresentazione grafica, etichettata Esegui query SQL, viene visualizzato un grafico che mostra le operazioni che avvengono in background.

Le prime due caselle rappresentano i due input uniti: l'argomento Pub/Sub, transactions, e la tabella BigQuery, us_state_salesregions.

Per visualizzare la tabella di output contenente i risultati del job, vai all'interfaccia utente BigQuery.

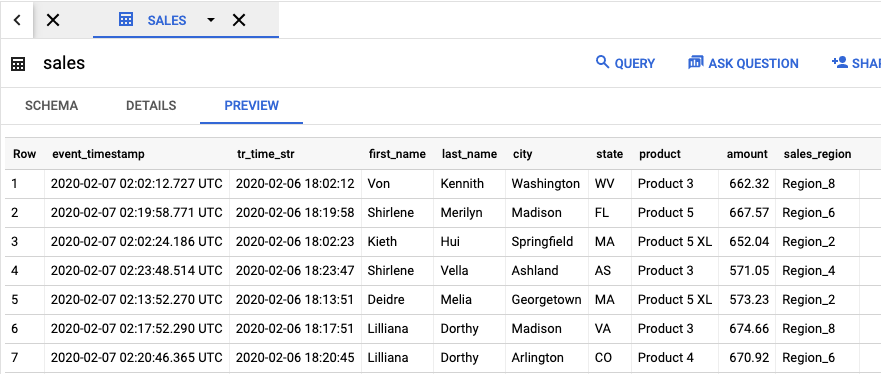

Nel riquadro Explorer, nel tuo progetto, fai clic sul set di dati dataflow_sql_tutorial che hai creato. poi fai clic sulla tabella di output,

sales. La scheda Anteprima mostra i contenuti della tabella di output.

Visualizzare i job passati e modificare le query

L'interfaccia utente di Dataflow archivia i job e le query precedenti nella pagina Job di Dataflow.

Puoi utilizzare l'elenco della cronologia dei job per visualizzare le query SQL precedenti. Ad esempio, vuoi modificare la query per aggregare le vendite per regione di vendita ogni 15 secondi. Utilizza la pagina Job per accedere al job in esecuzione che hai avviato in precedenza nel tutorial, copia la query SQL ed esegui un altro job con una query modificata.

Esegui la pulizia

Per evitare che al tuo account di fatturazione Cloud vengano addebitati costi relativi alle risorse utilizzate in questo tutorial:

Passaggi successivi

- Consulta un'introduzione a Dataflow SQL.

- Scopri di più sulle nozioni di base sulla pipeline streaming.

- Esplora il riferimento SQL di Dataflow.

- Guarda la demo dell'analisi dei flussi di dati presentata a Cloud Next 2019.