Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

En esta página, se proporcionan información y pasos para solucionar problemas comunes con los programadores de Airflow.

Identifica el origen del problema

Para comenzar a solucionar problemas, primero debes identificar si el problema ocurre en el momento del análisis del DAG o mientras se procesan las tareas en el momento de la ejecución. Para obtener más información sobre el tiempo de análisis y el tiempo de ejecución, consulta la Diferencia entre el tiempo de análisis y de ejecución del DAG.

Inspecciona los registros del procesador de DAG

Si tienes DAGs complejos, es posible que el encargado del tratamiento de datos, que ejecuta el programador, no analice todos tus DAGs. Esto puede generar muchos problemas que tengan los siguientes síntomas.

Síntomas:

Si el procesador de DAG encuentra problemas cuando analiza tus DAG, es posible que se produzca una combinación de los problemas que se indican a continuación. Si los DAG se generan de forma dinámica, estos problemas pueden ser más graves en comparación con los DAG estáticos.

Los DAG no son visibles en la IU de Airflow ni en la IU de DAG.

Los DAG no están programados para su ejecución.

Hay errores en los registros del procesador de DAG, por ejemplo:

dag-processor-manager [2023-04-21 21:10:44,510] {manager.py:1144} ERROR - Processor for /home/airflow/gcs/dags/dag-example.py with PID 68311 started at 2023-04-21T21:09:53.772793+00:00 has timed out, killing it.o

dag-processor-manager [2023-04-26 06:18:34,860] {manager.py:948} ERROR - Processor for /home/airflow/gcs/dags/dag-example.py exited with return code 1.Los programadores de Airflow tienen problemas que provocan reinicios del programador.

Las tareas de Airflow programadas para su ejecución se cancelan, y las ejecuciones de DAG para los DAG que no se pudieron analizar pueden marcarse como

failed. Por ejemplo:airflow-scheduler Failed to get task '<TaskInstance: dag-example.task1--1 manual__2023-04-17T10:02:03.137439+00:00 [removed]>' for dag 'dag-example'. Marking it as removed.

Solution:

Aumenta los parámetros relacionados con el análisis de DAG:

Aumenta dagbag-import-timeout a, al menos, 120 segundos (o más, si es necesario).

Aumenta dag-file-processor-timeout a, al menos, 180 segundos (o más, si es necesario). Este valor debe ser superior a

dagbag-import-timeout.

Corrige o quita los DAG que causan problemas al procesador de DAG.

Inspecciona los tiempos de análisis del DAG

Para verificar si el problema ocurre durante el análisis del DAG, sigue estos pasos.

Console

En la consola de Google Cloud, puedes usar la página Monitoring y la pestaña Logs para inspeccionar los tiempos de análisis de DAG.

Inspecciona los tiempos de análisis del DAG con la página de supervisión de Cloud Composer:

En la consola de Google Cloud, ve a la página Entornos.

En la lista de entornos, haz clic en el nombre de tu entorno. Se abrirá la página Supervisión.

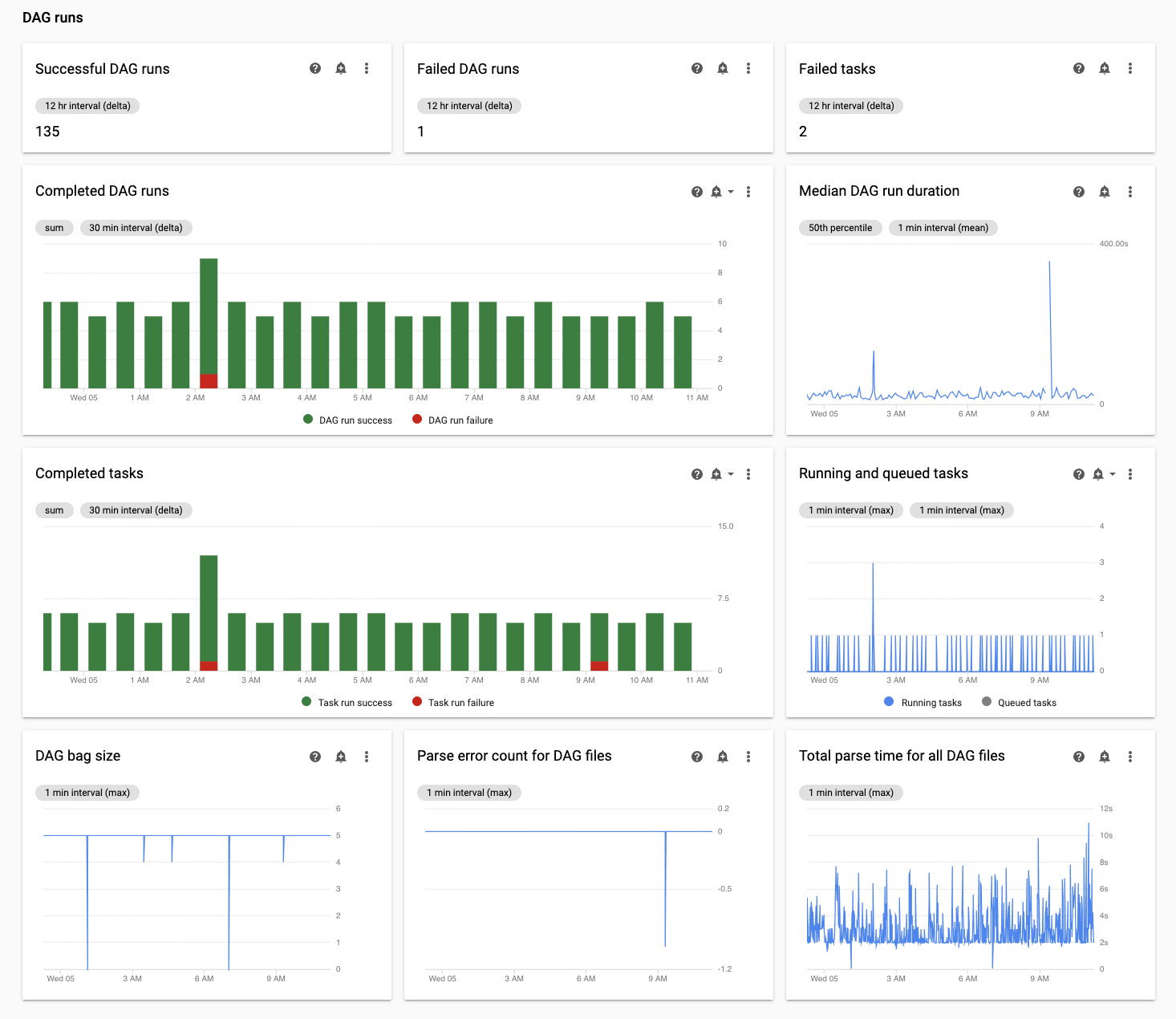

En la pestaña Monitoring, revisa el gráfico Tiempo total de análisis de todos los archivos DAG en la sección Ejecuciones de DAG y, luego, identifica posibles problemas.

Inspecciona los tiempos de análisis del DAG con la pestaña Registros de Cloud Composer:

En la consola de Google Cloud, ve a la página Entornos.

En la lista de entornos, haz clic en el nombre de tu entorno. Se abrirá la página Supervisión.

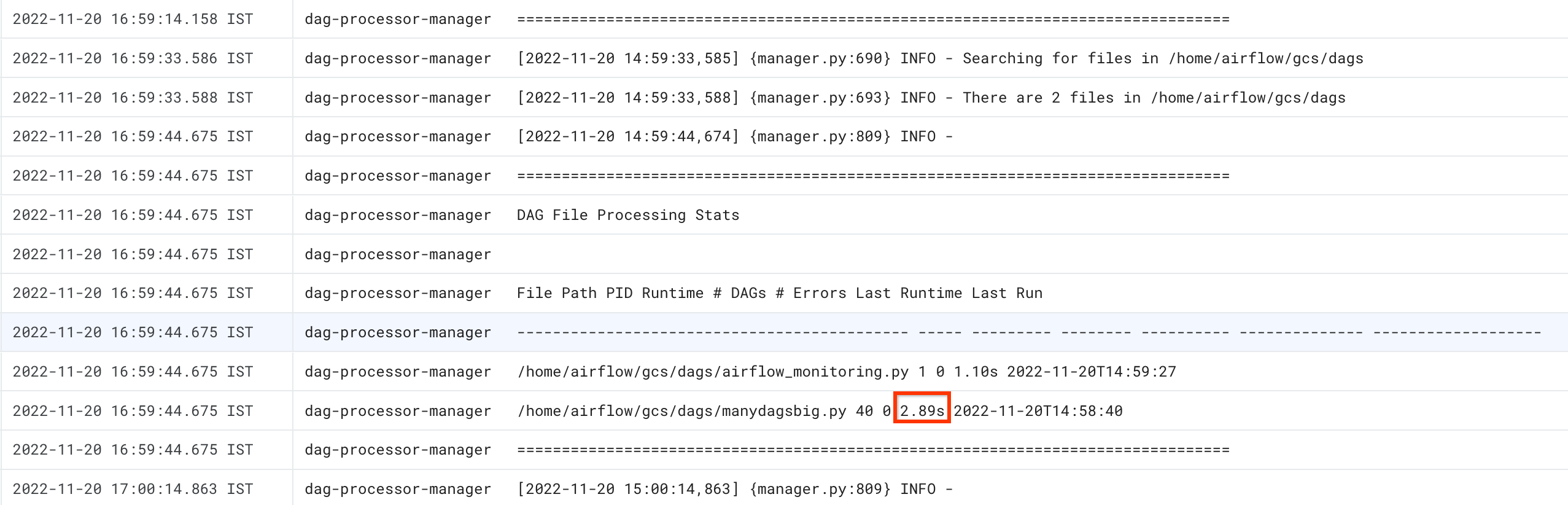

Ve a la pestaña Registros y, en el árbol de navegación Todos los registros, selecciona la sección Administrador de procesadores DAG.

Revisa los registros de

dag-processor-managery, luego, identifica los posibles problemas.

gcloud: Airflow 1

Usa el comando list_dags con la marca -r para ver el tiempo de análisis de todos tus DAG.

gcloud composer environments run ENVIRONMENT_NAME \

--location LOCATION \

list_dags -- -r

Reemplaza lo siguiente:

ENVIRONMENT_NAMEpor el nombre del entorno.LOCATIONpor la región en la que se encuentra el entorno.

El resultado del comando es similar al siguiente:

-------------------------------------------------------------------

DagBag loading stats for /home/airflow/gcs/dags

-------------------------------------------------------------------

Number of DAGs: 5

Total task number: 13

DagBag parsing time: 0.6765180000000001

-----------+----------+---------+----------+-----------------------

file | duration | dag_num | task_num | dags

-----------+----------+---------+----------+-----------------------

/dag_1.py | 0.6477 | 1 | 2 | ['dag_1']

/dag_2.py | 0.018652 | 1 | 2 | ['dag_2']

/dag_3.py | 0.004024 | 1 | 6 | ['dag_3']

/dag_4.py | 0.003476 | 1 | 2 | ['dag_4']

/dag_5.py | 0.002666 | 1 | 1 | ['dag_5']

-----------+----------+---------+----------+-----------------------

Busca el valor de tiempo de análisis de DagBag. Un valor alto puede indicar que uno de tus DAG no se implementa de manera óptima. En la tabla de resultados, puedes identificar qué DAG tienen un tiempo de análisis prolongado.

gcloud: Airflow 2

Usa el comando dags report para ver el tiempo de análisis de todos tus DAG.

gcloud composer environments run ENVIRONMENT_NAME \

--location LOCATION \

dags report

Reemplaza lo siguiente:

ENVIRONMENT_NAMEpor el nombre del entorno.LOCATIONpor la región en la que se encuentra el entorno.

El resultado del comando es similar al siguiente:

Executing within the following Kubernetes cluster namespace: composer-2-0-31-airflow-2-3-3

file | duration | dag_num | task_num | dags

======================+================+=========+==========+===================

/manydagsbig.py | 0:00:00.038334 | 2 | 10 | serial-0,serial-0

/airflow_monitoring.py| 0:00:00.001620 | 1 | 1 | airflow_monitoring

Busca el valor de duration para cada uno de los DAG que aparecen en la tabla. Un valor alto puede indicar que uno de tus DAG no se implementa de manera óptima. En la tabla de resultados, puedes identificar qué DAGs tienen un tiempo de análisis prolongado.

Supervisa tareas en ejecución y en cola

Para verificar si hay tareas atascadas en una cola, sigue estos pasos.

En la consola de Google Cloud, ve a la página Entornos.

En la lista de entornos, haz clic en el nombre de tu entorno. Se abrirá la página Detalles del entorno.

Ve a la pestaña Monitoring.

En la pestaña Monitoring, revisa el gráfico Tareas de Airflow en la sección Ejecuciones de DAG y, luego, identifica posibles problemas. Las tareas de Airflow son tareas que se encuentran en un estado en cola en Airflow y pueden ir a la cola del agente de Celery o de Kubernetes Executor. Las tareas en cola de Celery son instancias de tareas que se ponen en la cola de agentes de Celery.

Soluciona problemas durante el análisis de DAG

En las siguientes secciones, se describen los síntomas y las posibles soluciones para algunos problemas comunes durante el análisis de DAG.

Análisis y programación de DAG en Cloud Composer 1 y Airflow 1

La eficiencia del análisis de DAG mejoró significativamente en Airflow 2. Si tienes problemas de rendimiento relacionados con el análisis y la programación de DAG, considera migrar a Airflow 2.

En Cloud Composer 1, el programador se ejecuta en nodos de clúster junto con otros componentes de Cloud Composer. Por este motivo, la carga de los nodos del clúster individuales puede ser mayor o menor en comparación con otros nodos. El rendimiento del programador (análisis y programación de DAG) puede variar según el nodo en el que se ejecuta. Además, un nodo individual en el que se ejecuta el programador puede cambiar como resultado de operaciones de actualización o mantenimiento. Esta limitación se resolvió en Cloud Composer 2, en el que puedes asignar recursos de CPU y memoria al programador, y el rendimiento del programador no depende de la carga de los nodos del clúster.

Cantidad limitada de subprocesos

Permitir que el administrador del procesador de DAG (la parte del programador que procesa los archivos DAG) use solo una cantidad limitada de subprocesos podría afectar el tiempo de análisis del DAG.

Para resolver el problema, anula las siguientes opciones de configuración de Airflow:

Para Airflow 1.10.12 y versiones anteriores, anula el parámetro

max_threads:Sección Clave Valor Notas schedulermax_threadsNUMBER_OF_CORES_IN_MACHINE - 1Reemplaza NUMBER_OF_CORES_IN_MACHINEpor la cantidad de núcleos

en las máquinas de nodos trabajadores.Para Airflow 1.10.14 y versiones posteriores, anula el parámetro

parsing_processes:Sección Clave Valor Notas schedulerparsing_processesNUMBER_OF_CORES_IN_MACHINE - 1Reemplaza NUMBER_OF_CORES_IN_MACHINEpor la cantidad de núcleos

en las máquinas de nodos trabajadores.

Distribución de números y horarios de las tareas

Airflow es conocido por tener problemas para programar una gran cantidad de tareas pequeñas. En tales casos, debes elegir una cantidad menor de tareas más consolidadas.

Programar una gran cantidad de DAG o tareas al mismo tiempo también puede ser una posible fuente de problemas. Para evitar este problema, distribuye tus tareas de manera más uniforme en el tiempo.

Soluciona problemas de tareas en ejecución y en cola

En las siguientes secciones, se describen los síntomas y las posibles soluciones para algunos problemas comunes con las tareas en cola y en ejecución.

Las listas de tareas en cola son demasiado largas

En algunos casos, una lista de tareas en cola puede ser demasiado larga para el programador. Para obtener información sobre cómo optimizar los parámetros de trabajador y Celery, lee sobre cómo escalar tu entorno de Cloud Composer junto con tu negocio.

Cómo usar la función TimeTable del programador de Airflow

A partir de Airflow 2.2, puedes definir un programa de tiempo para un DAG con una función nueva llamada TimeTable.

Puedes definir un horario con uno de los siguientes métodos:

Recursos de clúster limitados

Esta sección solo se aplica a Cloud Composer 1.

Es posible que experimentes problemas de rendimiento si el clúster de GKE de tu entorno es demasiado pequeño para todos tus DAG y tareas. En este caso, prueba una de las siguientes soluciones:

- Crea un entorno nuevo con un tipo de máquina que proporcione más rendimiento y migra tus DAG a él

- Crea más entornos de Cloud Composer y divide los DAG entre ellos

- Cambia el tipo de máquina de los nodos de GKE, como se describe en Actualización del tipo de máquina de los nodos de GKE. Dado que este procedimiento es propenso a errores, es la opción menos recomendada.

- Actualiza el tipo de máquina de la instancia de Cloud SQL que ejecuta la base de datos de Airflow en tu entorno, por ejemplo, mediante los comandos

gcloud composer environments update. El rendimiento bajo de la base de datos de Airflow podría ser la razón por la que el programador es lento.

Evita la programación de tareas durante los períodos de mantenimiento

Puedes definir períodos de mantenimiento específicos para tu entorno. Durante estos períodos, se producen los eventos de mantenimiento para Cloud SQL y GKE.

Haz que el programador de Airflow ignore archivos innecesarios

Puedes mejorar el rendimiento del programador de Airflow si omites los archivos innecesarios en la carpeta de DAG. El programador de Airflow ignora los archivos y carpetas especificados en el archivo .airflowignore.

Para que el programador de Airflow ignore archivos innecesarios, haz lo siguiente:

- Crea un archivo

.airflowignore. - En este archivo, se muestra una lista de los archivos y las carpetas que se deben ignorar.

- Sube este archivo a la carpeta

/dagsen el bucket de tu entorno.

Para obtener más información sobre el formato de archivo .airflowignore, consulta la documentación de Airflow.

El programador de Airflow procesa los DAG pausados

Los usuarios de Airflow pausan los DAG para evitar su ejecución. Esto ahorra ciclos de procesamiento de los trabajadores de Airflow.

El programador de Airflow continuará analizando los DAG pausados. Si en realidad deseas mejorar el rendimiento del programador de Airflow, usa .airflowignore o borra los DAG pausados de la carpeta de DAG.

Uso de “wait_for_downstream” en tus DAG

Si configuras el parámetro wait_for_downstream en True en tus DAG, para que una tarea tenga éxito, todas las tareas que se encuentran en una etapa posterior de esta tarea también deben tener éxito. Significa que la ejecución de las tareas que pertenecen a una ejecución de DAG determinada puede ralentizarse mediante la ejecución de tareas de la ejecución del DAG anterior. Obtén más información sobre este tema en la documentación de Airflow.

Las tareas que estén en cola durante demasiado tiempo se cancelarán y reprogramarán.

Si una tarea de Airflow se mantiene en la cola durante demasiado tiempo, el programador la volverá a programar para su ejecución (en versiones de Airflow anteriores a la 2.3.1, la tarea también se marca como fallida y se vuelve a intentar si es apta para un reintento).

Una forma de observar los síntomas de esta situación es mirar el gráfico con la cantidad de tareas en cola (pestaña “Supervisión” en la IU de Cloud Composer) y, si los picos de este gráfico no disminuyen en aproximadamente dos horas, es probable que las tareas se reprogramen (sin registros) y, luego, se muestre la entrada de registro “Las tareas adoptadas aún estaban pendientes …” en los registros del programador. En esos casos, es posible que veas el mensaje “No se encontró el archivo de registro…” en los registros de tareas de Airflow porque la tarea no se ejecutó.

En general, se espera este comportamiento, y la siguiente instancia de la tarea programada se debe ejecutar según la programación. Si observas muchos casos de este tipo en tus entornos de Cloud Composer, es posible que signifique que no hay suficientes trabajadores de Airflow en tu entorno para procesar todas las tareas programadas.

Resolución: Para resolver este problema, debes asegurarte de que siempre haya capacidad en los trabajadores de Airflow para ejecutar tareas en cola. Por ejemplo, puedes aumentar la cantidad de trabajadores o worker_concurrency. También puedes ajustar el paralelismo o los grupos para evitar que se almacenen en cola tareas más allá de la capacidad que tienes.

De forma esporádica, las tareas inactivas pueden bloquear la ejecución de un DAG específico.

En casos normales, el programador de Airflow debería poder controlar situaciones en las que hay tareas inactivas en la cola y, por algún motivo, no es posible ejecutarlas correctamente (p.ej., se borró un DAG al que pertenecen las tareas inactivas).

Si el programador no borra estas tareas inactivas, es posible que debas borrarlas de forma manual. Puedes hacerlo, por ejemplo, en la IU de Airflow. Puedes navegar a (Menú > Navegador > Instancias de tareas), encontrar tareas en cola que pertenecen a un DAG inactivo y borrarlas.

Para resolver este problema, actualiza tu entorno a la versión 2.1.12 o posterior de Cloud Composer.

Enfoque de Cloud Composer para el parámetro [scheduler]min_file_process_interval

Cloud Composer cambia la forma en que el programador de Airflow usa [scheduler]min_file_process_interval.

Airflow 1

En el caso de Cloud Composer que usa Airflow 1, los usuarios pueden establecer el valor de [scheduler]min_file_process_interval entre 0 y 600 segundos. Los valores superiores a 600 segundos proporcionan los mismos resultados que si [scheduler]min_file_process_interval se establece en 600 segundos.

Airflow 2

En Airflow 2, [scheduler]min_file_process_interval solo se puede usar con las versiones 1.19.9 y 2.0.26 o versiones posteriores.

Versiones de Cloud Composer anteriores a 1.19.9 y 2.0.26

En estas versiones, se ignora

[scheduler]min_file_process_interval.Versiones 1.19.9 o 2.0.26 de Cloud Composer, o versiones posteriores

El programador de Airflow se reinicia después de una cierta cantidad de veces que se programan todos los DAG, y el parámetro

[scheduler]num_runscontrola cuántas veces lo hace el programador. Cuando el programador llega a los bucles de programación de[scheduler]num_runs, se reinicia. El programador es un componente sin estado, y ese reinicio es un mecanismo de reparación automática para cualquier problema que pueda experimentar. Cuando no se especifica, se aplica el valor predeterminado de[scheduler]num_runs, que es 5000.Se puede usar

[scheduler]min_file_process_intervalpara configurar la frecuencia con la que se realiza el análisis de DAG, pero este parámetro no puede ser más largo que el tiempo requerido para que un programador realice bucles[scheduler]num_runscuando programe tus DAG.

Ajusta la configuración de Airflow

Airflow proporciona opciones de configuración que controlan cuántas tareas y DAG de Airflow pueden ejecutarse al mismo tiempo. Para establecer estas opciones de configuración, anula sus valores para tu entorno.

Simultaneidad de los trabajadores

El parámetro

[celery]worker_concurrencycontrola la cantidad máxima de tareas que un trabajador de Airflow puede ejecutar al mismo tiempo. Si multiplicas el valor de este parámetro por la cantidad de trabajadores de Airflow en tu entorno de Cloud Composer, obtendrás la cantidad máxima de tareas que se pueden ejecutar en un momento determinado de tu entorno. Este número está limitado por la opción de configuración[core]parallelismde Airflow, que se describe con más detalle.En los entornos de Cloud Composer 2, el valor predeterminado de

[celery]worker_concurrencyse calcula automáticamente.Para las versiones de Airflow 2.3.3 y posteriores,

[celery]worker_concurrencyse establece en un valor mínimo de 32, 12 × worker_CPU y 8 × worker_memory.Para las versiones de Airflow 2.2.5 o anteriores,

[celery]worker_concurrencyse establece en 12 × cantidad de CPUs de los trabajadores.

Ejecuciones máximas de DAG activas

La opción de configuración

[core]max_active_runs_per_dagde Airflow controla la cantidad máxima de ejecuciones activas del DAG por DAG. El programador no crea más ejecuciones de DAG si alcanza este límite.Si este parámetro se establece de forma incorrecta, puedes encontrar un problema en el que el programador regula la ejecución del DAG porque no puede crear más instancias de ejecución de DAG en un momento determinado.

Cantidad máxima de tareas activas por DAG

La opción de configuración

[core]max_active_tasks_per_dagde Airflow controla la cantidad máxima de instancias de tareas que se pueden ejecutar de forma simultánea en cada DAG. Es un parámetro a nivel del DAG.Si este parámetro se establece de manera incorrecta, es posible que tengas un problema en el que la ejecución de una sola instancia de DAG sea lenta porque solo hay una cantidad limitada de tareas de DAG que se pueden ejecutar en un momento determinado.

Solución: Aumenta

[core]max_active_tasks_per_dag.Paralelismo y tamaño del grupo

La opción de configuración

[core]parallelismde Airflow controla cuántas tareas puede poner en cola el programador de Airflow en la cola del ejecutor después de que se cumplen todas las dependencias para estas tareas.Este es un parámetro global para toda la configuración de Airflow.

Las tareas se ponen en cola y se ejecutan dentro de un grupo. Los entornos de Cloud Composer usan solo un grupo. El tamaño de este grupo controla cuántas tareas puede poner en cola el programador para su ejecución en un momento determinado. Si el tamaño del grupo es demasiado pequeño, el programador no puede poner en cola las tareas para su ejecución a pesar de los límites, que se definen mediante la opción de configuración

[core]parallelismy[celery]worker_concurrencymultiplicada por la cantidad de trabajadores de Airflow, que todavía no se cumplen.Puedes configurar el tamaño del grupo en la IU de Airflow (Menú > Administrador > Grupos). Ajusta el tamaño del grupo al nivel del paralelismo que esperas en tu entorno.

Por lo general,

[core]parallelismse establece como un producto de la cantidad máxima de trabajadores y [celery]worker_concurrency.

El programador no programa los DAG debido a los tiempos de espera del procesador de DAG

Para obtener más información sobre este problema, consulta Solución de problemas de DAG.

Marcar tareas como fallidas después de alcanzar dagrun_timeout

El programador marca las tareas que no están terminadas (en ejecución, programadas y en cola) como fallidas si una ejecución de DAG no finaliza dentro de dagrun_timeout (un parámetro de DAG).

Solución:

Extiende

dagrun_timeoutpara cumplir con el tiempo de espera.(Cloud Composer 2) Aumentar la cantidad de trabajadores o aumentar los parámetros de rendimiento de los trabajadores, para que el DAG se ejecute más rápido.

Síntomas de que la base de datos de Airflow está bajo presión de carga

A veces, en los registros del programador de Airflow, es posible que veas la siguiente entrada de registro de advertencia:

Scheduler heartbeat got an exception: (_mysql_exceptions.OperationalError) (2006, "Lost connection to MySQL server at 'reading initial communication packet', system error: 0")"

También se pueden observar síntomas similares en los registros de los trabajadores de Airflow:

Para MySQL:

(_mysql_exceptions.OperationalError) (2006, "Lost connection to MySQL server at

'reading initial communication packet', system error: 0")"

Para PostgreSQL:

psycopg2.OperationalError: connection to server at ... failed

Estos errores o advertencias pueden ser un síntoma de que la base de datos de Airflow está sobrecargada con la cantidad de conexiones abiertas o la cantidad de consultas que se ejecutan al mismo tiempo, ya sea por programadores o por otros componentes de Airflow, como trabajadores, activadores y servidores web.

Soluciones posibles:

Cómo quitar datos innecesarios de la base de datos de Airflow

Ajusta la escala de la base de datos de Airflow:

- (Cloud Composer 1) Cambia el tipo de máquina de la instancia de Cloud SQL que almacena la base de datos de Airflow de tu entorno.

- (Cloud Composer 2) Ajusta el tamaño de tu entorno.

Reduce la cantidad de programadores. En la mayoría de los casos, uno o dos programadores son suficientes para analizar y programar tareas de Airflow. No se recomienda configurar más de dos programadores, a menos que haya un caso justificado.

Evita usar variables globales en los DAG de Airflow: variables de entorno de Cloud Composer y variables de Airflow.

Establece [scheduler]scheduler-heartbeat-sec en un valor más alto, por ejemplo, en 15 segundos o más.

Establece [scheduler]job-heartbeat-sec en un valor más alto, por ejemplo, 30 segundos o más.

Establece [scheduler]scheduler_health_check_threshold en un valor igual a

[scheduler]job-heartbeat-secmultiplicado por4.

El servidor web muestra la advertencia "Parece que el programador no está ejecutándose".

El programador informa su señal de monitoreo de funcionamiento con regularidad a la base de datos de Airflow. En función de esta información, el servidor web de Airflow determina si el programador está activo.

A veces, si el programador está bajo una carga pesada, es posible que no pueda informar su señal de monitoreo de funcionamiento cada [scheduler]scheduler-heartbeat-sec.

En tal caso, el servidor web de Airflow podría mostrar la siguiente advertencia:

The scheduler does not appear to be running. Last heartbeat was received <X>

seconds ago.

Soluciones posibles:

Aumenta los recursos de CPU y memoria del programador.

Optimiza tus DAG para que su análisis y programación sean más rápidos y no consuman demasiados recursos del programador.

Evita usar variables globales en los DAG de Airflow: variables de entorno de Cloud Composer y variables de Airflow.

Aumenta el valor de [scheduler]scheduler-health-check-threshold para que el servidor web espere más tiempo antes de informar la falta de disponibilidad del programador.

Soluciones alternativas para los problemas que se encuentran durante el reabastecimiento de DAG

A veces, es posible que desees volver a ejecutar DAG que ya se ejecutaron. Puedes hacerlo con la herramienta de línea de comandos de Airflow de la siguiente manera:

Airflow 1

gcloud composer environments run \

ENVIRONMENT_NAME \

--location LOCATION \

backfill -- -B \

-s START_DATE \

-e END_DATE \

DAG_NAME

Para volver a ejecutar solo las tareas fallidas de un DAG específico, usa también el argumento --rerun_failed_tasks.

Airflow 2

gcloud composer environments run \

ENVIRONMENT_NAME \

--location LOCATION \

dags backfill -- -B \

-s START_DATE \

-e END_DATE \

DAG_NAME

Para volver a ejecutar solo las tareas fallidas de un DAG específico, usa también el argumento --rerun-failed-tasks.

Reemplaza lo siguiente:

ENVIRONMENT_NAMEpor el nombre del entorno.LOCATIONpor la región en la que se encuentra el entorno.START_DATEcon un valor para el parámetro DAGstart_date, en el formatoYYYY-MM-DD.END_DATEcon un valor para el parámetro DAGend_date, en el formatoYYYY-MM-DD.DAG_NAMEpor el nombre del DAG.

A veces, la operación de reabastecimiento puede generar una situación de interbloqueo en la que no es posible reabastecer porque hay un bloqueo en una tarea. Por ejemplo:

2022-11-08 21:24:18.198 CET DAG ID Task ID Run ID Try number

2022-11-08 21:24:18.201 CET -------- --------- -------- ------------

2022-11-08 21:24:18.202 CET 2022-11-08 21:24:18.203 CET These tasks are deadlocked:

2022-11-08 21:24:18.203 CET DAG ID Task ID Run ID Try number

2022-11-08 21:24:18.204 CET ----------------------- ----------- ----------------------------------- ------------

2022-11-08 21:24:18.204 CET <DAG name> <Task name> backfill__2022-10-27T00:00:00+00:00 1

2022-11-08 21:24:19.249 CET Command exited with return code 1

...

2022-11-08 21:24:19.348 CET Failed to execute job 627927 for task backfill

En algunos casos, puedes usar las siguientes soluciones alternativas para superar los interbloqueos:

Para inhabilitar el programador en miniatura, anula

[core]schedule-after-task-executionenFalse.Ejecuta reabastecimientos para períodos más estrechos. Por ejemplo, configura

START_DATEyEND_DATEpara especificar un período de solo 1 día.