Menjalankan DAG Apache Airflow di Cloud Composer 1

Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

Panduan memulai ini menunjukkan cara membuat lingkungan Cloud Composer dan menjalankan DAG Apache Airflow di Cloud Composer 1.

Jika Anda baru menggunakan Airflow, lihat tutorial konsep Airflow dalam dokumentasi Apache Airflow untuk mengetahui informasi selengkapnya tentang konsep, objek, dan penggunaan Airflow.

Jika Anda ingin menggunakan Google Cloud CLI, lihat Menjalankan DAG Apache Airflow di Cloud Composer (Google Cloud CLI).

Jika Anda ingin membuat lingkungan menggunakan Terraform, lihat Membuat lingkungan (Terraform).

Sebelum memulai

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the Cloud Composer API.

-

Untuk mendapatkan izin yang Anda perlukan untuk menyelesaikan panduan memulai ini, minta administrator untuk memberi Anda peran IAM berikut di project Anda:

-

Untuk melihat, membuat, dan mengelola lingkungan Cloud Composer:

-

Environment and Storage Object Administrator (

roles/composer.environmentAndStorageObjectAdmin) -

Service Account User (

roles/iam.serviceAccountUser)

-

Environment and Storage Object Administrator (

-

Untuk melihat log:

Logs Viewer (

roles/logging.viewer)

Untuk mengetahui informasi selengkapnya tentang cara memberikan peran, lihat Mengelola akses ke project, folder, dan organisasi.

Anda mungkin juga bisa mendapatkan izin yang diperlukan melalui peran khusus atau peran bawaan lainnya.

-

Untuk melihat, membuat, dan mengelola lingkungan Cloud Composer:

Membuat akun layanan lingkungan

Saat membuat lingkungan, Anda harus menentukan akun layanan. Akun layanan ini disebut akun layanan lingkungan. Lingkungan Anda menggunakan akun layanan ini untuk melakukan sebagian besar operasi.

Akun layanan untuk lingkungan Anda bukan akun pengguna. Akun layanan adalah jenis akun khusus yang digunakan oleh aplikasi atau instance virtual machine (VM), bukan orang.

Untuk membuat akun layanan bagi lingkungan Anda:

Buat akun layanan baru, seperti yang dijelaskan dalam dokumentasi Identity and Access Management.

Berikan peran ke akun tersebut, seperti yang dijelaskan dalam dokumentasi Identity and Access Management. Peran yang diperlukan adalah Pekerja Composer (

composer.worker).

Membuat lingkungan

Di konsol Google Cloud, buka halaman Create environment.

Di kolom Name, masukkan

example-environment.Di menu drop-down Location, pilih region untuk lingkungan Cloud Composer. Panduan ini menggunakan region

us-central1.Untuk opsi konfigurasi lingkungan lainnya, gunakan default yang disediakan.

Klik Create dan tunggu hingga lingkungan dibuat.

Setelah selesai, tanda centang hijau akan ditampilkan di samping nama lingkungan.

Membuat file DAG

DAG Airflow adalah kumpulan tugas terorganisir yang ingin Anda jadwalkan dan jalankan. DAG ditentukan dalam file Python standar.

Panduan ini menggunakan contoh DAG Airflow yang ditentukan dalam file quickstart.py.

Kode Python dalam file ini melakukan hal berikut:

- Membuat DAG,

composer_sample_dag. DAG ini berjalan setiap hari. - Menjalankan satu tugas,

print_dag_run_conf. Tugas ini mencetak konfigurasi eksekusi DAG menggunakan operator bash.

Simpan salinan file quickstart.py di komputer lokal Anda:

Upload file DAG ke bucket lingkungan Anda

Setiap lingkungan Cloud Composer memiliki bucket Cloud Storage yang terkait. Airflow di Cloud Composer hanya menjadwalkan DAG yang berada di folder /dags di bucket ini.

Untuk menjadwalkan DAG, upload quickstart.py dari komputer lokal ke

folder /dags lingkungan Anda:

Di konsol Google Cloud, buka halaman Environments.

Dalam daftar lingkungan, klik nama lingkungan Anda,

example-environment. Halaman Environment details akan terbuka.Klik Buka folder DAG. Halaman Detail bucket akan terbuka.

Klik Upload file, lalu pilih salinan

quickstart.pyAnda.Untuk mengupload file, klik Buka.

Melihat DAG

Setelah Anda mengupload file DAG, Airflow akan melakukan hal berikut:

- Mengurai file DAG yang Anda upload. Mungkin perlu waktu beberapa menit hingga DAG tersedia untuk Airflow.

- Menambahkan DAG ke daftar DAG yang tersedia.

- Menjalankan DAG sesuai dengan jadwal yang Anda berikan dalam file DAG.

Pastikan DAG Anda diproses tanpa error dan tersedia di Airflow dengan melihatnya di UI DAG. UI DAG adalah antarmuka Cloud Composer untuk melihat informasi DAG di konsol Google Cloud. Cloud Composer juga menyediakan akses ke UI Airflow, yang merupakan antarmuka web Airflow native.

Tunggu sekitar lima menit untuk memberi Airflow waktu guna memproses file DAG yang Anda upload sebelumnya, dan menyelesaikan operasi DAG pertama (akan dijelaskan nanti).

Di konsol Google Cloud, buka halaman Environments.

Dalam daftar lingkungan, klik nama lingkungan Anda,

example-environment. Halaman Environment details akan terbuka.Buka tab DAG.

Pastikan DAG

composer_quickstartada dalam daftar DAG.

Gambar 1. Daftar DAG menampilkan DAG composer_quickstart (klik untuk memperbesar)

Melihat detail operasi DAG

Satu eksekusi DAG disebut eksekusi DAG. Airflow segera menjalankan DAG untuk contoh DAG karena tanggal mulai dalam file DAG ditetapkan ke kemarin. Dengan cara ini, Airflow akan mengejar jadwal DAG yang ditentukan.

Contoh DAG berisi satu tugas, print_dag_run_conf, yang menjalankan perintah echo di konsol. Perintah ini menghasilkan informasi meta tentang DAG

(ID numerik DAG run).

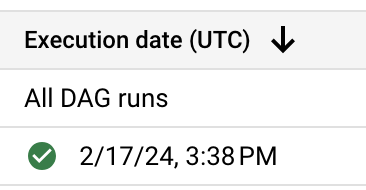

Di tab DAG, klik

composer_quickstart. Tab Runs untuk DAG akan terbuka.Dalam daftar DAG yang berjalan, klik entri pertama.

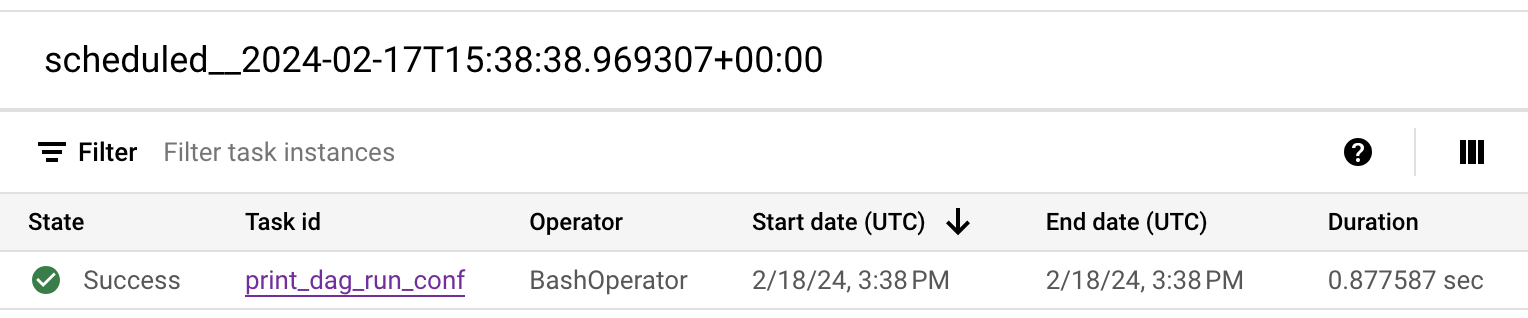

Gambar 2. Daftar DAG yang dijalankan untuk DAG composer_quickstart (klik untuk memperbesar) Detail operasi DAG ditampilkan, yang menjelaskan informasi tentang setiap tugas dari contoh DAG.

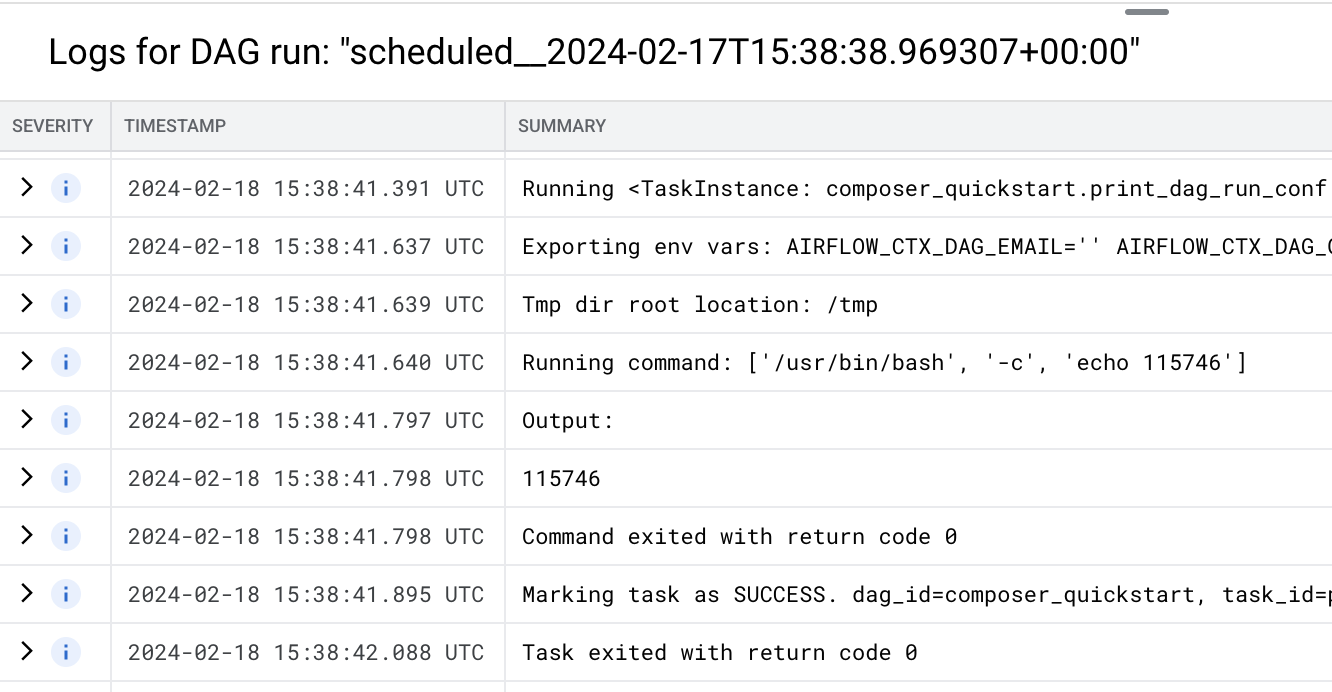

Gambar 3. Daftar tugas yang dieksekusi dalam operasi DAG (klik untuk memperbesar) Bagian Log untuk operasi DAG mencantumkan log untuk semua tugas dalam operasi DAG. Anda dapat melihat output perintah

echodalam log.

Gambar 4. Log tugas print_dag_run_conf (klik untuk memperbesar)

Pembersihan

Agar akun Google Cloud Anda tidak dikenai biaya untuk resource yang digunakan di halaman ini, ikuti langkah-langkah berikut.

Hapus resource yang digunakan dalam tutorial ini:

Hapus lingkungan Cloud Composer:

Di konsol Google Cloud, buka halaman Environments.

Pilih

example-environment, lalu klik Hapus.Tunggu hingga lingkungan dihapus.

Hapus bucket lingkungan Anda. Menghapus lingkungan Cloud Composer tidak akan menghapus bucket-nya.

Di konsol Google Cloud, buka halaman Storage > Browser.

Pilih bucket lingkungan, lalu klik Hapus. Misalnya, bucket ini dapat diberi nama

us-central1-example-environ-c1616fe8-bucket.

Langkah selanjutnya