Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

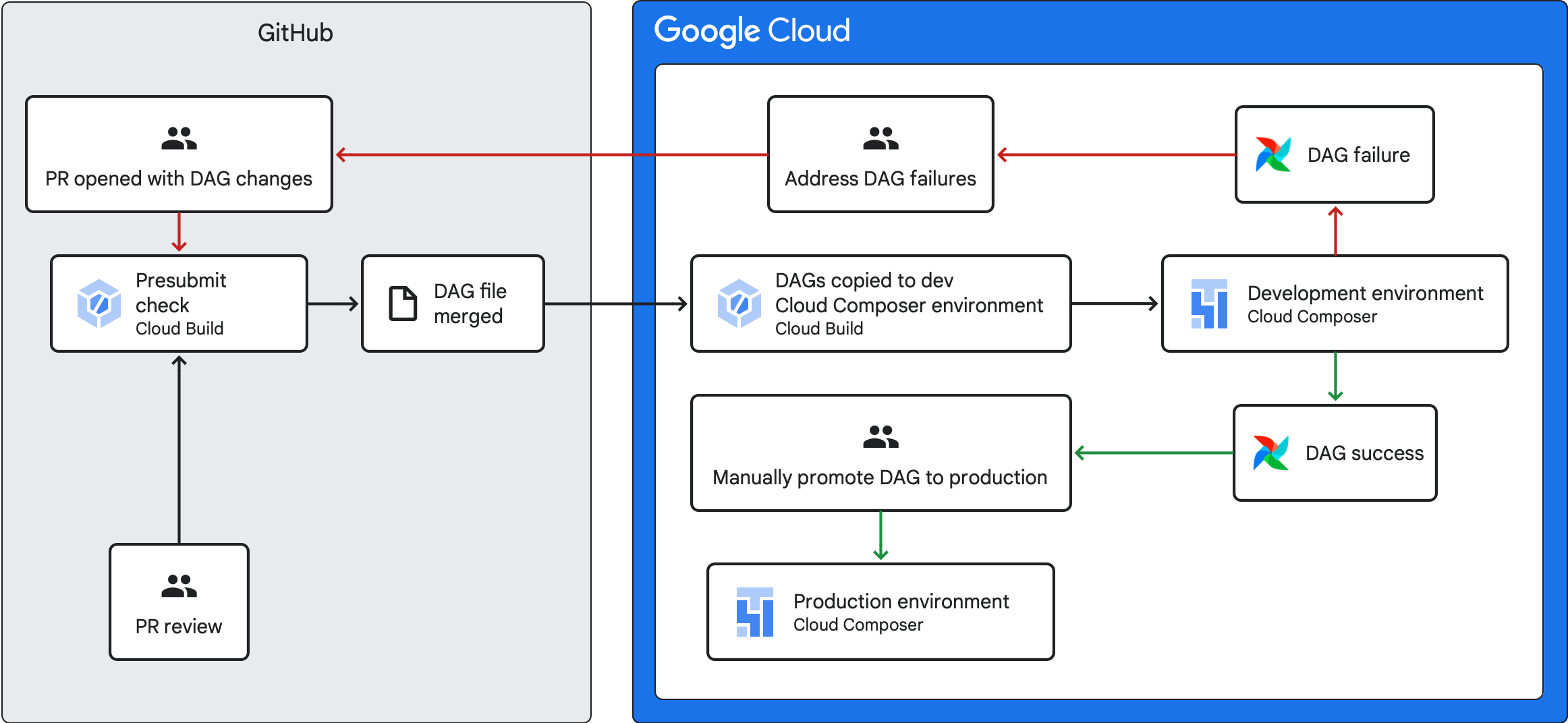

En esta guía, se explica cómo crear una canalización de CI/CD para probar, sincronizar e implementar DAG en tu entorno de Cloud Composer desde tu repositorio de GitHub.

Si solo quieres sincronizar datos de otros servicios, consulta Cómo transferir datos de otros servicios.

Descripción general de la canalización de CI/CD

La canalización de CI/CD que prueba, sincroniza e implementa DAGs tiene los siguientes pasos:

Realizas un cambio en un DAG y lo envías a una rama de desarrollo en tu repositorio.

Abres una solicitud de extracción en la rama principal de tu repositorio.

Cloud Build ejecuta pruebas de unidades para verificar que tu DAG sea válido.

Se aprobó tu solicitud de extracción y se fusionó en la rama principal de tu repositorio.

Cloud Build sincroniza tu entorno de Cloud Composer de desarrollo con estos cambios nuevos.

Verificas que el DAG se comporte como se espera en tu entorno de desarrollo.

Si tu DAG funciona como se espera, súbela a tu entorno de producción de Cloud Composer.

Objetivos

Antes de comenzar

En esta guía, se da por sentado que trabajas con dos entornos de Cloud Composer idénticos: un entorno de desarrollo y un entorno de producción.

A los efectos de esta guía, configurarás una canalización de CI/CD solo para tu entorno de desarrollo. Asegúrate de que el entorno que uses no sea de producción.

En esta guía, se da por sentado que tienes tus DAG y sus pruebas almacenadas en un repositorio de GitHub.

En la canalización de CI/CD de ejemplo, se muestra el contenido de un repositorio de ejemplo. Los DAG y las pruebas se almacenan en el directorio

dags/, con los archivos de requisitos, el archivo de restricciones y los archivos de configuración de Cloud Build almacenados en el nivel superior. La utilidad de sincronización de DAG y sus requisitos se encuentran en el directorioutils.Esta estructura se puede usar para entornos de Airflow 1, Airflow 2, Cloud Composer 1 y Cloud Composer 2.

Crea un trabajo de verificación previa al envío y pruebas de unidades

El primer trabajo de Cloud Build ejecuta una verificación previa al envío, que ejecuta pruebas de unidades para tus DAG.

Cómo agregar pruebas de unidades

Si aún no lo hiciste, crea pruebas de unidades para tus DAG. Guarda estas pruebas junto con los DAG en tu repositorio, cada uno con el sufijo _test. Por ejemplo, el archivo de prueba del DAG en example_dag.py es example_dag_test.py. Estas son las pruebas que se ejecutan como una verificación previa al envío en tu repositorio.

Crea la configuración de YAML de Cloud Build para la verificación previa al envío

En tu repositorio, crea un archivo YAML llamado test-dags.cloudbuild.yaml que configure tu trabajo de Cloud Build para las verificaciones previas al envío. En él, hay tres pasos:

- Instala las dependencias que necesitan tus DAG.

- Instala las dependencias que necesitan tus pruebas de unidades.

- Ejecuta las pruebas de DAG.

Crea el activador de Cloud Build para la verificación previa al envío

Sigue las instrucciones de la guía Cómo compilar repositorios desde GitHub para crear un activador basado en la app de GitHub con la siguiente configuración:

Nombre:

test-dagsEvento: Solicitud de extracción

Fuente: Repositorio: Elige tu repositorio.

Fuente: Rama base:

^main$(cambiamainal nombre de la rama base de tu repositorio, si es necesario)Fuente: Control de comentarios: no es obligatorio

Configuración de compilación: Archivo de configuración de Cloud Build:

/test-dags.cloudbuild.yaml(la ruta de acceso al archivo de compilación)

Crea un trabajo de sincronización de DAG y agrega una secuencia de comandos de utilidad de DAG

A continuación, configura un trabajo de Cloud Build que ejecute una secuencia de comandos de utilidad de DAGs. La secuencia de comandos de utilidad de esta tarea sincroniza tus DAG con tu entorno de Cloud Composer después de que se combinan con la rama principal de tu repositorio.

Agrega la secuencia de comandos de utilidad de DAG

Agrega la secuencia de comandos de utilidad de DAG a tu repositorio. Esta secuencia de comandos de utilidad copia todos los archivos DAG del directorio dags/ de tu

repositorio en un directorio temporal y omite todos los archivos Python que no sean DAG. Luego, la secuencia de comandos usa la biblioteca cliente de Cloud Storage para subir todos los archivos de ese directorio temporal al directorio dags/ en el bucket de tu entorno de Cloud Composer.

Crea una configuración YAML de Cloud Build para sincronizar DAG

En tu repositorio, crea un archivo YAML llamado add-dags-to-composer.cloudbuild.yaml que configure tu trabajo de Cloud Build para sincronizar DAG. En él, hay dos pasos:

Instala las dependencias que necesita la secuencia de comandos de la utilidad de DAG.

Ejecuta la secuencia de comandos de utilidad para sincronizar los DAG de tu repositorio con tu entorno de Cloud Composer.

Crea el activador de Cloud Build

Sigue las instrucciones de la guía Cómo compilar repositorios desde GitHub para crear un activador basado en la app de GitHub con la siguiente configuración:

Nombre:

add-dags-to-composerEvento: Enviar a una rama

Fuente: Repositorio: Elige tu repositorio.

Fuente: Rama base:

^main$(cambiamainal nombre de la rama base de tu repositorio, si es necesario)Fuente: Filtro de archivos incluidos (GLOB):

dags/**Configuración de compilación: Archivo de configuración de Cloud Build:

/add-dags-to-composer.cloudbuild.yaml(la ruta de acceso al archivo de compilación)

En la configuración avanzada, agrega dos variables de sustitución:

_DAGS_DIRECTORY: Es el directorio en el que se encuentran los DAG en tu repositorio. Si usas el repositorio de ejemplo de esta guía, esdags/._DAGS_BUCKET: Es el bucket de Cloud Storage que contiene el directoriodags/en tu entorno de Cloud Composer de desarrollo. Omite el prefijogs://. Por ejemplo:us-central1-example-env-1234ab56-bucket

Prueba tu canalización de CI/CD

En esta sección, sigue un flujo de desarrollo de DAG que usa los activadores de Cloud Build que creaste recientemente.

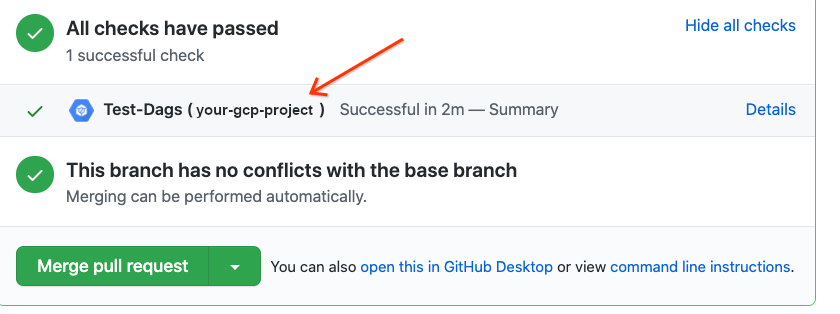

Ejecuta un trabajo previo al envío

Crea una solicitud de extracción en tu rama principal para probar la compilación. Busca la verificación previa al envío en la página. Haz clic en Detalles y elige Ver más detalles en Google Cloud Build para ver los registros de compilación en la consola de Google Cloud.

Si la verificación previa al envío falló, consulta Cómo abordar las fallas de compilación.

Valida que tu DAG funcione en tu entorno de Cloud Composer de desarrollo

Una vez que se apruebe la solicitud de extracción, combínala con la rama principal. Usa la

consola de Google Cloud para

ver los resultados de la compilación. Si tienes muchos

activadores de Cloud Build, puedes filtrar tus compilaciones según el nombre del activador

add-dags-to-composer.

Una vez que se complete correctamente la tarea de sincronización de Cloud Build, el DAG sincronizado aparecerá en tu entorno de Cloud Composer de desarrollo. Allí, puedes confirmar que el DAG funciona como se espera.

Agrega el DAG a tu entorno de producción

Una vez que el DAG funcione según lo esperado, agrégalo de forma manual a tu entorno de producción. Para ello, sube el archivo DAG al directorio dags/ en el bucket de tu entorno de Cloud Composer de producción.

Si tu trabajo de sincronización de DAG falló o si tu DAG no se comporta como se espera en tu entorno de Cloud Composer de desarrollo, consulta Cómo abordar las fallas de compilación.

Cómo abordar las fallas de compilación

En esta sección, se explica cómo abordar situaciones comunes de fallas de compilación.

¿Qué sucede si mi verificación previa al envío falla?

En tu solicitud de extracción, haz clic en Detalles y elige Ver más detalles en Google Cloud Build para ver los registros de compilación en la consola de Google Cloud. Usa estos registros para depurar el problema con tu DAG. Una vez que hayas resuelto los problemas, confirma la corrección y envíala a tu rama. La verificación previa al envío se vuelve a ejecutar, y puedes seguir iterando con los registros como herramienta de depuración.

¿Qué sucede si mi trabajo de sincronización de DAG falla?

Usa la consola de Google Cloud para

ver los resultados de la compilación. Si tienes muchos

activadores de Cloud Build, puedes filtrar tus compilaciones según el nombre del activador

add-dags-to-composer. Examina los registros del trabajo de compilación y resuelve los errores. Si necesitas ayuda adicional para resolver los errores, usa los canales de asistencia.

¿Qué sucede si mi DAG no funciona correctamente en mi entorno de Cloud Composer?

Si tu DAG no funciona como se espera en tu entorno de Cloud Composer de desarrollo, no lo promociones manualmente a tu entorno de Cloud Composer de producción. Como alternativa, toma una de las siguientes medidas:

- Reverte la solicitud de extracción con los cambios que rompieron tu DAG para restablecerlo al estado que tenía inmediatamente antes de realizar los cambios (esto también revertirá todos los demás archivos de esa solicitud de extracción).

- Crea una nueva solicitud de extracción para revertir manualmente los cambios en el DAG dañado.

- Crea una nueva solicitud de extracción para corregir los errores en tu DAG.

Si sigues cualquiera de estos pasos, se activará una nueva verificación previa al envío y, después de la combinación, el trabajo de sincronización de DAG.