Cloud Composer 3 | Cloud Composer 2 | Cloud Composer 1

本页面列出了 Cloud Composer 的已知问题。如需了解问题修复信息,请参阅版本说明。

对于上传的 DAG 文件,首次运行 DAG 时有几个失败的任务

当您上传某个 DAG 文件时,有时针对该文件的首次 DAG 运行的前几个任务会失败,并显示 Unable to read remote log... 错误。出现此问题的原因是 DAG 文件在环境的存储分区、Airflow 工作器和环境的 Airflow 调度器之间同步。如果调度器获取 DAG 文件并安排其由工作器执行,并且工作器还没有 DAG 文件,则任务执行将失败。

为了缓解此问题,默认情况下,Airflow 2 环境配置为对失败的任务执行两次重试。如果任务失败,系统会按 5 分钟的时间间隔重试任务两次。

Cloud Composer 不应受 Apache Log4j 2 漏洞 (CVE-2021-44228) 影响

针对 Apache Log4j 2 漏洞 (CVE-2021-44228),Cloud Composer 开展了详细调查,我们认为 Cloud Composer 不会受到此漏洞的影响。

更改插件后,Airflow 界面有时有时不重新加载插件

如果插件包含多个会导入其他模块的文件,则 Airflow 界面可能无法识别应该重新加载插件的情况。在这种情况下,请重启环境的 Airflow Web 服务器。

访问 Airflow 界面时出现 504 错误

访问 Airflow 界面时,您可能会遇到 504 Gateway Timeout 错误。此错误可能有多种原因:

暂时性通信问题。在这种情况下,请稍后尝试访问 Airflow 界面。您还可以重启 Airflow Web 服务器。

(仅限 Cloud Composer 3)连接问题。如果 Airflow 界面始终无法访问,并且生成了超时或 504 错误,请确保您的环境可以访问

*.composer.googleusercontent.com。(仅限 Cloud Composer 2)连接问题。如果 Airflow 界面始终无法访问,并且生成了超时或 504 错误,请确保您的环境可以访问

*.composer.cloud.google.com。如果您使用专用 Google 访问通道并通过private.googleapis.com虚拟 IP 发送流量,或者使用 VPC Service Controls 并通过restricted.googleapis.com虚拟 IP 发送流量,请确保您的 Cloud DNS 也针对*.composer.cloud.google.com域名进行了配置。Airflow Web 服务器无响应。如果 504 错误仍然存在,但您仍然可以在某些时间访问 Airflow 界面,则可能是 Airflow Web 服务器因过载而无响应。尝试增加 Web 服务器的规模和性能参数。

访问 Airflow 界面时出现 502 错误

错误 502 Internal server exception 表示 Airflow 界面无法处理传入的请求。此错误可能有多种原因:

暂时性通信问题。请稍后尝试访问 Airflow 界面。

无法启动 Web 服务器。若要开始,Web 服务器需要先同步配置文件。检查 Web 服务器日志,看看是否存在类似于

GCS sync exited with 1: gcloud storage cp gs://<bucket-name>/airflow.cfg /home/airflow/gcs/airflow.cfg.tmp或GCS sync exited with 1: gcloud storage cp gs://<bucket-name>/env_var.json.cfg /home/airflow/gcs/env_var.json.tmp的日志条目。如果您看到这些错误,请检查错误消息中提及的文件是否仍存在于环境的存储桶中。如果这些备份被意外移除(例如,由于配置了保留政策),您可以恢复它们:

在您的环境中设置新的环境变量。您可以使用任何变量名称和值。

替换 Airflow 配置选项。您可以使用不存在的 Airflow 配置选项。

在树状视图中将鼠标悬停在任务实例上时,系统会抛出未捕获的 TypeError

在 Airflow 2 中,使用非默认时区时,Airflow 界面中的树状视图有时可能无法正常运行。如需解决此问题,请在 Airflow 界面中明确配置时区。

调度器和工作器中的空文件夹

Cloud Composer 不会主动从 Airflow 工作器和调度器中移除空文件夹。当这些文件夹存在于存储桶中并最终被移除时,环境存储桶同步过程可能会创建此类实体。

建议:调整您的 DAG,使其能够跳过此类空文件夹。

当 Airflow 调度器和工作器重启时(例如,由于环境集群中的缩减或维护操作),此类实体最终会从这些组件的本地存储空间中移除。

支持 Kerberos

Cloud Composer 不支持 Airflow Kerberos 配置。

Cloud Composer 2 和 Cloud Composer 3 中的计算类支持

Cloud Composer 3 和 Cloud Composer 2 仅支持通用型 计算类。这意味着无法运行请求其他计算类(例如均衡或横向扩展)的 Pod。

通用类允许运行请求最多 110 GB 内存和最多 30 个 CPU 的 Pod(如计算类最大请求中所述)。

如果您想使用基于 ARM 的架构或需要更多 CPU 和内存,则必须使用其他计算类,但 Cloud Composer 3 和 Cloud Composer 2 集群不支持这些计算类。

建议:使用 GKEStartPodOperator 在支持所选计算类的其他集群上运行 Kubernetes Pod。如果您运行需要其他计算类的自定义 Pod,则这些 Pod 也必须在非 Cloud Composer 集群上运行。

无法减少 Cloud SQL 存储空间

Cloud Composer 使用 Cloud SQL 运行 Airflow 数据库。随着时间的推移,Cloud SQL 实例的磁盘存储空间可能会增加,因为当 Airflow 数据库增长时,磁盘会扩容以适应 Cloud SQL 操作存储的数据。

无法缩减 Cloud SQL 磁盘大小。

作为一种解决方法,如果您想使用最小的 Cloud SQL 磁盘大小,可以重新创建具有快照的 Cloud Composer 环境。

从 Cloud SQL 中移除记录后,数据库磁盘使用率指标未减少

关系型数据库(例如 Postgres 或 MySQL)在删除或更新行时,不会实际移除这些行。而是将它们标记为“死元组”,以保持数据一致性并避免阻塞并发事务。

MySQL 和 Postgres 都实现了在删除记录后回收空间的机制。

虽然可以强制数据库回收未使用的磁盘空间,但这是一项非常消耗资源的操作,并且还会锁定数据库,导致 Cloud Composer 无法使用。因此,建议依靠构建机制来回收未使用的空间。

禁止访问:发生了授权错误

如果此问题影响了用户,则访问权限遭拒:授权错误对话框会包含 Error 400: admin_policy_enforced 消息。

如果 Google Workspace 中启用了 API 控制 > 未配置的第三方应用 > 不允许用户访问任何第三方应用选项,并且未明确允许 Cloud Composer 中的 Apache Airflow 应用,则用户无法访问 Airflow 界面,除非他们明确允许该应用。

如需允许访问,请执行允许在 Google Workspace 中访问 Airflow 界面中提供的步骤。

访问 Airflow 界面时出现登录循环

此问题可能由以下原因引起:

如果 Chrome Enterprise 进阶版情境感知访问权限绑定与依赖于设备属性的访问权限级别搭配使用,并且 Cloud Composer 中的 Apache Airflow 应用未获得豁免,则由于登录循环,无法访问 Airflow 界面。如需允许访问,请执行在情境感知访问权限绑定中允许访问 Airflow 界面中提供的步骤。

如果保护项目的 VPC Service Controls 边界中配置了入站流量规则,并且允许访问 Cloud Composer 服务的入站流量规则使用

ANY_SERVICE_ACCOUNT或ANY_USER_ACCOUNT身份类型,则用户无法访问 Airflow 界面,最终陷入登录循环。如需详细了解如何解决此问题,请参阅在 VPC Service Controls 入站规则中允许访问 Airflow 界面。

/data 文件夹在 Airflow Web 服务器中不可用

在 Cloud Composer 2 和 Cloud Composer 3 中,Airflow Web 服务器主要是一个只读组件,Cloud Composer 不会将 data/ 文件夹同步到此组件。

有时,您可能需要在所有 Airflow 组件(包括 Airflow Web 服务器)之间共享通用文件。

解决方案:

将要与 Web 服务器共享的文件封装到 PYPI 模块中,并将其作为常规 PYPI 软件包进行安装。在环境中安装 PYPI 模块后,这些文件会添加到 Airflow 组件的映像中,并可供这些组件使用。

将文件添加到

plugins/文件夹。此文件夹会同步到 Airflow Web 服务器。

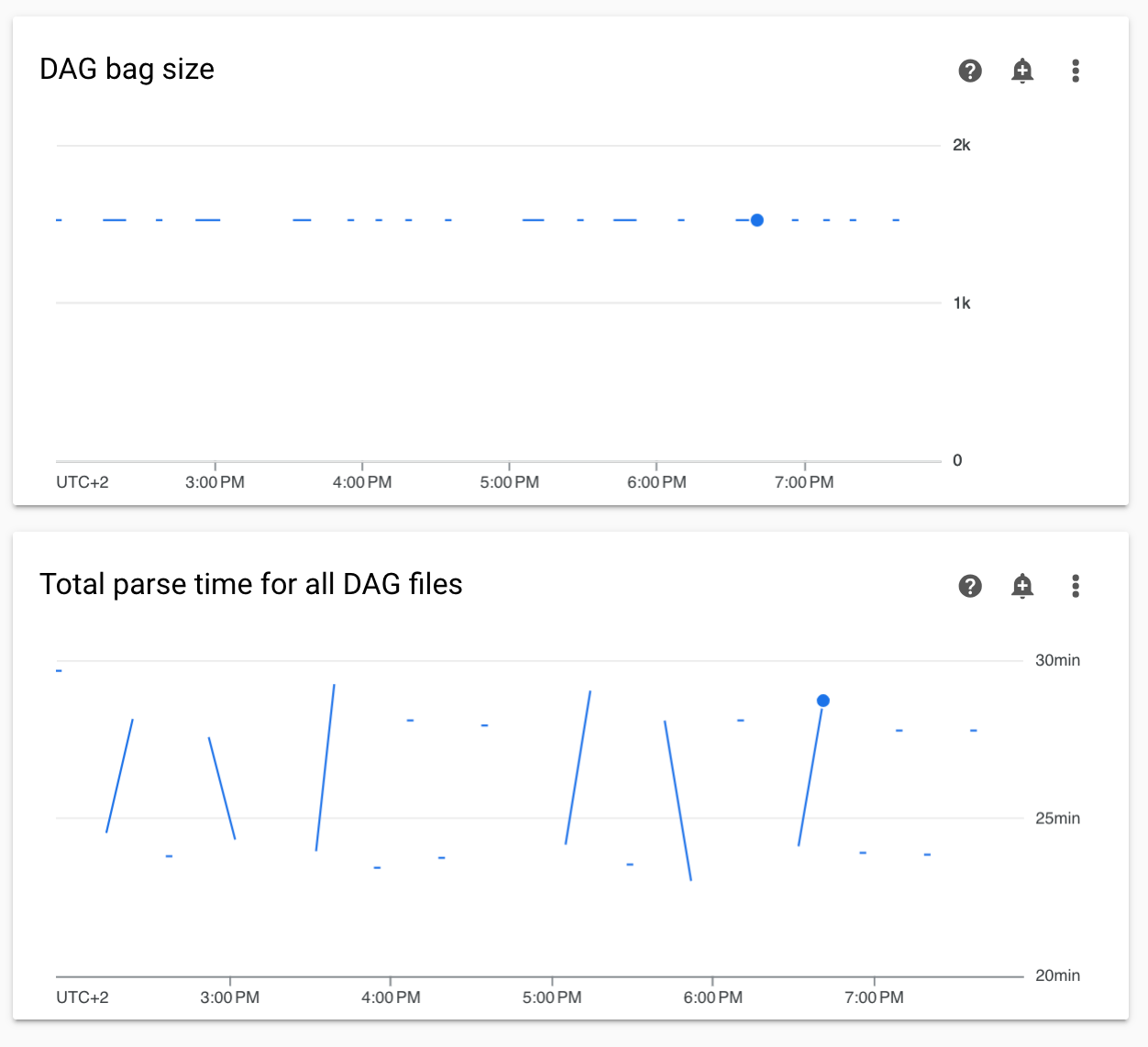

监控中的非连续 DAG 解析时间和 DAG 包大小图表

监控信息中心上的非连续 DAG 解析时间和 DAG 包大小图表表明 DAG 解析时间过长(超过 5 分钟)存在问题。

解决方案:建议将总 DAG 解析时间保持在 5 分钟以内。如需缩短 DAG 解析时间,请遵循 DAG 编写指南。

任务日志延迟显示

具体情况:

- 在 Cloud Composer 3 中,Airflow 任务日志不会立即显示,而是会延迟几分钟。

- 您可能会在 Airflow 日志中看到

Logs not found for Cloud Logging filter消息

原因:

如果您的环境同时运行大量任务,任务日志可能会延迟,因为环境的基础设施规模不足以快速处理所有日志。

解决方案:

- 考虑增加环境的基础设施规模以提高性能。

- 随时间推移分布 DAG 运行,以便任务不会同时执行。

KubernetesPodOperator 和 KubernetesExecutor 的启动时间增加

使用 KubernetesPodOperator 创建的 Pod 和使用 KubernetesExecutor 执行的任务的启动时间有所增加。Cloud Composer 团队正在努力寻找解决方案,并会在问题解决后发布公告。

解决方法:

- 启动具有更多 CPU 的 Pod。

- 如果可能,请优化图片(减少图层、缩小尺寸)。

在项目的结算账号被删除或停用,或者 Cloud Composer API 被停用后,环境处于 ERROR 状态

受这些问题影响的 Cloud Composer 环境无法恢复:

- 项目结算账号被删除或停用后,即使后来关联了其他账号也是如此。

- 在项目中停用 Cloud Composer API 后,即使后来又启用了该 API,也会出现此问题。

您可以执行以下操作来解决此问题:

您仍然可以访问存储在环境存储分区中的数据,但环境本身不再可用。您可以创建新的 Cloud Composer 环境,然后转移 DAG 和数据。

如果您想执行任何会导致环境无法恢复的操作,请务必备份数据,例如创建环境的快照。这样一来,您就可以创建另一个环境,并通过加载此快照来转移其数据。

如果 [core]execute_tasks_new_python_interpreter 设置为 True,则不会收集 Airflow 任务的日志

如果 [core]execute_tasks_new_python_interpreter Airflow 配置选项设置为 True,Cloud Composer 将不会收集 Airflow 任务的日志。

可能的解决方法:

- 移除此配置选项的替换值,或将其值设置为

False。

删除环境时移除网络附件时出错

如果同时删除多个共享同一网络连接的环境,部分删除操作会失败并报错。

症状:

系统会生成以下错误:

Got error while removing Network Attachment: <error code>

报告的错误代码可以是 Bad request: <resource> is not ready 或 Precondition failed: Invalid fingerprint。

可能的解决方法:

逐个删除使用相同网络连接的环境。

在删除环境之前,请先停用与 VPC 网络的连接。我们建议使用此解决方法来自动删除环境。