Google Cloud 탐색: 데이터 및 분석 워크로드를 위한 의사결정 트리

Priyanka Vergadia

Staff Developer Advocate, Google Cloud

Alicia Williams

Developer Advocate, Google Cloud

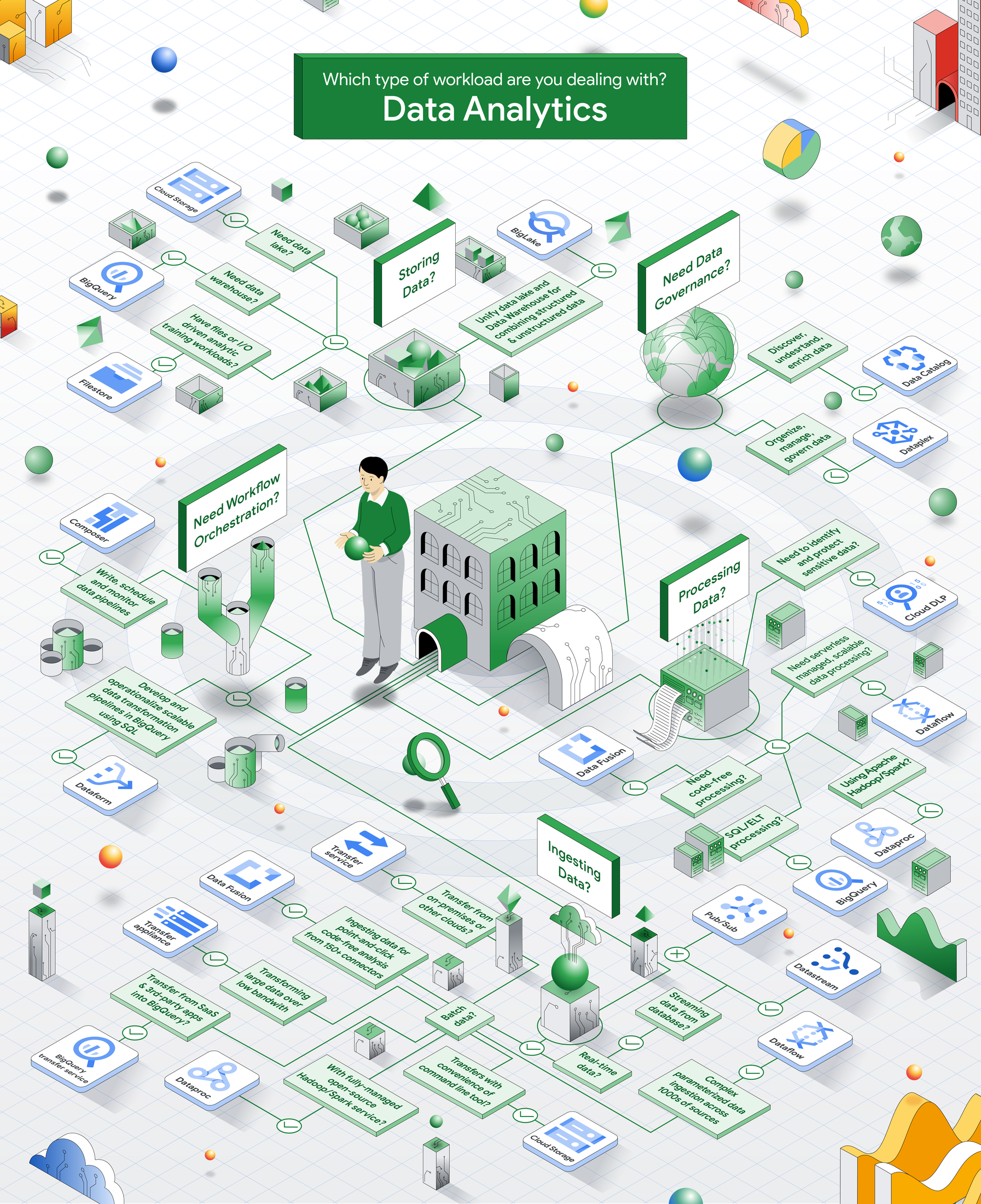

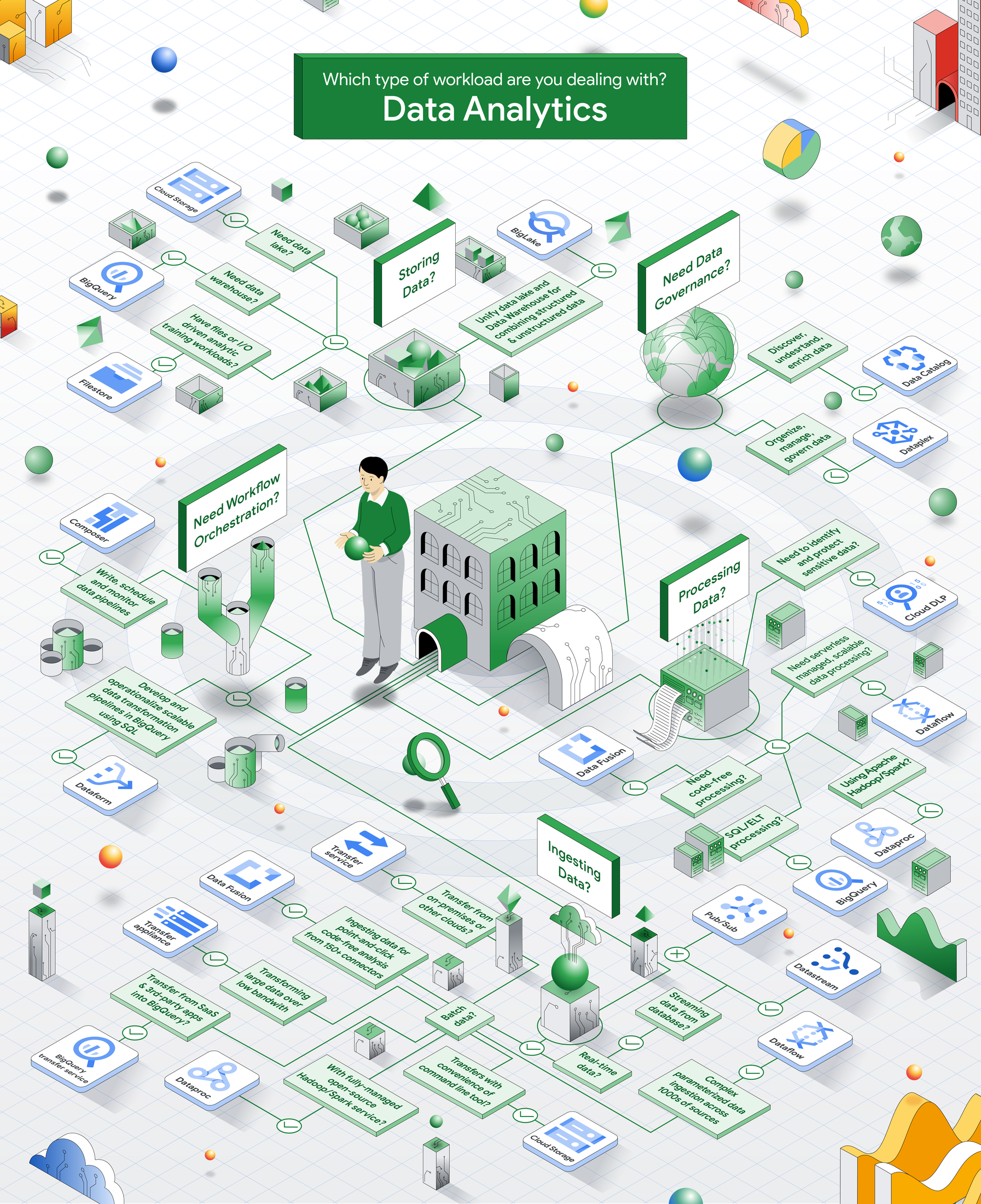

데이터 및 분석 워크로드의 실행을 지원하는 Google Cloud의 서비스가 워낙 광범위하다 보니, 특정 사용 사례에 적합한 도구를 선택하려면 많은 정보를 살펴봐야 할 수 있습니다. 워크로드마다 데이터 수집 및 처리에서부터 저장, 거버넌스, 오케스트레이션에 이르기까지 각기 고유한 서비스 모음이 필요합니다. 이 의사결정 프로세스를 간소화하기 위해 Google이 개발한 유용한 의사결정 트리를 소개합니다. 이 의사결정 트리는 사용자의 구체적인 니즈를 기반으로 최선의 서비스를 연구하고 선택하는 데 도움이 되는 로드맵을 제공합니다.

이 게시글에서는 각 워크로드 영역을 세부적으로 살펴보면서 적합한 Google Cloud 서비스를 선택하는 방법을 알아보겠습니다.

데이터 수집

모든 데이터 및 분석 워크플로의 첫 단계는 데이터를 시스템으로 가져오는 것입니다. 데이터 수집은 마이그레이션에 따른 첫 번째 대량 로드가 될 수도 있고, 일단 워크로드가 가동되기 시작하면 정기적인 수집이 더 필요할 수도 있습니다. 수집하는 데이터의 유형과 출처에 따라 사용해야 하는 서비스도 달라질 수 있습니다.

실시간 데이터 수집의 경우 선택할 수 있는 몇 가지 옵션이 있습니다.

- 데이터스트림: 운영 데이터베이스에서 데이터를 가져오고 있다면, 서버리스 실시간 수집 서비스인 데이터 스트림을 살펴보세요. 운영 데이터베이스나 다른 시스템에 큰 영향을 주지 않는 변경된 데이터 캡처(CDC)를 사용하여 BigQuery에 데이터를 안정적으로 복제하고 스트리밍 및 운영 분석을 가능하게 합니다. 고급 변환 기능을 갖춘 사용자 지정 워크플로를 구축하기 위해 Dataflow 템플릿 및 Data Fusion과 통합됩니다.

- Pub/Sub은 데이터가 도착하는 대로 처리하고 분석해야 하는 경우 이상적인 선택입니다. Pub/Sub은 완전 관리형 메시징 서비스로, 실시간 데이터 수집에 적합하게 설계되었으며 BigQuery를 포함한 Google의 데이터 처리 서비스에 바로 통합됩니다.

일괄 데이터 수집의 경우 다음과 같은 여러 옵션 중에서 선택할 수 있습니다.

- Cloud Storage: Google Cloud로 데이터를 가져오는 매우 편리한 방법 중 하나는 객체 스토리지 버킷을 사용하는 것입니다. 명령줄 도구인 gsutil을 사용하면 클라이언트 또는 다른 버킷에서 Cloud Storage 버킷으로의 데이터 이동을 최적화하면서 병렬 처리 수준을 극대화할 수 있습니다.

- Storage Transfer Service: 온프레미스 또는 다른 클라우드에서 대량의 데이터를 전송하는 경우에는 Storage Transfer Service를 사용할 수 있습니다.

- Transfer Appliance: 대량의 온프레미스 데이터를 낮은 대역폭에서 전송해야 하는 경우 Transfer Appliance는 고객이 Google Cloud로 보낸 실제 기기를 사용하여 더 안전하고 효율적인 옵션을 제공합니다.

- BigQuery Transfer Service: SaaS 또는 서드 파티 앱의 데이터를 BigQuery 데이터 웨어하우스로 수집하는 경우 BigQuery Transfer Service를 사용할 수 있습니다. 이 서비스는 일반적인 데이터 소스를 위해 사전 구축된 커넥터뿐 아니라 스케줄링, 모니터링 및 관리 기능을 제공합니다.

- Dataflow: Dataflow를 사용하면 포괄적인 데이터 처리 서비스의 일부로 수천 개의 소스 전반에 걸쳐 대규모의 복잡하고 매개변수화된 데이터 수집을 안정적으로 관리할 수 있습니다.

- Dataproc: 100% 오픈소스의 완전 관리형 Hadoop/Spark 서비스인 Dataproc을 사용할 수도 있습니다. Dataproc을 사용하면 온프레미스 또는 다른 클라우드의 데이터를 Dataproc Serverless 기반의 즉시 사용할 수 있는 구성 가능한 템플릿을 통해 수집할 수 있습니다.

- Data Fusion: Data Fusion을 사용하면 150개 이상의 커넥터를 통해 포인트 앤 클릭 인터페이스로 일괄 데이터를 수집할 수 있습니다(코딩 없는 분석도 가능).

데이터 처리

원시 데이터를 수집했다면 실제로 사용할 수 있는 형태로 이 데이터를 처리해야 할 수 있습니다. 데이터 처리에는 데이터의 접근성을 높이고 데이터를 체계화하며 쉽게 이해할 수 있도록 하기 위해 데이터를 정제, 필터링, 집계, 변환하는 등의 활동이 포함될 수 있습니다. 여기에 사용할 구체적인 Google Cloud 도구는 데이터 레이크, 데이터베이스, 데이터 웨어하우스에 저장할 데이터를 어디에서, 어떻게 처리하고자 하는지에 따라 달라집니다.

- Dataflow: Apache Beam 및 Java, Python, Go와 같은 프로그래밍 언어를 사용해 일괄 데이터 및 스트리밍 데이터를 처리하기 적합한 완전 관리형의 확장 가능하고 안정적인 서버리스 서비스가 필요하다면 Dataflow를 선택하세요.

- Dataproc: Apache Hadoop/Spark 워크로드의 경우 Dataproc을 사용하면 Delta, Iceberg, Hudi 등의 테이블 형식을 포함해 다양한 파일 형식으로 저장된 방대한 양의 데이터를 처리할 수 있습니다.

- Data Fusion: 코딩 없이 처리해야 할 경우에는 다양한 변환 작업을 지원하는 Data Fusion을 사용할 수 있습니다.

- BigQuery: SQL 기반 ELT 처리로 관리할 수 있는 워크로드의 경우 확장성이 높고 비용 효율적인 서버리스 클라우드 데이터 웨어하우스인 BigQuery를 사용하면 가격 대비 높은 성능의 혜택을 누릴 수 있습니다.

- Cloud Data Loss Prevention: Cloud DLP는 민감한 정보를 발견, 분류, 보호하는 데 유용한 완전 관리형 서비스입니다. 이 도구는 데이터 처리 파이프라인에 포함되어 마이그레이션, 데이터 워크로드, 실시간 데이터 수집 및 처리 과정에서 익명화로 배포할 수 있습니다.

Data Storage

이제 데이터를 안전하고 효율적으로 저장하여 비즈니스 인텔리전스 또는 머신러닝과 같은 다운스트림 애플리케이션에서 쉽게 액세스하고, 분석하며, 사용할 수 있도록 해야 합니다. Google Cloud에 데이터를 저장하는 데는 여러 옵션이 있으므로 선택 시 구체적인 서비스는 사용 환경에 따라 달라집니다. 다음은 데이터 및 분석 워크로드를 위한 스토리지에 초점을 둔 몇 가지 예시입니다.

- Cloud Storage: Cloud Storage는 데이터 레이크 스토리지를 위한 좋은 출발점입니다. 확장 가능하고 내구성이 높은 고가용성 객체 스토리지 서비스로서 정형, 반정형 및 비정형 데이터를 포함해 다양한 데이터를 저장하는 데 사용됩니다. 이중 리전 스토리지를 통해 지연 시간이 짧은 중복성을 제공하고, 수동 복제가 필요 없으며, 필요한 경우 장애 조치를 관리합니다.

- BigQuery: 정형 또는 반정형(네이티브 JSON 유형, 중첩 필드) 데이터의 경우 BigQuery에 저장하고 굉장히 빠른 SQL 분석을 수행할 수 있습니다.

- Filestore: 사용 사례에 특별히 높은 성능과 짧은 지연 시간이 필요한 경우(예를 들어 I/O 기반 분석 학습 워크로드) Filestore를 사용하는 것이 좋습니다.

데이터가 BigQuery, Cloud Storage는 물론 다른 클라우드에 걸쳐 다양한 위치에 저장될 수 있으므로 BigLake를 사용하여 이를 통합하고 액세스 가능하도록 하는 것이 중요합니다. BigLake는 데이터 액세스 엔진으로서 여러 데이터 레이크와 데이터 웨어하우스에 걸쳐 데이터를 통합, 관리 및 분석할 수 있도록 해줍니다. 향상된 성능을 제공하며 수준 높은 거버넌스와 열(column) 과 행(row) 기반의 보안을 제공합니다.

거버넌스

기업에서 데이터가 정확하고 일관성이 있으며 보호를 받고 규정을 준수하도록 보장하기 위해 데이터 관리에 대한 가이드라인과 권장사항을 수립하는 것이 점점 더 중요해지고 있습니다. 데이터 거버넌스에는 데이터 카탈로그 작성, 데이터 계보 관리, 데이터 품질 관리, PII 식별, 데이터 액세스 제어와 같은 활동이 포함될 수 있습니다.

Dataplex는 이러한 작업에 유용하며 Google Cloud 및 그 외의 데이터 레이크, 데이터 웨어하우스 및 데이터 마트 전반에 걸쳐 중앙 집중화된 거버넌스를 지원합니다. Dataplex 내에서 완전 관리형 메타데이터 저장소인Data Catalog를 사용하여 데이터를 발견 및 파악하고 보강할 수 있습니다.

또한 Google Cloud 제품 내에 거버넌스 관련 기능이 내장되어 있습니다. 예를 들어 BigQuery는 고객 관리 암호화 키(CMEK)와 열 및 행 수준의 보안을 지원합니다. 이 기능은 BigLake 테이블을 통해 객체 스토리지로 확장됩니다.

오케스트레이션

마지막으로, 오케스트레이션을 통해 워크플로의 다양한 구성요소를 조율 및 관리할 수 있습니다. 오케스트레이션에는 파이프라인 정의, 데이터 처리 작업 스케줄링, 데이터가 적시에 효율적으로 처리되는지 확인하기 위한 데이터 파이프라인 모니터링이 포함될 수 있습니다.

Google Cloud는 다음과 같은 두 가지 오케스트레이션 서비스를 제공합니다

- Composer: 위에 언급된 데이터 처리 옵션과 통합되는 이 완전 관리형 Airflow 서비스를 사용하여 데이터 파이프라인을 작성, 스케줄링 및 모니터링할 수 있습니다.

- Dataform: SQL을 사용하여 ETL/ELT 데이터 파이프라인을 구축 및 관리하려는 경우 Dataform을 통해 BigQuery에서 확장 가능한 데이터 변환 파이프라인을 개발하고 운용할 수 있습니다.

데이터 사용

데이터 워크플로가 준비되면 이제 언제든 원하는 곳으로 데이터를 가져갈 수 있습니다.

- 빠른 SQL 분석을 수행하려면 BigQuery로 이동하세요.

- 데이터 이동 없이 데이터 및 인사이트를 대규모로 안전하게 공유하려면 Analytics Hub를 사용하세요.

- 보고를 위해 데이터를 시각화하거나 대시보드를 만들고자 한다면 Looker Studio가 강력하고 직관적인 BI 도구입니다.

- 데이터를 사용해 커스텀 머신러닝 모델을 개발하려는 경우라면 Vertex AI를 통해 머신러닝 워크플로를 엔드 투 엔드로 통합하세요.

다음 단계

데이터 및 분석 워크플로는 다양한 소스의 데이터 수집에서부터 데이터의 처리, 저장, 거버넌스, 오케스트레이션 및 공유에 이르기까지 여러 단계로 구성됩니다. Google은 여러분이 니즈에 맞는 도구와 기술을 최대한 쉽게 찾을 수 있도록 돕고자 합니다. 앞으로 다른 클라우드 워크로드에 대해서도 더 많은 의사결정 트리를 게시할 예정이니, 이 의사결정 트리를 북마크에 추가하고 계속 지켜봐 주시기 바랍니다.

Cloud Analytics Discord 채널을 방문하여 이 게시글 및 의사결정 트리에 관한 의견을 남겨주세요. Innovators 및 Google Developers Discord에 가입되어 있어야 합니다.