AI ワークロード向けの高性能ストレージ イノベーション

Sameet Agarwal

VP/GM, Storage

Asad Khan

Sr. Director of Product Management, Google Storage

※この投稿は米国時間 2025 年 4 月 11 日に、Google Cloud blog に投稿されたものの抄訳です。

AI Hypercomputer の高性能ストレージ スタックには、地理的なリージョン、ゾーン、GPU / TPU アーキテクチャから得られた学習結果が組み込まれ、アジャイルで経済的な統合ストレージ アーキテクチャを実現しています。Google は最近、高性能ストレージでアクセラレータの使用率を改善することで費用とリソースを最適化し、AI ワークロードを加速させるために、いくつかのイノベーションを成し遂げました。

-

Rapid Storage: 新しい Cloud Storage ゾーンバケット。業界トップクラスである 1 ミリ秒未満のランダム読み取り / 書き込みレイテンシ、20 倍高速のデータアクセス、6 TB/秒のスループット、他の主要なハイパースケーラーと比較して 5 分の 1 のランダム読み取り / 書き込みレイテンシを実現します。

-

Anywhere Cache: 既存のリージョン バケットで動作する、強整合性のある新しいキャッシュ。選択したゾーン内でデータをキャッシュに保存します。Anywhere Cache はレイテンシを最大 70% および 2.5 TB/秒削減し、AI ワークロードを高速化します。また、データを GPU または TPU の近くに保持することで、グッドプットを最大化します。

-

Google Cloud Managed Lustre: DDN EXAScaler Lustre ファイル システム上に構築された、新しい高性能なフルマネージド並列ファイル システム。このゾーン ストレージ ソリューションは、AI ワークロード向けに、PB 規模のストレージを提供し、1 ミリ秒未満のレイテンシ、数百万の IOPS、TB/秒のスループットを実現します。

-

Storage Intelligence : オブジェクト メタデータを大規模にクエリし、LLM の機能を活用することで、環境に固有のストレージ分析情報を生成する、業界初のソリューション。Storage Intelligence は、膨大なデータ資産に関する分析情報だけでなく、アクションを実行する機能も提供します。たとえば、バケットの再配置を使用して、アクセラレータとデータを、混乱を招くことなく同じ場所に配置できます。

Rapid Storage により、ミリ秒単位のレイテンシで AI ワークロードを実現

AI モデルを最大限の効率でトレーニングし、チェックポイントを作成して、提供するには、GPU または TPU をデータで飽和状態に保ち、コンピューティングの無駄を最小限に抑える必要があります(グッドプットで測定)。しかし、従来のオブジェクト ストレージには、レイテンシという重大な制限があります。Rapid Storage は、Google の Colossus クラスタレベルのファイル システムを使用して、新しいゾーンバケットにストレージと AI アクセラレータを共存させる新しいアプローチを提供します。また、Rapid Storage は Colossus を基盤としているため、アクセラレータとデータがそれぞれ別のゾーンにあることにより発生する、通常のリージョン ストレージのレイテンシを回避できます。

リージョンの Cloud Storage バケットとは異なり、Rapid Storage ゾーンバケットは、GPU と TPU が実行されているゾーン内にデータを集中させ、ミリ秒未満の読み取り / 書き込みレイテンシと高スループットを実現します。実際、Rapid Storage は、他の主要なハイパースケーラーと比較して、ランダム読み取り / 書き込みのレイテンシを 5 分の 1 に短縮します。バケットあたり最大 6 TB/秒のスループットと最大 2,000 万の秒間クエリ数(QPS)を組み合わせることで、Rapid Storage を使用して、新たなレベルのパフォーマンスで AI モデルをトレーニングできるようになりました。

高いパフォーマンスを実現するために複雑さを増やすべきではないため、Cloud Storage FUSE を利用して Rapid Storage バケットをファイル システムとしてマウントできます。これにより、TensorFlow や PyTorch などの一般的な AI フレームワークが、コードを変更することなくオブジェクト ストレージにアクセスできるようになります。

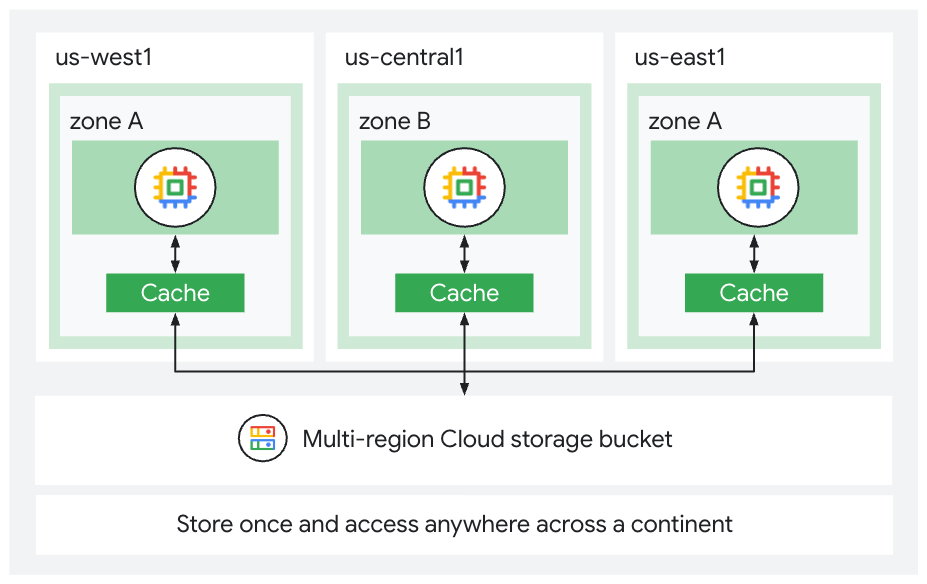

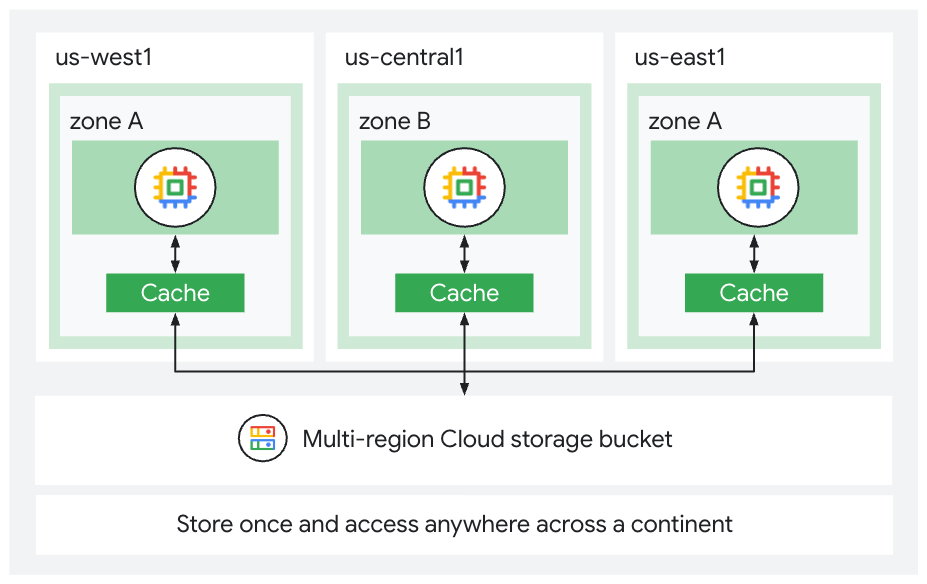

Anywhere Cache は優先ゾーンにデータを配置

Anywhere Cache は、既存のストレージ バケット(リージョン、マルチリージョン、デュアルリージョン)で動作する、強整合性のゾーン読み取りキャッシュです。選択したゾーン内でデータをインテリジェントにキャッシュします。その結果、Anywhere Cache により、ストレージの読み取りレイテンシが最大 70% 改善します。データを目的のゾーンに動的にキャッシュし、GPU や TPU の近くに配置することで、最大 2.5 TB/秒のパフォーマンスを実現し、複数のエポック トレーニング時間を最小限に抑えます。アクセラレータの可用性の変更など、状況が変化した場合、Anywhere Cache はデータが AI アクセラレータに付随するようにします。バケットやアプリケーションを変更することなく、ワンクリックで他のリージョンやゾーンで Anywhere Cache を有効にできます。さらに、キャッシュされたデータの下り(外向き)料金が不要になります。マルチリージョン バケットを使用している既存の Anywhere Cache のお客様の 70% が、費用面でのメリットを得ています。

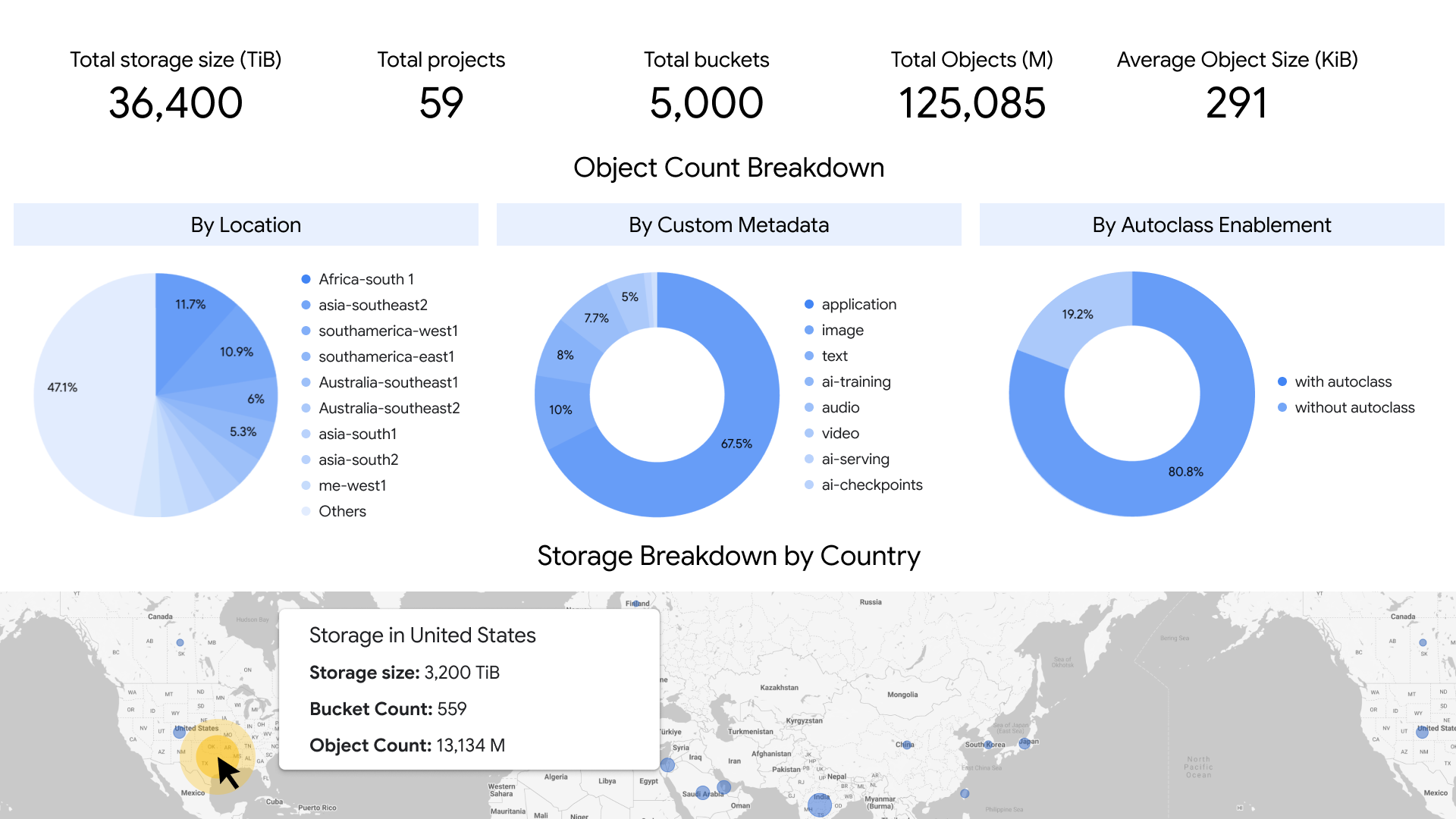

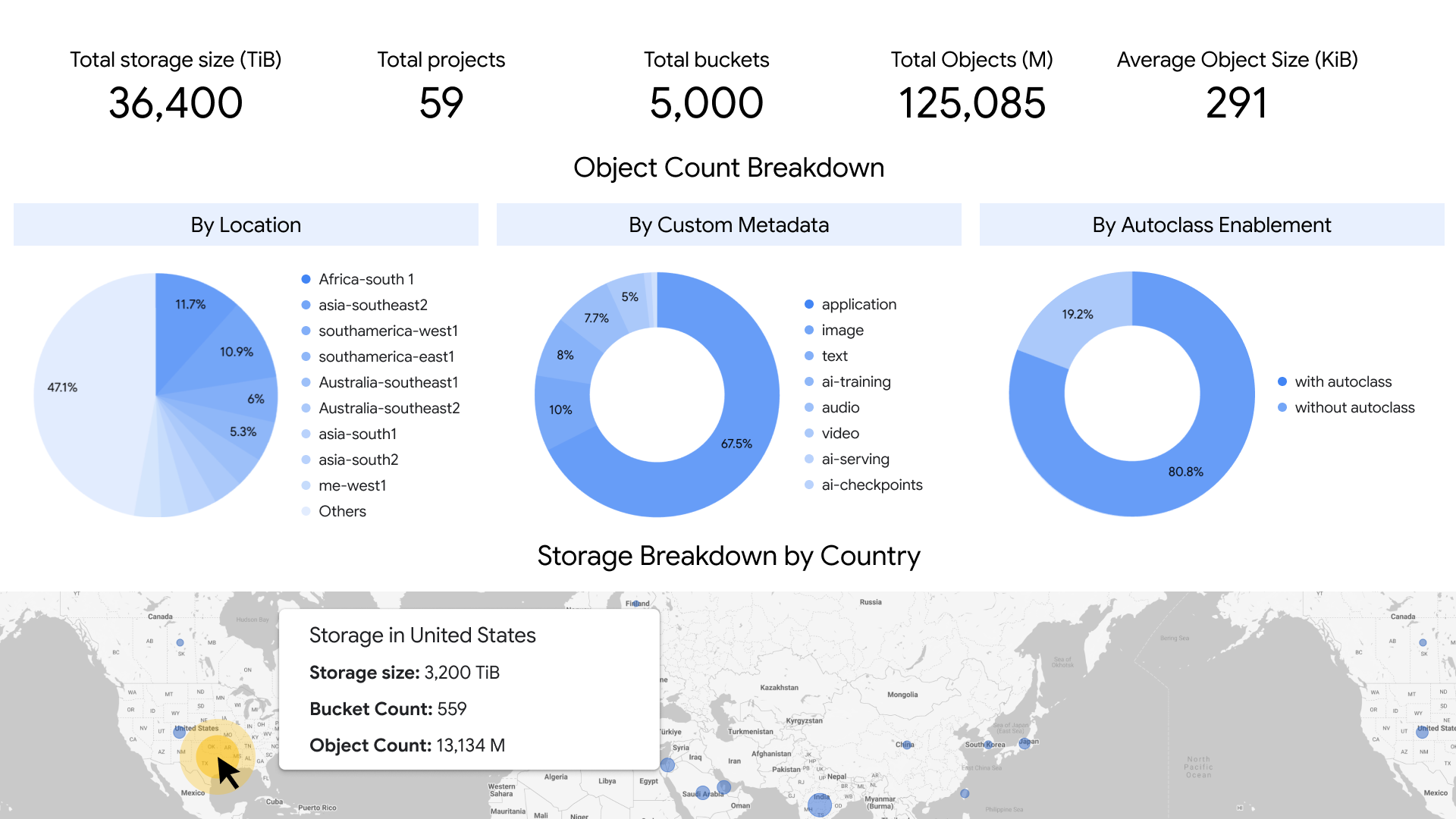

Anthropic は、Anywhere Cache を活用して、単一のゾーンに TPU とデータを配置し、最大 6 TB/秒の動的にスケーラブルな読み取りスループットを提供することで、クラウド ワークロードの復元力を向上させています。また、Storage Intelligence を使用して 850 億以上のオブジェクトに関する詳細な分析情報を取得し、ストレージ インフラストラクチャを最適化しています。

Google Cloud Managed Lustre で HPC と AI のワークロードを高速化

AI ワークロードは、小さなファイルやランダム I/O にアクセスできますが、並列ファイル システムのミリ秒未満のレイテンシが必要です。新しい Google Cloud Managed Lustre は、フルマネージドの並列ファイル システム サービスです。完全に POSIX に対応しており、テラバイトからペタバイトまでスケールする永続ゾーン ストレージとして利用できます。永続的な並列ファイル システムである Managed Lustre を使用すると、トレーニング、チェックポイント、サービング データを確実に保存できるだけでなく、高スループット、ミリ秒未満のレイテンシ、複数のジョブにわたる数百万の IOPS を実現しながら、グッドプットを最大化できます。全二重通信ネットワークの利用により、Managed Lustre は 20 GB/秒で VM を完全に飽和させ、最大 1 TB/秒の合計スループットを実現できます。また、Cloud Storage の一括インポート / エクスポート API に対応しているため、Cloud Storage との間でのデータセットの移動が簡単です。Managed Lustre は、DDN と連携して構築され、EXAScaler をベースにしています。

Storage Intelligence でデータを分析し、データに基づいた行動を起こす

AI モデルの質は、トレーニングに使用したデータの質に必ず比例します。このたび、新サービスの Storage Intelligence を発表しました。このサービスは、AI トレーニングに使用されるすべてのバケットのメタデータをクエリして適切なデータセットを見つけられるよう支援し、AI の費用最適化の取り組みを改善します。Storage Intelligence は LLM の力を活用してオブジェクト メタデータを大規模にクエリし、環境に固有のストレージ分析情報を生成します。クラウド ハイパースケーラーが提供する初のストレージ インテリジェンス サービスである Storage Intelligence を使用すれば、組織全体のバケットやプロジェクト内の数百万、数十億ものオブジェクト メタデータを分析できます。この分析から得られる情報を使用して、重複するオブジェクトの削除、オブジェクトのライフサイクル管理や Autoclass によって削除または下位のストレージ クラスに移動できるオブジェクトの特定、会社のセキュリティ ポリシーに違反するオブジェクトの特定などに関して、情報に基づいた意思決定を行うことができます。

Google の Cloud Storage の Autoclass と Storage Intelligence の機能により、Spotify はストレージ費用を把握し、最適化できました。2024 年、Spotify はこれらの機能を活用して、ストレージ費用を 37% 削減しました。

AI ワークロード向けの高性能ストレージ

Google は、可用性、高スループット、低レイテンシ、耐久性のあるアーキテクチャを実現する高性能ストレージ ソリューションである Rapid Storage、Anywhere Cache、Managed Lustre を構築しました。Storage Intelligence は、ストレージ エステートに関する、有益で行動につながるインサイトを提供します。

これらのイノベーションの詳細を知るには、Google Cloud Next '25 のブレイクアウト セッション「What’s new with Google Cloud’s Storage(Google Cloud のストレージに関する最新情報)」(BRK2-025)と「AI Hypercomputer: Mastering your Storage Infrastructure(AI Hypercomputer: ストレージ インフラストラクチャをマスターする)」(BRK2-020)にご参加ください。

-ストレージ担当 VP 兼 GM、Sameet Agarwal

-ストレージ担当シニア ディレクター兼 PM、Asad Khan