Cloud TPU v5e が大規模な AI 推論を高速化

Google Cloud Japan Team

※この投稿は米国時間 2023 年 9 月 1 日に、Google Cloud blog に投稿されたものの抄訳です。

Google Cloud の AI に最適化されたインフラストラクチャを使用すると、企業は最先端の AI モデルのトレーニング、微調整、推論の実行速度を、大規模かつ低コストでさらに高めることができます。このたび、Cloud TPU での推論のプレビューについてお知らせできることを嬉しく思います。新しい Cloud TPU v5e では、最新の大規模言語モデル(LLM)や生成 AI モデルなど、幅広い AI ワークロードに対して高性能で費用対効果の高い推論を行えます。

新しいモデルがリリースされ、AI がより高度になるにしたがい、企業はより強力でコスト効率の高いコンピューティング オプションを必要としています。Google は AI ファーストの企業であり、AI に最適化された Google のインフラストラクチャは、何十億ものユーザーにサービスを提供する YouTube、Gmail、Google マップ、Google Play、Android といった Google プロダクトやクラウドのお客様が求める、グローバルなスケーラビリティとパフォーマンスを提供できるように構築されています。

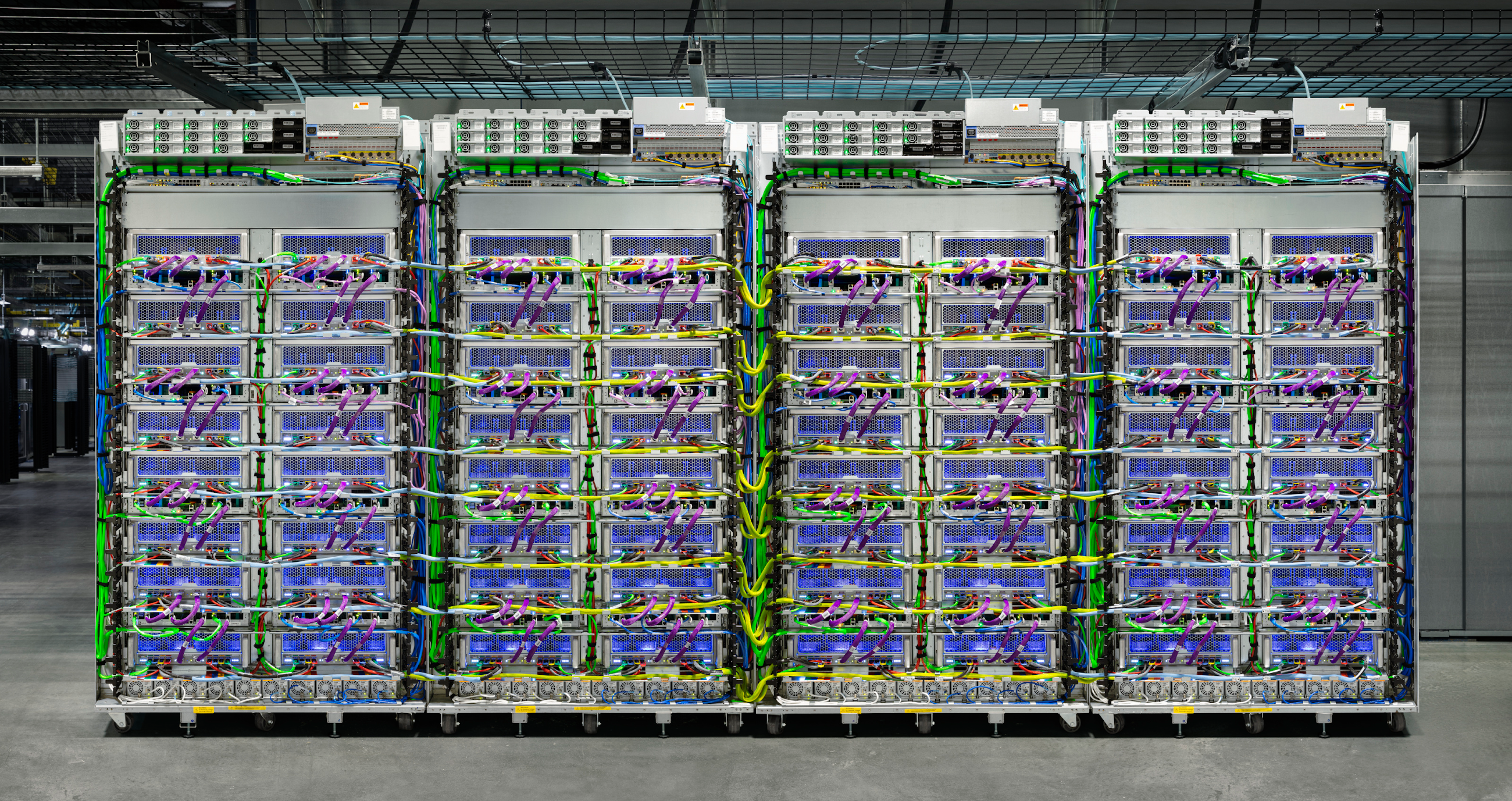

LLM と生成 AI のブレークスルーを実現するには、AI モデルのトレーニングと対応に膨大な量の計算が必要です。Google は Cloud TPU v5e をカスタム設計、構築、デプロイすることで、この増大する計算需要にコスト効率よく対応しています。

Cloud TPU v5e は AI 推論ワークロードの高速化に最適です。

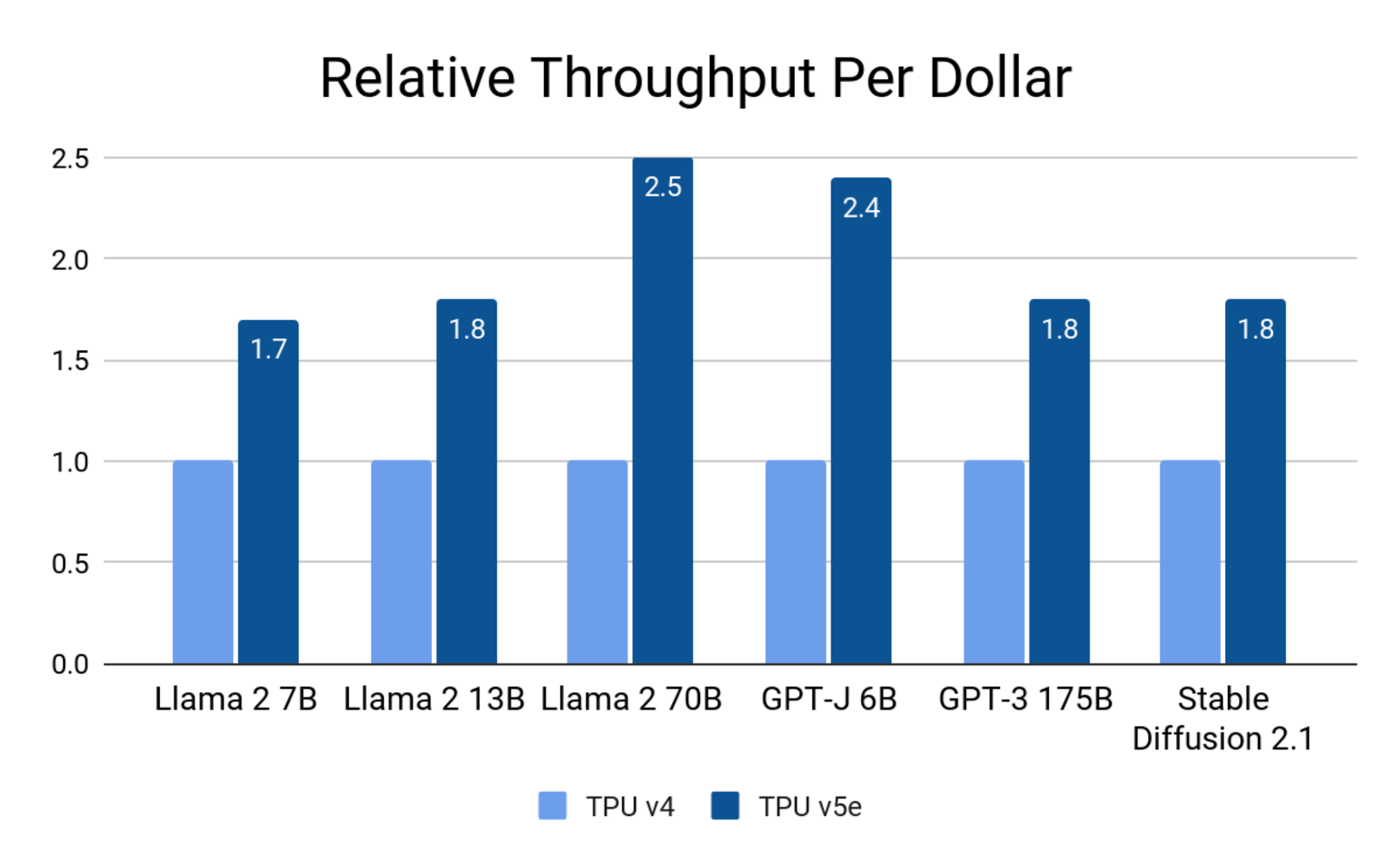

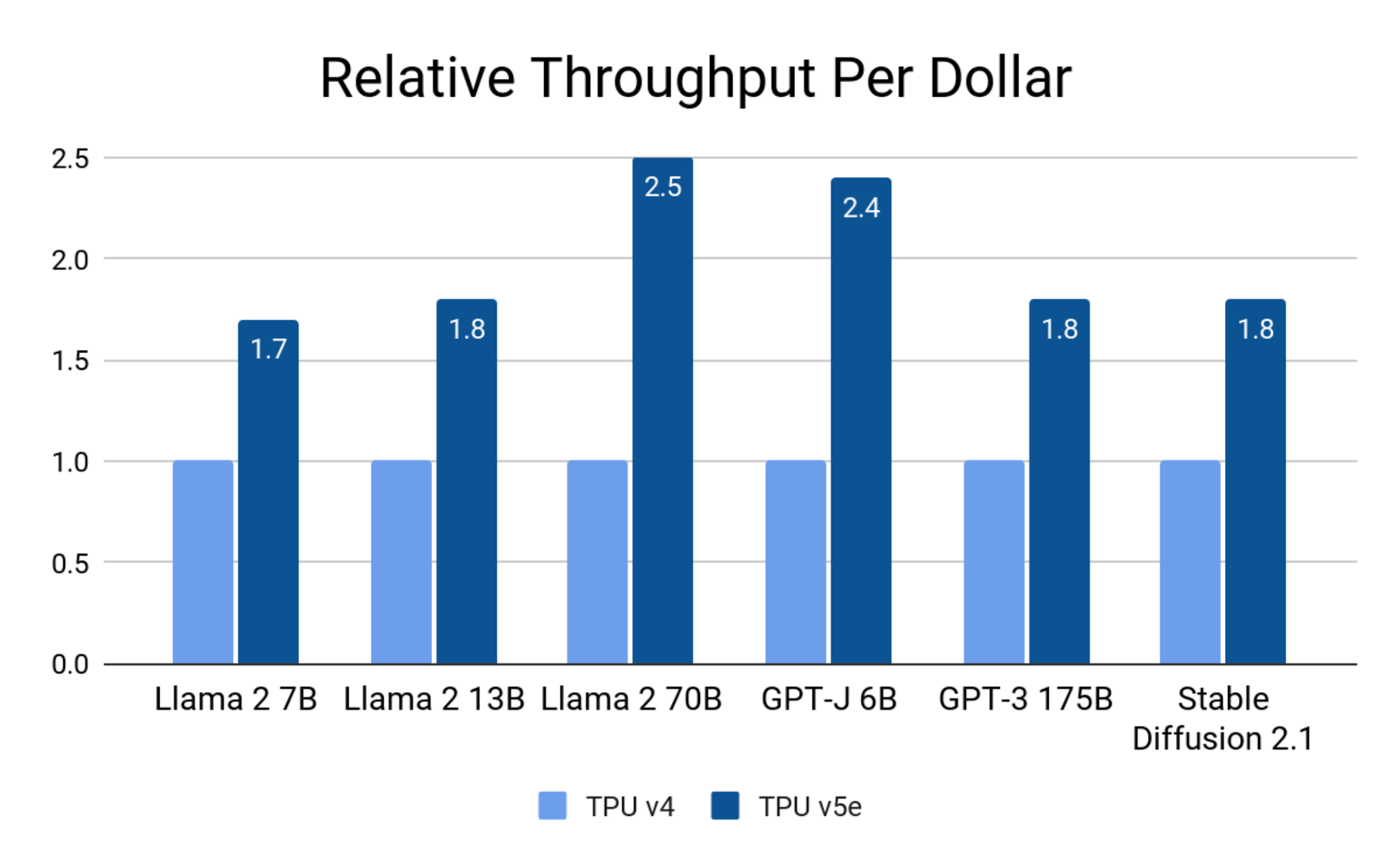

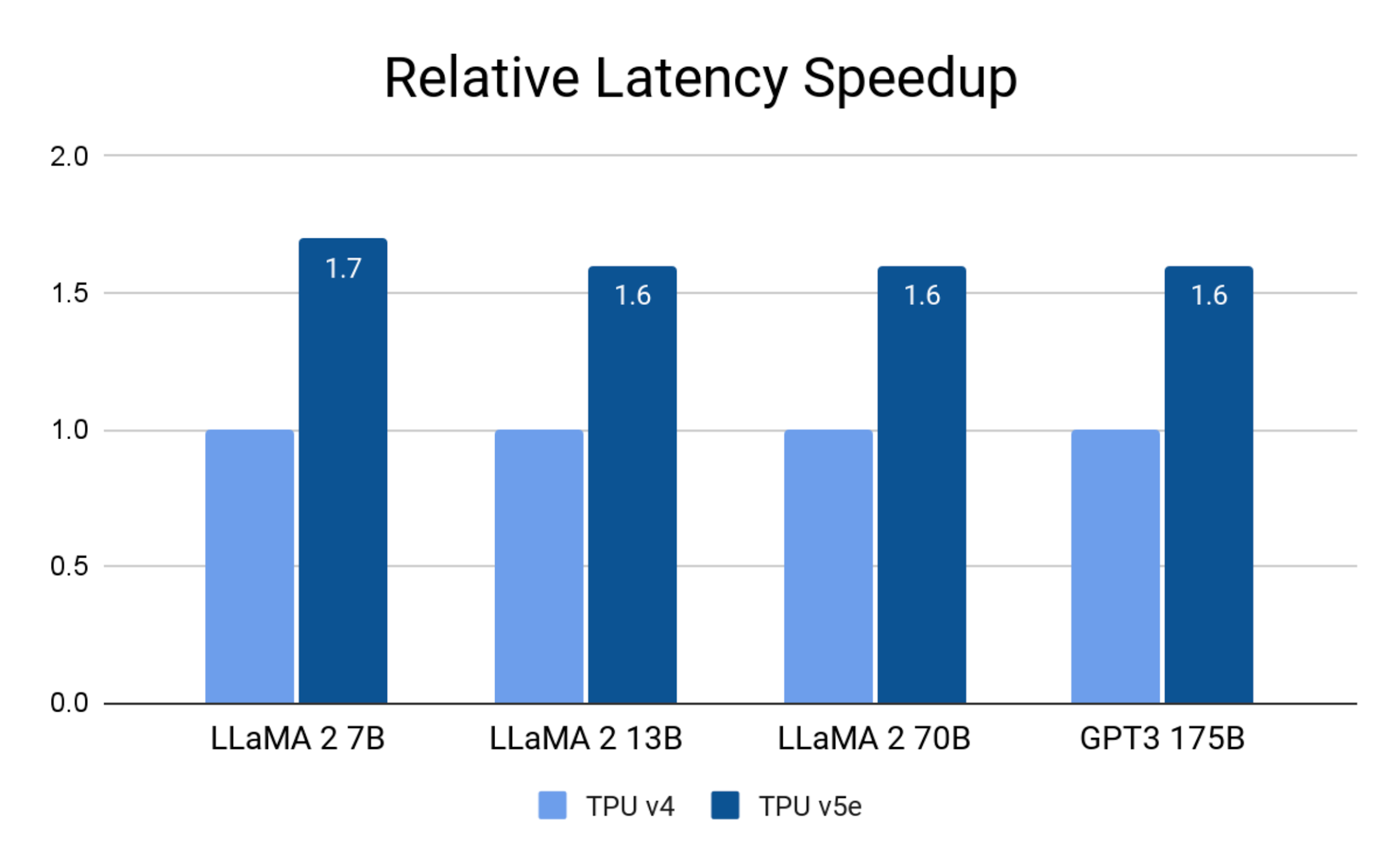

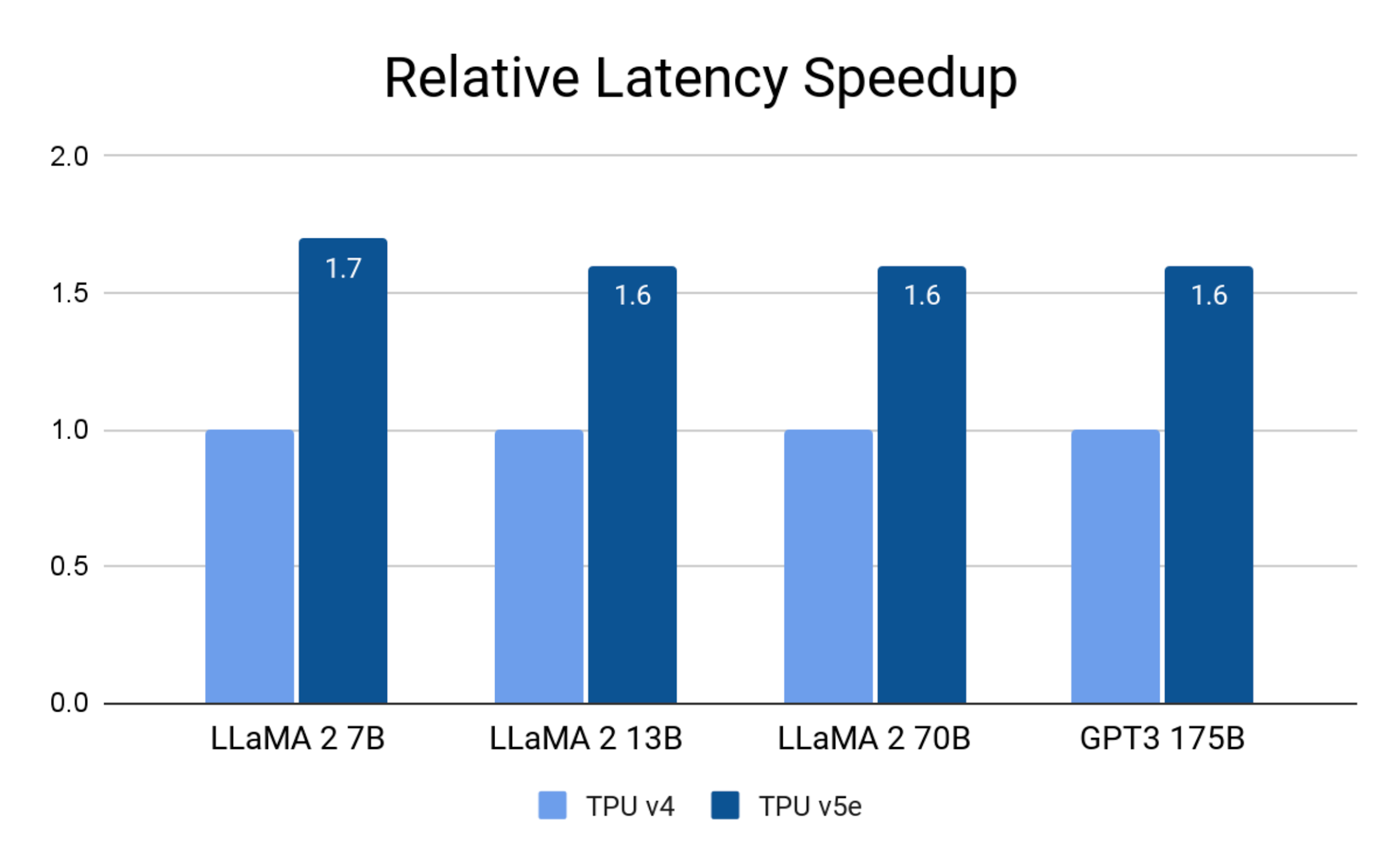

コスト効率が良い: TPU v4 と比較して、最大で 1 ドルあたりのパフォーマンスが 2.5 倍高く、推論のレイテンシが 1.7 倍低い。

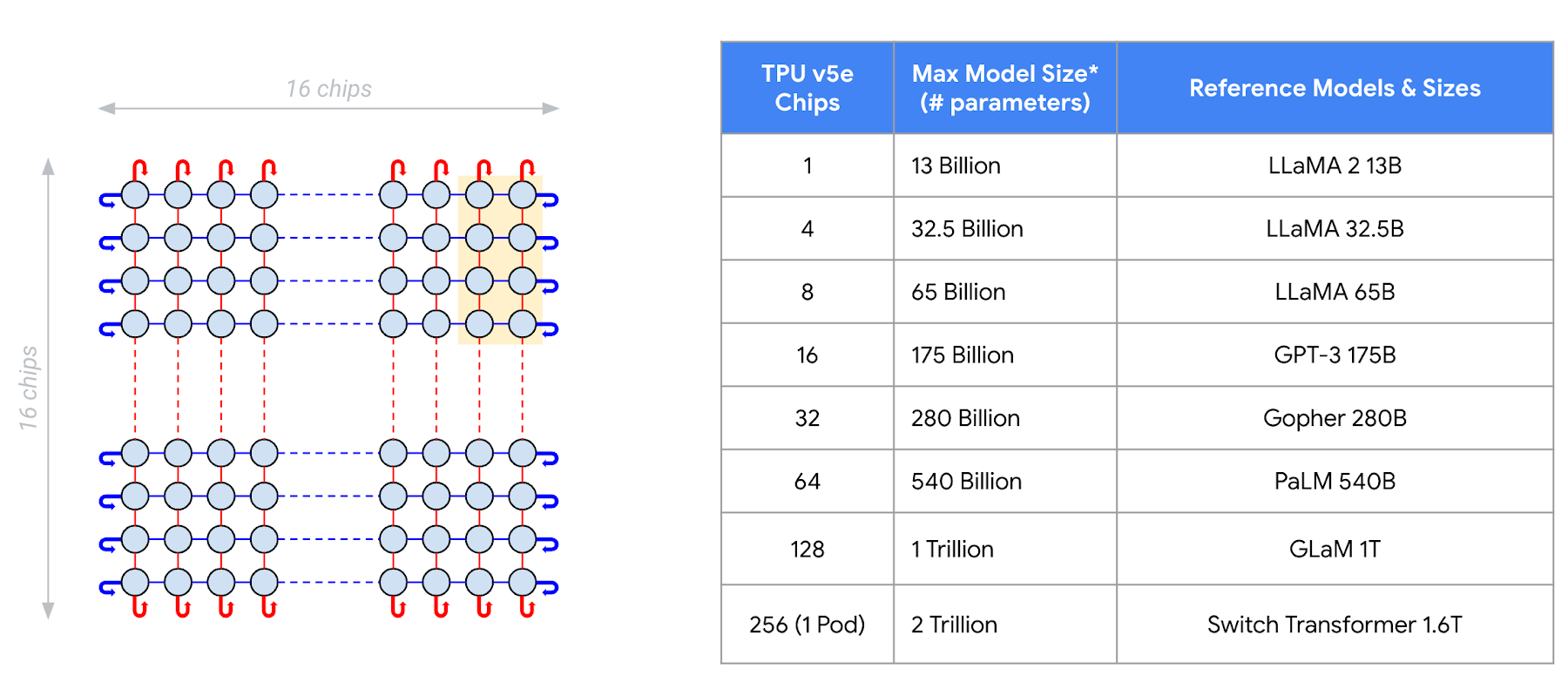

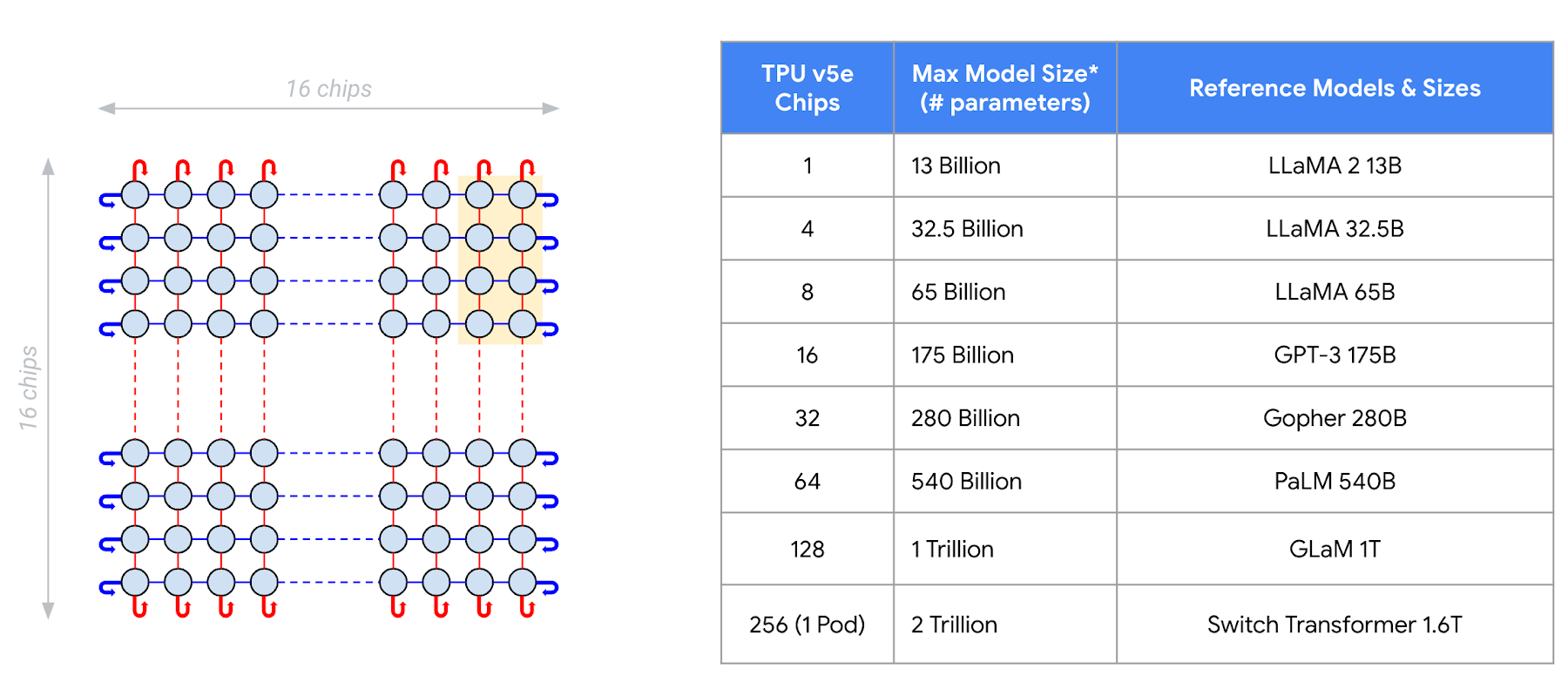

スケーラブル: TPU の 8 つの形状が、LMM と生成 AI モデルの全サイズ(最大 2 兆個のパラメータ)をサポート。

汎用的: 堅牢な AI フレームワークとオーケストレーションのサポート。

このブログでは、TPU v5e を AI 推論に効果的に活用する方法について詳しく説明します。

最大で 1 ドルあたりのパフォーマンスが 2.5 倍高く、推論のレイテンシが 1.7 倍低い

各 TPU v5e チップは int8 演算を 1 秒あたり最大 393 兆回(TOPS)行うため、複雑なモデルで素早く予測できます。TPU v5e Pod は、超高速リンクでネットワーク化された 256 個のチップで構成されます。各 TPU v5e Pod には、int8 演算を 1 秒あたり最大 10 京回(100 PetaOps)行える計算能力があります。

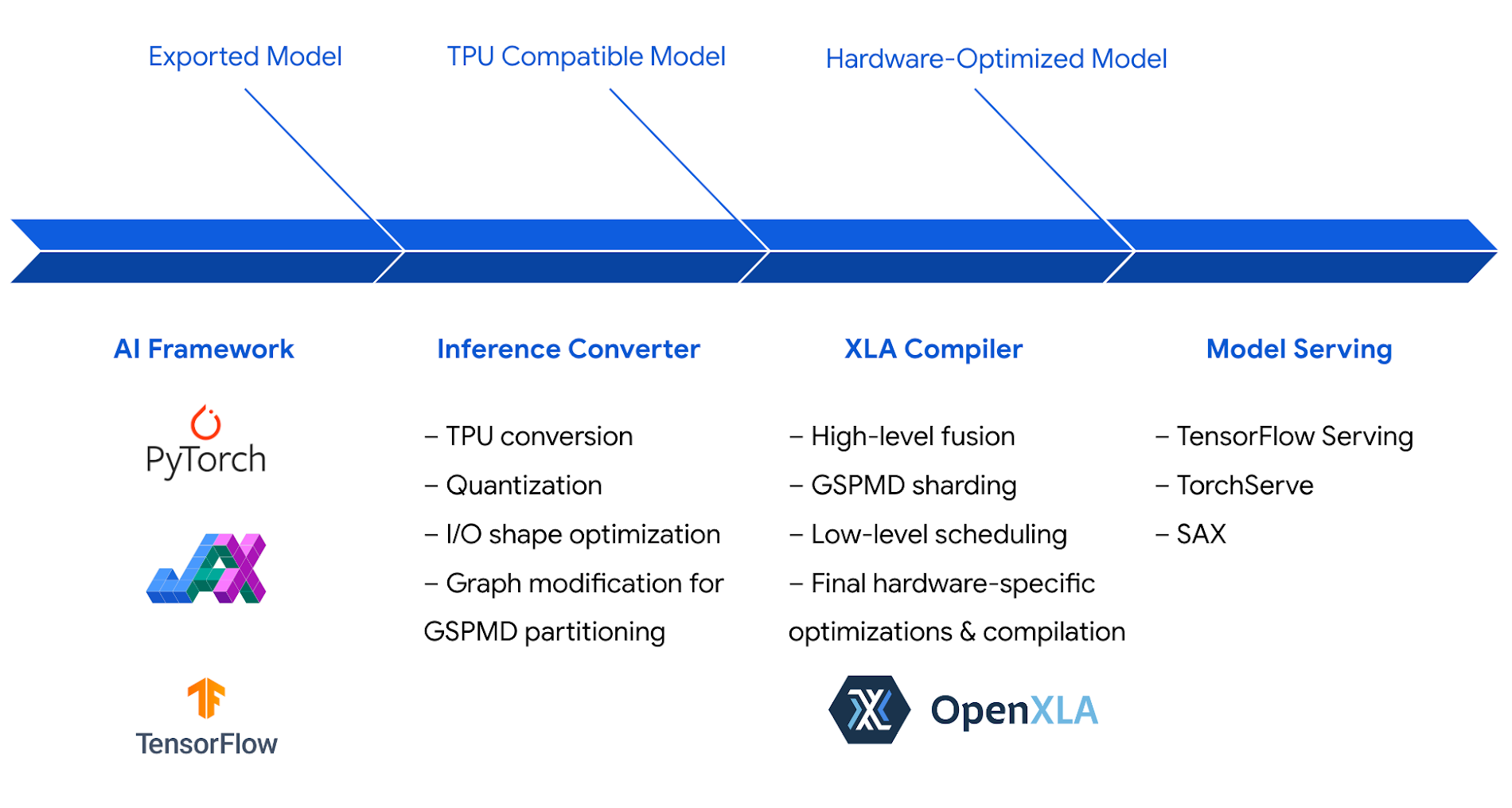

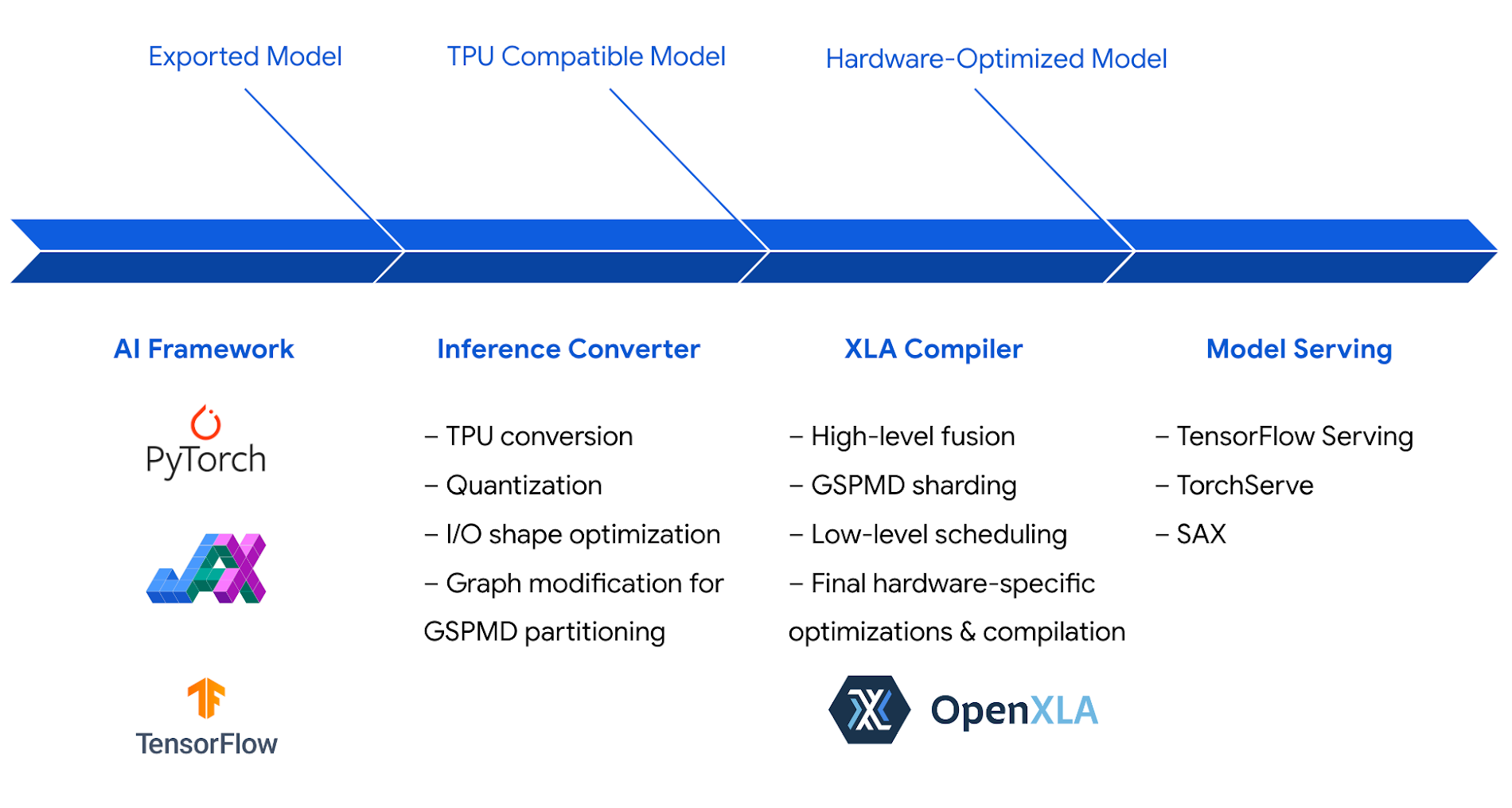

Cloud TPU 推論ソフトウェア スタックは、このハードウェアを最大限に活用するように最適化されました。推論スタックは TPU 向けに高効率なコードを生成する XLA(Google の AI コンパイラ)を利用して、パフォーマンスと効率を最大限に高めています。

int8 量子化を含め、ハードウェアとソフトウェアの最適化を組み合わせることで、Cloud TPU v5e は Llama 2、GPT-3、Stable Diffusion 2.1 を含む最先端の LLM と生成 AI モデルについて、Cloud TPU v4 と比較して 1 ドルあたり最大 2.5 倍の推論パフォーマンスを達成できます。

レイテンシに関しては、Cloud TPU v5e は TPU v4 と比較して最大 1.7 倍のスピードアップを達成しています。

Google Cloud のお客様は Cloud TPU v5e で推論を実行しており、一部のお客様は特定のワークロードでさらなるスピードアップを実感しています。

AssemblyAI では、音声認識と理解のために数十個の AI モデルがお客様に提供され、推論呼び出しが毎日 2,500 万回以上行われています。

「Cloud TPU v5e は、当社の本番環境モデルで推論を実行する際に、市販の同等のソリューションと比較して、1 ドルあたり最大 4 倍のパフォーマンスを一貫して実現しました。Google Cloud のソフトウェア スタックは高パフォーマンスと効率を実現するよう最適化されており、最先端の AI モデルと ML モデルを高速化することに特化した TPU v5e ハードウェアを最大限に活用します。このハードウェアとソフトウェアの強力で汎用性の高い組み合わせにより、解決までの時間が劇的に短縮されました。何週間もかけてカスタム カーネルを手作業で調整するのではなく、数時間以内にモデルを最適化して推論パフォーマンスの目標を達成し、上回ることができました。」- AssemblyAI テクノロジー担当バイス プレジデント Domenic Donato 氏

LLM と生成 AI モデルのあらゆるサイズに合わせてスケーリング

LLM と生成 AI モデルは、サイズと計算費用が増大し続けています。最大のモデルは、数百のハードウェア アクセラレータの計算とメモリを組み合わせる必要があります。Cloud TPU v5e では、さまざまなモデルサイズの推論を行えます。1 個の v5e チップで、最大 130 億個のパラメータを持つモデルを実行できます。さらに数百個のチップにスケールアップすると、最大 2 兆個のパラメータを持つモデルを実行できます。

Gridspace は Google Cloud TPU インフラストラクチャを活用して、フルスタックの対話型 AI プラットフォームを運用しています(リアルタイムの対話型 ASR、LLM、セマンティック検索、ニューラル TTS の構築と統合)。

「Google Cloud TPU の大ファンです。当社のベンチマークでは、Google Cloud TPU v5e でトレーニングして実行した場合、AI モデルの速度が 5 倍向上することが実証されています。また、推論指標のスケールも 6 倍向上しています。Google Cloud の AI インフラストラクチャを利用して、金融サービス、資本市場、ヘルスケアにわたり、AI モデルの年間対話数を数十億件までスケールアップしました。当社の Grace bot には、Cloud TPU を使用してトレーニングしたモデルが搭載されています。GKE で大規模にサービスを提供し、PCI、HITRUST、SOC 2 の準拠に対応しています。」- Gridspace ML 責任者 Wonkyum Lee 氏

堅牢な AI フレームワークとオーケストレーションのサポート

PyTorch、JAX、TensorFlow などの主要な AI フレームワークは、Cloud TPU v5e での推論を確実にサポートします。つまり、Cloud TPU でエンドツーエンドにモデルのトレーニングと提供を行えるようになりました。

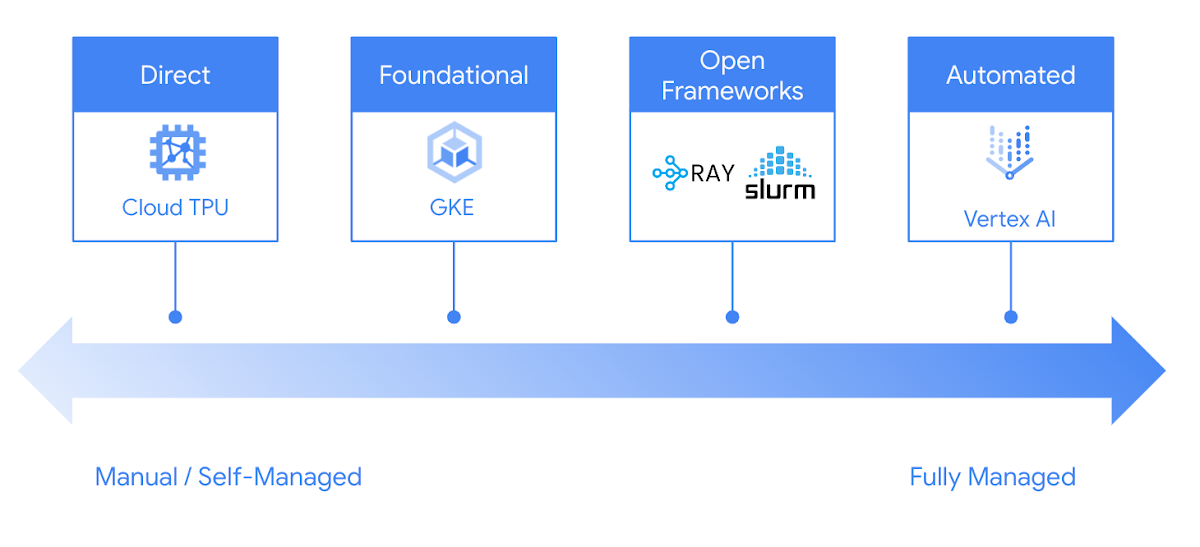

Google Cloud には、Cloud TPU で推論を簡単かつ確実に実行する選択肢が多数用意されています。GKE や Vertex AI から、Ray や Slurm などの人気のあるオープンソース フレームワークに至るまで、開発プロセスに適した望ましい方法で Google Cloud TPU を活用できます。

Cloud TPU v5e での推論を今すぐお試しください

Cloud TPU v5e は LLM と生成 AI モデル向けに、高性能でコスト効率が良く、スケーラブルで信頼性の高い推論プラットフォームを提供します。大手の AI 企業は Cloud TPU v5e を活用して大規模に AI モデルを提供しています。

Cloud TPU での推論を開始するには、Google Cloud アカウント マネージャーか、Google Cloud セールスにお問い合わせください。

- シニア ソフトウェア エンジニアリング マネージャー Gang Ji