費用対効果の高い方法で高パフォーマンスの推論をスケーリング

Mark Lohmeyer

VP & GM, AI & Computing Infrastructure

Drew Bradstock

Sr. Director of Product Management, Cloud Runtimes

※この投稿は米国時間 2025 年 9 月 13 日に、Google Cloud blog に投稿されたものの抄訳です。

Google Cloud Next 2025 にて、GKE Inference Gateway を使用した新しい推論機能が発表されました。これには、TPU 上の vLLM、Ironwood TPU、Anywhere Cache のサポートが含まれます。

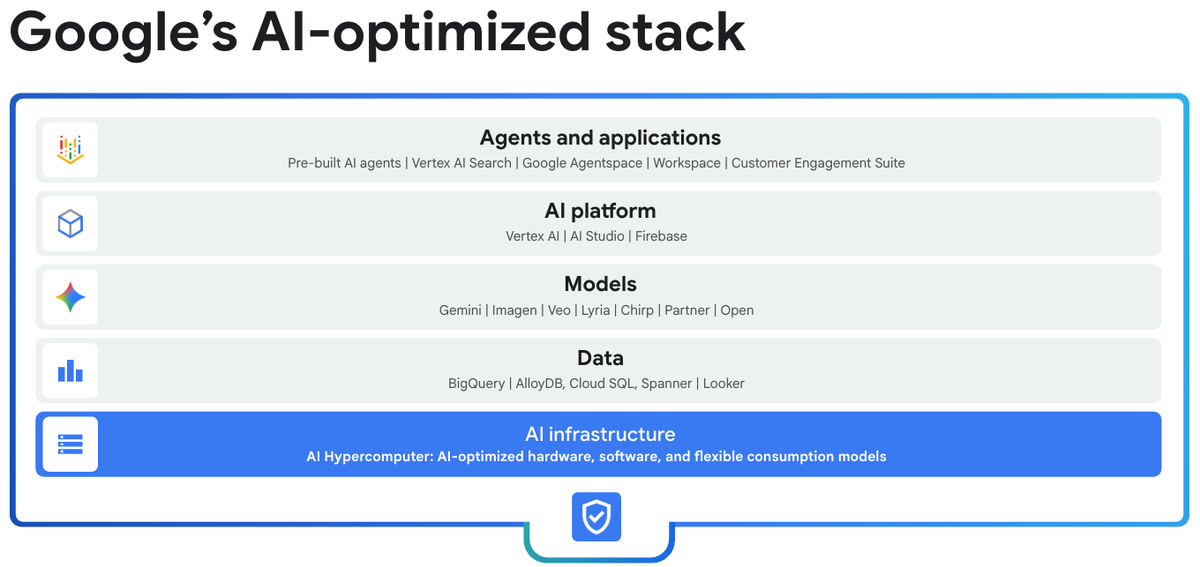

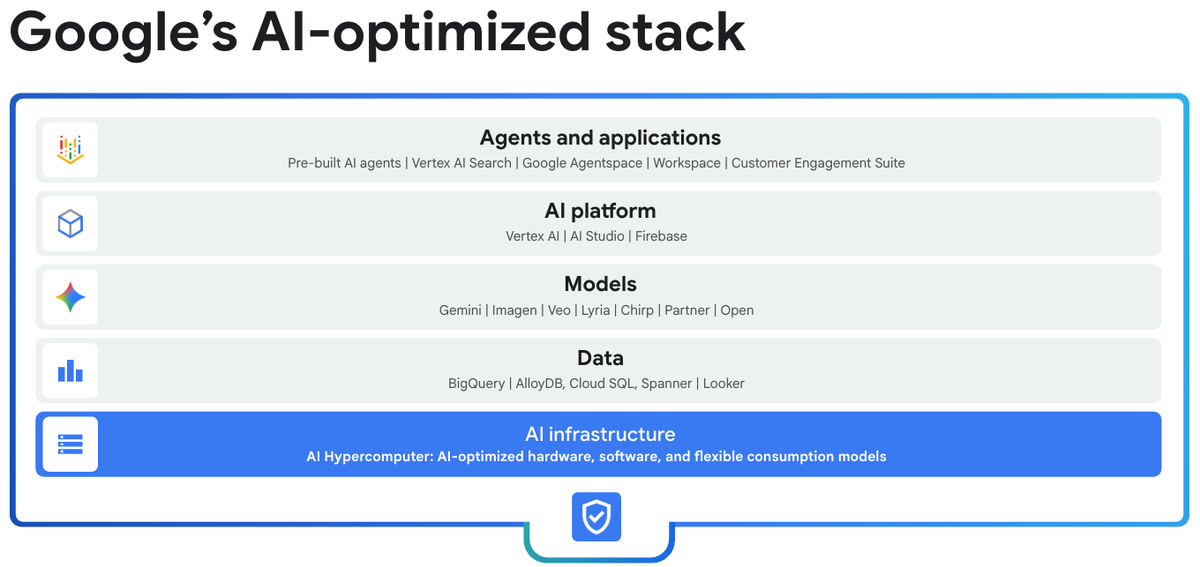

Google の推論ソリューションは、AI Hypercomputer をベースにしています。AI Hypercomputer は、Gemini や Veo 3 などのモデルを運用した経験に基づいて構築されたシステムで、毎月 980 兆以上のトークンを 4 億 5,000 万人以上のユーザーに提供しています。AI Hypercomputer サービスは、リソース管理、ワークロードの最適化とルーティング、スケーリングとパフォーマンスのための高度なストレージなど、インテリジェントで最適化された推論を提供します。これらはすべて、業界をリードする GPU および TPU アクセラレータと連携するように共同設計されています。

本日、GKE Inference Gateway の一般提供が開始され、さらに価値を高める新機能がリリースされました。これは、トレーニングとサービングの両方でパフォーマンスを向上させ、コストを最適化することで、企業がより多くのインテリジェンスを提供できるよう支援するという Google の取り組みを明確に示しています。

今回発表する新機能を見ていきましょう。

効率的なモデル提供と負荷分散

生成 AI アプリケーションのユーザー エクスペリエンスは、リクエストに対する迅速な初期応答と、完了までのスムーズなレスポンス ストリーミングの両方に大きく依存します。これらの新機能により、AI Hypercomputer のファースト トークンまでの時間(TTFT)と出力トークンあたりの時間(TPOT)が改善されました。TTFT は、モデルを完全にパススルーしてキー値(KV)キャッシュを作成する、コンピューティング バウンド プロセスであるプレフィル フェーズに基づいています。TPOT は、デコード フェーズに基づいています。デコード フェーズは、プレフィル ステージの KV キャッシュを使用してトークンを生成する、メモリバウンドのプロセスです。

Google は、さまざまな方法でこの両方を改善しています。chatbot やコード生成などの生成 AI アプリケーションでは、API 呼び出しで同じプレフィックスが再利用されることがよくあります。これを最適化するために、GKE Inference Gateway で プレフィックス対応のロード バランシングが提供されるようになりました。この新しい一般提供機能は、同じプレフィックスを持つリクエストを同じアクセラレータにインテリジェントにルーティングし、負荷を分散してホットスポットやレイテンシの急増を防ぐことで、プレフィックスを多用するワークロードのピーク時のスループットで、他のクラウドよりも TTFT レイテンシを最大 96% 向上させます。

たとえば、金融サービス会社の chatbot が、ユーザーの口座に関する問い合わせに対応するとします。ユーザーが最近のクレジットカード取引について質問するために会話を開始します。プレフィックスを認識するルーティングがない場合、ユーザーが請求日や確認番号などのフォローアップの質問をすると、LLM はフォローアップの質問に答える前に、最初のクエリ全体を再読み取りして再処理する必要があります。プレフィル フェーズの再計算は非常に非効率的で、不要なレイテンシが追加されるため、質問の度に待たされることになります。プレフィックスを認識するルーティングでは、リクエストを同じ KV キャッシュにルーティングすることで、最初のクエリのデータをインテリジェントに再利用します。これにより、プリフィル フェーズがバイパスされ、モデルはほぼ瞬時に回答できるようになります。計算量が少ないということは、同じワークロードに必要なアクセラレータの数も少なくなるため、大幅な費用削減につながります。

推論のパフォーマンスをさらに最適化するために、AI Hypercomputer を使用して分散サービングを実行できるようになりました。これにより、スループットを 60% 向上させることができます。GKE Inference Gateway、llm-d、vLLM の機能強化により、クエリサイズに基づいてプリフィル ノードとデコードノードを動的に選択できるようになります。これにより、コンピューティング リソースとメモリリソースの使用率が大規模に向上し、TTFT と TPOT の両方が大幅に改善されます。

たとえば、インタラクティブ性を維持するために低レイテンシのレスポンスを提供する必要がある、AI ベースのコード補完アプリケーションを考えてみましょう。開発者が補完リクエストを送信すると、アプリケーションはまず入力されたコードベースを処理する必要があります。これはプリフィル フェーズと呼ばれます。次に、アプリケーションはコード提案トークンをトークンごとに生成します。これはデコード フェーズと呼ばれます。これらのタスクでは、アクセラレータ リソースに対する要求が大きく異なります。つまり、コンピューティング集中型処理とメモリ集中型処理です。両方のフェーズを単一のノードで実行すると、どちらも完全に最適化されず、レイテンシが増加して応答時間が長くなります。分離型サービングでは、これらのフェーズが別々のノードに割り当てられるため、各フェーズを個別にスケーリングして最適化できます。たとえば、開発者のユーザーベースが大規模なコードベースに基づいて多数のリクエストを送信する場合、プリフィルノードをスケーリングできます。これにより、レイテンシとスループットが改善され、システム全体の効率が向上します。

プレフィックスを認識したルーティングによって会話コンテキストの再利用が最適化され、分離されたサービングによってモデルのプレフィルとトークン デコードの計算需要がインテリジェントに分離されてパフォーマンスが向上するように、Google は、これらの大規模モデルをそもそも実行するという根本的な課題にも対処してきました。生成 AI モデルは数百ギガバイトのサイズにまで拡大しており、読み込みに 10 分以上かかることが多く、起動とスケーリングが遅くなります。この問題を解決するため、Google は Run:ai モデル ストリーマーと Google Cloud Storage および vLLM 用の Anywhere Cache をサポートするようになりました。SGLang のサポートも近日中に提供される予定です。これにより、アクセラレータ メモリへの直接スループットが 5.4 GiB/s になり、モデルの読み込み時間が 4.9 倍以上短縮され、エンドユーザー エクスペリエンスが向上します。

vLLM モデルの読み込み時間

データドリブンな意思決定で迅速に開始

AI モデルを提供するための最適な技術スタックを見つけることは、業界にとって大きな課題です。これまで、お客様は急速に進化するテクノロジーや、ハードウェアの選択に影響する切り替え費用、さらには何十万通りにも及ぶデプロイ アーキテクチャの選択肢に対応しなければなりませんでした。このような複雑さがあるため、推論環境で最適な費用対効果を迅速に実現することは困難です。

一般提供が開始された GKE Inference Quickstart は、ワークロードに適したアクセラレータを適切な構成で特定し、AI/ML 推論アプリケーションに最適なアクセラレータ、モデルサーバー、スケーリング構成を提案することで、AI ワークロードのデプロイにかかる時間を短縮し、パフォーマンスを向上させ、費用を削減します。GKE Inference Quickstart の新しい改善点には、費用に関する分析情報とベンチマークされたパフォーマンスのベスト プラクティスが含まれています。これにより、費用を簡単に比較してレイテンシ プロファイルを把握できるため、評価と認定に数か月を費やす必要がなくなります。

GKE Inference Quickstart の推奨事項は、モデルとアクセラレータのパフォーマンス データのライブ リポジトリに基づいています。このデータは、GPU と TPU のアクセラレータを Llama、Mixtral、Gemma などの主要な大規模言語モデルに対して週に 100 回以上ベンチマークすることで生成されます。この広範なパフォーマンス データは、Gemini、検索、YouTube などの Google のグローバル規模のサービスで AI 推論を強化するのと同じストレージ、ネットワーク、ソフトウェアの最適化によって強化されます。

新しい一般公開のチャットボットをデプロイするよう指示されたとします。目標は、高品質な回答を迅速に、最小限の費用で提供することです。これまで、AI モデルをデプロイするための最適な費用対効果の高いソリューションを見つけることは、大きな課題でした。デベロッパーやエンジニアは、試行錯誤を繰り返すという骨の折れるプロセスに頼らざるを得ませんでした。これには、さまざまなモデル、アクセラレータ、サービング アーキテクチャの無数の組み合わせを手動でベンチマークし、すべてのデータをスプレッドシートに記録して、各シナリオのクエリあたりの費用を計算することが含まれていました。この手作業によるプロジェクトは数週間、あるいは数か月もかかり、人為的ミスが発生しやすく、最善の解決策が見つかる保証もありませんでした。

Google Colab と Google Cloud コンソールの組み込みの最適化機能を使用する GKE Inference Quickstart を使用すると、たとえば、TTFT が 500 ミリ秒未満の Llama 3 ベースの chatbot アプリケーションのサービングなど、費用対効果が最も高いアクセラレータを選択できます。これらの推奨事項はデプロイ可能なマニフェストであるため、Google Cloud 環境の GKE からプロビジョニングできる技術スタックを簡単に選択できます。GKE Inference Quickstart を使用することで、評価と認定の作業が数か月から数日に短縮されました。

エンジニアが評価に役立てる Google Colab のビュー。

これらの新機能をぜひお試しください。GKE Inference QuickStart を使用するには、Google Cloud コンソールで [Kubernetes Engine] > [AI/ML] に移動し、画面上部付近の [+ モデルをデプロイ] を選択します。フィルタを使用して、[最適化済み] > [値] = [True] を選択します。価格とパフォーマンスが最適化されたすべてのモデルが表示されるので、その中から選択できます。モデルを選択すると、レイテンシを選択するためのスライドバーが表示されます。プルダウンの互換性のあるアクセラレータが、選択したレイテンシのパフォーマンスに一致するものに変更されます。選択内容に応じて、出力トークン 100 万個あたりの費用も変わります。

Google Colab を使用して、Google Cloud 上の主要な AI モデルの価格とパフォーマンスをプロットして表示できます。Chatbot Arena の評価が統合されているため、モデルのサイズ、評価、100 万トークンあたりの料金に基づいて、ニーズに最適なモデルを判断できます。また、組織内の品質測定基準を Colab に取り込み、Google の包括的なベンチマークと組み合わせて、データドリブンな意思決定を行うこともできます。

推論の最適化に特化

Google Cloud は、企業が AI 推論ワークロードを大規模にデプロイして改善できるよう支援することに尽力しています。Google は、大規模言語モデルやその他の生成 AI アプリケーションを支えるために、比類のないパフォーマンスと費用対効果を実現する包括的なプラットフォームを提供することに注力しています。AI Hypercomputer、GKE 推論ゲートウェイ、プレフィックス認識ルーティング、分離型サービング、モデル ストリーミングなどの専用の最適化機能を含む、業界をリードするハードウェアとソフトウェアのイノベーションを共同設計したスタックを活用することで、企業はよりインテリジェントなサービスを、より迅速かつ応答性の高いユーザー エクスペリエンスと低い総所有コストで提供できるようになります。Google のソリューションは、モデルの読み込み時間からリソース使用率まで、推論に特有の課題に対処するように設計されており、生成 AI の可能性を最大限に引き出すことができます。詳細を確認して使用を開始するには、AI Hypercomputer のサイトをご覧ください。

ー コンピューティングおよび AI Infrastructure 担当、バイス プレジデント兼ゼネラル マネージャー Mark Lohmeyer

ー Cloud Runtimes プロダクト管理担当シニア ディレクター Drew Bradstock