責任ある AI によるビジネスの取り扱い

Google Cloud Japan Team

※この投稿は米国時間 2020 年 9 月 1 日に、Google Cloud blog に投稿されたものの抄訳です。

今後 10 年以内に、全世界で GDP の成長を押し上げる最大の要因が人工知能(AI)になるだろうと予測する人たちがいます1。これは驚くべき予測です。次の 10 年で、採用と革新が劇的に増加するでしょう。実際のところ、AI 対応でないアプリケーションは欠陥品とみなされるようになるかもしれません。

このような大きな期待にもかかわらず、エンタープライズにとって AI への信頼は、採用に対する大きな障害になりつつあることを、私は見てきました。全世界のビジネス エグゼクティブを対象とした調査によれば、回答者の 90% 以上は AI システムの採用に関して倫理的な問題に直面したことがあると回答しています。そのうち 40% はプロジェクトを完全に破棄しています2。倫理的な懸念の確実な評価と、AI のビルドとデプロイに関する責任範囲の明確化が行われなければ、多くのプロジェクトが破棄されることにより、このテクノロジーの恩恵を受けられないというリスクが存在することになります。

Google は、責任範囲が明確な AI を構築する方法の厳格な評価は正しい手法であるだけでなく、成功する AI を作成するために不可欠な要素であると確信しています。

Google は 2017 年中盤に自社の AI 原則の開発を開始し、1 年後の 2018 年 6 月に公開しました。これらの原則は、Google における高度なテクノロジーの構築、調査の実行、ポリシーの立案の方針を主導するために進化し続けています。この AI 原則によって、共通の目的により動機付けられ、全社会に最良の利益をもたらす高度なテクノロジーを使用するための方針を得られ、Google の使命と中核的な価値に合致した決定を下すことができます。また、これらはデプロイされた AI の長期的な成功と不可分のものです。2 年以上が経過した後で残った真実は、Google の製品をどのように構築するかという質問に対して Google の AI 原則が直接回答を与えてくれることは稀だということです。これらの原則は、厳格な会話を回避することを許さず、また許すべきでもありません。Google が何を支持するか、何をどのような目的で構築するかを規定する基盤であり、Google のエンタープライズ AI 製品が成功するための中核となるものなのです。

Google Cloud による Google の AI 原則の実践

Google の管理プロセスは、Google の AI 原則を系統的で繰り返し可能な方法で実装するよう設計されています。これらのプロセスには、製品と取引のレビュー、機械学習開発のベスト プラクティス、社内および社外の教育、クラウドの説明可能な AI などのツールと製品に加えて、お客様やパートナーと相談して共同で作業を行う方法の手引きなどが含まれます。

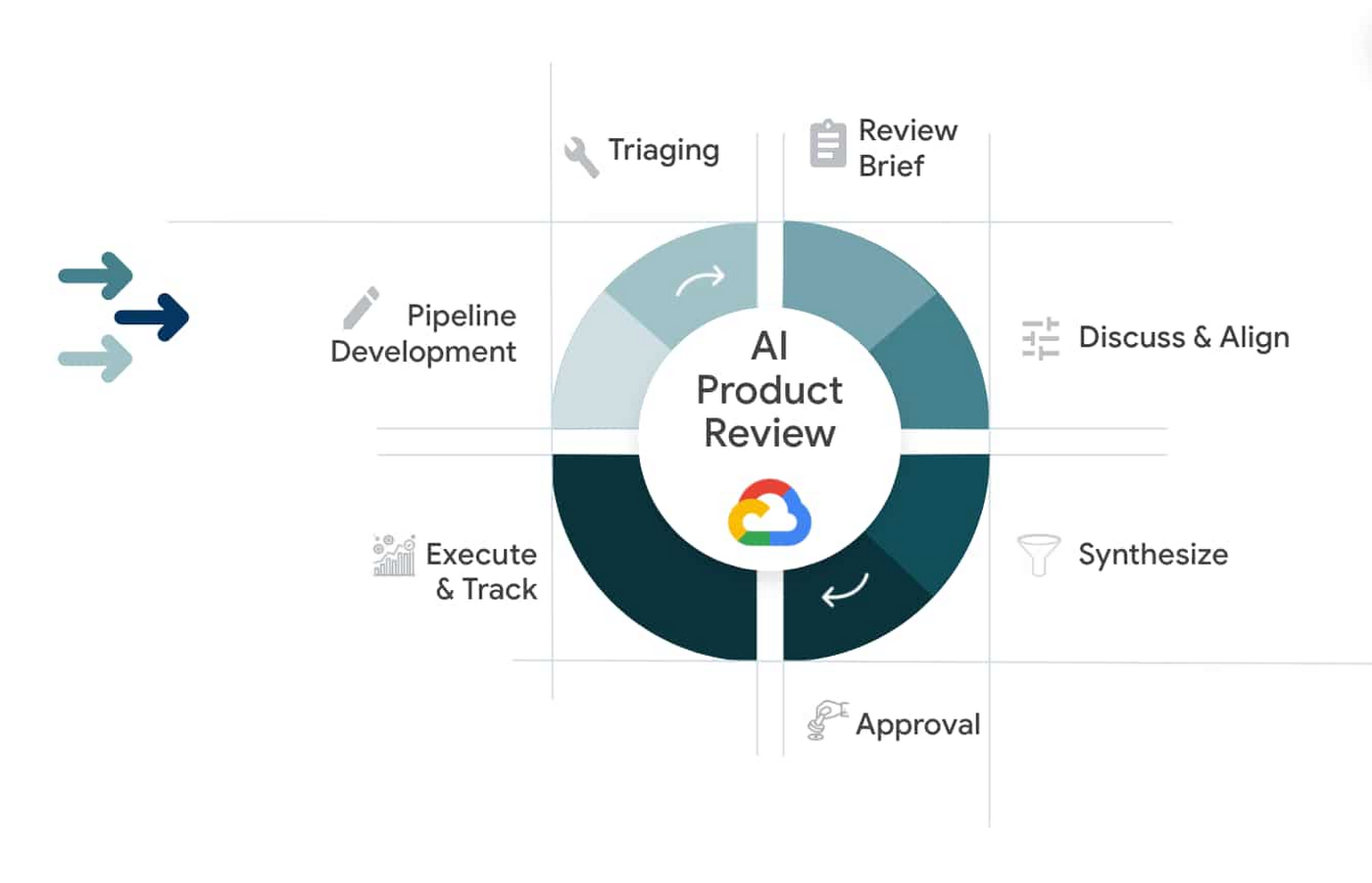

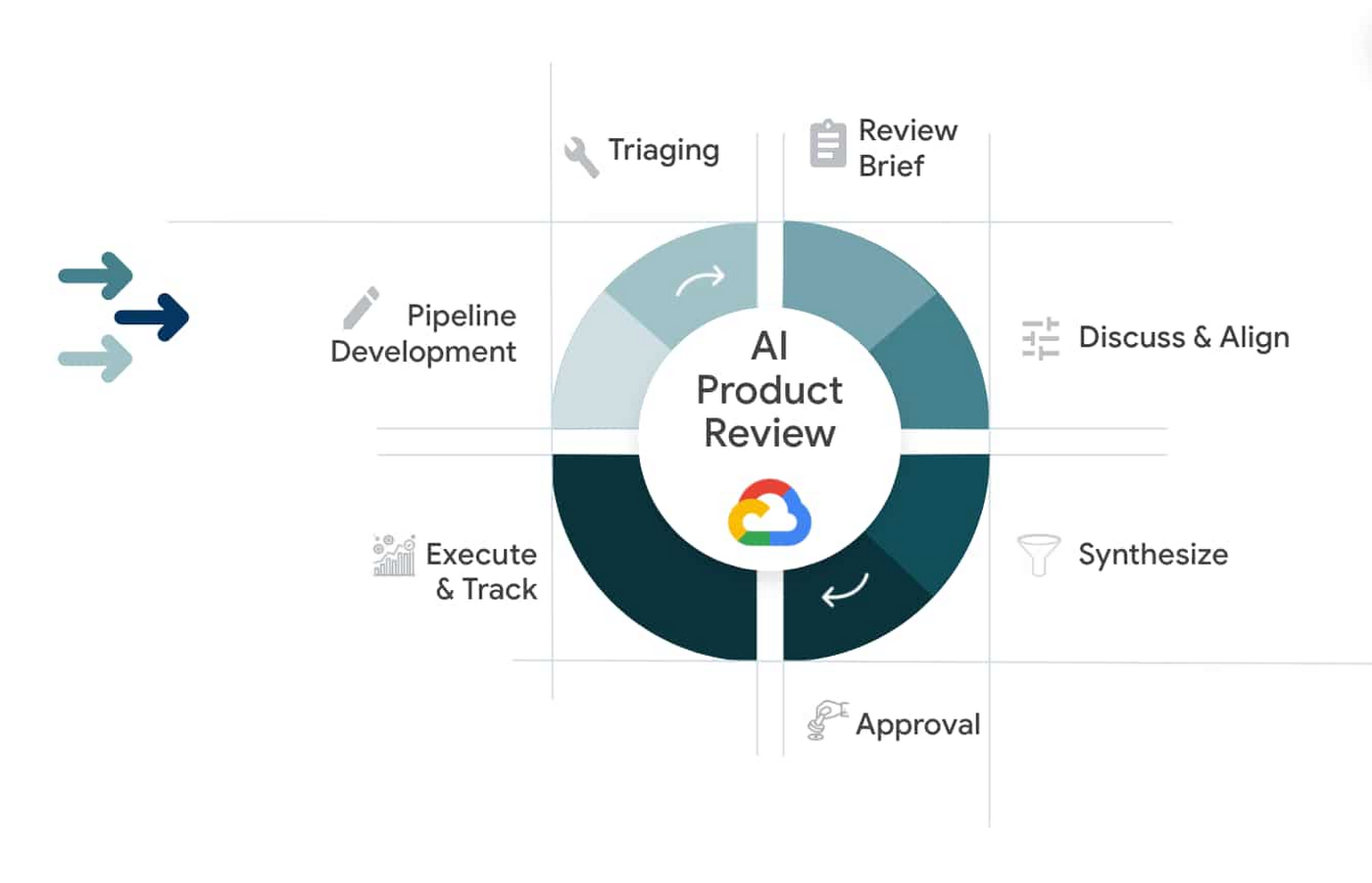

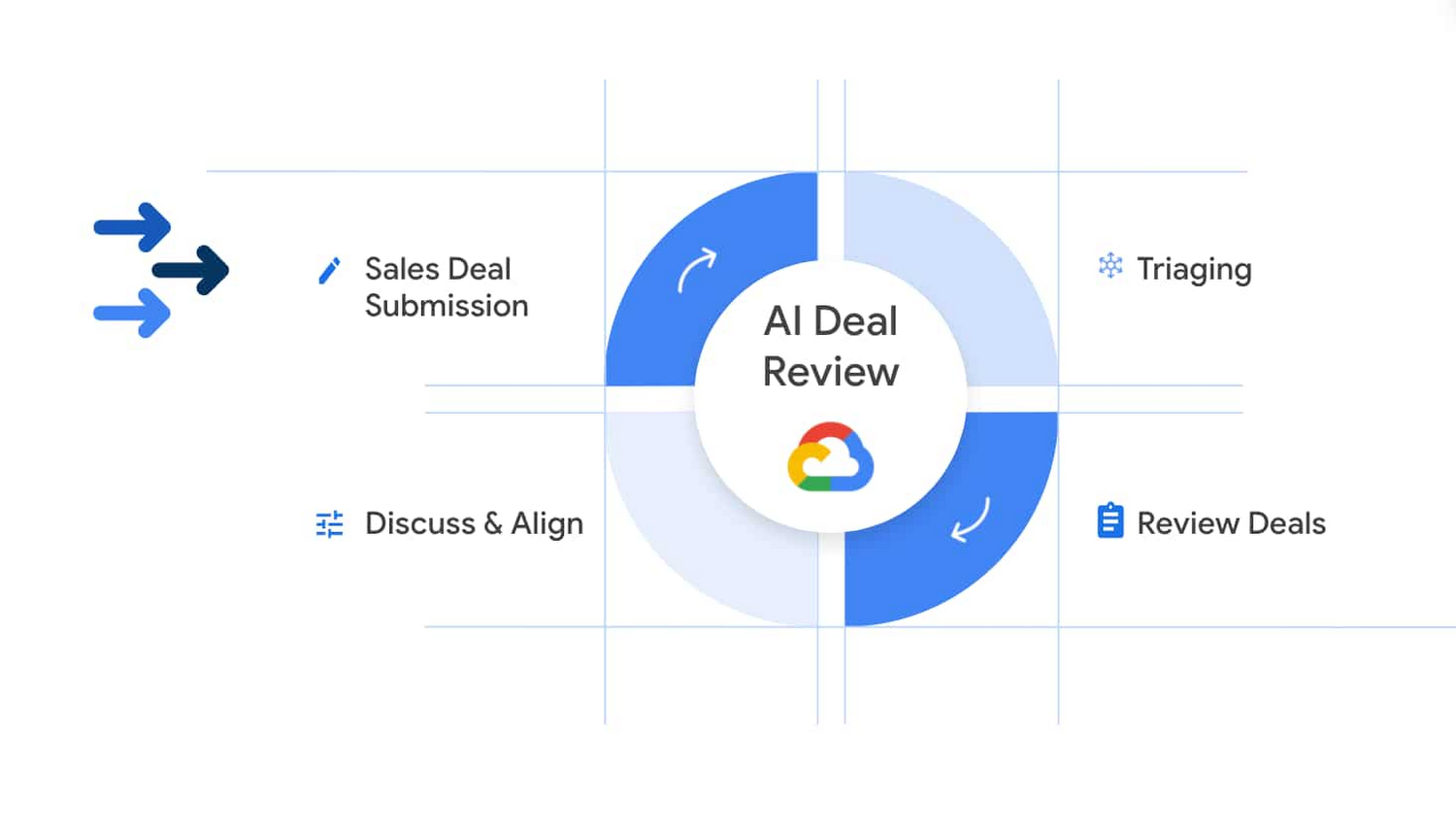

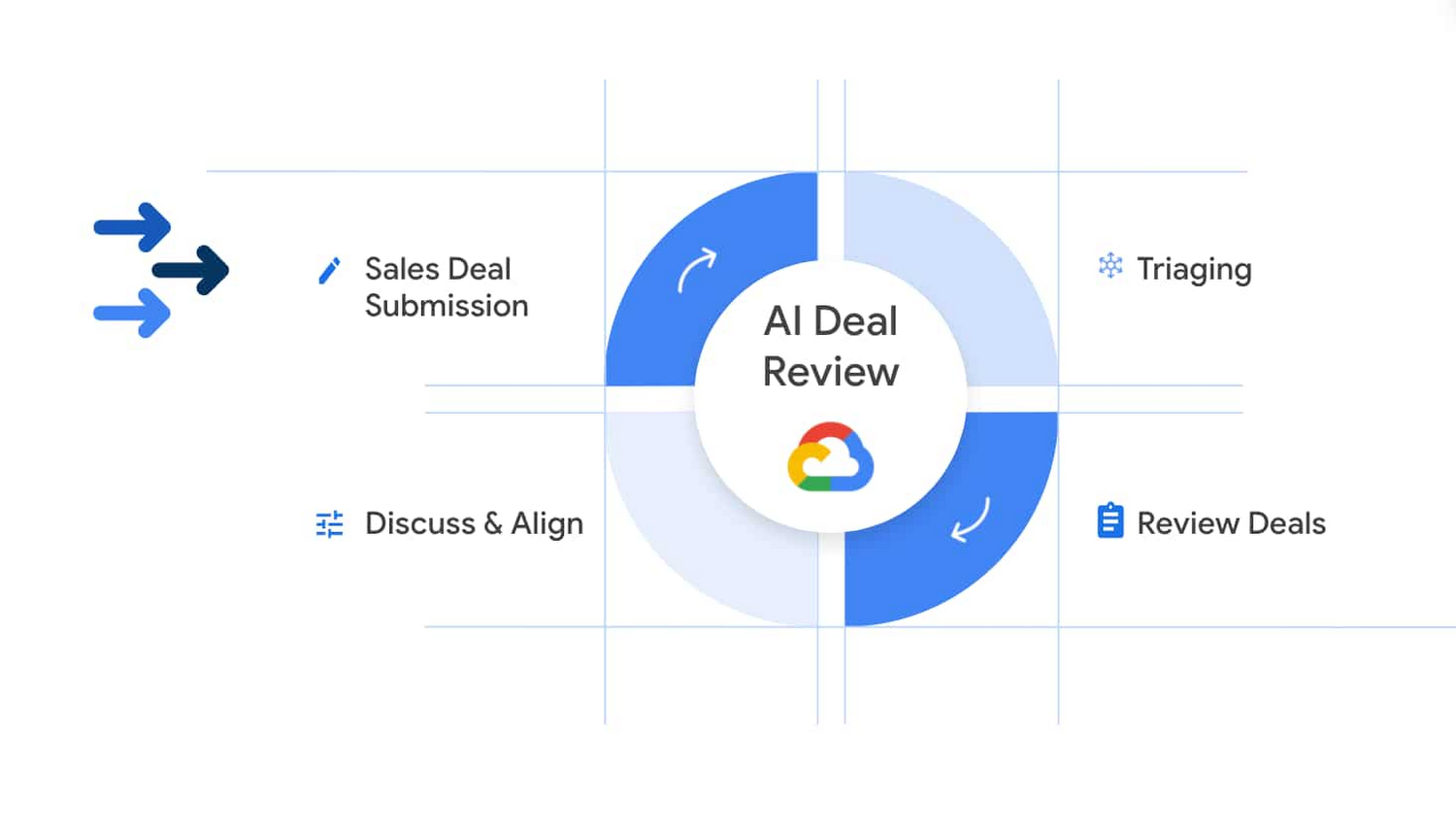

クラウドについては、2 つの独立したレビュー プロセスが作成されています。このレビュー プロセスの 1 つは、高度なテクノロジーを使用して構築される製品に特化したもので、もう 1 つは Google で一般提供されている製品の枠を超えたカスタム作業が関わる、初期段階の取引に特化したものです。

Google の製品開発の同期

高度なテクノロジーが関与する新しい製品やサービスや、このプロセスを開始するときすでに一般提供されていた類似の製品やサービスを開発するときは、厳格で深遠な倫理的分析を行い、それぞれの原則にわたってリスクと機会を評価し、堅牢なライブレビューを行います。これには難しい会話が含まれることがありますが、多くの場合新しい考えを呼び起こすことにもなります。私たちは、機械学習の公平性、暗黙的なバイアス、Google 自身の経験が AI による影響の可能性と大きく異なる可能性、その他 Google がその製品を推進するかどうかの決定に影響する可能性のある他の考慮事項などの、重要で困難なトピックについて自由に話し合います。レビューチーム間での心理的な安全性を生み出して維持し、すべての意見とトピックが聞き入れられ、評価されることを保証するため、多くの時間を費やします。これらのレビューにより、長期的には、望んだのと逆の結果になる可能性について難しい話し合いを行いやすくなり、予防のための作業も行えるようになるのです。

カスタム AI を使用してお客様の取引を同期する

Google は、締結よりずっと前の初期段階で商業取引のレビューも行い、これにはクライアント用のカスタム AI の構築が関与します。 Google は、プロジェクトにおいて、高度なテクノロジーが Google の AI 原則に違反する形で使用される可能性があるかどうかを、初期段階で判定します。

Google が自社の評価において技術を構築し、長期的に「判例法」を開発して、どこまでが Google の責任範囲なのかを決定するため慎重に考慮するにつれ、Google は自社のエンゲージメント レビューの範囲内、または範囲外と考える作業を繰り返し行ってきました。Google は一般提供されている製品の詳細レビューを行い、それぞれについて調整計画を作成してきたため、固有やカスタムのユースケースに一般提供されている製品をどのように適用するかという部分に取引レビューを集中できました。

Google の製品レビューによりロードマップとベスト プラクティスが明白に

これらのレビューにより今後についてさまざまな道が考えられます。Google は製品の範囲を狭く定義し、特定のユースケースと汎用 API に集中することも考えられます。 たとえば、Google は顔面認識の手法として、範囲を狭めて十分に調査された実装である Celebrity Recognition API を設計しました。他の軽減措置として、Model Card や、Google の インクルーシブ ML ガイドのようなより特定の実装など、立ち上げに結び付けられた教育資料やベスト プラクティスも考えられます。場合によっては、Google はポリシーや利用規約を実装し、また別の場合にはその製品の推進自体を中止することもあります。

Google は過去数年間にわたって、多くのベスト プラクティスを開発しており、私は独自の原則の設定を目指している他の組織と協力するとき、多くの場合にこれらのベスト プラクティスを共有してきました。ベスト プラクティスには次のようなものがあります。

- 倫理的なチェックリストを使用しない。意思決定ツリーを作成し、良いことと悪いことを簡単に区別できるようにするのは魅力的に思えます。私自身もこれを試みましたし、私が知っている限り、このような原則を作成しようとするほとんどの人もこれを試みています。残念ながら、それは不可能です。同期の決定の手引きとなるのは、テクノロジー、データ、ユースケース、およびそれらをどこで、どのように適用するかの交点であり、似ているものであっても、決して同じものではありません。

- 設計による責任。Google は開発ライフサイクルの早期段階で詳細レビューを行っており、これは同期を保証するために不可欠であることが証明されています。

- 入力の多様性。Google のレビュー委員会の常任委員は Google 全体にわたり、技術的およびそれ以外を含む多様な職務にまたがっています。複数のメンバーには社会科学、哲学、倫理学の経歴があります。これらのメンバーは意図的に複数のレベルとして、職歴の浅い者から上級エグゼクティブまでが含まれています。社内外からの入力も重要視しています。これは特に、私たち自身の経験だけでは決定を明確に行えない場合に大切なものです。社外の特定分野の専門家や、影響を受ける人々からの直接入力も鍵となります。たとえば、人権影響評価(Human Rights Impact Assessments) は BSR などの組織から、Google の人権活動の要素として提供されるもので、Google に非常に役立っています。あらゆる意見が聞き入れられると保証することは絶対に必要ですが、容易に行えるとは限りません。

- サポートの文化。トップレベルの指示は不可欠ですが、それだけで十分ではありません。組織全体にわたる文化的な展開が鍵となります。これは部分的には、技術的な倫理のトレーニングにより、価値中立と信じられているテクノロジーと倫理とを積極的に結合することで行われます。このような変換的なテクノロジーが有害である可能性について語るのは、場合によっては不快なことですが、たとえ困難であってもそれをモデル化し、コミットメントを構築することは重要です。

- 透過性。これらの原則と実践が存在する理由の中核は信頼です。あらゆる決定を透過的にすることは、プライバシーへのコミットメントの関係上不可能ですが、このレベルの透過性は不必要と考えられます。行われるすべての決定が満場一致の承認を受けるような世界は存在しません。それは何も問題はありません。Google が目標としているのは、決定をどのように行うかを理解することで、これによって意見の不一致の中にさえも信頼を築き上げることができます。

- 謙虚な手法。AI は迅速に変化しつつあり、私たちの世界も静的なものではありません。Google は、常に学習し続けることを忘れないようにしています。製品が完全なものであると認定するのは達成不可能な目標ですが、改良は常に行うことができます。Google は長期的に、Cloud Vision API からジェンダーのラベルを削除するなどの困難な決定を行います。これらの変更は、社内と社外の両方に対して説明が困難なものですが、Google は高度なテクノロジーの複雑な現実を尊重するよう心がけています。

- 作業は(簡単に)測定できません。原則の同期は多くの場合に定量化できず、主観的で、文化的に相対的で、明確に定義できないものです。しかし、Google が活動を行うのはまさに、このような課題が存在することが理由です。

Google は、この作業に確固として取り組んでいます。

テクノロジーの設計の中心にあるのも、それにより影響を受けるのも人間です。そして人間の行う決定は、常にすべての人々の要求に即したものではありません。その意味を明確に示すため 2 つの例を挙げましょう。これらはいずれも修正されたものです。

- 2011 年まで、自動車メーカーは女性の身体を表現したクラッシュ テスト用人形を使用する義務はありませんでした。その結果、自動車事故において女性が重傷を負う確率は、男性より 47% 高くなっていました3。

- 数十年にわたり、粘着性の包帯、パンティストッキング、さらにクレヨンも白人の肌色を基準として設計されていたため、肌の色が濃い人々は肌の色に合わせることを意図された薄ピンク色のバンドエイドや、肌色を明るくするヌード ストッキングを使うことを強いられ、「肌色の」クレヨンは実際には桃色のトーンのものだけでした。

製品とテクノロジーはすべての人のためのものであるべきです。多くの要因により不当なバイアスが発生することがあり、Google はこれらの根本原因を解明し、対話するための作業を行っています。これには、データに入り込んだ社会的なコンテキストを入力として使用することも含まれます。

Google の製品とサービスは社会と無関係に存在するわけではありせん。Google は、自社の方針において社会的なコンテキストを考慮し、単なる技術的な分析に留まらないものとするよう努力しています。Google は傷害の可能性を識別し、それらを軽減または回避するともに、すべての人々にテクノロジーの恩恵を最大限にもたらせるよう最大限に努力しています。

責任ある AI は Google Cloud の Next OnAir バーチャル会議の主要なテーマで、私のセッションでは責任ある AI を実際に使用するためのベスト プラクティスと使用例を中心にご紹介します。

1. McKinsey & Company、「Notes from the AI Frontier Modeling the Impact of AI on the World Economy」(2018 年 9 月)

2. Capgemini、「Organizations must address ethics in AI to gain public's trust and loyalty」(2019 年 7 月)

3. https://www.ncbi.nlm.nih.gov/pmc/articles/PMC3222446/

-Cloud AI プロダクト戦略およびオペレーション担当ディレクター Tracy Frey