Vertex AI RAG Engine の概要: Vertex AI RAG パイプラインを自信を持ってスケールする

Crispin Velez

Global AI incubation, Google

Lewis Liu

Group Product Manager, Google Cloud

※この投稿は米国時間 2025 年 1 月 10 日に、Google Cloud blog に投稿されたものの抄訳です。

企業向け生成 AI のデプロイを成功させるには、モデルを使用した素晴らしいデモと現実のパフォーマンスとのギャップを埋めることがきわめて重要です。企業向け生成 AI には驚くべき機能が備わっているにもかかわらず、よく知られたこのギャップが、多くの開発者や企業にとって AI を「製品化」する障壁となっている可能性があります。そこで、検索拡張生成(RAG)が不可欠になります。RAG は AI 出力への信頼を構築することにより、エンタープライズ アプリケーションを強化します。

このたび、Vertex AI の RAG Engine の一般提供を開始しました。これは、データとメソッドを使用して RAG 実装を構築およびデプロイするのに役立つフルマネージド サービスです。Vertex AI RAG Engine には、次のメリットがあります。

-

どのアーキテクチャにも適応: ユースケースに最適なモデル、ベクトル データベース、データソースを選択できます。この柔軟性により、RAG Engine は既存のインフラストラクチャに適応できるため、ユーザーが RAG Engine への適応を求められることはありません。

-

ユースケースに合わせて進化: 構成に簡単な変更を加えることで、新しいデータソースの追加、モデルの更新、取得パラメータの調整を行えます。システムは需要に応じて拡張可能で、整合性を維持しながら新たな要件に対応できます。

-

シンプルな評価方法: 構成が異なる複数の RAG エンジンを設定し、ユースケースに最適な構成を見つけられます。

Vertex AI RAG Engine の概要

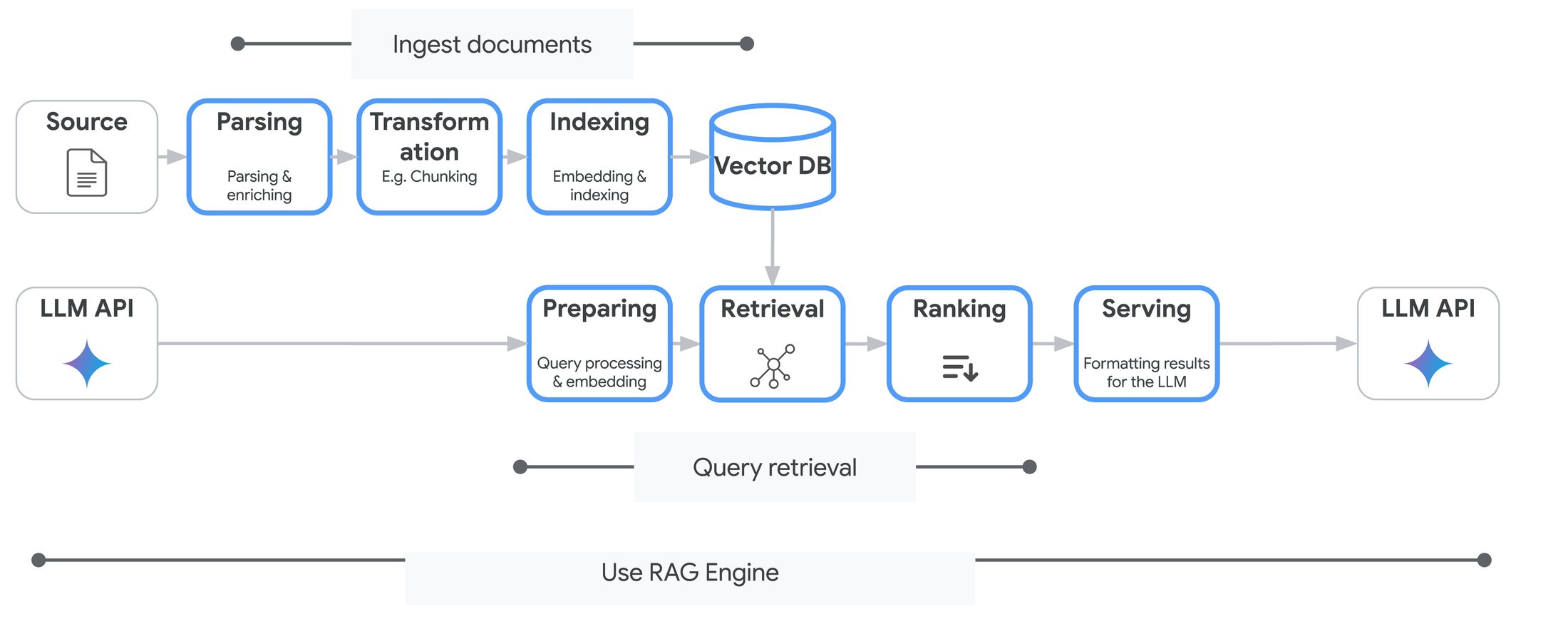

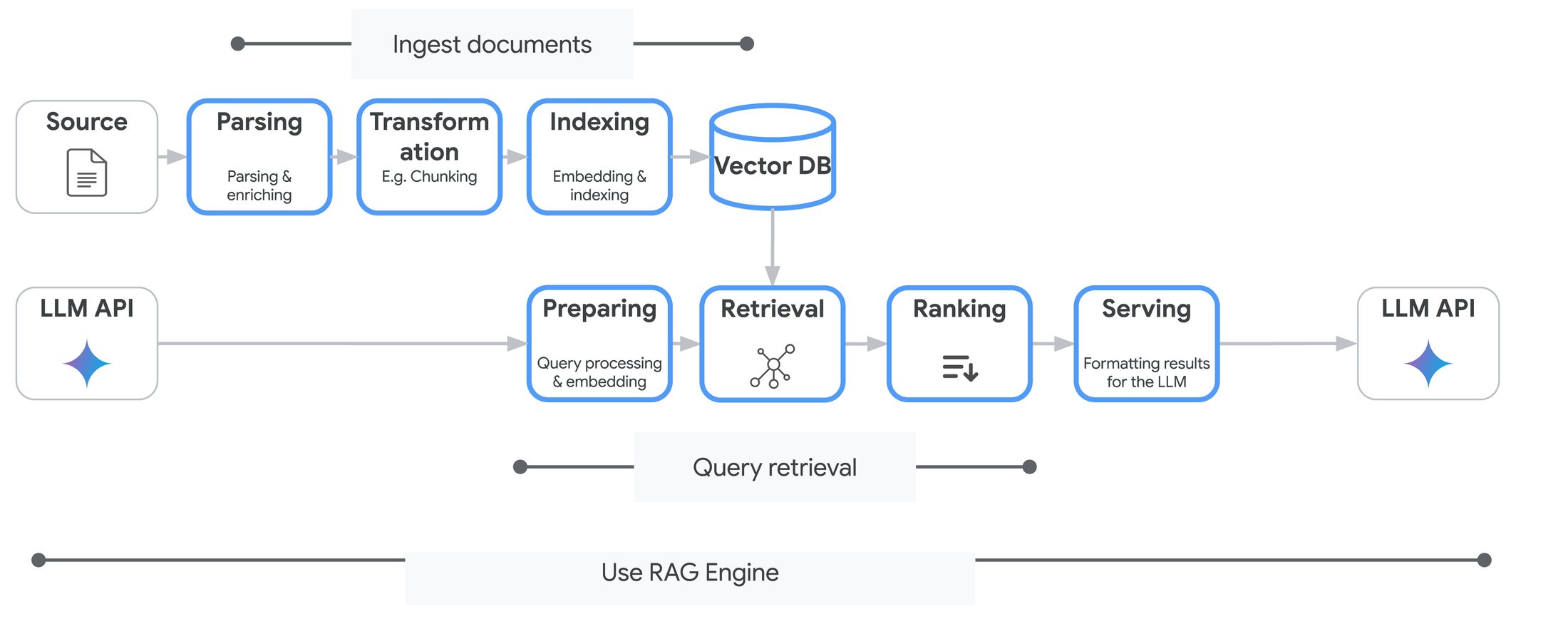

Vertex AI RAG Engine は、データとメソッドを使用して RAG 実装を構築およびデプロイできるマネージド サービスです。それはまるで、効率的なベクトル ストレージ、インテリジェントなチャンキング、最適な取得戦略、正確な拡張といった複雑なインフラストラクチャの課題をすでに解決した専門家のチームを持つようなもので、特定のユースケースに合わせて設定をカスタマイズできます。

図 1: Vertex AI RAG Engine のワークフロー。

Vertex AI の RAG Engine は、多様なニーズを満たす幅広いオプションを備えた、活気のあるエコシステムを提供します。

-

DIY 機能: DIY RAG を使用すると、ユーザーはさまざまなコンポーネントをうまく組み合わせてソリューションをカスタマイズできます。簡単に使い始められる API が用意されているため、複雑さの程度が低いか中程度のユースケースに最適であり、数回クリックするだけで迅速なテスト、概念実証、RAG ベースのアプリケーション構築が可能になります。

-

検索機能: Vertex AI Search は、堅牢なフルマネージド ソリューションとして際立っています。高品質の機能を簡単に使い始めることができるうえ、最小限のメンテナンスですむため、シンプルなユースケースから複雑なユースケースまで幅広く対応できます。

-

コネクタ: サポート対象のコネクタが急速に増え続けているため、Cloud Storage、Google ドライブ、Jira、Slack、ローカル ファイルなどのさまざまなデータソースにすばやく接続できます。RAG Engine は、直感的なインターフェースを通じて、取り込みプロセス(複数のソースの場合でも)を処理します。

-

高いパフォーマンスとスケーラビリティ: Vertex AI Search は、非常に短いレイテンシで大量のデータを処理できるよう設計されています。これにより、複雑であったり広範なナレッジベースを扱うときには特に、RAG アプリケーションの応答時間が短縮され、パフォーマンスが向上します。

-

シンプルなデータ マネジメント: ウェブサイト、BigQuery データセット、Cloud Storage バケットなどのさまざまなソースからデータをインポートして、データの取り込みプロセスを効率化できます。

-

LLM 出力品質の向上: Vertex AI Search の検索機能を使用することにより、RAG アプリケーションがコーパスから最も関連性の高い情報を確実に取得できるようになり、より正確で有益な LLM 生成出力が得られます。

カスタマイズ

Vertex AI の RAG Engine の決定的な強みの一つは、カスタマイズできる範囲の広さです。この柔軟性により、さまざまなコンポーネントを微調整して、データとユースケースに完全に適合させることが可能になります。

-

解析: ドキュメントがインデックスに取り込まれると、チャンクに分割されます。RAG Engine は、チャンクサイズやチャンク オーバーラップを調整する機能と、異なる種類のドキュメントをサポートするためのさまざまな戦略を提供します。

-

取得: すでに Pinecone を使用している場合もあれば、Weaviate のオープンソース機能を使いたいと考えている場合もあるでしょう。あるいは、Vertex AI ベクトル検索や Vector データベースを活用したいと考える場合もあるでしょう。どれを選択した場合も、RAG Engine はそれに応じて動作しますが、必要に応じてベクトル ストレージを完全に管理することもできます。この柔軟性により、ニーズが進化しても単一のアプローチに縛られることがなくなります。

-

生成: Vertex AI Model Garden では、Google の Gemini、Llama、Claude など、数百もの LLM から選択できます。

Gemini で Vertex AI RAG をツールとして使用する

Vertex AI の RAG Engine は、ツールとして Gemini API とネイティブに統合されているため、RAG を使用してコンテキストに応じた関連性の高い回答を提供する、根拠に基づいた会話を作成できます。取得するドキュメントの数や LLM ベースのランカーの使用など、特定の設定で構成された RAG 取得ツールを初期化するだけです。その後、このツールは Gemini モデルに渡されます。

Vertex AI Search をリトリーバーとして使用する:

Vertex AI Search は、Vertex AI RAG アプリケーション内でデータを取得および管理するためのソリューションを提供します。Vertex AI Search を取得バックエンドとして使用することにより、パフォーマンス、スケーラビリティ、統合しやすさを向上させることができます。

-

高いパフォーマンスとスケーラビリティ: Vertex AI Search は、非常に短いレイテンシで大量のデータを処理できるよう設計されています。これにより、複雑であったり広範なナレッジベースを扱うときには特に、RAG アプリケーションの応答時間が短縮され、パフォーマンスが向上します。

-

シンプルなデータ マネジメント: ウェブサイト、BigQuery データセット、Cloud Storage バケットなどのさまざまなソースからデータをインポートして、データの取り込みプロセスを効率化できます。

-

シームレスな統合: Vertex AI には Vertex AI Search との統合が組み込まれているため、RAG アプリケーションのコーパス バックエンドとして Vertex AI Search を選択できます。これにより、統合プロセスが簡素化され、コンポーネント間の最適な互換性が確保されます。

-

LLM 出力品質の向上: Vertex AI Search の検索機能を使用することにより、RAG アプリケーションがコーパスから最も関連性の高い情報を確実に取得できるようになり、より正確で有益な LLM 生成出力が得られます。

使ってみる

Vertex AI の RAG Engine には、Vertex AI Studio を通じてアクセスできます。利用を開始するには、Google Cloud コンソールにアクセスするか、ガイド付きの概念実証について Google にお問い合わせください。または、RAG クイック スタート ドキュメントを参照するか、Vertex AI RAG Engine GitHub リポジトリをご覧ください。