GKE 上の NVIDIA BioNeMo Framework と Blueprint を使用してヘルスケアにおける AI を加速

Sujit Khasnis

Staff Solutions Architect, Partner Engineering

Neel Patel

Ph.D., Technical Marketing Engineer, NVIDIA

※この投稿は米国時間 2025 年 3 月 19 日に、Google Cloud blog に投稿されたものの抄訳です。

医療における新しい治療法の開発は、10 年にわたる開発サイクルで数十億の分子化合物をスクリーニングするという、時間のかかる困難なプロセスでした。治療薬候補の大半は、臨床試験をクリアすることさえできません。

そうした状況の中、AI がこのタイムラインを劇的に加速させようとしています。

NVIDIA と Google Cloud は、幅広い業界にまたがるコラボレーションの一環として、生成 AI アプリケーションとプラットフォームの開発をサポートしてきました。NVIDIA BioNeMo は、医学および薬学研究者のニーズに合わせて特別に調整された、パワフルなオープンソースのモデル コレクションです。

あらゆる規模の医療機関やバイオ医薬品企業は、この分野に革新をもたらすために、予測モデルと AI 基盤モデルに注目しています。AI を活用して、潜在的な医薬品候補の特定と最適化を加速させ、開発のタイムラインを大幅に短縮するとともに、満たされていない医療ニーズに対応しようとしています。これは、DNA、RNA、タンパク質の配列や化学物質の解析、分子間相互作用の予測、新しい治療薬の設計を大規模に行ううえで重要な転換点となっています。

BioNeMo により、この分野の企業は、時間のかかる実験手法への依存を減らしつつ、データドリブンのアプローチで医薬品の開発を行うことができます。ただし、こうした飛躍的な進展には独自の課題が伴います。生成 AI による医療への移行には、堅牢な技術スタックが必要です。たとえば、モデルの構築、スケール、カスタマイズのためのパワフルなインフラストラクチャ、効率的なリソースの利用、より高速なイテレーションのためのアジリティ、フォールト トレランス、分散ワークロードのオーケストレーションなどです。

Google Kubernetes Engine(GKE)は、このような要求の厳しいワークロードの多くを実現するためのパワフルなソリューションを提供します。GKE を NVIDIA BioNeMo と組み合わせることで、プラットフォームでの作業を加速できます。BioNeMo を GKE で運用することにより、組織はこれまでにないスピードと効果で、医療のブレークスルーと新しい研究を達成できます。

このブログでは、GKE 上の NVIDIA BioNeMo プラットフォームを使用してモデルを構築、カスタマイズし、リファレンス ブループリントを起動する方法をご紹介します。

GKE 上の NVIDIA の BioNeMo プラットフォーム

NVIDIA BioNeMo は、研究者が生物学的配列や構造をモデル化し、シミュレートできるようにする生成 AI フレームワークです。そのため、パワフルな GPU によるコンピューティング、大規模なデータセットや複雑なモデルを処理するためのスケーラブルなインフラストラクチャ、ストレージ、ネットワーキング、セキュリティのための堅牢なマネージド サービスが求められます。

GKE は、AI や ML、特にバイオ医薬品の研究開発に見られるような要求の厳しいワークロードに最適かつスケーラブルで柔軟なプラットフォームを提供します。GKE の自動スケーリング機能は、リソースの効率的な利用を保証し、他の Google Cloud サービスとのインテグレーションにより AI ワークフローを簡素化します。

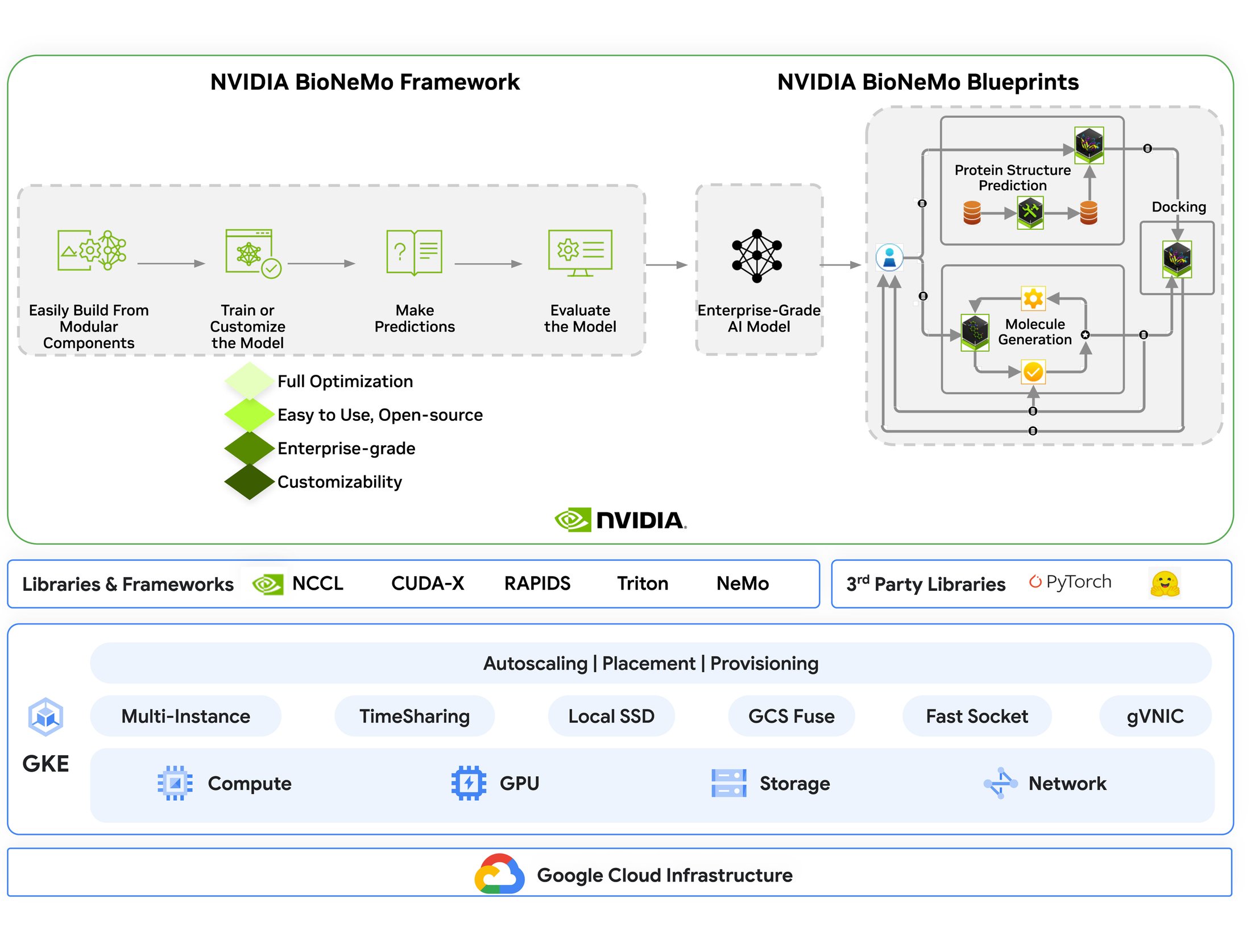

NVIDIA の BioNeMo プラットフォームは、2 つの相乗効果のあるコンポーネントを提供します。

1. BioNeMo Framework: 創薬 AI の大規模トレーニング プラットフォーム

ESM-2 や Evo2 などの生体分子 AI モデル向けのスケーラブルなオープンソースのトレーニング システムであり、生体分子 AI モデルのトレーニングとファインチューニングに最適化された環境を提供します。NVIDIA NeMo と PyTorch Lightning を基盤として構築されており、次のような機能を備えています。

-

ドメイン固有の最適化: 創薬ワークフローに合わせた CUDA アクセラレーテッド ツールで構築された代表的なモデル例(ESM-2、Geneformer など)とともに、数十億のパラメータにスケールできる高性能な生体分子 AI アーキテクチャ(BERT、Striped Hyena など)を提供します。

-

GPU による高速処理: NVIDIA GPU とのネイティブかつ大規模なインテグレーションにより、大規模言語モデルや予測モデルのトレーニング時間を短縮し、業界をリードする速度を実現します。

-

包括的なオープンソース リソース: プログラミング ツール、ライブラリ、パッケージ化済みデータセット、そして研究者やデベロッパーの生体分子 AI ソリューションの導入をサポートする詳細なドキュメントを含みます。

詳細については、こちらのプレプリントをご覧ください。

2. BioNeMo Blueprint: 創薬のための本番環境対応ワークフロー

BioNeMo Blueprint は、タンパク質バインダーの設計、仮想スクリーニング、分子ドッキングなどのタスクにすぐに使用できるリファレンス ワークフローを提供します。このワークフローには、AlphaFold2、DiffDock 2.0、RFdiffusion、MolMIM、ProteinMPNN などの高度な AI モデルが統合されており、創薬プロセスを加速させます。こうしたブループリントは、他の業界のユースケースで識別されたパターンに対するソリューションを提供します。科学分野のデベロッパーは、build.nvidia.com で NVIDIA 推論マイクロサービス(NIM)を試用し、NVIDIA デベロッパー ライセンスを通じて NIM にアクセスしてテストできます。

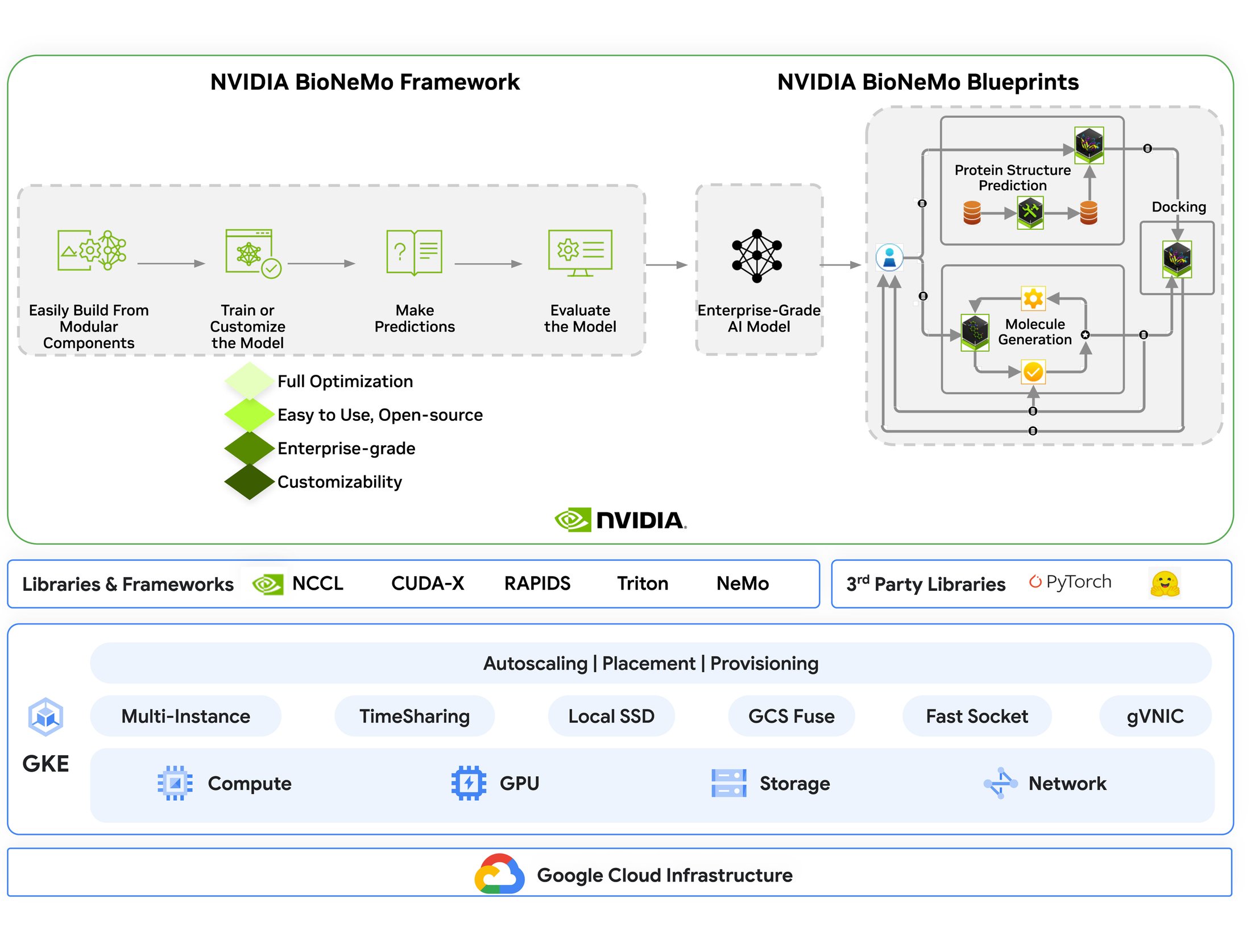

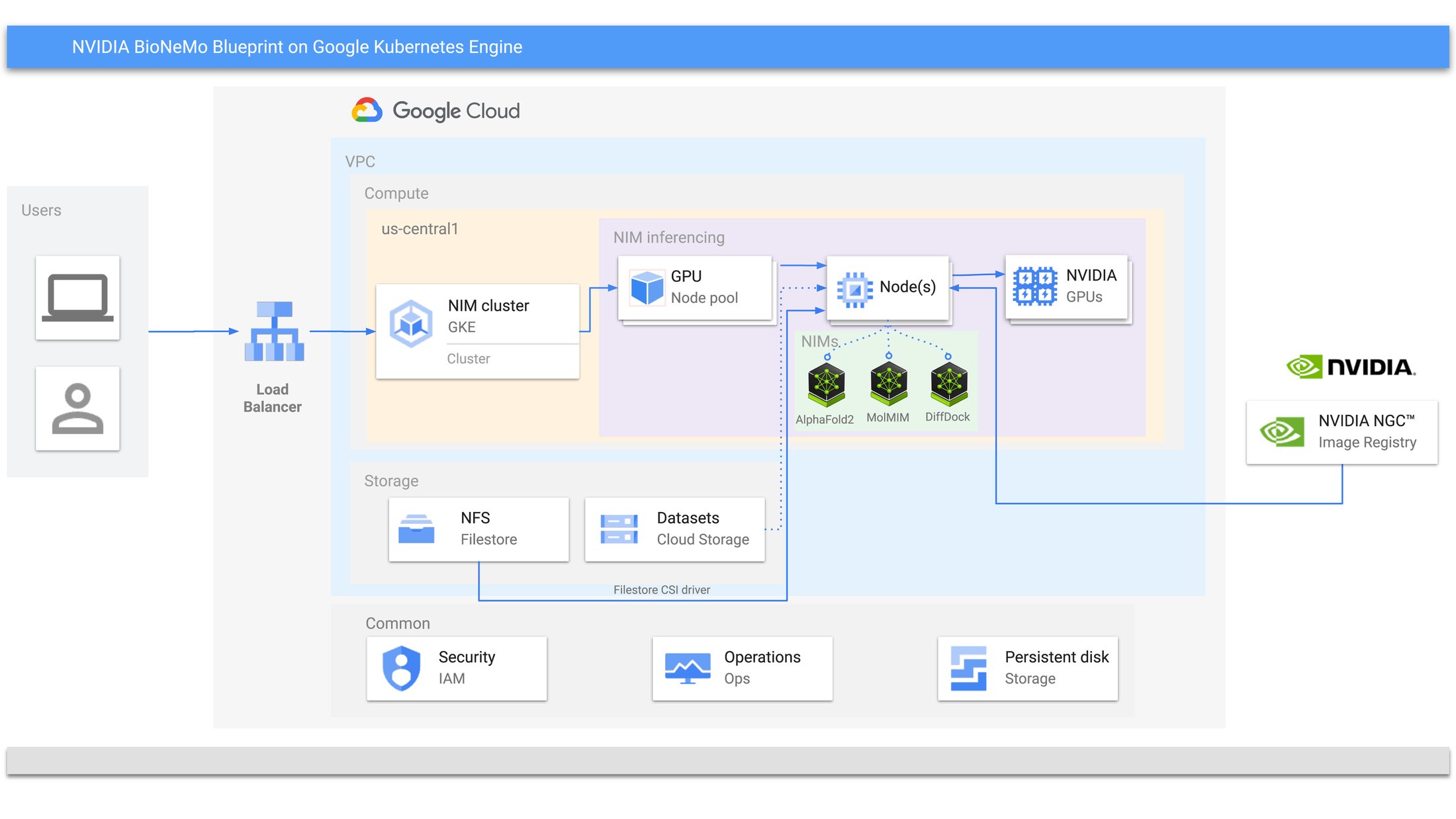

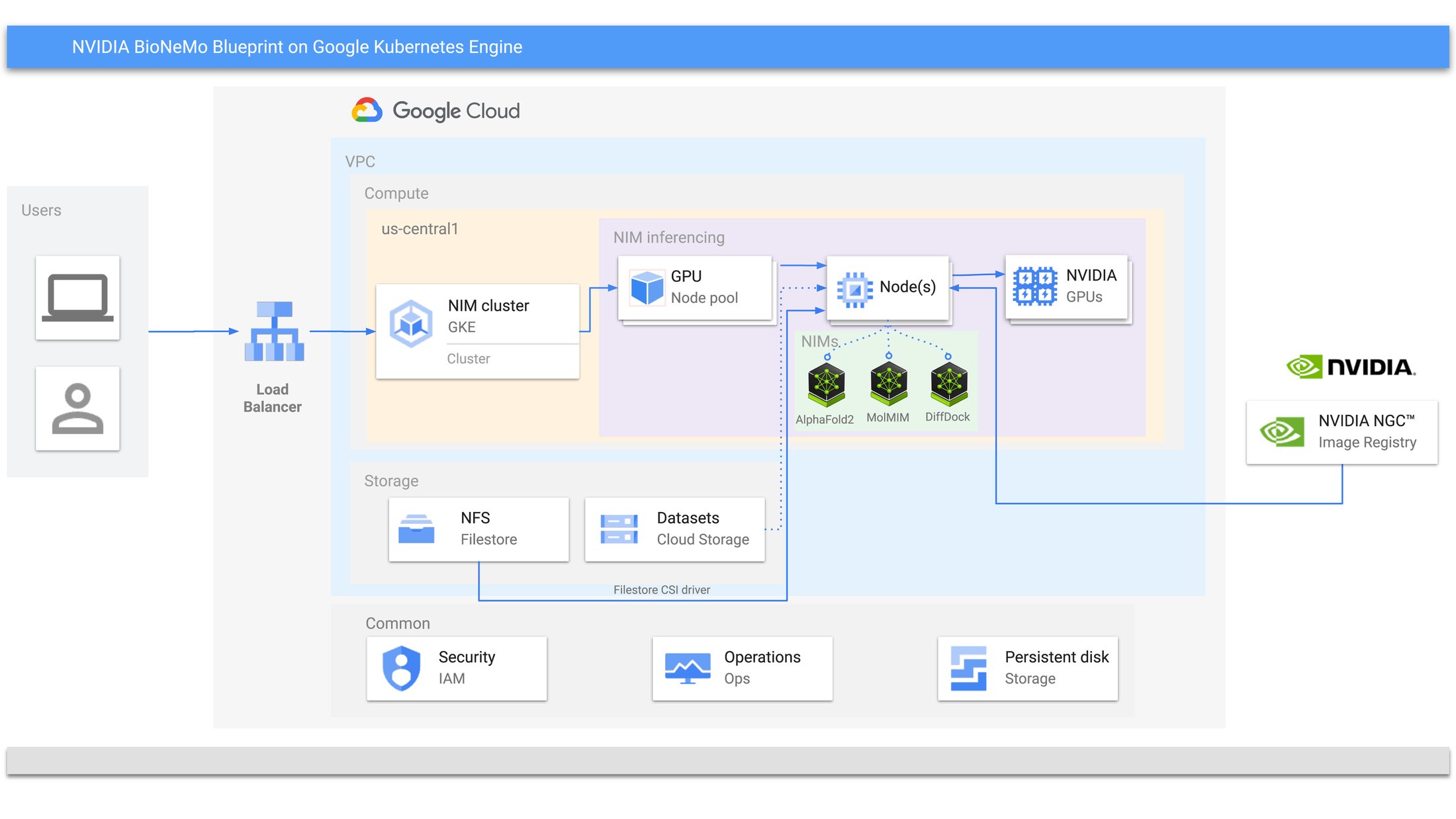

次の図は、BioNeMo プラットフォームで使用される GKE のコンポーネントと機能を示しています。このブログでは、NVIDIA のドメイン固有の AI ツールと Google Cloud のマネージド Kubernetes インフラストラクチャを組み合わせて、以下を実現するために GKE 上にこれらのコンポーネントをデプロイする方法を示します。

-

NVIDIA GPU クラスタ全体にわたるモデルの分散型事前トレーニングとファインチューニング

-

NIM を使用したブループリント主導のワークフロー

-

GKE の動的なノードプールとプリエンプティブル VM によるコスト最適化スケーリング

図 1: GKE 上の NVIDIA BioNeMO Framework と BioNeMo Blueprint

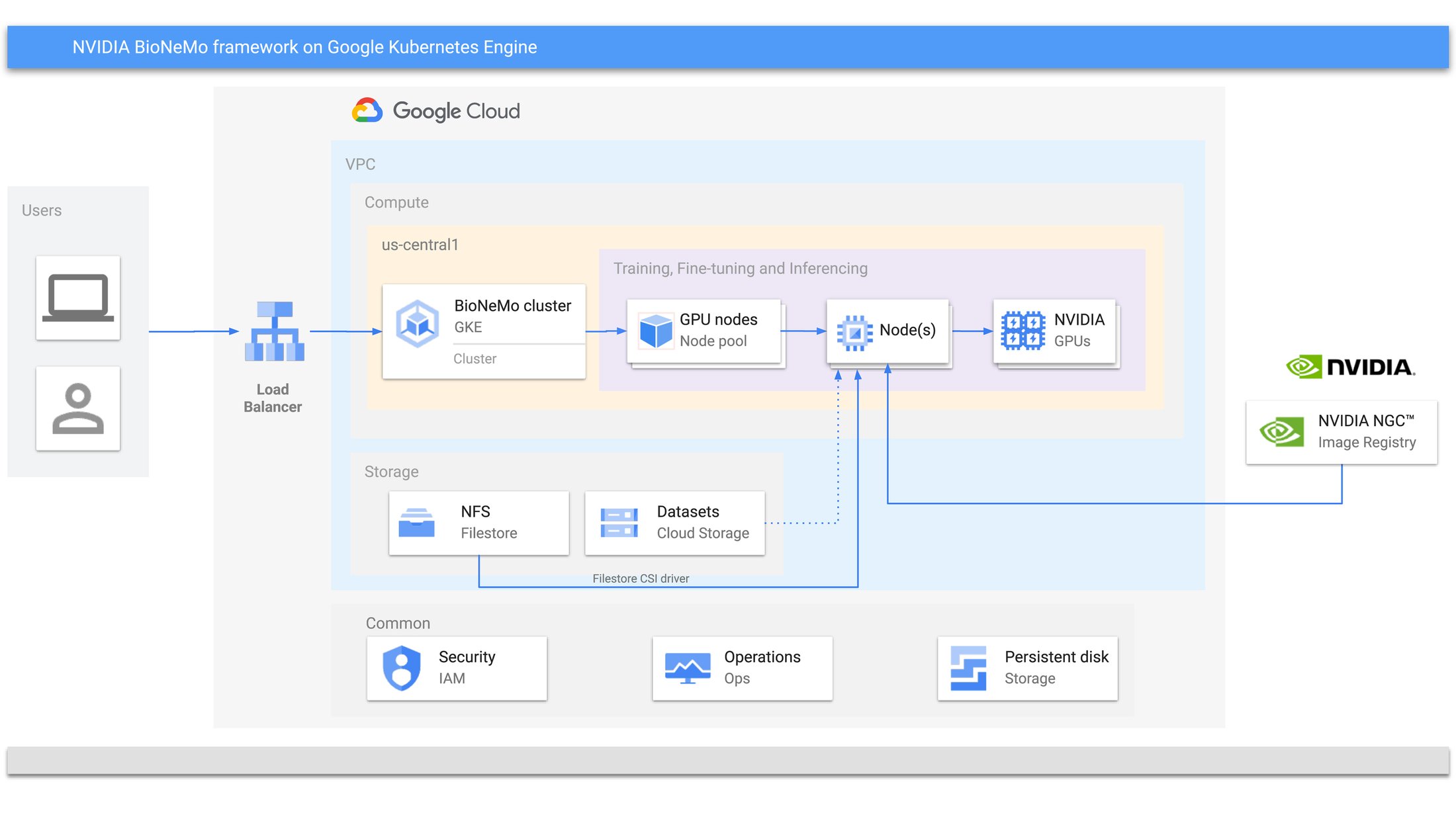

BioNeMo Framework のソリューション アーキテクチャ

ここでは、ESM2 の事前トレーニングとファインチューニングを実行するために、GKE で BioNeMo Framework を設定する手順を説明します。

図 2: GKE 上の BioNeMo Framework

上記の図は、AI モデルの事前トレーニング、ファインチューニング、推論のために GKE に NVIDIA BioNeMo Framework をデプロイするアーキテクチャの概要を示しています。以下は、アーキテクチャの観点から見た各基本要素です。

-

GKE: BioNeMo Framework のデプロイとスケーリングを管理するコントロール プレーンを含むコア オーケストレーション プラットフォーム。これはリージョン クラスタとしてデプロイされ、ゾーンクラスタとして構成することもできます。

-

ノードプール: GKE クラスタ内のワーカーノードのグループ。AI ワークロードを高速化するために NVIDIA GPU で特別に構成されています。

-

ノード: ノードプール内の個々のマシンに NVIDIA GPU を搭載。

-

NVIDIA BioNeMo Framework: GKE 内で実行される AI ソフトウェア プラットフォーム。AI モデルの事前トレーニング、ファインチューニング、推論を可能にします。

-

ネットワーキング:

-

Virtual Private Cloud(VPC): GCP 内の論理的に隔離されたネットワーク。リソース間の安全な通信を保証します。

-

ロードバランサ: GKE クラスタ内で実行されている BioNeMo サービスに受信トラフィックを分散し、可用性とスケーラビリティを向上させます。

-

ストレージ:

-

Filestore(NFS): データセットとモデルのチェックポイントに高パフォーマンスのネットワーク ファイル ストレージを提供します。

-

Cloud Storage: データセットやその他の大容量ファイルを保存するためのオブジェクト ストレージ。

-

NVIDIA NGC Image Registry: BioNeMo と関連ソフトウェアのコンテナ イメージを提供し、一貫性のある最適化されたデプロイを実現します。

ステップ

GitHub の「Pretraining and Fine-tuning ESM-2 LLM on GKE using BioNeMo Framework 2.0」リポジトリに、GKE 内で BioNeMo Framework を使用して ESM-2 モデルの事前トレーニング、ファインチューニング、推論を行う例を公開しています。以下に、事前トレーニングの手順の概要を示します。

1. GKE クラスタを作成する

2. NVIDIA GPU を搭載したノードプールを追加する

3. Google Cloud Filestore をすべてのノードにマウントする

4. 事前トレーニング Job を実行する

5. TensorBoard で結果を可視化する

ウェブブラウザで http://localhost:8000/#timeseries にアクセスして、損失曲線を確認します。ファインチューニングと推論の詳細は、GitHub リポジトリに記載されています。

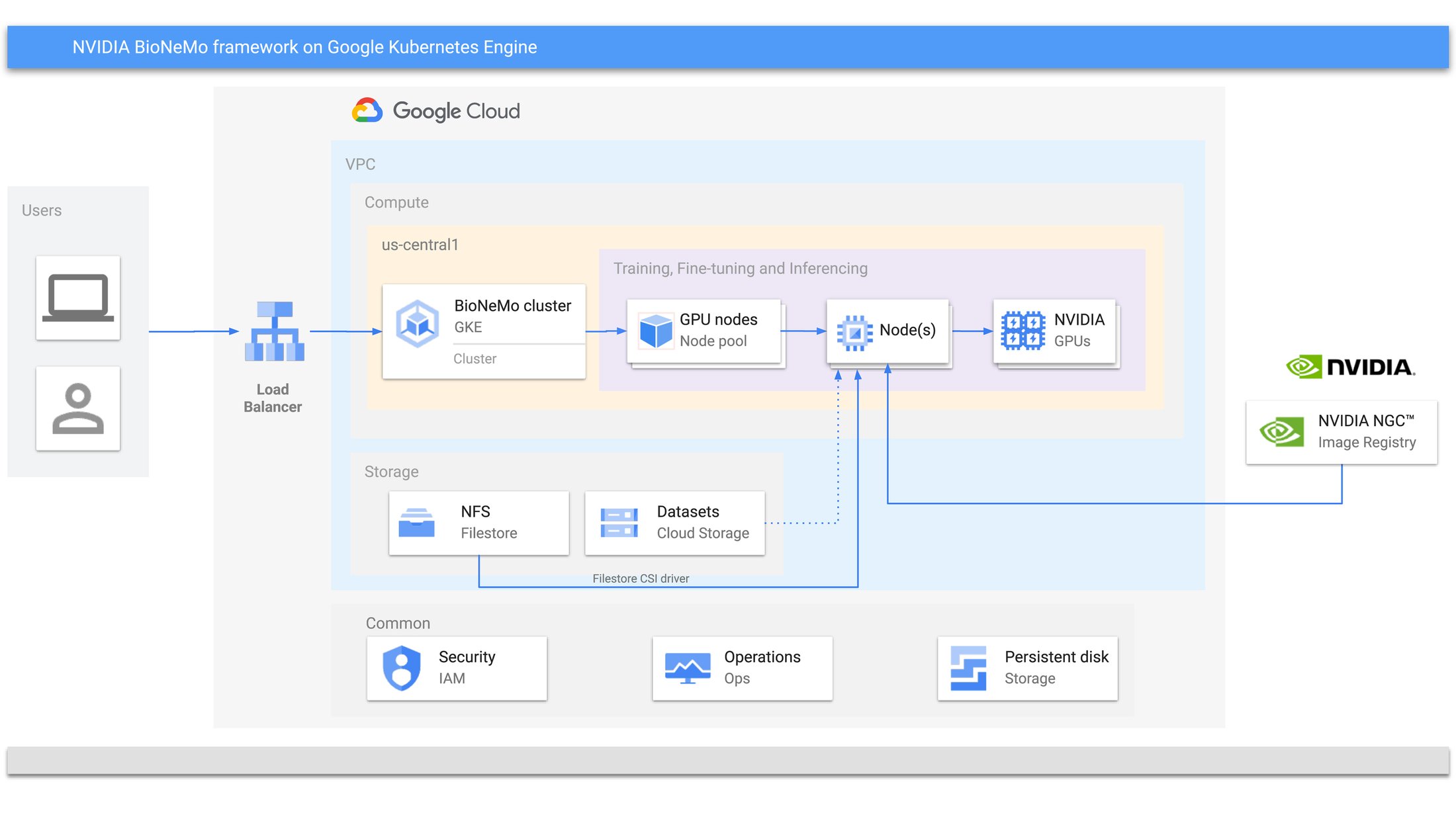

BioNeMo Blueprint のソリューション アーキテクチャ

以下の図は、推論のために GKE にデプロイされた BioNeMo Blueprint を示しています。インフラストラクチャの観点から、コンピューティング、ネットワーキング、ストレージ レイヤで使用されるコンポーネントは、図 2 と類似しています。

-

NIM は、ランタイムとモデル固有の重みを持つ 1 つのユニットとしてパッケージ化されます。ブループリントは、Helm チャートを使用して 1 つ以上の NIM をデプロイします。または、gcloud コマンドや docker コマンドを使用してデプロイし、kubectl コマンドを使用して構成することもできます。各 NIM には、GKE ノードプールからアクセス可能な NVIDIA GPU が 1 つ以上必要です。

-

3 つの NIM(AlphaFold2、DiffDock、MolMIM)は、個別の Kubernetes Deployment としてデプロイされます。各 Deployment は GPU と NIM コンテナ イメージを使用し、モデルのチェックポイントとデータを保存するために Persistent Volume Claim をマウントします。サービスは、各アプリケーションを異なるポートで公開します。GPU の数は、スケーラビリティを高めるためにより大きな値に構成できます。

図 3: GKE 上の NIM Blueprint

ステップ

生成仮想スクリーニング用の BioNeMo Blueprint をデプロイする例は、GitHub リポジトリの「Generative Virtual Screening for Drug Discovery on GKE」にあります。GKE クラスタ、ノードプール、Filestore のマウントなどの設定手順は、BioNeMo トレーニングと似ています。以下の手順は、BioNeMo Blueprint をデプロイして推論に使用する際の概要を示しています。

1. BioNeMo Blueprint をデプロイする

2. ポート転送を使用して Pod を操作する

3. curl ステートメントを使用して、MolMIM NIM をローカルでテストします。出力には生成された分子が含まれます。

NVIDIA BioNeMo Blueprint ワークフローは、創薬以外のさまざまなドメイン固有のユースケースにも適応できます。たとえば、研究者は、RFdiffusion や ProteinMPNN などの生成 AI モデルをタンパク質工学に活用して、高い親和性を持つ安定したタンパク質バインダーを設計し、実験のイテレーション サイクルを大幅に削減できます。

モジュール式の NIM マイクロサービスを GKE のようなスケーラブルなプラットフォームと統合することで、バイオ医薬品から農業に至るまで、さまざまな業界が独自の課題に合わせて AI を活用したソリューションをデプロイし、より迅速な分析情報と効率的なプロセスを大規模に実現できます。

まとめ

このブログ投稿で説明したように、GKE は、NVIDIA BioNeMo Framework と NVIDIA BioNeMo Blueprint の両方をデプロイして実行するための、堅牢で汎用性の高いプラットフォームを提供します。GKE のスケーラビリティ、コンテナ オーケストレーション機能、Google Cloud のエコシステムとのインテグレーションを活用することで、ライフ サイエンスやその他の分野における AI ソリューションの開発とデプロイを効率化できます。

BioNeMo で創薬を加速させる場合や、NIM で生成 AI モデルをデプロイする場合でも、GKE は AI の力を最大限に引き出し、イノベーションの推進に貢献します。両方のプラットフォームの長所を活用することで、デプロイ プロセスの合理化とパフォーマンスの最適化を実現し、AI ワークロードをシームレスにスケールできます。

Google Cloud で NVIDIA BioNeMo のパワーを体験してみませんか?BioNeMo Framework と NIM カタログで、今すぐ GKE に最初の生成 AI モデルをデプロイし、アプリケーションの新しい可能性を解き放ちましょう。

このガイドの作成に協力してくれた NVIDIA チームのメンバー、ソリューション アーキテクトの Juan Pablo Guerra 氏とシニア ソリューション アーキテクトの Kushal Shah 氏に感謝の意を表します。

-パートナー エンジニアリング、スタッフ ソリューション アーキテクト Sujit Khasnis

-Neel Patel 博士NVIDIA、テクニカル マーケティング エンジニア