Membuat teks menggunakan model text-bison dan fungsi ML.GENERATE_TEXT

Tutorial ini menunjukkan cara membuat model jarak jauh yang didasarkan pada model bahasa besar text-bison@002, lalu menggunakan model tersebut dan fungsi ML.GENERATE_TEXT untuk melakukan beberapa tugas pembuatan teks. Tutorial ini menggunakan tabel publik bigquery-public-data.imdb.reviews.

Izin yang diperlukan

- Untuk membuat set data, Anda memerlukan izin Identity and Access Management (IAM)

bigquery.datasets.create. Untuk membuat resource koneksi, Anda memerlukan izin IAM berikut:

bigquery.connections.createbigquery.connections.get

Untuk memberikan izin ke akun layanan koneksi, Anda memerlukan izin berikut:

resourcemanager.projects.setIamPolicy

Untuk membuat model, Anda memerlukan izin berikut:

bigquery.jobs.createbigquery.models.createbigquery.models.getDatabigquery.models.updateDatabigquery.connections.delegate

Untuk menjalankan inferensi, Anda memerlukan izin berikut:

bigquery.models.getDatabigquery.jobs.create

Biaya

Dalam dokumen ini, Anda akan menggunakan komponen Google Cloudyang dapat ditagih berikut:

- BigQuery ML: You incur costs for the data that you process in BigQuery.

- Vertex AI: You incur costs for calls to the Vertex AI service that's represented by the remote model.

Untuk membuat perkiraan biaya berdasarkan proyeksi penggunaan Anda,

gunakan kalkulator harga.

Untuk mengetahui informasi selengkapnya tentang harga BigQuery, lihat harga BigQuery dalam dokumentasi BigQuery.

Untuk mengetahui informasi selengkapnya tentang harga Vertex AI, lihat halaman harga Vertex AI.

Sebelum memulai

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

-

Verify that billing is enabled for your Google Cloud project.

-

Enable the BigQuery, BigQuery Connection, and Vertex AI APIs.

Membuat set data

Buat set data BigQuery untuk menyimpan model ML Anda.

Konsol

Di Konsol Google Cloud, buka halaman BigQuery.

Di panel Explorer, klik nama project Anda.

Klik View actions > Create dataset.

Di halaman Create dataset, lakukan hal berikut:

Untuk Dataset ID, masukkan

bqml_tutorial.Untuk Location type, pilih Multi-region, lalu pilih US (multiple regions in United States).

Jangan ubah setelan default yang tersisa, lalu klik Create dataset.

bq

Untuk membuat set data baru, gunakan perintah bq mk dengan flag --location. Untuk daftar lengkap parameter yang mungkin, lihat

referensi

perintah bq mk --dataset.

Buat set data bernama

bqml_tutorialdengan lokasi data ditetapkan keUSdan deskripsiBigQuery ML tutorial dataset:bq --location=US mk -d \ --description "BigQuery ML tutorial dataset." \ bqml_tutorial

Perintah ini menggunakan pintasan

-d, bukan flag--dataset. Jika Anda menghapus-ddan--dataset, perintah defaultnya adalah membuat set data.Pastikan set data telah dibuat:

bq ls

API

Panggil metode datasets.insert dengan resource set data yang ditentukan.

{ "datasetReference": { "datasetId": "bqml_tutorial" } }

Membuat koneksi

Buat koneksi resource Cloud dan dapatkan akun layanan koneksi. Buat koneksi di lokasi yang sama dengan set data yang Anda buat di langkah sebelumnya.

Pilih salah satu opsi berikut:

Konsol

Buka halaman BigQuery.

Di panel Penjelajah, klik Tambahkan data.

Dialog Add data akan terbuka.

Di panel Filter By, di bagian Data Source Type, pilih Databases.

Atau, di kolom Search for data sources, Anda dapat memasukkan

Vertex AI.Di bagian Sumber data unggulan, klik Vertex AI.

Klik kartu solusi Vertex AI Models: BigQuery Federation.

Dalam daftar Connection type, pilih Vertex AI remote models, remote functions and BigLake (Cloud Resource).

Di kolom Connection ID, masukkan nama untuk koneksi Anda.

Klik Create connection.

Klik Go to connection.

Di panel Connection info, salin ID akun layanan untuk digunakan di langkah berikutnya.

bq

Di lingkungan command line, buat koneksi:

bq mk --connection --location=REGION --project_id=PROJECT_ID \ --connection_type=CLOUD_RESOURCE CONNECTION_ID

Parameter

--project_idakan mengganti project default.Ganti kode berikut:

REGION: region koneksi AndaPROJECT_ID: project ID Google Cloud AndaCONNECTION_ID: ID untuk koneksi Anda

Saat Anda membuat resource koneksi, BigQuery akan membuat akun layanan sistem unik dan mengaitkannya dengan koneksi.

Pemecahan masalah: Jika Anda mendapatkan error koneksi berikut, update Google Cloud SDK:

Flags parsing error: flag --connection_type=CLOUD_RESOURCE: value should be one of...

Ambil dan salin ID akun layanan untuk digunakan di langkah berikutnya:

bq show --connection PROJECT_ID.REGION.CONNECTION_ID

Outputnya mirip dengan hal berikut ini:

name properties 1234.REGION.CONNECTION_ID {"serviceAccountId": "connection-1234-9u56h9@gcp-sa-bigquery-condel."}

Terraform

Gunakan resource google_bigquery_connection.

Untuk melakukan autentikasi ke BigQuery, siapkan Kredensial Default Aplikasi. Untuk informasi selengkapnya, lihat Menyiapkan autentikasi untuk library klien.

Contoh berikut membuat koneksi resource Cloud bernama

my_cloud_resource_connection di region US:

Untuk menerapkan konfigurasi Terraform di project Google Cloud, selesaikan langkah-langkah di bagian berikut.

Menyiapkan Cloud Shell

- Luncurkan Cloud Shell.

-

Tetapkan project Google Cloud default tempat Anda ingin menerapkan konfigurasi Terraform.

Anda hanya perlu menjalankan perintah ini sekali per project, dan dapat dijalankan di direktori mana pun.

export GOOGLE_CLOUD_PROJECT=PROJECT_ID

Variabel lingkungan akan diganti jika Anda menetapkan nilai eksplisit dalam file konfigurasi Terraform.

Menyiapkan direktori

Setiap file konfigurasi Terraform harus memiliki direktorinya sendiri (juga disebut modul root).

-

Di Cloud Shell, buat direktori dan file baru di dalam direktori tersebut. Nama file harus memiliki

ekstensi

.tf—misalnyamain.tf. Dalam tutorial ini, file ini disebut sebagaimain.tf.mkdir DIRECTORY && cd DIRECTORY && touch main.tf

-

Jika mengikuti tutorial, Anda dapat menyalin kode contoh di setiap bagian atau langkah.

Salin kode contoh ke dalam

main.tfyang baru dibuat.Atau, salin kode dari GitHub. Tindakan ini direkomendasikan jika cuplikan Terraform adalah bagian dari solusi menyeluruh.

- Tinjau dan ubah contoh parameter untuk diterapkan pada lingkungan Anda.

- Simpan perubahan Anda.

-

Lakukan inisialisasi Terraform. Anda hanya perlu melakukan ini sekali per direktori.

terraform init

Secara opsional, untuk menggunakan versi penyedia Google terbaru, sertakan opsi

-upgrade:terraform init -upgrade

Menerapkan perubahan

-

Tinjau konfigurasi dan pastikan resource yang akan dibuat atau

diupdate oleh Terraform sesuai yang Anda inginkan:

terraform plan

Koreksi konfigurasi jika diperlukan.

-

Terapkan konfigurasi Terraform dengan menjalankan perintah berikut dan memasukkan

yespada prompt:terraform apply

Tunggu hingga Terraform menampilkan pesan "Apply complete!".

- Buka project Google Cloud Anda untuk melihat hasilnya. Di Konsol Google Cloud, buka resource Anda di UI untuk memastikan bahwa Terraform telah membuat atau mengupdatenya.

Memberikan izin ke akun layanan koneksi

Berikan peran Vertex AI User ke akun layanan koneksi. Anda harus memberikan peran ini di project yang sama dengan yang Anda buat atau pilih di bagian Sebelum memulai. Memberikan peran di project lain akan menyebabkan error bqcx-1234567890-xxxx@gcp-sa-bigquery-condel. does not have the permission to access resource.

Untuk memberikan peran, ikuti langkah-langkah berikut:

Buka halaman IAM & Admin.

Klik Berikan Akses.

Di kolom New principals, masukkan ID akun layanan yang Anda salin sebelumnya.

Di kolom Pilih peran, pilih Vertex AI, lalu pilih Peran Pengguna Vertex AI.

Klik Save.

Membuat model jarak jauh

Buat model jarak jauh yang merepresentasikan model bahasa besar (LLM) Vertex AI yang dihosting:

SQL

Di Konsol Google Cloud, buka halaman BigQuery.

Di editor kueri, jalankan pernyataan berikut:

CREATE OR REPLACE MODEL `bqml_tutorial.llm_model` REMOTE WITH CONNECTION `LOCATION.CONNECTION_ID` OPTIONS (ENDPOINT = 'text-bison@002');

Ganti kode berikut:

LOCATION: lokasi koneksiCONNECTION_ID: ID koneksi BigQuery AndaSaat Anda melihat detail koneksi di Konsol Google Cloud, ini adalah nilai di bagian terakhir ID koneksi yang sepenuhnya memenuhi syarat yang ditampilkan di ID Koneksi, misalnya

projects/myproject/locations/connection_location/connections/myconnection

Kueri memerlukan waktu beberapa detik untuk diselesaikan, setelah itu model

llm_modelakan muncul di set databqml_tutorialdi panel Explorer. Karena kueri menggunakan pernyataanCREATE MODELuntuk membuat model, tidak akan ada hasil kueri.

DataFrame BigQuery

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan BigQuery DataFrames di panduan memulai BigQuery menggunakan BigQuery DataFrames. Untuk mengetahui informasi selengkapnya, lihat dokumentasi referensi BigQuery DataFrames.

Untuk melakukan autentikasi ke BigQuery, siapkan Kredensial Default Aplikasi. Untuk informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Melakukan ekstraksi kata kunci

Lakukan ekstraksi kata kunci pada ulasan film IMDB dengan menggunakan model jarak jauh dan fungsi ML.GENERATE_TEXT:

SQL

Di Konsol Google Cloud, buka halaman BigQuery.

Di editor kueri, masukkan pernyataan berikut untuk melakukan ekstraksi kata kunci pada lima ulasan film:

SELECT ml_generate_text_result['predictions'][0]['content'] AS generated_text, ml_generate_text_result['predictions'][0]['safetyAttributes'] AS safety_attributes, * EXCEPT (ml_generate_text_result) FROM ML.GENERATE_TEXT( MODEL `bqml_tutorial.llm_model`, ( SELECT CONCAT('Extract the key words from the text below: ', review) AS prompt, * FROM `bigquery-public-data.imdb.reviews` LIMIT 5 ), STRUCT( 0.2 AS temperature, 100 AS max_output_tokens));

Outputnya mirip dengan berikut ini, dengan kolom yang tidak dihasilkan dihilangkan untuk kejelasan:

+----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+ | generated_text | safety_attributes | ml_generate_text_status | prompt | ... | +----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+ | " Keywords:\n- British Airways\n- | {"blocked":false,"categories": | | Extract the key words from | | | acting\n- story\n- kid\n- switch off" | ["Death, Harm & Tragedy","Derogatory", | | the text below: I had to | | | | "Finance","Health","Insult", | | see this on the British | | | | "Profanity","Religion & Belief", | | Airways plane. It was | | | | "Sexual","Toxic"] | | terribly bad acting and | | | | "safetyRatings":[{"category": | | a dumb story. Not even | | | | "Dangerous Content","probabilityScore"... | | a kid would enjoy this... | | +----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+ | " - Family movie\n- ITV station\n- THE | {"blocked":false,"categories": | | Extract the key words from | | | REAL HOWARD SPITZ\n- Roald Dahl\n- | ["Death, Harm & Tragedy","Derogatory", | | the text below: This is | | | DOCTOR WHO\n- Pulp fiction\n- Child | "Health","Illicit Drugs","Insult", | | a family movie that was | | | abuse\n- KINDERGARTEN COP\n- PC\n- | "Legal","Profanity","Public Safety", | | broadcast on my local | | | Children's author\n- Vadim Jean\n- | "Sexual","Toxic","Violent"], | | ITV station at 1.00 am a | | | Haphazard\n- Kelsey Grammar\n- | "safetyRatings":[{"category": | | couple of nights ago. | | | Dead pan\n- Ridiculous camera angles" | "Dangerous Content","probabilityScore"... | | This might be a strange... | | +----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+Hasilnya mencakup kolom berikut:

generated_text: teks yang dihasilkan.safety_attributes: atribut keamanan, beserta informasi tentang apakah konten diblokir karena salah satu kategori pemblokiran. Untuk mengetahui informasi selengkapnya tentang atribut keamanan, lihat Vertex PaLM API.ml_generate_text_status: status respons API untuk baris yang sesuai. Jika operasi berhasil, nilai ini akan kosong.prompt: prompt yang digunakan untuk analisis sentimen.- Semua kolom dari tabel

bigquery-public-data.imdb.reviews.

Opsional: Daripada mengurai JSON yang ditampilkan oleh fungsi secara manual, seperti yang Anda lakukan di langkah sebelumnya, gunakan argumen

flatten_json_outputuntuk menampilkan teks yang dihasilkan dan atribut keamanan dalam kolom terpisah.Di editor kueri, jalankan pernyataan berikut:

SELECT * FROM ML.GENERATE_TEXT( MODEL `bqml_tutorial.llm_model`, ( SELECT CONCAT('Extract the key words from the text below: ', review) AS prompt, * FROM `bigquery-public-data.imdb.reviews` LIMIT 5 ), STRUCT( 0.2 AS temperature, 100 AS max_output_tokens, TRUE AS flatten_json_output));

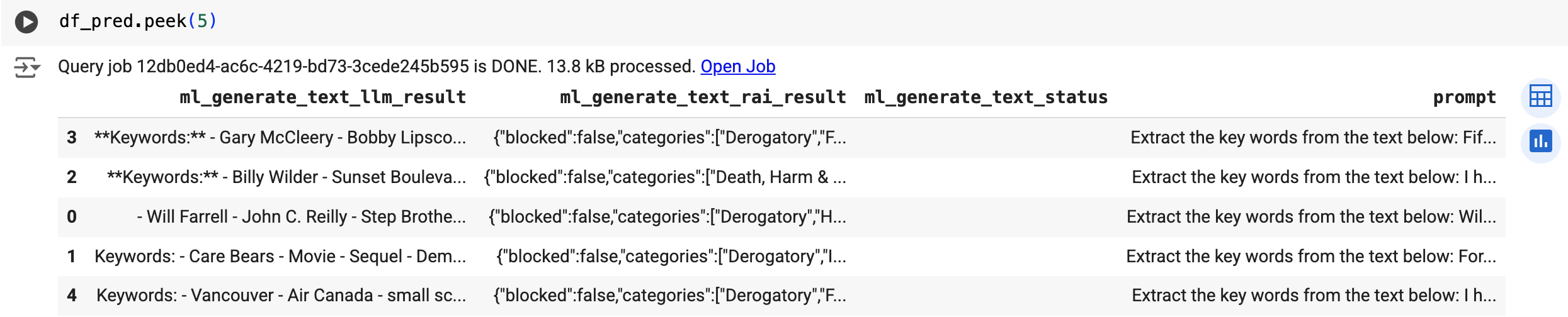

Outputnya mirip dengan berikut ini, dengan kolom yang tidak dihasilkan dihilangkan untuk kejelasan:

+----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+ | ml_generate_text_llm_result | ml_generate_text_rai_result | ml_generate_text_status | prompt | ... | +----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+ | Keywords: | {"blocked":false,"categories": | | Extract the key words from | | | - British Airways | ["Death, Harm & Tragedy","Derogatory", | | the text below: I had to | | | - acting | "Finance","Health","Insult", | | see this on the British | | | - story | "Profanity","Religion & Belief", | | Airways plane. It was | | | - kid | "Sexual","Toxic"] | | terribly bad acting and | | | - switch off | "safetyRatings":[{"category": | | a dumb story. Not even | | | | "Dangerous Content","probabilityScore"... | | a kid would enjoy this... | | +----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+ | - Family movie | {"blocked":false,"categories": | | Extract the key words from | | | - ITV station | ["Death, Harm & Tragedy","Derogatory", | | the text below: This is | | | - THE REAL HOWARD SPITZ | "Health","Illicit Drugs","Insult", | | a family movie that was | | | - Roald Dahl | "Legal","Profanity","Public Safety", | | broadcast on my local | | | - DOCTOR WHO | "Sexual","Toxic","Violent"], | | ITV station at 1.00 am a | | | - Pulp Fiction | "safetyRatings":[{"category": | | couple of nights ago. | | | - ... | "Dangerous Content","probabilityScore"... | | This might be a strange... | | +----------------------------------------+---------------------------------------------+-------------------------+----------------------------+-----+Hasilnya mencakup kolom berikut:

ml_generate_text_llm_result: teks yang dihasilkan.ml_generate_text_rai_result: atribut keamanan, beserta informasi tentang apakah konten diblokir karena salah satu kategori pemblokiran. Untuk mengetahui informasi selengkapnya tentang atribut keamanan, lihat Vertex PaLM API.ml_generate_text_status: status respons API untuk baris yang sesuai. Jika operasi berhasil, nilai ini akan kosong.prompt: perintah yang digunakan untuk ekstraksi kata kunci.- Semua kolom dari tabel

bigquery-public-data.imdb.reviews.

DataFrame BigQuery

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan BigQuery DataFrames di panduan memulai BigQuery menggunakan BigQuery DataFrames. Untuk mengetahui informasi selengkapnya, lihat dokumentasi referensi BigQuery DataFrames.

Untuk melakukan autentikasi ke BigQuery, siapkan Kredensial Default Aplikasi. Untuk informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Gunakan fungsi predict untuk menjalankan model jarak jauh:

Hasilnya mirip dengan berikut ini:

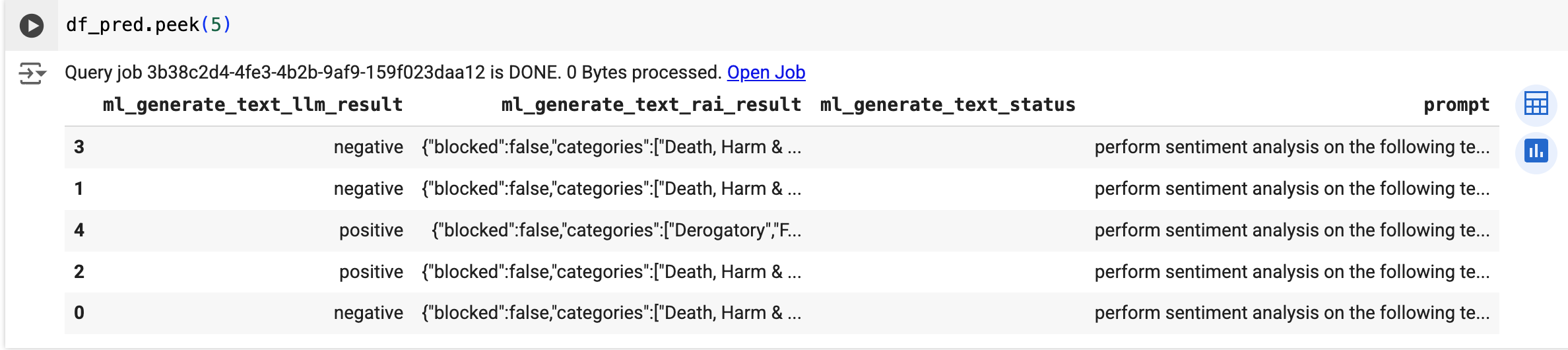

Melakukan analisis sentimen

Lakukan analisis sentimen pada ulasan film IMDB menggunakan model jarak jauh dan fungsi ML.GENERATE_TEXT:

SQL

Di Konsol Google Cloud, buka halaman BigQuery.

Di editor kueri, jalankan pernyataan berikut untuk melakukan analisis sentimen pada lima ulasan film:

SELECT ml_generate_text_result['predictions'][0]['content'] AS generated_text, ml_generate_text_result['predictions'][0]['safetyAttributes'] AS safety_attributes, * EXCEPT (ml_generate_text_result) FROM ML.GENERATE_TEXT( MODEL `bqml_tutorial.llm_model`, ( SELECT CONCAT( 'perform sentiment analysis on the following text, return one the following categories: positive, negative: ', review) AS prompt, * FROM `bigquery-public-data.imdb.reviews` LIMIT 5 ), STRUCT( 0.2 AS temperature, 100 AS max_output_tokens));

Outputnya mirip dengan berikut ini, dengan kolom yang tidak dihasilkan dihilangkan untuk kejelasan:

+----------------+---------------------------------------------+-------------------------+----------------------------+-----+ | generated_text | safety_attributes | ml_generate_text_status | prompt | ... | +----------------+---------------------------------------------+-------------------------+----------------------------+-----+ | "negative" | {"blocked":false,"categories": | | perform sentiment analysis | | | | ["Death, Harm & Tragedy","Derogatory", | | on the following text, | | | | "Finance","Health","Insult", | | return one the following | | | | "Profanity","Religion & Belief", | | categories: positive, | | | | "Sexual","Toxic"] | | negative: I had to see | | | | "safetyRatings":[{"category": | | this on the British | | | | "Dangerous Content","probabilityScore"... | | Airways plane. It was... | | +----------------+---------------------------------------------+-------------------------+----------------------------+-----+ | "negative" | {"blocked":false,"categories": | | perform sentiment analysis | | | | ["Death, Harm & Tragedy","Derogatory", | | on the following text, | | | | "Health","Illicit Drugs","Insult", | | return one the following | | | | "Legal","Profanity","Public Safety", | | categories: positive, | | | | "Sexual","Toxic","Violent"], | | negative: This is a family | | | | "safetyRatings":[{"category": | | movie that was broadcast | | | | "Dangerous Content","probabilityScore"... | | on my local ITV station... | | +----------------+---------------------------------------------+-------------------------+----------------------------+-----+Hasilnya mencakup kolom yang sama dengan yang didokumentasikan untuk Melakukan ekstraksi kata kunci.

DataFrame BigQuery

Sebelum mencoba contoh ini, ikuti petunjuk penyiapan BigQuery DataFrames di panduan memulai BigQuery menggunakan BigQuery DataFrames. Untuk mengetahui informasi selengkapnya, lihat dokumentasi referensi BigQuery DataFrames.

Untuk melakukan autentikasi ke BigQuery, siapkan Kredensial Default Aplikasi. Untuk informasi selengkapnya, lihat Menyiapkan ADC untuk lingkungan pengembangan lokal.

Gunakan fungsi predict untuk menjalankan model jarak jauh:

Hasilnya mirip dengan berikut ini:

Pembersihan

- In the Google Cloud console, go to the Manage resources page.

- In the project list, select the project that you want to delete, and then click Delete.

- In the dialog, type the project ID, and then click Shut down to delete the project.