Palo Alto Networks がマルチテナントのスケーラブルな統合データ プラットフォームを構築した方法

Pavan Paladugu

Customer Engineer, Data Analytics, Google Cloud

Gaurav Mishra

Senior Principal Engineer, Palo Alto Networks

Try Gemini 3.1 Pro

Our most intelligent model available yet for complex tasks on Gemini Enterprise and Vertex AI

Try now※この投稿は米国時間 2026 年 1 月 17 日に、Google Cloud blog に投稿されたものの抄訳です。

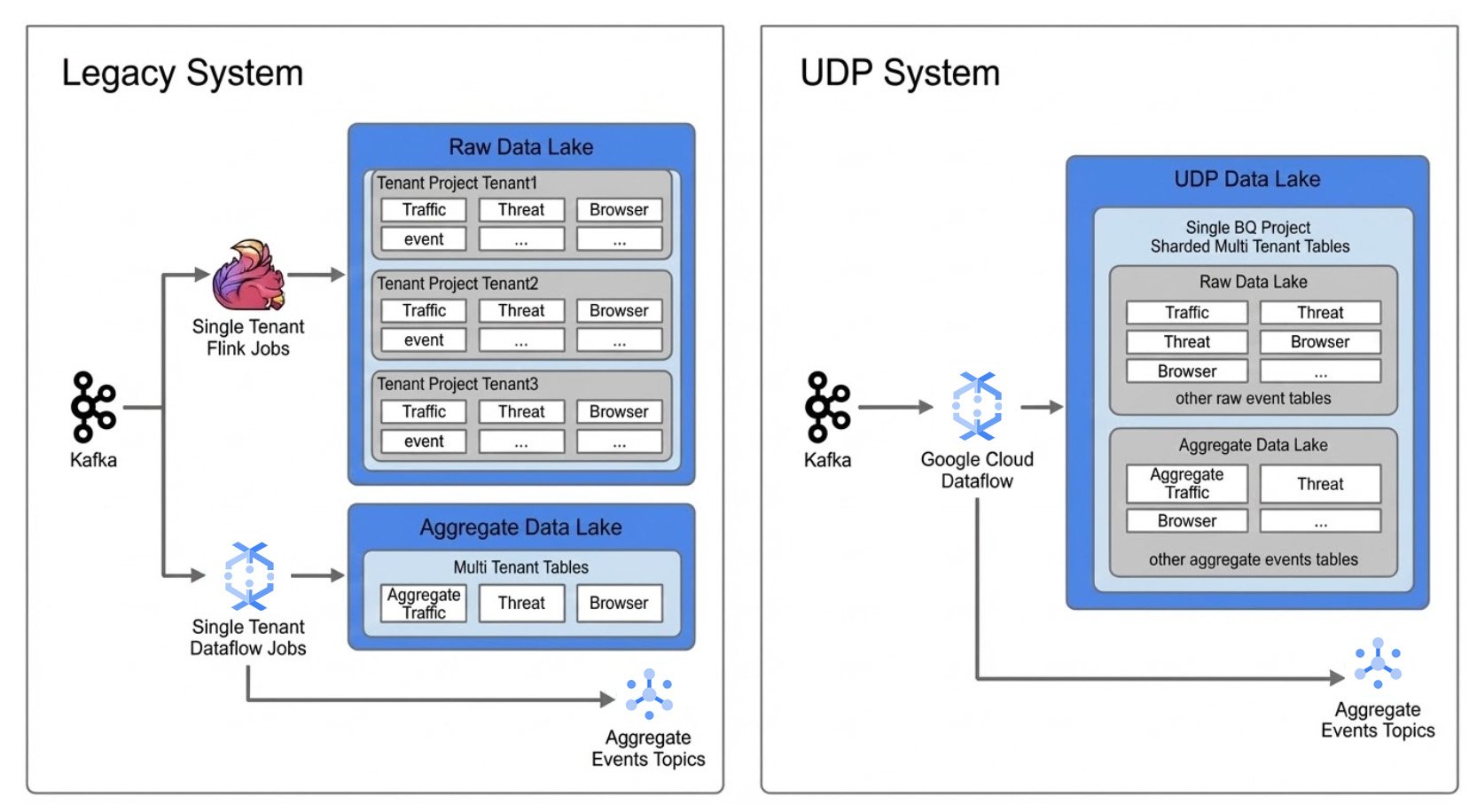

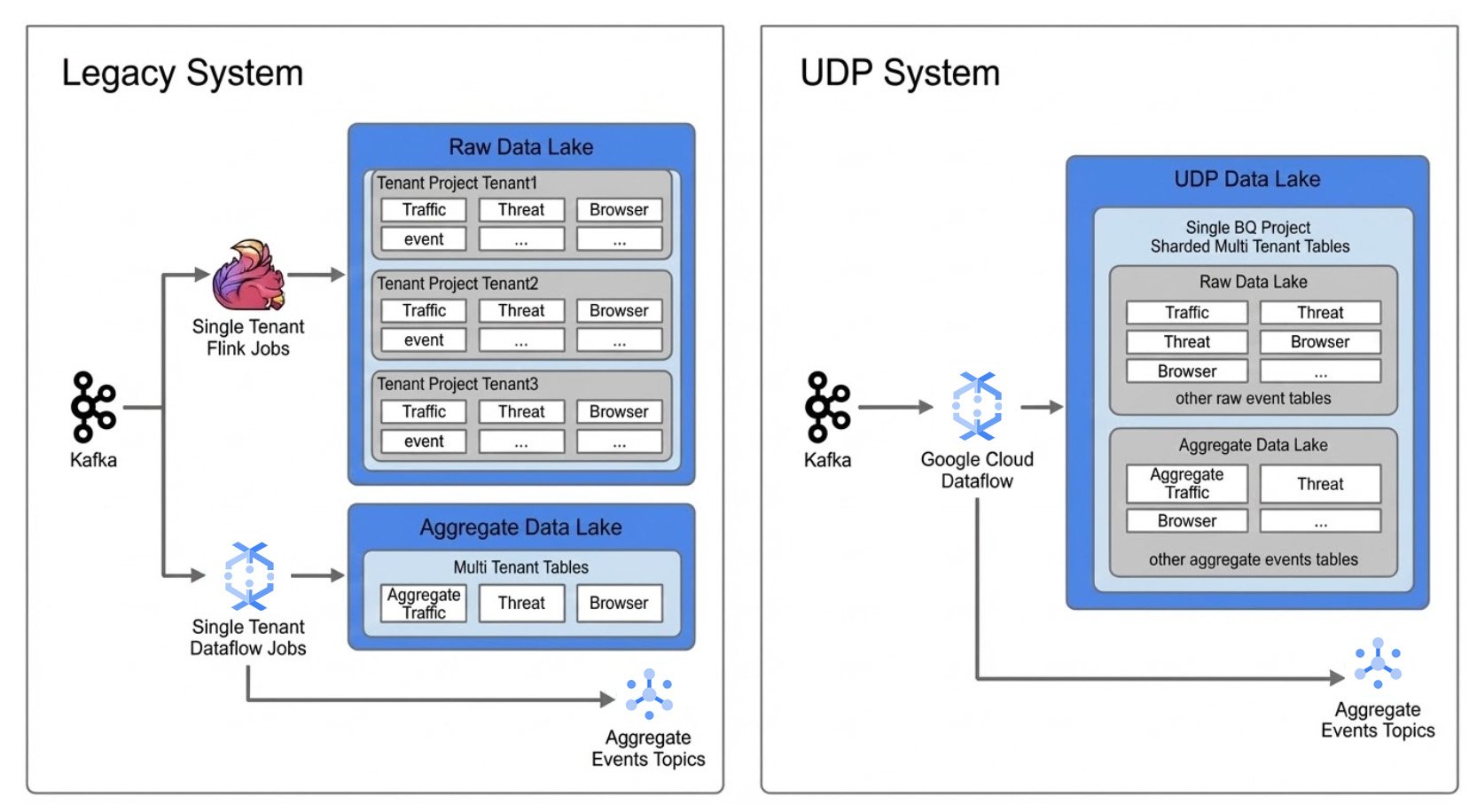

世界中の企業が大量のデータを処理しています。Palo Alto Networks は、同社の製品ポートフォリオ全体で、毎秒数千件のファイアウォール ログ、テレメトリー シグナル、脅威イベントを処理しています。この規模に対応するため、Palo Alto Networks は 30,000 個の別個のデータ パイプラインを運用しており、それぞれに運用負荷がかかっていました。このシングル テナント アーキテクチャ モデルは当初はうまく機能していましたが、最近ではイノベーションの停滞、規模拡大の制限が始まり、新しい分析ユースケースの導入コストの増加につながっていました。

次世代のセキュリティ プロダクトをサポートするため、Palo Alto Networks は Google Cloud と提携し、Dataflow、Pub/Sub、BigQuery を活用した統合マルチテナント プラットフォームへとデータ処理環境をモダナイズしました。この変革は、Palo Alto Networks の統合データ プラットフォーム(UDP)の基盤となり、現在ではアジリティの向上、運用の簡素化、費用対効果の向上により、毎日数十億件のイベントを処理できるようになりました。

課題: シングル テナント アーキテクチャでは対応しきれない

移行前、Palo Alto Networks のデータ プラットフォームは「テナントごとに 1 つのパイプライン」モデルに基づいて構築されていました。テナント パイプラインごとに、独自の構成、トラブルシューティング、オンコール ローテーション、キャパシティ調整が必要でした。Palo Alto Networks の利用が増えるにつれて、次のような問題も増加しました。

-

合計で毎秒約 30 GB のスループットを処理する 30,000 以上のパイプラインをサポートするための脆弱なアラートと毎週の運用オーバーヘッド。

-

デプロイ サイクルの遅さから、新しいテナントのオンボーディングが難しくなっていた。

-

負荷に関係なく、各テナントに大量のコンピューティング リソースが割り当てられていた。

-

エンジニアリングの時間が、新しい分析の構築ではなくインフラストラクチャの管理に費やされていた。

このモデルは運用のアジリティを妨げ、新しいプロダクト ラインの拡大やデータ量の増加に伴うスケーリングを困難にしていました。

変革: Dataflow による新しいアーキテクチャ パラダイムの採用

転機が訪れたのは、Google Cloud Dataflow のサーバーレス自動スケーリング アーキテクチャがまったく異なる運用モデルをサポートできることをチームが認識したときでした。Palo Alto Networks は、数千もの別個のパイプラインを維持する代わりに、ワークロードをマルチテナント システムに統合し、テナント間でリソースをインテリジェントに共有することができました。

これを可能にしたのは、次のような複数のコア機能です。

1. アーキテクチャの移行Dataflow を使用することで、チームは「テナントごとに 1 つのジョブ」から、単一のアーキテクチャ内で複数のテナントを処理できる「共有リソースプール」に移行できました。この移行により、運用が大幅に簡素化され、新たな効率性が実現しました。

2. 大規模なマルチテナントの実現Dataflow の自動スケーリング エンジンは、変動するワークロードを簡単に管理し、サイバーセキュリティ環境でよくある予測不可能な急増に対応します。これにより、手動でのキャパシティ プランニングが不要になりました。

3. 運用の自由度Flex テンプレートと Dataflow のマネージド サービス モデルを使用することで、チームは CI / CD プロセスを、1 週間かかるデプロイ サイクルから 1 日で完了するワークフローへと変革しました。エンジニアはインフラストラクチャの管理に時間を費やす必要がなくなり、分析、脅威検出、プロダクト イノベーションに集中できます。

4. 実行の統合すべてのジョブが Dataflow ベースの共有プラットフォームで実行されるため、チームは異なるコードベースを維持しなくても、リアルタイム システムとバッチシステムの間でワークロードを柔軟に移動できるようになりました。

5. オブザーバビリティDataflow では、チームは組み込みのロギングと指標を利用して、リアルタイム ワークロードとバッチ ワークロードの両方でパイプラインの健全性をモニタリングし、追加のツールを使用せずにパフォーマンスを明確に可視化できます。Dataflow により、オンコール アラートに必要なすべての指標が明らかになるため、PANW コードベースでカスタム指標を構築または維持する必要がなくなります。アラートがトリガーされると、エンジニアは Dataflow UI を使用してパフォーマンスのボトルネックを迅速に特定し、是正措置を講じることができます。

アーキテクチャの概要

Palo Alto Networks の UDP を強化する Dataflow ベースの統合リアルタイム パイプライン

効果: 価値、費用、エンジニアリングの重点の大きな変化

Dataflow への移行は、古いシステムをモダナイズしただけではありません。エンジニアリング チームの働き方を根本的に変え、さまざまな面で効果をもたらしました。

-

経済的なメリット: パイプラインを統合し、Dataflow の自動スケーリングを利用することで、Palo Alto Networks はコンピューティング費用を約 30% 削減しました。この費用削減は、冗長なパイプラインの削減、共有リソースの利用率向上、手動によるキャパシティ調整の排除によって実現しました。

-

プラットフォームにとってのメリット: 統合データ プラットフォームは、同社全体でリアルタイム データ処理の長期的な標準となりました。スケーラブルで再現性があり、エンジニアリング作業を重複させることなく新しいプロダクト ラインをサポートできる「Dataflow ネイティブ」なブループリントを提供します。

-

従業員にとってのメリット: Dataflow が運用の複雑さに対処するため、エンジニアはインフラストラクチャの管理ではなく、新しい分析機能の構築に集中できるようになりました。この移行により、士気が向上して、デリバリー サイクルが加速し、アラート疲れが軽減されました。「当社にとって真の差別化要因は、Dataflow が大規模かつ真のマルチテナンシーに対応できることでした。その自動スケーリング エンジンは、1 つのジョブで数千のテナントにまたがるリソースを管理できるほど優れており、これが約 30% の費用削減を実現する鍵となりました。30,000 件以上のジョブを管理する環境から、ほんの一握りのジョブを管理する環境へと移行しました。その結果、チームの業務内容が根本的に変わりました。」- Palo Alto Networks エンジニアリング チーム

モデルの拡張: サイバーセキュリティ以外のユースケース

Palo Alto Networks が採用したアーキテクチャ パターンは、マルチテナントのリアルタイム データを大規模に扱うあらゆる組織に幅広く適用できます。次に例を示します。

-

e コマース: 単一のマーケットプレイスで数千の販売者向けにリアルタイム ダッシュボードを提供する

-

ゲーム: 数百万人のプレーヤーからのテレメトリー シグナルを処理して、リーダーボードを更新し、不正行為を検出する

-

フィンテック: 数百の銀行における取引をモニタリングし、不審な行動にリアルタイムでフラグを付ける

-

IoT とロジスティクス: 車両フリートのデータを分析して、ルーティングとメンテナンス スケジュールを最適化する

マルチテナンシー、共有実行、自動スケーリングといった同様の原則は、多くの業界で効率の向上に役立ちます。

持続可能なデータの未来を創る

Palo Alto Networks は、Dataflow を標準化することで、セキュリティ分析プラットフォームの長期的なアジリティの基盤を築きました。統合データ プラットフォームは現在、同社のリアルタイム データ戦略の基盤として機能し、イノベーションの加速と経済効率の高い運用に役立っています。

この事例は、Dataflow のような柔軟で高性能なデータ処理エンジンによって、運用オーバーヘッドを増やすことなくスケールできるという自信を企業に与えられることを示しています。さらに、Google Cloud を使用してリアルタイム アーキテクチャをモダナイズしたいと考えるチーム向けに、再利用可能なハンドブックも提供します。

データ パイプラインをモダナイズする方法の詳細については、Dataflow のプロダクト ページをご覧ください。

- Google Cloud、データ分析担当カスタマー エンジニア Pavan Paladugu

- Palo Alto Networks、シニア プリンシパル エンジニア Gaurav Mishra 氏