ドイツ銀行が AI を活用した金融調査を DB Lumina で提供

Max Sommerfeld

Head of Applied AI Engineering , Deutsche Bank

Crispin Velez

Global AI incubation, Google

※この投稿は米国時間 2025 年 9 月 24 日に、Google Cloud blog に投稿されたものの抄訳です。

ドイツ銀行リサーチ センター のアナリストの主な使命は、独自の独立した経済および財務分析を提供することです。しかし、調査レポートやメモの作成は、手間のかかる手作業に大きく依存していました。少なくとも、生成 AI が登場するまでは。

従来、アナリストは財務諸表、規制当局への提出書類、業界レポートからデータをふるいにかけて収集していました。しかし本当の大仕事はこの後で、この膨大な量の情報を統合して、分析情報と調査結果を明らかにすることでした。そのためには、財務モデルを構築し、パターンと傾向を特定し、さまざまなソース、過去の調査、より広範なグローバル コンテキスト間のつながりを把握する必要があります。

アナリストは、価値ある分析情報をできるだけ早く市場に提供する必要があるため、この時間のかかるプロセスによって、分析の深さや対象となるトピックの範囲が制限される可能性があります。

私たちの目標は、リサーチ アナリストの体験を向上させ、手動プロセスやアウトソーシングへの依存を減らすことでした。そこで、DB Lumina を作成しました。これは、AI を活用した調査エージェントで、データ分析の自動化、ワークフローの合理化、より正確でタイムリーな分析情報の提供を支援します。これらすべてを、規制の厳しい金融業界の厳格なデータプライバシー要件を維持しながら行います。

「数百人のリサーチ アナリストが DB Lumina デジタル アシスタントを採用したことは、dbResearch、社内の開発チーム、その他多くの関係者による 12 か月以上にわたる集中的なコラボレーションの集大成です。これは私たちの取り組みの始まりにすぎません。研究成果の創出における AI の責任ある活用の可能性をさらに広げながら、この基盤を発展させ、幅広いカバレッジ領域で新たなイノベーションを切り拓いていくことを楽しみにしています。」- Pam Finelli 氏、ドイツ銀行、投資調査担当グローバル COO

AI を活用した研究体験の創出

DB Lumina には 3 つの主要な機能があり、高度なテクノロジーによってアナリストの調査エクスペリエンスを変革し、生産性を向上させます。

1. 生成 AI を活用したチャット

DB Lumina のコアとなる会話型インターフェースにより、アナリストはマルチモーダル Gemini モデルを含む Google の最先端の AI 基盤モデルと対話できます。質問、アイデアのブレインストーミング、文章の推敲、コンテンツのリアルタイム生成も可能です。さらに、チャット機能では、ドキュメントのアップロードと会話形式でのクエリがサポートされており、以前のチャット履歴を活用して、以前のセッションを再開して継続できます。DB Lumina は、要約、校正、翻訳、コンテンツの下書きなどのタスクを正確かつ迅速に支援します。さらに、コンプライアンスに準拠した信頼性の高い出力を生成するために、ガードレール技術を実装しました。

2. プロンプト テンプレート

プロンプト テンプレートは、ドキュメント処理に合わせて事前に構成された指示を提供し、一貫した高品質の結果をもたらします。これらのテンプレートを使用すると、アナリストは大規模なドキュメントの要約、主要なデータポイントの抽出、反復タスクのための再利用可能なワークフローの作成を容易に行うことができます。特定の役割やビジネスニーズに合わせてカスタマイズでき、チーム全体で標準化できます。アナリストはテンプレートを保存して共有することもできるため、業務の合理化とコラボレーションの強化が実現します。この機能は、Google の長いコンテキスト ウィンドウと高度なプロンプト技術を組み合わせることで実現しており、検証のための引用も提供します。

3. 知識

DB Lumina は、検索拡張生成(RAG)アーキテクチャを統合し、内部調査、外部の非構造化データ(SEC 提出書類など)、その他のドキュメント リポジトリなどの企業ナレッジソースに基づいて回答を生成します。エージェントは、ファクト チェックのためにインラインの引用とソースビューアを提供することで、透明性と精度を高めます。また、監査ロギングと説明可能性機能により、機密データへのアクセスを制御し、安全で信頼できる運用を確保します。Google Cloud テクノロジーでサポートされている高度な RAG アーキテクチャを使用することで、生成機能を企業ナレッジ リソースに導入し、アナリストが調査レポートやメモを作成する際に、最新かつ最も関連性の高い情報にアクセスできるようにします。

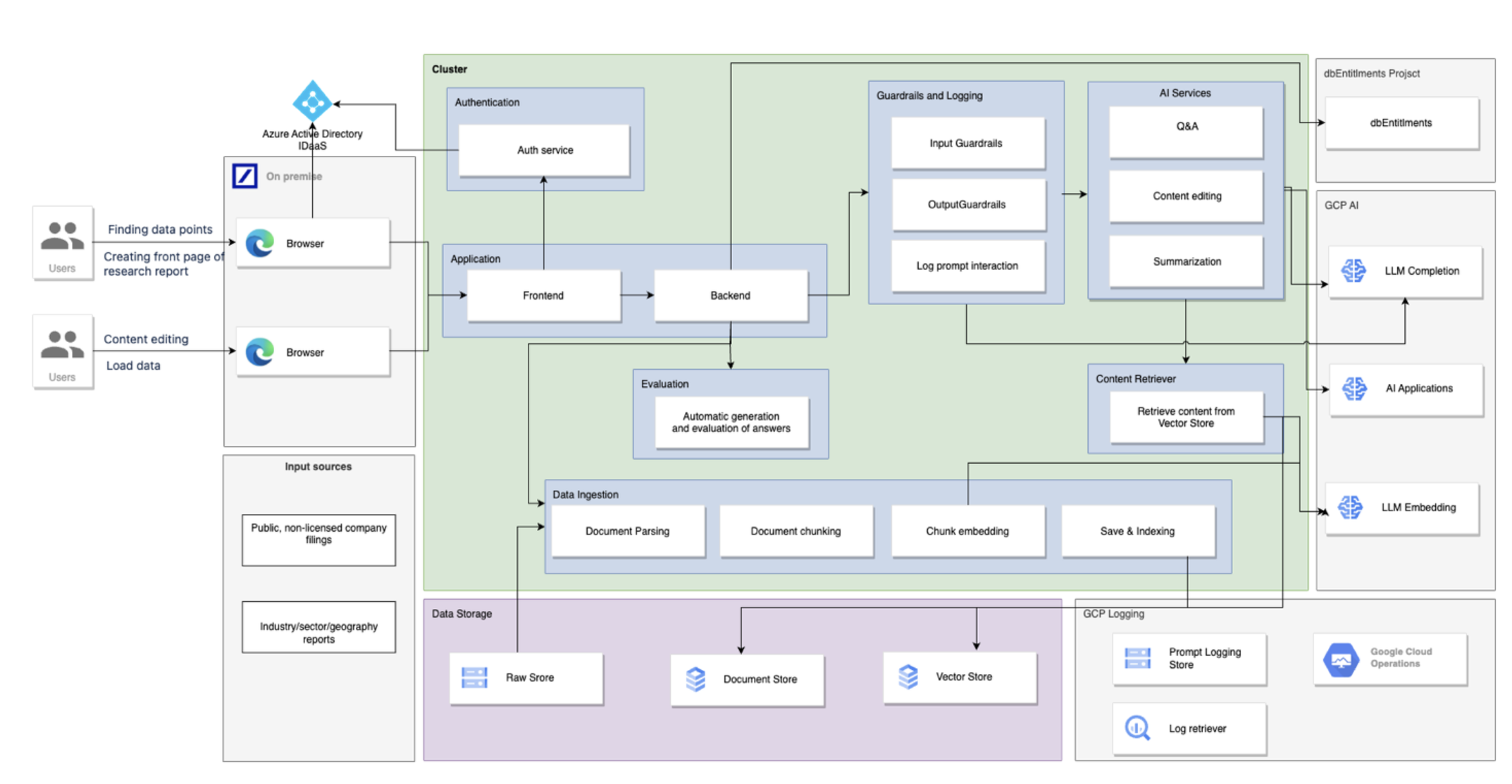

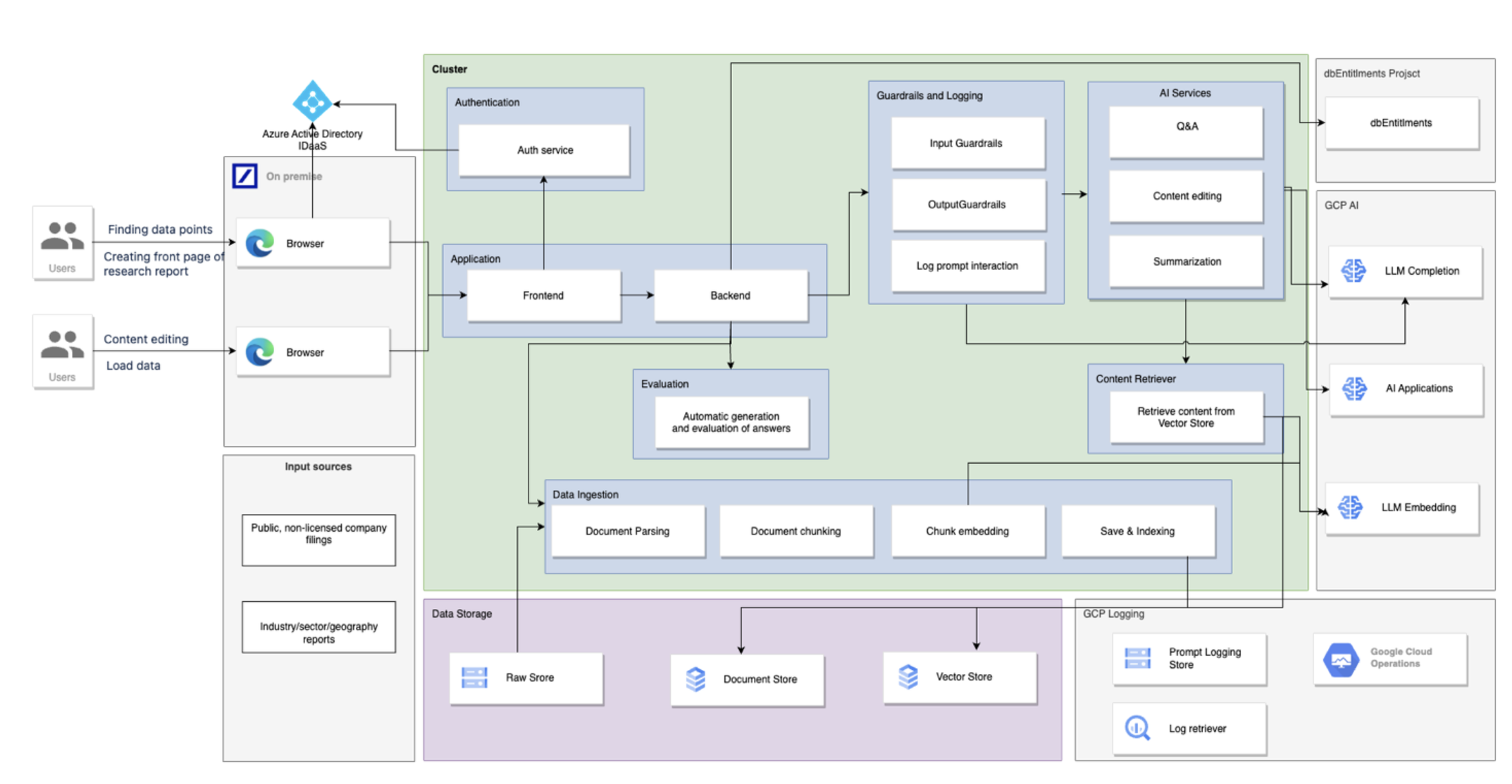

DB Lumina アーキテクチャ

DB Lumina は、ドキュメントの取り込み、コンテンツの要約、Q&A、編集を可能にすることで、ドイツ銀行リサーチ センターの生産性を向上させるように設計されました。

Google Cloud 上に構築されたこのアーキテクチャでは、次のサービスを活用しています。

-

マイクロサービス オーケストレーションのための Google Kubernetes Engine(GKE)

-

ベクトル サポートのための pgvector 拡張機能を備えた Cloud SQL

-

Cloud Storage: 非構造化データの管理と保存

-

ドキュメントの取り込みとエンベディングのための Dataflow

-

Gemini を使用したマルチモーダル AI 機能を強化する Vertex AI

-

テキストとコンテンツのモデレーションのための Cloud Natural Language API

DB Lumina のすべての AI 機能は、安全でコンプライアンスに準拠したやり取りを確保するための仕組みが実装されています。また、ロギングとモニタリングは Google Cloud のオブザーバビリティ スイートを使用し、プロンプトのインタラクションを Cloud Storage に保存して BigQuery でクエリを実行します。認証を管理するために、Azure AD と統合された Identity as a Service を使用し、dbEntitlements を通じて認可を一元化しています。

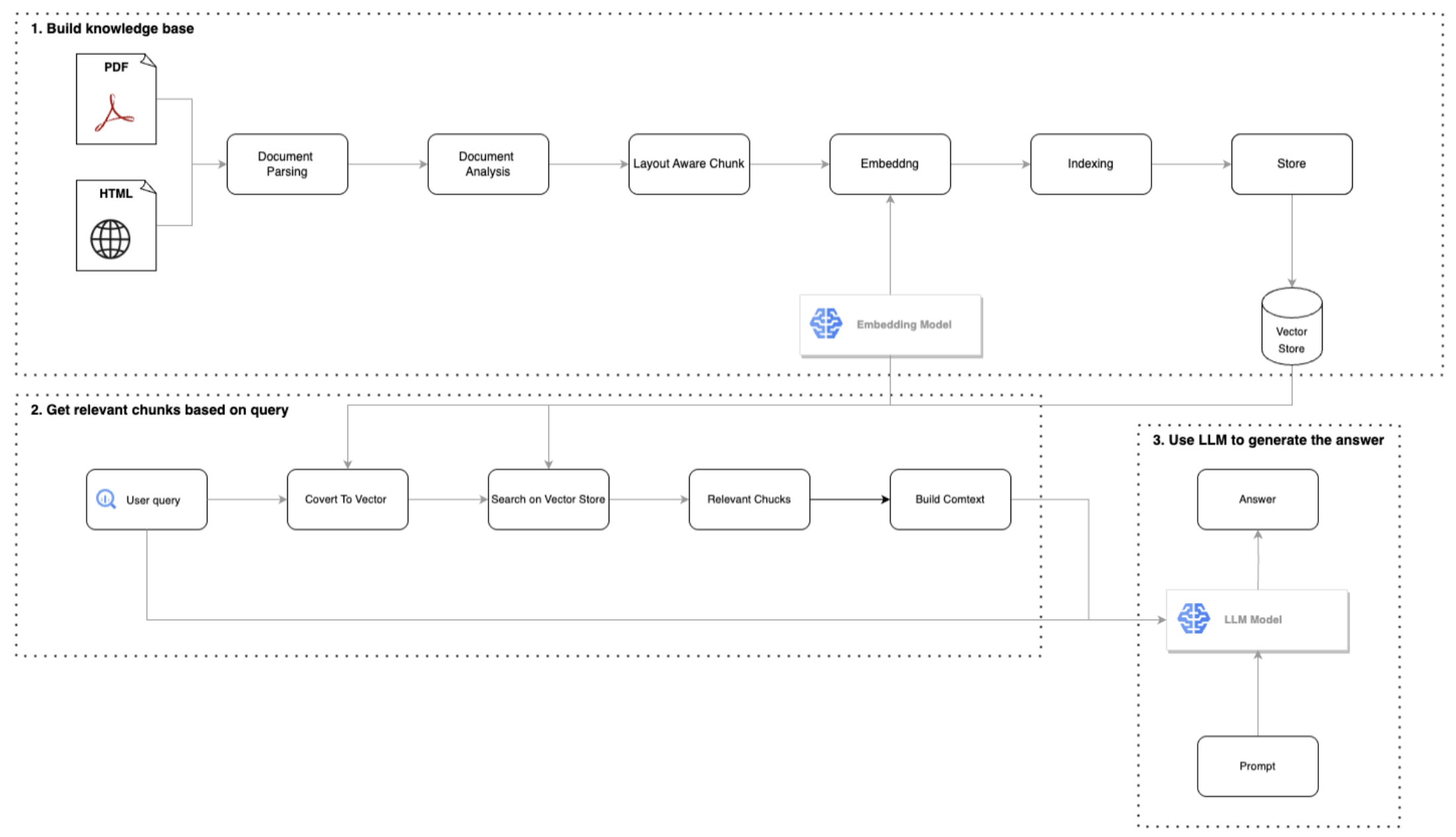

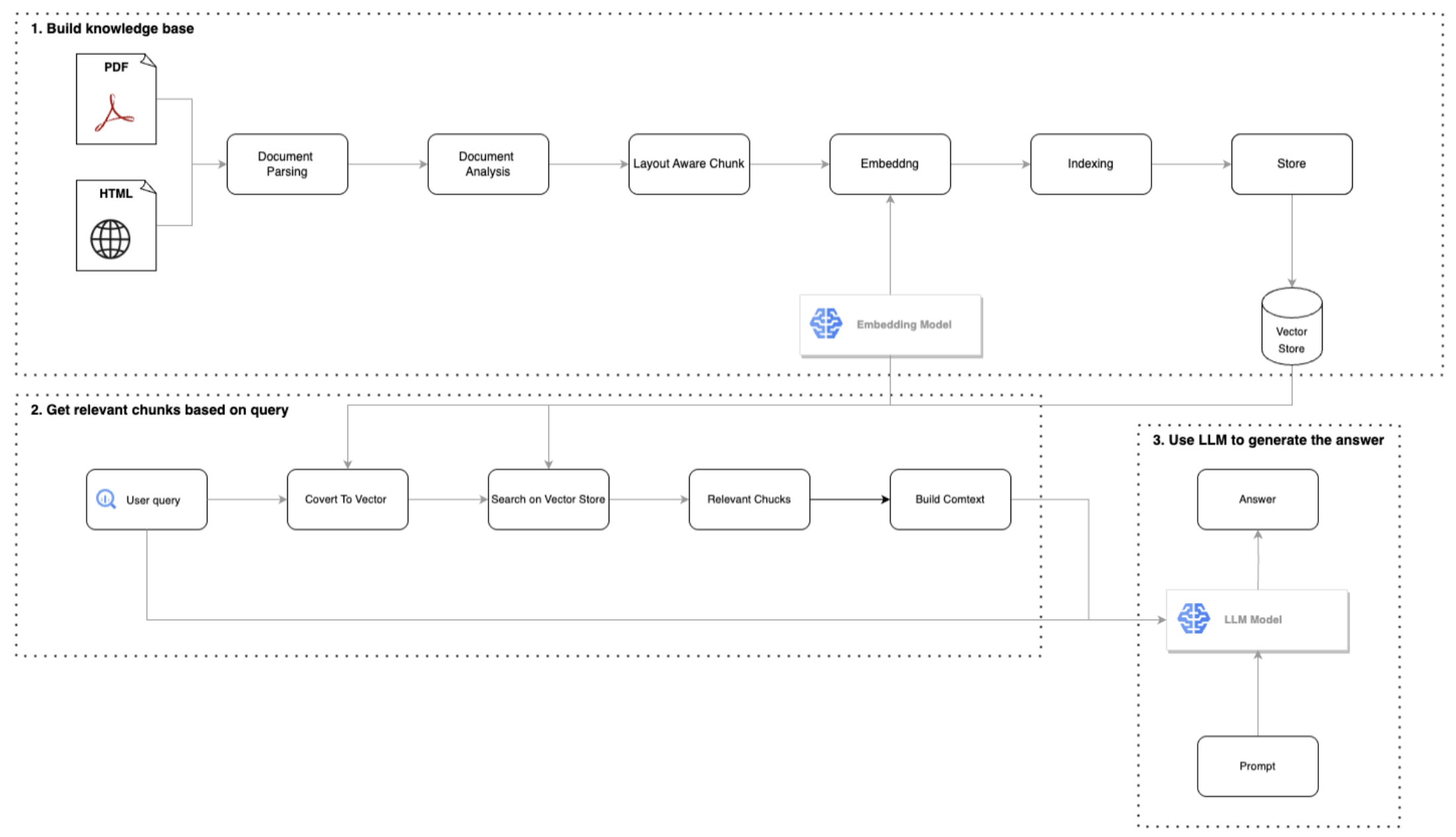

RAG とドキュメントの取り込み

DB Lumina がドキュメントを処理してインデックス化する際、ドキュメントはチャンクに分割され、Gemini Embeddings API などの API を使用してエンべディングが作成されます。その後、これらのエンベディングは、Vertex AI Vector Search や Cloud SQL の pgvector 拡張機能などのベクトル データベースに保存されます。未加工のテキストチャンクは、Datastore や Cloud Storage などに個別に保存されます。

以下の図は、一般的な RAG と取り込みのパターンを示しています。

エージェントの概要。

アナリストがクエリを送信すると、システムはクエリエンジンを介してクエリをルーティングします。Python アプリケーションは、LLM API(Gemini 2.0 および 2.5)を活用して、クエリに基づいて関連するドキュメント スニペットを取得し、モデルが関連する回答を生成するために使用するコンテキストを提供します。ソースには、Cloud SQL for PostgreSQL で pgvector 拡張機能を使用するものと、Vertex AI Search に基づくものを含め、さまざまなリトリーバーを使用した実験が示されています。

ユーザー インターフェース

DB Lumina のインターフェースのスライダーを使用すると、ユーザーは要約のさまざまなパラメータ(冗長性、データ密度、事実性、構造、読者の視点、流れ、個性など)を簡単に調整できます。このインターフェースには、要約に関するフィードバックを提供する機能も含まれています。

生成 AI の評価フレームワーク

DB Lumina のような生成 AI アプリケーションやエージェントを評価するには、モデル出力の複雑さと変動性に対応するための、カスタム フレームワークが必要です。従来の指標や一般的なベンチマークでは、生成 AI 機能のニーズ、ドメイン固有のユーザーの微妙な期待、企業環境の運用上の制約を捉えられないことがよくあります。そのため、パフォーマンスを正確に測定するには、生成 AI の新しい指標が必要になります。

DB Lumina の評価フレームワークでは、業界標準の指標とカスタム開発された指標の両方からなる、豊富で拡張可能なセットが採用されています。これらの指標は、定義されたカテゴリにマッピングされ、中央の指標ディクショナリに文書化されているため、チームと機能全体で一貫性が確保されます。精度、完全性、レイテンシなどの標準的な指標は基本ですが、引用の精度と再現率、偽陽性率、冗長性制御などのカスタム指標で補強されています。これらの指標はそれぞれ、金融調査とドキュメントに基づく生成の特定の要件と規制要件に合わせて調整されています。Ragas などの一般的なフレームワークも、RAG システムが取得したドキュメントにどの程度根拠を持って応答を生成できているか、またハルシネーションを回避しているかを評価するうえで、有用な基盤を提供します。

さらに、テストデータセットは、DB Lumina のコア機能(チャット、ドキュメントの Q&A、テンプレート、RAG ベースのナレッジ検索など)にわたって、幅広い実際的なシナリオ、エッジケース、潜在的なバイアスを反映するように慎重にキュレートされています。これらのデータセットはバージョン管理されており、ツールが進化するにつれて関連性を維持するために定期的に更新されます。その目的は、制御された条件下でモデルの動作を評価するための安定したベンチマークを提供し、最適化サイクル全体で一貫した比較を可能にすることです。

評価は定量的および定性的で、自動スコアリングと人間によるレビューを組み合わせて、トーン、構造、コンテンツの忠実性などの側面を評価します。重要なのは、このフレームワークにより、各機能の正確性、ユーザビリティ、効率性、コンプライアンスが評価されると同時に、反復的な最適化と継続的なパフォーマンス モニタリングをサポートするために必要な迅速なフィードバックと堅牢なリスク管理が可能になることです。安定したテストセット、Git ハッシュのトラッキング、自動化された指標パイプラインを活用して、現在の指標出力を過去のベースラインと比較し、パフォーマンスの逸脱を早期に検出し、ユーザーやコンプライアンス基準に影響を与える前に対応できるよう、プロアクティブな介入をサポートします。

この階層化されたアプローチにより、DB Lumina は正確かつ効率的であるだけでなく、ドイツ銀行の社内基準にも準拠し、イノベーションと説明責任の両方をサポートする、バランスの取れた厳格な評価戦略を実現しています。

ビジネスに新たなメリットをもたらす

Google Cloud コンサルティングと共同で DB Lumina の最初のパイロット版を開発し、ユースケース開発の初期段階で、プロンプトなしでエンべディングのみを使用したシンプルなプロトタイプを作成しました。このパイロット版は、後のバージョンに機能面で劣るものの、DB Lumina の RAG アーキテクチャのその後の開発に役立ちました。

その後、プロジェクトは開発環境とアプリケーション テスト環境を経て本番環境へのデプロイに移行し、2024 年 9 月に本番環境で稼働を開始しました。現在、DB Lumina はドイツ銀行リサーチ センターの約 5,000 人のユーザーが利用しており、具体的には投資銀行のオリジネーション&アドバイザリー部門や債券&通貨部門などで活用されています。年末までに、法人向けバンキングやその他の機能で 10,000 人以上のユーザーに展開する予定です。

DBLumina は、ドイツ銀行に次のような大きなビジネス上のメリットをもたらすことが期待されています。

-

時間の節約: アナリストは、収益に関するメモのテンプレートの準備に 30 ~ 45 分、調査レポートやロードショーの最新情報の作成に最大 2 時間を節約できるなど、大幅な時間短縮を報告しています。

-

分析の深さの向上: あるアナリストは、収益レポートの分析を 50% 増加させ、地域別およびアクティビティ別の追加セクションと、予測変更の概要セクションを追加しました。これは、収益リリースと投資家向け説明会の要約を作成し、その後、会話型プロンプトを使用して分析することで実現しました。

-

新たな分析の機会: DB Lumina は、チームが新しいトピックを分析する新たな機会を創出しました。たとえば、米国と欧州のエコノミクス チームは、DB Lumina を使用して中央銀行のコミュニケーションをスコアリングし、時間の経過とともにタカ派とハト派の度合いを評価しています。別の分析担当者は、8 つの異なる省庁の予算演説を分析して比較し、能力の制約と成長志向に関連するキーワードを集計して、優先順位の変化を特定しました。

-

精度が向上: アナリストは、編集プロセスの一環として DB Lumina の使用も開始しました。ある監督アナリストは、導入以来、アナリストのメモ全体で、特に英語を母語としないアナリストのメモで、編集と文法の正確さが著しく向上したと述べています。

金融業界における生成 AI と RAG の未来を構築

RAG の力によって、金融機関がデータとやり取りする方法が変革されるのを見てきました。DB Lumina は、検索、生成 AI、会話型 AI を組み合わせることの価値を証明しましたが、これは取り組みの始まりにすぎません。Google は、Google のアーキテクチャに固有の「エージェント」機能を活用し、改良していくことが未来につながると考えています。さまざまなコンポーネントがエージェントとして機能するシステムを構築し、オーケストレートすることを想定しています。すべてのエージェントが連携して、複雑な財務に関する問い合わせに対してインテリジェントで情報に基づいた回答を提供します。

今後のビジョンをサポートするため、RAG フレームワーク内でエージェントの専門性を深め、コンプライアンス、投資戦略、リスク評価など、特定の種類のクエリやタスクを処理するように設計されたエージェントを構築する予定です。また、ReAct(Reasoning and Acting)パラダイムをエージェントの意思決定プロセスに組み込み、エージェントが情報を取得するだけでなく、積極的に推論し、行動を計画し、検索を絞り込んで、より正確でニュアンスに富んだ回答を提供できるようにしたいと考えています。

さらに、Vertex AI で利用できるツールやサービスを積極的に調査して実装し、AI 機能をさらに強化していきます。これには、特定のタスクやさまざまなパフォーマンス特性を実現するための他のモデルの探索、ベクトル検索インフラストラクチャの最適化、RAG システム全体の効率とスケーラビリティを高めるための AI パイプラインの活用が含まれます。最終的な目標は、コンテキストの理解を深めることで、DB Lumina がますます複雑化する多面的なクエリを処理できるようにすることです。これにより、以前のやり取りや基礎となる金融の概念などのコンテキストを正確に解釈できるようになります。これには、単純な質問への回答だけでなく、取得した情報に基づいて分析や推奨事項を提供することも含まれます。DB Lumina がリアルタイムで情報を提供し、最新の外部データを必要とするクエリに対応する能力を強化するため、インターネットベースの情報で回答をグラウンディングする機能を統合する予定です。

これらの分野に注力することで、DB Lumina を、有益な情報検索ツールから、最も困難な金融関連の問い合わせにも対応できる強力な AI エージェントへと変革することを目指しています。これにより、金融機関はカスタマー サービスの向上、意思決定の強化、運用効率の向上という新たな機会を得ることができます。金融業界における RAG と生成 AI の未来は明るく、Google はこの変革的なテクノロジーの最前線に立つことを楽しみにしています。

ー Max Sommerfeld 氏、ドイツ銀行、応用 AI エンジニアリング担当責任者

ー Crispin Velez、Google、グローバル AI インキュベーション