NVIDIA RTX PRO 6000 により、Cloud Run 上で高性能推論とサーバーレス コンピューティングが融合

James Ma

Sr. Product Manager

Oded Shahar

Sr. Engineering Manager

※この投稿は米国時間 2026 年 2 月 3 日に、Google Cloud blog に投稿されたものの抄訳です。

大規模な推論モデルの実行には、クラスタ管理や VM の手動メンテナンスなど、運用面で大きな負担が伴うことが少なくありません。こうした負担を軽減する方法の一つが、基盤となるインフラストラクチャを意識せずに利用できるサーバーレスのコンピューティング プラットフォームを活用することです。Google はこのたび、Cloud Run で NVIDIA RTX PRO™ 6000 Blackwell Server Edition GPU に対応するハイエンド推論においてサーバーレスの提供を開始いたしました。現在はプレビュー版が提供されており、Gemma 3 27B や Llama 3.1 70B といった大規模モデルも、Cloud Run でおなじみの「デプロイしたらあとは任せる」感覚でデプロイできます。予約は不要。クラスタ管理も不要。必要なのはコードだけです。

強力な GPU プラットフォーム

NVIDIA RTX PRO 6000 Blackwell GPU は、NVIDIA L4 GPU と比べて大幅な性能向上を実現しており、96 GB の vGPU メモリ、1.6 TB/秒の帯域幅に加え、FP4 および FP6 をサポートしています。これにより、基盤となるインフラストラクチャを自ら管理することなく、70B 超のパラメータを持つ大規模モデルを提供できます。Cloud Run では、NVIDIA RTX PRO 6000 Blackwell GPU を Cloud Run サービス、ジョブ、またはワーカープールに、予約不要でオンデマンドにアタッチできます。以下は、NVIDIA RTX PRO 6000 Blackwell GPU を活用してビジネスを加速できる主な活用例です。

-

生成 AI と推論: FP4 精度をサポートする NVIDIA RTX PRO 6000 Blackwell GPU の高効率な演算性能により、LLM のファインチューニングや推論を高速化できます。これにより、マルチモーダル モデルやテキストから画像を生成するモデルなど、リアルタイム性が求められる生成 AI アプリケーションを構築できます。さらに、Cloud Run サービス上でモデルを実行することで、迅速な起動とスケーリングのメリットも享受できます。インスタンス数が 0 の状態から、GPU ドライバがインストールされた GPU 環境を 5 秒未満で起動可能です。トラフィックが減少してリクエストがなくなると、Cloud Run は GPU インスタンスを自動的に 0 までスケールダウンします。

-

ファインチューニングとオフライン推論: NVIDIA RTX PRO 6000 Blackwell GPU は、Cloud Run ジョブと組み合わせることで、モデルのファインチューニングに活用できます。第 5 世代 NVIDIA Tensor コアは AI モデルと連携し、レンダリング パイプラインの高速化やコンテンツ制作の効率向上に貢献します。

-

特定のワークロードに最適化されたスケーリング: GPU 対応のワーカープールを使用することで、GPU ワーカーをきめ細かく制御できます。外部のカスタム指標に基づく動的スケーリングや、複雑でステートフルな処理に対応するための「常時稼働」インスタンスの手動プロビジョニングなど、用途に応じた柔軟なスケーリングを実現できます。

Cloud Run は、プロダクション レディな GPU アクセラレーテッド タスクを、最もシンプルに実行できるよう設計されています。Cloud Run の主な特長は次のとおりです。

-

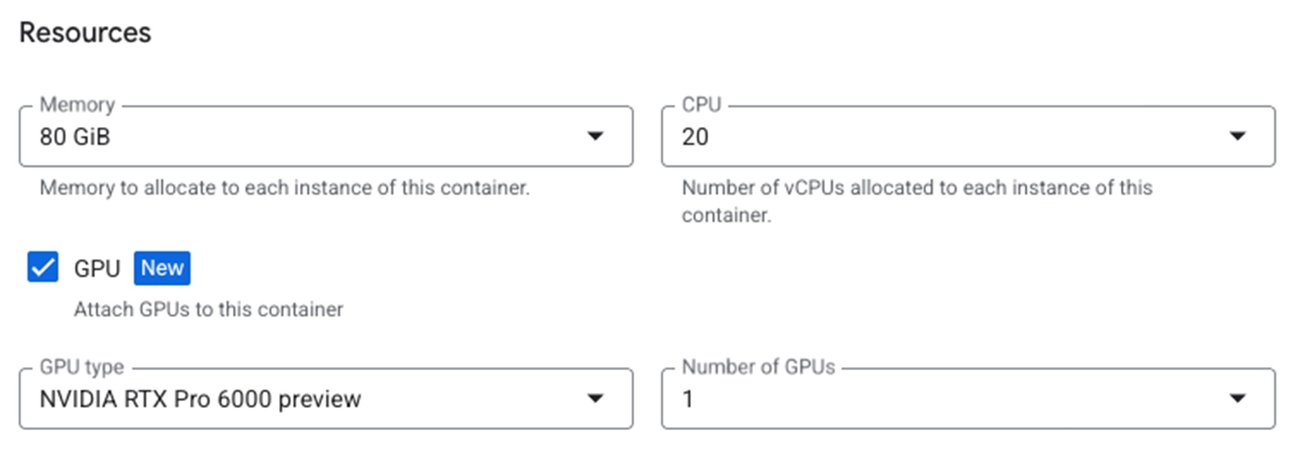

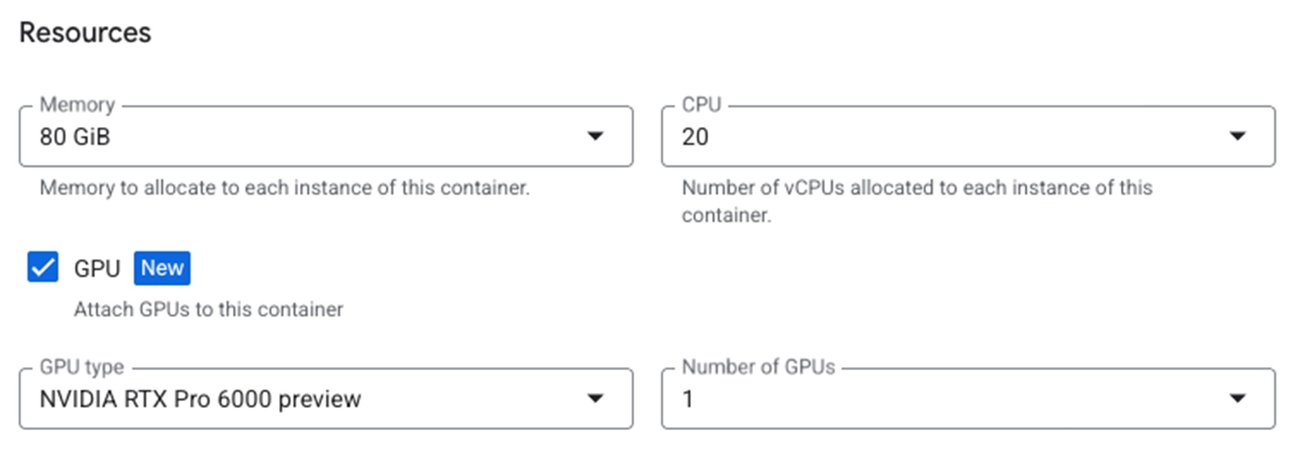

柔軟なコンピューティングを備えたマネージド GPU: Cloud Run では、必要な NVIDIA ドライバがあらかじめインストールされているため、インフラストラクチャの準備に煩わされることなく、コードの実装に集中できます。NVIDIA RTX PRO 6000 Blackwell GPU を使用する Cloud Run インスタンスでは、最大 44 vCPU と 176 GB の RAM を構成できます。

-

本番環境レベルの信頼性: Cloud Run はデフォルトでゾーン冗長性を提供しており、ゾーン停止に耐えるために十分な容量をサービスに確保できます。これは、Cloud Run で GPU を使用した場合にも適用されます。また、ゾーン冗長性をオフにして、ゾーン停止が発生した場合に GPU ワークロードのベスト エフォート フェイルオーバーを行うことにすれば、料金を低く抑えられるメリットがあります。

-

緊密な統合: Cloud Run は、Google Cloud の他のサービスとネイティブに連携します。Cloud Storage バケットをローカル ボリュームとしてマウントすることで大規模なモデルの重みを読み込んだり、Identity-Aware Proxy(IAP)を使用して Cloud Run サービス宛てのトラフィックを安全に保護したりすることができます。

使ってみる

NVIDIA RTX PRO 6000 Blackwell GPU は、現在プレビュー版としてオンデマンドで利用可能です。対応リージョンは us-central1 および europe-west4 で、asia-south2 と asia-southeast1 では限定的に提供されています。オープンモデルを実行する最も簡単な方法の一つである Ollama を使用すれば、NVIDIA RTX PRO 6000 GPU を有効化した Cloud Run 上に、次のコマンドで最初のサービスをデプロイできます。

詳しくは、最新の Cloud Run ドキュメントおよび AI 推論のベスト プラクティスをご覧ください。

-シニア プロダクト マネージャー、James Ma

-シニア エンジニアリング マネージャー、Oded Shahar