セキュリティが確保された AI を Google Cloud で使いこなすための企業向け実践ガイド

Schneider Larbi

Principal Partner Engineer

David Peterside

Partner Engineer

※この投稿は米国時間 2025 年 3 月 22 日に、Google Cloud blog に投稿されたものの抄訳です。

はじめに

業界全体で AI の導入が急速に進むなか、データのプライバシーとセキュリティに関する新たな課題が浮上し、多くの組織はセキュリティが確保されたソリューションの実装に依然として苦労しています。

Google は、お客様による AI の開発とデプロイの成功を望んでおり、そのためにはリスク軽減とプロアクティブなセキュリティ対策を慎重に検討する必要があります。

セキュアな AI プラットフォームの 4 つの基盤

AI を導入する際には、個々のモデルだけに注目するのではなく、プラットフォーム ベースのアプローチを検討することが重要です。

セキュアな AI プラットフォームには、安全なストレージ施設と同様に、強固な基盤が必要です。それを構成するのがインフラストラクチャ、データ、セキュリティ、責任ある AI(RAI)です。

-

インフラストラクチャは組織の基礎です。ストレージ施設の物理的なセキュリティと同様の役割を果たすセキュアな Google Cloud インフラストラクチャ(コンピューティング、ネットワーキング、ストレージ)は、AI モデルと AI アプリケーションが動作する AI プラットフォームです。

-

データは保護された燃料のようなものです。AI を活用したアプリケーションの開発にはデータ セキュリティが極めて重要であり、データを不正アクセス、改ざん、盗難から保護することは不可欠です。保護されたデータは、AI の完全性、プライバシー コンプライアンス、顧客からの信頼の確保に役立ちます。

-

セキュリティは盾のようなものです。このレイヤは、ストレージ施設のセキュリティ システムと同様に、脅威の検出と防止、および脅威への対応によって AI エコシステム全体を保護します。攻撃対象領域の最小化、インシデントの検出と、機密性、完全性、可用性の維持につながる強固な AI セキュリティ戦略が必要です。

-

責任ある AI は倫理的な指針です。企業の AI システムに対する信頼を築くことは、その保護と同じくらい重要です。責任ある AI とは、AI システムを社会に有益な方法で倫理的に使用するためのアプローチであり、ストレージ施設を違法行為や非倫理的な行為ではなく、意図された目的のために使用することと同様の意味を持ちます。RAI は次の概念に基づいています。

-

公平性: AI モデルにバイアスがないようにバイアスを軽減し、すべてのユーザーを公平に扱うようにします。そのためには、慎重なデータ選択、モデル評価、継続的なモニタリングが必要です。

-

説明可能性: AI モデルに透明性を持たせて理解しやすくすることで、潜在的な問題を特定し対処できるようになります。Explainable AI は、AI システムに対する信頼の構築に役立ちます。

-

プライバシー: データ保護とコンプライアンスにより、ユーザーデータを保護し、プライバシーに関する規則を遵守できます。これには、適切にデータを匿名化する手法の実装が含まれます。

-

アカウンタビリティ: 企業の AI システムの開発とデプロイに関する責任範囲を明確化し、その倫理的な影響に関するアカウンタビリティを確保します。

責任ある AI は、AI システムに対する信頼の構築と、AI システムの倫理的かつ有益な使用を実現するために不可欠です。公平性、説明可能性、プライバシー、アカウンタビリティの確保を優先することで、組織はセキュリティが確保された信頼できる AI システムを構築できます。Google は、次のような設計上の考慮事項によってお客様の AI 導入をサポートしています。

Vertex AI のセキュリティに関する設計上の主な考慮事項

Vertex AI は、ML モデルの構築とデプロイ、ならびに基盤モデルへのアクセスに利用できるセキュアなマネージド環境を提供します。ただし、Vertex 上に構築する場合、慎重なセキュリティ設計が必要です。

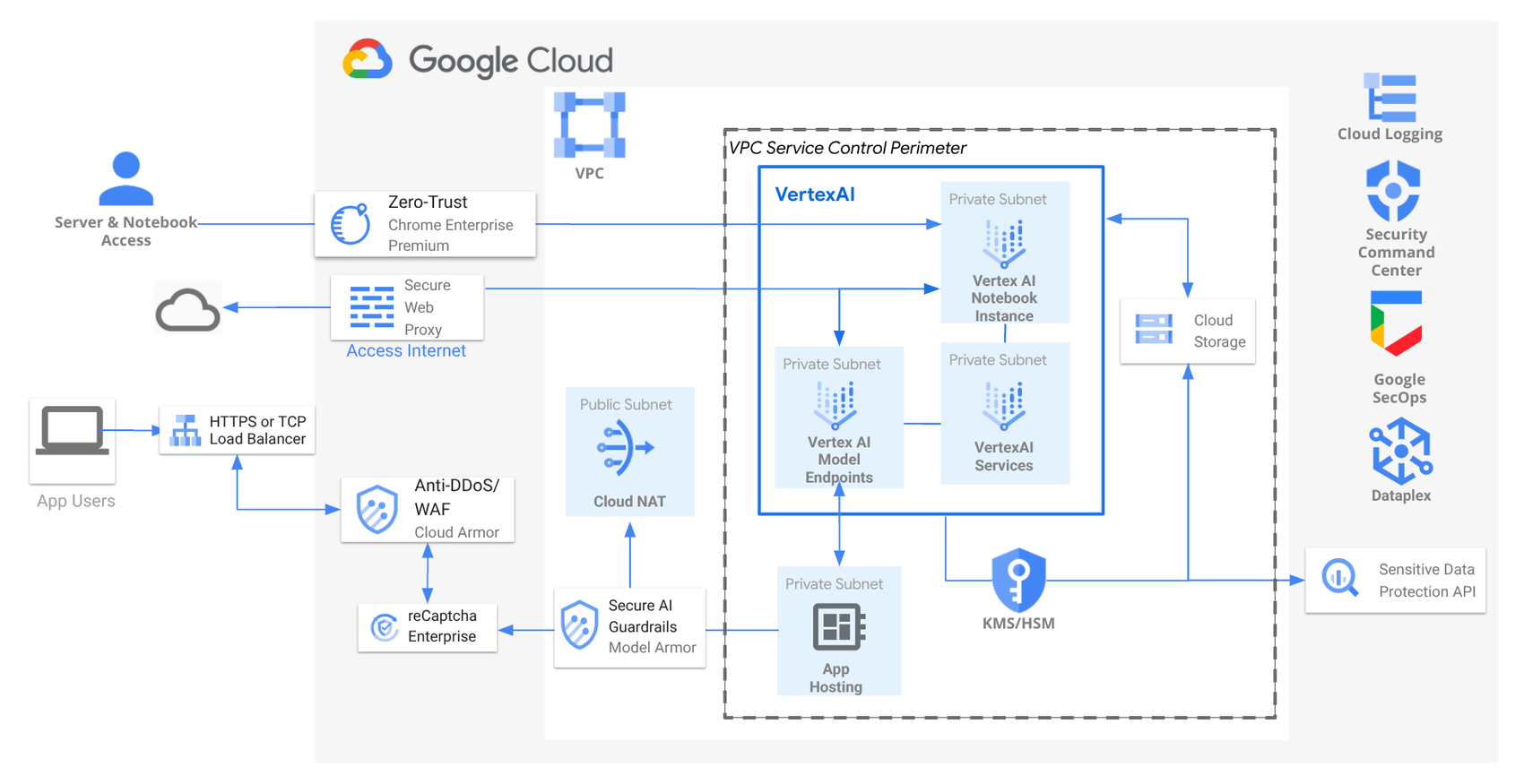

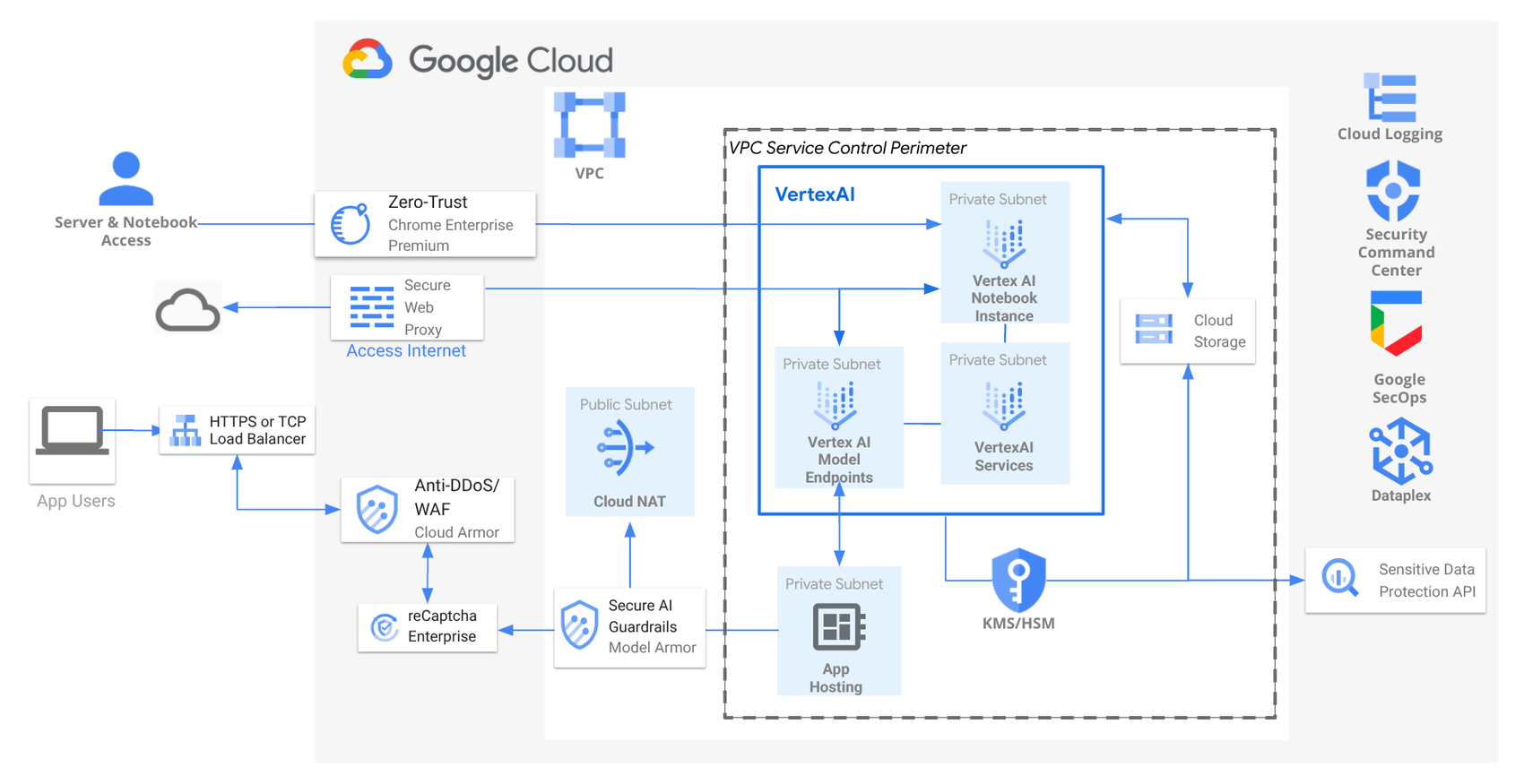

セキュアな AI / ML デプロイのリファレンス アーキテクチャ

上のアーキテクチャでは、4 つの重要な基盤を念頭に置いて AI アプリケーションのセキュリティを設計することを推奨しています。

ここに示されているように、Virtual Private Cloud(VPC)はプラットフォームの基礎として公共のインターネットから AI リソースを隔離し、Google Cloud 上に機密データ、アプリケーション、モデルのためのプライベート ネットワークを構築します。

Vertex AI リソース(Notebooks やモデル エンドポイントなど)のプライベート エンドポイント タイプとして、Private Service Connect(PSC)を使用することをおすすめします。これにより、Vertex AI リソースをプライベート VPC サブネットにデプロイして、インターネットからの直接アクセスを防ぐことができます。また、VPC 内のプライベート サブネットにデプロイされたアプリケーションが、セキュリティを確保した状態で AI モデルに対する非公開の推論を行うこともできます。

VPC Service Controls 境界とファイアウォール ルールは、Identity and Access Management(IAM)に加えて、ネットワーク通信の承認や不要な接続のブロックに使用されます。これにより、AI 処理に使用するクラウド リソースとデータのセキュリティが強化されます。アクセスレベルを IP アドレス、デバイス ポリシー、ユーザー ID、地理的位置に基づいて定義することで、保護されたサービスやプロジェクトへのアクセスを制御できます。

ノートパソコンなどのプライベート リソースがアップデートのためにインターネットにアクセスする必要がある場合は、Cloud NAT を構築することをおすすめします。これにより、プライベート サブネット内のインスタンスが(ソフトウェア アップデートなどの場合に)直接の受信接続にさらされることなくインターネットにアクセスできるようになります。

このリファレンス アーキテクチャでは、AI アプリケーションのネットワーク エントリ ポイントとして クラウド ロードバランサ(LB)を使用しています。LB はトラフィックを複数のインスタンスにセキュアに分散させ、高可用性とスケーラビリティを実現します。Cloud Armor と統合されており、サービス拒否(DDoS)攻撃やウェブ攻撃を防御します。

reCAPTCHA Enterprise は、bot と人間の両方による不正行為や悪用を防ぐことができます。Google Cloud が史上最大規模の DDoS 攻撃を阻止したときのように、LB のスケーラビリティは DDoS 攻撃の影響を効果的に軽減できます。

Model Armor は、基盤モデルのプロンプトとレスポンスをスクリーニングしてさまざまなセキュリティや安全上のリスクを検出することで、AI アプリケーションのセキュリティと安全性を強化するために使用されます。このサービスでは、危険なハラスメントやヘイトスピーチのフィルタなどの機能を実行することもできます。さらに、Model Armor は、プロンプトおよびレスポンス内の悪意のある URL や、インジェクション攻撃、ジェイルブレイク攻撃を特定できます。

この設計では、Chrome Enterprise Premium を使用してゼロトラスト モデルを実装し、Google Cloud 上の AI アプリケーションへのリモート アクセスについてユーザーとデバイスごとに認証および認可することで、暗黙の信頼を排除しています。Chrome Enterprise Premium は、すべての受信トラフィックの検査と検証を強制し、Secure Web Proxy は、セキュアな下り(外向き)HTTP/S トラフィックを管理します。

Sensitive Data Protection は、機密情報を検出、分類、保護し、データの完全性を維持することで、Google Cloud 上の AI データを保護できます。Cloud Key Management は、Vertex AI モデル アーティファクトと機密データの一元的な暗号鍵管理に使用されます。

Vertex AI を使用する際には、このリファレンス アーキテクチャに加えて、適切な IAM ロールを実装することも重要です。これにより、ML ワークフローのさまざまな状態に応じた Vertex AI リソースの制御とアクセスが適用されます。たとえば、データ サイエンティスト、モデル トレーナー、モデルのデプロイ担当者などのロールを定義する必要があります。

最後に、Vertex AI のデプロイメントにおける潜在的な脆弱性を特定して対処するために、定期的なセキュリティ評価とペネトレーション テストを実施することが重要です。Security Command Center、Google Security Operations、Dataplex、Cloud Logging などのツールを使用して、Google Cloud で AI / ML をデプロイするためのセキュアなセキュリティ ポスチャーを強化できます。

Vertex AI での ML ワークフローの保護

前述の全般的な AI / ML セキュリティ アーキテクチャを基盤とする Vertex ベースの ML ワークフローでは、各段階で固有のセキュリティの課題が発生します。AI ワークロードを保護する際には、以下の推奨事項に沿ってそれらの課題に対処してください。

-

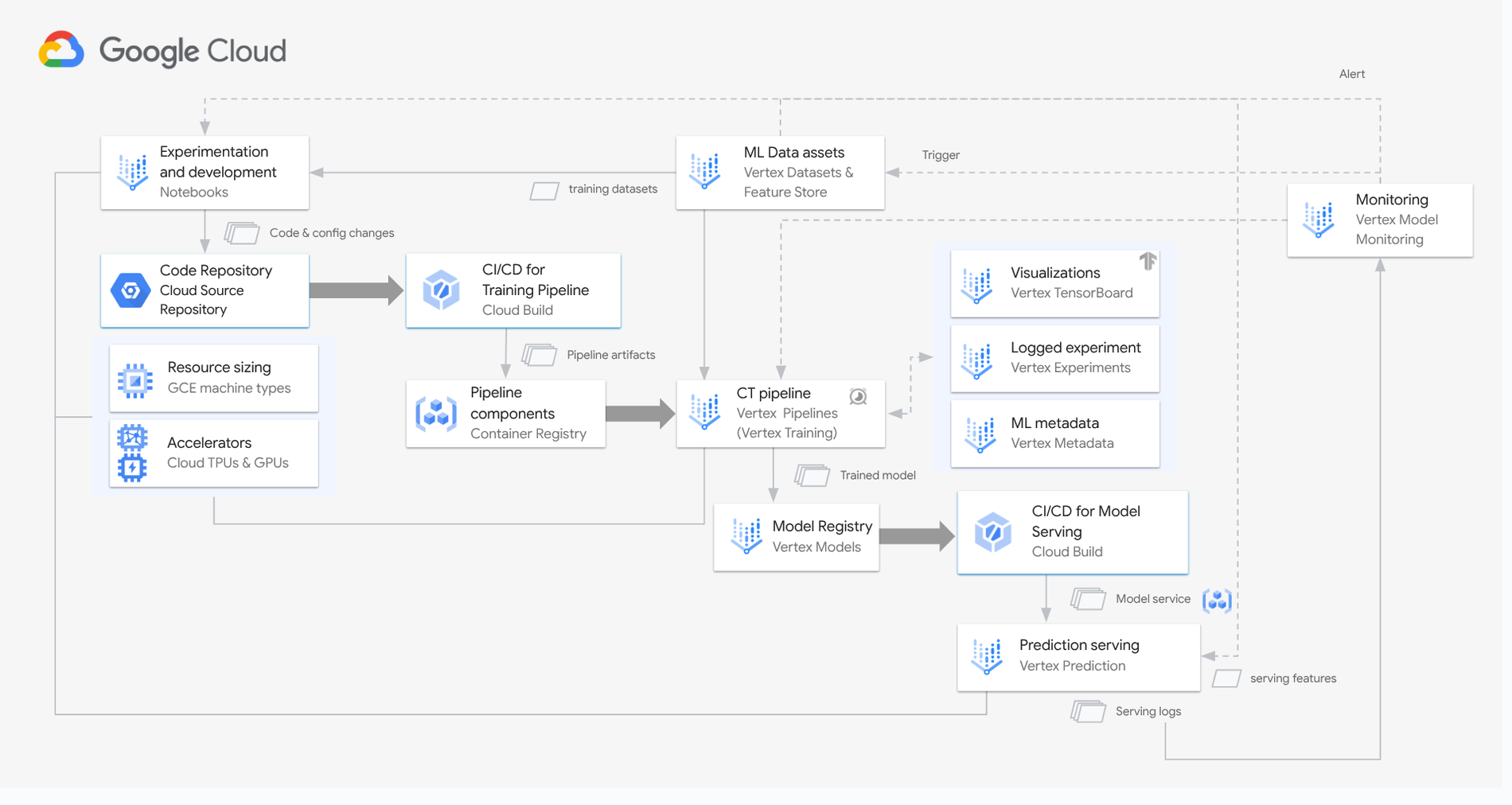

開発とデータの取り込み: 最初に IAM ロールでアクセスを管理してセキュアな開発を開始し、Vertex AI Notebooks で環境を分離してから、パイプラインの認証と入力のサニタイズによってインジェクション攻撃を防止することでセキュリティを確保した状態でデータを取り込みます。

-

コードとパイプラインのセキュリティ: IAM により、アクセス制御のために Cloud Source Repositories を使用してコード リポジトリを保護し、ブランチ保護ポリシーを実装します。Cloud Build を使用して CI / CD パイプラインを保護し、IAM でビルドの実行とアーティファクトへのアクセスを制御します。セキュアなイメージソースを使用し、コンテナ イメージに対して脆弱性スキャンを実施します。

-

トレーニングとモデルの保護: プライベート エンドポイントの使用、トレーニング データへのアクセスの制御、不審なアクティビティのモニタリングによって、モデルのトレーニング環境を保護します。Container Registry によってパイプライン コンポーネントを管理し、限定公開レジストリへのアクセスの制御とコンテナ イメージの脆弱性スキャンを優先します。

-

デプロイとサービング: 強固な認証と認可によってモデルのエンドポイントを保護します。また、レート制限を実装して不正使用を防止します。予測サービングに Vertex Prediction を使用し、モデルのアクセス制御と入力のサニタイズに関する IAM ポリシーを実装してプロンプト インジェクションを防ぎます。

-

モニタリングとガバナンス: 継続的なモニタリングが重要です。Vertex Model Monitoring をアラートの設定、異常値の検出、データ プライバシー保護対策の実行に使用します。

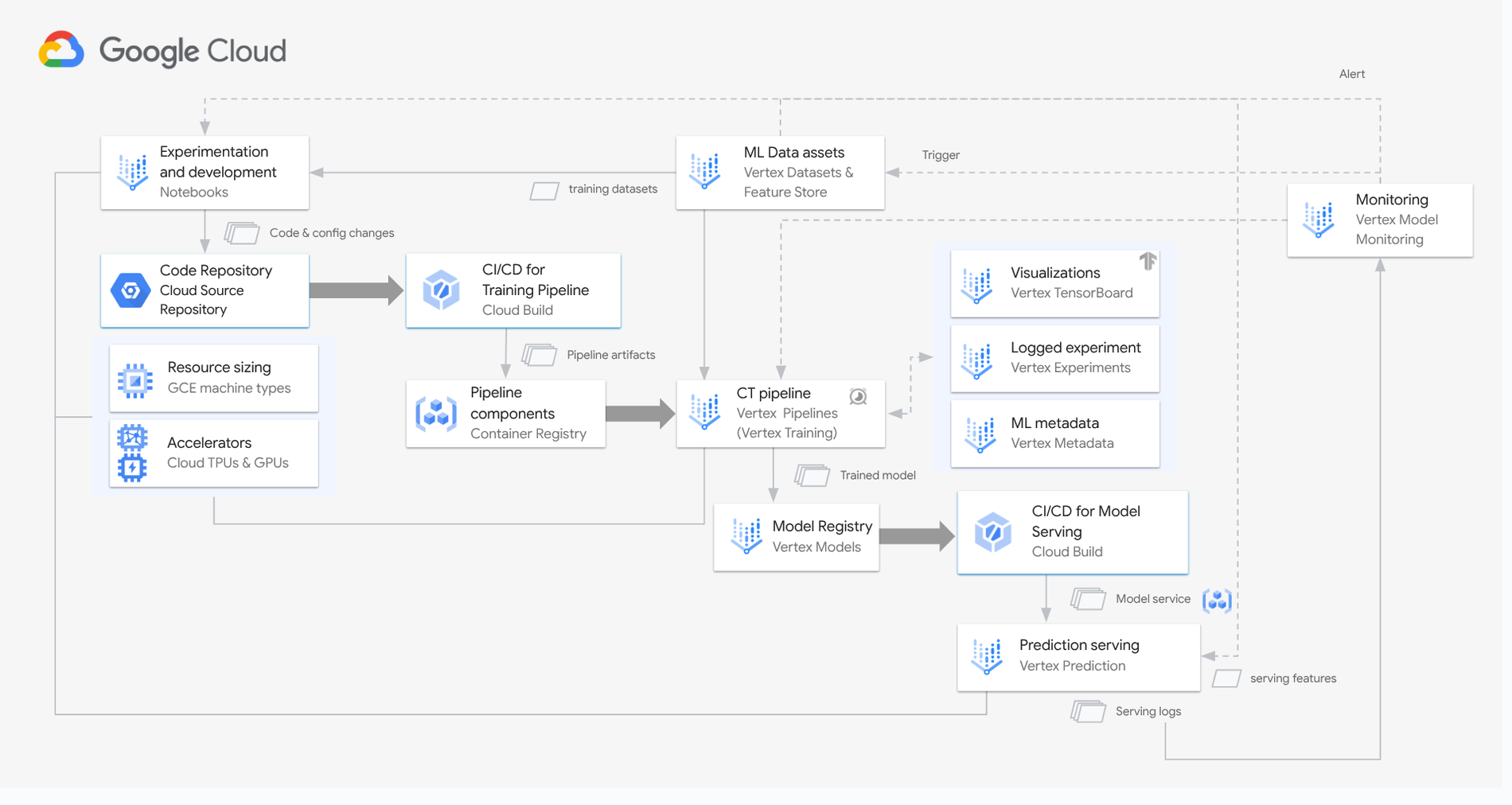

セキュアな MLOps のリファレンス アーキテクチャ

セキュアな開発とコード管理から、堅牢なモデル保護と継続的なモニタリングまで、Vertex AI MLOps ワークフロー内のこれらの主要領域に重点を置くことで、AI アプリケーションのセキュリティを大幅に強化できます。

Vertex AI の機密性の高い AI

Vertex AI で機密性の高い顧客データを扱う場合は、Confidential Computing を使用することをおすすめします。これにより、VM メモリの暗号化、Google でも抽出できない各 VM で一意のハードウェアベースのエフェメラル鍵の生成、CPU / GPU 間で転送中のデータを暗号化が可能になります。この高信頼実行環境では、データアクセスが承認済みのワークロードのみに制限されます。

また、データの機密性が確保され、証明書によってコードの完全性が保証され、オペレーターとワークロード オーナーが信頼境界から除外されます。

今すぐ対策を開始

組織で次の重要なアクションを実行し、Google Cloud での AI セキュリティに優先的に取り組んでいただくことをおすすめします。

-

データ ガバナンス、セキュリティ、インフラストラクチャ、RAI について、Google Cloud のベスト プラクティスが採用されていることを確認する。

-

VPC Service Controls、CMEK による暗号化、IAM によるアクセス制御などのセキュリティ管理を実装する。

-

RAI ツールキットを使用して、AI に対する責任あるアプローチを実践する。

-

Google Safeguards を使用して AI モデルを保護する。

-

データ マネジメントにおけるデータ プライバシーとセキュアな手法の重要性を確認する。

-

MLOps ワークフロー全体に、おすすめのセキュリティ対策を適用する。

-

セキュア AI フレームワーク(SAIF)を含む最新のリソースによって常に情報を収集し、最新の状態を維持する。

これらの戦略を実装することで、組織は AI のメリットを活用しながらリスクを効果的に軽減し、Google Cloud 上で信頼できるセキュアな AI エコシステムを確保できます。これらの手法の実装にサポートが必要な場合は、Google 認定パートナーにお問い合わせください。

-シニア パートナー エンジニア、Schneider Larbi

-パートナー エンジニア、David Peterside