Confidential Accelerators による AI ワークロードのセキュリティ強化

Joanna Young

Senior Product Manager, Google

Sam Lugani

Product Lead, Confidential Computing, Google Cloud

※この投稿は米国時間 2024 年 6 月 18 日に、Google Cloud blog に投稿されたものの抄訳です。

AI と ML のワークロードが普及するにつれ、専門的なデータ セキュリティ対策によってワークロードを保護することが重要になります。Confidential Computing では、ML のトレーニングに使用される機密データが保護され、推論中のユーザー プロンプトや AI / ML モデルのプライバシーを維持でき、モデル作成中のセキュアな協業が可能になります。

Google Cloud Next において、AI / ML ワークロードのプライバシーと機密性の保護を目的に開発した 2 つの新しい Confidential Computing ソリューションを発表しました。HGX の保護された PCIe を備えた NVIDIA H100 Tensor Core GPU 搭載の Confidential VMs と、Intel Advanced Matrix Extensions(インテル AMX)をサポートする Confidential VMs です。

A3 Confidential VMs: 機密 AI / ML ワークロードを保護

Google Cloud は NVIDIA と協業して、GPU に Confidential Computing を導入しました。H100 は NVIDIA として初の Confidential Computing をサポートする GPU で、専用の Confidential Computing モードが用意されています。このモードではハードウェア ベースの堅牢なセキュリティが有効になり、承認されたユーザーのみが高信頼実行環境(TEE)内でデータとコードを実行できます。

HGX の保護された PCIe を備えた NVIDIA H100 Tensor Core GPU 搭載の Confidential VMs によって、制限の強いデータセットや、追加保護を必要とする機密モデルを含むユースケースの実行が可能になります。また、Confidential Computing ハードウェアを通じてインフラストラクチャのリスクを軽減し、分離を強化しながら、信頼が確認されていない複数の相手やパートナーとの共同作業が可能になります。

ファインチューニングとトレーニングAI モデルのトレーニングでは、データとコードを常に保護したいと考えるでしょう。NVIDIA H100 GPU を搭載した A3 Confidential VMs では、個人を特定できる情報(PII)や独自のデータラベル付け、企業秘密を含む入力データを使用するトレーニングを TEE 内で実行できるので、ファインチューニングやその他の AI / ML トレーニングが TEE の外部から見えないようにすることができます。

たとえば、小売業者が顧客により良いサービスを提供するために、カスタマイズされたレコメンデーション エンジンを作成したいとします。そのためには顧客の属性や購入履歴を使用してトレーニングを行う必要があります。このような場合、トレーニングを TEE 内で行えば、小売業者は顧客データがエンドツーエンドで保護されることを保証できるようになります。

サービングAI モデルとその重みは、多くの場合、高度な保護を必要とする機密性の高い知的財産です。そのモデルが使用時に保護されなければ、モデルから機密の顧客データが漏洩し、操作やリバース エンジニアリングさえもが行われるリスクが生じます。NVIDIA H100 GPU を搭載した A3 Confidential VMs は、データとモデルを高度にセキュアな状態で処理することを可能にし、機密性の高いモデルやリクエストの不正アクセスや漏洩を防ぐことで、モデルと推論リクエストおよびレスポンスを保護できます。必要に応じて、モデルの作成者からも保護できます。

これは、AI / ML による chatbot を実行する人々にとっては特に重要です。自然言語処理(NLP)モデルで動作する chatbot へのプロンプトの一部として、ユーザーがプライベートなデータを入力することはよくあり、データ プライバシーに関する規則により、そうしたユーザーのクエリを保護する必要が生じる場合があります。モデルベースの chatbot が A3 Confidential VMs 上で実行されていれば、その chatbot の作者は、ユーザーの入力は本人以外の誰にも見えないという追加の保証を提供できます。

協業多くの組織は、それぞれのモデルや制限付きデータを互いに公開することなく、モデルのトレーニングとその上での推論を実行する必要があります。NVIDIA H100 Tensor Core GPU を搭載した Confidential VMs を使用すると、データの処理や結果の共有の方法に関する検証可能なポリシーを適用することにより、組織は機密性を保ちながら協業することが可能になります。

このユースケースは、複数の医療機関や病院の間で高度に保護された医療データセットや記録を集約して、元データを相互に開示せずにモデルをトレーニングする場合など、ヘルスケア産業でよく見られます。NVIDIA H100 GPU を搭載した A3 Confidential VMs を使用すれば、ヘルスケア企業は Confidential Space のようなデータ クリーンルーム内で協業できるので、セキュリティとパフォーマンスを確保できます。

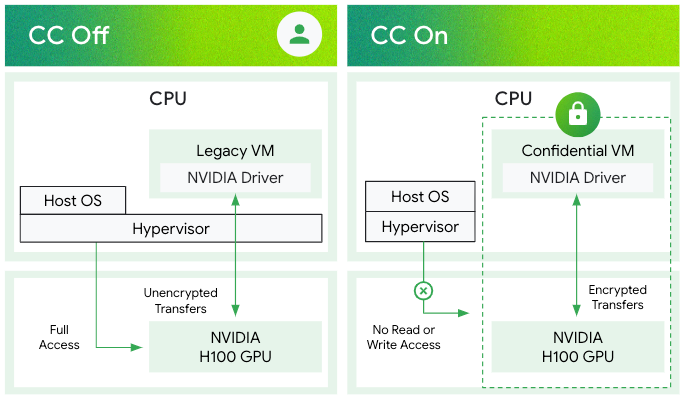

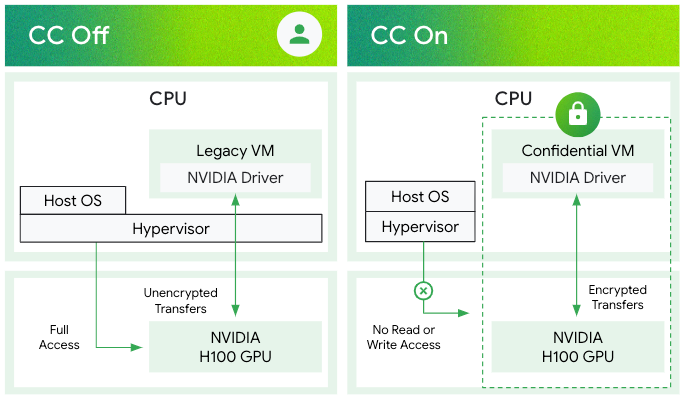

A3 Confidential VMs は、高信頼実行環境(TEE)を VM 自体の範囲を超えて拡張し、統合された NVIDIA H100 GPU を包含することで、総合的なデータ保護を確保します。これはプライバシーを中心に置いたアプローチによって実現されます。CPU ハードウェアによって Confidential VMs のメモリへの GPU の直接アクセスが防御され、強固なセキュリティ境界を維持できます。

セキュアにデータを転送するため、CPU TEE 内で動作する NVIDIA のドライバは、共有システムメモリ内に設けられた暗号化「バウンス バッファ」を利用します。このバッファは仲介役として機能し、コマンド バッファや CUDA カーネルを含む CPU と GPU の間のすべての通信を暗号化することで、起こりうるインバンド攻撃を軽減します。すなわち、このアーキテクチャではセキュアなデータ パイプラインが作成されるため、パワフルな NVIDIA H100 GPU で機密情報が処理される場合でも、機密性と完全性が保証されます。

最大のメリットとしては、CUDA ドライバと GPU ファームウェアが透過的に暗号化を処理するため、パフォーマンスが維持され使用しやすいことが挙げられます。

インテル TDX とインテル AMX を使用した Confidential VMs

「AI によってほぼすべての産業に変革が起こるでしょうが、そこにはセキュリティ、プライバシー、規制についての重要な要件が付随します」と Intel のセキュリティ ソフトウェアおよびソリューション グループ担当バイス プレジデント兼ゼネラル マネージャーである Anand Pashupathy 氏は述べています。「インテル TDX で保護される Google Cloud の新しい機密 AI サービスは、インテル AMX 命令で強化された CPU ベースの AI を使用している場合でも、外部の GPU で加速された AI を使用している場合でも、AI の実務担当者にデータとモデルを保護し、コンプライアンス態勢を強化する能力を提供します。」

マシンシリーズの CPU によって、Confidential VMs でどの種類のセキュリティ機能が使用できるかが決定します。たとえば、汎用の C3 マシンシリーズは第 4 世代の Intel Xeon スケーラブル プロセッサ(コード名: Sapphire Rapids)上で実行されます。このプロセッサでは、Intel Trust Domain Extensions(インテル TDX)と呼ばれる Confidential Computing 技術を利用できます。

インテル TDX はハードウェア ベースの高信頼実行環境を作成し、各ゲスト VM を暗号的に分離された「信頼ドメイン」に分けてデプロイすることで、機密データやアプリケーションを不正アクセスから保護します。インテル TDX を搭載した C3 マシンシリーズで Confidential VMs のプレビュー版が 3 月よりご利用いただけるようになっています。

また、C3 には Intel Advanced Matrix Extensions(インテル AMX)と呼ばれるもう一つの重要な CPU 機能があります。これは新しい命令セット アーキテクチャ(ISA)拡張機能で、AI / ML ワークロードのアクセラレーション用に設計されています。行列の乗算と畳み込み演算という AI や ML で最もよく使用される 2 つの演算に使用できる新しい命令が導入されています。インテル AMX を使用した C3 インスタンスでは、前の世代のインスタンスと比較してより高い AI 推論性能が得られます。

AI / ML ワークロードに高レベルのセキュリティを与えるために、C3 マシンシリーズの Confidential VMs はすべてデフォルトでインテル AMX の命令セットをサポートしています。このため、使用される AI / ML ワークロードは機密性を保って実行され、特権を持った管理者やクラウド運用者でさえも不正アクセスできないよう保護されます。インテル AMX は組み込みのアクセラレータで、CPU ベースのトレーニングや推論の性能が改善され、自然言語処理、レコメンデーション システム、画像認識などのワークロードにおいて高い費用対効果が得られます。Confidential VMs でインテル AMX を使用すると、AI / ML のデータやコードが権限のないユーザーに開示されるリスクを低減できます。

Thales は、防衛とセキュリティ、航空宇宙、サイバーセキュリティとデジタル アイデンティティの 3 つの事業分野で事業を展開する先進テクノロジーのグローバル リーダーであり、Confidential Computing を活用して同社の機密ワークロードのセキュリティを向上させています。

「データやワークロードをクラウドに移行する企業の増加に伴い、特に機密性の高いワークロード、知的財産、AI モデル、価値の高い情報に関するデータのプライバシーと完全性を確保する手段への需要が高まっています。こうした連携のおかげで、企業は保存データをはじめ、転送中や使用中のデータを、完全に検証可能な証明書に基づいて保護し、管理できるようになりました。Google Cloud およびインテルとの緊密な連携によって、当社のお客様のクラウド移行に対する信頼感が高まっています」と、Thales のデータ セキュリティ プロダクト担当バイス プレジデントの Todd Moore 氏は語っています。

今すぐお試しください

C3 マシンシリーズのインテル TDX を搭載した Confidential VMs ではデフォルトでインテル AMX が有効です。C3 マシンシリーズで Confidential VM を作成して AI / ML ワークロードを実行するだけで、インテル AMX をお試しいただけます。一般公開ドキュメントは、こちらでご覧いただけます。

高性能な NVIDIA H100 GPU を活用した A3 マシンシリーズの Confidential VMs の最新動向を入手するには、こちらのお問い合わせフォームでご登録ください。

ー Confidential Computing 担当プロダクト マネージャー Joanna Young

ー Confidential Computing & Confidential AI 担当グループ プロダクト マネージャー Sam Lugani