Apigee で生成 AI アプリを運用化する

Michael Vakoc

Product Manager, Google Cloud

Ruben Gonzalez

Customer Engineer

※この投稿は米国時間 2025 年 2 月 14 日に、Google Cloud blog に投稿されたものの抄訳です。

生成 AI は、今やブームを越えて実運用の段階に達しています。企業は大規模言語モデル(LLM)を基盤とするエンタープライズ向け生成 AI ソリューションの構築に意欲的ですが、デプロイの管理、保護、スケーリングの面で課題を抱えており、特に API に関してはその傾向が顕著です。プラットフォーム チームの一員としてすでに統合型の生成 AI プラットフォームの構築に携わっている方も多い中で、次のような質問がよく聞かれます。

-

組織として、セキュリティと安全性をどのように確保すればよいでしょうか?他の API と同様に、LLM API も攻撃ベクトルとなります。気をつけるべき LLM 特有の考慮事項は、どのようなものですか?

-

LLM を活用する機会が増えるなかで、予算超過を防ぐのと同時に、各チームが継続的にイノベーションを起こしビジネスの生産性を高めるために必要な LLM キャパシティを確保するにはどうすればよいですか?

-

使用パターンの把握や、トラブルシューティングの支援、コンプライアンス データの収集のために、適切なオブザーバビリティ機能をどのように設ければよいでしょうか?

-

生成 AI アプリケーションのエンドユーザーにできるだけ優れたエクスペリエンスを提供するには、どうすればよいですか?(たとえば、最小限のダウンタイムで最適なモデルから回答を行うには?)

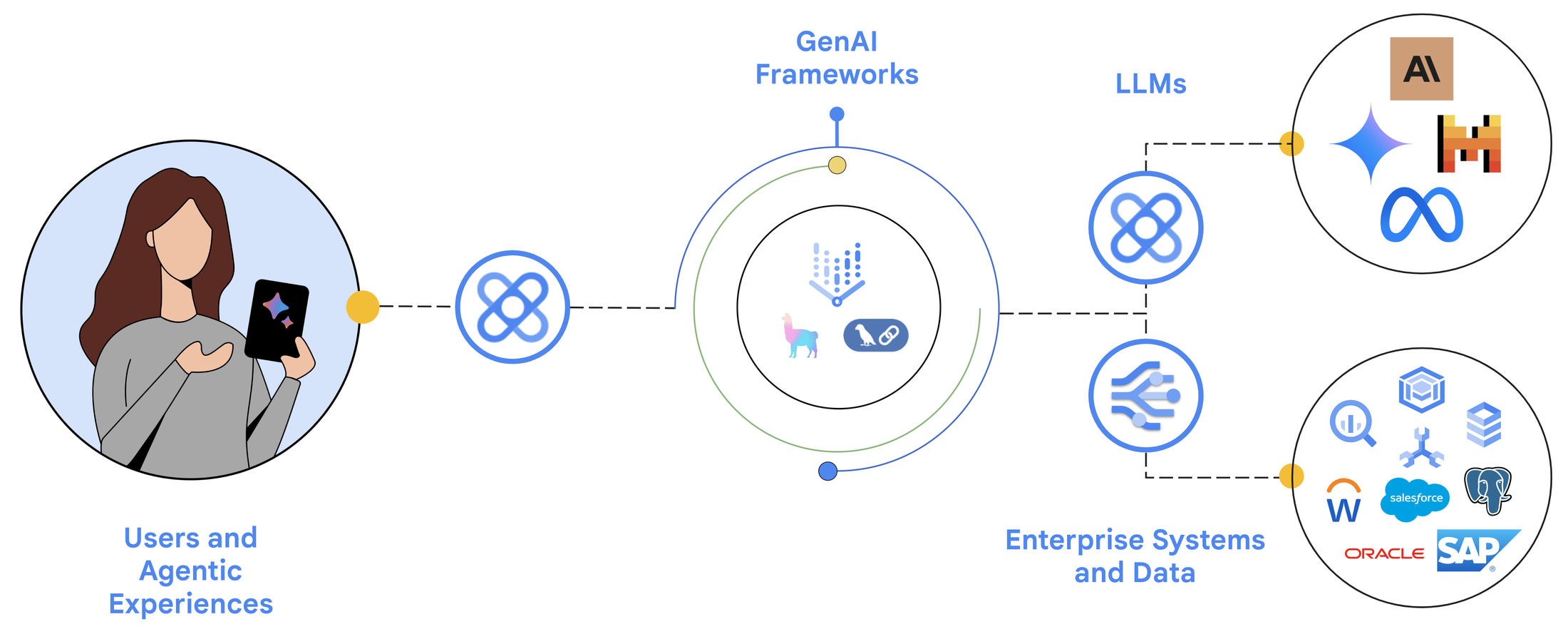

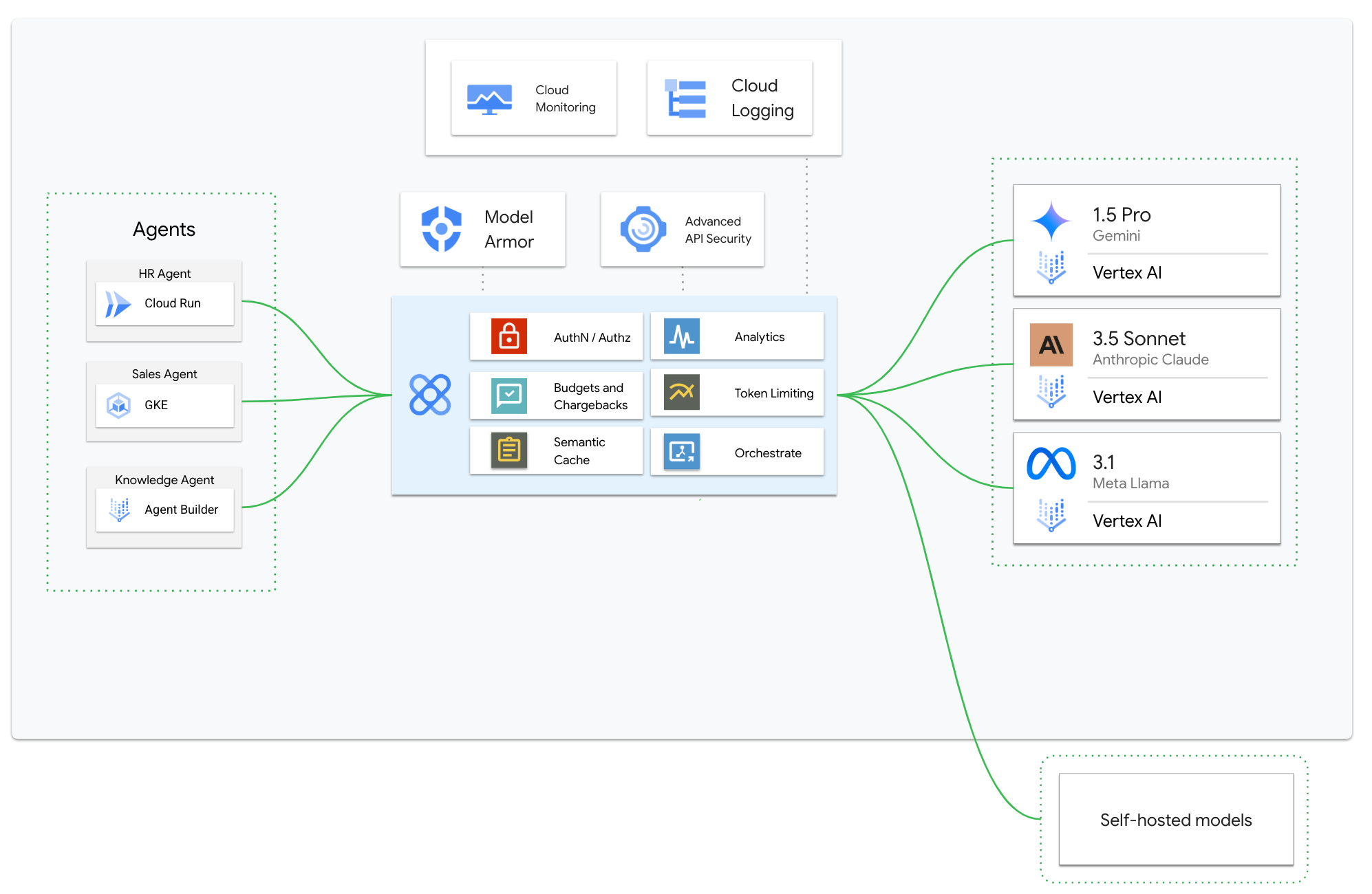

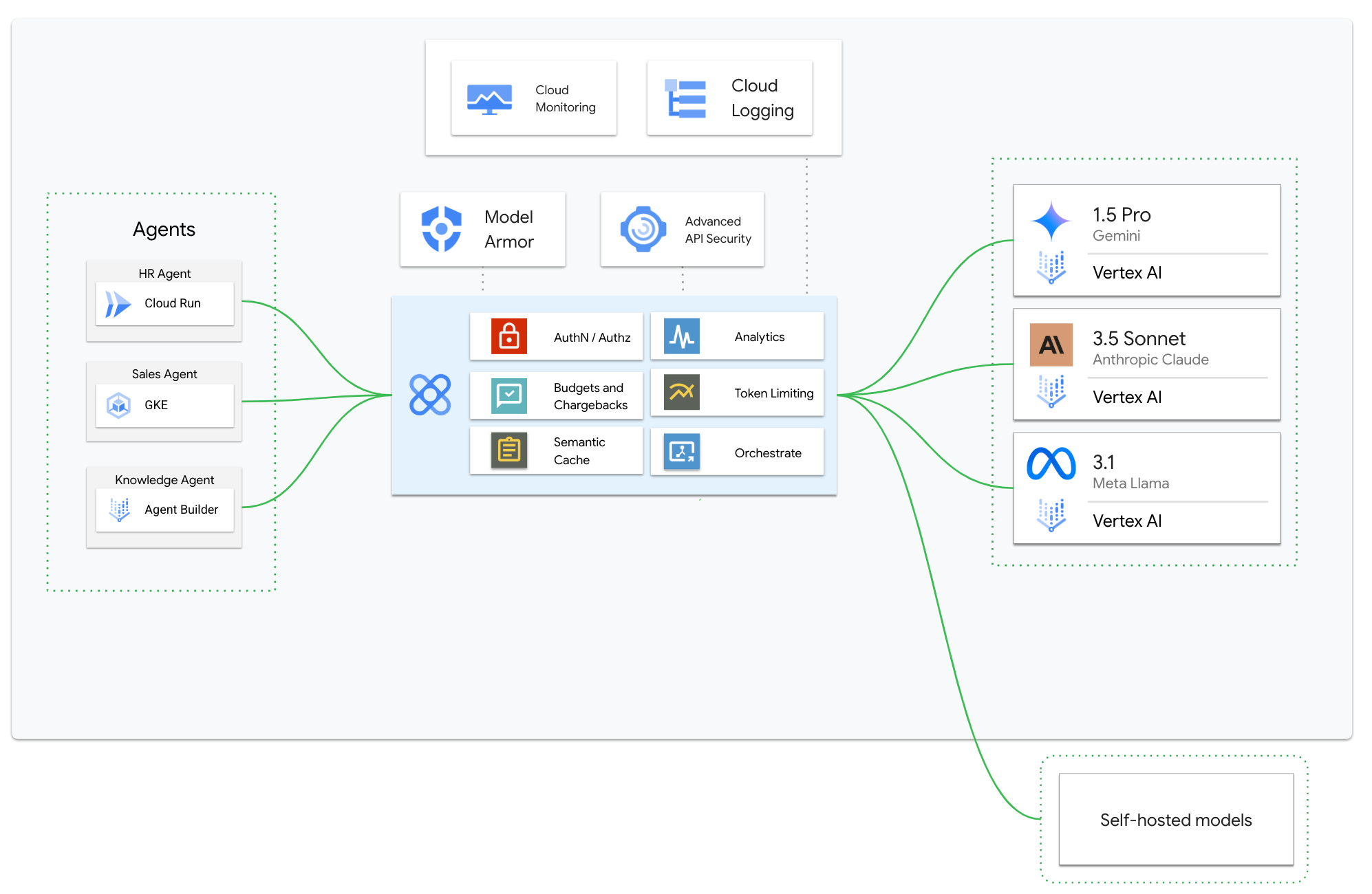

Apigee は Google Cloud の API 管理プラットフォームであり、これまで 10 年以上にわたってこのような API の課題を解決できるようお客様を支援してきました。Apigee API Management を活用した AI によるデジタル バリュー チェーンを図で表すと、次のようになります。

図 1: AI によるデジタル バリュー チェーン

AI エージェントと LLM を活用した生成 AI は、顧客の企業との関わり方を変え、あらゆる企業に大きな機会をもたらしています。Apigee を利用すると、認証やトラフィック制御、分析、ポリシーの適用といった機能を通じて、セキュリティ、スケーラビリティ、ガバナンスを強化でき、生成 AI エージェントをアプリケーションに統合するプロセスが合理化されます。また、LLM との連携を管理し、セキュリティと効率を向上させることができます。さらに、Google Cloud の Integration Platform as a Service ソリューションである Application Integration には、生成 AI エージェントからデータベースや外部システムへの接続を容易にする事前構築済みコネクタが用意されており、ユーザー リクエストへの応答に役立てられています。

このブログでは、LLM API 特有の課題に対処するための Apigee の活用方法を詳しく説明します。また、網羅的なリファレンス ソリューションも公開していますので、ご自身で Apigee を利用して課題に対処する際にお役立てください。同じトピックに関して、プロダクトのデモを含むウェブセミナーをご覧になることもできます。

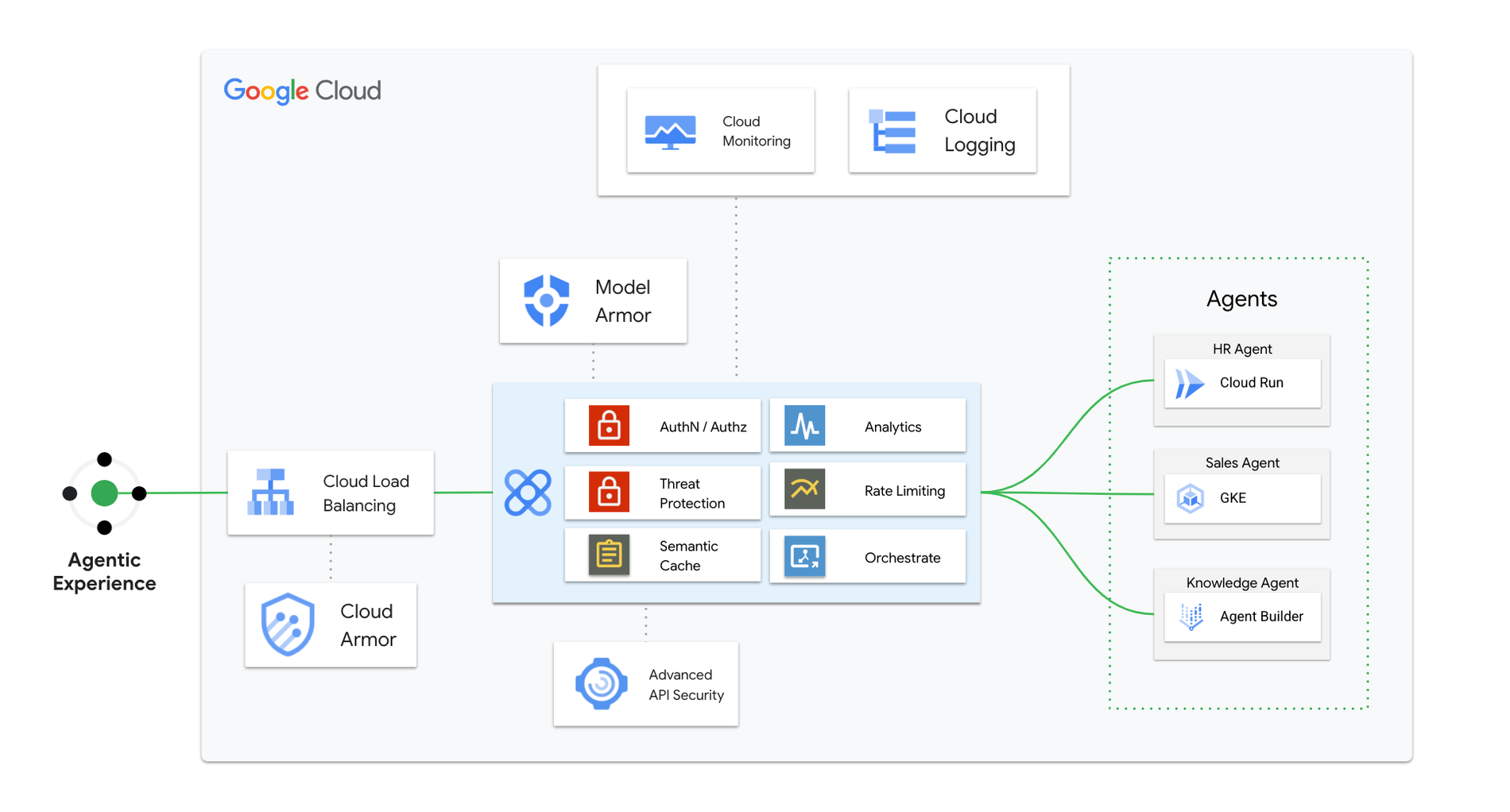

エージェントに取り次ぐプロキシとしての Apigee

AI エージェントは、LLM の機能を活用してエンドユーザーのためにタスクを遂行します。エージェントの構築には、ノーコードまたはローコードのプラットフォームから、LangChain や LlamaIndex などのフルコードのフレームワークまで、さまざまなツールを使用できます。Apigee は AI アプリケーションとエージェントの間で仲介役として機能します。Apigee を使用すると、OWASP トップ 10 API セキュリティ リスクから LLM API を守ることができるため、セキュリティが強化されます。ユーザーの認証と認可の管理や、セマンティック キャッシングなどの機能によるパフォーマンスの最適化も可能です。トークンの制限を適用して費用を抑えられるほか、高度なユースケースでは複数の AI エージェント間で複雑なインタラクションをオーケストレートすることもできます。

LLM アプリケーションとモデルをつなぐゲートウェイとしての Apigee

AI エージェントでは目下のタスクに応じて、さまざまな LLM を活用する必要が生じることがあります。Apigee はこれを簡素化するために、最適な LLM へのリクエストのルーティングやフェイルオーバーを、柔軟な構成とテンプレートを活用してインテリジェントに行います。また、LLM の堅牢なアクセス制御を行いながら、新しい AI アプリケーションおよびエージェントの導入を効率化します。エージェントは多くの場合、ユーザーのニーズに十分に応えるために、LLM 以外にデータベースや外部のシステムとも接続する必要があります。Apigee の堅牢な API 管理プラットフォームを使用すると、マネージド API を介してこうしたインタラクションを行えるようになります。カスタムのビジネス ロジックが必要となる複雑なインタラクションの場合は、Google Cloud の Application Integration プラットフォームを活用できます。

こうしたパターンが万能でないことは覚えておかなければなりません。具体的なユースケースにより、エージェントと LLM のインタラクションのアーキテクチャ パターンは変わります。たとえば、必ずしも複数の LLM にリクエストをルーティングする必要はないかもしれません。場合によっては、Apigee エージェントのプロキシレイヤから、データベースや外部のシステムに直接接続することもできます。重要なのは柔軟性です。Apigee では、ニーズに合わせてアーキテクチャを適応させることができます。

それでは、Apigee が役立つ具体的な分野を一つずつ見ていきましょう。

AI の安全性Apigee で管理される API では、Google Cloud のモデル安全性サービスである Model Armor を呼び出すことができます。これにより、あらゆるプロンプトと回答を調査して潜在的なプロンプト攻撃を防ぎ、設定したガードレール内で LLM が回答できるようにします。たとえば、LLM アプリケーションで金融や政治のトピックに関する回答を行わないように指定できます。

レイテンシと費用モデルの回答のレイテンシは、依然として、LLM を活用したアプリケーションを構築するときの大きな要因です。推論プロセスで行う論理的推論の数が多くなると、このレイテンシの問題は悪化します。Apigee ではセマンティック キャッシュを実装することで、モデルを問わず、意味的に類似した質問に対する回答をキャッシュに保存できます。これにより、エンドユーザーの待ち時間が大幅に短縮されます。

このソリューションでは、Vertex AI Vector Search と Vertex AI Embeddings API によってプロンプトを処理し、類似プロンプトの特定に利用します。そして、この類似プロンプトへの回答が Apigee のキャッシュから取得されます。ご利用にあたっては、Apigee のセマンティック キャッシュに関するリファレンス ソリューションを参照してください。

パフォーマンスモデルが異なれば、得意分野も異なります。たとえば、Gemini Pro モデルは非常に質の高い回答を提供しますが、Gemini Flash モデルはスピードと効率性に優れています。ユースケースやアプリケーションに応じて、ユーザーのプロンプトをそのジョブに最適なモデルにルーティングできます。

どのモデルを使用するかは API 呼び出しで指定でき、Apigee は一貫した API コントラクトを維持しながら希望するモデルへのルーティングを行います。ご利用にあたっては、こちらのリファレンス ソリューションを参照してください。

配分と使用量上限Apigee を使用すると、組織内のすべてのモデルにセルフサービスでアクセスできる統合ポータルを作成できます。また、個々のアプリや開発者ごとに使用量上限を設定することで、それぞれが必要とするだけの容量を確保しながら、全体的な費用を抑えることもできます。LLM トークン数に基づいて Apigee の使用量上限を設定する方法については、こちらをご覧ください。

可用性LLM 推論には大量の計算が必要になるため、モデル プロバイダは通常、一定の時間枠内で使用できるトークンの数を制限しています。モデルでその上限に達すると、アプリケーションからのリクエストがスロットリングされるため、エンドユーザーがそのモデルを利用できなくなる可能性があります。そうならないようにするには、Apigee にサーキット ブレーカーを実装して、利用可能な容量のあるモデルにリクエストが再ルーティングされるようにします。ご利用にあたっては、こちらのリファレンス ソリューションを参照してください。

レポートプラットフォーム チームは、サポートするさまざまなモデルの使用状況や、各アプリのトークン消費量を把握する必要があります。こういったデータは、社内の費用レポートや最適化にも利用可能です。いずれの場合も Apigee では、ダッシュボードを構築し、「LLM API の通貨」とも言えるトークンの実際の利用数に基づいて使用状況を可視化できます。この方法なら、アプリケーションをまたいだ実際の使用量も確認できます。ご利用にあたっては、こちらのリファレンス ソリューションを参照してください。

監査とトラブルシューティングコンプライアンスやトラブルシューティングの要件を満たすために、LLM とのすべてのインタラクション(プロンプト、回答、RAG データ)をロギングする必要が生じる場合があります。あるいは、LLM アプリケーションを継続的に改善するために、回答の質を分析したい場合もあります。Apigee を使用すれば、Cloud Logging で LLM とのインタラクションを安全にロギングし、匿名化して、使い慣れたインターフェースからそれを調査することができます。まずはこちらをご覧ください。

セキュリティAPI が攻撃対象領域として捉えられることが増えるなか、セキュリティは API プログラムの最重要事項となっています。Apigee は、API キー、OAuth 2.0、JWT 検証でアクセスを制御できる、LLM API の安全なゲートウェイとしても機能します。そのため、モデルとやり取りするユーザーとアプリケーションの認証に、エンタープライズ レベルのセキュリティ標準を適用できます。Apigee では、レート制限と割り当てを適用することで悪用や過負荷を防止し、悪意のある攻撃や予期せぬトラフィックの急増から LLM を保護することもできます。

このようなセキュリティ管理に加え、Apigee は、利用可能なモデル プロバイダとモデルの管理にも利用できます。その場合、モデルにアクセスできるユーザーまたはアプリケーションを定義するポリシーを作成します。たとえば、特に強力な LLM へのアクセスを特定のユーザーに限って許可するポリシーや、一部のタスクにおいて LLM へのアクセスを特定のアプリケーションに限って許可するポリシーを作成することができます。こうして、意図した目的にのみ LLM が使用されるよう、その使用方法をきめ細かく制御できます。

それだけでなく、Apigee には Advanced API Security によるさらに高度な保護機能も用意されています。これは、LLM API を OWASP トップ 10 API セキュリティ脆弱性から防御するのに有効です。

Apigee を LLM アーキテクチャと統合すると、安全で信頼性の高い環境が構築され、AI アプリケーションの機能を存分に活かすことができます。

生成 AI の可能性を最大限に引き出すには

AI の運用化のために Apigee の包括的な機能について確認し、安全かつスケーラブルで効率的な生成 AI ソリューションの構築に取りかかりましょう。詳細と利用開始にご関心をお持ちの方は、Apigee の生成 AI サンプルのページや、より詳しい情報を提供しているウェブセミナーをご覧ください。このページからのお問い合わせもお待ちしています。

-プロダクト マネージャー Michael Vakoc

-カスタマー エンジニア Ruben Gonzalez