Edge-Computing: Ein Paradigmenwechsel jenseits der Hybrid-Cloud

Joshua Landman

Customer Engineer, Application Modernization Specialist, Google

Praveen Rajagopalan

Customer Engineer, Application Modernization Specialist, Google

GCP testen

Profitieren Sie von einem 300 $-Guthaben, um Google Cloud und mehr als 20 zu jeder Zeit kostenlose Produkte kennenzulernen.

JETZT TESTENUnternehmen haben eine bemerkenswerte Konsolidierung und Zentralisierung ihrer Rechenkapazitäten erlebt – ob in der Cloud oder in den eigenen Rechenzentren. Doch mit dem Einzug immer leistungsfähigerer Mobilgeräte und Mobilfunknetze muss beim Planen von Anwendungen immer öfter über den Tellerrand des Rechenzentrums hinaus auf die Edge geschaut werden.

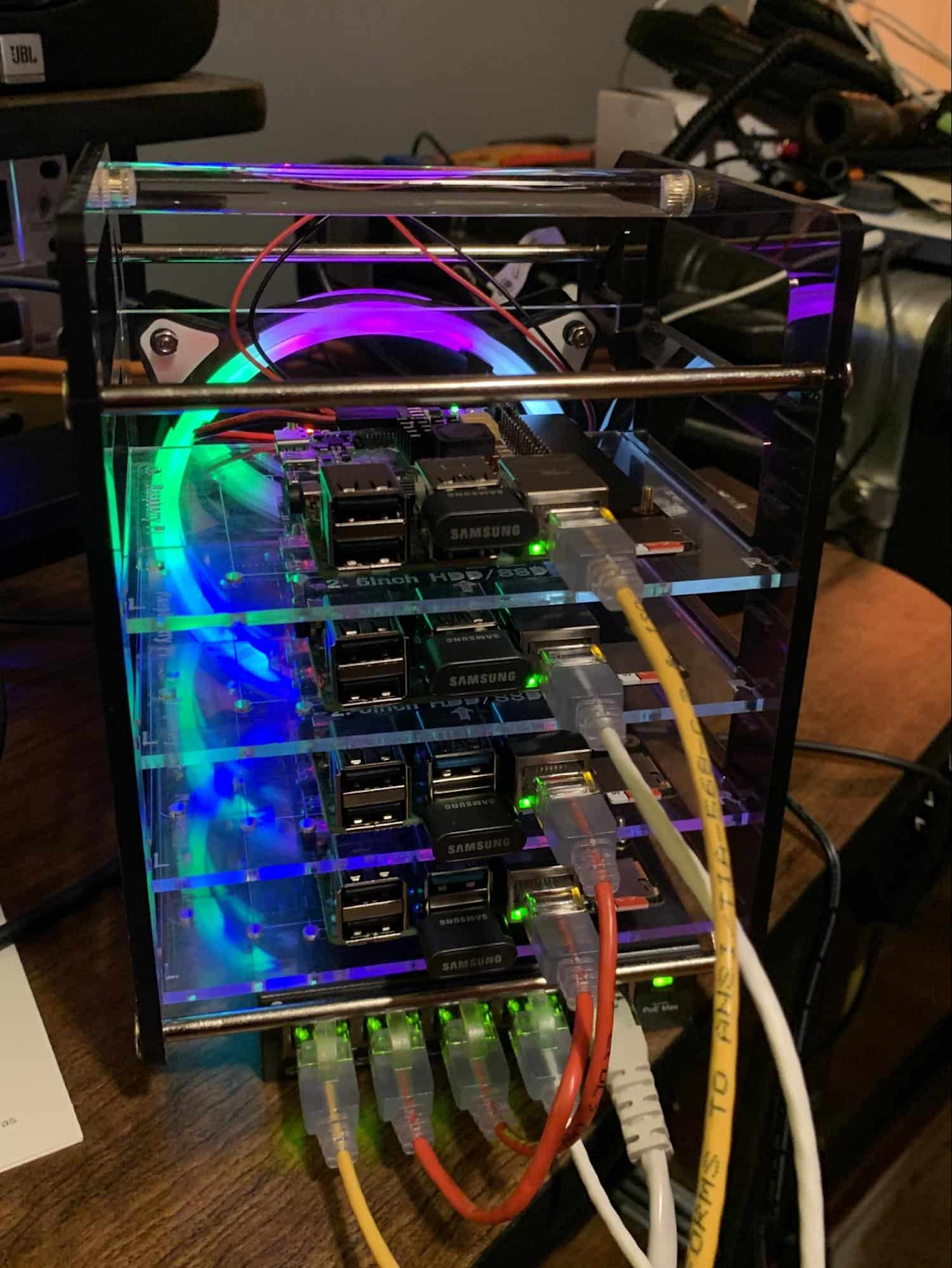

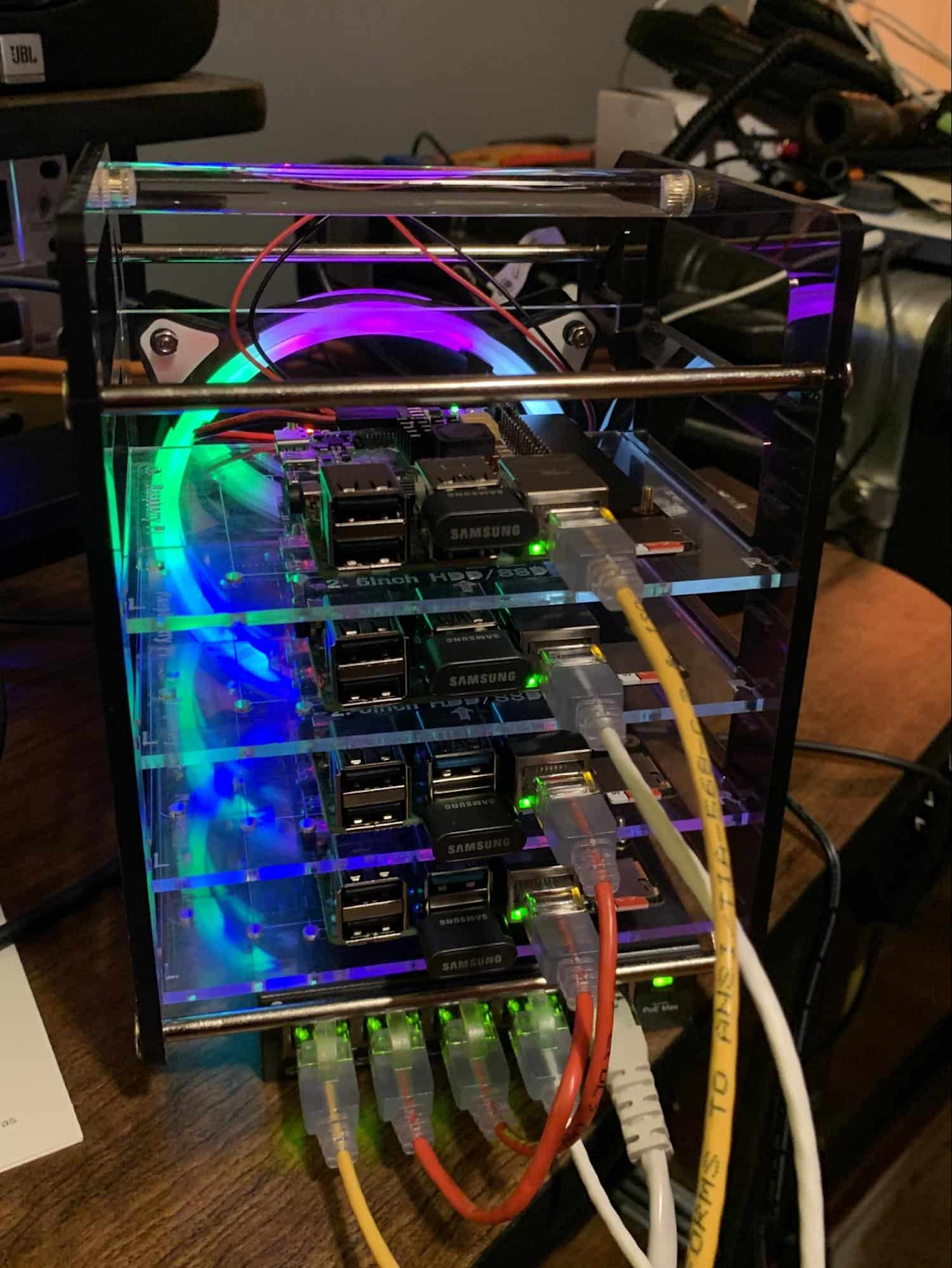

Doch was genau ist eigentlich Edge-Computing? Der Begriff bezeichnet die dezentrale Datenverarbeitung am Rand (engl. Edge) des Netzwerks auf einer Reihe von neuartigen Geräten. Dazu gehören – natürlich – Mobiltelefone, aber beispielsweise auch Sensoren in Fabriken, Industrieanlagen oder sogar die Temperatur- und Reaktionsüberwachung in Remote-Laboren. Edge-Geräte sind zudem vernetzt, d. h. sie können über drahtlose oder mobile Netzwerke mit dem Hauptstandort kommunizieren.

Ausgestattet mit immer leistungsfähigeren Prozessoren übernehmen diese Edge-Geräte zunehmend Aufgaben, die bislang von traditioneller IT nicht geleistet werden konnten. Für Unternehmen kann dies vieles bedeuten: Sie können eingehende Telemetriedaten im Fahrzeug vorverarbeiten, in den Geschäften eines Einkaufszentrums Videos aufzeichnen, Qualitätskontrolldaten mit Kameras in einem Lager erfassen oder als interaktive Medien im Einzelhandel dienen. Unternehmen greifen zudem auf Edge-Computing zurück, um Daten von Außenstellen oder Geräten mit unregelmäßigen Verbindungen zu erfassen, etwa von Ölplattformen oder landwirtschaftlichen Geräten. Diese Daten können sie filtern, um die Qualität zu verbessern, auf die benötigte Informationsmenge reduzieren und diese anschließend in der Cloud verarbeiten. Neue Daten und Modelle werden dann zurück an die Edge gesendet. Zusätzlich können wir auch Konfigurations-, Software- und Medien-Updates übertragen und die Verarbeitungslast dezentralisieren.

Beim Edge-Computing geht es jedoch nicht nur um neue Anwendungsfälle, sondern auch um die richtige Dimensionierung der Umgebungen und die Verbesserung der Ressourcenauslastung. So kann beispielsweise die Einführung eines Edge-Modells die bestehenden Rechenzentren entlasten.

Aber auch wenn Edge-Computing für Unternehmen sehr vielversprechend ist, gibt es dabei viele Aspekte, die noch nicht ausgereift sind. Darüber hinaus unterscheidet sich die Entwicklung von Edge-Workloads stark von der Entwicklung herkömmlicher Anwendungen, die über eine stabile Datenverbindung verfügen und auf gut ausgestatteten Hardwareplattformen ausgeführt werden. Cloud-Architekt*innen stehen also mit ihren Überlegungen, wie sie die Edge für ihre Unternehmen am besten nutzen und implementieren können noch ganz am Anfang.

Zum Glück gibt es Tools, die Ihnen den Wechsel auf Edge-Computing erleichtern und sogar mit großer Wahrscheinlichkeit in die bestehenden Computersysteme Ihres Unternehmens eingebunden werden können. Eines davon ist Kubernetes; aber auch Management-Tools wie Anthos können hierbei helfen. Letzteres bietet eine übergreifende Steuerebene für die Cloud, private Rechenzentren und Edge-Standorte. Andere Produkte der Anthos-Familie – Anthos Config Management und Anthos Service Mesh – gehen sogar noch einen Schritt weiter und unterstützen ein einheitliches, zentrales Management all Ihrer Edge- und Cloud-Bereitstellungen. Und das ist erst der Anfang.

In den folgenden Absätzen werden wir tiefer in die Vergangenheit und Gegenwart des Edge-Computing eintauchen. Welche Vorteile erwarten Architekt*innen und Entwickler*innen durch Edge-Computing? In einem Folgebeitrag werfen wir einen genaueren Blick auf die Herausforderungen, die die Entwicklung von Edge-Lösungen mit sich bringt, und stellen diesen die Vorteile gegenüber, die die Einführung des Edge-Modells für ein Unternehmen hat. Abschließend schauen wir uns die Tools von Google Cloud an, die Ihnen zum Aufbau Ihrer Edge-Umgebung zur Verfügung stehen und gehen auf Kundenbeispiele ein, die zeigen, was heute damit bereits möglich ist.

Die Entwicklung des Edge-Computing

Die Edge ist eigentlich kein neues Konzept – es gibt sie bereits seit zwei Jahrzehnten mit zahlreichen Anwendungsfällen, die bis heute weit verbreitet sind. Einer der ersten Anwendungsfälle war die Nutzung von Content Delivery Networks (CDN), um statische Webseiten in der Nähe der Clients zwischenzuspeichern und täglich bereitzustellen. Ein Beispiel hierfür sind Webserver in kalifornischen Rechenzentren, die Finanzdaten an europäische Kunden liefern.

Mit verbesserter Konnektivität und modernerer Software entwickelte sich auch die Edge weiter. Heute liegt der Schwerpunkt darauf, die Edge zur dezentralen Bereitstellung von Diensten zu nutzen. Zunächst wurden einfache Dienste basierend auf statischem HTML-Code auf Javascript-Bibliotheken oder Bildarchive erweitert. Es folgten gängige Funktionen wie Bildumwandlung sowie unterstützende Services zur Kredit- und Adressprüfung. Schon bald implementierten Unternehmen komplexere Cloudlet- und geclusterte Microservices-Installationen sowie verteilte und replizierte Datensätze. Der Begriff „Endpoint“ bzw. „Endgerät“ war plötzlich in aller Munde und APIs sprossen überall aus dem Boden.

Parallel dazu gab es eine regelrechte Kreativitäts-Explosion bei Hardware, Mikrocontrollern und speziellen Edge-Geräten. Weltweit wurden auf Edge-Gebrauch spezialisierte Produkte eingeführt. Mit Diensten wie Google Cloud IoT Core ließen sich die verteilten Services besser verwalten und sicher vernetzen, wodurch das Plattform-Management neue Tools registrieren und verwaltete Dienste wie Pub/Sub und Dataflow für die Datenaufnahme nutzen konnte. Und mit Kubernetes arbeiten große Remote-Cluster – die selbst eine Art Mini-Private-Cloud darstellen – als selbstregulierende, automatisch skalierbare Dienste im gesamten Internet, was den Weg für neue Anwendungsmodelle und Architekturmuster ebnet. Kurz gesagt: Verteilte asynchrone Systeme und die Wirtschaft sind aufgeblüht.

Was bedeutet das für Unternehmen? In dieser Blogserie sprechen wir von Edge-Computing als Möglichkeit, über den Netzwerkrand Ihres Unternehmensnetzwerks, über Cloud-VPCs und über die Hybrid-Cloud hinaus zu gehen. Die moderne Edge muss weder ein großes, dezentrales Rechenzentrum noch ein CDN, ein Cloud-Anbieter oder ein Rack im unternehmenseigenen Rechenzentrum sein – sie kann vielmehr aus Hunderten dieser Geräte bestehen, die mit Tausenden von Sensoren verbunden sind.

Kurz gesagt, heißt Edge, dass Hardware und Geräte an dezentralen Standorten installiert werden, die die von ihnen gesammelten und generierten Informationen verarbeiten und zurückmelden können. Die Herausforderung beim Edge-Management besteht darin, Konfigurationen und Software-/Modell-/Medienaktualisierungen an diese dezentralen Standorte zu übertragen, wenn eine Verbindung besteht.

Neue Anwendungsfälle

Wir erleben heute eine neue Dimension des Edge-Computing – eine, bei der Mikro-Rechenzentren sozusagen am Rande eines kleinen Auslegers eingesetzt werden. Zusammen bilden sie ein umfassendes, geografisch verteiltes, jederzeit verfügbares Framework für Streaming, Erfassung, Verarbeitung und Bereitstellung asynchroner Daten. Dieses große, lose verbundene Anwendungssystem lebt, atmet und wächst. Es verändert sich permanent, lernt aus den gesammelten Daten – und gibt immer dann aktualisierte Modelle weiter, wenn die einzelnen Netz-Ableger miteinander verbunden sind.

Und mit dem Vormarsch von 5G werden die Grenzen der Edge noch weiter ausgedehnt. 5G-fähige Geräte können Daten ohne ISP über ein Mobilfunknetz übertragen. Damit ist Konnektivität überall gegeben, wo ein Mobilfunkmast in Reichweite ist. Diese Netze haben zwar eine geringere Bandbreite, aber für bestimmte Arten von Daten sind sie oft mehr als ausreichend. Zum Beispiel können sie für Brandmelder in Wäldern am Rande abgelegener Städte genutzt werden, die in regelmäßigen Abständen Temperatur- oder Kohlenmonoxid-Daten übermitteln. Vor kurzem ging Google Cloud eine Partnerschaft mit AT&T ein, um die kommerzielle Nutzung der 5G-Edge-Technologie zu fördern. Die Möglichkeiten sind jedoch noch lange nicht ausgeschöpft.

Geringere Investitionen in Rechenzentren

Edge-Technologie ermöglicht nicht nur die Digitalisierung einer breiten Palette neuer Anwendungsfälle, sondern kommt auch Ihrem bestehenden Rechenzentrum zugute.

Machen wir uns nichts vor: Rechenzentren zu betreiben ist eine kostspielige Angelegenheit. Die teilweise Verlagerung der Last in Rechenzentren an Edge-Standorte kann Ihre Investitionen in die Infrastruktur der Rechenzentren sowie die dort anfallende Rechenzeit reduzieren. Edge-Services haben in der Regel deutlich niedrigere Service Level Objectives (SLOs) als die Dienste der Rechenzentren, was geringere Hardwareinvestitionen mit sich bringt. Zudem tolerieren die meisten Edge-Installationen Verbindungsabbrüche und funktionieren daher auch mit niedrigeren SLOs – und zu niedrigeren Kosten – einwandfrei.

Schauen wir uns ein Beispiel dafür an, wo Edge-Computing die Kosten spürbar senken kann: Big Data. Früher haben wir monolithische serielle Prozessoren – sogenannte State Machines – gebaut, die zum Schutz vor Systemausfällen stets den aktuellen Stand der Verarbeitung aufzeichnen mussten. Es hat sich jedoch immer wieder herausgestellt, dass eine verteilte Verarbeitung kleinerer Datenmengen große, teure Probleme vermeiden bzw. in kleinere, kostengünstigere Häppchen aufteilen kann.

Seit dem Durchbruch von MapReduce vor fast 20 Jahren wurden Big Data-Workloads parallel über mehrere Cluster in einem Netzwerk verteilt. Damit bot sich die Möglichkeit, Verarbeitungszustände weiterzugeben, abzuwarten oder die Berechnung von diesen Punkten aus neu zu starten und so resilienter gegen Ausfälle zu werden. Die monolithischen Systeme wurden durch kostengünstigere, intelligentere, vernetzte Cluster und Data Repositories (Datenlager) ersetzt, in denen parallele Workloads ausgeführt und in verwertbare Datensätze umgewandelt werden konnten.

Ein kurzer Sprung in die heutige Zeit zeigt, dass dieselben Konzepte auch auf Edge-Datenerfassungspunkte anwendbar und übertragbar sind. Im Zuge der voranschreitenden Big Data-Verarbeitung wächst die Menge unserer Beobachtungsdaten bis sie so umfangreich ist, dass wir sie lokal vorfiltern und auf eine überschaubare Größe reduzieren müssen, damit sie verwertbar ist. Erst dann sollten sie für eine ressourcenintensivere Verarbeitung und Modellbildung in die zentralen Data Repositories (Datenlager) zurückgeschrieben werden.

Kurz gesagt: Datenerfassung und -bereinigung sowie ggf. auch die anfängliche Aggregation erfolgen bereits am Edge-Standort, wodurch die Menge an unnötigen Daten in kostspieligen Datenspeichern reduziert wird. Dies erhöht die Leistung des zentralen Data Warehouse und reduziert den Umfang und die Kosten für Netzwerkübertragung und Speicherung.

Edge-Computing ist eine große Chance für die Unternehmen von heute. Die Gestaltung von Umgebungen, in denen die Vorteile der Edge-Technologie effektiv nutzbar sind, ist jedoch nicht unproblematisch. In Teil 2 der Blogserie sehen wir uns die architektonischen Herausforderungen an, die sich bei der Entwicklung von Edge-Lösungen stellen.