이 페이지는 Apigee 및 Apigee Hybrid에 적용됩니다.

Apigee Edge 문서 보기

![]()

Apigee 애널리틱스는 API 전반의 다양한 데이터를 수집하고 분석하며, 대화형 대시보드, 커스텀 보고서, API 프록시 성능의 트렌드를 파악하는 기타 도구와 같은 시각화 도구를 제공합니다.

이제 Apigee 애널리틱스에서 Google Cloud Storage 또는 Google BigQuery와 같은 자체 데이터 저장소로 분석 데이터를 내보내서 이 풍부한 콘텐츠를 활용할 수 있습니다. 그런 다음 Google BigQuery 및 TensorFlow에서 제공하는 강력한 쿼리 및 머신러닝 기능을 활용하여 자체 데이터 분석을 수행할 수 있습니다. 또한 내보낸 분석 데이터를 웹 로그와 같은 다른 데이터와 결합하여 사용자, API, 애플리케이션에 대한 유용한 정보를 얻을 수 있습니다.

어떤 내보내기 데이터 형식이 지원되나요?

분석 데이터를 다음 형식 중 하나로 내보냅니다.

쉼표로 구분된 값(CSV)

기본 구분 기호는 쉼표 문자이며, 지원되는 구분 기호 문자는 쉼표(,), 파이프(|), 탭(\t)입니다. 내보내기 요청 속성 참조에 설명된 대로

csvDelimiter속성을 사용하여 값을 구성합니다.JSON(줄바꿈으로 구분)

줄바꿈 문자를 구분 기호로 사용하도록 합니다.

내보낸 데이터에는 Apigee에 내장된 모든 분석 측정항목과 측정기준 및 추가하는 커스텀 분석 데이터가 포함됩니다. 내보낸 데이터에 대한 설명은 분석 측정항목, 측정기준, 필터 참조를 확인하세요.

분석 데이터를 다음 데이터 저장소로 내보낼 수 있습니다.

분석 데이터를 내보내는 단계

다음은 분석 데이터를 내보내는 데 사용되는 프로세스를 요약한 단계입니다.

- 데이터 내보내기를 위해 데이터 저장소를 구성합니다(Cloud Storage 또는 BigQuery). 데이터 저장소가 올바르게 구성되었는지, 그리고 데이터 저장소에 데이터를 쓰는 데 사용된 Apigee 서비스 에이전트 서비스 계정에 올바른 권한이 있는지 확인해야 합니다.

- 데이터를 내보낼 데이터 저장소(Cloud Storage 또는 BigQuery)의 속성을 정의하는 Datastore를 생성합니다.

- 분석 데이터를 내보냅니다. 데이터 내보내기는 백그라운드에서 비동기식으로 실행됩니다.

- 내보내기 요청 상태를 확인하여 내보내기 완료 시점을 확인합니다.

- 내보내기가 완료되면 데이터 저장소에서 내보낸 데이터에 액세스합니다.

다음 섹션에서는 이러한 단계를 자세히 설명합니다.

데이터 저장소 구성

분석 데이터 내보내기로 액세스할 수 있도록 Cloud Storage 또는 BigQuery를 구성합니다.

Google Cloud Storage 구성

Google Cloud Storage로 데이터를 내보내려면 먼저 다음을 수행해야 합니다.

Google Cloud Storage 버킷을 만듭니다.

Google Cloud Platform 프로젝트에서 BigQuery API가 사용 설정되어 있는지 확인합니다. Apigee는 Cloud Storage로 내보낼 때 BigQuery API를 통해 BigQuery 내보내기 기능을 활용합니다.

자세한 내용은 API 사용 설정을 참조하세요.

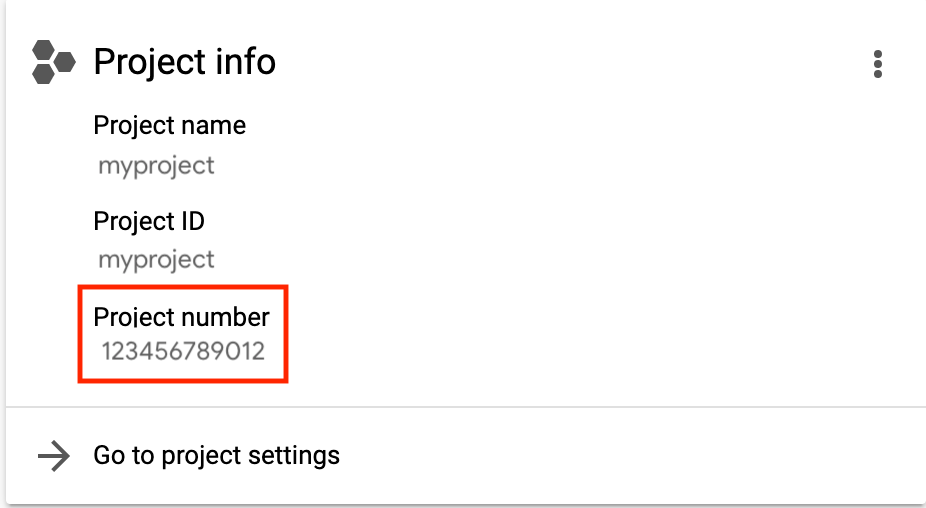

이메일 주소가

service-project-number@gcp-sa-apigee.iam.gserviceaccount.com인 Apigee 서비스 에이전트 서비스 계정에 다음 역할이 할당되어 있는지 확인합니다.- BigQuery 작업 사용자

- 스토리지 관리자

project-number는 아래 표시된 것처럼 프로젝트 홈페이지에 나열됩니다.

리소스에 대한 액세스 권한 부여, 변경, 취소를 참조하세요.

또는 기존 역할을 수정하거나 커스텀 역할을 만들려면 다음 권한을 역할에 추가합니다.

bigquery.jobs.createstorage.objects.createstorage.objects.deletestorage.objects.list

Google BigQuery 구성

Google BigQuery로 데이터를 내보내려면 먼저 다음 안내를 따르세요.

- Google Cloud Platform 프로젝트에서 BigQuery를 사용 설정했는지 확인합니다.

- Google Cloud Platform 프로젝트에서 BigQuery API가 사용 설정되어 있는지 확인합니다. 자세한 내용은 API 사용 설정을 참조하세요.

이메일 주소가

service-project-number@gcp-sa-apigee.iam.gserviceaccount.com인 Apigee 서비스 에이전트 서비스 계정에 다음 역할이 할당되어 있는지 확인합니다.- BigQuery 작업 사용자

- BigQuery 데이터 편집자

project-number는 아래 표시된 것처럼 프로젝트 홈페이지에 나열됩니다.

리소스에 대한 액세스 권한 부여, 변경, 취소를 참조하세요.

기존 역할을 수정하거나 커스텀 역할을 만들려면 다음 권한을 역할에 추가합니다.

bigquery.datasets.createbigquery.datasets.getbigquery.jobs.createbigquery.tables.createbigquery.tables.getbigquery.tables.updateData

BigQuery 데이터세트를 만듭니다.

미국 또는 EU의 개별 리전에 대해 데이터를 BigQuery로 내보내기

미국 또는 EU의 분석 데이터는 미국 또는 EU 멀티 리전에 저장되므로 BigQuery의 개별 미국 또는 EU 리전으로 직접 데이터를 내보낼 수 없습니다. 이 문제를 해결하려면 다음과 같이 먼저 Google Cloud Storage로 데이터를 내보낸 후 BigQuery로 전송합니다.

- Cloud Storage 버킷을 만들고 위치를 BigQuery의 데이터와 연결할 미국 또는 EU의 개별 리전으로 설정합니다.

- 이전 단계에서 만든 스토리지 버킷을 사용하여 Cloud Storage Datastore를 만듭니다.

- Cloud Storage로 데이터를 내보냅니다. 아래의 예시 1: Cloud Storage로 데이터 내보내기를 참조하세요.

- 다음 섹션에 설명된 대로 BigQuery에 데이터를 로드합니다.

Datastore 관리

Datastore는 내보내기 데이터 저장소(Cloud Storage, BigQuery)에 대한 연결을 정의합니다.

다음 섹션에서는 Datastore를 만들고 관리하는 방법을 설명합니다. Datastore를 만들기 전에 데이터 저장소 구성을 테스트하는 것이 좋습니다.

데이터 저장소 구성 테스트

데이터 저장소를 만들 때 Apigee는 구성이 유효한지 테스트하거나 검증하지 않습니다. 즉, Datastore를 만들고(다음 단계) 첫 번째 데이터 내보내기를 실행하기 전에는 오류를 감지하지 않습니다.

데이터 내보내기 프로세스를 실행하는 데 시간이 오래 걸릴 수 있으므로 데이터 저장소 구성이 유효한지 테스트하고, Datastore를 만들기 전에 오류를 수정하여 더 빨리 오류를 감지할 수 있습니다.

데이터 저장소 구성을 테스트하려면 /organizations/{org}/analytics/datastores:test API에 POST 요청을 실행합니다. 요청 본문에 다음 정보를 전달합니다.

- 표시 이름

- Datastore 유형

- Datastore 요청 속성 참조에 설명된 Datastore 유형에 따른 구성 세부정보

예를 들어 다음은 Cloud Storage 데이터 저장소 구성을 테스트합니다.

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores:test" \

-X POST \

-H "Content-type:application/json" \

-H "Authorization: Bearer $TOKEN" \

-d \

'{

"displayName": "My Cloud Storage datastore",

"targetType": "gcs",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

}'

다음은 테스트가 성공한 경우의 응답 예시입니다.

{

"state": "completed",

}

다음은 테스트가 실패한 경우의 응답 예시입니다.

{

"state": "failed",

"error": "<error message>"

}

이 경우 오류 메시지에서 발생한 문제를 해결하고 데이터 저장소 구성을 다시 테스트합니다. 테스트가 성공한 후 다음 섹션에 설명된 대로 Datastore를 만듭니다.

Datastore 만들기

Datastore를 만들려면 /organizations/{org}/analytics/datastores API에 POST 요청을 실행하고, 요청 본문에 다음 정보를 전달합니다.

- 표시 이름

- Datastore 유형

- Datastore 요청 속성 참조에 설명된 Datastore 유형에 따른 구성 세부정보

각 Datastore 유형에 대한 예시는 아래에 나와 있습니다.

다음은 Cloud Storage 데이터 저장소의 응답 예시입니다.

{

"self": "/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b",

"displayName": "My Cloud Storage datastore",

"org": "myorg",

"targetType": "gcs",

"createTime": "1535411583949",

"lastUpdateTime": "1535411634291",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

}

Datastore 세부정보 보기에 설명된 대로 self 속성에서 반환된 URL을 사용하여 Datastore 세부정보를 확인합니다.

자세한 내용은 Data Store API 만들기를 참조하세요.

예시1: Cloud Storage Datastore 만들기

다음 요청은 Cloud Storage Datastore를 만듭니다.

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores" \

-X POST \

-H "Content-type:application/json" \

-H "Authorization: Bearer $TOKEN" \

-d \

'{

"displayName": "My Cloud Storage datastore",

"targetType": "gcs",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

}'

$TOKEN를 OAuth 2.0 액세스 토큰 가져오기에 설명된 대로 OAuth 2.0 액세스 토큰으로 설정합니다. 이 예시에서 사용된 curl 옵션에 대한 자세한 내용은 curl 사용을 참조하세요. 사용된 환경 변수에 대한 설명은 Apigee API 요청에 대한 환경 변수 설정을 참조하세요.

예시2: BigQuery Datastore 만들기

다음 요청은 BigQuery Datastore를 만듭니다.

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores" \

-X POST \

-H "Content-type:application/json" \

-H "Authorization: Bearer $TOKEN" \

-d \

'{

"displayName": "My BigQuery datastore",

"targetType": "bigquery",

"datastoreConfig": {

"projectId": "my-project",

"datasetName": "mybigquery",

"tablePrefix": "bqprefix"

}

}'

$TOKEN를 OAuth 2.0 액세스 토큰 가져오기에 설명된 대로 OAuth 2.0 액세스 토큰으로 설정합니다. 이 예시에서 사용된 curl 옵션에 대한 자세한 내용은 curl 사용을 참조하세요. 사용된 환경 변수에 대한 설명은 Apigee API 요청에 대한 환경 변수 설정을 참조하세요.

모든 Datastore 보기

조직의 모든 Datastore를 보려면 /organizations/{org}/analytics/datastores API에 GET 요청을 실행합니다.

예를 들면 다음과 같습니다.

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores" \ -X GET \ -H "Authorization: Bearer $TOKEN"

$TOKEN를 OAuth 2.0 액세스 토큰 가져오기에 설명된 대로 OAuth 2.0 액세스 토큰으로 설정합니다. 이 예시에서 사용된 curl 옵션에 대한 자세한 내용은 curl 사용을 참조하세요. 사용된 환경 변수에 대한 설명은 Apigee API 요청에 대한 환경 변수 설정을 참조하세요.

다음은 응답의 예시입니다.

{

"datastores": [

{

"self": "/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b",

"displayName": "My Cloud Storage datastore",

"org": "myorg",

"targetType": "gcs",

"createTime": "1535411583949",

"lastUpdateTime": "1535411634291",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

},

{

"self": "/organizations/myorg/analytics/datastores/g8c3f0mk-1f78-8837-9c67-k222b60ce30b",

"displayName": "My BigQuery datastore",

"org": "myorg",

"targetType": "bigquery",

"createTime": "1535411583949",

"lastUpdateTime": "1535411634291",

"datastoreConfig": {

"projectId": "my-project",

"datasetName": "mybigquery",

"tablePrefix": "bqprefix"

}

}

]

}

자세한 내용은 Data Store API 나열을 참조하세요.

Datastore의 세부정보 보기

Datastore의 세부정보를 보려면 /organizations/{org}/analytics/datastores/{datastore} API에 GET 요청을 실행합니다.

예를 들면 다음과 같습니다.

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b" \ -X GET \ -H "Authorization: Bearer $TOKEN"

$TOKEN를 OAuth 2.0 액세스 토큰 가져오기에 설명된 대로 OAuth 2.0 액세스 토큰으로 설정합니다. 이 예시에서 사용된 curl 옵션에 대한 자세한 내용은 curl 사용을 참조하세요. 사용된 환경 변수에 대한 설명은 Apigee API 요청에 대한 환경 변수 설정을 참조하세요.

다음은 Cloud Storage Datastore의 응답 예시입니다.

{

"self": "/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b",

"displayName": "My Cloud Storage datastore",

"org": "myorg",

"targetType": "gcs",

"createTime": "1535411583949",

"lastUpdateTime": "1535411634291",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

}

자세한 내용은 Data Store API 가져오기를 참조하세요.

Datastore 수정

Datastore를 수정하려면 /organizations/{org}/analytics/datastores/{datastore} API에 PUT 요청을 실행합니다. 다음 정보의 전체 또는 일부를 요청 본문에 전달하세요.

- Datastore 표시 이름

- Datastore 요청 속성 참조에 설명된 Datastore 유형에 따른 구성 세부정보

예를 들어 Cloud Storage Datastore를 업데이트하려면 다음 명령어를 입력합니다.

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores" \

-X PUT \

-H "Content-type:application/json" \

-H "Authorization: Bearer $TOKEN" \

-d \

'{

"displayName": "My Cloud Storage datastore",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

}'

$TOKEN를 OAuth 2.0 액세스 토큰 가져오기에 설명된 대로 OAuth 2.0 액세스 토큰으로 설정합니다. 이 예시에서 사용된 curl 옵션에 대한 자세한 내용은 curl 사용을 참조하세요. 사용된 환경 변수에 대한 설명은 Apigee API 요청에 대한 환경 변수 설정을 참조하세요.

다음은 Cloud Storage Datastore의 응답 예시입니다.

{

"self": "/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b",

"displayName": "My Cloud Storage datastore",

"org": "myorg",

"targetType": "gcs",

"createTime": "1535411583949",

"lastUpdateTime": "1535411634291",

"datastoreConfig": {

"projectId": "my-project",

"bucketName": "my-bucket",

"path": "my/analytics/path"

}

}

자세한 내용은 Data Store API 업데이트를 참조하세요.

Datastore 삭제

Datastore를 삭제하려면 /organizations/{org}/analytics/datastores/{datastore} API에 DELETE 요청을 실행합니다.

예를 들면 다음과 같습니다.

curl "https://apigee.googleapis.com/v1/organizations/myorg/analytics/datastores/c7d3b5aq-1c64-3389-9c43-b211b60de35b" \ -X DELETE \ -H "Authorization: Bearer $TOKEN"

$TOKEN를 OAuth 2.0 액세스 토큰 가져오기에 설명된 대로 OAuth 2.0 액세스 토큰으로 설정합니다. 이 예시에서 사용된 curl 옵션에 대한 자세한 내용은 curl 사용을 참조하세요. 사용된 환경 변수에 대한 설명은 Apigee API 요청에 대한 환경 변수 설정을 참조하세요.

다음은 응답의 예시입니다.

{}자세한 내용은 Data Store API 삭제를 참조하세요.

분석 데이터 내보내기

분석 데이터를 내보내려면 /organizations/{org}/environments/{env}/analytics/exports API에 POST 요청을 실행합니다. 요청 본문에 다음 정보를 전달합니다.

- 내보내기 요청의 이름 및 설명

- 내보낸 데이터의 기간(값은 하루만 가능)

- 내보낸 데이터의 형식

- Datastore 이름

내보내기 요청의 예시는 다음과 같습니다. 요청 본문 속성에 대한 자세한 설명은 내보내기 요청 속성 참조를 확인하세요.

POST의 응답은 다음과 같은 형식입니다.

{

"self": "/organizations/myorg/environments/test/analytics/exports/a7c2f0dd-1b53-4917-9c42-a211b60ce35b",

"created": "2017-09-28T12:39:35Z",

"state": "enqueued"

}

응답의 state 속성은 enqueued로 설정됩니다. POST 요청은 비동기식으로 작동합니다. 즉, 요청이 응답을 반환한 후에도 백그라운드에서 계속 실행됩니다. 가능한 state 값은 enqueued, running, completed, failed입니다.

self 속성에 반환된 URL을 사용하여 애널리틱스 내보내기 요청 상태 보기에 설명된 대로 데이터 내보내기 요청의 상태를 확인합니다. 요청이 완료되면 응답의 state 속성 값이 completed로 설정됩니다. 그런 다음 Datastore의 분석 데이터에 액세스할 수 있습니다.

자세한 내용은 Data Export API 만들기를 참조하세요.

예시1: Cloud Storage로 데이터 내보내기

다음 예시에서는 myorg 조직의 test 환경에서 지난 24시간의 전체 원시 데이터 세트를 내보냅니다. 콘텐츠는 JSON의 Cloud Storage로 내보내집니다.

curl "https://apigee.googleapis.com/v1/organizations/myorg/environments/test/analytics/exports" \

-X POST \

-H "Content-type:application/json" \

-H "Authorization: Bearer $TOKEN" \

-d \

'{

"name": "Export raw results to Cloud Storage",

"description": "Export raw results to Cloud Storage for last 24 hours",

"dateRange": {

"start": "2020-06-08",

"end": "2020-06-09"

},

"outputFormat": "json",

"datastoreName": "My Cloud Storage data repository"

}'

$TOKEN를 OAuth 2.0 액세스 토큰 가져오기에 설명된 대로 OAuth 2.0 액세스 토큰으로 설정합니다. 이 예시에서 사용된 curl 옵션에 대한 자세한 내용은 curl 사용을 참조하세요. 사용된 환경 변수에 대한 설명은 Apigee API 요청에 대한 환경 변수 설정을 참조하세요.

self 속성으로 지정된 URI를 사용하여 애널리틱스 내보내기 요청 상태 보기에 설명된 대로 작업 상태를 모니터링합니다.

예시2: BigQuery로 데이터 내보내기

다음은 쉼표로 구분된 CSV 파일을 BigQuery로 내보내는 예시입니다.

curl "https://apigee.googleapis.com/v1/organizations/myorg/environments/test/analytics/exports" \

-X POST \

-H "Content-type:application/json" \

-H "Authorization: Bearer $TOKEN" \

-d \

'{

"name": "Export query results to BigQuery",

"description": "One-time export to BigQuery",

"dateRange": {

"start": "2018-06-08",

"end": "2018-06-09"

},

"outputFormat": "csv",

"csvDelimiter": ",",

"datastoreName": "My BigQuery data repository"

}'

$TOKEN를 OAuth 2.0 액세스 토큰 가져오기에 설명된 대로 OAuth 2.0 액세스 토큰으로 설정합니다. 이 예시에서 사용된 curl 옵션에 대한 자세한 내용은 curl 사용을 참조하세요. 사용된 환경 변수에 대한 설명은 Apigee API 요청에 대한 환경 변수 설정을 참조하세요.

참고: 내보낸 CSV 파일은 다음 프리픽스로 BigQuery 테이블을 만듭니다.

<PREFIX>_<EXPORT_DATE>_api_<UUID>_from_<FROM_DATE>_to_<TO_DATE>

self 속성으로 지정된 URI를 사용하여 애널리틱스 내보내기 요청 상태 보기에 설명된 대로 작업 상태를 모니터링합니다.

내보내기 API 할당량 정보

비용이 많이 드는 데이터 내보내기 API 호출의 과다 사용을 방지하기 위해 Apigee에서는 organizations/{org}/environments/{env}/analytics/exports API 호출에 조직당 일일 15회의 할당량을 적용합니다.

호출 할당량을 초과하면 API는 HTTP 429 응답을 반환합니다.

모든 애널리틱스 내보내기 요청 상태 보기

모든 애널리틱스 내보내기 요청의 상태를 보려면 /organizations/{org}/environments/{env}/analytics/exports에 GET 요청을 실행합니다.

예를 들어 다음 요청은 myorg 조직의 test 환경에 대한 모든 애널리틱스 내보내기 요청 상태를 반환합니다.

curl "https://apigee.googleapis.com/v1/organizations/myorg/environments/test/analytics/exports" \ -X GET \ -H "Authorization: Bearer $TOKEN"

$TOKEN를 OAuth 2.0 액세스 토큰 가져오기에 설명된 대로 OAuth 2.0 액세스 토큰으로 설정합니다. 이 예시에서 사용된 curl 옵션에 대한 자세한 내용은 curl 사용을 참조하세요. 사용된 환경 변수에 대한 설명은 Apigee API 요청에 대한 환경 변수 설정을 참조하세요.

다음은 큐에 추가된(생성되고 큐에 있는) 요청과 완료된 요청의 두 가지 내보내기 요청을 보여주는 응답 예시를 보여줍니다.

[

{

"self":

"/v1/organizations/myorg/environments/test/analytics/exports/e8b8db22-fe03-4364-aaf2-6d4f110444ba",

"name": "Export results To Cloud Storage",

"description": "One-time export to Cloud Storage",

"userId": "my@email.com",

"datastoreName": "My datastore",

"executionTime": "36 seconds",

"created": "2018-09-28T12:39:35Z",

"updated": "2018-09-28T12:39:42Z",

"state": "enqueued"

},

{

"self":

"/v1/organizations/myorg/environments/test/analytics/exports/9870987089fe03-4364-aaf2-6d4f110444ba"

"name": "Export raw results to BigQuery",

"description": "One-time export to BigQuery",

...

}

]

자세한 내용은 Data Exports API 나열을 참조하세요.

애널리틱스 내보내기 요청 상태 보기

특정 애널리틱스 내보내기 요청의 상태를 보려면 /organizations/{org}/environments/{env}/analytics/exports/{exportId}에 GET 요청을 실행합니다. 여기서 {exportId}는 애널리틱스 내보내기 요청과 연결된 ID입니다.

예를 들어 다음 요청은 ID가 4d6d94ad-a33b-4572-8dba-8677c9c4bd98인 애널리틱스 내보내기 요청의 상태를 반환합니다.

curl "https://apigee.googleapis.com/v1/organizations/myorg/environments/test/analytics/exports/4d6d94ad-a33b-4572-8dba-8677c9c4bd98" \ -X GET \ -H "Authorization: Bearer $TOKEN"

다음은 응답의 예시입니다.

{

"self":

"/v1/organizations/myorg/environments/test/analytics/exports/4d6d94ad-a33b-4572-8dba-8677c9c4bd98",

"name": "Export results to Cloud Storage",

"description": "One-time export to Cloud Storage",

"userId": "my@email.com",

"datastoreName": "My datastore",

"executionTime": "36 seconds",

"created": "2018-09-28T12:39:35Z",

"updated": "2018-09-28T12:39:42Z",

"state": "enqueued"

}

자세한 내용은 Data Export API 가져오기를 참조하세요.

애널리틱스 내보내기에서 분석 데이터가 반환되지 않는 경우 executionTime은 '0초'로 설정됩니다.

Datastore 요청 속성 참조

다음 표에서는 Datastore 유형을 기반으로 Datastore를 만들 때 JSON 형식으로 요청 본문을 전달할 수 있는 속성을 설명합니다.

Google Cloud Storage의 경우:

| 속성 | 설명 | 필수 여부 |

|---|---|---|

| 프로젝트 ID | Google Cloud Platform 프로젝트 ID

Google Cloud Platform 프로젝트를 만들려면 Google Cloud Platform 문서의 프로젝트 만들기 및 관리를 참조하세요. |

예 |

| 버킷 이름 | 분석 데이터를 내보낼 Cloud Storage의 버킷 이름입니다.

참고: 데이터 내보내기를 수행하기 전에 버킷이 있어야 합니다. Cloud Storage 버킷을 만들려면 Google Cloud Platform 문서에서 버킷 만들기를 참조하세요. |

예 |

| 경로 | Cloud Storage 버킷에 분석 데이터를 저장할 디렉터리입니다. | 예 |

BigQuery의 경우:

| 속성 | 설명 | 필수 여부 |

|---|---|---|

| 프로젝트 ID | Google Cloud Platform 프로젝트 ID

Google Cloud Platform 프로젝트를 만들려면 Google Cloud Platform 문서의 프로젝트 만들기 및 관리를 참조하세요. |

예 |

| 데이터 세트 이름 | 분석 데이터를 내보낼 BigQuery 데이터 세트의 이름입니다. 데이터 내보내기를 요청하기 전에 데이터 세트가 만들어졌는지 확인합니다.

BigQuery 데이터 세트를 만들려면 Google Cloud Platform 문서의 데이터 세트 만들기 및 사용을 참조하세요. |

예 |

| 테이블 프리픽스 | BigQuery 데이터 세트에서 분석 데이터에 대해 생성된 테이블 이름의 프리픽스입니다. | 예 |

내보내기 요청 속성 참조

다음 표에서는 분석 데이터를 내보낼 때 JSON 형식으로 요청 본문을 전달할 수 있는 속성을 설명합니다.

| 속성 | 설명 | 필수 여부 |

|---|---|---|

description

|

내보내기 요청에 대한 설명입니다. | N |

name

|

내보내기 요청의 이름입니다. | 예 |

dateRange

|

내보낼 데이터의

"dateRange": {

"start": "2018-07-29",

"end": "2018-07-30"

}

참고 : 전날의 모든 데이터가 캡처되도록 내보내기 요청의 시작 시간을 지연시켜야 할 수 있습니다(예: 00:05:00 AM UTC). |

예 |

outputFormat

|

json 또는 csv로 지정합니다. |

예 |

csvDelimiter

|

|

N |

datastoreName

|

Datastore의 정의를 포함하는 Datastore의 이름입니다. | 예 |

예를 들면 다음과 같습니다.

{

"name": "Export raw results to Cloud Storage",

"description": "Export raw results to Cloud Storage for last 24 hours",

"datastoreName": "My Cloud Storage datastore"

}