안전한 Google Cloud AI를 마스터하기: 기업을 위한 실용 가이드

Schneider Larbi

Principal Partner Engineer

David Peterside

Partner Engineer

Try Gemini 3.1 Pro

Our most intelligent model available yet for complex tasks on Gemini Enterprise and Vertex AI

Try now해당 블로그의 원문은 2025년 3월 22일 Google Cloud 블로그(영문)에 게재되었습니다.

서론

업계 전반에 걸쳐 AI 도입이 급속히 확산되고 있지만, 조직들은 여전히 데이터 개인 정보 보호 및 보안에 대한 새로운 도전으로 인해 안전한 솔루션을 구현하는 데 어려움을 겪는 경우가 많습니다.

저희는 고객들이 AI를 개발하고 배포하는 과정에서 성공을 거두는 것을 돕기 위해, 위험 완화(risk mitigation)와 선제적인 보안 조치(proactive security measures)를 신중하게 고려해야 한다고 강조합니다.

안전한 AI 플랫폼의 네 가지 초석

-

인프라: 여러분의 기반 (Infrastructure is your foundation.)

-

마치 보관 시설의 물리적 보안과 같이, 안전한 Google Cloud 인프라 (컴퓨팅, 네트워킹, 스토리지)는 AI 모델 및 애플리케이션이 작동하는 AI 플랫폼의 토대가 됩니다.

-

-

데이터: 여러분의 보호받는 연료 (Data is your protected fuel.)

-

AI 기반 애플리케이션을 개발할 때 데이터 보안은 매우 중요합니다. 무단 액세스, 수정 및 도난으로부터 데이터를 보호하는 것이 필수적입니다. 보호된 데이터는 AI 무결성을 보호하고, 개인 정보 보호 규정 준수를 보장하며, 고객 신뢰를 구축하는 데 도움이 될 수 있습니다.

-

-

보안: 여러분의 방패 (Security is your shield.)

-

이 계층은 보관 시설의 보안 시스템과 유사하게 위협을 탐지, 방지 및 대응하여 전체 AI 생태계를 보호합니다. 강력한 AI 보안 전략은 공격 표면을 최소화하고, 인시던트를 탐지하며, 기밀성, 무결성 및 가용성을 유지해야 합니다.

-

-

책임감 있는 AI (RAI): 여러분의 윤리적 나침반 (Responsible AI is your ethical compass.)

-

엔터프라이즈 AI 시스템에 대한 신뢰를 구축하는 것은 시스템을 보호하는 것만큼 중요합니다. 책임감 있는 AI는 AI 시스템이 윤리적으로, 그리고 사회에 이익이 되는 방식으로 사용되도록 보장합니다. 이는 보관 시설이 원래 의도된 목적으로 사용되며 불법적이거나 비윤리적인 활동에 사용되지 않도록 보장하는 것과 같습니다. RAI는 다음을 기반으로 합니다:

-

공정성 (Fairness): 편향 완화를 사용하여 AI 모델이 편향되지 않고 모든 사용자를 공정하게 대하도록 보장합니다. 이를 위해서는 신중한 데이터 선택, 모델 평가 및 지속적인 모니터링이 필요합니다.

-

설명 가능성 (Explainability): 모델 투명성은 AI 모델을 투명하고 이해하기 쉽게 만들어 잠재적인 문제를 식별하고 해결할 수 있도록 합니다. 설명 가능한 AI(Explainable AI)는 AI 시스템에 대한 신뢰를 구축하는 데 도움이 될 수 있습니다.

-

개인 정보 보호 (Privacy): 데이터 보호 및 규정 준수를 통해 사용자 데이터를 보호하고 개인 정보 보호 규정을 준수할 수 있습니다. 여기에는 적절한 데이터 익명화 및 비식별화 기술 구현이 포함됩니다.

-

책임성 (Accountability): 엔터프라이즈 AI 시스템의 윤리적 영향에 대한 책임이 있도록, 해당 시스템의 개발 및 배포에 대한 명확한 책임 라인을 설정합니다.

-

-

책임감 있는 AI는 AI 시스템에 대한 신뢰를 구축하고 시스템이 윤리적이며 유익한 방식으로 사용되도록 보장하는 데 필수적입니다. 공정성, 설명 가능성, 개인 정보 보호 및 책임성을 우선시함으로써 조직은 안전하고 신뢰할 수 있는 AI 시스템을 구축할 수 있습니다. 고객의 AI 여정을 지원하기 위해, 저희는 다음과 같은 설계 고려 사항을 제공했습니다.

Vertex AI의 주요 보안 설계 고려 사항

Vertex AI는 머신러닝 모델을 구축 및 배포하고 파운데이션 모델(Foundation Models)에 액세스할 수 있는 보안 관리 환경(secured managed environment)을 제공합니다. 그러나 Vertex AI를 기반으로 구축하려면 신중한 보안 설계가 필요합니다.

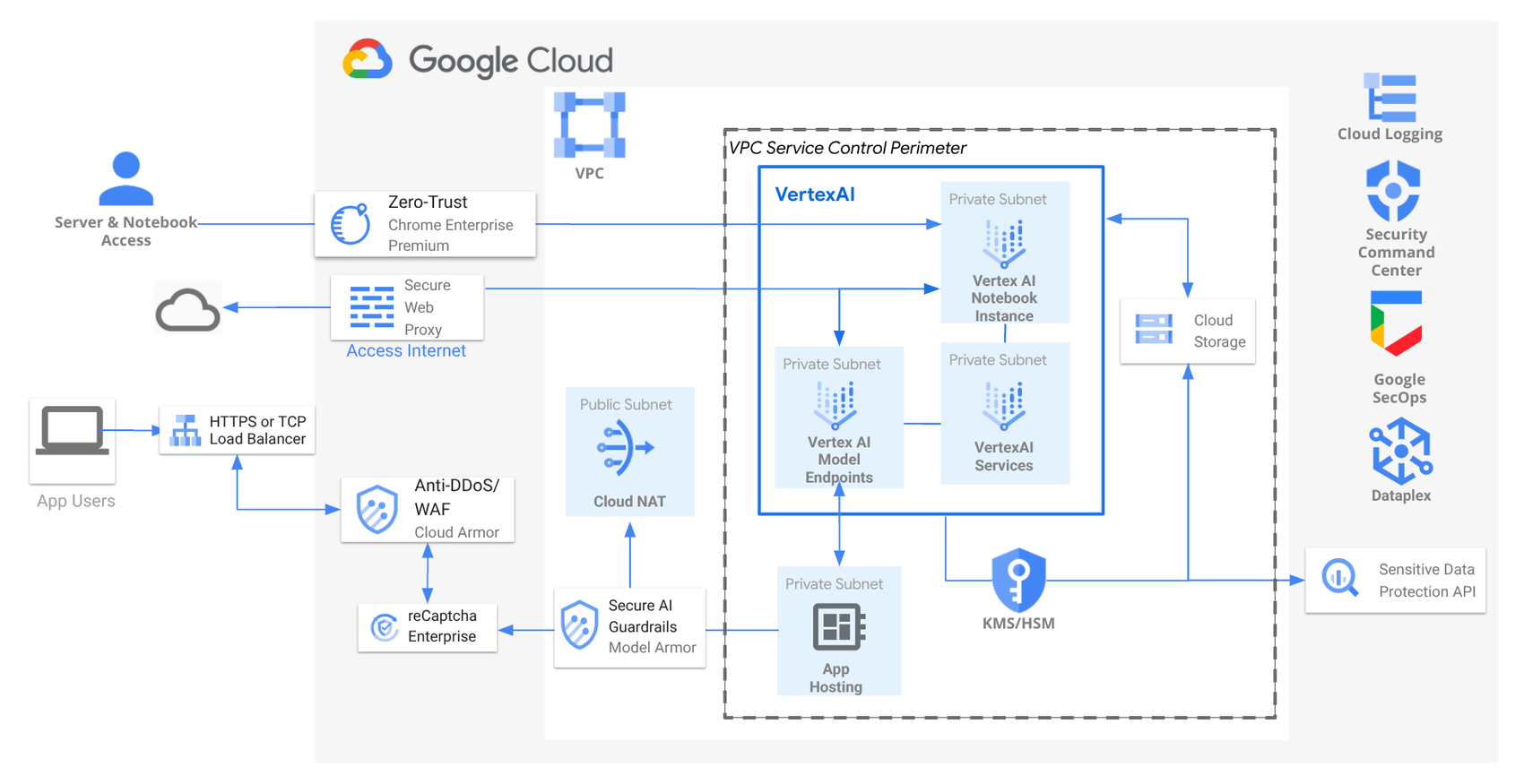

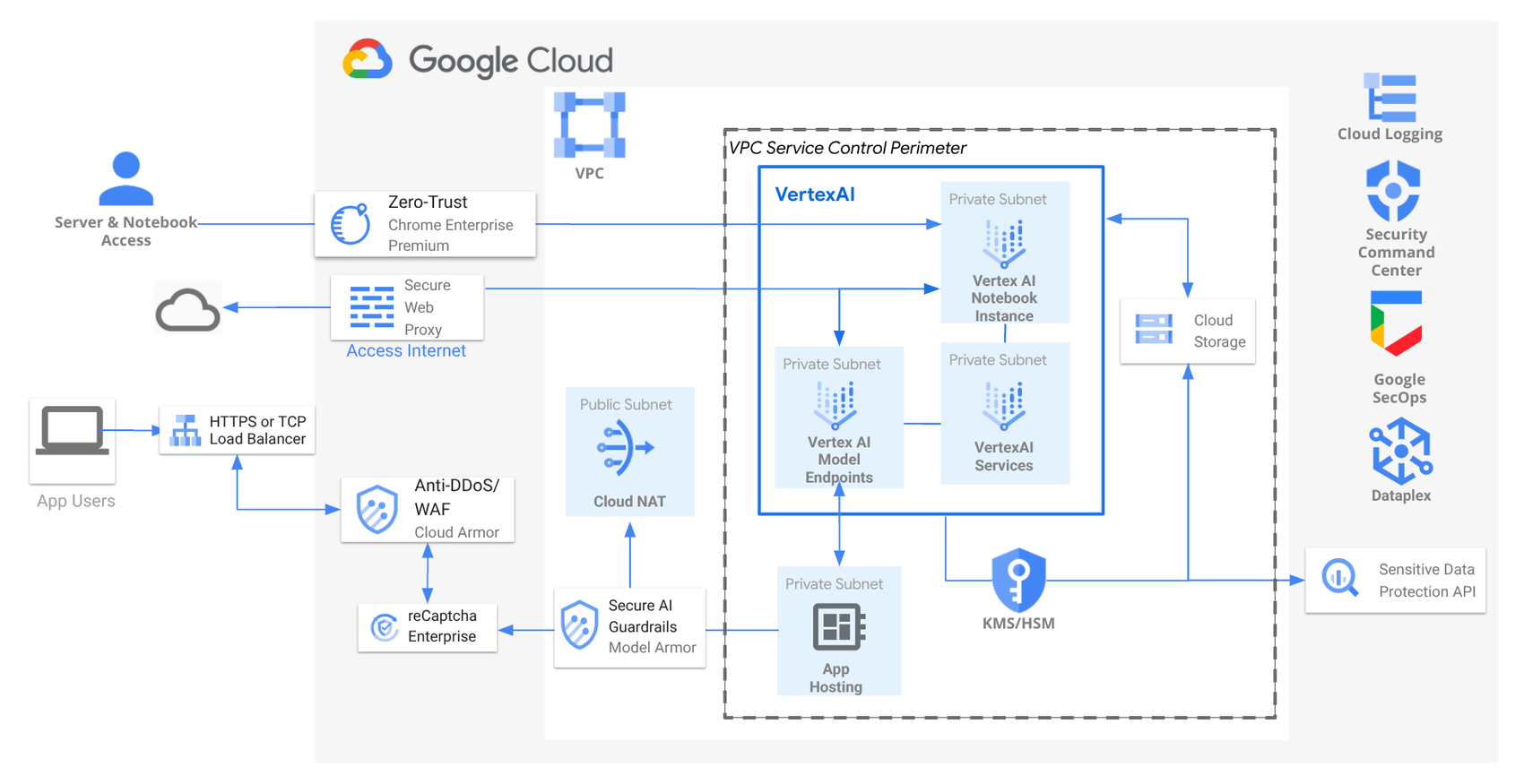

안전한 AI/ML 배포 참조 아키텍처

위에 제시된 아키텍처에서, 저희는 네 가지 핵심 초석을 염두에 두고 AI 애플리케이션 보안을 설계할 것을 권장한다는 것을 알 수 있습니다.

여기서 Virtual Private Cloud (VPC)가 플랫폼의 기반이라는 것을 알 수 있습니다. 이는 AI 자원을 공용 인터넷으로부터 격리하여, Google Cloud 상의 민감한 데이터, 애플리케이션 및 모델을 위한 사설 네트워크를 생성합니다.

저희는 Vertex AI 자원(예: Notebooks 및 모델 엔드포인트)에 대한 사설 엔드포인트 유형으로 Private Services Connect (PSC) 사용을 권장합니다. 이는 Vertex AI 자원이 사설 VPC 서브넷에 배포되어 직접적인 인터넷 액세스를 방지할 수 있도록 허용합니다. 또한, VPC 내 사설 서브넷에 배포된 애플리케이션이 AI 모델로 안전하게 추론(inference) 요청을 비공개로 할 수 있도록 합니다.

Identity and Access Management (IAM) 외에 추가적으로 VPC Service Control 경계와 방화벽 규칙(Firewall Rules)이 사용되어 네트워크 통신을 승인하고 원치 않는 연결을 차단합니다. 이는 AI 처리를 위한 클라우드 자원과 데이터의 보안을 강화합니다. 보호되는 서비스 및 프로젝트에 대한 액세스를 제어하기 위해 IP 주소, 장치 정책, 사용자 ID, 그리고 지리적 위치를 기반으로 액세스 수준을 정의할 수 있습니다.

노트북과 같은 사설 자원이 업데이트를 위해 인터넷에 액세스해야 하는 요구 사항이 있는 경우, Cloud NAT 구축을 권장합니다. Cloud NAT는 사설 서브넷의 인스턴스가 (소프트웨어 업데이트와 같이) 인터넷에 액세스할 수 있도록 하면서도, 직접적인 인바운드 연결에 노출되는 것을 방지합니다.

참조 아키텍처는 AI 애플리케이션의 네트워크 진입점으로 Cloud Load Balancer (LB)를 사용합니다. LB는 트래픽을 여러 인스턴스에 안전하게 분산하여 고가용성과 확장성을 보장합니다. Cloud Armor와 통합되어 DDoS (서비스 거부) 및 웹 공격으로부터 보호합니다.

reCAPTCHA Enterprise는 봇 또는 사람에 의해 자행되는 사기 및 남용을 방지할 수 있습니다. LB의 고유한 확장성은 Google Cloud가 사상 최대 규모의 DDoS 공격 중 하나를 막았을 때처럼 DDoS 공격을 효과적으로 완화할 수 있습니다.

Model Armor도 사용되어 파운데이션 모델의 프롬프트와 응답을 다양한 보안 및 안전 위험에 대해 선별함으로써 AI 애플리케이션의 보안과 안전을 강화합니다. Model Armor는 위험한 괴롭힘, 혐오 발언 등에 대한 필터링과 같은 기능을 수행할 수 있습니다. 또한, 프롬프트와 응답에서 악성 URL은 물론 인젝션 및 탈옥(jailbreak) 공격을 식별할 수 있습니다.

이 설계에서는 Chrome Enterprise Premium을 사용하여 제로 트러스트(Zero Trust) 모델을 구현합니다. 이는 Google Cloud의 AI 애플리케이션에 대한 원격 액세스 시 모든 사용자 및 장치를 인증하고 승인함으로써 내재된 신뢰를 제거합니다. Chrome Enterprise Premium은 모든 인바운드 트래픽의 검사 및 확인을 강제하는 한편, Secure Web Proxy는 안전한 이그레스(외부 발신) HTTP/S 트래픽을 관리합니다.

Sensitive Data Protection은 민감한 정보를 발견, 분류 및 보호하고 데이터 무결성을 유지함으로써 Google Cloud의 AI 데이터를 보호할 수 있습니다. Cloud Key Management는 Vertex AI 모델 아티팩트 및 민감한 데이터에 대한 중앙 집중식 암호화 키 관리를 제공하는 데 사용됩니다.

이 참조 아키텍처 외에도, Vertex AI를 사용할 때는 적절한 IAM 역할을 구현하는 것이 중요합니다. 이는 머신러닝(ML) 워크플로우의 다양한 단계에서 Vertex AI 자원에 대한 제어 및 액세스를 강제합니다. 예를 들어, 데이터 과학자, 모델 훈련 담당자, 모델 배포 담당자 등을 위한 역할이 정의되어야 합니다.

마지막으로, Vertex AI 배포에서 잠재적인 취약점을 식별하고 해결하기 위해 정기적인 보안 평가 및 침투 테스트를 수행하는 것이 중요합니다. Security Command Center, Google Security Operations, Dataplex, Cloud Logging과 같은 도구는 Google Cloud에서 AI/ML 배포에 대한 안전한 보안 태세(secure security posture)를 강화하는 데 사용될 수 있습니다.

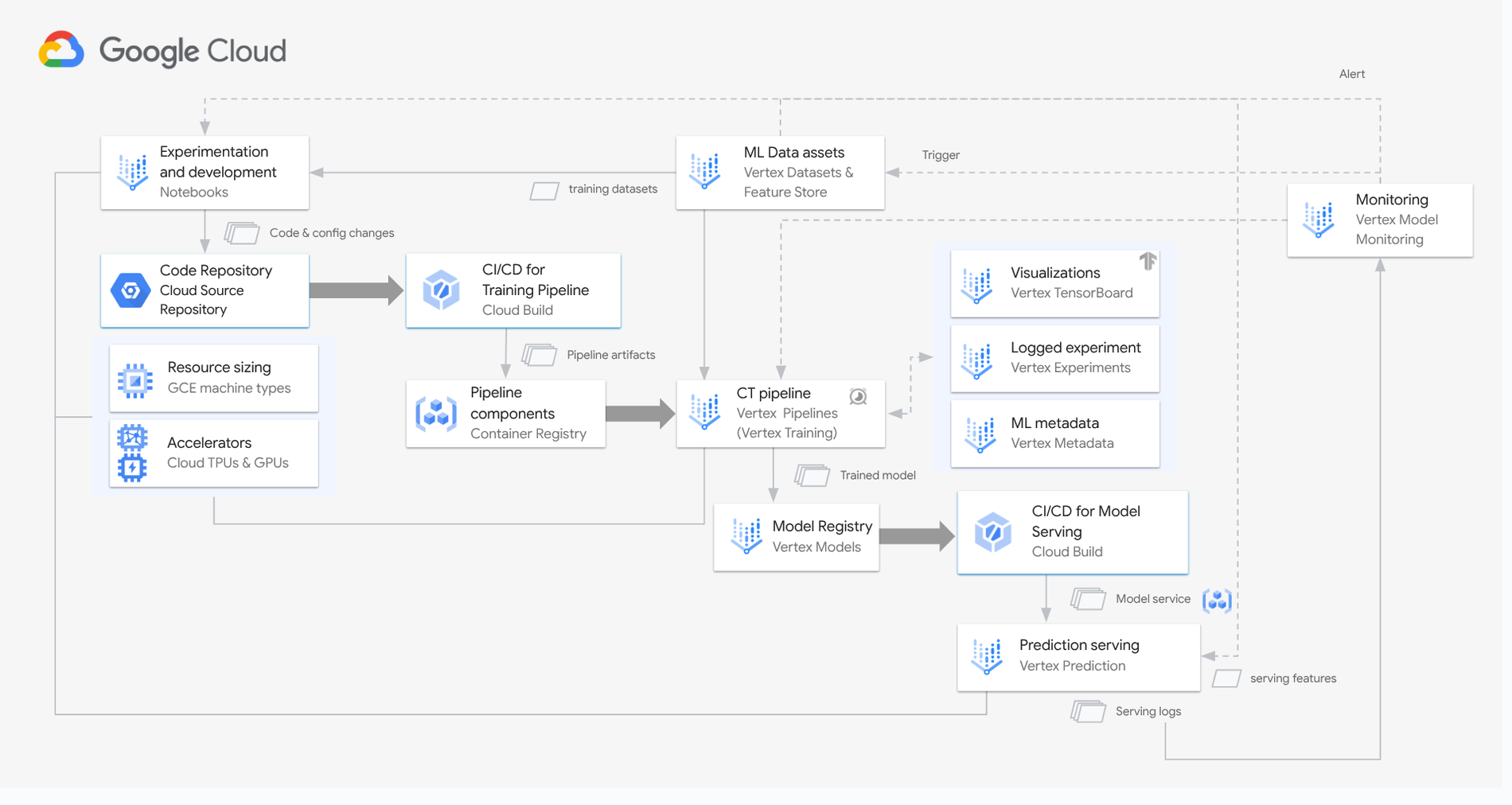

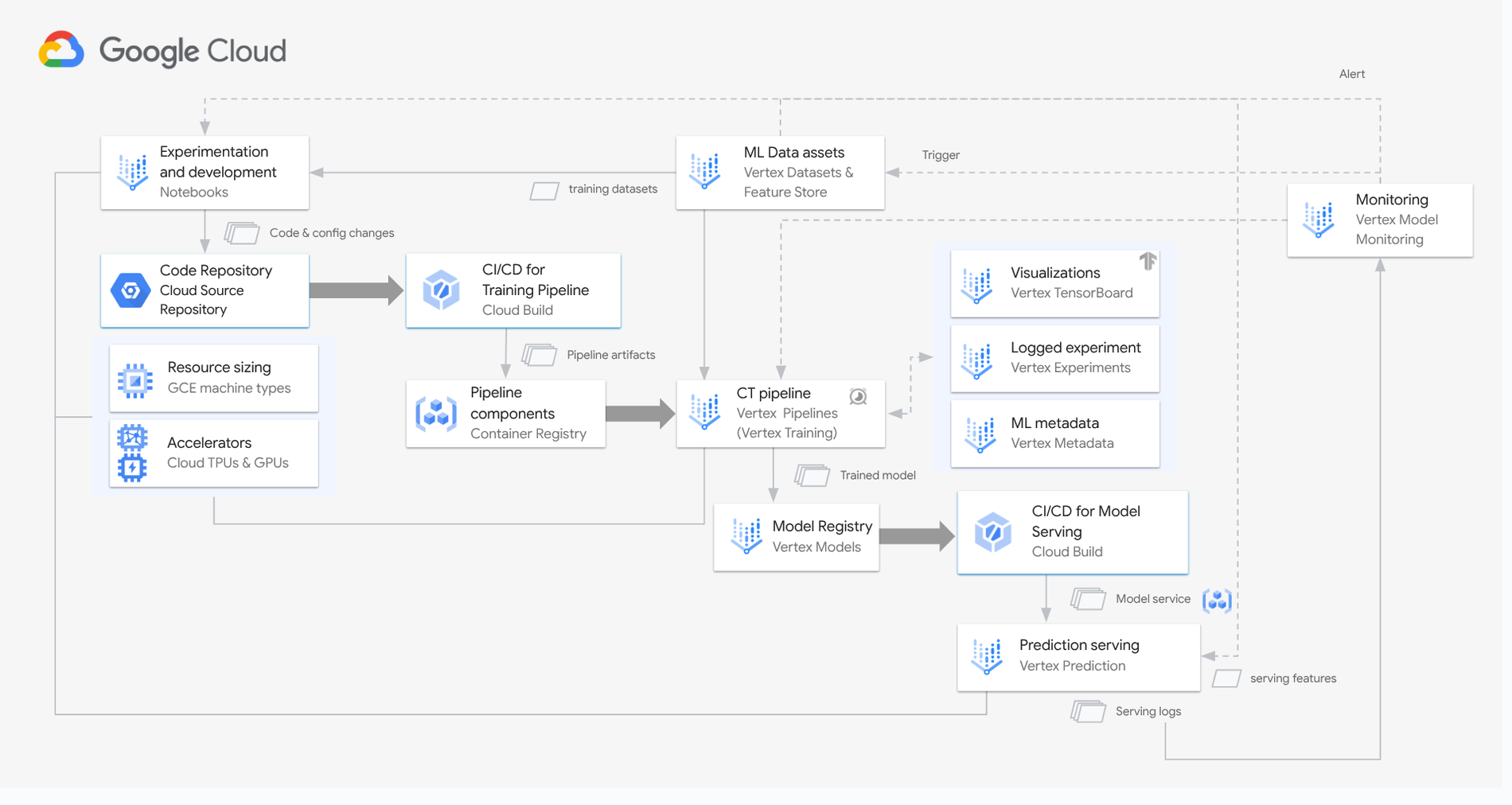

Vertex AI에서 머신러닝 워크플로우 보안

저희가 논의한 일반적인 AI/ML 보안 아키텍처를 기반으로, Vertex 기반 ML 워크플로우는 각 단계에서 특정 보안 과제를 제시합니다. 다음 권장 사항에 따라 AI 워크로드를 보호할 때 이러한 고유한 문제들을 해결하십시오:

-

개발 및 데이터 수집 (Development and data ingestion): IAM 역할로 액세스를 관리하고, Vertex AI Notebooks에서 환경을 격리하며, 파이프라인을 인증하고 입력을 정화(sanitizing)하여 인젝션 공격을 방지함으로써 안전한 개발을 시작하십시오.

-

코드 및 파이프라인 보안 (Code and pipeline security): 액세스 제어를 위해 Cloud Source Repositories를 사용하는 IAM으로 코드 리포지토리를 보호하고 브랜치 보호 정책을 구현하십시오. Cloud Build를 사용하여 빌드 실행 및 아티팩트 액세스를 IAM으로 제어하여 CI/CD 파이프라인을 보호하십시오. 안전한 이미지 소스를 사용하고 컨테이너 이미지에 대한 취약성 스캔을 수행하십시오.

-

훈련 및 모델 보호 (Training and model protection): 사설 엔드포인트를 사용하고, 훈련 데이터에 대한 액세스를 제어하며, 의심스러운 활동을 모니터링하여 모델 훈련 환경을 보호하십시오. Container Registry로 파이프라인 구성 요소를 관리하고, 사설 레지스트리 액세스 제어 및 컨테이너 이미지 취약성 스캔을 우선시하십시오.

-

배포 및 서빙 (Deployment and serving): 강력한 인증 및 권한 부여로 모델 엔드포인트를 보호하십시오. 남용을 방지하기 위해 속도 제한을 구현하십시오. 추론(prediction) 서빙을 위해 Vertex Prediction을 사용하고, IAM 정책을 구현하여 모델 액세스를 제어하고 입력 정화를 통해 프롬프트 인젝션을 방지하십시오.

-

모니터링 및 거버넌스 (Monitoring and governance): 지속적인 모니터링이 핵심입니다. Vertex Model Monitoring을 사용하여 알림을 설정하고, 이상 징후를 탐지하며, 데이터 개인 정보 보호 장치를 구현하십시오.

안전한 MLOps 참조 아키텍처

Vertex AI MLOps 워크플로우 내에서 보안 개발, 코드 관리, 강력한 모델 보호, 지속적인 모니터링과 같은 핵심 영역에 중점을 둠으로써, 고객들은 AI 애플리케이션의 보안을 크게 강화할 수 있습니다.

Vertex AI의 기밀 컴퓨팅 AI

Vertex AI에서 고도로 민감한 고객 데이터를 다루는 경우, 기밀 컴퓨팅(Confidential Computing) 사용을 권장합니다. 이는 VM 메모리를 암호화하고, Google조차 추출할 수 없는, 각 VM 고유의 임시 하드웨어 기반 키를 생성하며, CPU/GPU 간 전송 중인 데이터를 암호화합니다. 이 신뢰 실행 환경(Trusted Execution Environment)은 승인된 워크로드에게만 데이터 액세스를 제한합니다.

기밀 컴퓨팅은 데이터 기밀성을 보장하고, 인증(attestation)을 통해 코드 무결성을 강제하며, 운영자 및 워크로드 소유자를 신뢰 경계(trust boundary)에서 제외시킵니다.

오늘 바로 시작하십시오.

저희는 조직들이 다음의 핵심 조치들을 적용함으로써 Google Cloud 상의 AI 보안을 우선시하도록 권장합니다.

-

데이터 거버넌스, 보안, 인프라 및 RAI에 대해 Google Cloud의 모범 사례가 채택되었는지 확인하십시오.

-

VPC Service Controls, CMEK를 사용한 암호화, IAM을 사용한 액세스 제어와 같은 보안 제어 기능을 구현하십시오.

-

RAI Toolkit을 사용하여 책임감 있는 AI 접근 방식을 보장하십시오.

-

Google Safeguards를 사용하여 AI 모델을 보호하십시오.

-

데이터 개인 정보 보호와 데이터 관리를 위한 안전한 관행의 중요성을 확보하십시오.

-

MLOps 워크플로우 전반에 걸쳐 보안 모범 사례를 적용하십시오.

-

정보 습득 유지: Secure AI Framework (SAIF)를 포함한 최신 자료들을 지속적으로 파악하십시오.

이러한 전략들을 구현함으로써 조직들은 위험을 효과적으로 완화하는 동시에 AI의 이점을 활용할 수 있으며, Google Cloud 상에 안전하고 신뢰할 수 있는 AI 생태계를 보장할 수 있는 역량을 갖추게 됩니다. 귀하의 비즈니스를 위해 이러한 관행들을 구현하는 데 도움을 받으려면 Google의 공인 파트너에게 연락하십시오.