熱を帯びる AI インフラストラクチャに効果的な新しい電力分配と液体冷却のインフラストラクチャ

Madhusudan Iyengar

Principal Engineer

Amber Huffman

Principal Engineer, Google

※この投稿は米国時間 2025 年 4 月 30 日に、Google Cloud blog に投稿されたものの抄訳です。

AI がコンピューティング環境を根本的に変え、データセンター インフラストラクチャにはかつてないほどの進歩が求められています。Google は、AI の継続的なスケーリングにとって、物理的なインフラストラクチャ(全体を支える電力、冷却、機械の各システム)は単に重要であるだけでなく、不可欠なものであると考えています。

Google は Open Compute Project(OCP)と長年にわたって連携してきました。OCP は、業界内のコラボレーションと、インフラストラクチャにおけるオープン イノベーションの推進に貢献してきた組織です。Google は、今回の 2025 OCP EMEA Summit において、直流 48 ボルト(VDC)から新しい +/-400 VDC への電力供給の変革についてお話ししました。これにより、IT ラックを 100 kW から最大 1 MW までスケールできるようになります。また、第 5 世代の冷却水循環装置である Project Deschutes の情報を OCP に提供し、業界全体での液体冷却の推進を支援することもお伝えしました。

IT ラックあたり 1 MW で電力供給を変革

Google には、データセンターの電力供給を進化させてきた長い歴史があります。Google は 10 年ほど前に、一般的な 12 VDC ソリューションよりも電力分配の効率を大幅に向上させ、損失を減らすことを目指して、IT ラック内での 48 VDC の採用を提唱しました。業界は、このテクノロジーの共同開発を呼びかける Google の要請に応え、その結果完成したアーキテクチャは正常に機能し、IT ラックの 10 kW から 100 kW までのスケーリングを可能にしました。

AI 時代には、2 つの異なる理由から、より優れた電力供給能力が必要になります。1 つ目は、ML により 2030 年までに IT ラックあたり 500 kW 以上の電力が必要になることです。2 つ目は、各 IT ラックの高密度化です。IT ラック内のスペースは寸分余すところなく、密接に相互接続された「xPU」(GPU、TPU、CPU など)に使用されています。このため、電源コンポーネントとバッテリー バックアップを IT ラックの外に置いた、はるかに高い電圧の DC 電力分配ソリューションが必要になっています。

そこで、ラックあたり最大 1 MW に対応できる +/-400 VDC 電力供給をご紹介します。これは、単に電力供給能力を増やす以上の意味を持ちます。400 VDC を公称電圧として選択することで、電気自動車(EV)によって確立されたサプライ チェーンを活用し、スケール メリットの拡大、製造効率の向上、品質と規模の改善などを実現できます。Google は Mt Diablo プロジェクトの一環として、OCP で Meta および Microsoft と協力して、電気的および機械的なインターフェースの標準化に取り組んでいます。仕様書の第 0.5 版のドラフトを 5 月に公開し、業界のフィードバックを募る予定です。

この取り組みで最初に具体化されたのは、IT ラックから電源コンポーネントを分離する AC / DC サイドカー電源ラックです。このソリューションにより、エンドツーエンドの効率を約 3% 向上させながら、IT ラック全体を xPU に使用できるようになります。長期的には、データセンター内とラックに高電圧の DC 電力を直接分配し、電力の密度と効率をさらに高めることを検討しています。

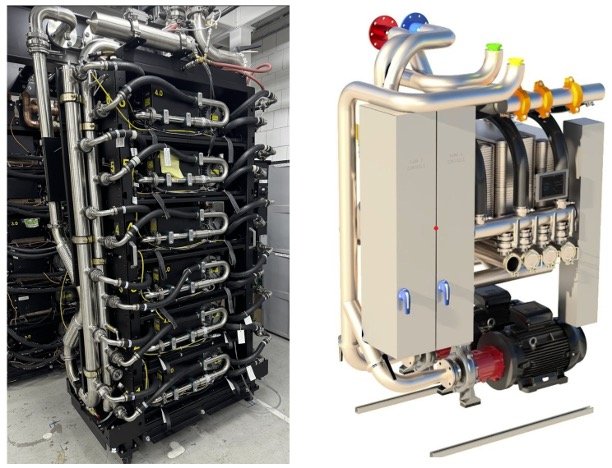

+/-400 VDC の電力供給: AC / DC サイドカー電源ラック

液体冷却の必要性

100 W のチップから 1,000 W を超えるアクセラレータまで、チップの消費電力が劇的に増加したため、高度な熱管理が不可欠になっています。より高電力のチップをラックに搭載することにより、冷却密度にも大きな課題が生じます。そこで、優れた熱特性と水力特性を備えた液体冷却が明確なソリューションとして浮上しました。水は、空気と比較して、同じ温度変化に対して単位体積あたり約 4,000 倍の熱を運ぶことができます。また、水の熱伝導率は空気の約 30 倍です。

Google は、過去 7 年間に 2,000 台以上の TPU Pod にわたって液体冷却をギガワット規模で導入し、驚異的な稼働率(一貫して約 99.999%)を実現してきました。Google が初めて液体冷却を使用したのは、2018 年に導入した TPU v3 です。液冷式 ML サーバーは、かさばるヒートシンクの代わりにコンパクトなコールド プレートを使用するため、空冷式 ML サーバーの半分近くの体積で済みます。このため、液冷式 TPU v3 スーパーコンピュータは、空冷式の TPU v2 世代と比較して、チップ密度が 2 倍、規模が 4 倍になりました。

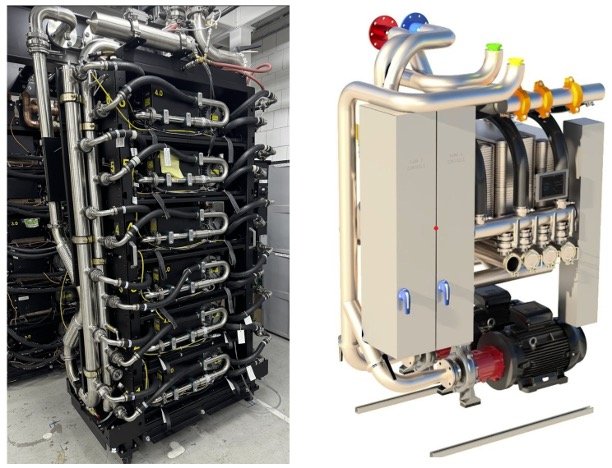

Google は、TPU v3 と TPU v4 から TPU v5、そして最新の Ironwood まで、世代を重ねてこのテクノロジーを改良し続けてきました。Google の実装では、列内の冷却水循環装置(CDU)とともに、冗長コンポーネントと無停電電源装置(UPS)を使用することで、高可用性を実現しています。これらの CDU は、ラックの液体ループを施設のループから分離し、マニホールド、フレキシブル ホース、そして高電力のチップに直接取り付けられたコールド プレートを通じて、制御された高性能の冷却システムを提供します。Project Deschutes と名付けられた Google の CDU アーキテクチャでは、ポンプと熱交換器ユニットを冗長化することで、2020 年以降、前述の CDU の可用性(約 99.999%)を一貫してフリート全体で達成しています。

現在開発中の第 5 世代の Project Deschutes CDU は、今年 OCP に提供する予定です。システムの詳細、仕様、ベスト プラクティスを含むこの貢献は、業界において広範囲で液体冷却の導入を促進することを目的としています。Google の知見は、4 世代の TPU にわたり、約 10 年かけて液体冷却を設計、導入してきた経験に基づくもので、次の内容が含まれます。

- 高い冷却性能を実現する設計

- 製造品質

- 信頼性と稼働時間

- 導入のスピード

- 優れた保守性と運用性

- サプライ エコシステムの進化

Project Deschutes CDU: 導入された第 4 世代、コンセプト段階の第 5 世代

次世代の AI に備える

電力供給と液体冷却において業界が大きな進歩を遂げたことは、Google にとって励みになっています。しかし、AI ハードウェアの開発が加速するなか、データセンターが次の段階に備えられるよう、業界全体でペースを速めなければならないことは明らかです。Google は特に、近日公開される Mt Diablo の仕様により、+/-400 VDC が業界で迅速に採用される可能性に期待しています。また、業界の皆様には、Project Deschutes CDU の設計を採用し、Google の液体冷却に関する豊富な知見を活用することを強くおすすめします。こうした進歩を受け入れ、より深いコラボレーションを促進することで、さらに大きな影響をもたらすイノベーションがこの先に待っていると信じています。

- プリンシパル エンジニア、Madhusudan Iyengar

- Google、プリンシパル エンジニア、Amber Huffman