Edge computing - un changement de paradigme qui va au-delà du cloud hybride

Joshua Landman

Customer Engineer, Application Modernization Specialist, Google

Praveen Rajagopalan

Customer Engineer, Application Modernization Specialist, Google

Essayer GCP

Les nouveaux clients peuvent explorer et évaluer Google Cloud avec des conditions exceptionnelles.

EssayerLes entreprises viennent de traverser une importante période de consolidation de leurs actifs informatiques dans le cloud ou sur leurs propres datacenters. Mais l'apparition d'appareils mobiles de plus en plus puissants et de réseaux cellulaires de plus en plus performants pousse les architectes d’applications à penser au-delà des frontières des datacenters et à se tourner vers la périphérie ou « Edge » en anglais.

Qu'entendons-nous exactement par « edge computing » ? On peut résumer le concept à une informatique distribuée exploitant une grande variété de périphériques non traditionnels, tels que des téléphones mobiles, bien entendu, mais aussi des capteurs embarqués dans des équipements d’usines, des équipements industriels ou même des capteurs pour surveiller la température ou des réactions dans un laboratoire distant. Ces dispositifs situés en périphérie ont également pour particularité d’être connectés et peuvent communiquer avec le vaisseau-mère – le système d’information central – via des réseaux sans fil ou cellulaires.

Équipés de processeurs toujours plus puissants, ces dispositifs sont amenés à effectuer des tâches qui, jusqu'à présent, ne relevaient pas de l'informatique traditionnelle : prétraitements de données entrantes dans un véhicule, collecte de vidéos dans les rayons d’un centre commercial ou de données de contrôle de la qualité à l'aide de caméras dans un entrepôt, animation de médias interactifs dans une boutique… Les entreprises s’appuient également sur le Edge pour ingérer des données provenant de postes distants ou d'appareils affublés d’une connectivité intermittente tels que des équipements agricoles ou des plateformes pétrolières. Elles peuvent ainsi filtrer les données afin d'en améliorer la qualité et d’en transformer l’information avant de les envoyer et de les traiter dans le cloud. Le résultat des traitements ainsi que les nouveaux modèles qui en découlent sont ensuite renvoyés vers le Edge. Parallèlement, les mises à jour de données de configuration, de logiciels et de médias peuvent également être transférées vers la périphérie, ce qui permet aussi de décentraliser la charge des traitements.

De fait, l’edge computing ne se résume pas à favoriser l’essor de nouveaux cas d’usage. Il permet aussi de mieux dimensionner les environnements et d’optimiser l’utilisation des ressources. Typiquement, son adoption peut contribuer à alléger la charge des traitements gérés par les datacenters.

Bien que très prometteur, l’edge computing manque toutefois encore de maturité. De plus, on ne développe pas pour le Edge comme on développe des applications traditionnelles qui bénéficient à la fois d’une connexion persistante et d’une plateforme matérielle qui ne limite pas les traitements. De fait, les architectes cloud commencent à peine à se pencher sur la question de l’edge computing et sur la façon dont ils pourraient le mettre en œuvre et l’utiliser pour en tirer avantage au sein de l’entreprise.

Fort heureusement, des outils facilitant la démarche existent déjà. Et il y a de fortes chances pour qu’ils s’intègrent aisément à l’informatique existante de votre organisation. Kubernetes en fait partie. Mais des outils de plus haut niveau, comme Anthos, peuvent également simplifier la démarche en fournissant un poste unifiant le pilotage du cloud, du datacenter privé et des sites Edge distants. D’autres composants de la famille Anthos, tels Anthos Config Management et Anthos Service Mesh, vont encore plus loin, fournissant une gestion à la fois unifiée et centralisée des déploiements sur le Edge et dans le cloud. Et ce portefolio va encore s’enrichir de nouveaux outils.

Dans la suite de ce billet, nous vous proposons de revenir plus en détail sur l’historique de l’edge computing, sur son évolution actuelle ainsi que sur ses potentiels bénéfices pour les architectes et les développeurs. Dans un prochain billet, nous reviendrons sur certains défis introduits par l’edge computing en matière de design ainsi que sur les avantages potentiels du edge pour les PME. Enfin, nous nous pencherons sur les outils Google Cloud disponibles dès aujourd'hui pour vous aider à créer votre environnement edge. Nous illustrerons notre propos par quelques exemples concrets de clients déjà bien avancés dans l’adoption de l’edge computing. Ils devraient vous permettre de réaliser ce qu’il est possible de faire dès aujourd’hui tout en stimulant votre imagination quant à ce que vous pourriez en faire demain.

Évolution de l’edge computing

L’edge computing n’est pas un concept nouveau. De fait, il existe depuis une vingtaine d’années et couvre de nombreux cas d’usage, aujourd’hui parfaitement banalisés. Typiquement, les CDN (content delivery network) ont été une des toutes premières applications du concept en mettant en cache les pages Web statiques pour rapprocher le contenu des utilisateurs et le délivrer localement. Un tel système est, par exemple, utilisé par des serveurs hébergés dans des datacenters californiens pour délivrer du contenu financier à des clients européens.

Avec l'amélioration de la connectivité et des logiciels, l’edge computing a naturellement évolué et l'accent a été mis sur l'utilisation du edge pour distribuer des services. Dans un premier temps, des services simples ont évolué de codes HTML statiques vers des bibliothèques JavaScript ou des banques d'images. D’autres fonctions courantes, comme la transformation d’images ou la validation d’adresses et de cartes bancaires, ont suivi. Très vite, les entreprises ont commencé à déployer des environnements plus complexes à base de microservices hébergés sur des installations cloudlets ou en clusters. Elles ont également commencé à utiliser des jeux de données distribués et répliqués. Le terme « endpoint » est devenu omniprésent et les API ont proliféré.

En parallèle, on assistait à une véritable explosion créative côté matériel, microcontrôleurs et dispositifs spécialement pensés pour le Edge. Des solutions dédiées ont été déployées un peu partout dans le monde.

Des services comme Google Cloud IoT Core ont étendu notre capacité à gérer et à connecter en toute sécurité ces équipements dispersés, permettant aux gestionnaires de plateformes d’embarquer des outils et d'exploiter des services managés tels que Pub/Sub et Dataflow pour l'ingestion de données.

Et avec Kubernetes, de grands clusters distants - des mini clouds privés en soi - fonctionnent comme des services capables de s’auto-réparer et de se répliquer à travers Internet pour monter en puissance, ouvrant la voie à de nouveaux modèles d'applications et d'architectures. En résumé, systèmes asynchrones distribués et marché du Edge ont fleuri de concert.

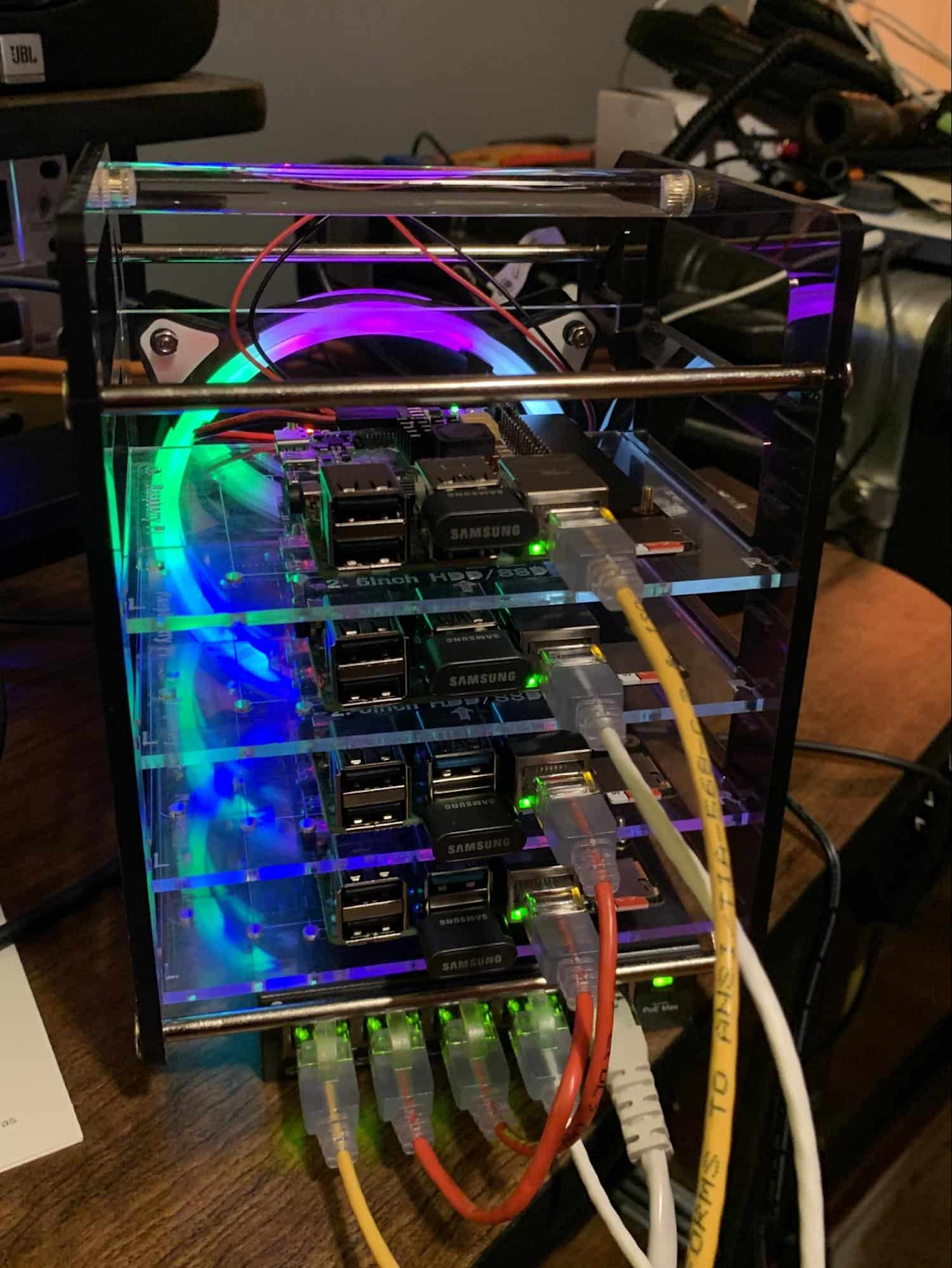

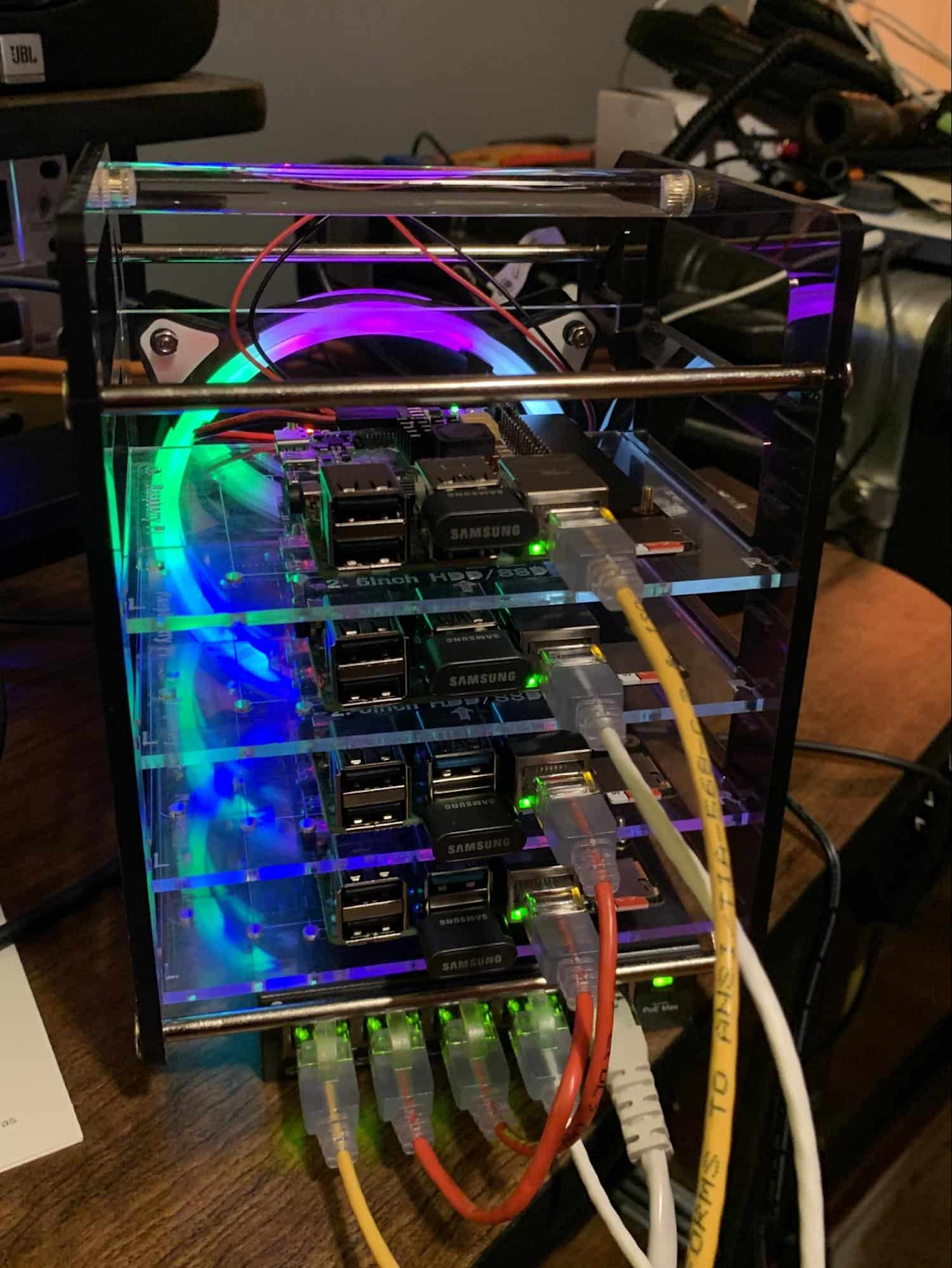

Quel impact sur les entreprises ? Dans le cadre de cette série d‘articles, l’edge computing rime avec la capacité des entreprises à étendre leur rayon d’action au-delà de leur réseau, de leurs VPCs (Virtual Private Cloud) et même de l’hybride. Le Edge d’aujourd’hui ne se situe plus dans un grand datacenter distant, dans un CDN, chez un prestataire de cloud ni même dans le rack d’un datacenter d’entreprise. Il ressemble bien davantage à une centaine d’équipements similaires à celui présenté ci-dessous, reliés à des milliers de capteurs.

Raspi K8s Cluster

En résumé, l’edge computing d’aujourd’hui signifie avoir du matériel et des équipements installés sur des sites distants capables de traiter et transférer les informations qu’ils collectent et/ou génèrent. Sans oublier le défi du management puisqu’il faut pouvoir pousser les mises à jour des logiciels, des configurations, des modèles ou encore des médias vers ces « équipements » distants lorsqu’ils sont connectés.

Favoriser l’essor de nouveaux cas d’usage

Aujourd’hui, l’Edge computing a franchi un nouveau palier. Tels les motifs d’une fractale, des micro-datacenters se déploient et se multiplient à l’infini. Ensemble, ils forment un framework étendu, géographiquement distribué, toujours disponible, pour diffuser, collecter, traiter, et distribuer des données asynchrones. Ce grand assemblage d’applications faiblement couplées vit, respire et se développe. En perpétuelle évolution, il tire des enseignements des données qu’il collecte et diffuse des modèles actualisés dès que les connexions sont opérationnelles.

Désormais, l’essor de la 5G repousse encore plus loin les limites du Edge. Les appareils équipés de 5G peuvent transmettre leurs données via le réseau mobile, autrement dit partout où l’on trouve une antenne cellulaire. Certes, ces réseaux ont une bande passante plus faible qu’une connexion fibre, mais ils sont souvent plus que suffisants pour certains types de données telles que celles de capteurs d’incendie dans les forêts bordant les villages par exemple. Nul besoin d’une folle bande passante pour périodiquement transmettre des données de température ou de monoxyde de carbone. Récemment, Google Cloud s’est associé à AT&T pour favoriser l’usage des technologies Edge 5G en entreprise.

Réduire les investissements en Datacenters

En plus de favoriser la digitalisation de nouveaux cas d’usage, l’adoption du Edge peut aussi profiter à votre datacenter existant.

Les centres de données sont coûteux à maintenir. Déplacer certains traitements du datacenter vers le Edge peut réduire vos investissements d’infrastructures dans les datacenters mais également réduire leur consommation de temps machine. Les services Edge ont tendance à nécessiter des niveaux de SLO (Service Levels Objectives) moindres par rapport à ceux des datacenters, ce qui réduit les investissements matériels. Et les installations Edge sont aussi souvent plus tolérantes aux déconnexions et fonctionnent donc parfaitement bien avec des SLOs et des coûts réduits.

À titre d’exemple, le Big Data est un des domaines où le Edge peut réellement réduire les coûts. Autrefois, nous élaborions des systèmes monolithiques en série – des machines à états – qui devaient être capables en cas de panne de savoir où ils en étaient dans le traitement. Mais nous avons constaté à maintes reprises qu’une approche plus réduite et plus distribuée permettait de décomposer de gros problèmes coûteux en petits avec une résolution plus économique à la clef.

Depuis l’essor de MapReduce, il y a environ 20 ans, les workloads Big Data ont été parallélisés sur des clusters en réseau. La gestion des états a été simplifiée grâce à la production de résultats intermédiaires qui peuvent être partagés, mis en attente ou servir à relancer un processus à partir d’un point de contrôle. Les systèmes monolithiques ont été remplacés par des clusters en réseau et des référentiels de données moins chers et plus intelligents, favorisant la parallélisation de traitements pouvant être exécutés et restitués au sein de datasets (jeux de données) exploitables.

Aujourd'hui, ces mêmes concepts sont appliqués et distribués aux points de collecte de données du Edge. Dans cette évolution des traitements Big Data, on monte en puissance (par scale-up et scale-out) jusqu’à atteindre le point de rupture à partir duquel la volumétrie des données devient si colossale qu’elle doit être préalablement filtrée avant d’être prétraitée pour la ramener à une volumétrie acceptable et exploitable. Alors et seulement alors, les données filtrées et prétraitées peuvent être injectées dans les bases centrales pour être utilisées dans des processus gourmands en ressources et dans la construction de modèles.

En résumé, la collecte, le nettoyage et même une potentielle première phase d’agrégation des données s’effectuent aujourd’hui sur le Edge, ce qui réduit d’autant la quantité de données inutiles stockées dans les onéreux entrepôts de données. L’entrepôt de données central gagne en performances. Parallèlement, la taille et les coûts des transferts de données comme de stockage sont considérablement réduits !

Le Edge représente une énorme opportunité pour les entreprises. Mais il faut relever un certain nombre de challenges pour concevoir des environnements capables de l'exploiter efficacement. Dans la deuxième partie de cette série d’articles, nous examinerons certains des défis architecturaux généralement rencontrés lors de la conception d'environnements Edge et les différentes approches que nous avons commencé à utiliser pour les relever.