Un framework pour exploiter pleinement Gemini Code Assist et mesurer son impact

S. Bogdan

Product Manager

Nathen Harvey

DORA Lead

Contraintes de livrer toujours plus vite, les équipes de développeurs sont soumises à une pression constante. En tant que partenaires de DORA research, nous nous sommes récemment penchés sur l’adoption de l’intelligence artificielle et son impact sur le cycle de vie du développement logiciel. Les résultats montrent que plus de 75 % des développeurs s’appuient déjà sur l’IA dans le cadre de leurs activités quotidiennes.

Avec Gemini Code Assist, les développeurs cherchent à gagner en efficacité et à améliorer la qualité de leur code. Mais comment adopter concrètement le codage assisté par l’IA ? Et comment mesurer l’impact réel de ces technologies sur la performance de vos équipes ?

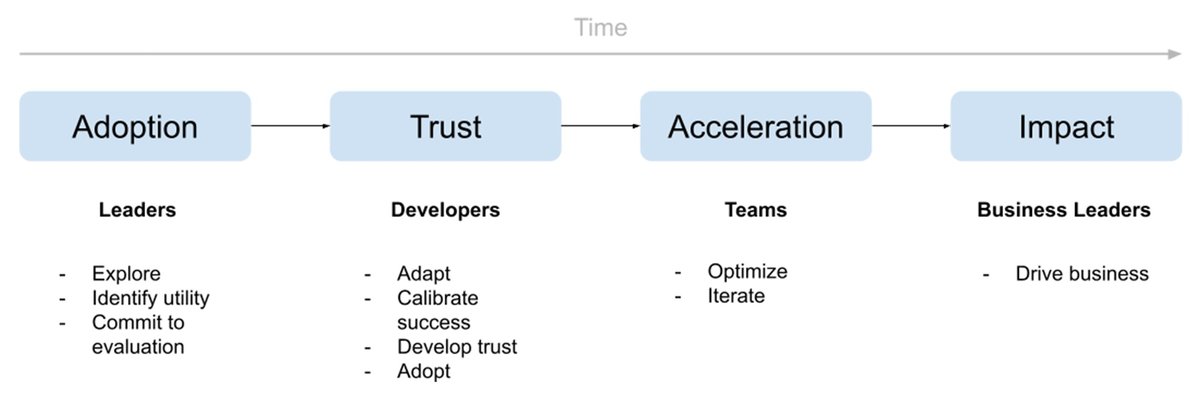

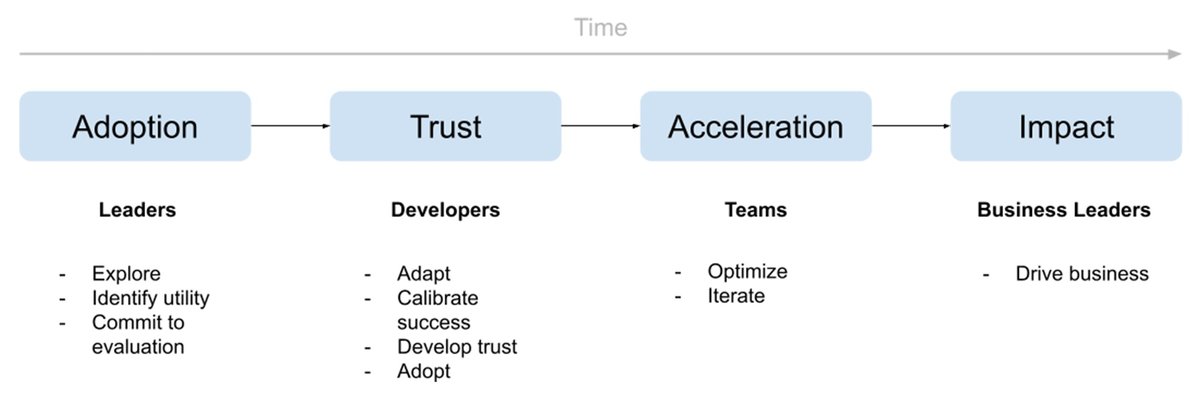

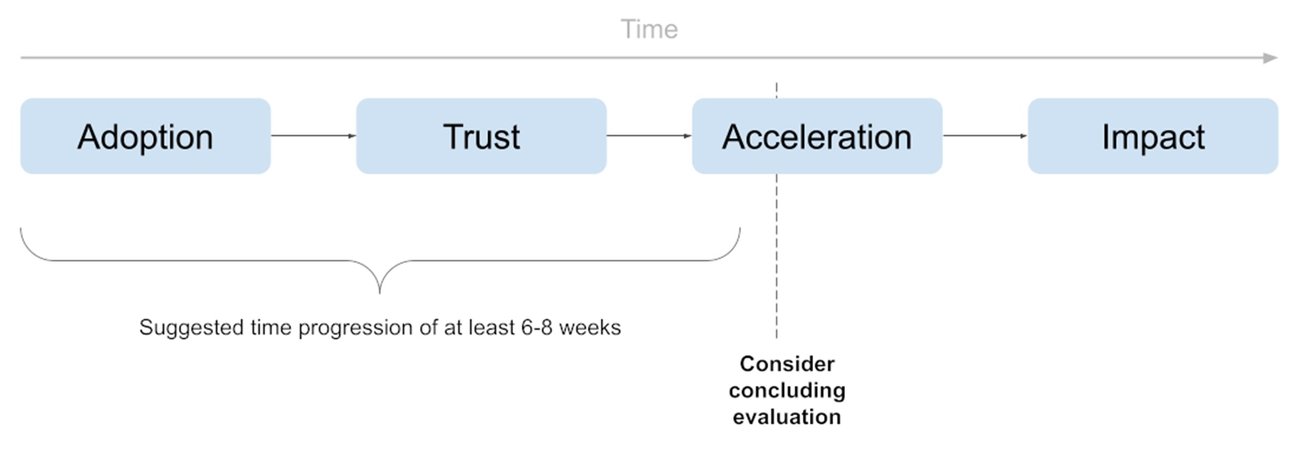

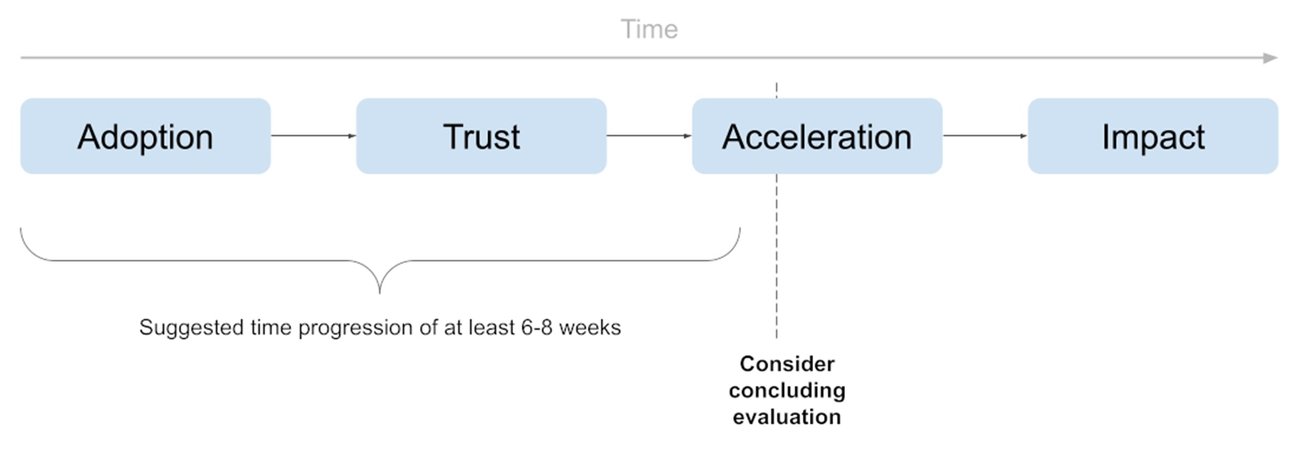

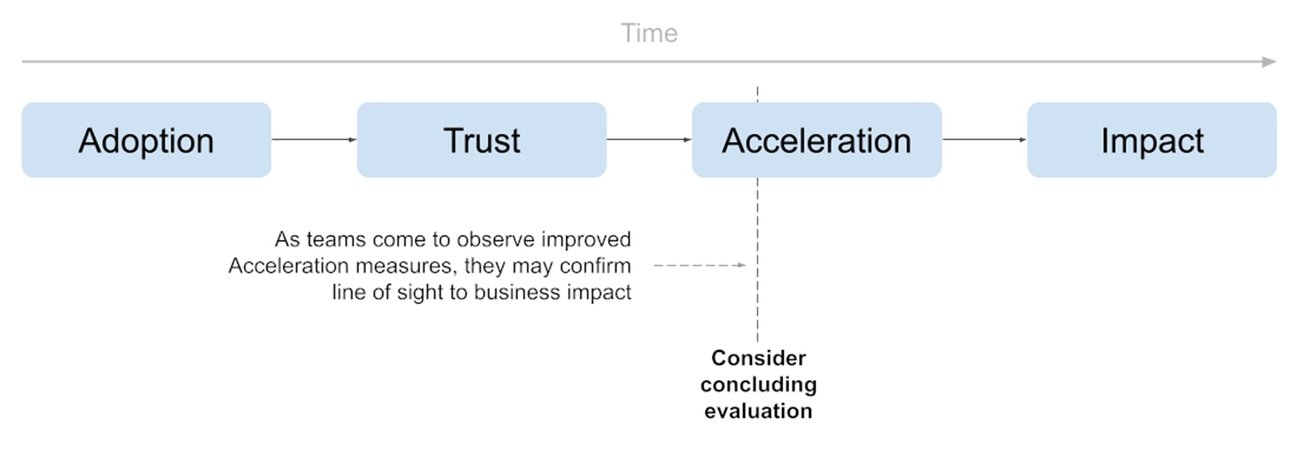

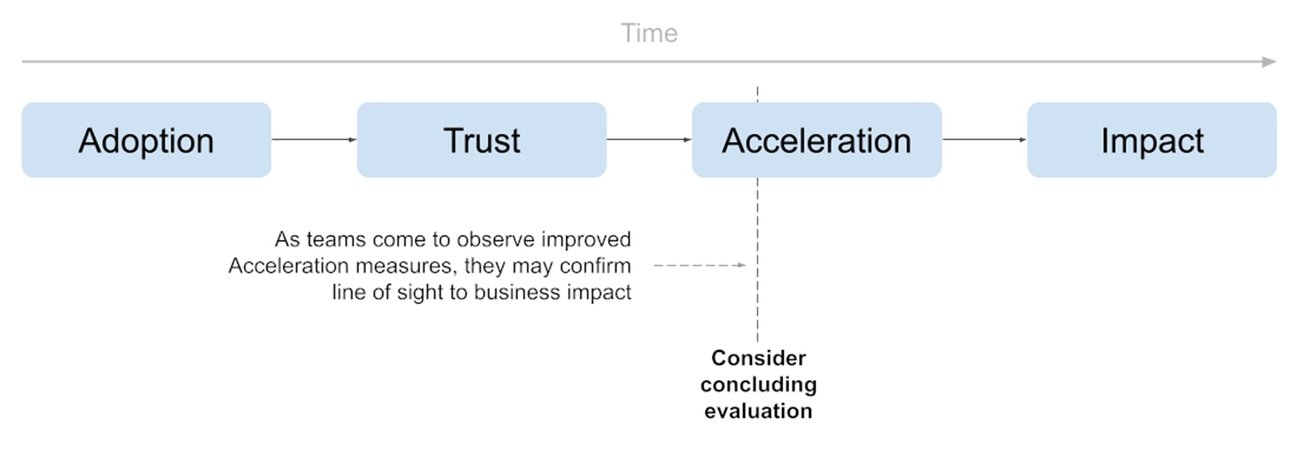

Dans cet article, nous proposons une méthode concrète, un framework, pour adopter la génération de code assistée par l’IA dans votre équipe mais plus encore en mesurer les effets dans vos processus de développement. Ce framework comporte quatre étapes :

- Adoption : vérifiez que l’outil est réellement utilisé au quotidien en suivant des indicateurs comme le nombre d’utilisateurs actifs et le volume de suggestions de code générées.

- Confiance : mesurez dans quelle mesure les développeurs font confiance aux suggestions de l’IA, à travers le taux d’acceptation des recommandations et le nombre de lignes intégrées.

- Accélération : évaluez les gains en productivité et en qualité logicielle via vos indicateurs habituels : les métriques DORA (mesures de performance des équipes DevOps), les « Story Points » de vos sprints agiles, le nombre de tickets résolus, etc.

- Impact : reliez ces gains à vos objectifs business en observant l’évolution d’indicateurs clés comme le chiffre d’affaires, la part de marché ou les délais de mise sur le marché.

Intégrer l’assistance IA : une démarche progressive

Adopter l’assistance au codage avec l’IA, c’est initier une dynamique de changement : l’équipe doit passer d’une méthodologie traditionnelle (codage sans IA) à une nouvelle façon de coder, assistée par l’IA. En d’autres termes, il faut prévoir une transition progressive.

Les quatre étapes de la montée en puissance de la productivité du codage assisté par l’IA

Ces quatre étapes structurent l’adoption de l’assistance IA dans le temps, chacune correspondant à un niveau d’usage, d’engagement et de maturité différent. Voici ce qu’elles recouvrent concrètement :

- Adoption : C’est une phase d’évaluation et de PoC (Proof of Concept) visant à identifier dans quels contextes et sur quels cas d’usage l’assistance au codage avec l’IA peut contribuer à améliorer la production des développeurs.

- Confiance : La phase où l’IA gagne la confiance des développeurs grâce à la pertinence de ses suggestions.

- Accélération : Phase où l’assistance IA commence à générer des gains concrets en efficacité, mesurés à l’aide d’indicateurs tels que les métriques DORA ou les story points.

- Impact : Validation de l’effet réel de l’assistance IA sur les indicateurs de performance business, comme le chiffre d’affaires, la part de marché ou le time-to-market.

Au-delà du rôle de chaque phase, il est essentiel de comprendre comment chaque acteur y contribue. Les responsables techniques et leaders business jouent souvent un rôle moteur dans les phases d’adoption (en lançant les premières évaluations) et les phases d’impact (en confirmant les résultats obtenus). Entre ces deux étapes, ce sont les développeurs qui explorent activement l’outil, testent ses fonctionnalités, apprennent à l’utiliser et commencent à l’intégrer à leur quotidien (confiance). Pendant cette phase, il est essentiel de laisser le temps aux développeurs d’explorer librement les possibilités offertes par l’outil pour en tirer le meilleur parti. À mesure que la confiance s’installe, les développeurs commencent à partager leurs retours, affinent leurs usages et font évoluer leurs pratiques ensemble : la phase d’accélération peut commencer.

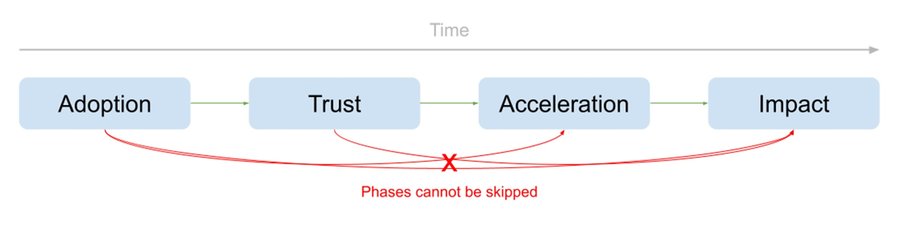

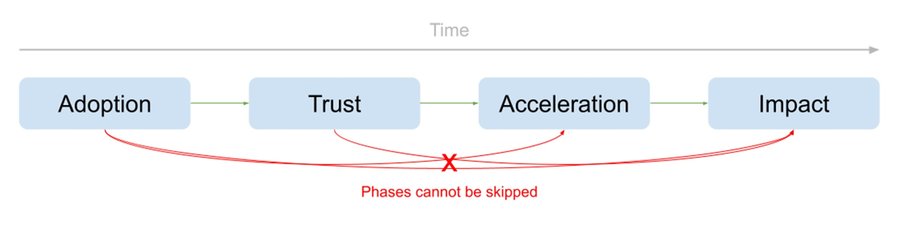

Les quatre étapes s’inscrivent dans une progression logique : chacune alimente la suivante, et aucune ne peut être court-circuitée.

L’une des erreurs fréquentes des organisations consiste à croire que l’usage d’un assistant de codage basé sur l’IA (phase d’adoption) produira immédiatement des résultats business tangibles (phase d’impact). Autrement dit, elles imaginent pouvoir passer directement de l’adoption à l’impact, en faisant l’impasse sur les étapes de Confiance et d’Accélération. Si les organisations ne s’engagent pas résolument dans l’Adoption des outils d’assistance IA, et si elles ne laissent pas le temps à la Confiance de s’installer, il est illusoire d’espérer une amélioration sensible de la productivité (Accélération) — et a fortiori un véritable Impact business.

Un délai de 6 à 8 semaines est généralement nécessaire pour valider l’adoption et instaurer la confiance

Une autre idée reçue consiste à croire que l’adoption d’un assistant IA au codage produira des effets immédiats. Chaque organisation est différente, mais notre expérience montre qu’il faut généralement au moins 6 à 8 semaines — soit l’équivalent de quatre sprints de deux semaines — avant de pouvoir observer un réel impact sur la productivité (phase d’accélération). Comme chaque étape alimente la suivante, il faut du temps pour que les effets de l’adoption de l’IA se diffusent dans l’organisation. Ce facteur temps est particulièrement important à prendre en compte lorsqu’on entre en phase d’évaluation, nous y reviendrons plus loin.

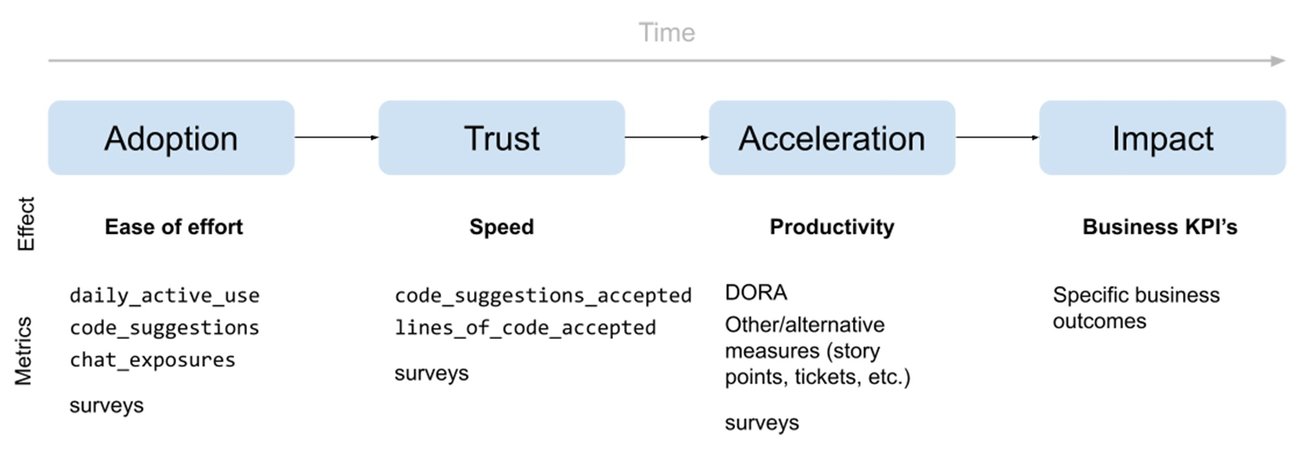

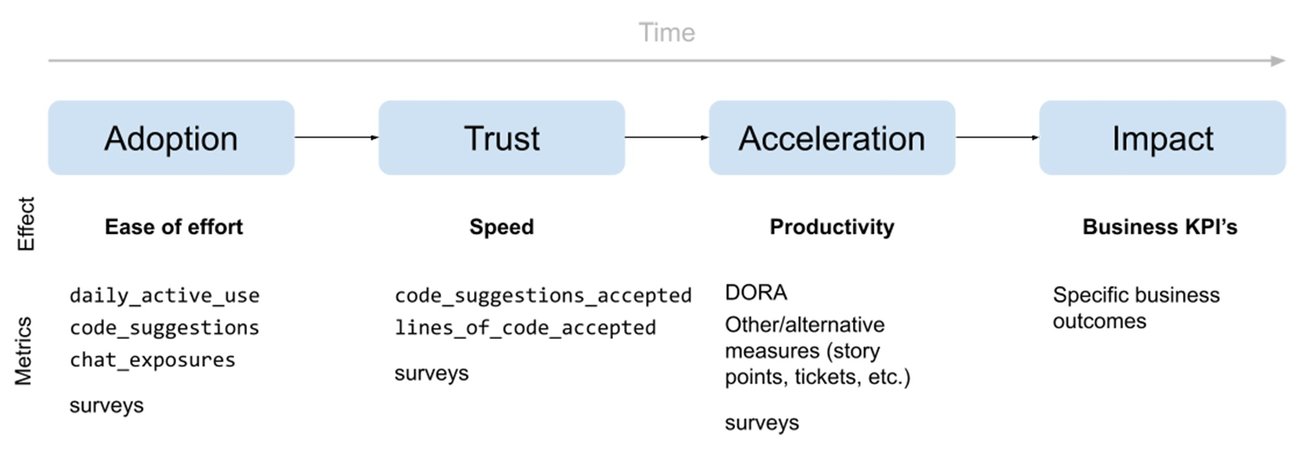

Effets attendus et indicateurs associés à chaque phase

Même si elles sont conceptuelles, ces quatre phases d’adoptions peuvent être mesurées pour valider à la fois la progression du parcours et l’impact. Voici comment et quand utiliser ces mesures :

- Adoption. Les premières mesures à surveiller sont : le volume d’activité quotidienne (utilisation de l’assistance IA par les développeurs), le nombre de suggestions de code générées par l’IA et le volume d’interactions via le chat (demandes formulées à l’IA). Ces indicateurs permettent de vérifier si les développeurs commencent réellement à tirer parti de l’outil, l’objectif étant de confirmer un engagement quotidien régulier et en croissance.

Lorsque l’adoption s’ancre dans les usages, vous pouvez alors porter votre attention sur la confiance. - Confiance. Les développeurs qui adoptent l’outil acceptent-ils réellement l’aide de l’IA ? Pour le mesurer, vous pouvez vous appuyer sur les indicateurs suivants : nombre de suggestions de code acceptées (suggestions générées par l’IA acceptées), taux d’acceptation (nombre de suggestions acceptées divisé par le total des suggestions proposées) et le nombre de lignes de code issues de l’IA intégrées dans le code final. Des taux d’acceptation faibles doivent vous alerter et vous pousser à analyser les causes du manque de confiance. Des entretiens avec les développeurs ou des enquêtes ciblées peuvent apporter un éclairage complémentaire (voir nos exemples de questions).

- Accélération. Vous disposez peut-être déjà d’indicateurs de productivité des développeurs, à commencer par les métriques DORA liées à la performance de livraison logicielle. Vous pouvez également suivre le nombre de story points réalisés ou de tickets clôturés sur une période donnée, par exemple. Une fois l’adoption et la confiance établies, le suivi de ces métriques sur l’Accélération permet de confirmer les bénéfices concrets de l’aide de IA sur la productivité tout en offrant une visibilité sur les impacts métier potentiels.

- Impact. Dernière étape : la traduction des gains en indicateurs business. Ces KPI varient selon les organisations et doivent être suivis par les décideurs pour évaluer la valeur générée par l’IA. Parmi les indicateurs classiques, on trouve notamment le chiffre d’affaires, les parts de e marché, le time-to-market (délai de mise à disposition d’une amélioration produit) ou encore des critères de performance globale. Une amélioration observée dans la phase d’accélération est en principe un signal positif pour les indicateurs d’impact business.

Attention : ne confondez pas les indicateurs des phases d’adoption et de confiance — qui mesurent l’usage, pas la productivité — avec les véritables indicateurs portant sur la productivité, utilisés dans la phase d’accélération. De fait, un taux élevé d’acceptation des suggestions IA ou un grand nombre de lignes de code générées par l’IA ne constituent pas, en soi, une preuve de gain de productivité : si ces résultats s’accompagnent d’une dégradation des métriques DORA ou d’une baisse du rythme de clôture des tickets, il n’y a aucune amélioration réelle de la productivité. Raison pour laquelle la distinction entre les indicateurs d’usage et de productivité est essentielle. Les métriques associées à l’usage permettent de mesurer l’Adoption et la Confiance. Les métriques de productivité permettent de mesurer les effets de cette adoption. Et seuls les indicateurs d’impact permettent d’évaluer les bénéfices à l’échelle de l’organisation.

Avec un parcours clairement défini, des phases structurées et des indicateurs associés à chaque étape, vous disposez désormais d’un cadre de référence, d’un framework, pour piloter l’adoption de l’assistance IA au codage, en suivre la progression, et en démontrer concrètement les résultats.

Mesurer l’impact avec Gemini Code Assist

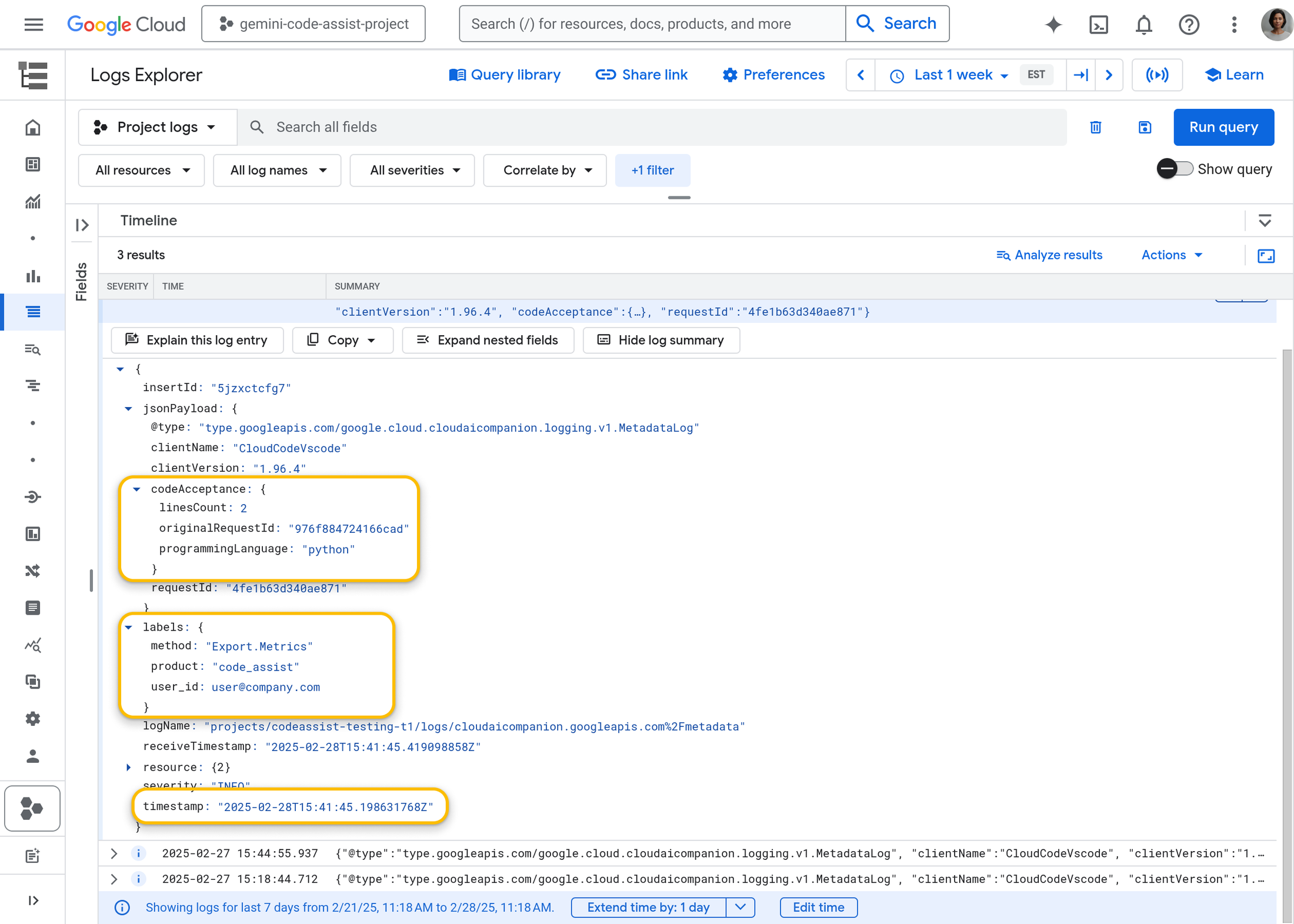

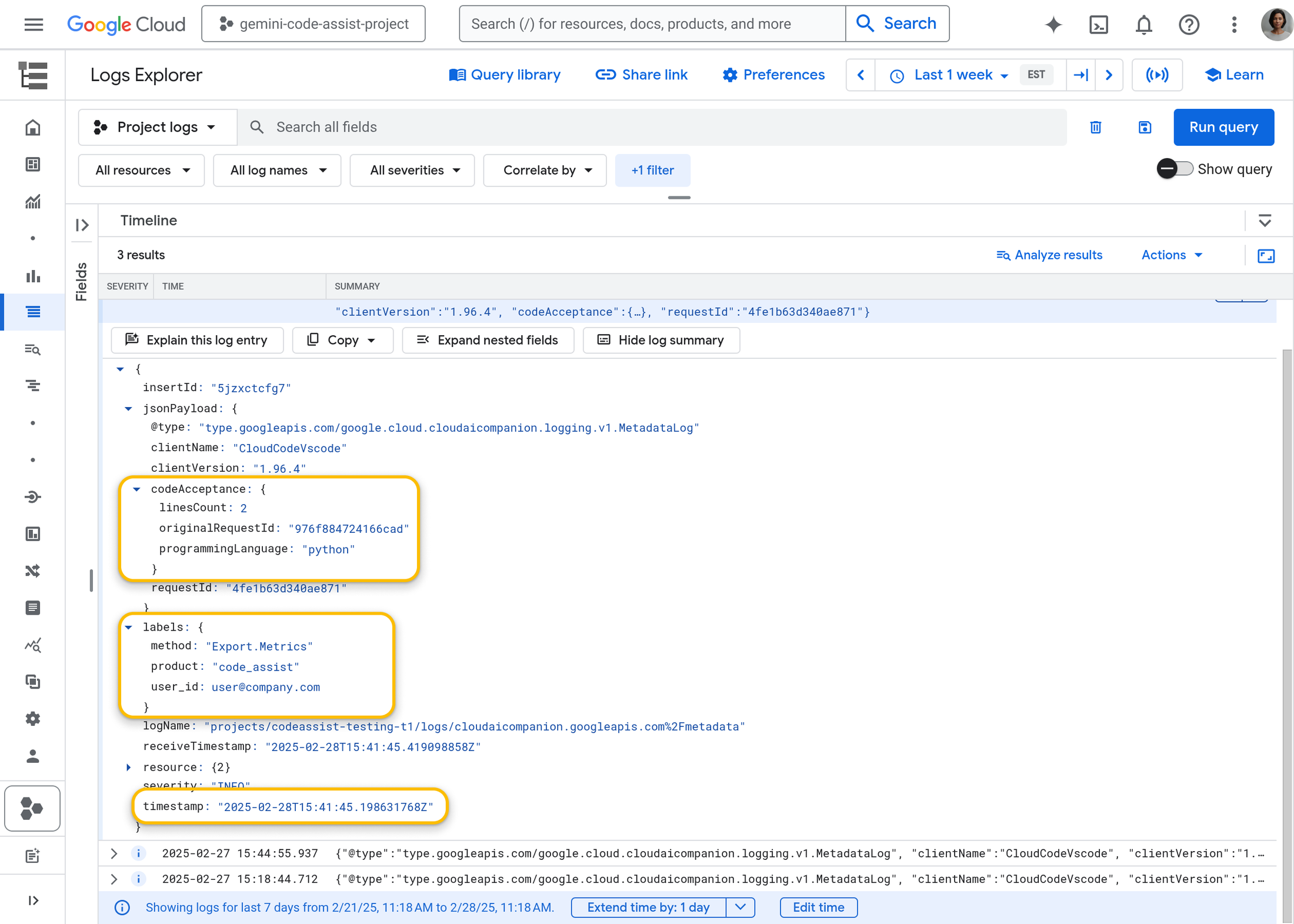

Gemini Code Assist permet de suivre les phrases d’Adoption et de Confiance grâce aux journaux de log « Gemini pour Google Cloud », disponibles en version Preview. Ces journaux permettent d’obtenir des métriques clés sur les usages, les suggestions de code générées, les suggestions acceptées, le taux d’acceptation, les interactions via le chat et les lignes de code acceptées. Les données sont granulaires, segmentées par utilisateur, langage de programmation, IDE utilisé et plage horaire. Ce niveau de détail est rarement proposé par les solutions d’assistance IA au codage. Essentielles, ces informations permettent pourtant non seulement de suivre la progression globale de l’organisation dans son parcours d’adoption, mais aussi de répondre à des questions précises, comme : « Combien de lignes de code assistées par l’IA avons-nous acceptées la semaine dernière ? Par langage ? Par développeur ? »

Les journaux de Gemini Code Assist fournissent des insights détaillés sur l’activité, notamment le volume de suggestions proposées et acceptées, segmentées par langage de programmation, utilisateur et période.

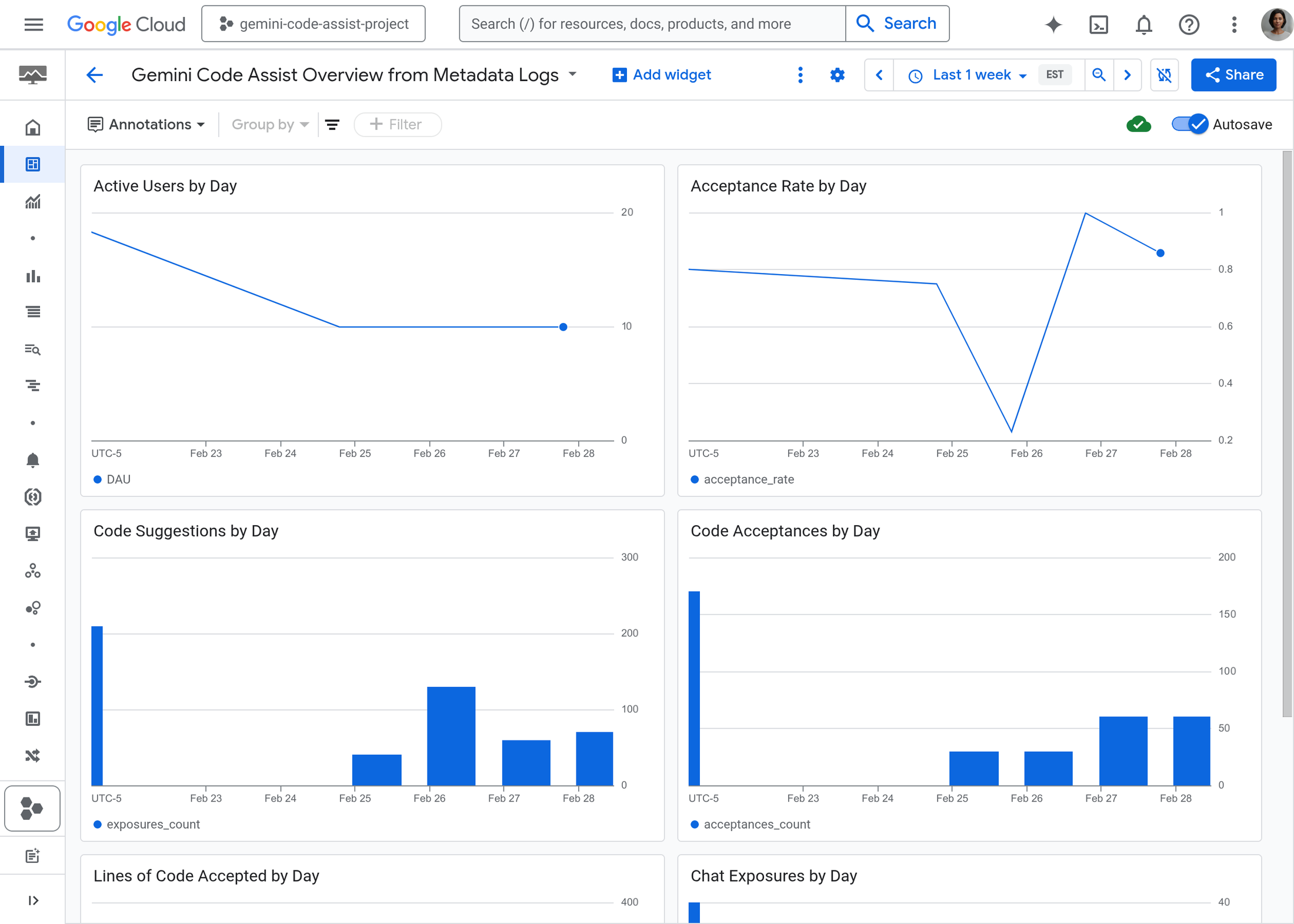

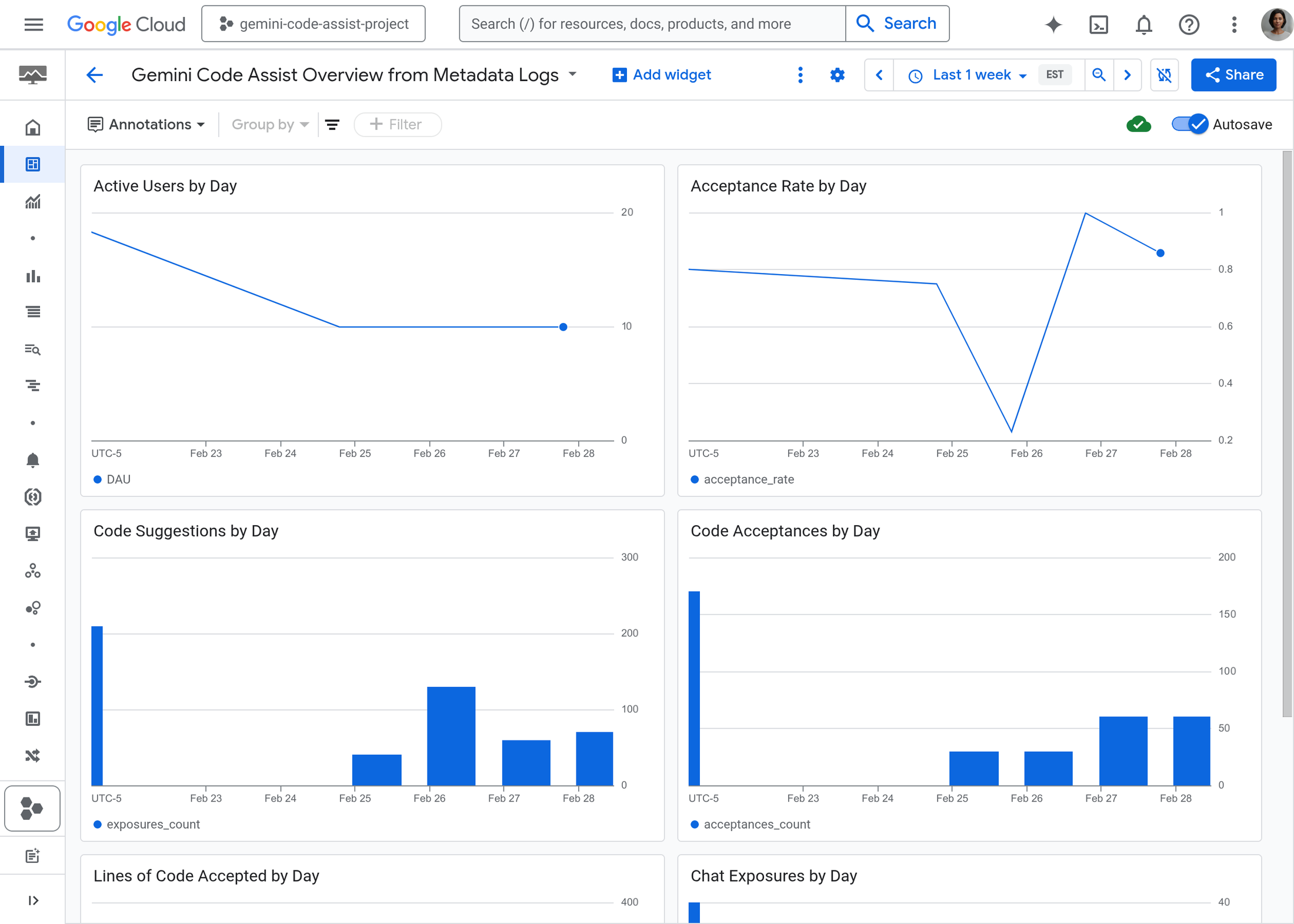

Les journaux de Gemini Code Assist offrent une vue détaillée des activités individuelles. Nous proposons aussi un tableau de bord construit avec Log Analytics pour faciliter le suivi agrégé des indicateurs d’Adoption et de Confiance.

Exemple de tableau de bord des mesures Gemini Code Assist, basé sur Log Analytics

En complément, des métriques Cloud Monitoring sont également disponibles (en version Preview) pour suivre l’utilisation de Gemini pour Google Cloud, Gemini Code Assist compris.

Mettre en place une phase d’évaluation

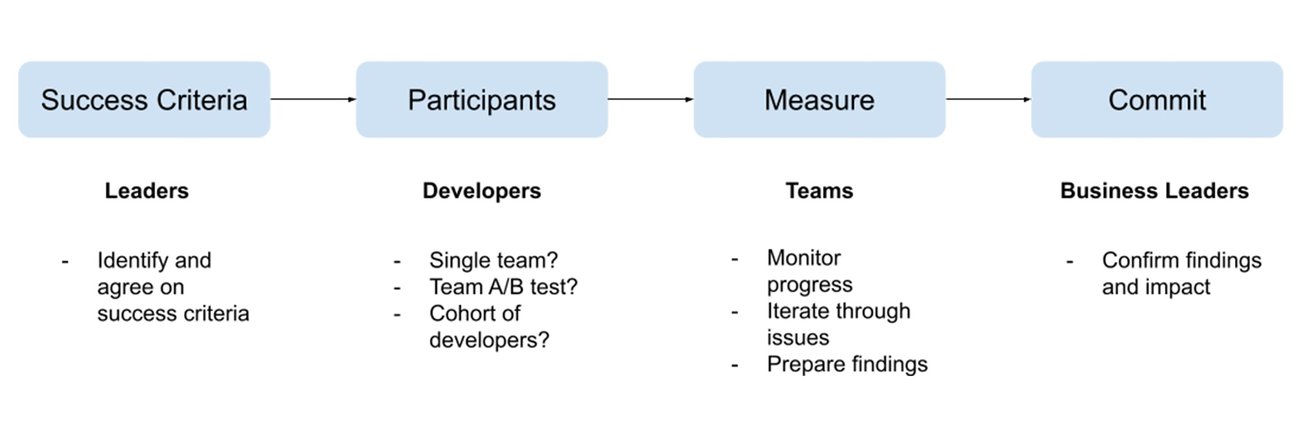

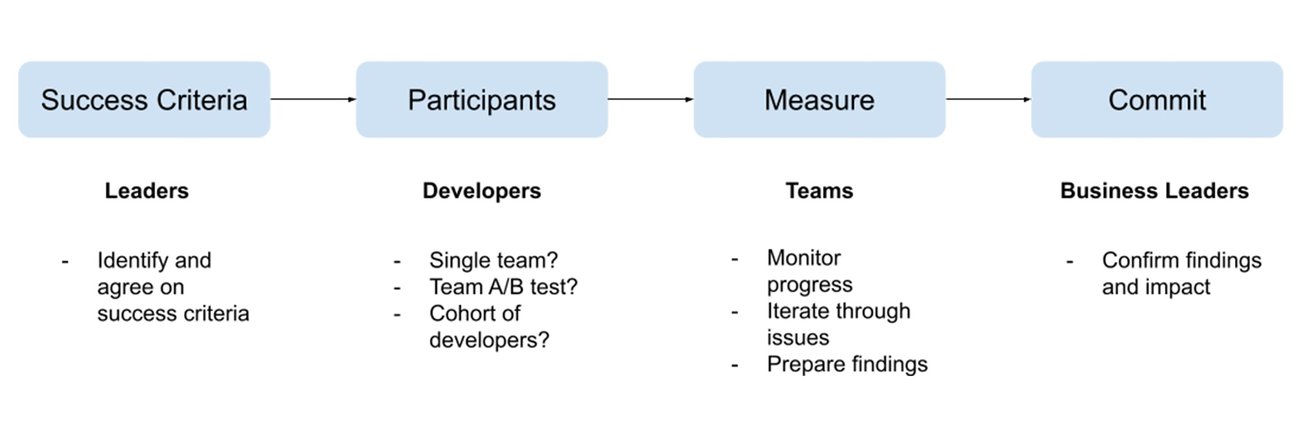

Les quatre étapes de l’évaluation de l’impact de l’assistance IA

Avant de s’engager pleinement sur l’assistance au code par l’IA, de nombreuses organisations choisissent de commencer par une phase d’évaluation. À l’image du parcours d’adoption, cette phase peut, elle aussi, être structurée en étapes successives, chacune impliquant des parties prenantes spécifiques. Comme précédemment, chaque étape alimente la suivante, aucune ne pouvant être court-circuitée.

Critères de succès. Avant de lancer l’évaluation, il est indispensable de définir clairement les critères de réussite. Ces critères doivent être définis conjointement par les équipes de développement et les décideurs métier. Les critères de succès peuvent, par exemple, inclure une amélioration des indicateurs de la phase d’Accélération (métriques DORA, rapidité d’exécution des story points, nombre de tickets résolus, etc.). Cette étape est souvent négligée, alors qu’elle est fondamentale : sans critères de réussite définis dès le départ, il est très difficile d’évaluer l’impact de l’assistance IA a posteriori. Or, c’est une erreur que nous observons régulièrement sur le terrain.

Participants. La sélection des participants à l’évaluation est une étape tout aussi essentielle et qui mérite beaucoup d’attention. Plusieurs configurations d’évaluation sont possibles, mais deux approches reviennent le plus souvent :

- travailler avec une seule équipe, en comparant deux projets réalisés successivement — l’un avec l’assistance IA, l’autre sans ;

- constituer deux groupes distincts dans une logique de test A/B — l’un utilisant l’assistance IA, l’autre non.

Quelle que soit l’option retenue, il est essentiel de définir clairement, dès le départ, qui participe à l’évaluation et pour quelles raisons. L’enjeu est de garantir une comparaison fiable, basée sur des critères « justes ». Par exemple, si l’équipe A (avec IA) est nettement plus expérimentée que l’équipe B (sans IA), l’évaluation sera biaisée avec le risque de tirer des conclusions erronées sur l’impact réel de l’IA.

Mesurer. Le parcours d’adoption de l’assistance IA peut servir de fil conducteur pour organiser et suivre l’évaluation. Des mesures à la fois quantitatives (métriques, journaux) et qualitatives (retours, enquêtes) doivent être croisées aux critères de succès (définis lors de la première phase) pour s’assurer que l’évaluation progresse dans la bonne direction.

Conclure. Si les critères de succès ont été fixés et suivis tout au long de l’évaluation, l’organisation est alors en mesure de confirmer ou non les avantages apportés par l’assistance IA, en fonction des résultats obtenus.

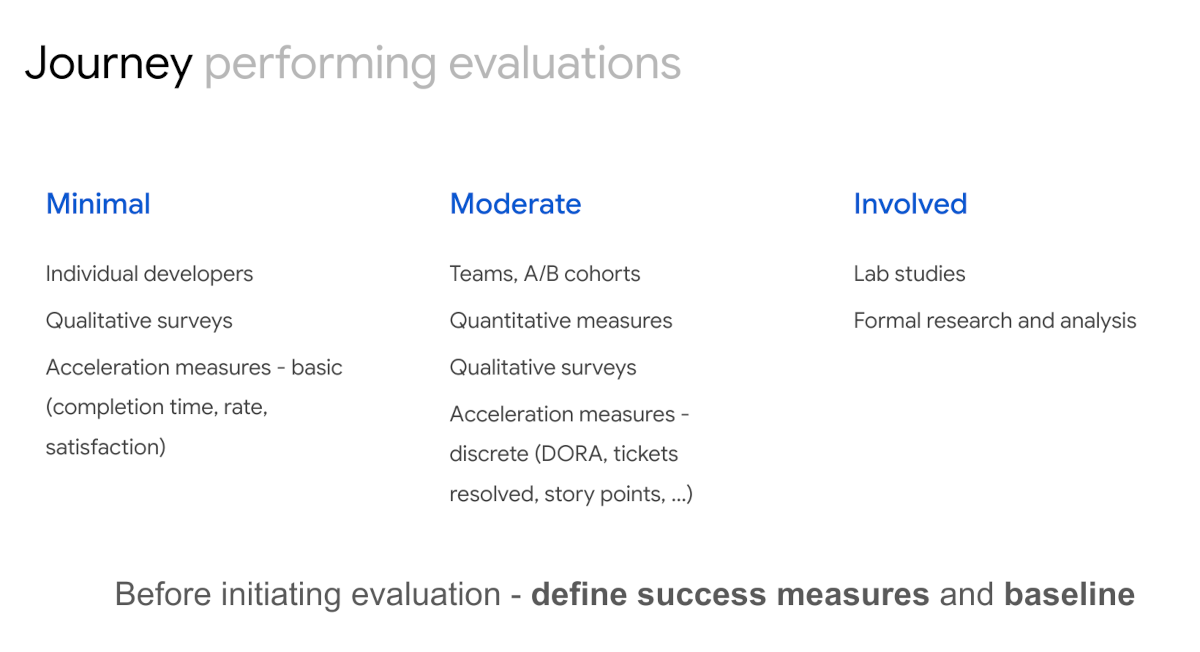

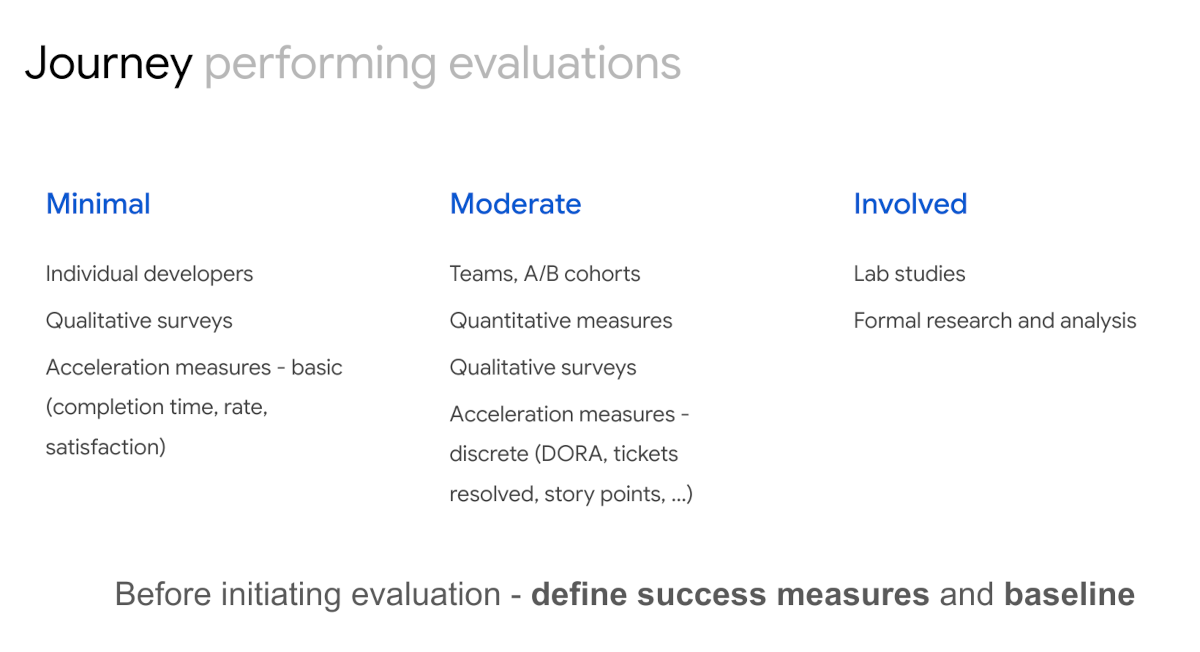

Les différents niveaux d’investissement dans l’évaluation

Le niveau d’investissement dans une évaluation de l’assistance IA au développement peut varier selon les objectifs visés. L’approche Minimale mobilise généralement un petit groupe de développeurs, s’appuie sur quelques enquêtes qualitatives et se limite au suivi d’indicateurs d’accélération de base. Dans la majorité des cas, les organisations optent plutôt pour un niveau Modéré, combinant des mesures quantitatives et qualitatives. Ce type d’évaluation repose le plus souvent sur l’une des deux méthodes suivantes :

- une même équipe effectue deux développements successifs, l’un avec l’assistance IA, l’autre sans ou deux

- deux équipes comparées en parallèle (test A/B), l’une utilisant l’assistance, l’autre non.

Le niveau d’évaluation Approfondi — plus rare — repose sur des protocoles de recherche formels, des études en environnement de test, et des analyses approfondies. Ce format reste peu courant dans la pratique.

Quelle que soit la démarche choisie, nous insistons de nouveau sur la nécessité de définir en amont les critères de succès et de collecter des données de référence pour pouvoir mesurer objectivement les résultats.

L’évaluation peut être finalisée dès lors qu’une amélioration des indicateurs d’accélération est constatée.

Lors de la définition des critères de succès, il est important de viser un seuil pertinent permettant de valider l’impact de l’assistance IA. Dans de nombreux cas, une amélioration des indicateurs de productivité associés à la phase d’accélération constitue un signal clair de l’effet positif sur les indicateurs business de la phase d’impact (KPI métiers). À l’inverse, fixer un critère de réussite trop ambitieux ou complexe à mesurer risque de retarder, voire d’empêcher, l’identification rapide des bénéfices de l’assistance IA.

Lancez-vous !

Prêt à adopter l’assistance IA pour vos développements ? Pour en savoir plus sur Gemini Code Assist, consultez notre page produit, la documentation et le guide pour démarrer rapidement.

Ressources complémentaires

- Vous pouvez vous appuyer sur les enseignements du rapport DORA 2024 concernant l’impact de l’assistance IA dans le codage, ainsi que sur les travaux de recherche de Google.

- Les métriques de performance de livraison logicielle définies par DORA sont d’excellents indicateurs pour évaluer les phases d’accélération et d’impact de votre parcours d’adoption.

Si vos équipes ne les suivent pas encore, vous pouvez utiliser DORA Quick Check pour mesurer leur niveau de performance actuel. - Par ailleurs, les recherches DORA montrent aussi que de nombreuses pratiques contribuent à l’amélioration des performances de la livraison logicielle. La mesure de ces pratiques peut alimenter les phases d’Adoption et de Confiance, tout en servant d’indicateurs avancés pour les étapes suivantes du parcours.

Enfin, des enquêtes ciblées (voir exemples) peuvent enrichir l’évaluation qualitative de l’adoption de l’IA et permettre de focaliser vos efforts sur les axes d’amélioration souhaités : performance de livraison, qualité de la documentation, durée des revues de code, fluidité des workflows ou centrage utilisateur.