Les nouveautés liées à l’infrastructure data cloud unifiée de Google Cloud

Bruno Aziza

Head of Data & Analytics, Google Cloud

Google compte parmi ses clients de nombreuses entreprises qui se distinguent par leur capacité à innover. Beaucoup d’entre elles se sont tournées vers Google Cloud afin de bénéficier de notre expertise reconnue dans le domaine de l’analyse de données et de l’IA.

Au fil de notre collaboration avec ces entreprises bien avancées sur l’exploitation de la donnée, nous avons constaté que la majorité partageait des priorités similaires : éliminer les obstacles liés à la complexité des données, faire émerger de nouveaux cas d’usage et maximiser l’impact de la donnée tout en démocratisant son accès au plus grand nombre.

Pour innover, ces entreprises qui bousculent leur marché s’appuient sur une infrastructure data cloud qui permet à leurs collaborateurs d’avoir accès à tout type de données, provenant de n’importe quelle source quelle que soit sa taille. Et ce, sans limite de capacité et avec des performances optimales. Ce data cloud permet également aux collaborateurs de passer facilement d’un workload à l’autre, en toute sécurité, et avec une configuration d’infrastructure minimale, qu’il s’agisse de basculer de SQL à Spark, de la BI (Business Intelligence) au ML (Machine Learning). Autrement dit, ces entreprises s’appuient sur un data cloud pour donner naissance à un écosystème de données ouvert, socle indispensable pour créer des services que les collaborateurs, les clients et les partenaires utilisent afin de prendre des décisions à même de changer la donne.

Le 11 octobre prochain, à l'occasion du Google Cloud Next '22, vous pourrez découvrir les nouvelles fonctionnalités de notre data cloud. Elles ont été spécialement conçues pour répondre aux attentes des entreprises qui souhaitent mettre en place cette approche moderne de la donnée. Si vous n’êtes pas encore inscrit aux sessions Data Cloud, réservez votre place dès aujourd’hui !

Je suis toutefois convaincu que les passionnés de data n’auront pas la patience d’attendre. C’est pourquoi je vous propose de découvrir en avant-première certaines des dernières innovations apportées à notre data cloud. La plupart sont disponibles dès à présent. Considérez-les comme un hors-d'œuvre en attendant le foisonnant festin qui vous sera proposé le 11 octobre.

Supprimer les barrières, obtenir des analyses en temps réel et ouvrir les écosystèmes

Les données dont vous avez besoin sont rarement stockées dans un seul endroit. Le plus souvent, elles sont éparpillées entre plusieurs sources et dans différents formats. Des mécanismes d’échange entre ces différentes sources ont été mis en place il y a déjà plusieurs années, voire des décennies. Mais les résultats sont plutôt mitigés. L’approche traditionnelle suppose en effet des déplacements de données d’autant plus laborieux qu’ils sont complexifiés par des problématiques de sécurité et de réglementations.

Cette situation nous a conduits à concevoir Analytics Hub. Disponible à tous dès à présent, cette solution se concrétise sous la forme d’une plateforme de partage de données, utilisée par les équipes et les organisations qui veulent réaliser des échanges sécurisés et fiables en interne comme avec l’extérieur de l’entreprise.

Cette innovation permet non seulement de conserver et de partager un large éventail de jeux de données prêts pour l’analyse mais également de les combiner aux jeux de données uniques proposés par Google, tels que Google Search Trends ou encore notre graphe de connaissances Data Commons.

Analytics Hub fait partie intégrante de BigQuery. Autrement dit, vous pouvez l’essayer gratuitement en passant par BigQuery, sans avoir à saisir de données de paiement.

Analytics Hub n’est évidemment pas le seul moyen que nous proposons pour simplifier l'intégration de données à des fins analytiques. Nous avons en effet récemment annoncé une solution pour extraire, charger et transformer des données en temps réel dans BigQuery : le nouveau type d’abonnement Pub/Sub "BigQuery Subscription". Cette innovation apportée à l’ETL simplifie la mise en place de workloads d’ingestion en continu (streaming). Plus facile à mettre en œuvre, cette solution est aussi plus économique car vous n’avez plus besoin d’exécuter de nouveaux traitements pour déplacer vos données et vous n’avez plus à payer pour l’ingestion en continu dans BigQuery.

Dans un monde où de plus en plus d’entreprises cherchent à réconcilier des informations réparties entre différents datalakes, entrepôts, clouds et formats de fichiers, l’approche traditionnelle pour dé-siloter les données peut s’avérer coûteuse, risquée, et difficile à passer à l’échelle.

Afin de les accompagner dans leur démarche, nous avons lancé BigLake, un nouveau moteur de stockage qui étend les nouveautés apportées à BigQuery aux formats de fichiers ouverts, stockés sur les « objects store » de clouds publics.

BigLake permet aux clients de créer aisément des datalakes sécurisés à partir de formats de fichiers ouverts. Il propose aussi des contrôles de sécurité fins et cohérents que ce soit pour Google Cloud ou pour des moteurs de requête open-source. La configuration de la sécurité est donc centralisée à un seul endroit et appliquée partout.

Des clients comme Deutsche Bank, Synapse LLC et Wizard ont eu l’occasion d’exploiter BigLake avant sa sortie. Cette solution est depuis peu accessible à tous. Je vous invite à découvrir dès à présent comment BigLake peut vous aider à construire votre propre écosystème de données.

Simplifier l’exploitation de la donnée

Quand les données sont hétérogènes et éparpillées entre des sources très variées, les entreprises ont généralement du mal à innover car leurs collaborateurs doivent sans cesse changer d’outils en fonction de la tâche à réaliser.

C’est un problème récurrent rencontré en Machine Learning, où les interfaces ML diffèrent généralement de celles utilisées pour la BI. Mais ce n’est pas le cas avec BigQuery ML : les clients ne sont pas freinés dans leur capacité à innover car les fonctionnalités ML sont intégrées à BigQuery (et non pas en option comme dans bien des solutions du marché).

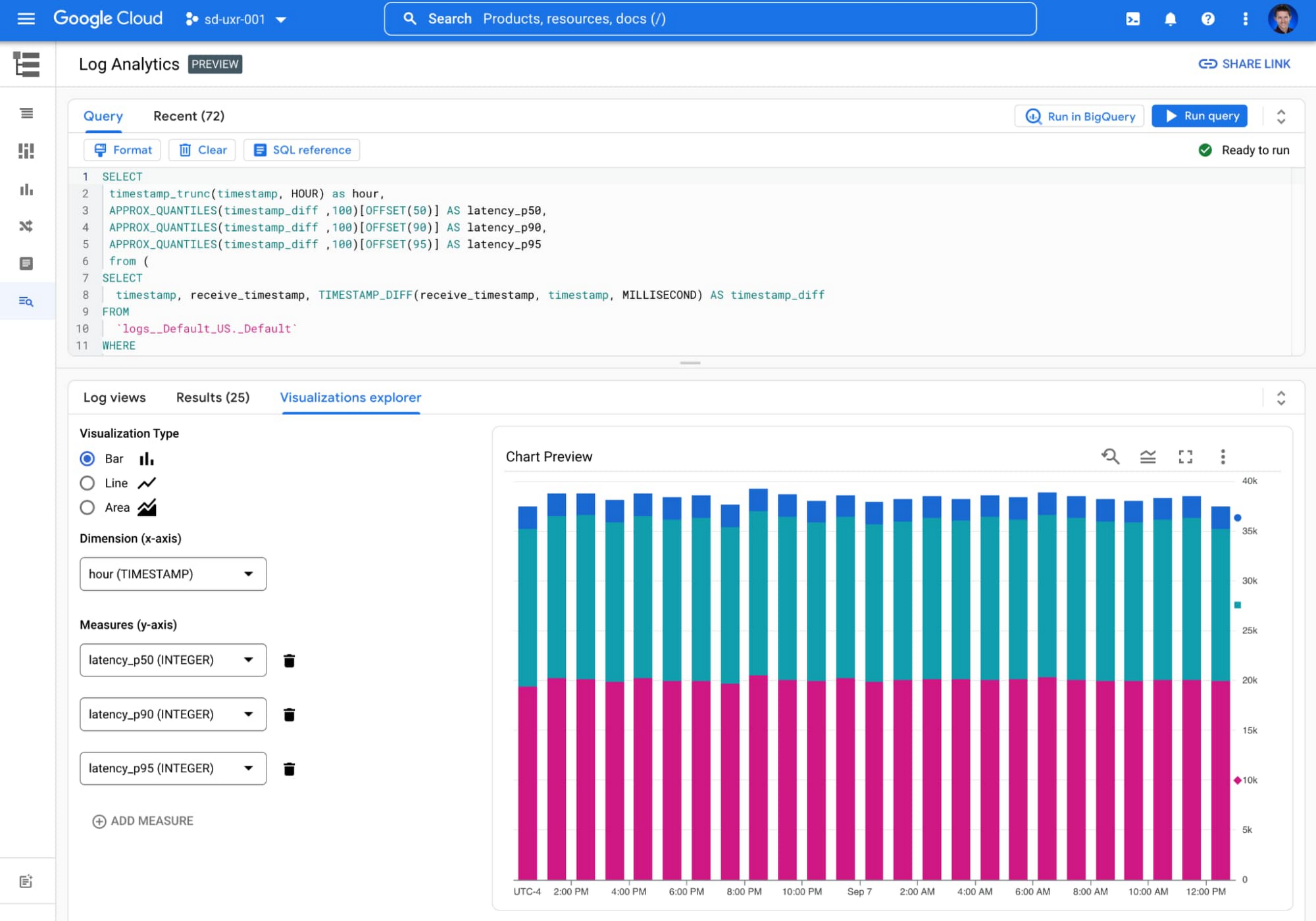

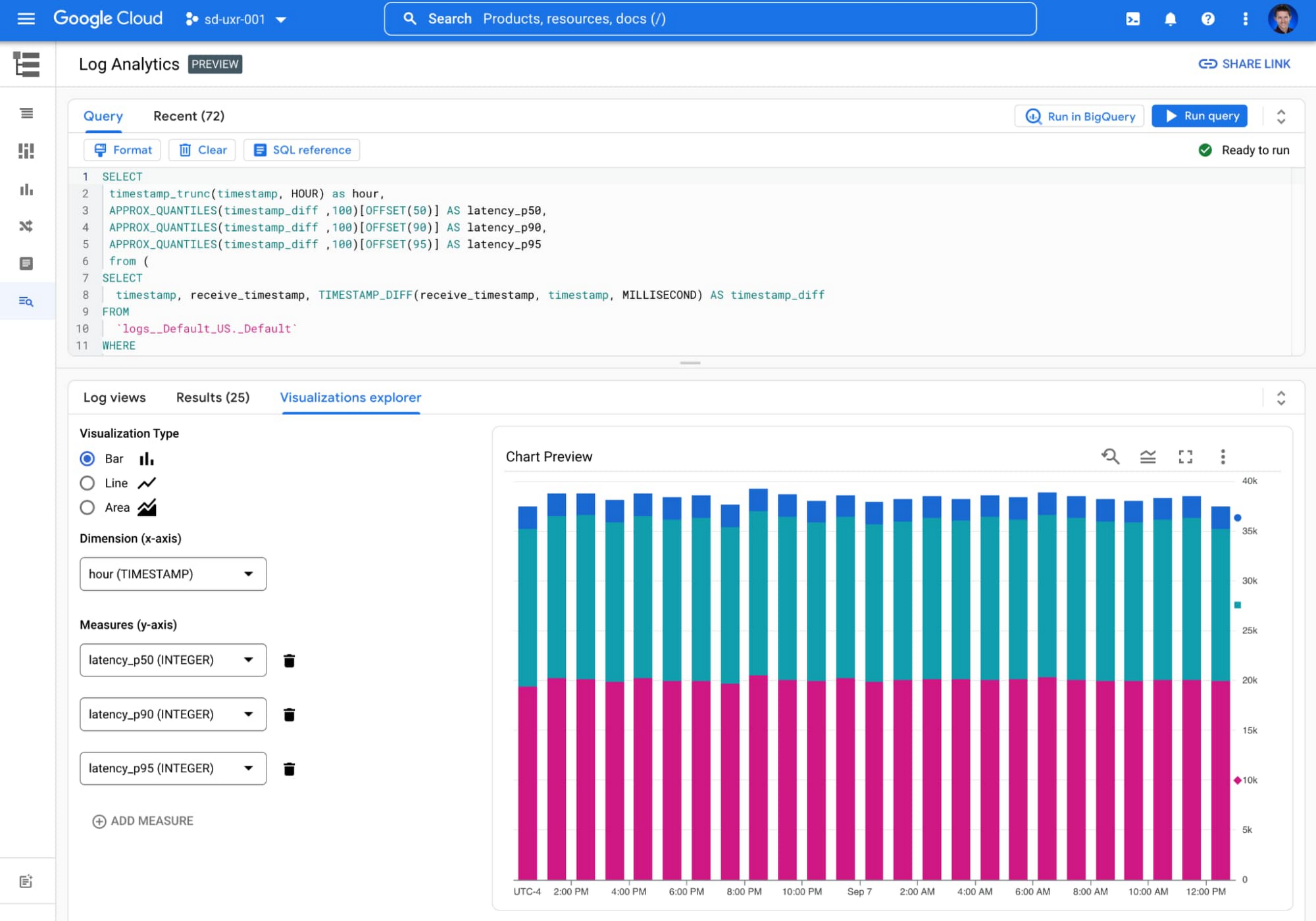

Nous appliquons désormais la même philosophie aux données de logs en proposant un service Log Analytics directement intégré au service Cloud Logging. Cette nouvelle fonctionnalité, actuellement en « preview », permet d’approfondir l’analyse des données de journalisation avec BigQuery. Log Analytics n'entraîne pas de facturation supplémentaire aux tarifs actuels de Cloud Logging et tire profit des fonctionnalités d’analyse de journaux de BigQuery qui seront bientôt disponibles : index de recherche (et son nouveau type de données JSON) et l’API « Storage Write » (API d’ingestion de données par lots de BigQuery).

Les clients qui stockent, explorent et analysent leurs propres « données machines » (autrement dit des données générées par des machines telles que des serveurs, des capteurs et autres dispositifs) peuvent exploiter ces mêmes fonctionnalités BigQuery pour faciliter l'interrogation de leurs journaux. Les données des journaux opérationnels peuvent ainsi être explorées avec le langage SQL BigQuery, comme n’importe quelle autre donnée de l’entreprise !

Tout ceci n’est bien entendu qu’un avant-goût des surprises que nous vous réservons à l’occasion de Next'22. Nous avons hâte de vous présenter notre nouvelle génération de solutions data cloud, dès le 11 octobre prochain. Pour participer aux sessions dédiées à vos centres d’intérêt ou à votre domaine de compétences, n’hésitez pas à consulter notre sélection des « Top sessions » pour Data-Engineers, Data-Scientists et Data-Analysts ou à créer vos propres listes et à les partager.

Rejoignez-nous à Next'22 pour découvrir comment des entreprises leader sur leur marché, telles que Boeing, Twitter, CNA Insurance, Telus, L'Oréal ou encore Wayfair, transforment l’exploitation de leurs données grâce au data cloud de Google.