Un projet peut avoir plusieurs ensembles de données, chacun servant à entraîner un modèle distinct. Vous pouvez obtenir la liste des ensembles de données disponibles, obtenir un ensemble de données spécifique, exporter un ensemble de données et supprimer un ensemble de données dont vous n'avez plus besoin.

Répertorier les ensembles de données

Cette section explique comment récupérer la liste des ensembles de données disponibles pour un projet.

UI Web

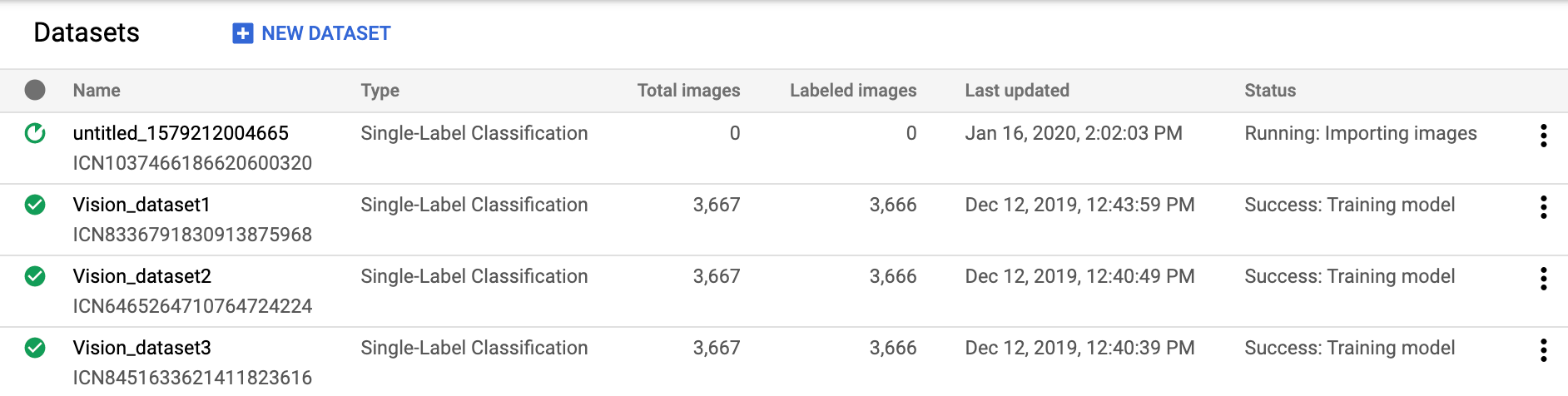

Pour afficher la liste des ensembles de données disponibles à l'aide de l'Vision Dashboard, cliquez sur le lien Datasets (Ensembles de données) en haut du menu de navigation de gauche.

Pour afficher les modèles d'un autre projet, sélectionnez le projet dans la liste déroulante située en haut à droite de la barre de titre.

REST

Avant d'utiliser les données de requête ci-dessous, effectuez les remplacements suivants :

- project-id : ID de votre projet GCP.

Méthode HTTP et URL :

GET https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets

Pour envoyer votre requête, choisissez l'une des options suivantes :

curl

Exécutez la commande suivante :

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets"

PowerShell

Exécutez la commande suivante :

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets" | Select-Object -Expand Content

Vous devriez recevoir une réponse JSON de ce type :

{

"datasets": [

{

"name": "projects/project-id/locations/us-central1/datasets/dataset-id",

"displayName": "my_new_dataset",

"createTime": "2019-10-29T17:31:12.010290Z",

"etag": "AB3BwFpNUaguCwKeQWtUKLBPQhZr7omCCUBz77pACPIINFpyFe7vbGhp9oZLEEGhIeM=",

"exampleCount": 3667,

"imageClassificationDatasetMetadata": {

"classificationType": "MULTICLASS"

}

},

{

"name": "projects/project-id/locations/us-central1/datasets/dataset-id",

"displayName": "new_dataset",

"createTime": "2019-10-02T00:44:57.821275Z",

"etag": "AB3BwFpU_ueMZtTD_8dt-9r8BWqunqMC76YbAbmQYQsQEbtQTxs6U3rPpgAMDCXhYPGq",

"imageClassificationDatasetMetadata": {

"classificationType": "MULTICLASS"

}

}

]

}

Go

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Java

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Node.js

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Python

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Langages supplémentaires

C# : Veuillez suivre les Instructions de configuration pour C# sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur AutoML Vision pour C#.

PHP : Veuillez suivre les Instructions de configuration pour PHP sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur AutoML Vision pour PHP.

Ruby : Veuillez suivre les Instructions de configuration pour Ruby sur la page des bibliothèques clientes, puis consultez la Documentation de référence sur AutoML Vision pour Ruby.

Obtenir un ensemble de données

Vous pouvez également obtenir un ensemble de données spécifique à l'aide d'un ID d'ensemble de données.

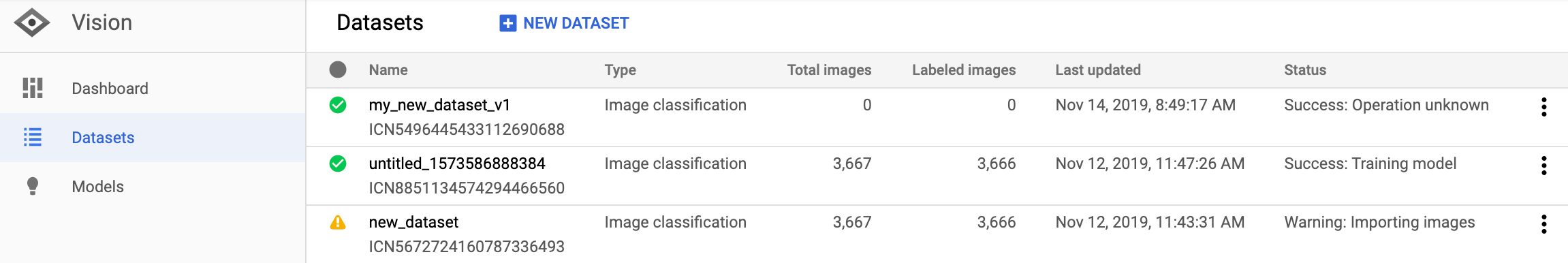

UI Web

Pour afficher la liste des ensembles de données disponibles à l'aide de l'UI d'AutoML Vision, cliquez sur le lien Datasets (Ensembles de données) en haut du menu de navigation de gauche.

Pour afficher les ensembles de données d'un autre projet, sélectionnez le projet dans la liste déroulante située à gauche de la barre de titre.

Accédez à un ensemble de données spécifique en sélectionnant son nom dans la liste.

REST

Avant d'utiliser les données de requête ci-dessous, effectuez les remplacements suivants :

- project-id : ID de votre projet GCP.

- dataset-id : ID de votre ensemble de données. L'ID correspond au dernier élément du nom de l'ensemble de données. Exemple :

- Nom de l'ensemble de données :

projects/project-id/locations/location-id/datasets/3104518874390609379 - ID de l'ensemble de données :

3104518874390609379

- Nom de l'ensemble de données :

Méthode HTTP et URL :

GET https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID

Pour envoyer votre requête, choisissez l'une des options suivantes :

curl

Exécutez la commande suivante :

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID"

PowerShell

Exécutez la commande suivante :

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID" | Select-Object -Expand Content

Vous devriez recevoir une réponse JSON de ce type :

{ "name": "projects/project-id/locations/us-central1/datasets/dataset-id", "displayName": "display-name", "createTime": "2019-10-29T17:31:12.010290Z", "etag": "AB3BwFoP09ffuRNnaWMx4UGi8uvYFctvOBjns84OercuMRIdXr0YINNiUqeW85SB3g4=", "exampleCount": 3667, "imageClassificationDatasetMetadata": { "classificationType": "MULTICLASS" } }

Go

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Java

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Node.js

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Python

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Exporter un ensemble de données

Vous pouvez exporter un fichier CSV contenant toutes les informations d'un ensemble de données vers un bucket Google Cloud Storage.

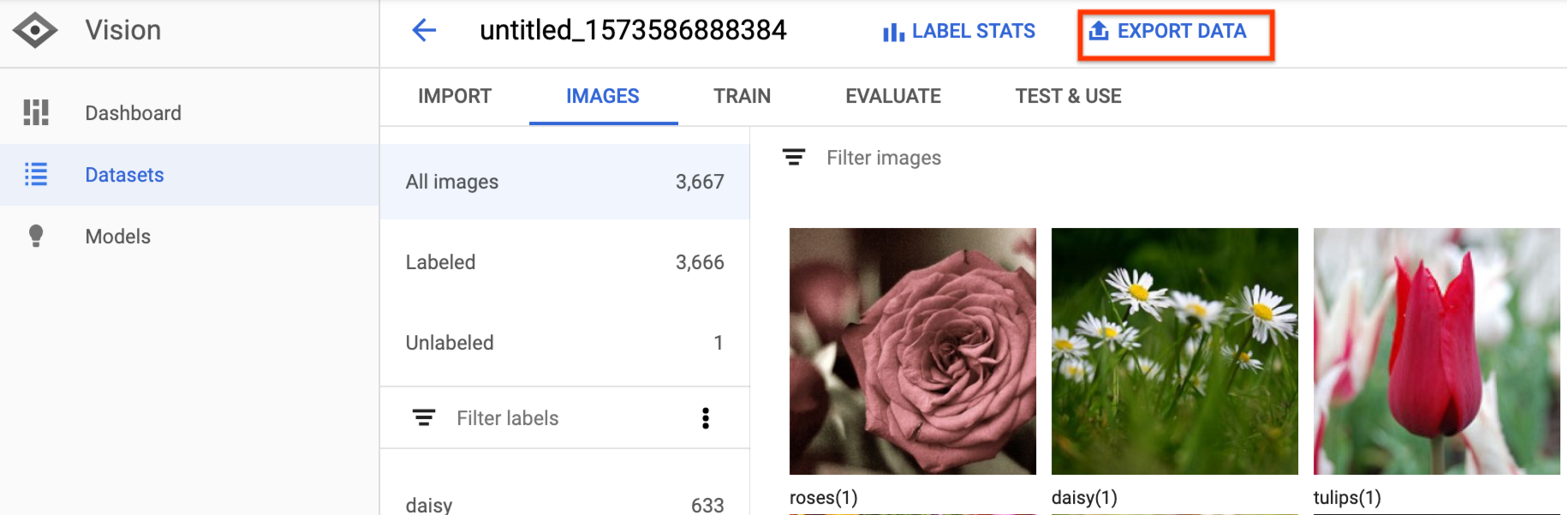

UI Web

Pour exporter un ensemble de données non vide, procédez comme suit :

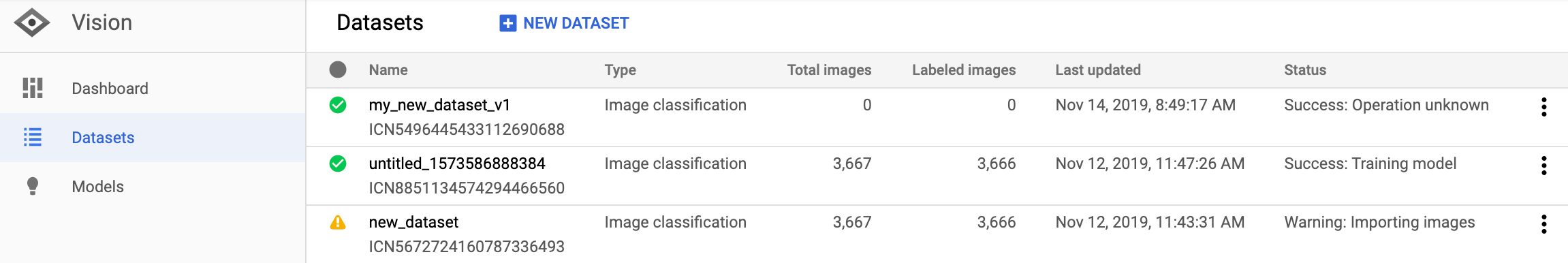

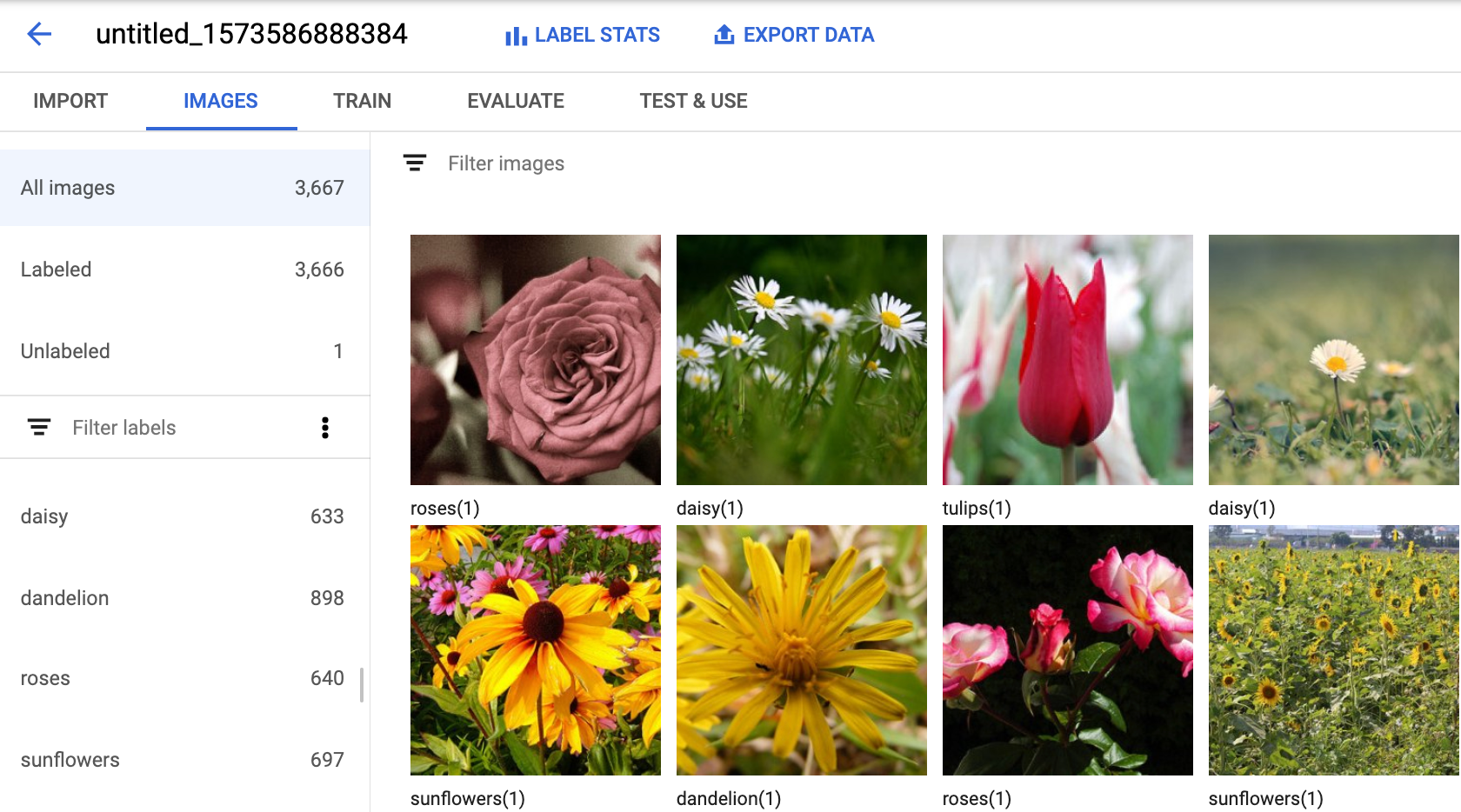

Sélectionnez l'ensemble de données non vide sur la page Datasets (Ensembles de données).

Sélectionnez l'ensemble de données non vide pour accéder à la page Détails de l'ensemble de données.

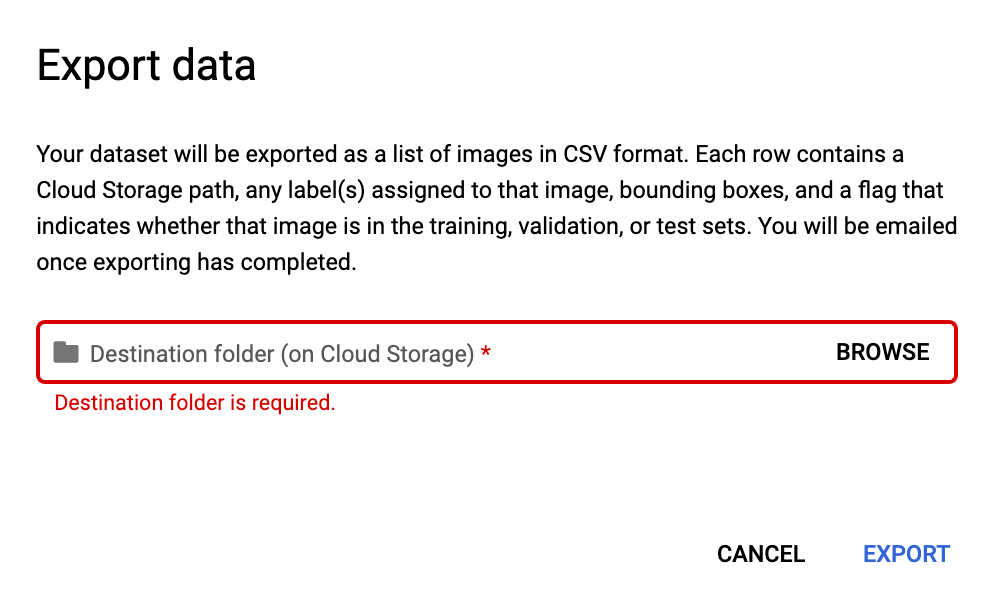

Sélectionnez l'option Export data (Exporter les données) en haut de la page des détails de l'ensemble des données.

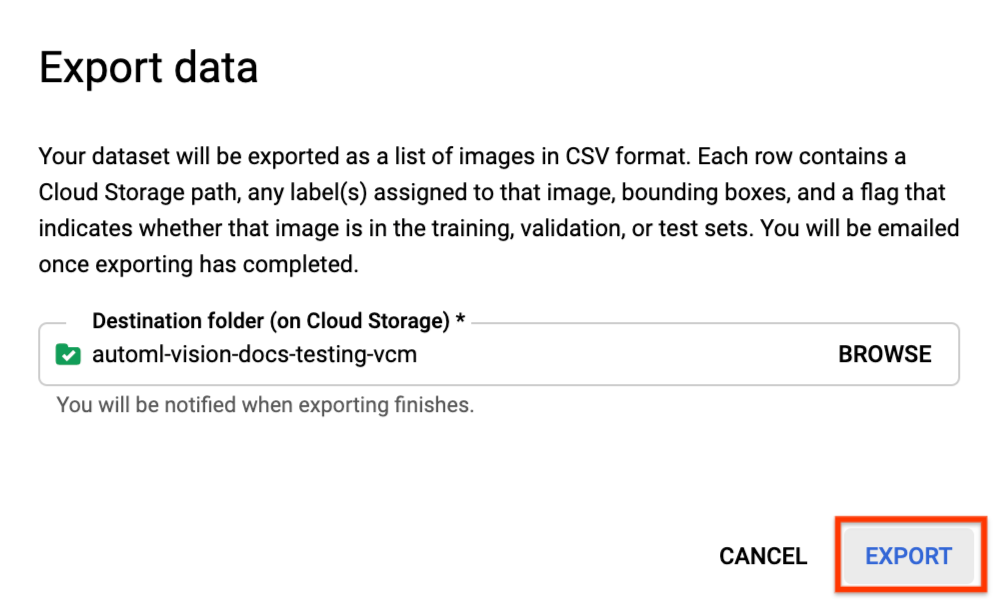

Cette opération ouvre une fenêtre dans laquelle vous pouvez choisir un emplacement de bucket Google Cloud Storage, ou créer un bucket et le désigner comme emplacement de stockage du fichier CSV.

Cliquez sur Export CSV (Exporter au format CSV) après avoir sélectionné un emplacement de bucket Google Cloud Storage nouveau ou existant.

Vous recevrez un e-mail une fois le processus d'exportation des données terminé.

REST

Avant d'utiliser les données de requête ci-dessous, effectuez les remplacements suivants :

- project-id : ID de votre projet GCP.

- dataset-id : ID de votre ensemble de données. L'ID correspond au dernier élément du nom de l'ensemble de données. Exemple :

- Nom de l'ensemble de données :

projects/project-id/locations/location-id/datasets/3104518874390609379 - ID de l'ensemble de données :

3104518874390609379

- Nom de l'ensemble de données :

- output-storage-bucket : répertoire/bucket Google Cloud Storage dans lequel enregistrer les fichiers de sortie, exprimé sous la forme suivante :

gs://bucket/directory/. L'utilisateur demandeur doit disposer d'autorisations en écriture sur le bucket.

Méthode HTTP et URL :

POST https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID:exportData

Corps JSON de la requête :

{

"outputConfig": {

"gcsDestination": {

"outputUriPrefix": "CLOUD_STORAGE_BUCKET"

}

}

}

Pour envoyer votre requête, choisissez l'une des options suivantes :

curl

Enregistrez le corps de la requête dans un fichier nommé request.json, puis exécutez la commande suivante :

curl -X POST \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

-H "Content-Type: application/json; charset=utf-8" \

-d @request.json \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID:exportData"

PowerShell

Enregistrez le corps de la requête dans un fichier nommé request.json, puis exécutez la commande suivante :

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method POST `

-Headers $headers `

-ContentType: "application/json; charset=utf-8" `

-InFile request.json `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID:exportData" | Select-Object -Expand Content

Des résultats semblables aux lignes suivantes devraient s'afficher : Vous pouvez obtenir l'état de la tâche à l'aide de l'ID de tâche. Pour consulter un exemple, reportez-vous à la page Travailler avec des opérations de longue durée.

{

"name": "projects/PROJECT_ID/locations/us-central1/operations/OPERATION_ID",

"metadata": {

"@type": "type.googleapis.com/google.cloud.automl.v1.OperationMetadata",

"createTime": "2019-08-12T18:52:31.637075Z",

"updateTime": "2019-08-12T18:52:31.637075Z",

"exportDataDetails": {

"outputInfo": {

"gcsOutputDirectory": "CLOUD_STORAGE_BUCKET/export_data-DATASET_NAME-TIMESTAMP_OF_EXPORT_CALL/"

}

}

}

}

Java

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Node.js

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Python

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Format CSV exporté

Le fichier CSV exporté contient la même mise en forme que le fichier CSV d'importation des données d'entraînement :

set,path,label0[,label1,label2,...]

Ce fichier CSV est enregistré dans un sous-dossier d'exportation spécialement créé à cet effet, qui se distingue par son horodatage unique. Voici à titre d'exemple quelques lignes d'un fichier CSV exporté :

my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/image_classification_1.csv :

TRAIN,gs://my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/files/img874.jpg,dandelion VALIDATION,gs://my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/files/img447.jpg,roses TRAIN,gs://my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/files/img672.jpg,dandelion VALIDATION,gs://my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/files/img421.jpg,sunflowers TRAIN,gs://my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/files/img495.jpg,tulips TEST,gs://my-storage-bucket/export_data-my_dataset_name-2019-11-08T22:28:13.081Z/files/img014.jpg,sunflowers

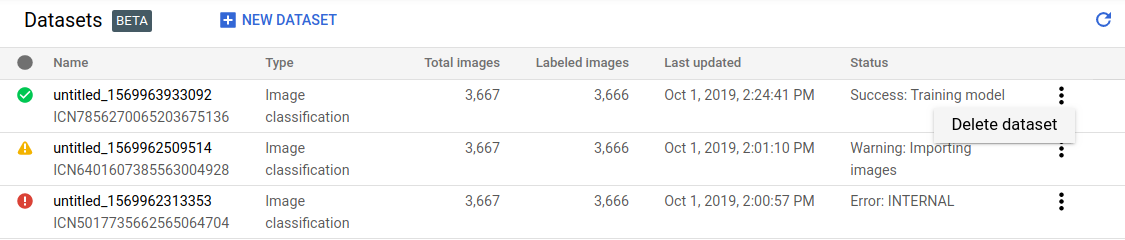

Supprimer un ensemble de données

Vous pouvez supprimer un ensemble de données dont vous n'avez plus besoin dans l'UI, ou avec l'ID de l'ensemble de données via les exemples de code suivants.

UI Web

Dans l'Vision Dashboard, cliquez sur le lien Datasets (Ensembles de données) en haut du menu de navigation de gauche pour afficher la liste des ensembles de données disponibles.

Cliquez sur le menu à trois points à l'extrémité droite de la ligne que vous souhaitez supprimer, puis sélectionnez Supprimer l'ensemble de données.

Cliquez sur Supprimer dans la boîte de dialogue de confirmation.

REST

Avant d'utiliser les données de requête ci-dessous, effectuez les remplacements suivants :

- project-id : ID de votre projet GCP.

- dataset-id : ID de votre ensemble de données. L'ID correspond au dernier élément du nom de l'ensemble de données. Exemple :

- Nom de l'ensemble de données :

projects/project-id/locations/location-id/datasets/3104518874390609379 - ID de l'ensemble de données :

3104518874390609379

- Nom de l'ensemble de données :

Méthode HTTP et URL :

DELETE https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID

Pour envoyer votre requête, choisissez l'une des options suivantes :

curl

Exécutez la commande suivante :

curl -X DELETE \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-id" \

"https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID"

PowerShell

Exécutez la commande suivante :

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-id" }

Invoke-WebRequest `

-Method DELETE `

-Headers $headers `

-Uri "https://automl.googleapis.com/v1/projects/PROJECT_ID/locations/us-central1/datasets/DATASET_ID" | Select-Object -Expand Content

Des résultats semblables aux lignes suivantes devraient s'afficher : Vous pouvez obtenir l'état de la tâche à l'aide de l'ID de tâche. Pour consulter un exemple, reportez-vous à la page Travailler avec des opérations de longue durée.

{

"name": "projects/PROJECT_ID/locations/us-central1/operations/OPERATION_ID",

"metadata": {

"@type": "type.googleapis.com/google.cloud.automl.v1.OperationMetadata",

"createTime": "2019-11-08T22:37:19.822128Z",

"updateTime": "2019-11-08T22:37:19.822128Z",

"deleteDetails": {}

},

"done": true,

"response": {

"@type": "type.googleapis.com/google.protobuf.Empty"

}

}

Go

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Java

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Node.js

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.

Python

Avant d'essayer l'exemple ci-dessous, suivez les instructions de configuration pour ce langage sur la page Bibliothèques clientes.