Evaluar modelos

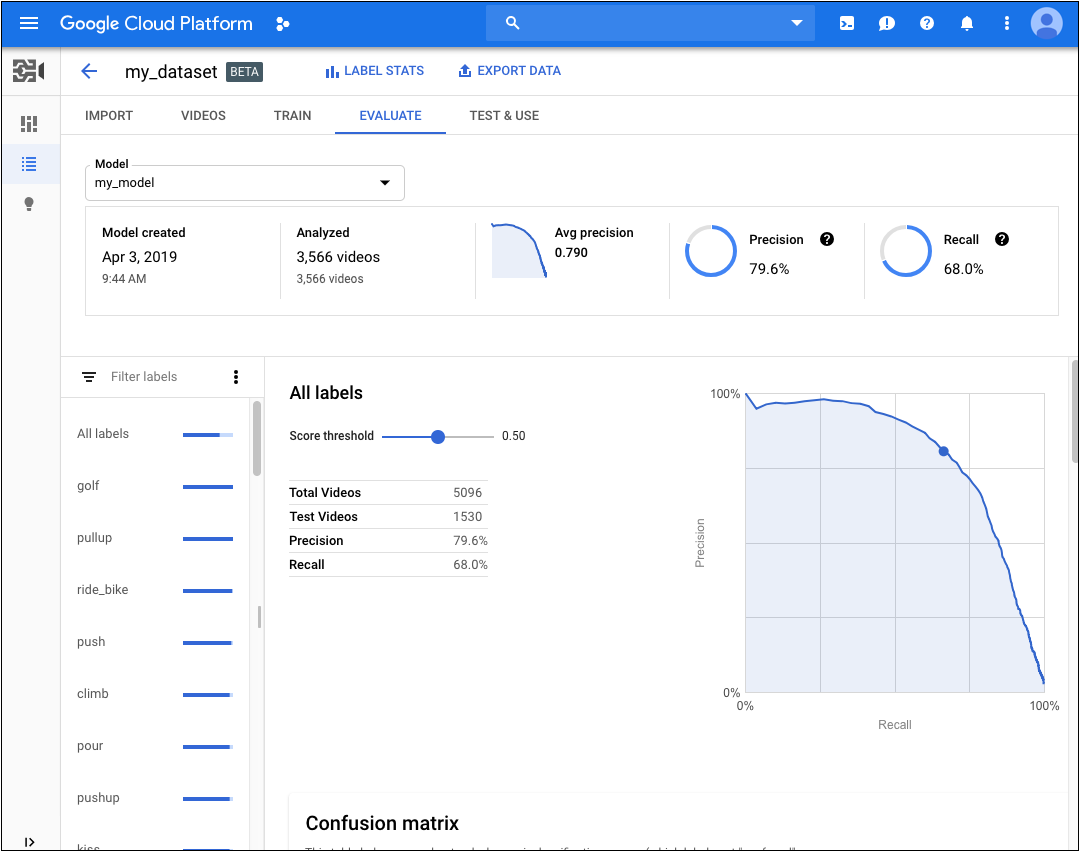

Después de que se entrena un modelo, la clasificación AutoML Video Intelligence usa elementos del conjunto de PRUEBA para evaluar la calidad y exactitud del modelo nuevo.

La clasificación AutoML Video Intelligence proporciona un conjunto agregado de métricas de evaluación que indican el rendimiento general del modelo, así como métricas de evaluación para cada etiqueta de categoría que indican el rendimiento del modelo en la etiqueta.

AuPRC : Área bajo la curva de Precisión/Recuperación, también conocida como "precisión promedio". Por lo general, se encuentra entre 0.5 y 1.0. Valores más altos indican modelos más exactos.

Las Curvas del umbral de confianza muestran de qué manera los diferentes umbrales de confidencia podrían afectar las tasas de precisión, recuperación, y de verdaderos y falsos positivos. Obtén información sobre la relación entre precisión y recuperación.

Usa estos datos para evaluar la preparación de tu modelo. Las puntuaciones bajas de AUC o las puntuaciones bajas de precisión y recuperación pueden indicar que tu modelo necesita datos de entrenamiento adicionales o que tiene etiquetas incoherentes. Una puntuación AUC muy alta y una precisión y recuperación perfectas podrían indicar que los datos son demasiado fáciles y pueden no generalizarse bien.

Obtén valores de modelos de evaluación

IU web

-

Abre la página Modelos en la IU de video de AutoML.

-

Haz clic en la fila del modelo que deseas evaluar.

-

Haz clic en la pestaña Evaluar.

Si se completó el entrenamiento del modelo, AutoML Video mostrará sus métricas de evaluación.

- Para ver las métricas de una etiqueta específica, selecciona el nombre de la etiqueta de la lista que se encuentra en la parte inferior de la página.

REST

Antes de usar cualquiera de los datos de solicitud a continuación, realiza los siguientes reemplazos:

- model-name: Es el nombre completo del modelo, según la respuesta que obtuviste cuando lo creaste. El nombre completo tiene el siguiente formato: projects/project-number/locations/location-id/models/model-id.

- project-number: Es el número de tu proyecto.

HTTP method and URL:

GET https://automl.googleapis.com/v1beta1/model-name:modelEvaluations

Para enviar tu solicitud, elige una de estas opciones:

curl

Ejecuta el siguiente comando:

curl -X GET \

-H "Authorization: Bearer $(gcloud auth print-access-token)" \

-H "x-goog-user-project: project-number" \

" https://automl.googleapis.com/v1beta1/model-name:modelEvaluations"

PowerShell

Ejecuta el siguiente comando:

$cred = gcloud auth print-access-token

$headers = @{ "Authorization" = "Bearer $cred"; "x-goog-user-project" = "project-number" }

Invoke-WebRequest `

-Method GET `

-Headers $headers `

-Uri " https://automl.googleapis.com/v1beta1/model-name:modelEvaluations" | Select-Object -Expand Content

2308399322008336298.

Java

Para autenticarte en AutoML Video, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Node.js

Para autenticarte en AutoML Video, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Python

Para autenticarte en AutoML Video, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Realiza iteraciones en tu modelo

Si no estás satisfecho con los niveles de calidad, puedes volver a realizar los pasos anteriores para mejorarla:

- Es posible que debas agregar diferentes tipos de videos (p. ej., un ángulo más amplio, mayor o menor resolución, diferentes puntos de vista).

- Considera quitar las etiquetas por completo si no tiene suficientes videos de entrenamiento.

- Recuerda que las máquinas no pueden leer el nombre de tu etiqueta; solo la ven como una string de letras al azar. Si tienes una etiqueta que dice “puerta” y otra que dice “puerta_con_picaporte”, la máquina no puede distinguir la diferencia más allá de los videos que le proporciones.

- Mejora tus datos con más ejemplos de verdaderos positivos y negativos. Los ejemplos más importantes son los que están cerca del límite de decisión.

Una vez que hayas hecho los cambios, entrena y evalúa un modelo nuevo hasta que alcances un nivel de calidad satisfactorio.