Prüfen Sie die Modellleistung mit der Google Cloud Console. Analysieren Sie Testfehler, um die Modellqualität iterativ zu verbessern, indem Sie Datenprobleme beheben.

Diese Anleitung umfasst mehrere Seiten:

Dataset zur Bildklassifizierung erstellen und Bilder importieren

Modellleistung bewerten und analysieren

Modell auf einem Endpunkt bereitstellen und eine Vorhersage senden

Auf jeder Seite wird davon ausgegangen, dass Sie die Anleitung auf den vorherigen Seiten des Leitfadens bereits ausgeführt haben.

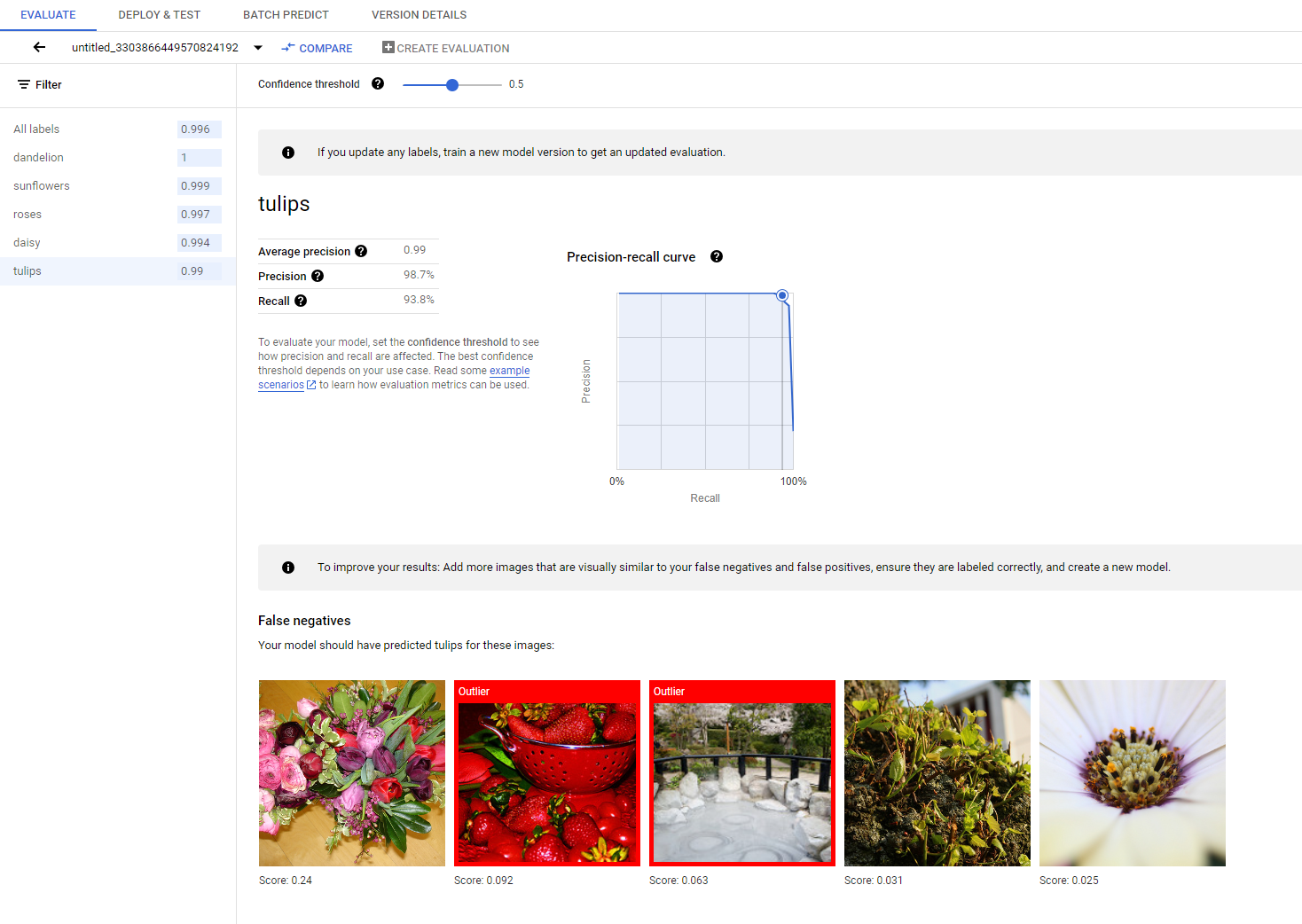

1. Ergebnisse der AutoML-Modellbewertung

Nach Abschluss des Trainings wird Ihr Modell automatisch anhand der Testdatenaufteilung bewertet. Die entsprechenden Bewertungsergebnisse werden angezeigt, wenn Sie auf der Seite Modellregistrierung oder der Seite Dataset auf den Namen des Modells klicken.

Von dort aus finden Sie die Messwerte, um die Leistung des Modells zu messen.

Im Abschnitt Modell bewerten, testen und bereitstellen finden Sie eine ausführlichere Einführung in verschiedene Bewertungsmesswerte.

2. Testergebnisse analysieren

Wenn Sie die Modellleistung weiter verbessern möchten, müssen Sie als erstes die Fehlerfälle und die möglichen Ursachen untersuchen. Die Bewertungsseite jeder Klasse enthält detaillierte Testbilder der angegebenen Klasse, die als falsch negative, falsch positive und richtig positive Ergebnisse kategorisiert sind. Die Definition der einzelnen Kategorien finden Sie im Abschnitt Modell bewerten, testen und bereitstellen.

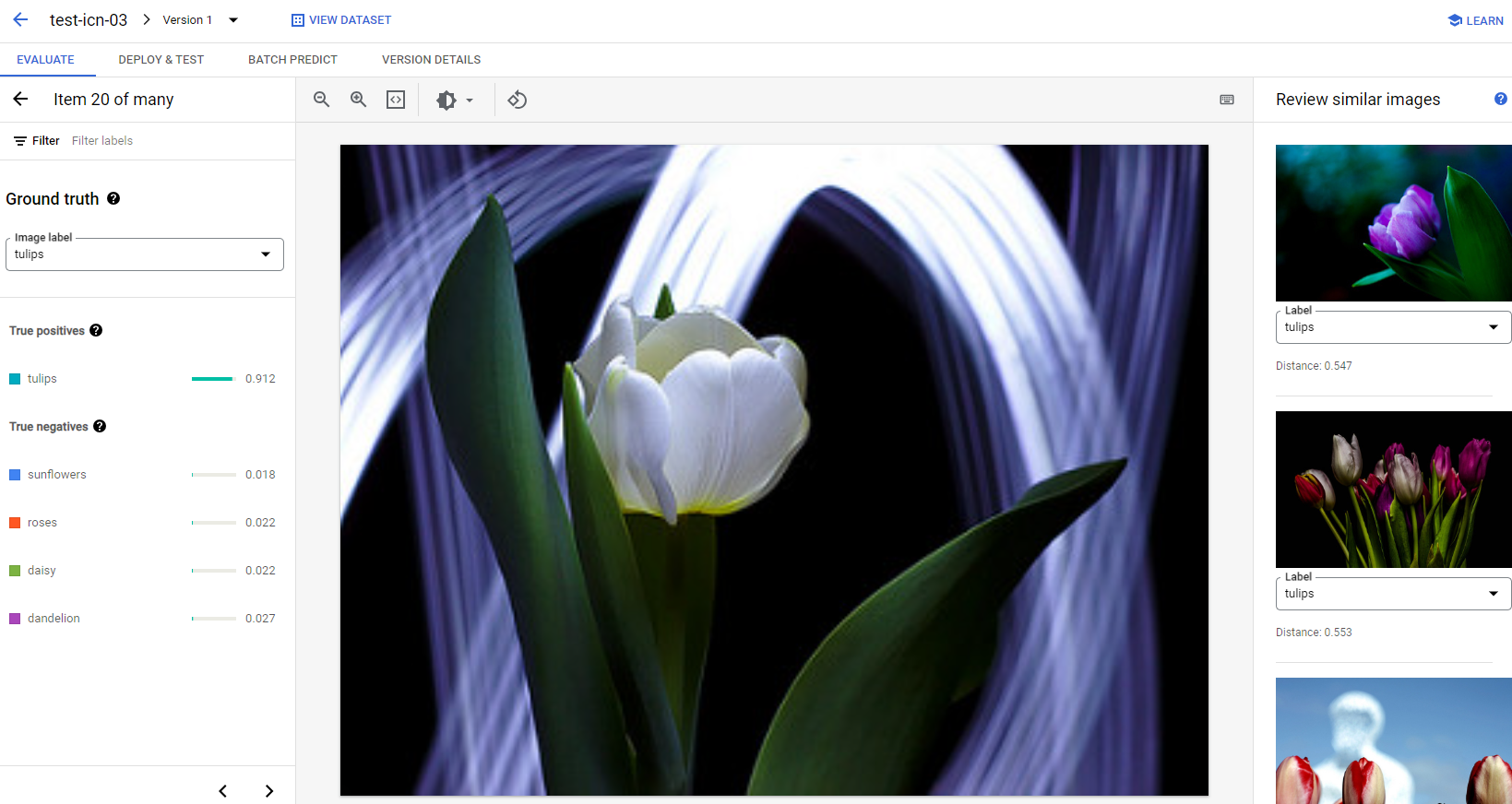

Für jedes Bild unter jeder Kategorie können Sie die Vorhersagedetails weiter prüfen, indem Sie auf das Bild klicken und die detaillierten Analyseergebnisse aufrufen. Rechts auf der Seite sehen Sie den Bereich Ähnliche Bilder prüfen. Dabei werden die am nächsten liegenden Beispiele aus dem Trainingssatz mit den im Featurebereich gemessenen Entfernungen angezeigt.

Es gibt zwei Arten von Datenproblemen, die Sie beachten sollten:

Labelinkonsistenz. Wenn ein visuell ähnliches Beispiel aus dem Trainings-Dataset andere Labels als das Test-Dataset hat, ist eines davon möglicherweise falsch oder der subtile Unterschied erfordert mehr Daten, aus denen das Modell lernen kann. Oder die aktuellen Klassenlabels sind einfach nicht genau genug, um das angegebene Beispiel zu beschreiben. Wenn Sie ähnliche Bilder überprüfen, können Sie die Labelinformationen korrekt gestalten. Entweder korrigieren Sie die Fehlerfälle oder schließen das problematische Beispiel aus dem Test-Dataset aus. Sie können das Label von Test- oder Trainingsbildern im Bereich Ähnliche Bilder prüfen auf derselben Seite ändern.

Ausreißer Wenn ein Testbeispiel als Ausreißer markiert ist, ist es möglich, dass im Trainings-Dataset keine visuell ähnlichen Beispiele vorhanden sind, um das Modell zu trainieren. Wenn Sie ähnliche Bilder aus dem Trainings-Dataset prüfen, können Sie diese Beispiele besser identifizieren und dem Trainings-Dataset ähnliche Bilder hinzufügen, um die Modellleistung in diesen Fällen weiter zu verbessern.

Nächste Schritte

Wenn Sie mit der Modellleistung zufrieden sind, folgen Sie der nächsten Seite dieser Anleitung, um Ihr trainiertes AutoML-Modell an einem Endpunkt bereitzustellen und ein Bild zur Vorhersage an das Modell zu senden. Wenn Sie Korrekturen an den Daten vornehmen, trainieren Sie andernfalls ein neues Modell. Verwenden Sie dazu die Anleitung AutoML-Bildklassifizierungsmodell trainieren.