OpenCensus es un proyecto gratuito de código abierto cuyas bibliotecas tienen las siguientes características:

- Proporcionar asistencia independiente del proveedor para la recopilación de datos de métricas y de seguimiento en varios lenguajes

- Puedes exportar los datos recopilados a varias aplicaciones de backend, incluida Cloud Monitoring, mediante exportadores.

Aunque Cloud Monitoring proporciona una API que admite la definición y recopilación de métricas definidas por el usuario, es una API propietaria de bajo nivel. OpenCensus proporciona una API que sigue el estilo de la comunidad de lenguajes, junto con un exportador que envía tus datos de métricas a Cloud Monitoring a través de la API de Monitoring.

OpenCensus también tiene una buena asistencia para el seguimiento de aplicaciones; consulta Seguimiento de OpenCensus a fin de obtener una descripción general. Cloud Trace recomienda que uses OpenCensus para la instrumentación de seguimiento. Para recopilar datos de métricas y de seguimiento de tus servicios, puedes usar una distribución única de bibliotecas. Si quieres obtener información sobre el uso de OpenCensus con Cloud Trace, consulta Bibliotecas cliente para Trace.

Antes de comenzar

Para usar Cloud Monitoring, debes tener un proyecto de Google Cloud con la facturación habilitada. Si es necesario, haz lo siguiente:

-

En la página del selector de proyectos de la consola de Google Cloud, selecciona o crea un proyecto de Google Cloud.

-

Asegúrate de que la facturación esté habilitada para tu proyecto de Google Cloud.

- Asegúrate de que la API de Monitoring esté habilitada. Para obtener más información, consulta Habilita la API de Monitoring.

Para las aplicaciones que se ejecutan fuera de Google Cloud, el proyecto de Google Cloud debe autenticar la aplicación. Por lo general, la autenticación se configura mediante la creación de una cuenta de servicio para el proyecto y la configuración de una variable de entorno.

Para las aplicaciones que ejecutas en una instancia de Amazon Elastic Compute Cloud (Amazon EC2), crea la cuenta de servicio para el proyecto de AWS Connector de la instancia.

Para obtener información sobre cómo crear una cuenta de servicio, consulta Comienza a usar la autenticación.

Instala OpenCensus

Si deseas usar las métricas que recopila OpenCensus en tu proyecto de Google Cloud, debes hacer que las bibliotecas de métricas de OpenCensus y el exportador de Stackdriver estén disponibles para tu aplicación. El exportador de Stackdriver exporta las métricas que OpenCensus recopila en tu proyecto de Google Cloud. Luego, puedes usar Cloud Monitoring para graficar o supervisar esas métricas.

Go

Para autenticarte en Monitoring, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Para usar OpenCensus, se requiere la versión 1.11 de Go o una superior. Las dependencias se administran de forma automática.Java

Para autenticarte en Monitoring, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Para Maven, agrega lo siguiente al elementodependencies en tu archivo pom.xml:

Node.js

Para autenticarte en Monitoring, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

- Antes de instalar las bibliotecas centrales y de exportador de OpenCensus, asegúrate de haber preparado tu entorno para el desarrollo de Node.js.

- La forma más fácil de instalar OpenCensus es con npm:

npm install @opencensus/core npm install @opencensus/exporter-stackdriver

- Coloca las declaraciones

requireque se muestran a continuación en la parte superior de la secuencia de comandos principal o punto de entrada de tu aplicación antes de colocar cualquier otro código:

Python

Para autenticarte en Monitoring, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Instala el núcleo de OpenCensus y las bibliotecas de exportador de Stackdriver con el siguiente comando:pip install -r opencensus/requirements.txt

El archivo requirements.txt se encuentra en el repositorio de GitHub para estas muestras, python-docs-samples.

Escribe métricas definidas por el usuario con OpenCensus

La instrumentación de tu código a fin de usar OpenCensus para métricas implica tres pasos:

- Importa los paquetes de estadísticas de OpenCensus y del exportador de Stackdriver de OpenCensus.

- Inicializa el exportador de Stackdriver.

- Usa la API de OpenCensus para instrumentar tu código.

El siguiente ejemplo es un programa mínimo que escribe datos de métricas mediante OpenCensus. El programa ejecuta un bucle y recopila medidas de latencia. Cuando este finaliza, exporta las estadísticas a Cloud Monitoring y sale:

Go

Para autenticarte en Monitoring, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Java

Para autenticarte en Monitoring, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Node.js

Para autenticarte en Monitoring, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

Python

Para autenticarte en Monitoring, configura las credenciales predeterminadas de la aplicación. Si deseas obtener más información, consulta Configura la autenticación para un entorno de desarrollo local.

El programa crea una vista de OpenCensus que se llama task_latency_distribution. Esta string se vuelve parte del nombre de la métrica cuando se exporta a Cloud Monitoring. Consulta Recupera descriptores de métricas para ver cómo se realiza la vista de OpenCensus como un descriptor de métrica de Cloud Monitoring.

A continuación, puedes usar el nombre de la vista como una string de búsqueda cuando seleccionas una métrica para representar.

-

En el panel de navegación de la consola de Google Cloud, elige Monitoring y, luego, leaderboard Explorador de métricas:

- En el elemento Métrica, expande el menú Seleccionar una métrica,

ingresa

OpenCensus/task_latency_distributionen la barra de filtros y, luego, usa los submenús para seleccionar un métrica y tipo de recurso específicos:- En el menú Recursos activos, selecciona tu recurso supervisado. Si ejecutas el programa en un entorno local, selecciona Global.

- En el menú Categorías de métricas activas, selecciona Personalizada.

- En el menú Métricas activas, selecciona Distribución de latencia de tareas.

- Haz clic en Aplicar.

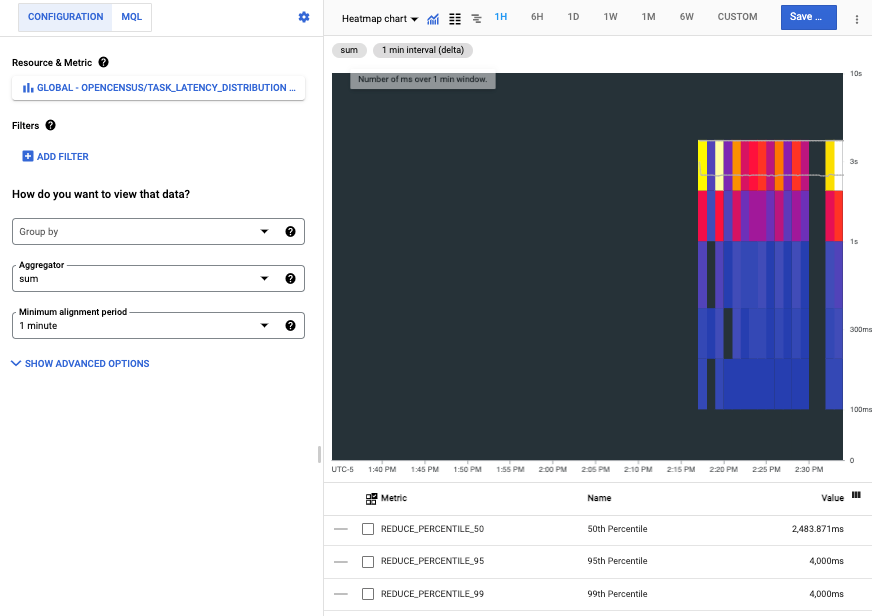

En la siguiente captura de pantalla, se muestran las series temporales recopiladas después de ejecutar el programa en un entorno local:

Cada barra en el mapa de calor representa una ejecución del programa, y los componentes en colores de cada barra representan depósitos en la distribución de latencia.

Lee métricas de OpenCensus en Cloud Monitoring

Usas métricas definidas por el usuario, incluidas las métricas escritas por OpenCensus, como las métricas integradas. Puedes crear gráficos, configurar alertas para ellos, leerlos y supervisarlos.

En esta sección, se muestra cómo usar el Explorador de APIs para leer datos de métricas. Para obtener información sobre cómo leer los datos de métricas con la API de Cloud Monitoring o con bibliotecas cliente, consulta los siguientes documentos:

- En Enumera los tipos de métricas y recursos, se explica cómo enumerar y examinar los tipos de recursos y tipos de métricas en tu sistema.

- En Recupera datos de series temporales, se explica cómo recuperar datos de series temporales a partir de métricas con la API de Monitoring.

Por ejemplo, la captura de pantalla que se muestra en la sección anterior es del Explorador de métricas. Cuando uses herramientas de gráficos, te recomendamos que uses el nombre de la vista de OpenCensus para filtrar la lista de métricas. Para obtener más información, consulta Selecciona métricas cuando uses el Explorador de métricas.

Recupera descriptores de métricas

Para recuperar los datos de métricas mediante la API de Monitoring directamente, debes conocer los nombres de Cloud Monitoring a los que se exportaron las métricas de OpenCensus. Para determinar estos nombres, recupera los descriptores de métricas que crea el exportador y, luego, observa el campo type. Para obtener detalles sobre los descriptores de métricas, consulta MetricDescriptor.

A fin de ver los descriptores de métricas creados para las métricas exportadas, haz lo siguiente:

- Ve a la página de referencia de

metricDescriptors.list. En el widget Prueba esta API de la página de referencia, completa los siguientes campos:

Ingresa el nombre de tu proyecto en el campo

name. Usa la siguiente estructura de nombres:projects/PROJECT_ID. En este documento, se usa un proyecto con el IDa-gcp-project.Ingresa un filtro en el campo

filter. Hay muchos descriptores de métricas en un proyecto. Filtrar te permite eliminar esos descriptores que no son de interés.Por ejemplo, debido a que el nombre de la vista de OpenCensus se convierte en parte del nombre de la métrica, puedes agregar un filtro como el siguiente:

metric.type=has_substring("task_latency_distribution")La clave

metric.typees un campo en un tipo incorporado en una serie temporal. ConsultaTimeSeriespara obtener más detalles.Haz clic en Ejecutar.

A continuación, se muestra el descriptor de métrica mostrado:

{

"metricDescriptors": [

{

"name": "projects/a-gcp-project/metricDescriptors/custom.googleapis.com/opencensus/task_latency_distribution",

"labels": [

{

"key": "opencensus_task",

"description": "Opencensus task identifier"

}

],

"metricKind": "CUMULATIVE",

"valueType": "DISTRIBUTION",

"unit": "ms",

"description": "The distribution of the task latencies",

"displayName": "OpenCensus/task_latency_distribution",

"type": "custom.googleapis.com/opencensus/task_latency_distribution"

}

]

}

Esta línea en el descriptor de métrica te indica el nombre del tipo de métrica en Cloud Monitoring:

"type": "custom.googleapis.com/opencensus/task_latency_distribution"

Ahora tienes la información que necesitas para recuperar de forma manual los datos asociados con el tipo de métrica. El valor del campo type también se muestra en la consola de Google Cloud cuando graficas la métrica.

Cómo recuperar datos de métricas

Para recuperar manualmente datos de series temporales de un tipo de métrica, haz lo siguiente:

- Ve a la página de referencia de

timeSeries.list. En el widget Prueba esta API de la página de referencia, completa los siguientes campos:

- Ingresa el nombre de tu proyecto en el campo

name. Usa la siguiente estructura de nombres:projects/PROJECT_ID. En el campo

filter, ingresa el siguiente valor:metric.type="custom.googleapis.com/opencensus/task_latency_distribution"Ingresa valores para los campos

interval.startTimeyinterval.endTime. Estos valores se deben ingresar como una marca de tiempo, por ejemplo,2018-10-11T15:48:38-04:00. Asegúrate de que el valorstartTimesea anterior al valorendTime.Haz clic en el botón Ejecutar.

- Ingresa el nombre de tu proyecto en el campo

A continuación, se muestra el resultado de la recuperación:

{

"timeSeries": [

{

"metric": {

"labels": {

"opencensus_task": "java-3424@docbuild"

},

"type": "custom.googleapis.com/opencensus/task_latency_distribution"

},

"resource": {

"type": "gce_instance",

"labels": {

"instance_id": "2455918024984027105",

"zone": "us-east1-b",

"project_id": "a-gcp-project"

}

},

"metricKind": "CUMULATIVE",

"valueType": "DISTRIBUTION",

"points": [

{

"interval": {

"startTime": "2019-04-04T17:49:34.163Z",

"endTime": "2019-04-04T17:50:42.917Z"

},

"value": {

"distributionValue": {

"count": "100",

"mean": 2610.11,

"sumOfSquaredDeviation": 206029821.78999996,

"bucketOptions": {

"explicitBuckets": {

"bounds": [

0,

100,

200,

400,

1000,

2000,

4000

]

}

},

"bucketCounts": [

"0",

"0",

"1",

"6",

"13",

"15",

"44",

"21"

]

}

}

}

]

},

[ ... data from additional program runs deleted ...]

]

}

Los datos de métricas que se muestran incluyen lo siguiente:

- Información acerca del recurso supervisado sobre el cual se recopilaron los datos.

OpenCensus puede detectar de forma automática los recursos supervisados

gce_instance,k8s_containeryaws_ec2_instance. Estos datos provienen de un programa que se ejecuta en una instancia de Compute Engine. Para obtener información sobre el uso de otros recursos supervisados, consulta Establece recursos supervisados para el exportador. - Descripción de la clase de métrica y el tipo de los valores.

- Los datos reales recopilados dentro del intervalo de tiempo solicitado.

Cómo Monitoring representa las métricas de OpenCensus

Se admite el uso directo de la API de Cloud Monitoring para las métricas definidas por el usuario; su uso se describe en Crea métricas definidas por el usuario con la API. De hecho, el exportador de OpenCensus para Cloud Monitoring usa esta API. En esta sección, se proporciona información sobre cómo Cloud Monitoring representa las métricas que escribe OpenCensus.

Las construcciones que usa la API de OpenCensus difieren de las construcciones usadas por Cloud Monitoring, al igual que algunos usos de la terminología. Donde Cloud Monitoring hace referencia a “métricas”, OpenCensus algunas veces hace referencia a “estadísticas”. Por ejemplo, el componente de OpenCensus que envía datos de métricas a Cloud Monitoring se denomina “exportador de estadísticas para Stackdrdiver”.

Si deseas obtener una descripción general del modelo de OpenCensus para métricas, consulta Métricas de OpenCensus.

Los modelos de datos para las estadísticas de OpenCensus y las métricas de Cloud Monitoring no pertenecen a una asignación de 1:1. Muchos de los mismos conceptos existen en cada uno, pero no son directamente intercambiables.

Una vista de OpenCensus es análoga a

MetricDescriptoren la API de Monitoring. Una vista describe cómo recopilar y agregar mediciones individuales. Las etiquetas se incluyen con todas las mediciones registradas.Una etiqueta de OpenCensus es un par clave-valor. Por lo general, una etiqueta de OpenCensus corresponde a

LabelDescriptoren la API de Monitoring. Las etiquetas te permiten capturar información contextual que puedes usar para filtrar y agrupar métricas.Una medida de OpenCensus describe datos de métricas para registrar. Una agregación de OpenCensus es una función que se aplica a los datos que se usan para resumirla. Estas funciones se usan en la exportación para determinar

MetricKind,ValueTypey la unidad informada en el descriptor de métrica de Cloud Monitoring.Una medición de OpenCensus es un dato recopilado. Las mediciones deben ser agregadas en vistas. De lo contrario, las mediciones individuales se descartan. Una medición de OpenCensus es análoga a

Pointen la API de Monitoring. Cuando las mediciones se agregan en las vistas, los datos agregados se almacenan como datos para la visualización, análogos aTimeSeriesen la API de Monitoring.

¿Qué sigue?

OpenCensus proporciona la documentación de referencia autorizada para tu API de métricas y el exportador de Stackdriver. La siguiente tabla proporciona vínculos a estos documentos de referencia:

Lenguaje Documentación de referencia de la API Documentación del exportador Guía de inicio rápido Go API de Go Exportadores de seguimiento y estadísticas Métricas Java API de Java Exportador de estadísticas Métricas NodeJS API de NodeJS Exportador de estadísticas Métricas Python API de Python Exportador de estadísticas Métricas