Tujuan

Gunakan Dataproc Hub untuk membuat lingkungan notebook JupyterLab satu pengguna yang berjalan di cluster Dataproc.

Buat notebook dan jalankan tugas Spark di cluster Dataproc.

Hapus cluster dan pertahankan notebook Anda di Cloud Storage.

Sebelum memulai

- Administrator harus memberi Anda izin

notebooks.instances.use(lihat Menetapkan peran Identity and Access Management (IAM)).

Membuat cluster Dataproc JupyterLab dari Dataproc Hub

Pilih tab User-Managed Notebooks di halaman Dataproc→Workbench di Konsol Google Cloud.

Klik Open JupyterLab di baris yang mencantumkan instance Dataproc Hub yang dibuat oleh administrator.

- Jika Anda tidak memiliki akses ke Google Cloud Console, masukkan URL instance Hub Dataproc yang dibagikan oleh administrator kepada Anda di browser web Anda.

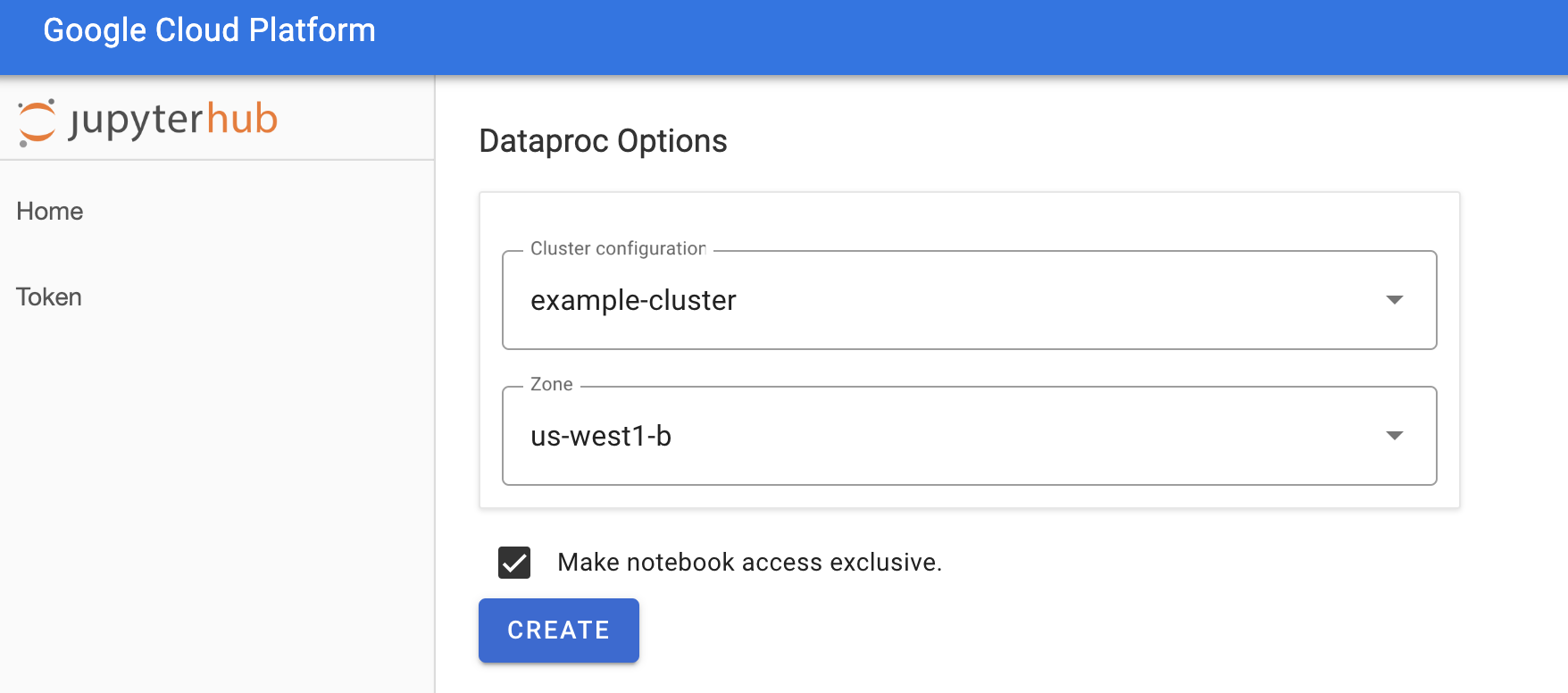

Di halaman Jupyterhub→Dataproc Options, pilih zona dan konfigurasi cluster. Jika diaktifkan, tentukan penyesuaian, lalu klik Create.

Setelah cluster Dataproc dibuat, Anda akan dialihkan ke antarmuka JupyterLab yang berjalan di cluster tersebut.

Membuat notebook dan menjalankan tugas Spark

Di panel kiri antarmuka JupyterLab, klik

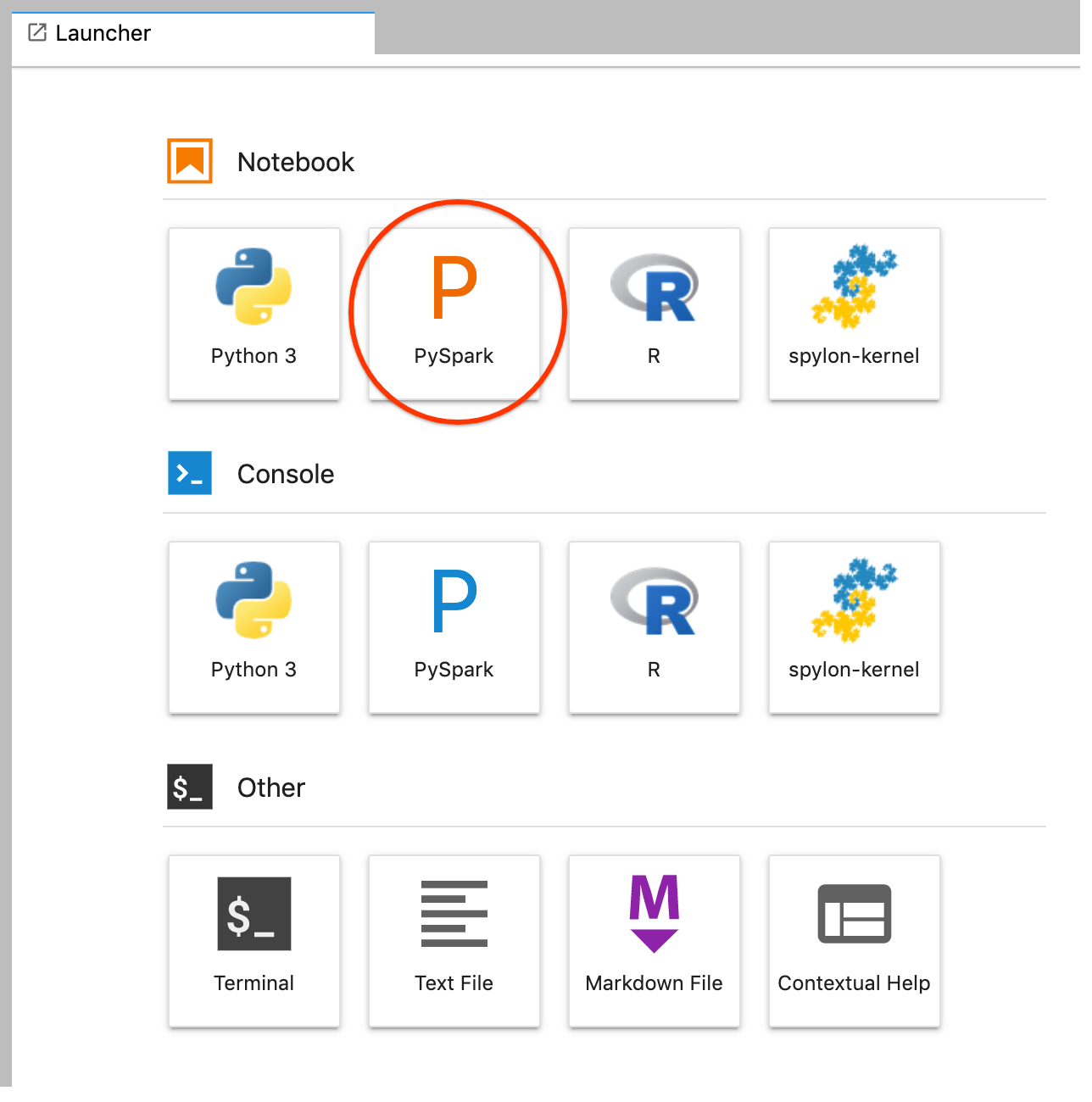

GCS(Cloud Storage).Buat notebook PySpark dari peluncur JupyterLab.

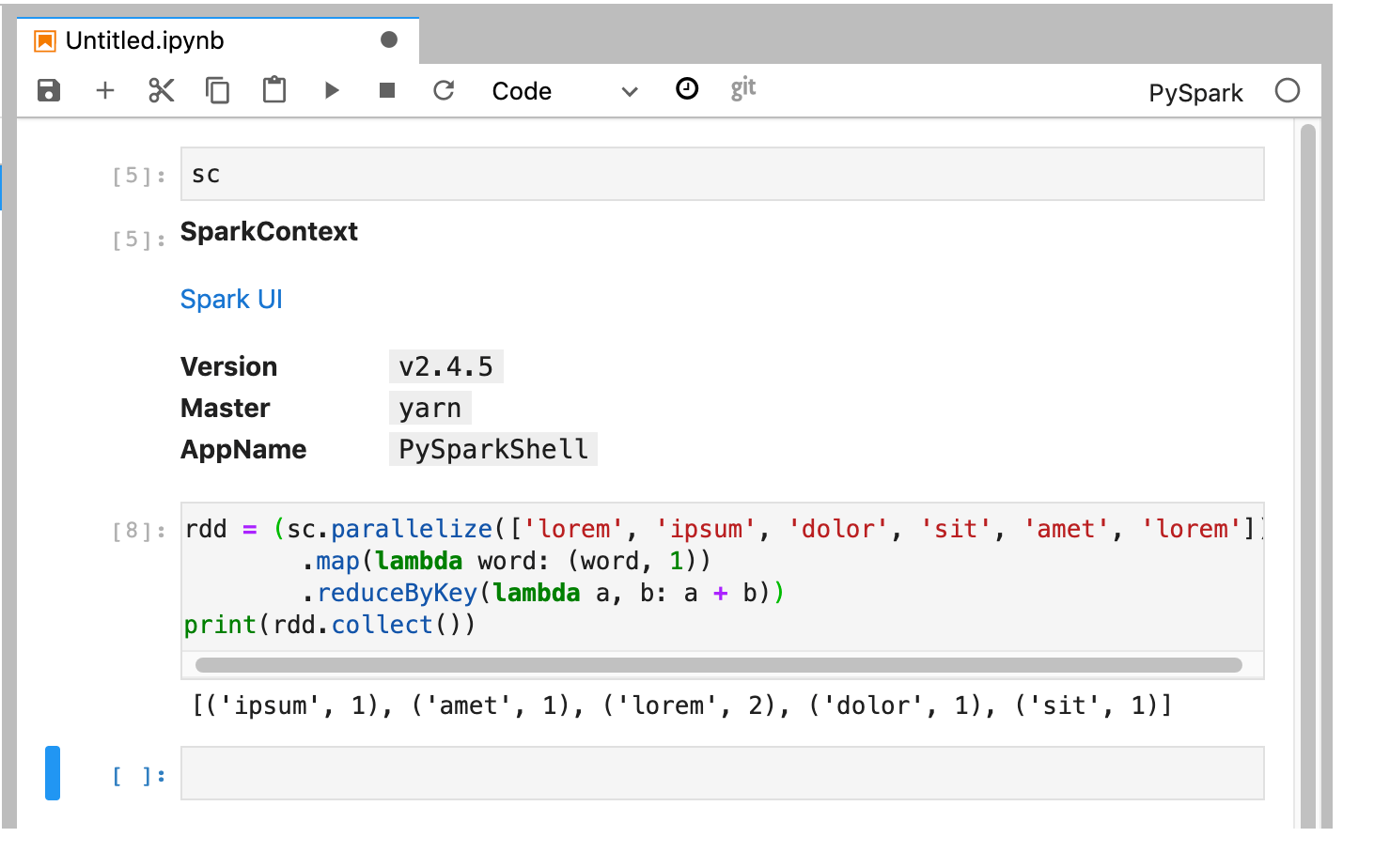

Kernel PySpark melakukan inisialisasi SparkContext (menggunakan variabel

sc). Anda dapat memeriksa SparkContext dan menjalankan tugas Spark dari notebook.rdd = (sc.parallelize(['lorem', 'ipsum', 'dolor', 'sit', 'amet', 'lorem']) .map(lambda word: (word, 1)) .reduceByKey(lambda a, b: a + b)) print(rdd.collect())

Beri nama dan simpan notebook tersebut. Notebook ini disimpan dan tetap berada di Cloud Storage setelah cluster Dataproc dihapus.

Mematikan cluster Dataproc

Dari antarmuka JupyterLab, pilih File→Hub Control Panel untuk membuka halaman Jupyterhub.

Klik Stop My Cluster untuk mematikan (menghapus) server JupyterLab, yang menghapus cluster Dataproc.

Langkah selanjutnya

- Pelajari Spark dan Jupyter Notebooks di Dataproc di GitHub.