Puedes enviar un trabajo a un clúster de Dataproc existente a través de una solicitud HTTP o programática jobs.submit a la API de Dataproc, con la herramienta de línea de comandos gcloud de Google Cloud CLI en una ventana de terminal local o en Cloud Shell, o desde la consola de Google Cloud abierta en un navegador local. También puedes establecer una conexión SSH con la instancia principal en tu clúster y luego ejecutar un trabajo de forma directa desde la instancia sin usar el servicio de Dataproc.

Cómo enviar un trabajo

Console

Abre la página Enviar un trabajo de Dataproc en la consola de Google Cloud en tu navegador.

Ejemplo de un trabajo de Spark

Para enviar un trabajo de Spark de muestra, completa los campos en la página Enviar un trabajo de la siguiente manera:

- En Clúster (Cluster), selecciona el nombre del clúster que quieres elegir de la lista.

- Establece Tipo de trabajo en

Spark. - Establece Clase principal o jar (Main class or jar) en

org.apache.spark.examples.SparkPi. - Establece Argumentos (Arguments) en un argumento único

1000. - Agrega

file:///usr/lib/spark/examples/jars/spark-examples.jara Archivos jar (Jar files):file:///denota un esquema LocalFileSystem de Hadoop. Dataproc instaló/usr/lib/spark/examples/jars/spark-examples.jaren el nodo principal del clúster cuando creó el clúster.- Como alternativa, puedes especificar una ruta de Cloud Storage (

gs://your-bucket/your-jarfile.jar) o una ruta del sistema de archivos distribuido de Hadoop (hdfs://path-to-jar.jar) a uno de tus archivos jar.

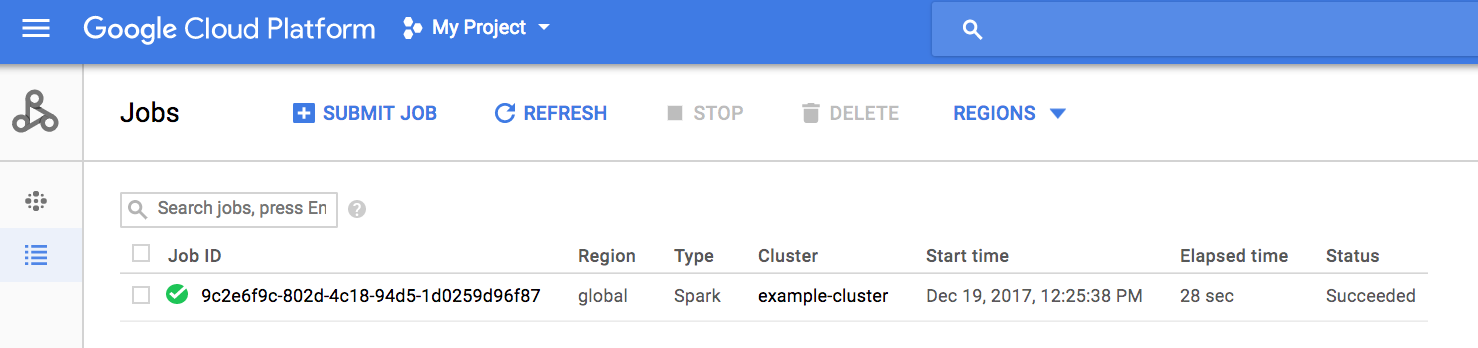

Haz clic en Submit (Enviar) para iniciar el trabajo. Una vez que se inicia el trabajo, se agrega a la lista Jobs (Trabajos).

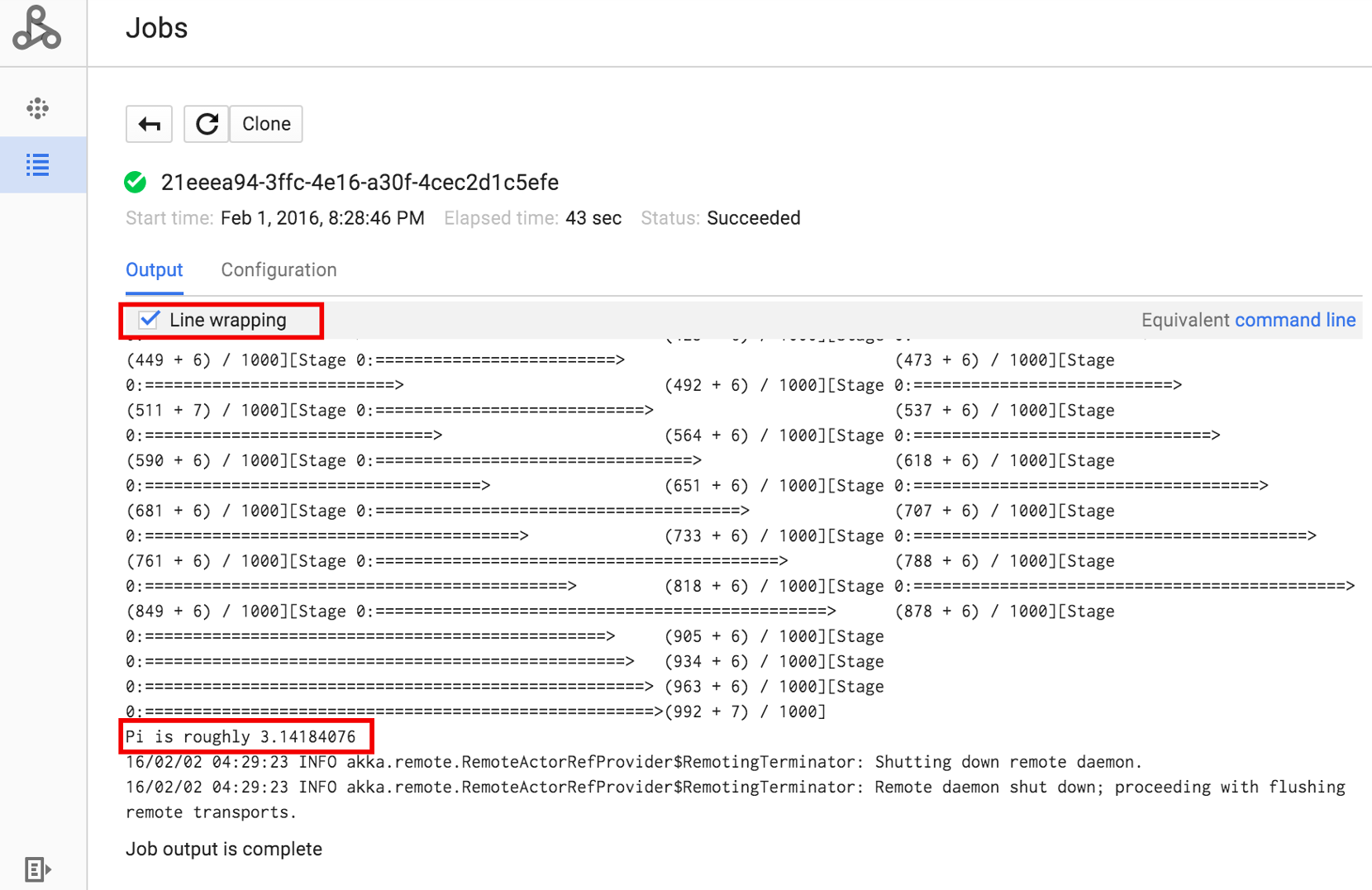

Haz clic en el ID del trabajo para abrir la página Jobs, en la que podrás ver el resultado del controlador del trabajo. Dado que este trabajo produce líneas de resultado largas que superan el ancho de la ventana del navegador, puedes marcar la casilla Ajuste de línea para ver todo el texto de resultado y mostrar el resultado calculado de pi.

Puedes ver el resultado del controlador de tu trabajo desde la línea de comandos con el comando gcloud dataproc jobs Wait que se muestra a continuación (para obtener más información, consulta Ver el resultado del trabajo: COMANDO DE GCLOUD).

Copia y pega tu ID del proyecto como el valor de la marca --project y tu ID de trabajo (que aparece en la lista de trabajos) como argumento final.

gcloud dataproc jobs wait job-id \ --project=project-id \ --region=region

Aquí hay fragmentos del resultado del controlador para el trabajo de muestra de SparkPi que se envió con anterioridad:

... 2015-06-25 23:27:23,810 INFO [dag-scheduler-event-loop] scheduler.DAGScheduler (Logging.scala:logInfo(59)) - Stage 0 (reduce at SparkPi.scala:35) finished in 21.169 s 2015-06-25 23:27:23,810 INFO [task-result-getter-3] cluster.YarnScheduler (Logging.scala:logInfo(59)) - Removed TaskSet 0.0, whose tasks have all completed, from pool 2015-06-25 23:27:23,819 INFO [main] scheduler.DAGScheduler (Logging.scala:logInfo(59)) - Job 0 finished: reduce at SparkPi.scala:35, took 21.674931 s Pi is roughly 3.14189648 ... Job [c556b47a-4b46-4a94-9ba2-2dcee31167b2] finished successfully. driverOutputUri: gs://sample-staging-bucket/google-cloud-dataproc-metainfo/cfeaa033-749e-48b9-... ...

gcloud

Para enviar un trabajo a un clúster de Dataproc, ejecuta el comando gcloud dataproc jobs submit de gcloud CLI de forma local en una ventana de terminal o en Cloud Shell.

gcloud dataproc jobs submit job-command \ --cluster=cluster-name \ --region=region \ other dataproc-flags \ -- job-argsEjemplo de envío de un trabajo de PySpark

- Muestra el

hello-world.pyde acceso público ubicado en Cloud Storage.gsutil cat gs://dataproc-examples/pyspark/hello-world/hello-world.py

A continuación, se muestra la lista de archivos:#!/usr/bin/python import pyspark sc = pyspark.SparkContext() rdd = sc.parallelize(['Hello,', 'world!']) words = sorted(rdd.collect()) print(words)

- Envía el trabajo de Pyspark a Dataproc.

gcloud dataproc jobs submit pyspark \ gs://dataproc-examples/pyspark/hello-world/hello-world.py \ --cluster=cluster-name \ --region=region

A continuación, se muestra el resultado de la terminal:Waiting for job output... … ['Hello,', 'world!'] Job finished successfully.

- Ejecuta el ejemplo de SparkPi preinstalado en el nodo principal del clúster de Dataproc.

gcloud dataproc jobs submit spark \ --cluster=cluster-name \ --region=region \ --class=org.apache.spark.examples.SparkPi \ --jars=file:///usr/lib/spark/examples/jars/spark-examples.jar \ -- 1000

A continuación, se muestra el resultado de la terminal:Job [54825071-ae28-4c5b-85a5-58fae6a597d6] submitted. Waiting for job output… … Pi is roughly 3.14177148 … Job finished successfully. …

REST

En esta sección, se muestra cómo enviar un trabajo de Spark para calcular el valor aproximado de pi con la API jobs.submit de Dataproc.

Antes de usar cualquiera de los datos de solicitud a continuación, realiza los siguientes reemplazos:

- project-id: ID del proyecto de Google Cloud

- region: región del clúster

- clusterName: nombre del clúster

Método HTTP y URL:

POST https://dataproc.googleapis.com/v1/projects/project-id/regions/region/jobs:submit

Cuerpo JSON de la solicitud:

{

"job": {

"placement": {

"clusterName": "cluster-name"

},

},

"sparkJob": {

"args": [

"1000"

],

"mainClass": "org.apache.spark.examples.SparkPi",

"jarFileUris": [

"file:///usr/lib/spark/examples/jars/spark-examples.jar"

]

}

}

}

Para enviar tu solicitud, expande una de estas opciones:

Deberías recibir una respuesta JSON similar a la que se muestra a continuación:

{

"reference": {

"projectId": "project-id",

"jobId": "job-id"

},

"placement": {

"clusterName": "cluster-name",

"clusterUuid": "cluster-Uuid"

},

"sparkJob": {

"mainClass": "org.apache.spark.examples.SparkPi",

"args": [

"1000"

],

"jarFileUris": [

"file:///usr/lib/spark/examples/jars/spark-examples.jar"

]

},

"status": {

"state": "PENDING",

"stateStartTime": "2020-10-07T20:16:21.759Z"

},

"jobUuid": "job-Uuid"

}

Java

Python

Go

Node.js

Envía un trabajo directamente en tu clúster

Si deseas ejecutar un trabajo directamente en tu clúster sin usar el servicio de Dataproc, establece una conexión SSH al nodo principal de tu clúster y, luego, ejecuta el trabajo en ese nodo.

Luego de establecer una conexión SSH a la instancia principal de VM, ejecuta comandos en una ventana de terminal en el nodo principal del clúster para realizar las siguientes acciones:

- Abrir una shell de Spark

- Ejecutar un trabajo de Spark simple para contar la cantidad de líneas en un archivo “hello-world” de Python (de siete líneas) ubicado en un archivo accesible de manera pública en Cloud Storage

Salir de la shell

user@cluster-name-m:~$ spark-shell ... scala> sc.textFile("gs://dataproc-examples" + "/pyspark/hello-world/hello-world.py").count ... res0: Long = 7 scala> :quit

Ejecuta trabajos de bash en Dataproc

Es posible que desees ejecutar una secuencia de comandos Bash como tu trabajo de Dataproc, ya sea porque los motores que usas no son compatibles como un tipo de trabajo de Dataproc de nivel superior o porque necesitas realizar una configuración o cálculo adicional de argumentos antes iniciar un trabajo mediante hadoop o spark-submit desde tu secuencia de comandos.

Ejemplo de pig

Supongamos que copiaste una secuencia de comandos bash hello.sh en Cloud Storage:

gsutil cp hello.sh gs://${BUCKET}/hello.sh

Dado que el comando pig fs usa rutas de Hadoop, copia la secuencia de comandos de Cloud Storage en un destino especificado como file:/// para asegurarte de que esté en el sistema de archivos local, en lugar de HDFS. Los comandos sh posteriores hacen referencia al sistema de archivos local de forma automática y no requieren el prefijo file:///.

gcloud dataproc jobs submit pig --cluster=${CLUSTER} --region=${REGION} \

-e='fs -cp -f gs://${BUCKET}/hello.sh file:///tmp/hello.sh; sh chmod 750 /tmp/hello.sh; sh /tmp/hello.sh'

De manera alternativa, como los trabajos de Dataproc envían un archivo a etapa de argumento --jars en un directorio temporal creado durante la vida útil del trabajo, puedes especificar tu secuencia de comandos de shell de Cloud Storage como argumento --jars:

gcloud dataproc jobs submit pig --cluster=${CLUSTER} --region=${REGION} \

--jars=gs://${BUCKET}/hello.sh \

-e='sh chmod 750 ${PWD}/hello.sh; sh ${PWD}/hello.sh'

Ten en cuenta que el argumento --jars también puede hacer referencia a una secuencia de comandos local:

gcloud dataproc jobs submit pig --cluster=${CLUSTER} --region=${REGION} \

--jars=hello.sh \

-e='sh chmod 750 ${PWD}/hello.sh; sh ${PWD}/hello.sh'