Cloud Monitoring vous offre une réelle visibilité sur les performances, le temps d'activité et l'état général de vos applications cloud. La suite Operations Google Cloud collecte et ingère des métriques, des événements et des métadonnées à partir de clusters Dataproc, y compris les métriques HDFS, YARN et de tâche par cluster, afin de générer des insights via des tableaux de bord et des graphiques (voir Métriques Dataproc Cloud Monitoring).

Utilisez les métriques de cluster Cloud Monitoring pour surveiller les performances et l'état des clusters Dataproc.

Consultez la page Tarifs Cloud Monitoring pour comprendre vos coûts.

Consultez la section Quotas et limites de Monitoring pour obtenir plus d'informations sur la conservation des données métriques.

Métriques de cluster Dataproc

Dataproc collecte les métriques de ressources du cluster que vous pouvez afficher dans Monitoring.

Afficher les métriques du cluster

Vous pouvez examiner Monitoring depuis la console Google Cloud ou à l'aide de l'API Monitoring.

Console

-

Après avoir créé un cluster, accédez à Monitoring dans la console Google Cloud pour afficher les données de surveillance du cluster.

Une fois la console Monitoring affichée, vous pouvez installer l'agent Monitoring sur les VM de votre projet comme étape de configuration supplémentaire. Il n'est pas nécessaire d'installer l'agent sur les VM des clusters Dataproc, car cette étape est effectuée automatiquement lorsque vous créez un cluster Dataproc.

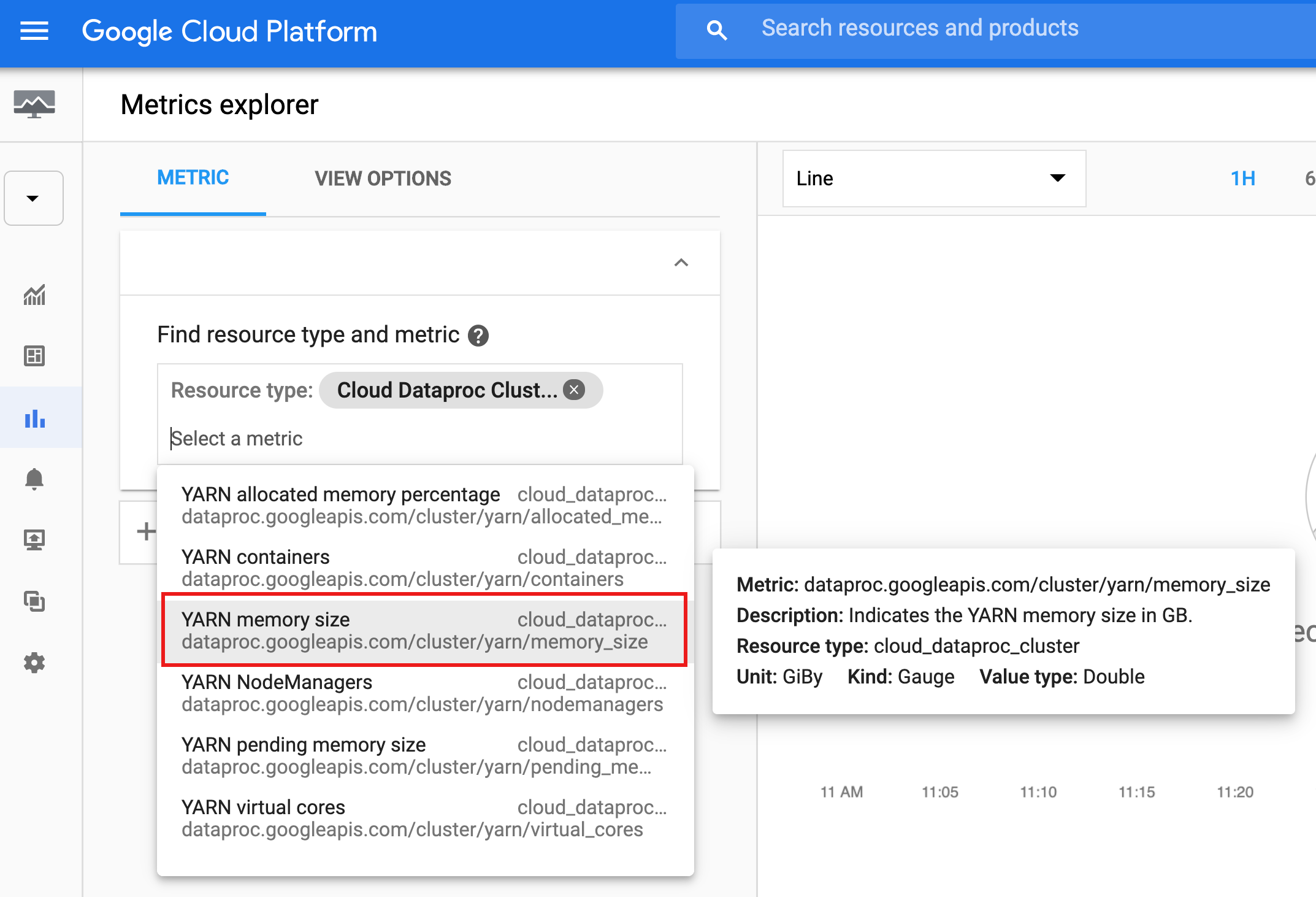

- Sélectionnez Metrics Explorer (Explorateur de métriques). Dans la liste déroulante "Find resource type and metric" (Rechercher un type de ressource et une métrique), sélectionnez la ressource "Cloud Dataproc Cluster" (Cluster Cloud Dataproc) ou saisissez "cloud_dataproc_cluster" dans la zone.

- Cliquez à nouveau dans la zone de saisie, puis sélectionnez une métrique dans la liste déroulante.

Dans la capture d'écran suivante, la métrique "YARN memory size" (Taille de mémoire YARN) est sélectionnée. Passez la souris sur le nom de la métrique pour afficher des informations la concernant.

Vous pouvez sélectionner des filtres, regrouper des métriques par libellés, effectuer des agrégations et sélectionner les options d'affichage des graphiques (consultez la documentation Monitoring).

API

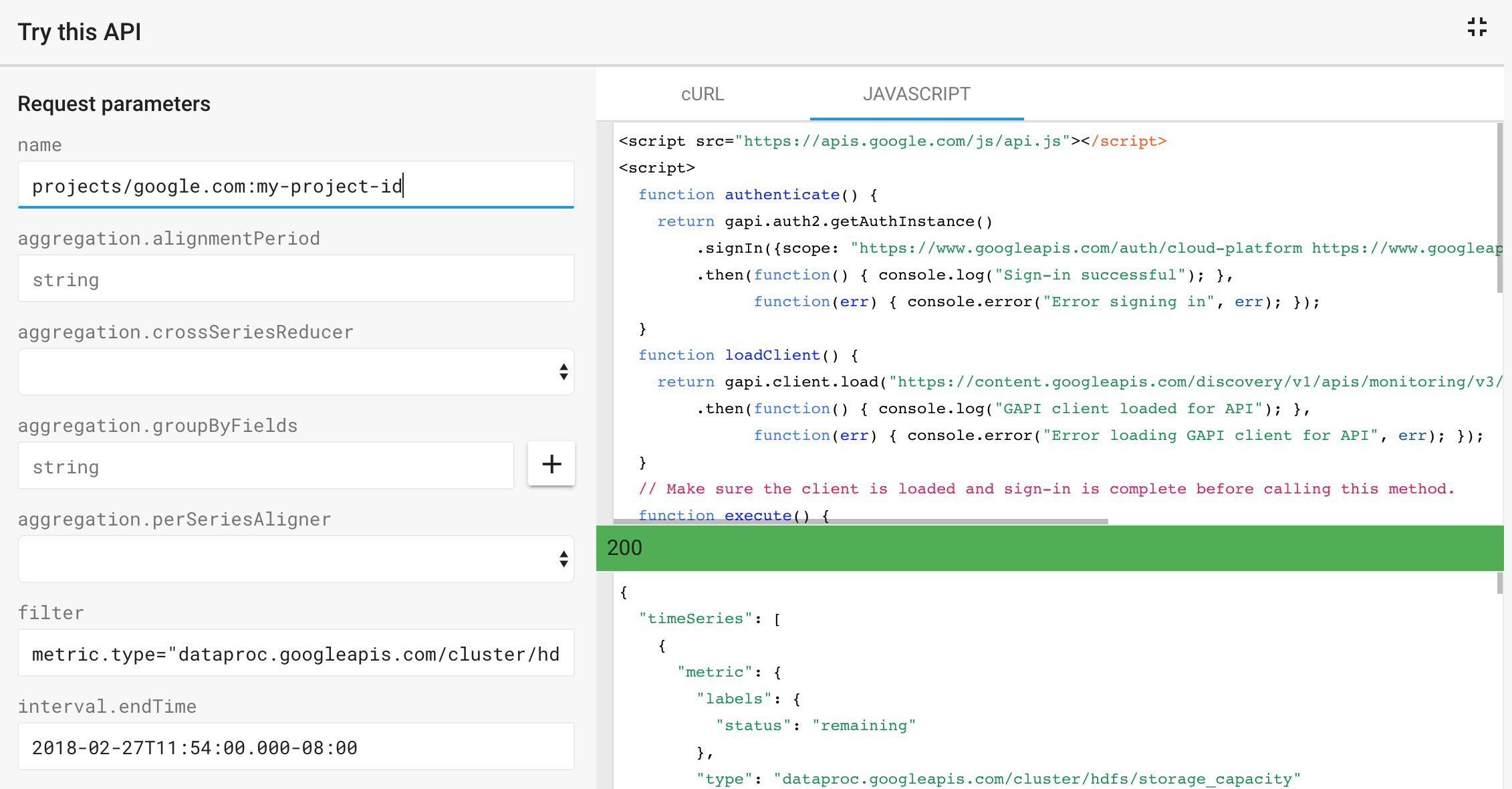

Vous pouvez utiliser l'API Monitoring timeSeries.list pour enregistrer et répertorier les métriques définies par une expression filter.

Utilisez le modèle Try this API (Essayer cette API) sur la page de l'API pour envoyer une requête API et afficher la réponse.

Exemple : Voici un instantané d'une requête modélisée et la réponse JSON renvoyée pour les paramètres timeSeries.list Monitoring suivants :

- name : projects/example-project-id

- filter : metric.type="dataproc.googleapis.com/cluster/hdfs/storage_capacity"

- interval.endTime : 2018-02-27T11:54:00.000-08:00

- interval.startTime : 2018-02-20T00:00:00.000-08:00

Métriques OSS

Vous pouvez autoriser Dataproc à collecter les métriques des composants OSS du cluster à afficher dans Monitoring. Les métriques Dataproc OSS sont collectées au format suivant:

custom.googleapis.com/OSS_COMPONENT/METRIC

Exemples de métriques OSS:

custom.googleapis.com/spark/driver/DAGScheduler/job/allJobs custom.googleapis.com/hiveserver2/memory/MaxNonHeapMemory

Métriques OSS disponibles

Vous pouvez autoriser Dataproc à collecter les métriques OSS répertoriées dans les tableaux suivants. La colonne Collecte par défaut est marquée "y" si Dataproc collecte la métrique par défaut lorsque vous activez la source de métrique associée. Toutes les métriques répertoriées pour une source de métriques, ainsi que toutes les métriques Spark, peuvent être activées pour la collecte si vous remplacez la collection des métriques par défaut pour la source de métriques (consultez Activer la collecte de métriques OSS).

Métriques Hadoop

Métriques HDFS

| Métrique | Nom de l'explorateur de métriques | Collecté par défaut |

|---|---|---|

| hdfs:NameNode:FSNamesystem:CapacityTotalGB | dfs/FSNamesystem/CapacityTotalGB | y |

| hdfs:NameNode:FSNamesystem:CapacityUsedGB | dfs/FSNamesystem/CapacityUsedGB | y |

| hdfs:NameNode:FSNamesystem:Capacity remainingGB | dfs/FSNamesystem/Capacity remainingGB | y |

| hdfs:NameNode:FSNamesystem:FilesTotal | dfs/FSNamesystem/FilesTotal | y |

| hdfs:NameNode:FSNamesystem:MissingBlocks | dfs/FSNamesystem/MissingBlocks | n |

| hdfs:NameNode:FSNamesystem:ArrivéeHeartbeats | dfs/FSNamesystem/expireHeartbeats | n |

| hdfs:NameNode:FSNamesystem:TransactionsSinceLastCheckpoint | dfs/FSNamesystem/TransactionsSinceLastCheckpoint | n |

| hdfs:NameNode:FSNamesystem:TransactionsSinceLastLogRoll | dfs/FSNamesystem/TransactionsSinceLastLogRoll | n |

| hdfs:NameNode:FSNamesystem:LastWriteTransactionId | dfs/FSNamesystem/LastWriteTransactionId | n |

| hdfs:NameNode:FSNamesystem:CapacityTotal | dfs/FSNamesystem/CapacityTotal | n |

| hdfs:NameNode:FSNamesystem:CapacityUsed | dfs/FSNamesystem/CapacityUsed | n |

| hdfs:NameNode:FSNamesystem:Capacity remaining | dfs/FSNamesystem/Capacity remaining | n |

| hdfs:NameNode:FSNamesystem:CapacityUsedNonDFS | dfs/FSNamesystem/CapacityUsedNonDFS | n |

| hdfs:NameNode:FSNamesystem:TotalLoad | dfs/FSNamesystem/TotalLoad | n |

| hdfs:NameNode:FSNamesystem:SnapshottableDirectories | dfs/FSNamesystem/SnapshottableDirectories | n |

| hdfs:NameNode:FSNamesystem:Snapshots | dfs/FSNamesystem/Snapshots | n |

| hdfs:NameNode:FSNamesystem:BlocksTotal | dfs/FSNamesystem/BlocksTotal | n |

| hdfs:NameNode:FSNamesystem:PendingReplicationBlocks | dfs/FSNamesystem/PendingReplicationBlocks | n |

| hdfs:NameNode:FSNamesystem:UnderReplicatedBlocks | dfs/FSNamesystem/UnderReplicatedBlocks | n |

| hdfs:NameNode:FSNamesystem:CorruptBlocks | dfs/FSNamesystem/CorruptBlocks | n |

| hdfs:NameNode:FSNamesystem:ScheduledReplicationBlocks | dfs/FSNamesystem/ScheduledReplicationBlocks | n |

| hdfs:NameNode:FSNamesystem:PendingDeletionBlocks | dfs/FSNamesystem/PendingDeletionBlocks | n |

| hdfs:NameNode:FSNamesystem:ExcessBlocks | dfs/FSNamesystem/ExcessBlocks | n |

| hdfs:NameNode:FSNamesystem:PostponedMisreplicatedBlocks | dfs/FSNamesystem/PostponedMisreplicatedBlocks | n |

| hdfs:NameNode:FSNamesystem:PendingDataNodeMessageCourt | dfs/FSNamesystem/PendingDataNodeMessageCourt | n |

| hdfs:NameNode:FSNamesystem:MillisSinceLastLoadedEdits | dfs/FSNamesystem/MillisSinceLastLoadedEdits | n |

| hdfs:NameNode:FSNamesystem:BlockCapacity | dfs/FSNamesystem/BlockCapacity | n |

| hdfs:NameNode:FSNamesystem:StaleDataNodes | dfs/FSNamesystem/StaleDataNodes | n |

| hdfs:NameNode:FSNamesystem:TotalFiles | dfs/FSNamesystem/TotalFiles | n |

| hdfs:NameNode:JvmMetrics:MemHeapUsedM | dfs/jvm/MemHeapUsedM | n |

| hdfs:NameNode:JvmMetrics:MemHeapCommittedM | dfs/jvm/MemHeapCommittedM | n |

| hdfs:NameNode:JvmMetrics:MemHeapMaxM | dfs/jvm/MemHeapMaxM | n |

| hdfs:NameNode:JvmMetrics:MemMaxM | dfs/jvm/MemMaxM | n |

Métriques YARN

| Métrique | Nom de l'explorateur de métriques | Collecté par défaut |

|---|---|---|

| yarn:ResourceManager:ClusterMetrics:NumNAM | yarn/ClusterMetrics/NumActiveNM | y |

| yarn:ResourceManager:ClusterMetrics:NombreDeNCM | yarn/ClusterMetrics/NumDemissionNM | n |

| yarn:ResourceManager:ClusterMetrics:NumNMN | yarn/ClusterMetrics/NumLostNM | n |

| yarn:ResourceManager:ClusterMetrics:NumUnhealthyNM | yarn/ClusterMetrics/NumUnhealthyNM | n |

| yarn:ResourceManager:ClusterMetrics:NumRedémarreredNM | yarn/ClusterMetrics/NumRestarted NM | n |

| yarn:ResourceManager:QueueMetrics:running_0 | yarn/QueueMetrics/running_0 | y |

| yarn:ResourceManager:QueueMetrics:running_60 | yarn/QueueMetrics/running_60 | y |

| yarn:ResourceManager:QueueMetrics:running_300 | yarn/QueueMetrics/running_300 | y |

| yarn:ResourceManager:QueueMetrics:running_1440 (en anglais) | yarn/QueueMetrics/running_1440 | y |

| yarn:ResourceManager:QueueMetrics:ApplicationsEnvoyées | yarn/QueueMetrics/AppsEnvoyé | y |

| yarn:ResourceManager:QueueMetrics:AvailableMB | yarn/QueueMetrics/AvailableMo | y |

| yarn:ResourceManager:QueueMetrics:PendingContainers | yarn/QueueMetrics/PendingContainers | y |

| yarn:ResourceManager:QueueMetrics:ApplicationsEn cours d'exécution | yarn/QueueMetrics/AppsRunning | n |

| yarn:ResourceManager:QueueMetrics:AppsEn attente | yarn/QueueMetrics/AppsPending | n |

| yarn:ResourceManager:QueueMetrics:ApplicationsTerminées | yarn/QueueMetrics/AppsCompleted | n |

| yarn:ResourceManager:QueueMetrics:ApplicationsKilled | yarn/QueueMetrics/AppsKilled | n |

| yarn:ResourceManager:QueueMetrics:ApplicationsÉchec | yarn/QueueMetrics/AppsFailed | n |

| yarn:ResourceManager:QueueMetrics:AllocaliséMo | yarn/QueueMetrics/AllocalizedMB | n |

| yarn:ResourceManager:QueueMetrics:AllocationVCores | yarn/QueueMetrics/AllocalizedVCores | n |

| yarn:ResourceManager:QueueMetrics:AllocationContainers | yarn/QueueMetrics/AllocalizedContainers | n |

| yarn:ResourceManager:QueueMetrics:AggregateContainersAllocalized | yarn/QueueMetrics/AggregateContainersAllocalized | n |

| yarn:ResourceManager:QueueMetrics:AggregateContainersReleased (en anglais) | yarn/QueueMetrics/AggregateContainersReleased | n |

| yarn:ResourceManager:QueueMetrics:AvailableVCores | yarn/QueueMetrics/AvailableVCores | n |

| yarn:ResourceManager:QueueMetrics:PendingMB | yarn/QueueMetrics/PendingMB | n |

| yarn:ResourceManager:QueueMetrics:PendingVCores | yarn/QueueMetrics/PendingVCores | n |

| yarn:ResourceManager:QueueMetrics:Réservé Mo | yarn/QueueMetrics/Réservé Mo | n |

| yarn:ResourceManager:QueueMetrics:RéservéVCVCs | yarn/QueueMetrics/RéservéVCores | n |

| yarn:ResourceManager:QueueMetrics:ReserveContainers | yarn/QueueMetrics/RéservéContainers | n |

| yarn:ResourceManager:QueueMetrics:ActiveUsers | yarn/QueueMetrics/ActiveUsers | n |

| yarn:ResourceManager:QueueMetrics:ActiveApplications | yarn/QueueMetrics/ActiveApplications | n |

| yarn:ResourceManager:QueueMetrics:FairShareMB | yarn/QueueMetrics/FairShareMB | n |

| yarn:ResourceManager:QueueMetrics:FairShareVCores | yarn/QueueMetrics/FairShareVCores | n |

| yarn:ResourceManager:QueueMetrics:MinShareMB | yarn/QueueMetrics/MinShareMB | n |

| yarn:ResourceManager:QueueMetrics:MinShareVCores | yarn/QueueMetrics/MinShareVCores | n |

| yarn:ResourceManager:QueueMetrics:MaxShareMB | yarn/QueueMetrics/MaxShareMB | n |

| yarn:ResourceManager:QueueMetrics:MaxShareVCores | yarn/QueueMetrics/MaxShareVCores | n |

| yarn:ResourceManager:JvmMetrics:MemHeapUsedM | yarn/jvm/MemHeapUsedM | n |

| yarn:ResourceManager:JvmMetrics:MemHeapCommittedM | fil/jvm/MemHeapCommittedM | n |

| yarn:ResourceManager:JvmMetrics:MemHeapMaxM | yarn/jvm/MemHeapMaxM | n |

| yarn:ResourceManager:JvmMetrics:MemMaxM | yarn/jvm/MemMaxM | n |

Métriques Spark

Métriques de pilote Spark

| Métrique | Nom de l'explorateur de métriques | Collecté par défaut |

|---|---|---|

| spark:driver:BlockManager:disk.diskSpaceUsed_MB | spark/driver/BlockManager/disk/diskSpaceUsed_MB | y |

| spark:driver:BlockManager:memory.maxMem_MB | spark/driver/BlockManager/memory/maxMem_MB | y |

| spark:driver:BlockManager:memory.memUsed_MB | spark/driver/BlockManager/memory/memUsed_MB | y |

| spark:driver:DAGScheduler:job.allJobs | spark/driver/DAGScheduler/job/allJobs | y |

| spark:driver:DAGScheduler:stage.failedStages (en anglais) | spark/driver/DAGScheduler/stage/failedStages | y |

| spark:driver:DAGScheduler:stage.waitingStages (en anglais) | spark/driver/DAGScheduler/stage/waitingStages | y |

Métriques de l'exécuteur Spark

| Métrique | Nom de l'explorateur de métriques | Collecté par défaut |

|---|---|---|

| spark:executor:executor:bytesRead | spark/executor/bytesRead | y |

| spark:executor:executor:bytesBytes | spark/executor/bytesBytes | y |

| spark:executor:executor:cpuTime | spark/executor/cpuTime | y |

| spark:executor:executor:diskBytesSpilled | spark/executor/diskBytesSpilled | y |

| spark:executor:executor:recordsRead | spark/executor/recordsRead | y |

| spark:executor:executor:recordsécrit | spark/executor/recordsécrit | y |

| spark:executor:executor:runTime | spark/executor/runTime | y |

| spark:executor:executor:shuffleRecordsRead | spark/executor/shuffleRecordsRead | y |

| spark:executor:executor:shuffleRecordsÉcriture | spark/executor/shuffleRecordsÉcriture | y |

Métriques du serveur d'historique Spark

Dataproc collecte les métriques de mémoire JVM suivantes du service d'historique Spark:

| Métrique | Nom de l'explorateur de métriques | Collecté par défaut |

|---|---|---|

| sparkHistoryServer:JVM:Memory:HeapMemoryUsage.commitmit | sparkHistoryServer/memory/CommittedHeapMemory | y |

| sparkHistoryServer:JVM:Memory:HeapMemoryUsage.used | sparkHistoryServer/memory/UsedHeapMemory | y |

| sparkHistoryServer:JVM:Memory:HeapMemoryUsage.max | sparkHistoryServer/memory/MaxHeapMemory | y |

| sparkHistoryServer:JVM:Memory:NonHeapMemoryUsage.commitmit | sparkHistoryServer/memory/CommittedNonHeapMemory | y |

| sparkHistoryServer:JVM:Memory:NonHeapMemoryUsage.used | sparkHistoryServer/memory/UsedNonHeapMemory | y |

| sparkHistoryServer:JVM:Memory:NonHeapMemoryUsage.max | sparkHistoryServer/memory/MaxNonHeapMemory | y |

Métriques HiveServer 2

| Métrique | Nom de l'explorateur de métriques | Collecté par défaut |

|---|---|---|

| hiveserver2:JVM:Memory:HeapMemoryUsage.commitmit | hiveserver2/memory/CommittedHeapMemory | y |

| hiveserver2:JVM:Memory:HeapMemoryUsage.used | serveurv2/mémoire/mémoireHeap | y |

| hiveserver2:JVM:Memory:HeapMemoryUsage.max | serveur_hive2/mémoire/maxHeapMemory | y |

| hiveserver2:JVM:Memory:NonHeapMemoryUsage.commitmit | hiveserver2/memory/CommittedNonHeapMemory | y |

| hiveserver2:JVM:Memory:NonHeapMemoryUsage.used | hiveserver2/memory/UsedNonHeapMemory | y |

| hiveserver2:JVM:Memory:NonHeapMemoryUsage.max | hiveserver2/memory/MaxNonHeapMemory | y |

Métriques Hive Metastore

| Métrique | Nom de l'explorateur de métriques | Collecté par défaut |

|---|---|---|

| hivemetastore:API:GetDatabase:Mean | hivemetastore/get_database/moyenne | y |

| hivemetastore:API:CreateDatabase:Mean | hivemetastore/create_database/moyenne | y |

| hivemetastore:API:DropDatabase:Mean | hivemetastore/drop_database/moyenne | y |

| hivemetastore:API:AlterDatabase:Mean | hivemetastore/alter_database/moyenne | y |

| hivemetastore:API:GetAllDatabases:Mean | hivemetastore/get_all_databases/mean | y |

| hivemetastore:API:CreateTable:Mean | mivemetastore/create_table/an | y |

| hivemetastore:API:DropTable:Mean | mivemetastore/drop_table/mean | y |

| hivemetastore:API:AlterTable:Mean | mivemetastore/alter_table/mean | y |

| hivemetastore:API:GetTable:Mean | mivemetastore/get_table/mean | y |

| hivemetastore:API:GetAllTables:Mean | mivemetastore/get_all_tables/an | y |

| hivemetastore:API:AddPartitionsReq:moyenne | hivemetastore/add_partitions_req/mean | y |

| hivemetastore:API:DropPartition:Mean | hivemetastore/drop_partition/mean | y |

| hivemetastore:API:AlterPartition:moyenne | hivemetastore/alter_partition/mean | y |

| hivemetastore:API:GetPartition:Moyenne | hivemetastore/get_partition/mean | y |

| hivemetastore:API:GetPartitionNames:Mean | hivemetastore/get_partition_names/moyenne | y |

| hivemetastore:API:GetPartitionsPs:Mean | hivemetastore/get_partitions_ps/moyenne | y |

| hivemetastore:API:GetPartitionsPsWithAuth:Mean | hivemetastore/get_partitions_ps_with_auth/mean | y |

Mesures des métriques Hive Metastore

| Mesure statistique | Exemple de métrique | Exemple de nom de métrique |

|---|---|---|

| Max | hivemetastore:API:GetDatabase:Max | hivemetastore/get_database/max |

| Min | hivemetastore:API:GetDatabase:Min | hivemetastore/get_database/min |

| Moyenne | hivemetastore:API:GetDatabase:Mean | hivemetastore/get_database/moyenne |

| Nombre | hivemetastore:API:GetDatabase:Count | hivemetastore/get_database/count |

| 50e centile | hivemetastore:API:GetDatabase:50thPercentile | hivemetastore/get_database/médiane |

| 75e centile | hivemetastore:API:GetDatabase:75thPercentile | hivemetastore/get_database/75th_percentile |

| 95e centile | hivemetastore:API:GetDatabase:95thPercentile | hivemetastore/get_database/95e_centile |

| 98e centile | hivemetastore:API:GetDatabase:98thPercentile | hivemetastore/get_database/98e_centile |

| 99e centile | hivemetastore:API:GetDatabase:99thPercentile | hivemetastore/get_database/99e_centile |

| 999e centile | hivemetastore:API:GetDatabase:999thPercentile | hivemetastore/get_database/999e_centile |

| StdDev | hivemetastore:API:GetDatabase:StdDev | hivemetastore/get_database/stddev |

| Taux de quinze minutes | hivemetastore:API:GetDatabase:FifteenMinuteRate | hivemetastore/get_database/15min_rate |

| Taux de 5 minutes | hivemetastore:API:GetDatabase:FiveMinuteRate | hivemetastore/get_database/5_min_rate |

| Taux d'une minute | hivemetastore:API:GetDatabase:OneMinuteRate | hivemetastore/get_database/1_min_rate |

| Taux moyen | hivemetastore:API:GetDatabase:MeanRate | hivemetastore/get_database/taux_moyen |

Métriques de l'agent de surveillance Dataproc

Par défaut, Dataproc collecte les métriques par défaut de l'agent de surveillance Dataproc suivantes, publiées avec le préfixe agent.googleapis.com:

Processeur

agent.googleapis.com/cpu/load_15m

agent.googleapis.com/cpu/load_1m

agent.googleapis.com/cpu/load_5m

agent.googleapis.com/cpu/usage_time*

agent.googleapis.com/cpu/utilization*

Disque

agent.googleapis.com/disk/bytes_used

agent.googleapis.com/disk/io_time

agent.googleapis.com/disk/merged_operations

agent.googleapis.com/disk/operation_count

agent.googleapis.com/disk/operation_time

agent.googleapis.com/disk/pending_operations

agent.googleapis.com/disk/percent_used

Échange

agent.googleapis.com/swap/bytes_used

agent.googleapis.com/swap/io

agent.googleapis.com/swap/percent_used

Mémoire

agent.googleapis.com/memory/bytes_used

agent.googleapis.com/memory/percent_used

Processus - (respecte une règle de quota légèrement différente pour quelques attributs)

agent.googleapis.com/processes/count_by_state

agent.googleapis.com/processes/cpu_time

agent.googleapis.com/processes/disk/read_bytes_count

agent.googleapis.com/processes_disk/write_bytes_count

agent.googleapis.com/processes/googleapis.com

Interface

agent.googleapis.com/interface/errors

agent.googleapis.com/interface/packets

agent.googleapis.com/interface/traffic

Réseau

agent.googleapis.com/network/tcp_connections

Activer la collecte de métriques OSS

Lorsque vous créez un cluster Dataproc, vous pouvez utiliser gcloud CLI ou l'API Dataproc pour activer la collecte des métriques OSS de deux manières (vous pouvez utiliser l'une des méthodes de collecte ou les deux):

- Activez la collecte des métriques par défaut uniquement à partir d'une ou de plusieurs sources de métriques OSS.

- Activer la collecte des métriques spécifiées ("remplacer") depuis une ou plusieurs sources de métriques OSS

Commande gcloud

Collecte de métriques par défaut

Utilisez l'option gcloud dataproc clusters create --metric-sources pour activer la collecte des métriques OSS disponibles par défaut à partir d'une ou de plusieurs sources de métriques.

gcloud dataproc clusters create cluster-name \ --metric-sources=METRIC_SOURCE(s) \ ... other flags

Remarques :

--metric-sources: obligatoire pour activer la collecte de métriques par défaut. Spécifiez une ou plusieurs des sources de métriques suivantes :spark,hdfs,yarn,spark-history-server,hiveserver2,hivemetastoreetmonitoring-agent-defaults. Le nom de la source de la métrique n'est pas sensible à la casse (par exemple, "yarn" ou "YARN" est acceptable).

Ignorer la collecte de métriques

Vous pouvez également ajouter l'option --metric-overrides ou --metric-overrides-file pour permettre la collecte d'une ou plusieurs métriques OSS disponibles à partir d'une ou de plusieurs sources de métriques.

-

Toutes les métriques OSS disponibles et toutes les métriques Spark peuvent être répertoriées pour la collecte en tant que remplacement de métrique. Les valeurs des métriques de remplacement sont sensibles à la casse et doivent être fournies, le cas échéant, au format CamelCase.

Examples

sparkHistoryServer:JVM:Memory:NonHeapMemoryUsage.committedhiveserver2:JVM:Memory:NonHeapMemoryUsage.usedyarn:ResourceManager:JvmMetrics:MemHeapMaxM

-

Seules les métriques remplacées seront collectées à partir d'une source de métrique donnée. Par exemple, si une ou plusieurs métriques

spark:executivesont listées comme remplacements de métriques, les autres métriquesSPARKne seront pas collectées. La collecte des métriques OSS par défaut à partir d'autres sources de métriques n'est pas affectée. Par exemple, si les sources de métriquesSPARKetYARNsont activées, et que des forçages sont fournis uniquement pour les métriques Spark, toutes les métriques YARN sont collectées par défaut. -

La source du remplacement de métrique spécifié doit être activée. Par exemple, si une ou plusieurs métriques

spark:driversont fournies en tant que remplacements de métriques, la source de métriquesparkdoit être activée (--metric-sources=spark).

Remplacer la liste des métriques

gcloud dataproc clusters create cluster-name \ --metric-sources=METRIC_SOURCE(s) \ --metric-overrides=LIST_OF_METRIC_OVERRIDES \ ... other flags

Remarques :

--metric-sources: obligatoire pour activer la collecte de métriques par défaut. Spécifiez une ou plusieurs des sources de métriques suivantes :spark,hdfs,yarn,spark-history-server,hiveserver2,hivemetastoreetmonitoring-agent-defaults. Le nom de la source de la métrique n'est pas sensible à la casse. Par exemple, vous pouvez utiliser "yarn" ou "YARN".--metric-overrides: fournissez une liste de métriques au format suivant:METRIC_SOURCE:INSTANCE:GROUP:METRIC

Exemple :

--metric-overrides=sparkHistoryServer:JVM:Memory:NonHeapMemoryUsage.committed- Cette option est une alternative à et ne peut pas être utilisée avec l'option

--metric-overrides-file.

Remplacer le fichier de métriques

gcloud dataproc clusters create cluster-name \ --metric-sources=METRIC-SOURCE(s) \ --metric-overrides-file=METRIC_OVERRIDES_FILENAME \ ... other flags

Remarques :

-

--metric-sources: obligatoire pour activer la collecte de métriques par défaut. Spécifiez une ou plusieurs des sources de métriques suivantes:spark,hdfs,yarn,spark-history-server,hiveserver2,hivemetastoreetmonitoring-agent-defaults. Le nom de la source de la métrique n'est pas sensible à la casse. Par exemple, vous pouvez utiliser "yarn" ou "YARN". -

--metric-overrides-file: spécifiez un fichier local ou Cloud Storage (gs://bucket/filename) contenant une ou plusieurs métriques au format suivant:METRIC_SOURCE :INSTANCE :GROUP :METRIC

Utilisez le format camelcase le cas échéant.Examples

--metric-overrides-file=gs://my-bucket/my-filename.txt--metric-overrides-file=./local-directory/local-filename.txt

- Cette option est une alternative à et ne peut pas être utilisée avec l'option

--metric-overrides.

API REST

Utilisez DataprocMetricConfig dans le cadre d'une requête clusters.create pour activer la collecte de métriques OSS.

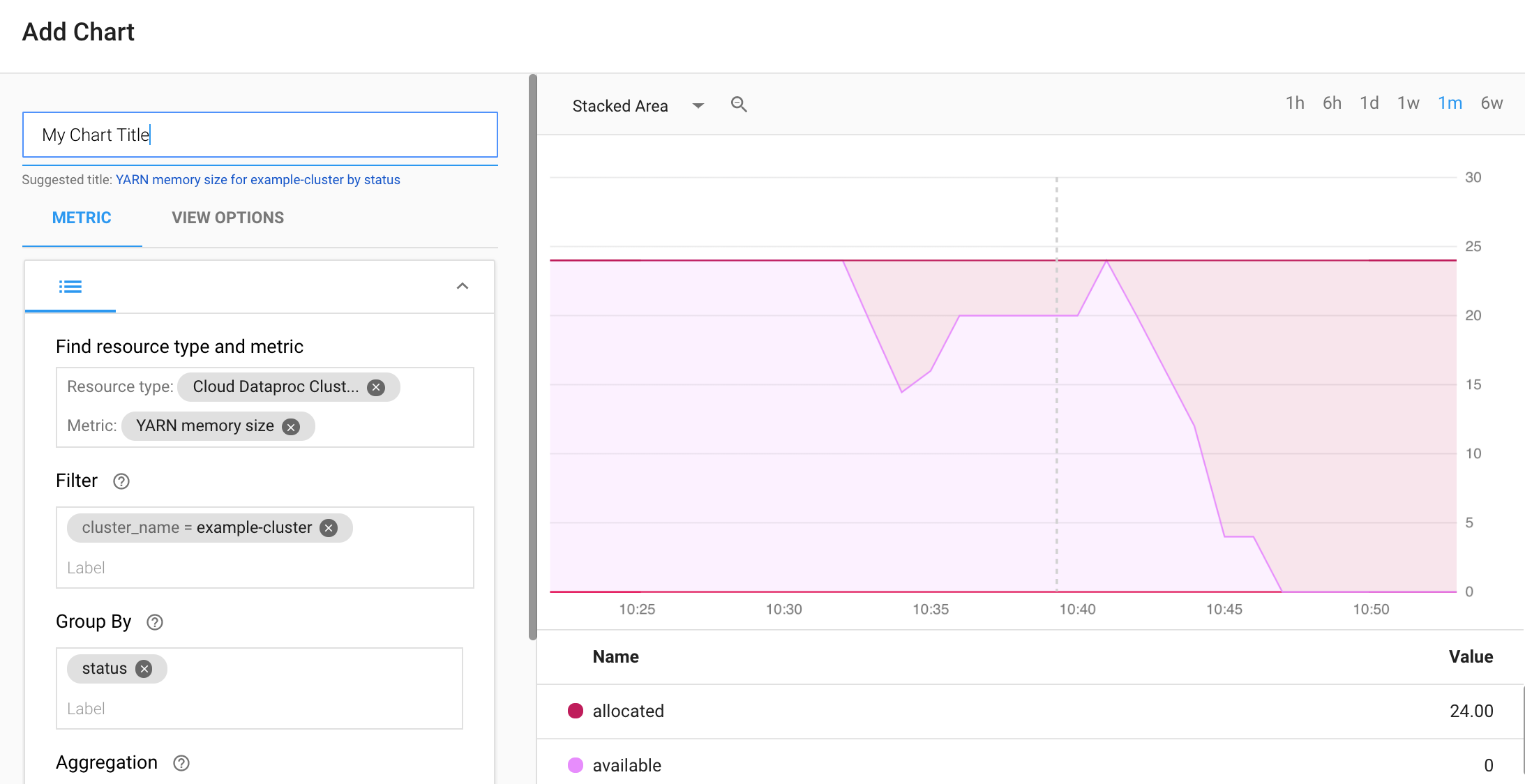

Créer un tableau de bord Monitoring

Vous pouvez créer un tableau de bord Monitoring personnalisé pour afficher les graphiques des métriques de cluster Cloud Dataproc sélectionnées.

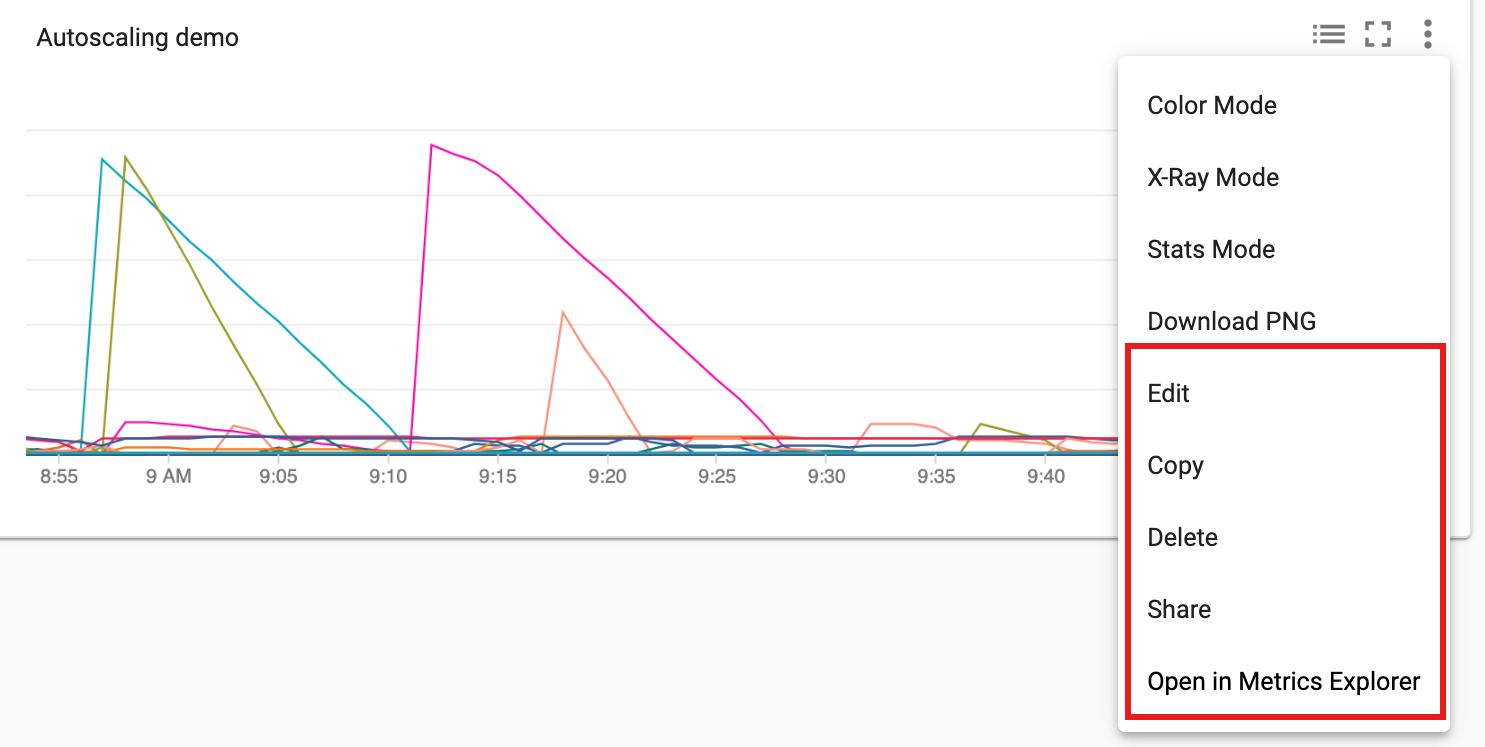

Sélectionnez + CRÉER UN TABLEAU DE BORD sur la page Aperçu des tableaux de bord de Monitoring. Attribuez un nom au tableau de bord, puis cliquez sur Add Chart (Ajouter un graphique) dans le menu situé dans l'angle supérieur droit pour ouvrir la fenêtre correspondante. Sélectionnez le type de ressource "Cloud Dataproc Cluster" (Cluster Cloud Dataproc). Sélectionnez une ou plusieurs métriques, ainsi que des propriétés de métrique et de graphique. Ensuite, enregistrez le graphique.

Vous pouvez ajouter des graphiques supplémentaires à votre tableau de bord. Une fois que vous avez enregistré le tableau de bord, son nom apparaît sur la page Aperçu des tableaux de bord de Monitoring. Les graphiques de tableau de bord peuvent être consultés, mis à jour et supprimés depuis la page d'affichage du tableau de bord.

Étape suivante

- Consultez la documentation Cloud Monitoring.

- Découvrez comment créer des alertes de métrique Dataproc.