Créer un pipeline de campagne cible

Découvrez comment utiliser Cloud Data Fusion pour nettoyer, transformer et traiter les données client afin de sélectionner des candidats pour une campagne cible.

Pour obtenir des instructions détaillées sur cette tâche directement dans la console Google Cloud, cliquez sur Visite guidée :

Scénario

Vous souhaitez créer des supports marketing personnalisés pour une promotion de campagne en cours et les distribuer directement dans les boîtes aux lettres personnelles de vos clients.

Votre campagne comporte deux contraintes :

- L'emplacement : vous livrez uniquement aux clients en Californie, à Washington et en Oregon.

- Coût: pour économiser du carburant, vous livrez au domicile des clients, qui est rapidement accessible. Vous ne livrez qu'aux clients qui habitent dans des avenues.

Ce tutoriel vous explique comment générer la liste des adresses de clients pour la campagne. Dans ce tutoriel, vous allez effectuer les opérations suivantes :

- Nettoyer les données client : filtrer les clients qui habitent dans une rue située en Californie, à Washington ou en Oregon.

Créez un pipeline qui effectue les opérations suivantes:

- Regroupe les données client filtrées via un ensemble de données public contenant des abréviations d'état.

- Il stocke les données nettoyées et jointes dans une table BigQuery que vous pouvez interroger (à l'aide de l'interface Web BigQuery) ou analyser (à l'aide de Looker Studio).

Objectifs

- Connecter Cloud Data Fusion à deux sources de données

- Appliquer des transformations de base

- Regrouper les deux sources de données

- Écrire les données de sortie dans un récepteur

Avant de commencer

- Connectez-vous à votre compte Google Cloud. Si vous débutez sur Google Cloud, créez un compte pour évaluer les performances de nos produits en conditions réelles. Les nouveaux clients bénéficient également de 300 $ de crédits gratuits pour exécuter, tester et déployer des charges de travail.

-

Dans Google Cloud Console, sur la page de sélection du projet, sélectionnez ou créez un projet Google Cloud.

-

Vérifiez que la facturation est activée pour votre projet Google Cloud.

-

Dans Google Cloud Console, sur la page de sélection du projet, sélectionnez ou créez un projet Google Cloud.

-

Vérifiez que la facturation est activée pour votre projet Google Cloud.

-

Activer les API Cloud Data Fusion, BigQuery, Cloud Storage, and Dataproc.

- Créez une instance Cloud Data Fusion.

Ce tutoriel suppose que vous utilisez le compte de service Compute Engine par défaut.

Gérer les autorisations

Créez et attribuez les rôles et autorisations personnalisés requis.

Créer un rôle personnalisé et ajouter des autorisations

Dans la console Google Cloud, accédez à la page Rôles:

Cliquez sur Créer un rôle.

Dans le champ Title (Titre), saisissez

Custom Role-Tutorial.Cliquez sur Ajouter des autorisations.

Dans la fenêtre Add permissions (Ajouter des autorisations), sélectionnez les autorisations suivantes et cliquez sur Add (Ajouter) :

bigquery.datasets.createbigquery.jobs.createstorage.buckets.create

Cliquez sur Créer.

Attribuer un rôle personnalisé au compte de service Compute Engine par défaut

Accédez à la page Instances de Cloud Data Fusion:

Cliquez sur le nom de votre instance.

Notez le compte de service Dataproc par défaut. La page de détails de l'instance contient ces informations.

Le format du nom du compte de service Dataproc est le suivant:

CUSTOMER_PROJECT_NUMBER-compute@developer.gserviceaccount.com.Obtenez plus d'informations sur les comptes de service Dataproc.

Accédez à la page IAM :

Dans la barre Filtre, saisissez le nom de votre compte de service Dataproc par défaut.

Pour votre compte de service Compute Engine par défaut, cliquez sur Modifier.

Cliquez sur Ajouter un autre rôle.

Dans le champ Sélectionnez un rôle, choisissez Tutoriel des rôles personnalisés.

Cliquez sur Enregistrer.

Assurez-vous que le compte de service dispose déjà du rôle d'exécuteur Cloud Data Fusion.

Préparer les données client

Ce tutoriel nécessite les deux ensembles de données d'entrée suivants, tous deux fournis avec votre instance Cloud Data Fusion :

- Exemples de données client : fichier CSV nommé

customers.csv. - Abréviations d'États : table BigQuery nommée

state_abbreviations.

Charger les données client

Accédez à la page Instances de Cloud Data Fusion:

Cliquez sur Afficher l'instance pour l'instance Cloud Data Fusion que vous utilisez. L'interface Web de Cloud Data Fusion s'ouvre dans un nouvel onglet.

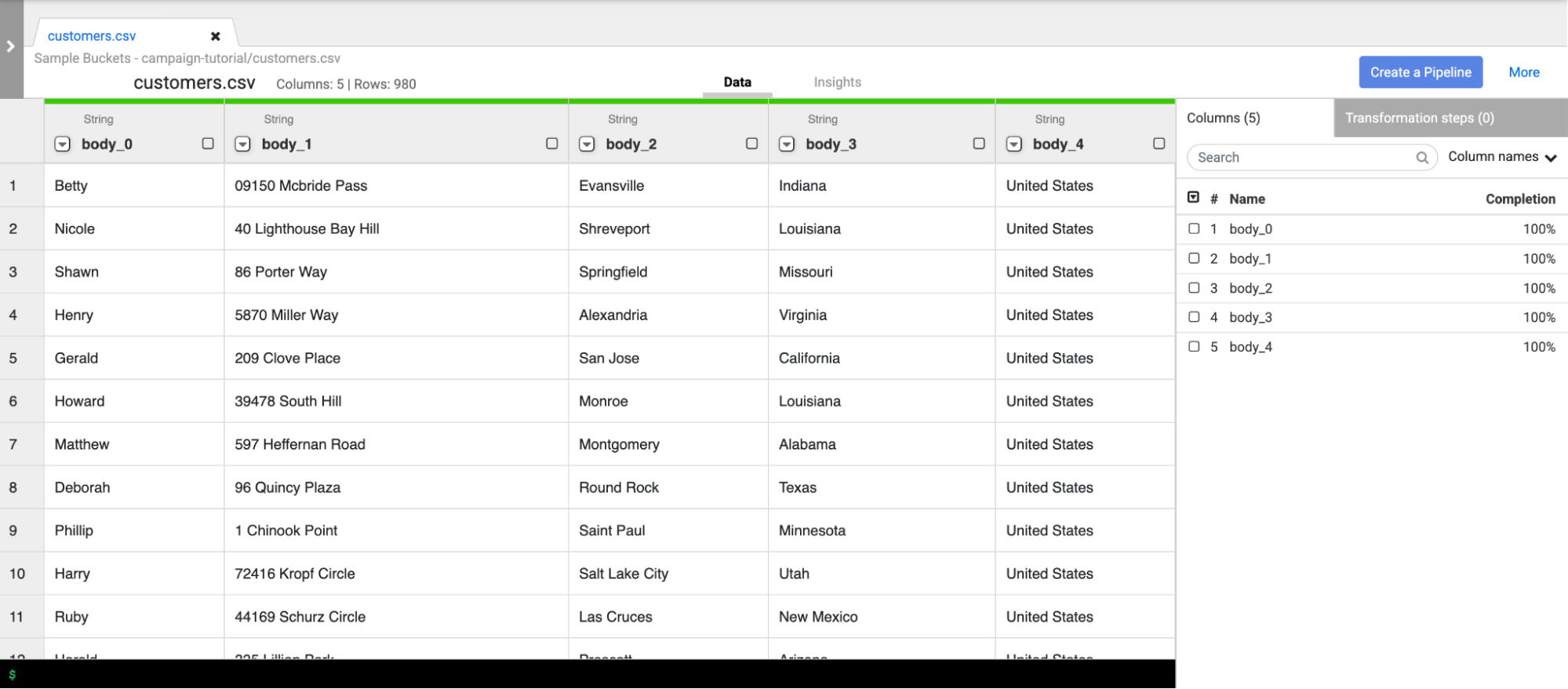

Cliquez sur Wrangler. La page Wrangler s'ouvre.

Dans le volet Connexions, sélectionnez GCS > Exemples de buckets.

Cliquez sur campaign-tutorial.

Cliquez sur customers.csv.

Dans la fenêtre Options d'analyse, spécifiez les éléments suivants:

- Format:

csv - Activer la valeur entre guillemets:

False - Utiliser la première ligne pour l'en-tête:

False - File-coding (Encodage du fichier) :

UTF-8

- Format:

Cliquez sur Confirm (Confirmer). Les données client sont chargées dans un nouvel onglet dans Wrangler.

Nettoyer les données client

Elle contient deux sous-tâches:

- Définir le schéma

- Filtrer les données client pour ne présenter que l'audience cible dont vous avez besoin

Définir le schéma

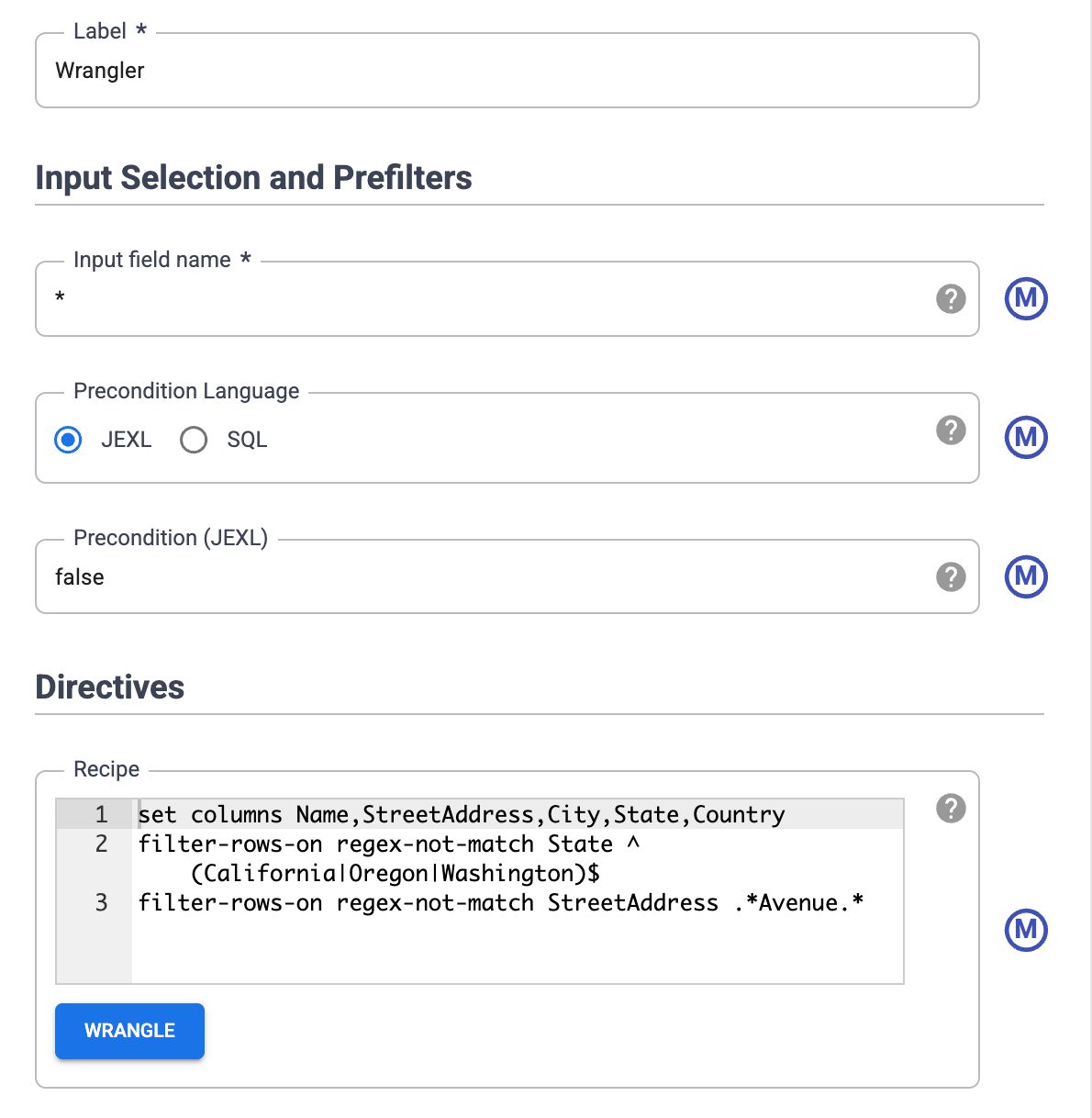

Définissez le schéma des données en attribuant des noms appropriés aux colonnes de la table. Pour attribuer des noms plus descriptifs aux colonnes, telles que body_1 et body_2, procédez comme suit :

- Dans le volet de droite, cliquez sur l'onglet Colonnes.

- Cliquez sur la liste déroulante Noms des colonnes, puis sélectionnez Tout définir.

Dans la boîte de dialogue Group set column names (Définir des noms de colonnes de manière groupée), saisissez les noms de colonnes suivants, séparés par une virgule:

Name,StreetAddress,City,State,CountryCliquez sur Appliquer.

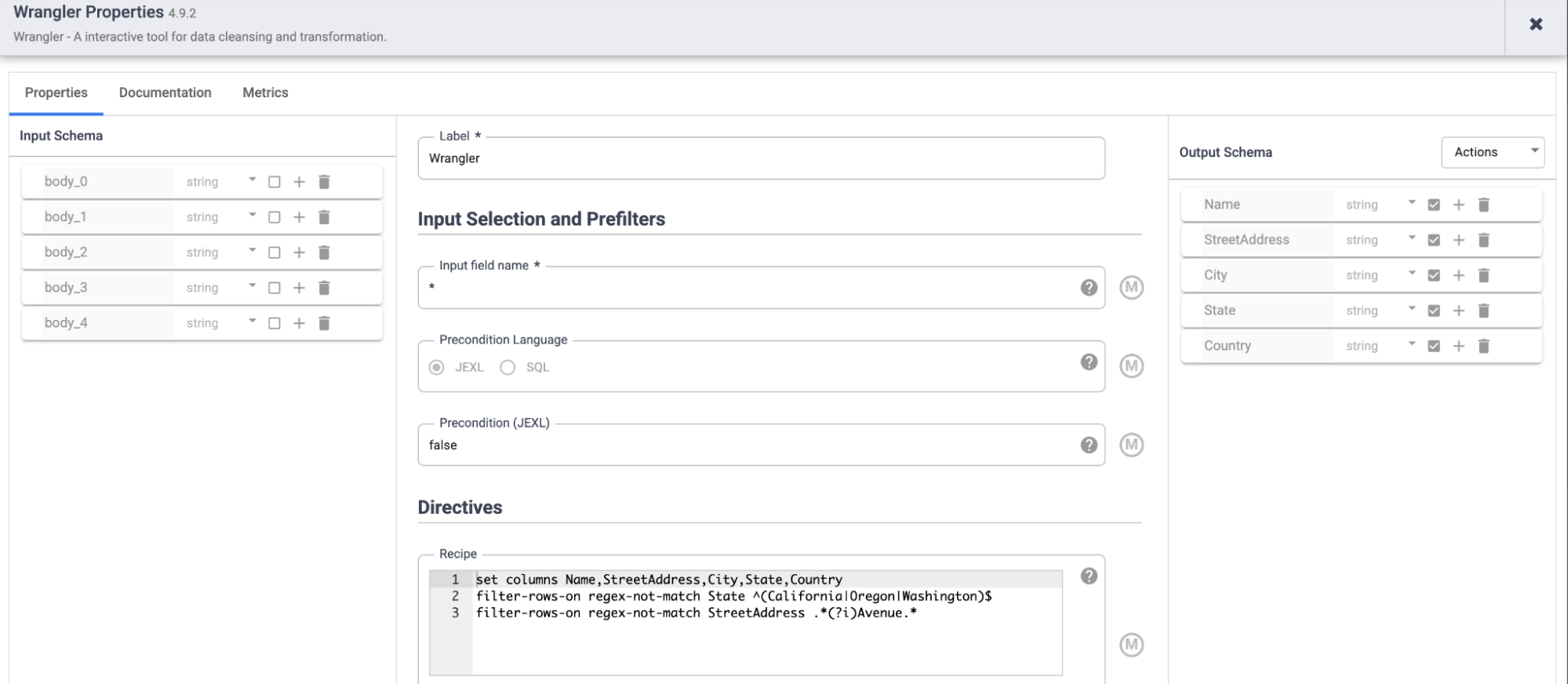

Filtrer les données

Filtrez les données pour n'afficher que les clients résidant en Californie, en Oregon ou à Washington.

Supprimez toutes les lignes contenant des valeurs autres que ces états:

- Cliquez sur la liste déroulante de la colonne État, puis sélectionnez Filtrer.

Dans la fenêtre de filtre, procédez comme suit :

- Cliquez sur Conserver les lignes.

- Cliquez sur la liste déroulante Si, puis sélectionnez la valeur correspond à l'expression régulière.

Saisissez l'expression régulière suivante :

^(California|Oregon|Washington)$Cliquez sur Appliquer.

Les valeurs de la colonne State sont California (Californie), Oregon ou Washington.

Filtrez les données pour n'afficher que les clients qui résident sur des avenues. Conservez uniquement les adresses contenant la chaîne avenue:

- Cliquez sur la liste déroulante de la colonne StreetAddress, puis sélectionnez Filtrer.

Dans la fenêtre de filtre, procédez comme suit :

- Cliquez sur Conserver les lignes.

- Cliquez sur le menu déroulant Si, sélectionnez la valeur contient, puis saisissez

Avenue. - Sélectionnez Ignore case (Ignorer le cas).

Cliquez sur Appliquer.

Avant d'effectuer des tâches de traitement en parallèle sur l'intégralité de votre ensemble de données, Wrangler n'affiche que les 1 000 premières valeurs de votre ensemble de données. Comme vous avez filtré certaines données, seuls quelques clients restent affichés dans Wrangler.

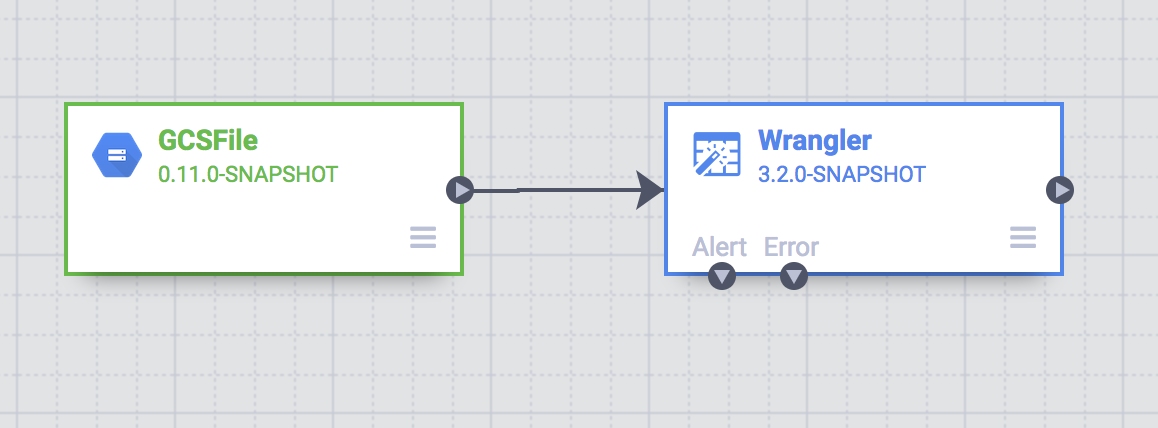

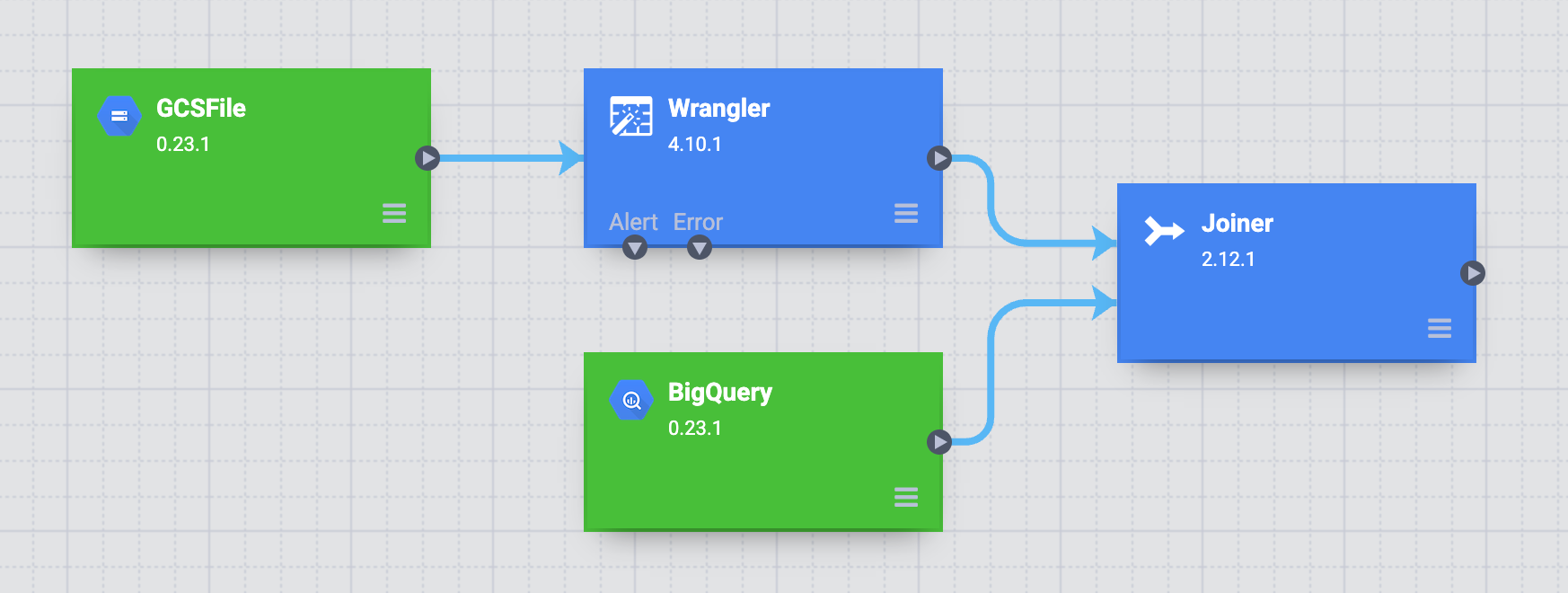

Créer un pipeline de traitement par lot

Vous avez nettoyé vos données et exécuté des transformations sur un sous-ensemble de vos données. Vous pouvez maintenant créer un pipeline par lots afin d'exécuter des transformations sur l'intégralité de votre ensemble de données.

Cloud Data Fusion traduit le pipeline que vous créez dans Studio en un programme Apache Spark qui exécute des transformations en parallèle sur un cluster Dataproc éphémère. Ce processus vous permet d'exécuter des transformations complexes sur de grandes quantités de données de manière fiable et évolutive, sans avoir à gérer l'infrastructure.

- Sur la page "Wrangler", cliquez sur Create a pipeline (Créer un pipeline).

- Sélectionnez Pipeline par lot. La page Studio s'ouvre.

En haut à gauche, assurez-vous que Data Pipeline - Batch (Pipeline de données – Lot) s'affiche en tant que type de pipeline.

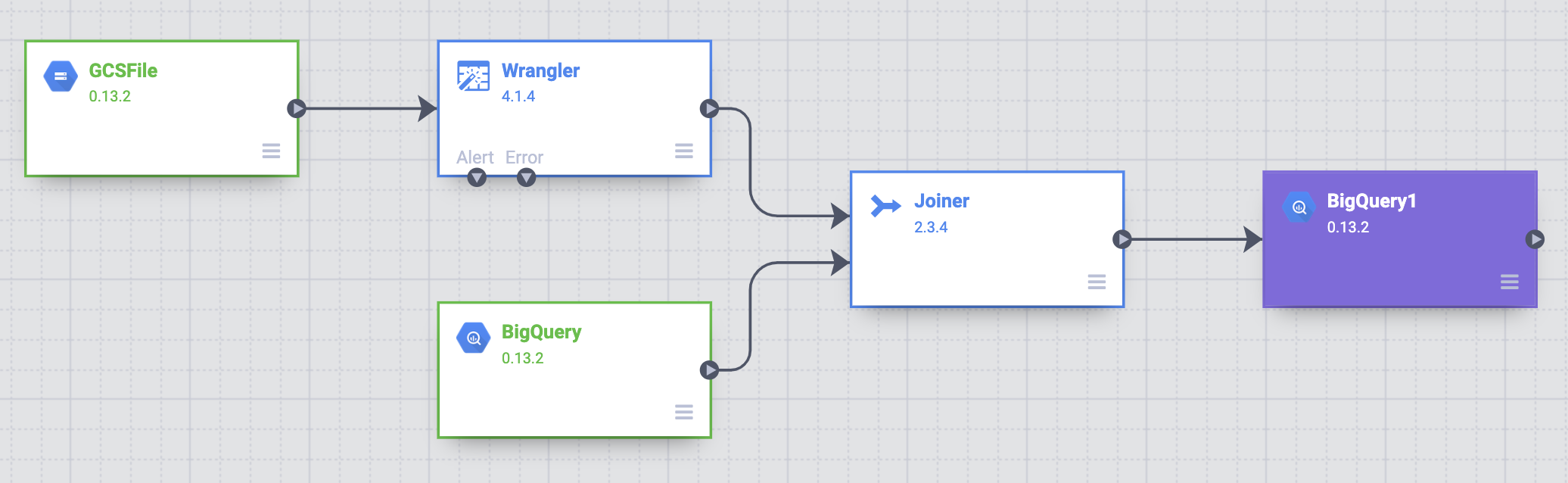

Sur la page Studio, un nœud source GCSFile est connecté à un nœud Wrangler.

Les transformations que vous avez appliquées sur la page Wrangler apparaissent dans le nœud Wrangler de la page Studio.

Pour afficher les transformations que vous avez appliquées, maintenez le pointeur sur le nœud Wrangler et cliquez sur Properties (Propriétés).

Les transformations que vous avez appliquées figurent dans les directives.

Cliquez sur Valider.

Cliquez sur Fermer.

Par exemple, vous réalisez que la colonne Pays n'est pas nécessaire, car la valeur est toujours "États-Unis". Pour supprimer la colonne, procédez comme suit :

- Cliquez sur Wrangle.

- Cliquez sur la flèche vers le bas à côté de Pays, puis sélectionnez Supprimer la colonne.

- Cliquez sur Appliquer. La page Wrangler se ferme et la fenêtre "Propriétés Wrangler" s'ouvre sur la page Studio. Dans les Directives,

drop Countrys'affiche. - Cliquez sur Fermer.

Abréger les noms d'État

Le système de navigation de votre véhicule de livraison ne reconnaît que les adresses contenant des noms d'État abrégés (Californie, et non la Californie), et vos données client contiennent les noms d'État complets.

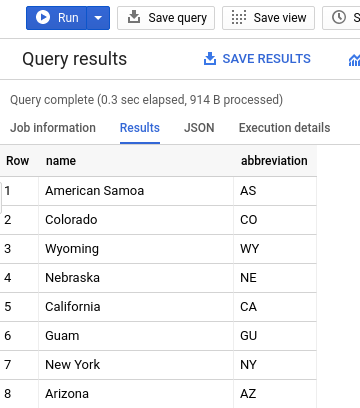

La table publique BigQuery state_abbreviations contient deux colonnes : une avec les noms d'État complets et une avec les noms d'État abrégés.

Vous pouvez utiliser cette table pour mettre à jour les noms d'État dans vos données client.

Afficher les données de noms d'État dans BigQuery

Dans un autre onglet, accédez à la page BigQuery Studio:

Cliquez sur Créer une requête SQL et saisissez la requête suivante dans l'éditeur de requête:

SELECT * FROM `dis-user-guide.campaign_tutorial.state_abbreviations`Cliquez sur Exécuter.

Les noms des États et leurs abréviations s'affichent.

Accéder à la table BigQuery

Ajoutez à votre pipeline une source qui accédera à la table BigQuery state_abbreviations.

- Accédez à la page Cloud Data Fusion Studio et développez le menu Source.

Cliquez sur BigQuery.

Un nœud source BigQuery apparaît sur le canevas avec les deux autres nœuds.

Maintenez le pointeur sur le nœud source BigQuery, puis cliquez sur Properties (Propriétés).

- Dans le champ ID du projet de l'ensemble de données, saisissez

dis-user-guide. - Dans le champ Reference Name (Nom de la référence), saisissez

state_abbreviations. - Dans le champ Ensemble de données, saisissez

campaign_tutorial. - Dans le champ Table, saisissez

state_abbreviations.

- Dans le champ ID du projet de l'ensemble de données, saisissez

Renseignez le schéma de la table à partir de BigQuery en cliquant sur Obtenir le schéma.

Cliquez sur Fermer.

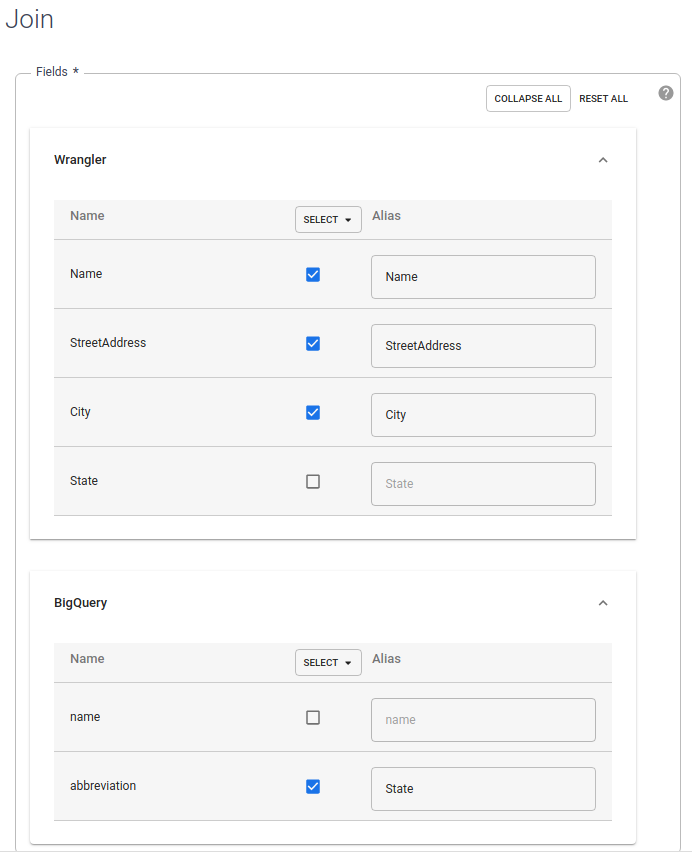

Joindre les deux sources de données

Pour générer une sortie contenant des données client avec des noms d'État abrégés, joignez les deux sources de données : les données client et les abréviations d'État.

- Accédez à la page Cloud Data Fusion Studio et développez le menu Analyse.

Cliquez sur Joiner.

Un nœud Joiner, représentant une action semblable à une jointure SQL, apparaît sur le canevas.

Connectez le nœud Wrangler et le nœud BigQuery au nœud Joiner: faites glisser une flèche de connexion sur le bord droit du nœud source et déposez-la sur le nœud de destination.

Maintenez le pointeur sur le nœud Joiner, puis cliquez sur Properties (Propriétés).

Dans la section Champs, développez Wrangler et BigQuery.

- Décochez la case state (État) de Wrangler.

- Décochez la case Nom BigQuery, car vous ne souhaitez obtenir que le nom d'État abrégé et non le nom complet.

Laissez la case à cocher abbreviation (BigQuery) cochée, et remplacez l'alias par

State.

Dans le champ Join Type (Type de jointure), laissez la valeur Outer (Externe). Sous Required input (Entrées requises), cochez la case Wrangler.

Dans la section Condition de jointure, sélectionnez État pour Wrangler. Pour BigQuery, sélectionnez

Name.Générez le schéma de la jointure obtenue. Cliquez sur Obtenir un schéma.

Cliquez sur Valider.

Cliquez sur Fermer.

Stocker le résultat dans BigQuery

Stockez le résultat de votre pipeline dans une table BigQuery. L'emplacement de stockage de vos données s'appelle un récepteur.

- Accédez à la page Cloud Data Fusion Studio et développez Récepteur.

- Cliquez sur BigQuery.

Connectez le nœud Joiner au nœud BigQuery.

Maintenez le pointeur sur le nœud BigQuery, puis cliquez sur Properties (Propriétés).

- Dans le champ Ensemble de données, saisissez

dis_user_guide. - Dans le champ Table, sélectionnez

customer_data_abbreviated_states. - Cliquez sur Fermer.

- Dans le champ Ensemble de données, saisissez

Déployer et exécuter le pipeline

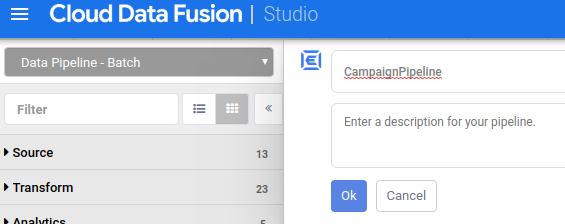

Sur la page Studio, cliquez sur Attribuer un nom au pipeline, puis saisissez

CampaignPipeline.

Cliquez sur OK.

Dans l'angle supérieur droit, cliquez sur Déployer.

Une fois le déploiement terminé, cliquez sur Exécuter.

L'exécution de votre pipeline peut prendre quelques minutes. En attendant, vous pouvez observer l'état de la transition du pipeline sous Provisionnement > Démarrage > Exécution > Déprovisionnement >

Afficher les résultats

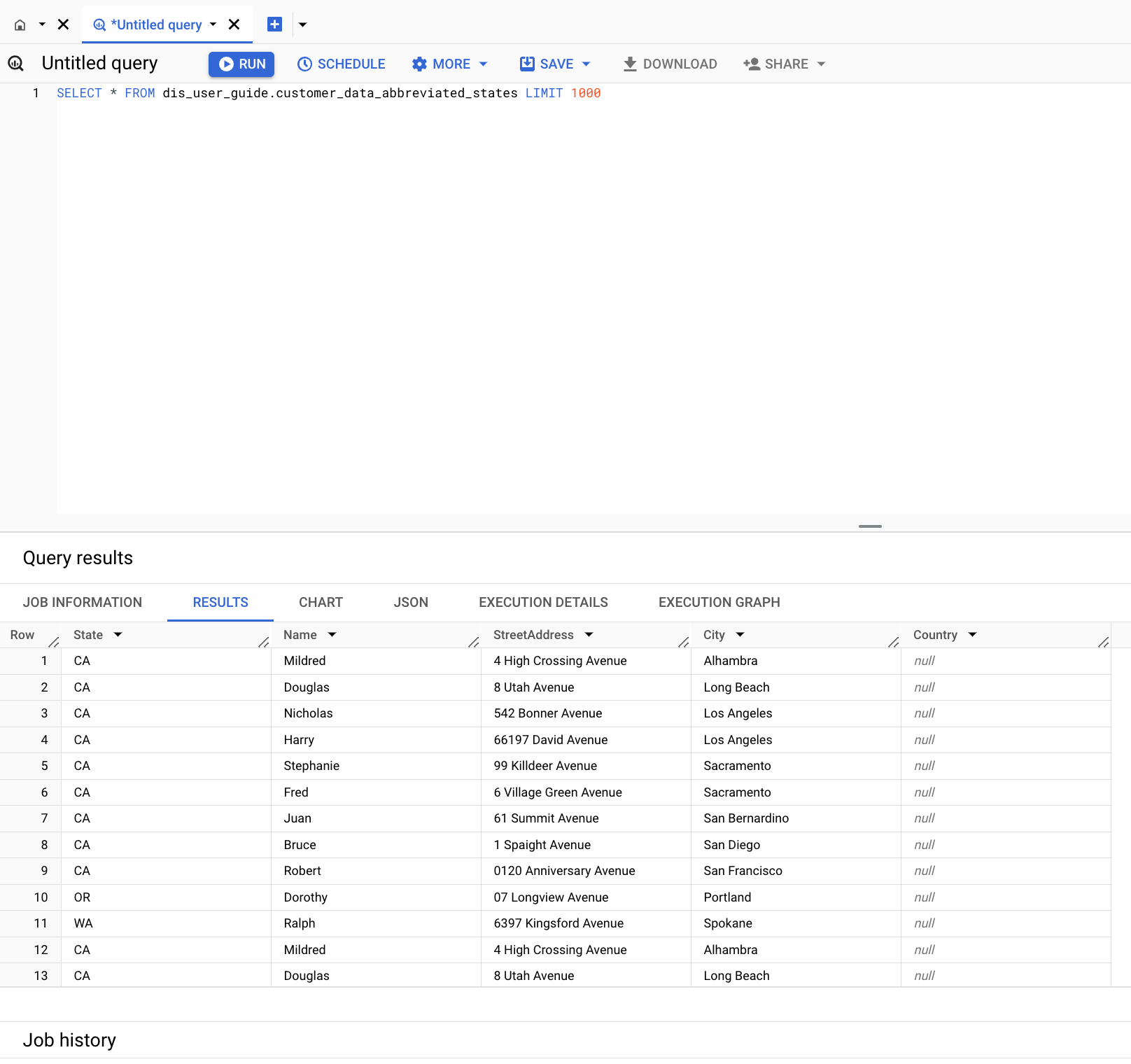

Dans Google Cloud Console, accédez à la page "BigQuery" :

Cliquez sur Créer une requête SQL.

Interrogez la table

customer_data_abbreviated_states:SELECT * FROM dis_user_guide.customer_data_abbreviated_states LIMIT 1000

Vous avez créé un pipeline de données.

Effectuer un nettoyage

Pour éviter que les ressources utilisées sur cette page soient facturées sur votre compte Google Cloud, procédez comme suit :

Supprimer l'ensemble de données BigQuery

Pour supprimer l'ensemble de données BigQuery que vous avez créé dans ce tutoriel, procédez comme suit:

- Dans la console Google Cloud, accédez à la page "BigQuery".

- Sélectionnez l'ensemble de données

dis_user_guide. - Cliquez sur delete Supprimer l'ensemble de données.

Supprimer l'instance Cloud Data Fusion

Suivez ces instructions pour supprimer votre instance Cloud Data Fusion.

Supprimer le projet

Le moyen le plus simple d'empêcher la facturation est de supprimer le projet que vous avez créé pour ce tutoriel.

Pour supprimer le projet :

- Dans la console Google Cloud, accédez à la page Gérer les ressources.

- Dans la liste des projets, sélectionnez le projet que vous souhaitez supprimer, puis cliquez sur Supprimer.

- Dans la boîte de dialogue, saisissez l'ID du projet, puis cliquez sur Arrêter pour supprimer le projet.

Étapes suivantes

- Apprenez-en plus sur Cloud Data Fusion.