Übertragungen verwalten

In diesem Dokument wird gezeigt, wie Sie vorhandene Datenübertragungskonfigurationen verwalten.

Sie können auch eine vorhandene Übertragung manuell auslösen, auch als Backfill-Ausführung bezeichnet.

Übertragungen aufrufen

Rufen Sie Ihre vorhandenen Übertragungskonfigurationen auf. Rufen Sie dazu Informationen zu jeder Übertragung auf, listen Sie alle vorhandenen Übertragungen auf und rufen Sie den Verlauf der Übertragungsausführungen oder Logeinträge auf.

Erforderliche Rollen

Bitten Sie Ihren Administrator, Ihnen die IAM-Rolle für das Projekt BigQuery-Nutzer (roles/bigquery.user) zu gewähren, um die Berechtigungen zu erhalten, die Sie zum Aufrufen von Übertragungsdetails benötigen.

Weitere Informationen zum Zuweisen von Rollen finden Sie unter Zugriff verwalten.

Sie können die erforderlichen Berechtigungen auch über benutzerdefinierte Rollen oder andere vordefinierte Rollen erhalten.

Darüber hinaus benötigen Sie Berechtigungen zum Aufrufen von Cloud Logging-Daten, um Logeinträge über die Google Cloud Console aufrufen zu können. Die Rolle „Log-Betrachter“ (roles/logging.viewer) bietet Ihnen Lesezugriff auf alle Logging-Features. Weitere Informationen zu den Berechtigungen und Rollen von Identity and Access Management (IAM), die für Cloud-Logging-Daten gelten, finden Sie in der Anleitung zur Zugriffssteuerung von Cloud Logging.

Weitere Informationen zu IAM-Rollen in BigQuery Data Transfer Service finden Sie in der Zugriffssteuerung.

Übertragungsdetails abrufen

Nachdem Sie eine Übertragung erstellt haben, können Sie Informationen zu der Übertragungskonfiguration abrufen. Die Konfiguration enthält die Werte, die Sie bei der Erstellung der Übertragung angegeben haben, sowie andere wichtige Informationen wie Ressourcennamen.

So rufen Sie Informationen zu einer Übertragungskonfiguration ab:

Console

Rufen Sie die Seite Datenübertragungen auf.

Wählen Sie die Übertragung aus, für die Sie die Details abrufen möchten.

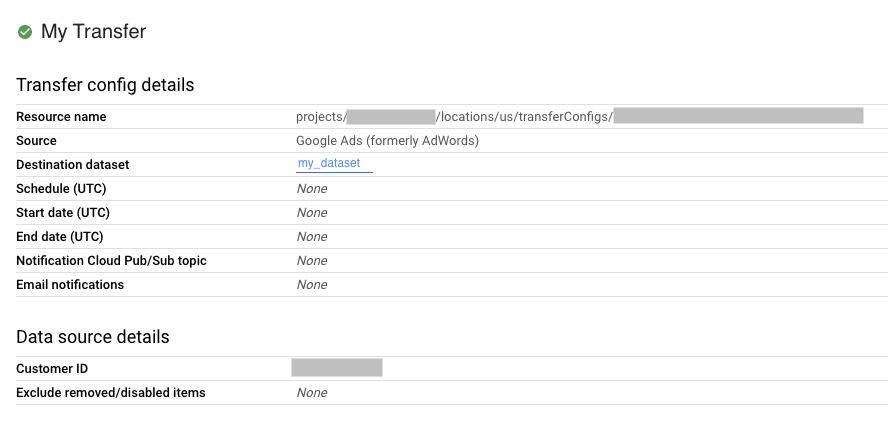

Klicken Sie auf der Seite Übertragungsdetails auf Konfiguration, um die Übertragungskonfiguration und die Details der Datenquelle aufzurufen. Im folgenden Beispiel werden die Konfigurationsattribute einer Google Ads-Übertragung dargestellt:

bq

Geben Sie den Befehl bq show ein und fügen Sie den Ressourcennamen der Übertragungskonfiguration hinzu. Mit dem Flag --format können Sie das Ausgabeformat festlegen.

bq show \

--format=prettyjson \

--transfer_config resource_name

Ersetzen Sie resource_name durch den Ressourcennamen der Übertragung (auch als Übertragungskonfiguration bezeichnet). Wenn Sie den Ressourcennamen der Übertragung nicht kennen, suchen Sie den Ressourcennamen mit bq ls --transfer_config --transfer_location=location.

Geben Sie beispielsweise den folgenden Befehl ein, um die Übertragungskonfiguration für projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7 anzeigen zu lassen:

bq show \

--format=prettyjson \

--transfer_config projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

API

Verwenden Sie die Methode projects.locations.transferConfigs.get und geben Sie die Übertragungskonfiguration mithilfe des Parameters name an.

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Java in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Java API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Übertragungskonfigurationen auflisten

So listen Sie alle vorhandenen Übertragungskonfigurationen in einem Projekt auf:

Console

Rufen Sie in der Google Cloud Console die Seite Datenübertragungen auf.

Wenn im Projekt Übertragungskonfigurationen vorhanden sind, wird auf der Seite Datenübertragungen eine Liste der Übertragungskonfigurationen angezeigt.

bq

Geben Sie den Befehl bq ls ein und fügen Sie die Flags --transfer_location und --transfer_config hinzu, um alle Übertragungskonfigurationen für ein Projekt nach dem Standort anzeigen zu lassen. Sie können auch das Flag --project_id bereitstellen, um ein bestimmtes Projekt anzugeben. Wenn --project_id nicht angegeben ist, wird das Standardprojekt verwendet.

Mit dem Flag --format können Sie das Ausgabeformat festlegen.

Geben Sie das Flag --filter an, um Übertragungskonfigurationen für bestimmte Datenquellen aufzulisten.

Wenn eine bestimmte Anzahl von Übertragungskonfigurationen auf einer Seite angezeigt werden soll, geben Sie das Flag --max_results an, um die Anzahl von Übertragungen festzulegen. Durch diesen Befehl wird ein Seitentoken zurückgegeben, das Sie mit dem Flag --page_token angeben, um die nächsten n Konfigurationen aufzurufen. Es gibt ein Limit von 1.000 Konfigurationen, die zurückgegeben werden, wenn --max_results weggelassen wird. --max_results akzeptiert keine Werte, die größer als 1.000 sind. Wenn Ihr Projekt mehr als 1.000 Konfigurationen hat, können Sie mit --max_results und --page_token alle iterieren.

bq ls \ --transfer_config \ --transfer_location=location \ --project_id=project_id \ --max_results=integer \ --filter=dataSourceIds:data_sources

Ersetzen Sie Folgendes:

locationist der Speicherort der Übertragungskonfigurationen. Der Speicherort wird beim Erstellen einer Übertragung angegeben.project_idist die Projekt-ID.integerist die Anzahl der Ergebnisse, die pro Seite angezeigt werden sollen.data_sourcesist eines oder mehrere der folgenden Elemente:amazon_s3– Amazon S3-Datenübertragungazure_blob_storage– Azure Blob Storage-Datenübertragungdcm_dt– Campaign Manager-Datenübertragunggoogle_cloud_storage– Cloud Storage-Datenübertragungcross_region_copy– Dataset-Kopiedfp_dt- Google Ad Manager-Datenübertragungadwords– Google Ads-Datenübertragunggoogle_ads– Google Ads-Datenübertragung (Vorschau)merchant_center– Google Merchant Center-Datenübertragungplay– Google Play-Datenübertragungscheduled_query– Datenübertragung geplanter Abfragendoubleclick_search– Search Ads 360-Datenübertragungyoutube_channel– YouTube-Kanal-Datenübertragungyoutube_content_owner– Datenübertragung für YouTube-Rechteinhaberredshift– Amazon Redshift-Migrationon_premises– Teradata-Migration

Beispiele:

Geben Sie den folgenden Befehl ein, um für Ihr Standardprojekt alle Übertragungskonfigurationen in den USA aufzurufen. Mit dem Flag --format können Sie das Ausgabeformat festlegen.

bq ls \

--format=prettyjson \

--transfer_config \

--transfer_location=us

Geben Sie den folgenden Befehl ein, um für die Projekt-ID myproject alle Übertragungskonfigurationen in den USA aufzurufen.

bq ls \

--transfer_config \

--transfer_location=us \

--project_id=myproject

Geben Sie den folgenden Befehl ein, um die letzten drei Übertragungskonfigurationen aufzulisten.

bq ls \

--transfer_config \

--transfer_location=us \

--project_id=myproject \

--max_results=3

Durch diesen Befehl wird ein Token für die nächste Seite zurückgegeben. Kopieren Sie das Seitentoken und geben Sie es im Befehl bq ls an, um die nächsten drei Ergebnisse anzeigen zu lassen.

bq ls \

--transfer_config \

--transfer_location=us \

--project_id=myproject \

--max_results=3 \

--page_token=AB1CdEfg_hIJKL

Geben Sie den folgenden Befehl ein, um die Übertragungskonfigurationen für Google Ads und Campaign Manager für die Projekt-ID myproject aufzulisten.

bq ls \

--transfer_config \

--transfer_location=us \

--project_id=myproject \

--filter=dataSourceIds:dcm_dt,google_ads

API

Verwenden Sie die Methode projects.locations.transferConfigs.list und geben Sie die Projekt-ID mithilfe des Parameters parent an.

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Java in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Java API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Python

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Python in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Python API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Verlauf der Übertragungsausführung abrufen

Beim Ausführen der geplanten Übertragungen wird für alle Übertragungskonfigurationen ein Ausführungsverlauf erstellt, der u. a. die erfolgreichen Übertragungen und fehlgeschlagenen Übertragungen enthält. Übertragungen, die älter als 90 Tage sind, werden automatisch aus dem Ausführungsverlauf gelöscht.

So zeigen Sie den Ausführungsverlauf für eine Übertragungskonfiguration an:

Console

Rufen Sie in der Google Cloud Console die Seite Datenübertragungen auf.

Klicken Sie in der Liste der Datenübertragungen auf die Übertragung.

Sie werden dann zur Seite Ausführungsverlauf für die ausgewählte Übertragung weitergeleitet.

bq

Geben Sie den Befehl bq

ls mit dem Flag --transfer_run ein, um Übertragungsausführungen für eine bestimmte Übertragungskonfiguration aufzulisten. Sie können auch das Flag --project_id bereitstellen, um ein bestimmtes Projekt anzugeben. Wenn resource_name keine Projektinformationen enthält, wird der Wert --project_id verwendet. Wenn --project_id nicht angegeben ist, wird das Standardprojekt verwendet. Mit dem Flag --format können Sie das Ausgabeformat festlegen.

Geben Sie das Flag --max_results an, um eine bestimmte Anzahl von Übertragungsaufführungen anzeigen zu lassen. Durch diesen Befehl wird ein Seitentoken zurückgegeben, das Sie mit dem Flag --page_token angeben, um die nächsten n Konfigurationen aufzurufen.

Geben Sie das Flag --filter an, um Übertragungsausführungen basierend auf dem Ausführungsstatus aufzulisten.

bq ls \ --transfer_run \ --max_results=integer \ --transfer_location=location \ --project_id=project_id \ --filter=states:state, ... \ resource_name

Ersetzen Sie Folgendes:

integerist die Anzahl der zurückzugebenden Ergebnisse.locationist der Speicherort der Übertragungskonfigurationen. Der Speicherort wird beim Erstellen einer Übertragung angegeben.project_idist die Projekt-ID.state, ...ist einer der folgenden Werte oder eine durch Kommas getrennte Liste:SUCCEEDEDFAILEDPENDINGRUNNINGCANCELLED

resource_nameist der Ressourcenname der Übertragung (auch als Übertragungskonfiguration bezeichnet). Wenn Sie den Ressourcennamen der Übertragung nicht kennen, suchen Sie den Ressourcennamen mitbq ls --transfer_config --transfer_location=location.

Beispiele:

Geben Sie den folgenden Befehl ein, um die letzten drei Ausführungen für die Übertragungskonfiguration projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7 aufzurufen.

Mit dem Flag --format können Sie das Ausgabeformat festlegen.

bq ls \

--format=prettyjson \

--transfer_run \

--max_results=3 \

--transfer_location=us \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

Durch diesen Befehl wird ein Token für die nächste Seite zurückgegeben. Kopieren Sie das Seitentoken und geben Sie es im Befehl bq ls an, um die nächsten drei Ergebnisse anzeigen zu lassen.

bq ls \

--format=prettyjson \

--transfer_run \

--max_results=3 \

--page_token=AB1CdEfg_hIJKL \

--transfer_location=us \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

Geben Sie den folgenden Befehl ein, um alle fehlgeschlagenen Ausführungen für die Übertragungskonfiguration projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7 aufzurufen.

bq ls \

--format=prettyjson \

--transfer_run \

--filter=states:FAILED \

--transfer_location=us \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

API

Verwenden Sie die Methode projects.locations.transferConfigs.runs.list und geben Sie die Projekt-ID mithilfe des Parameters parent an.

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Java in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Java API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Details zur Übertragungsausführung und Logmeldungen aufrufen

Ist eine Übertragungsausführung im Verlauf aufgeführt, können Sie die Übertragungsdetails anzeigen, einschließlich Protokollmeldungen, Warnungen und Fehler, Name sowie Start- und Endzeit.

So zeigen Sie die Details von Übertragungsausführungen an:

Console

Rufen Sie in der Google Cloud Console die Seite Datenübertragungen auf.

Klicken Sie in der Liste der Datenübertragungen auf die Übertragung.

Sie werden dann zur Seite Ausführungsverlauf für die ausgewählte Übertragung weitergeleitet.

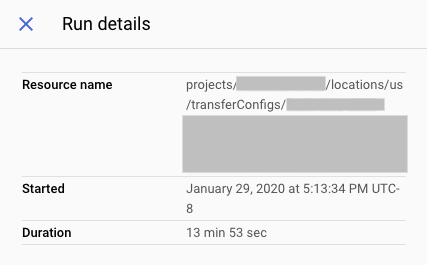

Klicken Sie auf eine einzelne Übertragungsausführung, um das Feld Ausführungsdetails für diese Übertragungsausführung zu öffnen.

Sehen Sie sich unter Ausführungsdetails alle Fehlermeldungen an. Sie benötigen diese Informationen, wenn Sie sich an den Cloud Customer Care wenden. Die Ausführungsdetails enthalten auch Logmeldungen und Warnungen.

bq

Geben Sie den Befehl bq show ein und fügen Sie mit dem Flag --transfer_run den Namen der Übertragungsausführung hinzu, um die Details von Übertragungsausführungen anzeigen zu lassen. Mit dem Flag --format können Sie das Ausgabeformat festlegen.

bq show \ --format=prettyjson \ --transfer_run run_name

Ersetzen Sie run_name durch den Namen der Übertragungsausführung.

Sie können den Ausführungsnamen mit dem Befehl bq ls abrufen.

Beispiel:

Geben Sie den folgenden Befehl ein, um Details für die Übertragungsausführung projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g aufzurufen.

bq show \

--format=prettyjson \

--transfer_run \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g

Geben Sie den Befehl bq ls mit dem Flag --transfer_log ein, um Übertragungslogmeldungen für eine Übertragungsausführung anzeigen zu lassen. Mit dem Flag --message_type können Sie Logmeldungen nach Typ filtern.

Geben Sie das Flag --max_results an, um eine bestimmte Anzahl von Logmeldungen anzeigen zu lassen. Bei diesem Befehl wird ein Seitentoken zurückgegeben, das Sie mit dem Flag --page_token angeben, um die nächsten n Meldungen aufzurufen.

bq ls \ --transfer_log \ --max_results=integer \ --message_type=messageTypes:message_type \ run_name

Ersetzen Sie Folgendes:

integerdie Anzahl der zurückzugebenden Protokollmeldungen ist.message_typeder Typ der Protokollmeldungen ist, die angezeigt werden sollen (ein einzelner Wert oder eine durch Kommas getrennte Liste):INFOWARNINGERROR

run_nameist der Name der Übertragungsausführung. Sie können den Ausführungsnamen mit dem Befehlbq lsabrufen.

Beispiele:

Geben Sie den folgenden Befehl ein, um die ersten zwei Logmeldungen für die Übertragungsausführung projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g aufzurufen.

bq ls \

--transfer_log \

--max_results=2 \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g

Durch diesen Befehl wird ein Token für die nächste Seite zurückgegeben. Kopieren Sie das Seitentoken und geben Sie es im Befehl bq ls an, um die nächsten zwei Ergebnisse anzeigen zu lassen.

bq ls \

--transfer_log \

--max_results=2 \

--page_token=AB1CdEfg_hIJKL \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g

Geben Sie den folgenden Befehl ein, um nur Fehlermeldungen für die Übertragungsausführung projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g anzeigen zu lassen.

bq ls \

--transfer_log \

--message_type=messageTypes:ERROR \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7/runs/1a2b345c-0000-1234-5a67-89de1f12345g

API

Verwenden Sie die Methode projects.transferConfigs.runs.transferLogs.list und geben Sie den Ausführungsnamen der Übertragungsausführung mithilfe des Parameters parent an.

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Java in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Java API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Übertragungen ändern

Sie können vorhandene Übertragungen ändern, indem Sie Informationen zur Übertragungskonfiguration bearbeiten, die Anmeldedaten eines Nutzers an eine Übertragungskonfiguration aktualisieren und eine Übertragung deaktivieren oder löschen.

Erforderliche Rollen

Bitten Sie Ihren Administrator, Ihnen die IAM-Rolle BigQuery-Administrator (roles/bigquery.admin) für das Projekt zuzuweisen, um die Berechtigungen zu erhalten, die Sie zum Ändern von Übertragungen benötigen.

Weitere Informationen zum Zuweisen von Rollen finden Sie unter Zugriff verwalten.

Sie können die erforderlichen Berechtigungen auch über benutzerdefinierte Rollen oder andere vordefinierte Rollen erhalten.

Übertragung aktualisieren

Nachdem Sie eine Übertragungskonfiguration erstellt haben, können Sie die folgenden Felder bearbeiten:

- Ziel-Dataset

- Anzeigename

- Alle Parameter, die für den spezifischen Übertragungstyp angegeben wurden

- Benachrichtigungseinstellungen ausführen

- Dienstkonto

Sie können die Quelle einer Übertragung nicht mehr bearbeiten, nachdem eine Übertragung erstellt wurde.

So aktualisieren Sie eine Übertragung:

Console

Rufen Sie in der Google Cloud Console die Seite Datenübertragungen auf.

Klicken Sie in der Liste der Datenübertragungen auf die Übertragung.

Klicken Sie auf Bearbeiten, um die Übertragungskonfiguration zu aktualisieren.

bq

Geben Sie den Befehl bq update ein, fügen Sie den Ressourcennamen der Übertragungskonfiguration mit dem Flag --transfer_config hinzu und geben Sie das Flag --display_name, --params, --refresh_window_days, --schedule oder --target_dataset an. Optional können Sie das Flag --destination_kms_key für geplante Abfragen oder Cloud Storage-Übertragungen angeben.

bq update \ --display_name='NAME' \ --params='PARAMETERS' \ --refresh_window_days=INTEGER \ --schedule='SCHEDULE' --target_dataset=DATASET_ID \ --destination_kms_key="DESTINATION_KEY" \ --transfer_config \ --service_account_name=SERVICE_ACCOUNT \ RESOURCE_NAME

Ersetzen Sie Folgendes:

NAME: Der Anzeigename für die Übertragungskonfiguration.PARAMETERS: Die Parameter für die Übertragungskonfiguration im JSON-Format:. Beispiel:--params='{"param1":"param_value1"}'Die folgenden Parameter können bearbeitet werden:- Campaign Manager:

bucketundnetwork_id - Google Ad Manager:

bucketundnetwork_code - Google Ads:

customer_id - Google Merchant Center:

merchant_id - Google Play:

bucketundtable_suffix - Geplante Abfrage:

destination_table_kms_key,destination_table_name_template,partitioning_field,partitioning_type,queryundwrite_disposition - Search Ads 360:

advertiser_id,agency_id,custom_floodlight_variables,include_removed_entitiesundtable_filter - YouTube-Kanal:

table_suffix - YouTube-Rechteinhaber:

content_owner_idundtable_suffix

- Campaign Manager:

INTEGER: ein Wert zwischen 0 und 30. Informationen zum Festlegen des Aktualisierungsfensters finden Sie in der Dokumentation für den jeweiligen Übertragungstyp.SCHEDULE: Wiederkehrender Zeitplan, z. B.--schedule="every 3 hours". Eine Beschreibung derschedule-Syntax finden Sie unterscheduleformatieren.- DATASET_ID: Das Ziel-Dataset für die Übertragungskonfiguration.

- DESTINATION_KEY: Die Cloud KMS-Schlüsselressourcen-ID, z. B.

projects/project_name/locations/us/keyRings/key_ring_name/cryptoKeys/key_name. CMEK ist nur für geplante Abfragen oder Cloud Storage-Übertragungen verfügbar. - SERVICE_ACCOUNT: Geben Sie ein Dienstkonto an, das für diese Übertragung verwendet werden soll.

- RESOURCE_NAME: Der Ressourcenname der Übertragung (auch als Übertragungskonfiguration bezeichnet). Wenn Sie den Ressourcennamen der Übertragung nicht kennen, suchen Sie den Ressourcennamen mit

bq ls --transfer_config --transfer_location=location.

Beispiele:

Mit dem folgenden Befehl werden der Anzeigename, das Ziel-Dataset, das Aktualisierungsfenster und die Parameter für die Google Ads-Übertragung projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7 aktualisiert:

bq update \

--display_name='My changed transfer' \

--params='{"customer_id":"123-123-5678"}' \

--refresh_window_days=3 \

--target_dataset=mydataset2 \

--transfer_config \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

Mit dem folgenden Befehl werden die Parameter und der Zeitplan für die Übertragung der geplanten Abfrage projects/myproject/locations/us/transferConfigs/5678z567-5678-5z67-5yx9-56zy3c866vw9 aktualisiert:

bq update \

--params='{"destination_table_name_template":"test", "write_disposition":"APPEND"}' \

--schedule="every 24 hours" \

--transfer_config \

projects/myproject/locations/us/transferConfigs/5678z567-5678-5z67-5yx9-56zy3c866vw9

API

Verwenden Sie die Methode projects.transferConfigs.patch und geben Sie den Ressourcennamen der Übertragung mithilfe des Parameters transferConfig.name an. Wenn Sie den Ressourcennamen der Übertragung nicht kennen, suchen Sie den Ressourcennamen mit bq ls --transfer_config --transfer_location=location.

Sie können auch die folgende Methode aufrufen und die Projekt-ID mithilfe des Parameters parent angeben, um alle Übertragungen aufzulisten: projects.locations.transferConfigs.list.

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Java in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Java API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Python

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Python in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Python API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Anmeldedaten aktualisieren

Bei einer Übertragung werden die Anmeldedaten des Nutzers, der sie erstellt hat, verwendet. Wenn Sie den einer Übertragung zugeordneten Nutzer ändern müssen, können Sie die Anmeldedaten der Übertragung aktualisieren. Dies ist hilfreich, wenn der Nutzer, der die Übertragung erstellt hat, der Organisation nicht mehr angehört.

So aktualisieren Sie die Anmeldedaten für eine Übertragung:

Console

Rufen Sie in der Google Cloud Console die Seite Datenübertragungen auf.

Klicken Sie in der Liste der Datenübertragungen auf die Übertragung.

Klicken Sie auf das Menü Mehr und wählen Sie Refresh credentials aus.

Melden Sie sich in Ihrem Google-Konto an und klicken Sie auf Zulassen, um BigQuery Data Transfer Service die Berechtigung zum Ansehen Ihrer Berichtsdaten und zum Aufrufen und Verwalten der Daten in BigQuery zu erteilen.

bq

Geben Sie den Befehl bq update ein, fügen Sie den Ressourcennamen der Übertragungskonfiguration mit dem Flag --transfer_config hinzu und geben Sie das Flag --update_credentials an.

bq update \ --update_credentials=boolean \ --transfer_config \ resource_name

Ersetzen Sie Folgendes:

booleanist ein boolescher Wert, mit dem angegeben wird, ob die Anmeldedaten für die Übertragungskonfiguration aktualisiert werden sollen.resource_nameist der Ressourcenname der Übertragung (auch als Übertragungskonfiguration bezeichnet). Wenn Sie den Ressourcennamen der Übertragung nicht kennen, suchen Sie den Ressourcennamen mitbq ls --transfer_config --transfer_location=location.

Beispiele:

Geben Sie den folgenden Befehl ein, um die Anmeldedaten für die Google Ads-Übertragung projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7 zu aktualisieren.

bq update \

--update_credentials=true \

--transfer_config \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

API

Verwenden Sie die Methode projects.transferConfigs.patch und geben Sie die Parameter authorizationCode und updateMask an.

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Java in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Java API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Python

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Python in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Python API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Übertragung deaktivieren

Wenn Sie eine Übertragung deaktivieren, wird dem Übertragungsnamen disabled hinzugefügt. Sobald die Übertragung deaktiviert ist, werden keine neuen Übertragungsausführungen geplant und keine neuen Backfills zugelassen. Alle laufenden Übertragungen werden abgeschlossen.

Bei der Deaktivierung einer Übertragung werden Daten, die bereits in BigQuery übertragen wurden, nicht entfernt. Für zuvor übertragene Daten werden die standardmäßigen Speicherkosten für BigQuery berechnet, bis Sie das Dataset löschen oder die Tabellen löschen.

So deaktivieren Sie eine Übertragung:

Console

Rufen Sie in der Google Cloud Console die Seite „BigQuery“ auf.

Klicken Sie auf Übertragungen.

Klicken Sie auf der Seite Übertragungen in der Liste auf die Übertragung, die Sie deaktivieren möchten.

Klicken Sie auf Deaktivieren. Klicken Sie auf Aktivieren, um die Übertragung wieder zu aktivieren.

bq

Das Deaktivieren einer Übertragung wird von der Befehlszeile nicht unterstützt.

API

Verwenden Sie die Methode projects.locations.transferConfigs.patch und setzen Sie in der Ressource projects.locations.transferConfig die Option disabled auf true.

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Java in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Java API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

So aktivieren Sie die Übertragung wieder:

Bevor Sie dieses Beispiel ausprobieren, folgen Sie der Java-Einrichtungsanleitung in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Java API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Übertragung löschen

Wenn eine Übertragung gelöscht wird, werden keine neuen Übertragungsausführungen geplant. Laufende Übertragungen werden beendet.

Beim Löschen einer Übertragung werden Daten, die bereits in BigQuery übertragen wurden, nicht entfernt. Für zuvor übertragene Daten werden die standardmäßigen Speicherkosten für BigQuery berechnet, bis Sie das Dataset löschen oder die Tabellen löschen.

So löschen Sie Ihre Übertragung:

Console

Rufen Sie in der Google Cloud Console die Seite „BigQuery“ auf.

Klicken Sie auf Übertragungen.

Klicken Sie auf der Seite Übertragungen in der Liste auf die Übertragung, die Sie löschen möchten.

Klicken Sie auf Löschen. Aus Sicherheitsgründen müssen Sie das Wort „delete“ in ein Feld eingeben, um Ihre Absicht zu bestätigen.

bq

Geben Sie den Befehl bq rm ein und fügen Sie den Ressourcennamen der Übertragungskonfiguration hinzu. Mit dem Flag -f können Sie eine Übertragungskonfiguration ohne Bestätigung löschen.

bq rm \

-f \

--transfer_config \

resource_name

Wobei:

- resource_name ist der Ressourcenname der Übertragung (auch als Übertragungskonfiguration bezeichnet). Wenn Sie den Ressourcennamen der Übertragung nicht kennen, führen Sie den Befehl

bq ls --transfer_config --transfer_location=locationaus, um alle Übertragungen aufzulisten.

Geben Sie beispielsweise den folgenden Befehl ein, um die Übertragungskonfiguration projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7 zu löschen.

bq rm \

--transfer_config \

projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7

API

Verwenden Sie die Methode projects.locations.transferConfigs.delete und geben Sie die zu löschende Ressource mithilfe des Parameters name an.

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Java in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Java API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Python

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Python in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Python API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Übertragung manuell auslösen

Sie können manuell eine Übertragung (auch als Backfill-Ausführung bezeichnet) auslösen, um zusätzliche Datendateien außerhalb Ihrer automatisch geplanten Übertragungen zu laden. Mit Datenquellen, die Laufzeitparameter unterstützen, können Sie auch eine Übertragung manuell auslösen. Geben Sie dazu ein Datum oder einen Zeitraum an, aus dem vergangene Daten geladen werden sollen.

Daten-Backfills können Sie jederzeit manuell initiieren. Zusätzlich zu den Quelllimits unterstützt BigQuery Data Transfer Service Zeiträume von maximal 180 Tagen pro Backfill-Anfrage. Gleichzeitige Backfill-Anfragen werden nicht unterstützt.

Informationen darüber, wie viele Daten für Backfills verfügbar sind, finden Sie im Leitfaden zur Übertragung für Ihre Datenquelle.

Erforderliche Rollen

Bitten Sie Ihren Administrator, Ihnen die IAM-Rolle BigQuery-Administrator (roles/bigquery.admin) für das Projekt zuzuweisen, um die Berechtigungen zu erhalten, die Sie zum Ändern von Übertragungen benötigen.

Weitere Informationen zum Zuweisen von Rollen finden Sie unter Zugriff verwalten.

Sie können die erforderlichen Berechtigungen auch über benutzerdefinierte Rollen oder andere vordefinierte Rollen erhalten.

Übertragung oder Backfill manuell auslösen

Mit den folgenden Methoden können Sie eine Übertragung oder einen Backfill manuell auslösen:

- Wählen Sie Ihre Übertragungsausführung mit der Google Cloud Console aus und klicken Sie dann auf Übertragung jetzt ausführen oder Backfill planen.

- Den Befehl

bq mk –transfer runmit dembq-Befehlszeilentool verwenden - API-Methode

projects.locations.transferConfigs.startManualRuns methodaufrufen

Eine detaillierte Anleitung zu den einzelnen Methoden finden Sie auf dem entsprechenden Tab:

Console

Rufen Sie in der Google Cloud Console die Seite Datenübertragungen auf.

Wählen Sie die Übertragung aus der Liste aus.

Klicken Sie auf Übertragung jetzt ausführen oder Backfill planen. Abhängig von der Art der Übertragungskonfiguration ist nur eine Option verfügbar.

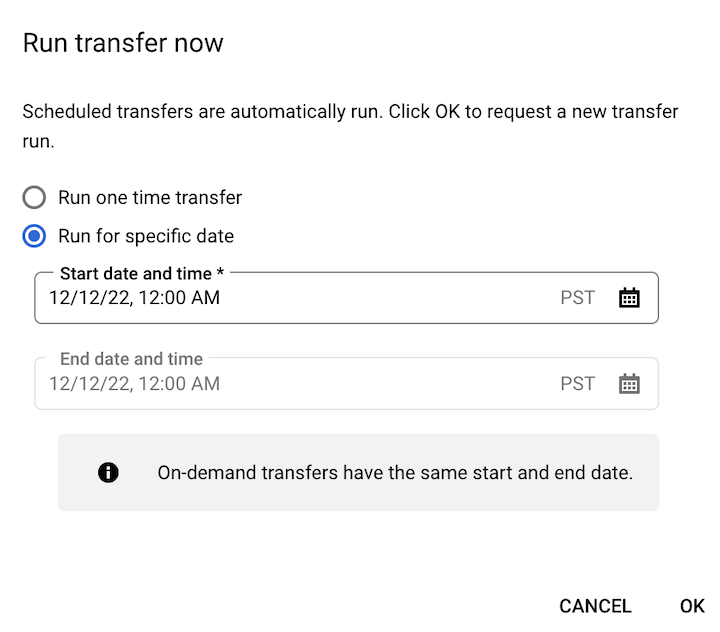

Wenn Sie auf Übertragung jetzt ausführen geklickt haben, wählen Sie Einmalige Übertragung ausführen oder Für bestimmtes Datum ausführen aus. Wenn Sie Für ein bestimmtes Datum ausführen ausgewählt haben, wählen Sie ein bestimmtes Datum und eine bestimmte Uhrzeit aus:

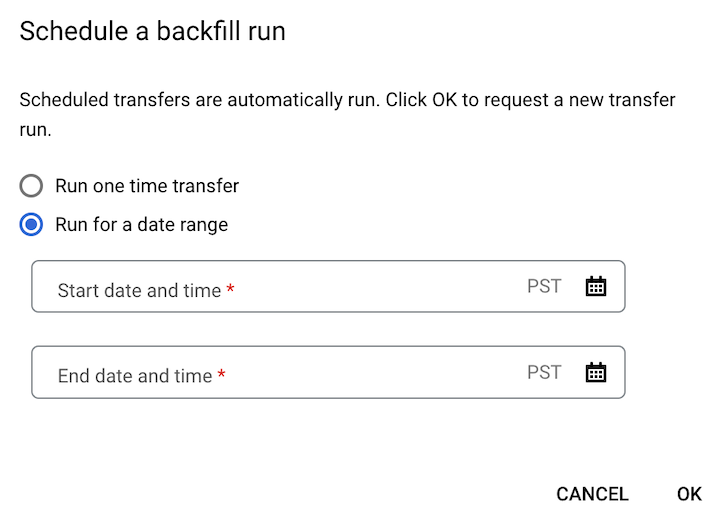

Wenn Sie auf Backfill planen geklickt haben, wählen Sie entweder Einmalige Übertragung ausführen oder Für einen Zeitraum ausführen aus. Wenn Sie Für einen Zeitraum ausführen ausgewählt haben, wählen Sie ein Start- und ein Enddatum sowie eine Uhrzeit aus:

Klicken Sie auf OK.

bq

Geben Sie den Befehl bq mk mit dem Flag --transfer_run ein, um eine Übertragungsausführung manuell zu starten:

bq mk \ --transfer_run \ --run_time='RUN_TIME' \ RESOURCE_NAME

Ersetzen Sie Folgendes:

RUN_TIMEist ein Zeitstempel, der das Datum einer früheren Übertragung angibt. Verwenden Sie Zeitstempel, die mit Z enden oder einen gültigen Zeitzonenversatz haben, z. B.2022-08-19T12:11:35.00Zoder2022-05-25T00:00:00+00:00.- Wenn Ihre Übertragung keinen Laufzeitparameter hat oder Sie jetzt eine Übertragung ohne Angabe einer früheren Übertragung auslösen möchten, geben Sie Ihre aktuelle Zeit in dieses Feld ein.

RESOURCE_NAMEist der Ressourcenname, der in der Übertragungskonfiguration aufgeführt ist, z. B.projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7.- Informationen zum Ressourcennamen einer Übertragungskonfiguration finden Sie unter Informationen zu Übertragungen abrufen.

- Der Ressourcenname hat das Format Relativer Ressourcenname.

Geben Sie den Befehl bq mk mit dem Flag --transfer_run zusammen mit einem Zeitraum ein, um eine Übertragungsausführung für einen bestimmten Zeitraum manuell zu starten:

bq mk \ --transfer_run \ --start_time='START_TIME' \ --end_time='END_TIME' \ RESOURCE_NAME

Ersetzen Sie Folgendes:

START_TIMEundEND_TIMEsind Zeitstempel, die mit Z enden oder einen gültigen Zeitzonen-Offset enthalten. Diese Werte geben den Zeitraum mit den vorherigen Übertragungsausführungen an, aus denen Sie einen Backfill ausführen möchten, z. B.2022-08-19T12:11:35.00Zoder2022-05-25T00:00:00+00:00.RESOURCE_NAMEist der in Ihrer Übertragungskonfiguration aufgeführte Ressourcenname, z. B.projects/myproject/locations/us/transferConfigs/1234a123-1234-1a23-1be9-12ab3c456de7- Informationen zum Ressourcennamen einer Übertragungskonfiguration finden Sie unter Informationen zu Übertragungen abrufen.

- Der Ressourcenname hat das Format Relativer Ressourcenname.

API

Verwenden Sie die Methode projects.locations.transferConfigs.startManualRuns, um eine Übertragungsausführung manuell zu starten. Geben Sie den Namen der Übertragungskonfigurationsressource mithilfe des übergeordneten Parameters an. Informationen zum Ressourcennamen einer Übertragungskonfiguration finden Sie unter Informationen zu Übertragungen abrufen.

"requestedRunTime": "RUN_TIME"

Ersetzen Sie Folgendes:

RUN_TIMEist ein Zeitstempel, der das Datum einer früheren Übertragung angibt. Verwenden Sie Zeitstempel, die mit Z enden oder einen gültigen Zeitzonenversatz haben, z. B.2022-08-19T12:11:35.00Zoder2022-05-25T00:00:00+00:00.- Wenn Ihre Übertragung keinen Laufzeitparameter hat oder Sie jetzt eine Übertragung ohne Angabe einer früheren Übertragung auslösen möchten, geben Sie Ihre aktuelle Zeit in dieses Feld ein.

Geben Sie einen Zeitraum an, um eine Übertragungsausführung manuell für einen bestimmten Zeitraum zu starten:

"requestedTimeRange": {

"startTime": "START_TIME",

"endTime": "END_TIME"

}

Ersetzen Sie Folgendes:

START_TIMEundEND_TIMEsind Zeitstempel, die mit Z enden oder einen gültigen Zeitzonen-Offset enthalten. Diese Werte geben den Zeitraum mit den vorherigen Übertragungsausführungen an, aus denen Sie einen Backfill ausführen möchten, z. B.2022-08-19T12:11:35.00Zoder2022-05-25T00:00:00+00:00.

Java

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Java in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Java API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Python

Bevor Sie dieses Beispiel anwenden, folgen Sie den Schritten zur Einrichtung von Python in der BigQuery-Kurzanleitung zur Verwendung von Clientbibliotheken. Weitere Angaben finden Sie in der Referenzdokumentation zur BigQuery Python API.

Richten Sie zur Authentifizierung bei BigQuery die Standardanmeldedaten für Anwendungen ein. Weitere Informationen finden Sie unter Authentifizierung für Clientbibliotheken einrichten.

Logging und Monitoring

Der BigQuery Data Transfer Service exportiert Logs und Messwerte nach Cloud Monitoring und Cloud Logging, die Beobachtbarkeit für Ihre Übertragungen ermöglichen. Mit Monitoring können Sie Dashboards einrichten, um Übertragungen zu überwachen, die Leistung von Übertragungsausführungen zu bewerten und Fehlermeldungen zur Fehlerbehebung bei Übertragungsfehlern anzuzeigen. Mit Logging können Sie Logs aufrufen, die sich auf eine Übertragungsausführung oder eine Übertragungskonfiguration beziehen.

Sie können auch Audit-Logs aufrufen, die dem BigQuery Data Transfer Service für Übertragungsaktivitäts- und Datenzugriffslogs zur Verfügung stehen.